基于生成对抗网络的图像风格迁移

0 引言

图像风格迁移是目前计算机视觉领域的研究热点.风格迁移的目的是将一幅图像转换成另一幅或多幅具有特定目标的图像,例如:输入一张纯色马的图片,输出的是斑马的图片;输入一张油画的图片,输出的是中国画的图片;等等.图像风格迁移不仅可以显著降低获取相关数据集的成本,而且还可以创建源数据以外的新图像,所以利用生成模型扩大研究数据集可有效提高深度学习网络模型的训练质量.

Goodfellow等[1]提出一种生成对抗网络模型,该模型由生成网络和判别网络组成,这两个网络在互相博弈的过程中优化彼此.随着判别网络的辨伪能力不断增强,生成网络产生的数据将更接近真实数据,生成对抗网络与其他网络相比具有更好的数据生成能力,因此生成对抗网络在图像生成和风格迁移领域得到了广泛应用.Isola等[2]提出的Pix2Pix模型作为有监督图像风格迁移的代表作,它通过有监督训练成对图像,得到的是一对一的风格迁移图像.虽然Pix2Pix模型得到的生成图像接近真实图像,但是该模型的训练需要大量的成对图像数据,而现实中收集成对数据集较困难,限制了其推广应用.Zhu等[3]提出的CycleGAN不需要训练成对的数据集,它是无监督风格迁移任务的经典模型,并且仅使用生成器和判别器完成图像域的风格迁移,首次实现了不成对图像之间的变换,在风格迁移领域得到了广泛的应用,但该模型并不能生成多样的结果.针对CycleGAN生成结果单一的问题,Zhu等[4]提出的BicycleGAN是一种基于条件遗传算法的混合模型,结合了cVAE-GAN[5]和cLR-GAN[6]的优点,学习两个图像域之间的多模态映射,有助于产生更多样化的结果.Park等[7]提出的CUT将对比学习应用到图像风格迁移,实现了一种轻量级的图像风格转换模型.尽管已有方法将一幅图像转换成另一幅或多幅图像时表现良好,但是由于输入生成器的生成图像与真实图像存在域差异,因此在模型收敛后得到的生成图像往往伴随着噪声和细节信息的丢失,使得图像风格迁移的质量仍有提升空间.在网络训练过程中数据之间的整体差异较小,存在较多极端值干扰的情况下,往往会导致模型训练变得不稳定.

本文针对上述问题,提出了以下几个方面的改进:

1)将残差模块引入BicycleGAN的生成器,解决GAN再训练中容易出现的退化现象;

2)将注意力机制引入BicycleGAN的生成器,在提取图像局部特征的同时,又注意全局特征,获得更多的图像特征,并使得图像风格转换过后的图像与真实图像保持特征一致性;

3)判别器每层卷积后面加入谱归一化,使得判别器和生成器在对抗训练中趋于稳定;

4)引入感知损失,能够稳定训练,提升生成图像的质量.

1 相关工作

1.1 BicycleGAN

1.2 残差块

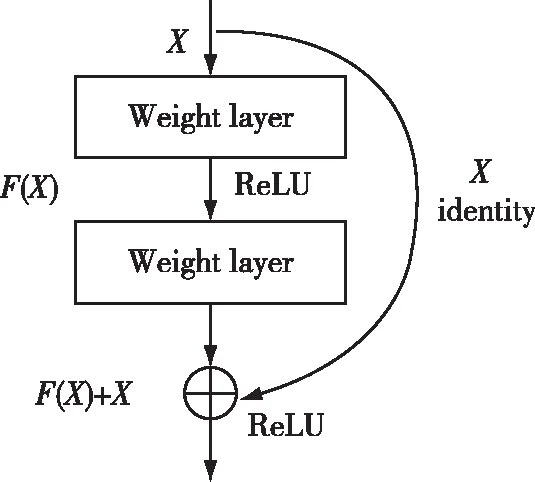

在深度学习中,网络的层数越多,意味着能够提取到的特征越丰富,并且越深的网络提取的特征越抽象、越具有语义信息[8],但如果简单地增加深度,会导致退化问题.随着网络层数增加,在训练集上的准确率趋于饱和甚至下降.为了解决这种退化现象,ResNet被He等[8]提出,其结构如图2所示.残差网络的思想就是将网络学习的映射从X到Y转为学习从X到Y-X的差,然后把学习到的残差信息加到原来的输出上即可.即便在某些极端情况下,这个残差为0,那么网络就是一个X到Y的恒等映射.残差块一个通用的表示方式是:

图2 残差网络结构Fig.2 Residual network structure

yl=h(xl)+F(xl,Wl), xl+1=f(yl),

(1)

其中,xl和xl+1分别是第l层的输入和输出,F是一个残差函数,h(·) 是恒等映射,f(·)是激活函数.残差网络跳过了一些网络层直接与后面某一层的输出结果进行连接.随着深度的增加,可以获取更高的精度,因为其学习的残差越准确.本文通过在生成器中引入残差模块,使得网络训练过程更加简单,有效缓解了网络退化的问题.

1.3 注意力机制

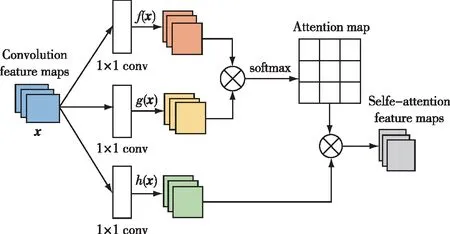

人的眼睛可以有选择性地看自己关注的事物,从而忽略一部分不感兴趣的信号,重点聚焦自己感兴趣的事物,这就是注意力机制.注意力机制能够使得模型在生成图片过程中可以自己关注不同特征区域.如图3所示,输入数据通过卷积初始化,使用数量为C/K(k=8)且大小为1×1的卷积核来对输入数据执行卷积运算,以获得特征图f(x)和g(x),使用一个数量为C且大小为1×1的卷积核对输入数据执行卷积运算以获得特征图h(x).经过局部自我注意特征图计算,重新调整特征图尺寸.然后计算f(x)与g(x)转置相乘,通过softmax归一化后得到Attention Map.再让Attention Map与h(x)每个像素点相乘,得到自注意力feature maps.

图3 自注意力机制结构Fig.3 Self-attention mechanism structure

其数学表达式如下:

(2)

在局部信息的基础上增加全局信息得到:

(3)

注意力层的最终输出为

yi=γoi+xi.

(4)

前一个隐藏层的图像特征向量x∈RC×N,转化为3个特征空间f(x)、g(x)和h(x),βj,i表示合成第j个区域时模型关注第i个区域的程度,然后输出注意力层是o=(oi,o2,o3,…,oj,…,oN)∈RC×N,再乘以一个初始化为0的可学习权重γ,并且添加特征向量x,通过反向传播不断更新.本文在生成器网络中引入自注意力机制,使其能够充分发现图像内部表征的整体性和长期依赖性,有效地降低了训练的计算量,使得训练更加稳定.

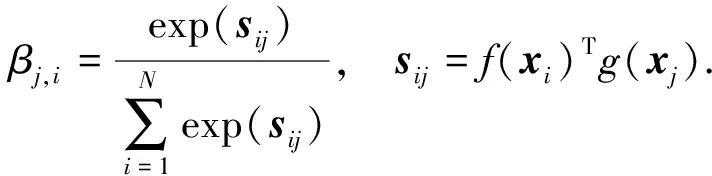

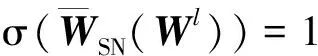

1.4 谱归一化

谱归一化 (Spectral Normalization,SN)[9]通过限制每一层的频谱范数来约束判别器的 Lipschitz常数,从而提高生成对抗网络的稳定性.谱归一化与其他归一化方法相比计算成本较小,不需要额外的超参数调整.它通过约束判别器D中每层f的权重矩阵的L2矩阵范数来控制Lipschitz常数.对于线性层f(x)=Wx,给出了它的Lipschitz范数如式(6)所示.根据定义,其中σ(W)代表矩阵W的L2矩阵标准,它也等于W的最大奇异值.

(5)

(6)

如果为每层选择的激活函数a的Lipschitz范数为1,根据范数相容性,可以获得判别器D中的Lipschitz范数的边界,如不等式(7),其中L是D的层数.

(7)

因此,需要一种频谱归一化方法来确保σ(W)始终等于1,谱归一化如等式(8)所示:

(8)

2 基于生成对抗网络的风格迁移模型

2.1 生成器模型

本文改进和优化了原始GAN的生成器部分,引入残差块和自注意力机制,使得在图像风格迁移过程中生成图像的真实性有较大提高,改善了生成图像的质量.所设计的生成器由编码器、转换器、解码器三部分组成,编码器由卷积神经网络组成、转换器由自注意力机制网络层与残差网络块结构组成、解码器由反卷积神经网络组成,生成器网络如图4所示.

图4 生成器网络Fig.4 Generator network

整个生成器的网络结构参数配置如表1所示,编码器和转换器使用实例归一化 (Instance Normalization,IN)[10]和ReLU 激活函数,解码器最后一层使用Tanh 激活函数.自注意力机制有助于在图像的相邻区域之间建立长期的、多层次的依赖关系.本文通过在生成器中引入自注意力机制,更好地在局部依赖基础上增加全局依赖,这有助于生成器合成更逼真的风格迁移图像.为了避免因网络层数的增加而导致梯度消失的问题,本文在生成器中引入残差块,模型的训练速度得到提升,残差网络层与层之间的跳跃连接可以保留原图一部分没有进行风格迁移的完整信息,从而提高了图像风格迁移后的视觉效果.

表1 生成器网络结构参数配置

L1(G,E)=EA~P(A),Z~P(Z)‖z-E(G(A,z))‖1,

(10)

(11)

G是生成器,D是判别器,E是编码器,λ为设置的超参数,嵌入Z的潜在编码被生成器网络用来保持接近实际测试时间分布p(z),L1损失可以体现重构后的图像轮廓,GAN能更好地锐化图像的清晰度.

2.2 判别器模型

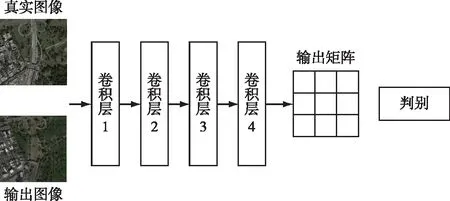

本文判别器网络采用Wang等[11]提出的 PatchGAN 作为模型的判别器,用来对输入的生成图像与真实图像进行真伪判别.判别器网络如图5所示.

图5 判别器网络Fig.5 Discriminator network

PatchGAN将输入的图像划分为70×70的多个小块,小块代表输入图像的感受野,然后对每个图像块进行真伪判断,其输出二维矩阵中每一个元素的值表示每个图像块是真实样本的概率,每个图像块真实概率的平均值作为最终整体图像的判定结果.该判别器可以很大程度上保持图像的高分辨率和细节.为了缓解梯度消失从而增加模型的稳定性,本文在判别器每层卷积后面加入谱归一化.判别器的网络结构如表2所示.

表2 判别器结构参数配置

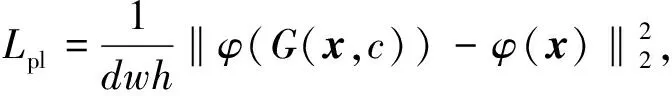

2.3 感知损失

Johnson 等[12]利用感知损失增强图像细节.为了生成图像的真实视觉效果,本文使用感知损失来优化生成网络.感知损失依赖训练的VGG16模型提取图像高级特征.先提取生成图像和原始图像的特征,然后计算它们之间的差异.为了最大限度地减少细节的丢失,应用感知损失来提高细节保护能力,如等式(12)所示:

(12)

其中,x是输入数据,c是输入目标属性标签,G(x,c)是生成的数据,φ是特征提取函数,d、w和h分别表示深度、宽度和高度.损失函数将通过真实图像卷积获得的特征与通过生成图像卷积获得的特征进行比较,以使内容信息和全局结构信息接近.

3 实验与结果分析

3.1 实验平台与数据集

本文实验环境如表3所示.

表3 实验环境

本文使用Facades数据集和AerialPhoto&Map数据集作为实验数据集.Facades数据集包含不同领域风格的建筑物图像,AerialPhoto&Map数据集包含Google Maps网站上获取的纽约市及其附近的卫星航拍图与导航路网图匹配图像.本研究工作分别取Facades数据集中的400幅图像和AerialPhoto&Map中的1 096幅图像作为实验数据集.Facades数据集中320幅图像用作训练集,80幅图像用做测试集,AerialPhoto&Map数据集中600幅图像用做训练集,496幅图像用作测试集.

3.2 实验结果

在Facades和AerialPhoto&Map数据集上分别进行了图像风格迁移实验.为了验证本文方法的有效性,将本文方法的实验结果与Pix2Pix、Cyclegan、CUT、BicycleGAN进行了对比.

3.2.1 在Facades数据上实验结果

Facades数据集上的实验结果如图6所示,目的是将输入语义图还原为真实建筑图像.图6中第1列是输入的建筑语义图像,第2、第3、第4和第5列分别为Pix2Pix模型、Cyclegan模型、CUT模型和BicycleGAN模型的图像风格迁移实验结果,第6列为本文方法的实验结果.

图6 Facades数据集实验结果Fig.6 Experimental results on Facades dataset

从图6中可以看出:

1)第1行,Pix2Pix没有完整转换出语义图像的建筑屋顶信息,风格迁移的建筑图像屋顶有缺失;Cyclegan的颜色不一致,建筑上方颜色偏淡,无法显示均匀一致的外墙颜色,处理的色彩不够真实;CUT风格迁移的建筑图像发生了大量缺失,建筑的墙体四周残缺,不能很好地填充完整的建筑图像;BicycleGAN对广告牌的转换能力欠佳,建筑下方的广告牌出现了黑影;本文方法能够完整提取语义图像信息,补全建筑整体外观,显示均匀一致的建筑外墙颜色,下方广告牌的转换没有严重形变和黑影出现,优于前4种风格迁移模型.

2)第2行,前4种模型风格迁移的建筑图像均出现了下方大门的形变,线条扭曲,外墙砖的显色模糊,本文方法风格迁移的细节比较前4种模型更好,大门的线条没有扭曲,外墙砖的纹理能够清晰显示.

3)第3行,CycleGAN风格迁移的建筑图像中护栏和窗户兼容能力较差,有护栏的窗户均出现了形变;BicycleGAN风格迁移的建筑图像下方出现了大量阴影,色彩偏暗;本文方法可以更好地显示建筑图像中窗户下方的护栏,色彩明亮,更接近真实建筑的颜色.

3.2.2 AerialPhoto&Map数据集实验结果

AerialPhoto&Map数据集上的实验结果如图7所示,目的是将输入语义图还原为真实航拍卫星图像.图7中第1列是输入的地图语义图像,第2、第3、第4和第5列分别为Pix2Pix模型、Cyclegan模型、CUT模型和BicycleGAN模型的航拍卫星图像风格迁移实验结果,第6列为本文方法的实验结果.

图7 AerialPhoto&Map数据集实验结果Fig.7 Experimental results on AerialPhoto&Map dataset

从实验结果可以看出,前4种模型对水系的语义无法有效提取,本文方法对水系的提取能力较好.第1行:Pix2Pix风格迁移的航拍卫星图像中将水系生成草坪,道路图像也失真,纹理不清晰;CycleGAN 对复杂建筑的航拍卫星图像转换效果较差,出现了移位和交错的模糊图像;本文方法更接近真实效果,道路图像纹理清晰.第2行:CUT对林地和道路的色调信息提取较差,林地的颜色偏暗,风格迁移的质量不能满足人眼主观认知;BicycleGAN风格迁移的航拍卫星图中右下方道路被草坪遮挡,道路提取效果较差;本文方法可以更好地展示边界位置,草坪没有遮挡道路.第3行:前4种模型方法风格迁移的航拍卫星图中建筑屋顶未能清晰显示,本文方法可以有效显示建筑屋顶,很好地提取了边界位置的道路.

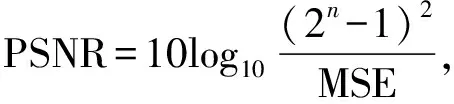

3.3 评价指标

为了客观地反映不同模型的生成图像的效果,采用峰值信噪比(PSNR)和结构相似性(SSIM)指标来评价生成图像.这两个指标常用作图像处理的评价指标.两幅图像之间较高的PSNR值表示生成图像和原始图像之间失真较小,即生成图像质量较高.SSIM反映了生成图像在亮度、对比度和结构方面与真实图像的相似性.SSIM越接近1,两幅图像之间的相似性越高,表明生成的图像更符合公众的视觉感知效果.

PSNR是评价彩色图像质量的客观标准.计算公式如下:

(13)

(14)

其中,H和W分别代表图像的宽度和高度,(i,j)代表每个像素点,n代表像素的位数,X和Y分别代表两幅图像.由于PSNR指数也有其局限性,不能完全反映图像质量和人的视觉效果的一致性,所以采用SSIM指数做进一步的比较.SSIM是一种度量两个图像相似性的标准.通过将模型绘制的图像与原始彩色图像进行比较,可以验证该算法的有效性和准确性.计算公式如下:

(15)

表4 PSNR分数对比

表5 SSIM分数对比

由表4和表5可以看出,本文方法的PSNR分数和SSIM分数均高于前4种方法,说明本文方法能够生成更丰富、更生动的图像内容.在Facades数据集上,本文方法的PSNR值比第二高的BicycleGAN模型高2.103 9 dB,SSIM分数比第二高的CUT模型提高了0.031 7.在AerialPhoto&Map数据集上,本文方法的PSNR值比第二高的CUT模型高2.135 1 dB,SSIM分数比第二高的CUT模型提高了0.102 8.CUT模型通过引入对比学习能够专注于两个域之间共性的部分,但忽略两个域之间的差异性部分,使得图像轮廓不清晰,本文方法引入自注意力机制增强了远距离像素之间的连接,能够使得风格迁移的图像获得更清晰的边缘.BicycleGAN在多目标任务中表现良好,但模型捕捉局部和整体之间的内部映射关系的能力较弱,本文通过引入感知损失,使得细节方面的表现优于其他模型.从PSNR来看,本文方法生成的图像质量更高,和原始图像之间失真较小.从SSIM来看,本文方法生成的图像在亮度、对比度和结构方面与真实图像更相似.

3.4 消融实验

为了验证自注意力机制、谱归一化和感受损失在风格迁移效果上的有效性,本文设计了一组消融实验.本文方法是在原BicycleGAN的基础上加入了自注意力机制、谱归一化和感知损失改进而来.实验采用控制变量法进行,将自注意力机制、谱归一化和感知损失3种改进方案分别命名为A、B、C,设计了4组实验进行对比.实验所生成的风格迁移图像如图8所示.

从图8可以看出,自注意力机制可以优化全局细节,无论是建筑图像的窗户线条还是航拍卫星图像的道路线条都能完整显示,提升图像质量.谱归一化和感知损失能够使得图像风格迁移更稳定的同时提升图像信息提取能力,原图像在航拍卫星图像的建筑屋顶出现了被草地覆盖使得显示不够清晰,改进方案使得图像的建筑屋顶与草地分明,细节处理更优.实验结果的PSNR分数对比客观指标如表6所示,SSIM分数对比如表7所示.

表7 消融SSIM分数对比

由表6和表7客观指标可以看出,在Facades和AerialPhoto&Map数据集上,自注意力机制、谱归一化和感知损失的改进均有助于提升PSNR和SSIM分数,图像风格迁移效果有明显提升.说明添加的模块在提高图像风格迁移的质量和保真度方面是有效的,采用本文方法生成的图像更加真实,且风格迁移的图像细节更加丰富.

4 结论

传统的BicycleGAN网络模型在图像风格迁移过程中图像细节不清晰,训练不稳定,有时会出现梯度爆炸的现象.本文对BicycleGAN进行了改进,在生成器中引入残差块,改善模型训练的退化现象,利用自注意力机制获得更多的图像特征,使得生成图像更接近真实图像.在判别器中引入谱归一化,提高训练稳定性,提升判别能力.同时引入感知损失,提升了图像生成质量.实验结果表明,本文方法与传统的风格迁移模型Pix2Pix、Cyclegan、CUT、BicycleGAN相比,图像生成质量和视觉效果有较大提高,PSNR分数和SSIM分数有较大提升.