基于多维注意力融合的驾驶场景分割增强算法

刘奕晨 章坚武 胡晶

摘 要:针对使用注意力机制的语义分割模型计算资源消耗与精度不平衡的问题,提出一种轻量化的语义分割注意力增强算法。首先,基于驾驶场景中物体的形状特点设计了条状分维注意力机制,使用条形池化代替传统方形卷积,并结合降维操作分维度提取长程语义关联,削减模型计算量。接着融合通道域与空间域上的注意力,形成可叠加与拆解的轻量化多维注意力融合模块,全方位提取特征信息,进一步提升模型精度。最后,将模块插入基于ResNet-101骨干网的编码—解码网络中,指导高低层语义融合,矫正特征图边缘信息,补充预测细节。实验表明,该模块有较强的鲁棒性和泛化能力,与同类型注意力机制相比,削减了约90%的参数量以及80%的计算量,且分割精度依旧取得了稳定的提升。

关键词:语义分割;注意力机制;条状特征提取;多维注意力融合

中图分类号:TP391 文献标志码:A 文章编号:1001-3695(2023)10-046-3180-06

doi:10.19734/j.issn.1001-3695.2023.01.0014

Driving scene segmentation enhancement algorithm based on multidimensional attention fusion

Liu Yichen1,Zhang Jianwu1,Hu Jing2

(1.School of Communication Engineering,Hangzhou Dianzi University,Hangzhou 310018,China;2.Zhejiang Uniview Technologies Co.,Ltd.,Hangzhou 310051,China)

Abstract:To address the problem of unbalanced computational resource consumption and accuracy of semantic segmentation models using attention mechanism,this paper proposed a lightweight attention enhancement algorithm for semantic segmentation.Firstly,it designed a striped dimensional attention mechanism based on the shape characteristics of objects in driving scenes,used striped pooling instead of traditional square convolution,and combined dimensionality reduction operations to extract long-range semantic associations in each dimension to cut down the model computation.Then it fused the attention on channel domain and spatial domain to form a lightweight multidimensional attention fusion module that could be superimposed and disassembled to extract feature information in all directions and further improve the model accuracy.Finally,it inserted the module into the ResNet-101 backbone based encoding-decoding network to guide the semantic fusion of high and low layers,correct the feature map edge information,and supplement the prediction details.The experiments show that the module has strong robustness and generalization ability,cutting about 90% of the number of parameters and 80% of the computation compared with the same type of attention mechanism,and the segmentation accuracy still achieves a stable improvement.

Key words:semantic segmentation;attention mechanism;strip feature extraction;multi-dimensional attention fusion

0 引言

语义图像分割是计算机视觉中的一项基本任务。传统分割主要是通过提取图片的低级特征然后进行分割,如阈值分割法[1,2]、边缘检测法[3,4]、区域分割法[5]等。这个阶段一般是非监督学习,分割出来的结果缺少语义标注。基于深度学习的图像语义分割能根据标签进行语义划分,具有批量化处理和多分類的优点,在各领域均取得了广泛的应用,如生物医学[6]、无人机航拍[7]、图像编辑[8]等。驾驶场景图像语义分割是以城市街景图像为研究对象理解城市内复杂的街景及交通状况,由此分析和获取路况信息。该技术对于实现自动驾驶、机器人传感和图像处理等潜在的应用领域具有重要意义。

全卷积网络[9]基于现存的知名分类模型,将包括AlexNet、VGG-16、GoogLeNet、ResNet等模型进行了改进,使其更加适应像素分类的要求。但由于固定的卷积核以及池化大小,模型缺乏上下文信息的交互能力。采用空洞卷积[10,11]在标准卷积中间填充0或者输入等间隔采样,在降采样的同时保持分辨率,可以增加感受野且降低计算量,可以起到检测分割大目标以及精确定位目标的作用。填充0的数量影响感受野大小,即捕获多尺度上下文信息。金字塔结构[12,13]也可以聚合不同尺度的信息,汇聚图像的全局线索。

引入软注意力机制也是增强上下文关联,建立像素远程依赖的有效手段之一。自动驾驶公司Momenta在2017年公布了一种全新的图像识别结构SENet[14],其中的SE模块通过全局平均池化获得全局感受野,强调了不同通道的权重,证明了通道注意力对结果提升的必要性。Wang等人[15]提出的ECANet延续了该理论并提出一种不降维的局部跨信道交互策略,显著降低了模型的复杂度。除此之外,许多研究也注意到了空间注意力可以加强同帧图像像素间、不同帧像素间的关联性。如CBAM[16]通过平均池化与最大池化结合捕捉空间注意力。非局部神经网络中的非局部块[17]合并了除通道外的所有维度,通过点乘操作建立当前像素间与其他所有像素间的关系。DANet[18]在此基础上融合了通道域与空间域的注意力,更好地做到了分割的精确性。文献[19]提出的基于多级叠加和注意力机制的图像语义分割方法中,也使用了由通道和空间组成的注意力机制模块来抑制无意义的特征。但是以上方法计算了每个像素间的关联矩阵,使得占用的内存大大增加,在实际应用中存在一定的局限性。

为了有效捕捉远距离上下文关系,并在提升精度的过程中简化注意力机制的计算操作,本文基于驾驶场景提出一种条状分維度注意力机制(strip partitioned dimensional attention,SPDA)。为了适应场景中道路、高层建筑、路灯、栅栏等条状物的分割,本文中用长条形池化核代替方形池化核,并在每个维度上将特征降维后单独计算注意力,再进行后续融合。首先,在每个通道的特征图上,利用条状池化在图像高度和宽度上分别进行了信息融合,再提取出该维度上的特征权重。在此基础上,设计了结合通道域与空间域的多维注意力融合模块(multi-attention fusion module,MAFM),将新的注意力机制应用于高度和宽度并进行融合,保证每个维度信息的完整性。为了证明该模块的有效性,本研究以DeepLab v3+编码—解码结构为基础,将ResNet101作为骨干网,构建了MAFM与网络融合后的多维注意力网络结构(multidimensional attention network,MANet)。实验表明,加入MAFM后的网络性能相比原网络取得了有效的提升,是一种较为先进的注意力提取方法。

本文的贡献如下:a)提出一种基于条状池化的注意力机制,能更好地适应驾驶场景中的目标物体;b)设计了结合通道域与空间域的多维注意力融合模块,在仅增加很小参数量的情况下融合了通道域和空间域的注意力;模块的轻量化设计允许该模块能够插入各种网络结构中;c)提出了基于DeepLab v3+编解码器结构的融合网络MANet,取得了更高质量的图像分割预测结果。

1 相关工作

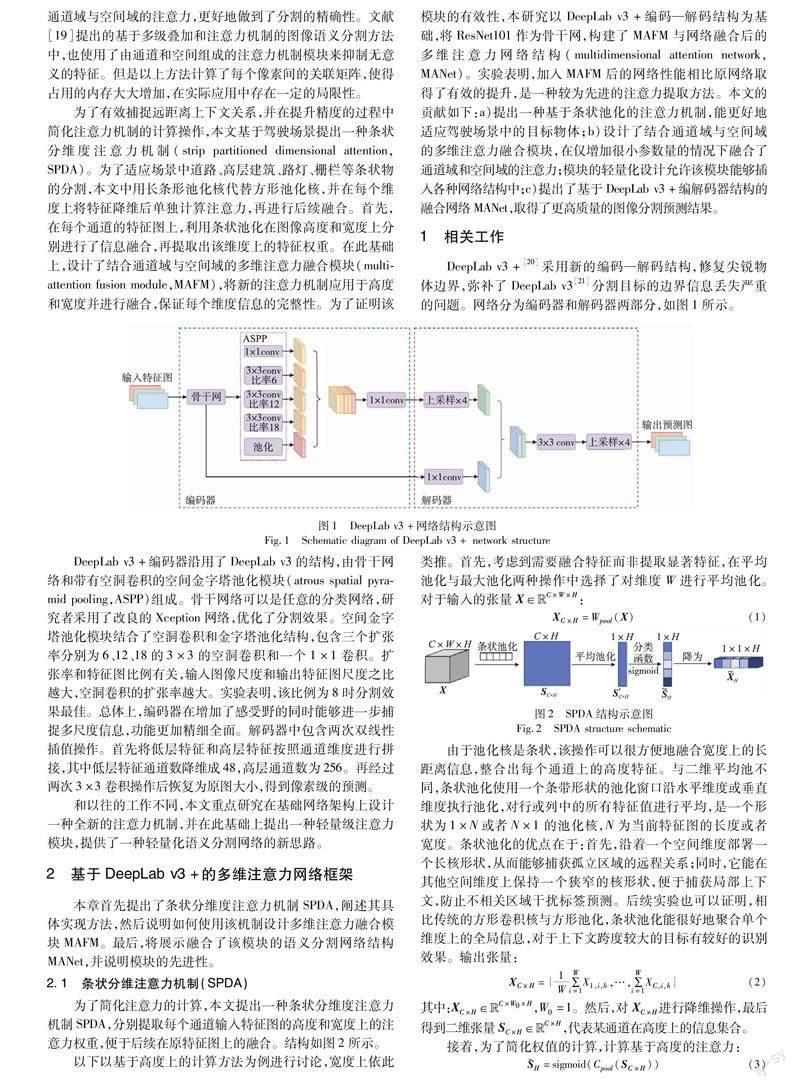

DeepLab v3+[20]采用新的编码—解码结构,修复尖锐物体边界,弥补了DeepLab v3[21]分割目标的边界信息丢失严重的问题。网络分为编码器和解码器两部分,如图1所示。

DeepLab v3+编码器沿用了DeepLab v3的结构,由骨干网络和带有空洞卷积的空间金字塔池化模块(atrous spatial pyramid pooling,ASPP)组成。骨干网络可以是任意的分类网络,研究者采用了改良的Xception网络,优化了分割效果。

空间金字塔池化模块结合了空洞卷积和金字塔池化结构,包含三个扩张率分别为6、12、18的3×3的空洞卷积和一个1×1卷积。扩张率和特征图比例有关,输入图像尺度和输出特征图尺度之比越大,空洞卷积的扩张率越大。实验表明,该比例为8时分割效果最佳。总体上,编码器在增加了感受野的同时能够进一步捕捉多尺度信息,功能更加精细全面。解码器中包含两次双线性插值操作。首先将低层特征和高层特征按照通道维度进行拼接,其中低层特征通道数降维成48,高层通道数为256。再经过两次3×3卷积操作后恢复为原图大小,得到像素级的预测。

和以往的工作不同,本文重点研究在基础网络架构上设计一种全新的注意力机制,并在此基础上提出一种轻量级注意力模块,提供了一种轻量化语义分割网络的新思路。

2 基于DeepLab v3+的多维注意力网络框架

本章首先提出了条状分维度注意力机制SPDA,阐述其具体实现方法,然后说明如何使用该机制设计多维注意力融合模块MAFM。最后,将展示融合了该模块的语义分割网络结构MANet,并说明模块的先进性。

2.1 条状分维注意力机制(SPDA)

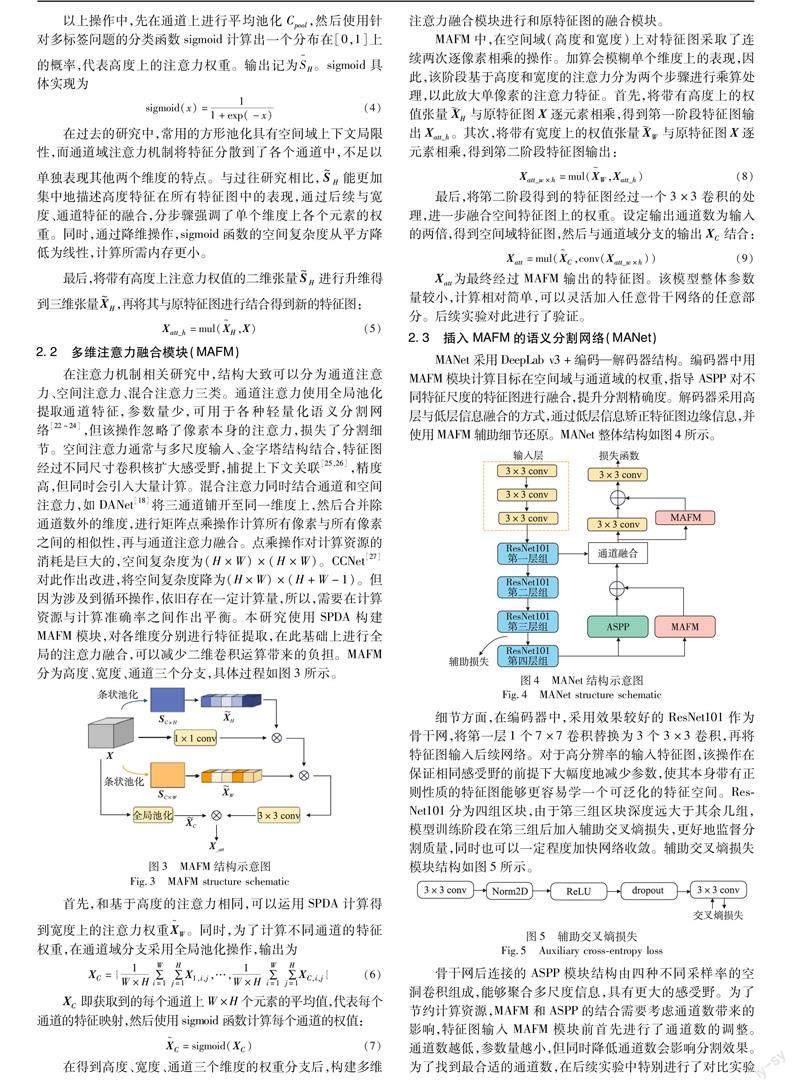

为了简化注意力的计算,本文提出一种条状分维度注意力机制SPDA,分别提取每个通道输入特征图的高度和宽度上的注意力权重,便于后续在原特征图上的融合。结构如图2所示。

由于池化核是条状,该操作可以很方便地融合宽度上的长距离信息,整合出每个通道上的高度特征。与二维平均池不同,条状池化使用一个条带形状的池化窗口沿水平维度或垂直维度执行池化,对行或列中的所有特征值进行平均,是一个形状为1×N或者N×1的池化核,N为当前特征图的长度或者宽度。条状池化的优点在于:首先,沿着一个空间维度部署一个长核形状,从而能够捕获孤立区域的远程关系;同时,它能在其他空间维度上保持一个狭窄的核形状,便于捕获局部上下文,防止不相关区域干扰标签预测。后续实验也可以证明,相比传统的方形卷积核与方形池化,条状池化能很好地聚合单个维度上的全局信息,对于上下文跨度较大的目标有较好的识别效果。输出张量:

在过去的研究中,常用的方形池化具有空间域上下文局限性,而通道域注意力机制将特征分散到了各个通道中,不足以单独表现其他两个维度的特点。与过往研究相比,S~H能更加集中地描述高度特征在所有特征图中的表现,通过后续与宽度、通道特征的融合,分步骤强调了单个维度上各个元素的权重。同时,通过降维操作,sigmoid函数的空间复杂度从平方降低为线性,计算所需内存更小。

2.2 多维注意力融合模块(MAFM)

在注意力机制相关研究中,结构大致可以分为通道注意力、空间注意力、混合注意力三类。通道注意力使用全局池化提取通道特征,参数量少,可用于各种轻量化语义分割网络[22~24],但该操作忽略了像素本身的注意力,损失了分割细节。空间注意力通常与多尺度输入、金字塔结构结合,特征图经过不同尺寸卷积核扩大感受野,捕捉上下文关联[25,26],精度高,但同時会引入大量计算。混合注意力同时结合通道和空间注意力,如DANet[18]将三通道铺开至同一维度上,然后合并除通道数外的维度,进行矩阵点乘操作计算所有像素与所有像素之间的相似性,再与通道注意力融合。点乘操作对计算资源的消耗是巨大的,空间复杂度为(H×W)×(H×W)。CCNet[27]对此作出改进,将空间复杂度降为(H×W)×(H+W-1)。但因为涉及到循环操作,依旧存在一定计算量,所以,需要在计算资源与计算准确率之间作出平衡。

本研究使用SPDA构建MAFM模块,对各维度分别进行特征提取,在此基础上进行全局的注意力融合,可以减少二维卷积运算带来的负担。MAFM分为高度、宽度、通道三个分支,具体过程如图3所示。

首先,和基于高度的注意力相同,可以运用SPDA计算得到宽度上的注意力权重X~W。同时,为了计算不同通道的特征权重,在通道域分支采用全局池化操作,输出为

XC即获取到的每个通道上W×H个元素的平均值,代表每个通道的特征映射,然后使用sigmoid函数计算每个通道的权值:

在得到高度、宽度、通道三个维度的权重分支后,构建多维注意力融合模块进行和原特征图的融合模块。

MAFM中,在空间域(高度和宽度)上对特征图采取了连续两次逐像素相乘的操作。加算会模糊单个维度上的表现,因此,该阶段基于高度和宽度的注意力分为两个步骤进行乘算处理,以此放大单像素的注意力特征。首先,将带有高度上的权值张量H与原特征图X逐元素相乘,得到第一阶段特征图输出Xatt_h。其次,将带有宽度上的权值张量W与原特征图X逐元素相乘,得到第二阶段特征图输出:

最后,将第二阶段得到的特征图经过一个3×3卷积的处理,进一步融合空间特征图上的权重。设定输出通道数为输入的两倍,得到空间域特征图,然后与通道域分支的输出XC结合:

Xatt为最终经过MAFM输出的特征图。该模型整体参数量较小,计算相对简单,可以灵活加入任意骨干网络的任意部分。后续实验对此进行了验证。

2.3 插入MAFM的语义分割网络(MANet)

MANet采用DeepLab v3+编码—解码器结构。编码器中用MAFM模块计算目标在空间域与通道域的权重,指导ASPP对不同特征尺度的特征图进行融合,提升分割精确度。解码器采用高层与低层信息融合的方式,通过低层信息矫正特征图边缘信息,并使用MAFM辅助细节还原。MANet整体结构如图4所示。

细节方面,在编码器中,采用效果较好的ResNet101作为骨干网,将第一层1个7×7卷积替换为3个3×3卷积,再将特征图输入后续网络。对于高分辨率的输入特征图,该操作在保证相同感受野的前提下大幅度地减少参数,使其本身带有正则性质的特征图能够更容易学一个可泛化的特征空间。ResNet101分为四组区块,由于第三组区块深度远大于其余几组,模型训练阶段在第三组后加入辅助交叉熵损失,更好地监督分割质量,同时也可以一定程度加快网络收敛。辅助交叉熵损失模块结构如图5所示。

骨干网后连接的ASPP模块结构由四种不同采样率的空洞卷积组成,能够聚合多尺度信息,具有更大的感受野。为了节约计算资源,MAFM和ASPP的结合需要考虑通道数带来的影响,特征图输入MAFM模块前首先进行了通道数的调整。通道数越低,参数量越小,但同时降低通道数会影响分割效果。为了找到最合适的通道数,在后续实验中特别进行了对比实验说明。之后, 将ASPP与MAFM特征图融合并压缩通道数,综合局部与全局的信息。MAFM相比DANet等骨干网串联的空间—通道域注意力模块拥有更小的计算量,允许多次并联。

解码器高层特征图输入大小为原特征图的1/8,经过一次上采样后与骨干网第一层组输出的底层特征图进行通道融合。然后,经过MAFM进一步处理通道融合后的特征图,还原上采样丢失的细节信息。最后,再次使用卷积并进行上采样得到最终的输出预测图。

实验注意到,MAFM的多次插入不会为网络带来过多的参数与计算量,并且可以对网络性能进行有效提升。在本研究的模型训练部分,将提供更多的结果和对此的分析。

3 实验与分析

为了评估模型性能,本研究基于城市景观数据集进行了综合实验。在本章中,首先会介绍数据集和相关的实现细节;然后针对核心模块MAFM进行了多组对比实验,包括在不同骨干网上添加MAFM模块,不同输入通道数时在编码器和解码器的不同位置上添加MAFM模块,以及在城市驾驶场景的不同目标上进行了分割精度的验证;最后,将插入MAFM模块形成的MANet分割结果进行了可视化,并与其他分割网络进行对比,说明模型的有效性。

3.1 数据集介绍

实验采用的数据集为针对自动驾驶开发的城市景观数据集cityscapes[28]。这是一个大规模的关注于城市街道场景理解的数据集,以车载视角拍摄高分辨率图片,包含50个城市不同场景、不同背景、不同季节的街景。有5 000张精细标注数据以及20 000张粗糙标注数据。本文采用精细标注数据进行训练和测试,包括来自16个城市共2 975张训练图,以及来自其他3个城市的500张测试图。语义标签分为19类,每张图像的分辨率为2 048×1 024。输入网络前,裁剪大小为768×768。为了避免过拟合,对数据集使用了随机缩放、水平翻转、高斯模糊、颜色抖动和图像裁剪等方法进行数据增强。

3.2 优化器

本研究采用SGD优化器,初始学习率为0.01,动量为0.9,权重衰减为1E-4。采用多项式学习率衰减策略:

其中:lr为初始学习率;lrend为终止训练时的学习率,这里为0; sglobal和smax分别为当前迭代次数和总迭代次数,可以根据训练环境进行手动调整;power设置为0.9。研究使用两个TITAN RTX-24 GB GPU进行训练,批次处理大小为4。

3.3 评估标准

评价指标采用mIoU(平均交并比):

3.4 MAFM对比实验

3.4.1 骨干网与MAFM的融合

在不同骨干网解码器上添加MAFM模块,以证明模块的广泛性。各网络添加MAFM前后性能对比如表1所示。其中,Params代表模型參数,用来衡量模型的大小。GMACs代表点乘运算量,用来衡量模型的复杂度。

实验表明,单个MAFM模块的引入给模型带来的新参数不足1 M,在不同骨干网上均能取得一定提升。在ResNet101上,mIoU提升达到了1.18,同时点乘操作仅增加4.50%。

3.4.2 编解码器与MAFM的融合

本研究采用ResNet101作为骨干网,输出步幅output_stride=8,研究MAFM插入网络时不同输入通道数k以及插入的不同位置对网络性能的影响,在城市景观数据集的验证集上进行消融实验。

在不同输入通道数的实验中,均采用MAFM模块在编解码器同时融合的情况,对64、128、256、512四种通道数进行了对比,实验结果如表2所示。实验表明,当MAFM输入通道数k为256时,模块性能到达峰值,mIoU从79.58提升到81.01。

在不同位置添加MAFM的实验中,分别研究了256输入通道下编码器融合、解码器融合与同时融合三种情况,实验结果如表3所示。

实验发现,每个位置均对网络性能有所提升。从单个部位看,编码器上加入MAFM时,参数量增加1.18 M,mIoU相比基线架构从79.58%提升至80.51%;在解码器上加入MAFM时,参数量比同条件下编码器降低0.45 M,mIoU提升至80.76%。当编码器、解码器同时和MAFM融合时,mIoU获得了进一步提升,相比基线架构提升1.53%,且叠加模块时参数量增长为线性。这意味着在同一网络中多次使用模块时不会产生参数量爆炸性增长的情况。

3.4.3 MAFM对不同分割目标的影响

表4展示了基线网络添加MAFM模块前后的语义分割结果,均使用城市景观数据集的训练集训练,在验证集上测试每个类别的详细mIoU。基线网络是以ResNet101作为骨干网,将第一层1个7×7卷积替换为3个3×3卷积,并添加了辅助交叉熵损失的DeepLab v3+网络。在其他类别准确率没有明显下降的前提下,多维注意力融合模块在提高柱状、条状物体的分割准确率方面成效显著。典型条状物如栅栏,柱子分别取得了2.9%和1.8%的提升;墙体、交通灯、交通标识、地面等形状较为规则的物体也取得了优秀的分割结果,较基线网络分别提升了9.9%、2.0%、1.9%、1.8%。此外,“人”的分割结果也有所提升,如行人、骑行者,均在原有基础上提升了1%;一些大面积分割目标如道路、建筑、天空等基本与基线保持相同水平。

3.5 MANet可视化分析

为了说明MANet在城市驾驶场景中比起传统语义分割网络具有更好的应用能力,对场景分割预测结果和分割边缘分别进行了可视化实验,并与DeepLab v3+的可视化结果进行比较。

场景分割预测可视化如图6所示(改善明显的区域已用红框标注,参见电子版)。由图(a)可以看出,MANet上下文关联度增强,分割结果更加明显且完整,切割边缘较基线更加平滑。由图(b)可以看出,对于和背景混淆度较高的目标,由于MANet中多维注意力的加入,建立了长程语义关联,能够更好地和背景实现分离,即使是比较细小的目标物(如路标杆、电线杆等)也能在像素级别上准确捕捉到。图(c)中的“植被”与“人行道”距离较近,形状相似,且亮度较低,极易产生错误判断,但MANet可以较为准确地将两者进行分割。由图(d)可以说明,MANet还可以区别出重叠度较高的不同目标,如同一个区域中的“骑行者”与“行人”,而DeepLab v3+有概率产生混淆,可能会造成误判,在驾驶场景中此类误判往往会带来安全隐患。

分割边缘可视化如图7所示,图中线条越细、越光滑,说明分割效果越好。由图中蓝框部分可以看出,DeepLab v3+的分割存在块状缺失,当目标中间有遮挡时,可能会将一个目标判断成多个;本文的MANet分割边缘精确度更高,修复了原网络存在的较大面积分割错误,对于重叠和遮挡的鲁棒性较强。

3.6 MANet性能对比

MANet和其他同样使用注意力机制的网络性能评估如表5所示,表中模型均采用ResNet-101作为骨干网,输入特征图大小为4×3×768×768。

和以往注意力机制相比,许多注意力机制因为本身计算量过大的问题,只能采用深度卷积模型,以骨干网与注意力模块串联的方式输出特征图。DANet和CCNet以经典的残差网络作为骨干网,后接注意力分支,经过特征融合得到输出特征图。该种结构限制了注意力机制的作用位置,只能在网络的特定位置插入并作用于网络训练。而MANet中的注意力机制更趋近于模块化,和DANet中的注意力方法相比,节约了约90%的参数量以及80%的计算量;在点乘量和CCNet保持同一数量级的基础上,参数量削减约10倍,mIoU提升0.5%,且多个MAFM的叠加不会带来计算量的指数增长。这意味着MAFM可以作为一种灵活调整的模块应用于各种网络。

不同模型预测结果对比如表6所示。

模型均采用ResNet-101作为骨干网络,使用城市景观数据集中的精细训练集训练。和其他使用相同骨干网的语义分割网络相比,添加了MAFM后构建的MANet在城市景观数据集上取得了较为先进的结果。由此可见,在传统注意力机制的思想基础上,MAFM结构的创新和计算资源的削减不会对语义分割的效果产生影响,并且取得了一定的提升,体现了良好的综合性能。

4 结束语

本文提出了一种可作为驾驶场景分割应用的语义分割增强算法。利用条状分维度注意力机制分别得到特征图高度和宽度上的注意力权重,并进行空间域和通道域上注意力的融合,形成轻量化的MAFM模块。该模块可以添加到不同骨干网的不同位置,在ResNet101上提升较高。模块输入通道数k为256时性能最好,且在编码器与解码器中同样有效,说明了模块的灵活性与广泛性。最后展示的各网络mIoU对比数据以及对特征图的可视化表明,MAFM使用参数少,模型简单,插入MAFM构建的语义分割网络MANet可以对远程上下文依赖性较大的物体产生更好的预测结果,且综合性能较为优秀。一般的注意力机制为达到更高的准确率,耗费计算资源大,网络训练时间久,但是在驾驶等应用场景中,计算速度与准确率需要同时满足一定要求。本研究目的在于缓解算力与精确度之间的矛盾,探究一种实用的注意力机制,并为语义分割网络在应用方面的研究打下基础。

参考文献:

[1]林正春,王知衍,张艳青.最优进化图像阈值分割算法[J].计算机辅助设计与图形学学报,2010,22(7):1202-1206.(Lin Zhengchun,Wang Zhiyan,Zhang Yanqing.Optimal evolution algorithm for image thresholding[J].Journal of Computer-Aided Design and Computer Graphics,2010,22(7):1202-1206.)

[2]Wang Shitong,Chung Fulai,Xiong Fusong.A novel image thresholding method based on Parzen window estimate[J].Pattern Recognition:the Journal of the Pattern Recognition Society,2008,41(1):117-129.

[3]季虎,孙即祥,邵晓芳,等.图像边缘提取方法及展望[J].计算机工程与应用,2004,40(14):70-73.(Ji Hu,Sun Jixiang,Shao Xiaofang,et al.The algorithm for image edge detection and prospect[J].Computer Engineering and Applications,2004,40(14):70-73.)

[4]段瑞玲,李慶祥,李玉和.图像边缘检测方法研究综述[J].光学技术,2005,31(3):415-419.(Duan Ruiling,Li Qingxiang,Li Yuhe.Summary of image edge detection[J].Optical Technique,2005,31(3):415-419.)

[5]Ronneberger O,Fischer P,Brox T.U-Net:convolutional networks for biomedical image segmentation[C]//Proc of International Conference on Medical Image Computing and Computer-Assisted Intervention.Cham:Springer,2015:234-241.

[6]张墺琦,亢宇鑫,武卓越,等.基于多尺度特征和注意力机制的肝脏组织病理图像语义分割网络[J].模式识别与人工智能,2021,34(4):375-384.(Zhang Aoqi,Kang Yuxin,Wu Zhuoyue,et al.Semantic segmentation network of pathological images of liver tissue based on multi-scale feature and attention mechanism[J].Pattern Recognition and Artificial Intelligence,2021,34(4):375-384.)

[7]Murali S,Govindan V K,Kalady S.Single image shadow removal by optimization using non-shadow anchor values[J].Computational Visual Media,2019,5(3):311-324.

[8]朱浩,谷小婧,蓝鑫,等.基于多尺度轮廓增强的RGB-IR双波段图像语义分割算法[J].激光与红外,2022,52(4):543-551.(Zhu Hao,Gu Xiaojing,Lan Xin,et al.RGB-IR semantic segmentation based on multi-scale edge enhancement[J].Laser and Infrared,2022,52(4):543-551.)

[9]Krizhevsky A,Sutskever I,Hinton G E.ImageNet classification with deep convolutional neural networks[J].Communications of the ACM,2017,60(6):84-90.

[10]Yu F,Koltun V.Multi-scale context aggregation by dilated convolutions[EB/OL].(2016-04-30)[2023-03-01].https://doi.org/10.48550/arXiv.1511.07122.

[11]Wang Panqu,Chen Pengfei,Yuan Ye,et al.Understanding convolution for semantic segmentation[C]//Proc of Winter Conference on Applications of Computer Vision.Piscataway,NJ:IEEE Press,2018:1451-1460.

[12]趙迪,孙鹏,陈奕博,等.基于高度有效驱动注意力与多层级特征融合的城市街景语义分割[J].光电子·激光,2022,33(10):1038-1046.(Zhao Di,Sun Peng,Chen Yibo,et al.Urban street view semantic segmentation based on height-driven effective attention and multi-stage feature fusion[J].Journal of Optoelectronics·Laser,2022,33(10):1038-1046.)

[13]Zhu Lanyun,Ji Deyi,Zhu Shiping,et al.Learning statistical texture for semantic segmentation[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2021:12537-12546.

[14]Hu Jie,Shen Li,Sun Gang.Squeeze-and-excitation networks[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Re-cognition.Piscataway,NJ:IEEE Press,2018:7132-7141.

[15]Wang Qilong,Wu Banggu,Zhu Pengfei,et al.ECA-Net:efficient channel attention for deep convolutional neural networks[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2020:11531-11539.

[16]Woo S,Park J,Lee J Y,et al.CBAM:convolutional block attention module[C]//Proc of European Conference on Computer Vision.Cham:Springer,2018:3-19.

[17]Wang Xiaolong,Girshick R,Gupta A,et al.Non-local neural networks[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2018:7794-7803.

[18]Fu Jun,Liu Jing,Tian Haijie,et al.Dual attention network for scene segmentation[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2019:3146-3154.

[19]苏晓东,李世洲,赵佳圆,等.基于多级叠加和注意力机制的图像语义分割方法[J/OL].计算机工程,2023.https://doi.org/10.19678/j.issn.1000-3428.0065940.(Su Xiaodong,Li Shizhou,Zhao Jiayuan,et al.Image semantic segmentation based on multi-level overlay and attention mechanism[J/OL].Computer Engineering,2023.https://doi.org/10.19678/j.issn.1000-3428.0065940.)

[20]Chen L C,Zhu Yukun,Papandreou G,et al.Encoder-decoder with atrous separable convolution for semantic image segmentation[C]//Proc of European Conference on Computer Vision.Cham:Springer,2018:801-818.

[21]Chen L C,Papandreou G,Schroff F,et al.Rethinking atrous convolution for semantic image segmentation[EB/OL].(2017-12-05)[2023-03-01].https://doi.org/10.48550/arXiv.1706.05587.

[22]Yu Changqian,Wang Jingbo,Peng Chao,et al.BiSeNet:bilateral segmentation network for real-time semantic segmentation[C]//Proc of European Conference on Computer Vision.Cham:Springer,2018:325-341.

[23]Yu Changqian,Gao Changxin,Wang Jingbo,et al.BiSeNet v2:bilateral network with guided aggregation for real-time semantic segmentation[J].International Journal of Computer Vision,2021,129(11):3051-3068.

[24]Li Hanchao,Xiong Pengfei,Fan Haoqiang,et al.DFANet:deep feature aggregation for real-time semantic segmentation[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Los Alamitos:IEEE Computer Society,2019:9522-9531.

[25]Yang Kailun,Zhang Jiaming,Rei S,et al.Capturing omni-range context for omnidirectional segmentation[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Washington DC:IEEE Computer Society,2021:1376-1386.

[26]梁新宇,权冀川,杨辉,等.多尺度特征提取和多层次注意力机制的迷彩伪装目标分割算法[J].计算机辅助设计与图形学学报,2022,34(5):683-692.(Liang Xinyu,Quan Jichuan,Yang Hui,et al.Ca-mouflage target segmentation algorithm using multi-Scale feature extraction and multi-level attention mechanism[J].Journal of Computer-Aided Design and Computer Graphics,2022,34(5):683-692.)

[27]Huang Zilong,Wang Xinggang,Huang Lichao,et al.CCNet:criss-cross attention for semantic segmentation[C]//Proc of IEEE/CVF International Conference on Computer Vision.Washington DC:IEEE Computer Society,2019:603-612.

[28]Cordts M,Omran M,Ramos S,et al.The cityscapes dataset for semantic urban scene understanding[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2016:3213-3223.

[29]Ma Ningning,Zhang Xiangyu,Zheng H T,et al.ShuffleNetV2:practical guidelines for efficient CNN architecture design[C]//Proc of European Conference on Computer Vision.Cham:Springer,2018:116-131.

[30]He Kaiming,Zhang Xiangyu,Ren Shaoqing,et al.Deep residual lear-ning for image recognition[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2016:770-778.

[31]Zagoruyko S,Komodakis N.Wide residual networks[EB/OL].(2017-06-14)[2023-03-01].https://doi.org/10.48550/arXiv.1605.07146.

[32]Zhang Fan,Chen Yanqin,Li Zhihang,et al.ACFNet:attentional class feature network for semantic segmentation[C]//Proc of IEEE/CVF International Conference on Computer Vision.Washington DC:IEEE Computer Society,2019:6798-6807.

[33]Li Xiangtai,You Ansheng,Zhu Zhen,et al.Semantic flow for fast and accurate scene parsing[C]//Proc of European Conference on Computer Vision.Cham:Springer,2020:775-793.

[34]Choi S,Kim J T,Choo J.Cars cant fly up in the sky:improving urban-scene segmentation via height-driven attention networks[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Re-cognition.Washington DC:IEEE Computer Society,2020:9370-9380.

收稿日期:2023-01-08;修回日期:2023-03-06基金項目:国家自然科学基金资助项目(U1866209,61772162)

作者简介:刘奕晨(1998-),女,浙江杭州人,硕士,主要研究方向为计算机视觉、人工智能图像处理;章坚武(1961-),男(通信作者),浙江杭州人,博导,博士,主要研究方向为移动通信、多媒体信号处理与人工智能、通信网络与信息安全(jwzhang@hdu.edu.cn);胡晶(1982-),女,浙江宇视科技有限公司高级工程师,总裁办主任,主要研究方向为人工智能、物联网.