IntSE:特征增强的知识图谱补全方法

周 新,郭敬楠,宁 博,李冠宇

(大连海事大学 信息科学技术学院,辽宁 大连 116026)

1 引 言

近年来,以Freebase,WordNet为代表的大型知识图谱在信息检索、知识问答和推荐系统等领域取得了广泛应用[1-3],其强大的语义处理能力和知识泛化能力为数据提供了一种新的表达和管理方式.知识图谱是事实三元组(头实体,关系,尾实体)的图表示,其中节点代表实体,边代表实体间关系.尽管大型知识图谱已经包含数亿万个实体和关系,它们仍存在不完整的困扰,Freebase的300万人中71%的实体没有出生地,75%的实体没有国籍,94%的实体缺少父母信息[4].链接预测任务就是为了提高知识图谱的完整性,根据知识图谱中的已知事实预测三元组的缺失部分.

嵌入模型学习实体和关系的低维向量或矩阵表示,是链接预测任务的主流方案.嵌入模型主要分为翻译模型(TransE[5]、TransH[6]、TransAH[7]、TransR[8]、TransD[9]等)、双线性及张量模型(DistMult[10]、SimplE[11]、TuckER[12]等)、神经网络模型(NTN[13]、ER-MLP[14]、ConvE[15]、ConvKB[16]、Conv-TransE[17]、InteractE[18]等)、复数向量模型(ComplEx[19]、RotatE[20]、QuatE[21]等).其中,卷积神经网络(Convolutional Neural Networks,CNN)模型具有较强的表达能力和泛化能力是近年的研究热点,同时也是本文的关注焦点.InteractE证实增加实体和关系嵌入分量的交互有助于提高知识图谱补全性能.InteractE通过特征排列、棋盘结构特征重塑和循环卷积3个核心操作增强ConvE模型的表达能力,是目前性能最优的卷积神经网络嵌入模型.

InteractE的棋盘结构增加实体和关系嵌入分量间的特征交互,提高模型表达能力,但棋盘结构同时破坏了原有实体和关系嵌入分量间的空间结构信息,本文将SENet[22](Squeeze-and-Excitation Network)应用到InteractE中,提出了改进 InteractE的知识图谱补全模型——IntSE.IntSE保留了InteractE的优点,同时SENet的引入增强了InteractE卷积得到的有用特征,抑制无用特征.

本文主要贡献如下:

1)提出改进InteractE的卷积神经网络嵌入模型——IntSE.IntSE在InteractE的卷积层之后,对输出的特征映射应用SENet做特征校准从而增强有用的特征,抑制无用的特征.

2)为了适应知识图谱补全,本文改进了SENet原型的门机制,提高了模型的表达能力,降低模型过拟合,同时减少参数量和计算代价.

3)基于FB15k-237和WN18RR两种数据集的实验结果表明,IntSE提升了InteractE的性能,优于主流的CNN嵌入模型.

2 相关工作

2.1 非神经网络模型

知识图谱嵌入学习实体和关系在连续低维向量空间中的嵌入表示.经典的嵌入模型始于TransE,将关系嵌入视为头实体嵌入到尾实体嵌入的一种平移,利用平移不变性,表示实体和关系之间的关联.TransE模型仅适用一对一的关系类别,对于一对多,多对一,多对多关系类别,TransE的性能会大打折扣.针对该问题,研究者进一步提出TransH、TransAH、TransR、TransD等模型,从不同的方面对TransE进行改进.不同于TransE系列模型用向量和全矩阵表达关系,DistMult系列模型用对角矩阵表达关系来简化模型,而ComplEx系列模型是DistMult在复数域上的拓展,可以更好地对非对称关系进行建模.Nguyen等人[23]和LIU等人[24]系统综述了知识图谱补全的嵌入模型.

2.2 神经网络模型

NTN用双线性张量表示关系,关联头实体嵌入和尾实体嵌入.ER-MLP将头实体嵌入、关系嵌入和尾实体嵌入联接起来送入一个单层MLP中.因卷积操作具有参数共享、泛化能力强、控制过拟合和鲁棒性强的优点,CNN也被用于知识图谱补全.ConvE将头实体嵌入和关系嵌入分别重组后堆叠在一起送入2D 卷积层,提取实体和关系的语义特征,生成的特征映射向量化,投影到尾实体的嵌入空间,通过内积和所有的候选尾实体嵌入进行匹配.Conv-TransE认为ConvE中实体和关系嵌入的重组破坏嵌入向量的平移不变性,Conv-TransE移除了ConvE中的嵌入向量重组操作,直接将已知实体和关系嵌入拼接放入卷积层,其余流程和ConvE一致,Conv-TransE可以看作ConvE的一个变种.ConvKB是另一种卷积神经网络嵌入模型,将头实体嵌入、关系嵌入和尾实体嵌入堆叠成矩阵M,并用1×3大小的卷积核作用于M转置后的每一维向量.由于ConvKB的性能在不同数据集和评估标准表现不一致,其成果具有争议性,本文不作实验进行对比.InteractE发现ConvE堆叠式的嵌入重组(如图1(a)所示)限制了实体和关系的特征交互,增加实体和关系嵌入的特征交互有利于提升补全效果,InteractE将实体和关系嵌入重组为棋盘结构(如图1(b)所示),同时用循环卷积增强边缘特征交互,是目前链接预测性能最好的卷积神经网络嵌入模型.

图1 不同的重组方式Fig.1 Different types of reshaping way

图2 SENet结构图Fig.2 Architecture of SENet model

3 背景知识

3.1 知识图谱

知识图谱是事实三元组(头实体,关系,尾实体)的集合,形式化表示如下:

KG={(s,r,o)}⊆ε×R×ε

其中,s∈ε表示三元组中的头实体,o∈ε表示三元组中的尾实体,r∈R表示三元组中实体间的关系.

3.2 链接预测

链接预测任务是预测三元组(s,r,o)中缺失的实体,如给定(s,r,?)预测o或给定(?,r,o)预测s.链接预测问题可以形式化表示为单样本的排序学习问题.基于嵌入的链接预测方法包含两个关键组件:a)编码组件:编码组件映射头实体s、关系r、尾实体o到相应的K维分布式嵌入表示es、er、eo,es,er,eo∈K;b)打分组件:打分组件衡量三元组的真实性.链接预测的目标是学习一个关于实体和关系嵌入的打分函数Ψ,使得事实三元组(s,r,o)的得分Ψ(s,r,o)高于非事实三元组(s′,r,o′)的得分Ψ(s′,r,o′).

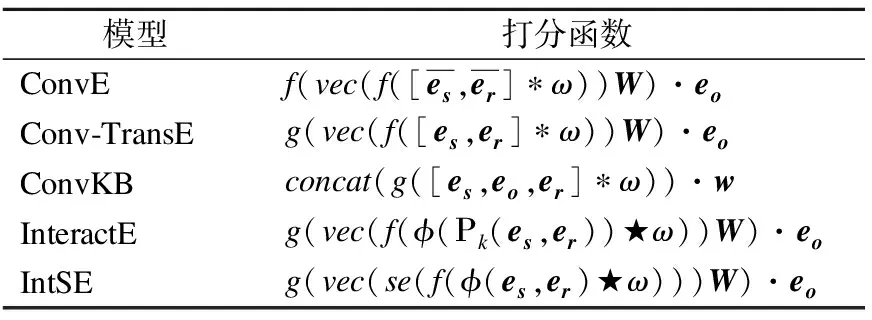

表1总结了CNN嵌入模型的打分函数.表2列出本文使用的函数符号及其含义.

表1 CNN嵌入模型的打分函数Table 1 Score function of CNN embedding model

表2 函数符号及其含义Table 2 Function symbols and their meanings

4 IntSE模型

4.1 IntSE模型

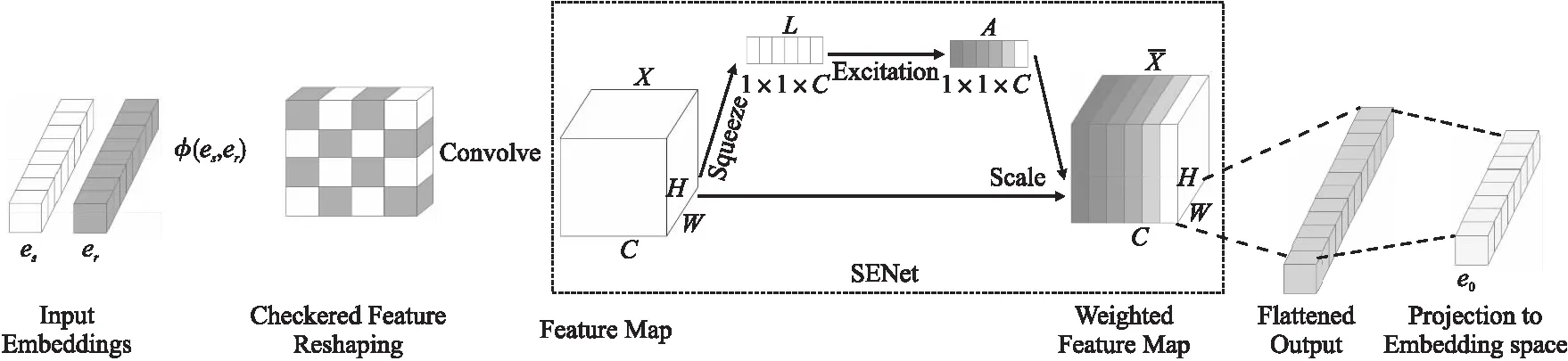

IntSE在InteractE的基础上增加了SENet,保留了InteractE优点的同时,增强了卷积通道中的有用特征,抑制了无用特征.IntSE的架构如图3所示,打分函数如式(1)所示:

图3 IntSE模型的结构图Fig.3 Architecture of IntSE model

Ψ(s,r,o)=g(vec(se(f(φ(es,er)★ω)))W)·eo

(1)

对于输入的实体嵌入向量es和关系嵌入向量er,IntSE先将es和er重组为棋盘式矩阵φ(es,er)∈m×n,其中m×n=2K,然后将其送入一个2D的循环卷积层,卷积层输出一个特征映射张量X=(x1,x2,…,xC)∈H×W×C,其中xi∈H×W×1代表第i个通道的特征映射,H和W和代表特征映射的大小,C代表通道总数.X被送入SENet进行特征校准,生成校准后的特征映射张量H×W×C,接着被向量化HWC,使用参数矩阵为W∈HWC×K的线性转换投影到K维向量空间,最后通过內积操作匹配尾实体嵌入eo.

为了训练模型参数,本文将带有标签平滑的二元交叉熵作为损失函数,如式(2)所示:

(2)

其中p=sigmoid(Ψ(s,r,o)),t为平滑标签,本文使用Adam作为优化器,并使用标签平滑来减少由于输出非线性饱和而导致的过拟合.

SENet显式定义特征通道间的关联,通过自学习各个通道的权重对特征通道信息进行筛选,增强有益特征,抑制无用特征.实验显示在InteractE中加入SENet原型能够提升链接预测的效果,然而收效有限.4.2小节对SENet做了适当改进,进一步提升链接预测的准确性.

4.2 改进的SENet

SENet原型如图2(a)所示,SENet的操作流程如下:

1)压缩(Squeeze):SENet 对输入张量X的每个特征通道做全局平均池化(Global Average Pooling,GAP),从而获取每个特征通道的统计信息.聚集C个特征通道的统计信息形成压缩的特征张量L∈1×1×C,L包含所有特征的全局信息.

2)激励(Excitation):为了利用L中的全局信息捕捉通道间的依赖,SENet设计了Sigmoid激励函数获得归一化权重系统的门机制,生成每个特征通道相对应的权重系数A∈1×1×C.门机制由1个全连接降维层,1个Relu激活层和1个全连接升维层构成,式(3)给出相应的函数表示:

A=g(W2(f(W1L)))

(3)

其中,f为Relu函数,g为Sigmoid函数.W1∈C/q×C,W2∈C×C/q被学习用来显式地建模特征通道间的相关性,q为维度约减因子.

(4)

SENet的门机制使用两个全连接层夹Relu的瓶颈结构,全连接层具有参数量大、容易过拟合、丢失特征映射的空间信息等不足.本文重新设计了门机制,将全连接层改为1×1的卷积层,增加Dropout避免过拟合.改进的SENet如图2(b)所示,生成的特征通道权重系数如式(5)所示:

A=g(f(f(L*ω1)*ω2))

(5)

其中*代表标准卷积操作,ω1和ω2为1×1为大小的卷积核,ω1个数为C/q,ω2个数为C.

相比SENet原型,改进的SENet具有更多的非线性,表达能力更高,同时对过拟合有较强的鲁棒性,卷积层具有与全连接层相同的输出效果,但减少参数量,提高了计算效率,并且输入和输出具有相对应的空间结构,避免了信息的流失,实验结果显示,改进的SENet更加适合链接预测任务.

5 实 验

5.1 数据集

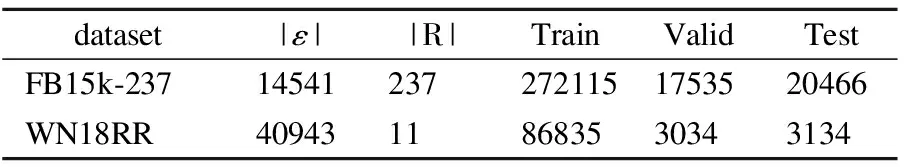

实验使用两个链接预测最常用的数据集进行评估,分别为FB15k-237和WN18RR,其中FB15k-237是从Freebase衍生出来的FB15k数据集的改进版本,删除了FB15k中所有反转关系,以防止通过反向训练三元组直接推断出测试三元组.WN18RR是从WordNet衍生出来的WN18数据集的一个子集,删除了与FB15k-237相似的逆关系.两种数据集的数据特征如表3所示.

表3 数据集统计Table 3 Statistics of datasets

5.2 评估标准

本文采用链接预测常用的4个评估标准MR,MRR,Hits@1和Hits@10衡量实验结果,MR表示正确实体的平均排名,MRR是正确实体的平均倒数排名,Hits@1是正确实体排名第1所占的百分比,Hits@10是正确实体排名前10所占的百分比.在4个指标中,MR越低越好,MRR,Hits@1和Hits@10越高越好.

“听、说、读、写”是学生英语核心素养的具体内容,在新时期提高核心素养是新时期教学发展过程中培养学生的重点任务之一,尤其是在阅读教学中,要充分利用阅读教学的多样性,对学生的核心素养进行全面的培养。同时要对教学现状进行全面分析,找到其中存在的问题,在实践中找到解决问题的措施,从而提高学生核心素养,全面提升学生综合素质,实现学生的全面发展。

5.3 参数设置

设置超参数范围如下:实体和关系嵌入维度设置为κ∈{100,200},2D卷积层中卷积核大小设置为λ∈{5,7,9,11},学习率为γ∈{0.01,0.001,0.005,0.0001},SENet的维度约减因子设置1/q∈{1/2,1/4,1/8,1/16},此外实验还使用批量标准化和Dropout来控制过拟合.本文通过超参数网格搜索法训练模型500次,根据验证集上的MRR来选择本文模型的最优超参数[15,18],在FB15k-237数据集上,最优参数设置为:κ=200,γ=0.0001,λ=9,1/q=1/4,批次大小为128.在WN18RR上,最优参数设置为:κ=200,γ=0.001,λ=11,1/q=1/8,批次大小为256.

5.4 实验分析

本文将IntSE与ConvE,Conv-TransE和InteractE进行对比,对比模型的实验结果摘自于原论文.Interact-SENet表示在InteractE加入SENet原型的模型.

5.4.1 数据集对模型准确性的影响

FB15k-237和WN18RR数据集上的实验结果如表4和表5所示.

表4 各模型在FB15k-237数据集上的实验结果Table 4 Experimental results of models on FB15k-237 dataset

表5 各模型在WN18RR数据集上的实验结果Table 5 Experimental results of models on WN18RR dataset

5.4.2 关系类别对模型准确性的影响

为了进一步验证IntSE模型的有效性,本文在FB15k-237数据集上评估模型在不同关系类别的链接预测性能.

选择FB15k-237进行分析是因为该数据集的关系更多样化.基于每个头实体的平均尾实体数和每个尾实体的平均头实体数,将关系分为4类:一对一,一对多,多对一,多对多.使用同为卷积神经网络补全模型的ConvE和InteractE作为对比试验,以MRR和Hits@10作为评估标准[9],表6展示了链接预测的实验结果.从表6可以发现,IntSE在四种关系类别上都获得了比ConvE和InteractE更好的性能,无论是应对简单的关系类别(如一对一),还是在复杂关系类别(如一对多,多对多)都达到最优效果.再次验证了IntSE具有较好的鲁棒性,适用于包含各种关系类别的链接预测任务.

表6 FB15k-237数据集上按关系类别的实验结果Table 6 Experimental results by relation category on FB15k-237 dataset

6 结束语

本文提出改进InteractE的模型——IntSE,通过改进的SENet捕捉InteractE模型中对知识图谱补全重要的特征交互信息,从而增强InteractE中的有用特征,提升知识图谱补全的效果.实验验证,相较于SENet原型,改进的SENet对知识图谱补全有更大的帮助,相较于其他主流的CNN嵌入模型,IntSE在多种评估标准下达到最优性能.在今后的研究中,我们将探索SENet的其他改进版能否提升InteractE的效果,同时进一步地探索如何提升实体和关系之间的有效特征交互.