基于改进模糊C均值聚类的图像融合算法

巩稼民,吴艺杰,刘 芳,张运生,雷舒陶,朱泽昊

〈图像处理与仿真〉

基于改进模糊C均值聚类的图像融合算法

巩稼民,吴艺杰,刘 芳,张运生,雷舒陶,朱泽昊

(西安邮电大学 通信与信息工程学院,陕西 西安 710061)

为了更好地突出红外与可见光融合图像中的目标信息,保留更多的纹理细节信息,提出了一种基于非下采样剪切波变换(non-subsample shearlet transform,NSST)域结合脉冲发放皮层模型(spiking cortical model,SCM)与改进的模糊C均值聚类(fuzzy C-means clustering,FCM)的红外与可见光图像融合算法。首先,用改进的FCM提取源红外图像中的红外目标信息;然后,将得到的红外图像与可见光图像的目标区域和背景区域进行NSST分解,得到各自的高低频子带图像;接着,对得到的不同区域采用不同的融合策略,其中,对于高频背景区域采用SCM模型与改进赋时矩阵进行融合;最后,使用NSST逆变换,得到最终的融合图像。仿真实验证明,与其他方法相比,本文算法得到的融合图像在主观视觉上红外目标信息突出,纹理细节信息丰富,在客观评价上,其信息熵和边缘保留因子达到最优。

图像融合;非下采样剪切波变换;脉冲发放皮层模型;模糊C均值聚类;赋时矩阵

0 引言

红外与可见光图像融合可以将红外图像的目标信息与可见光图像的纹理细节信息有效结合[1],得到信息更加丰富的融合图像,实现对场景更加全面准确的表达,这在医学成像、军事侦察、安全监测、人脸识别、森林消防等领域广泛应用[2]。而目前的红外与可见光图像融合算法中,仍存在以下问题:①红外目标信息不够突出,且目标人物周围易出现光晕;②边缘细节信息不够丰富,容易丢失。

像素级融合因图像失真率最小而被广泛应用于红外与可见光图像融合中。像素级的图像融合方法主要分为两大类:空间域和变换域[3]。而多尺度几何变换中的非下采样剪切波变换(non-subsample shearlet transform,NSST),由于具有计算复杂度小,且耗时较少等优点,被广泛应用在图像分割及图像融合领域。符合人眼视觉特征的脉冲发放皮层神经元网络(spiking cortical model,SCM),也被广泛应用于图像融合领域,将NSST与SCM结合的图像融合算法更是近些年的研究热门。如江泽涛[4]等提出了一种结合NSST和双通道SCM模型的图像融合算法,使用双通道的SCM模型对高频分量进行融合,得到了效果较好的融合图像,但融合图像的标准差较低,红外目标信息不够突出且周围容易出现光晕。

为了使目标信息更加突出,基于模糊聚类的图像融合方法被广泛提出,使用模糊聚类的方法可对图像进行目标提取,使图像的目标区域与背景区域分离,进而针对其各自特点进行融合。如李玉峰[5]等提出了一种采用非下采样轮廓波变换和FCM相结合的图像融合算法,采用FCM提取SAR图像的目标区域,取得了不错的融合效果,但非下采样轮廓波变换计算复杂度较大,对于时间的消耗较大,影响了融合效率。巩稼民[6]等提出了一种基于NSST与FCM的红外与可见光图像融合方法,获得了目标突出、背景清晰的融合图像,但仅使用FCM对于红外高频图像进行分解,忽视了红外低频图像的目标信息。因此,本文在此基础上进行了改进。

与传统方法先用NSST对图像进行分解,然后只在高频图像中提取红外目标信息的方法不同,本文提出的算法先使用改进的FCM对红外图像进行分割,提取红外目标后再使用NSST分解,使得源红外图像中的目标信息得到更完整的保留,然后针对不同的区域的不同特点,采用不同的融合规则,从而改善融合图像中目标信息不够突出,纹理细节信息不够丰富的问题。

1 基本原理

1.1 非下采样剪切波变换

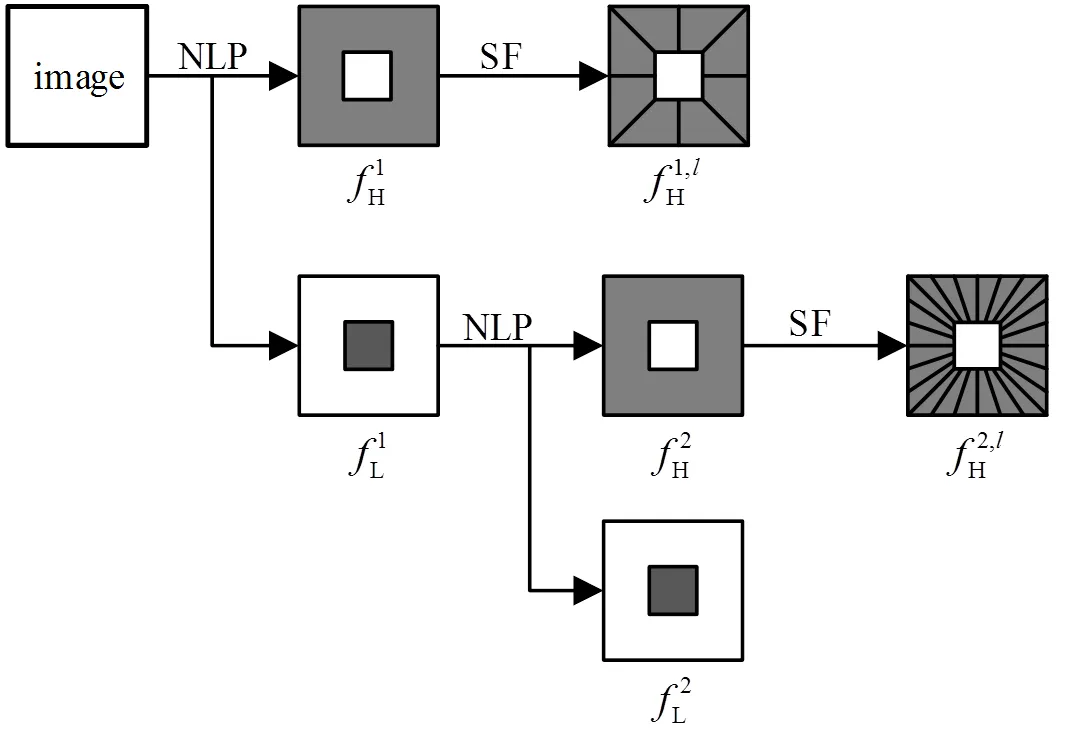

非下采样剪切波变换[7](NSST)是对剪切波变换的改进,在继承剪切波变换优点的同时,避免了伪吉布斯现象的出现。使用NSST将红外与可见光图像分解成各自的高低频子带图像,可避免其分解和重构过程中产生的频率混叠现象[8],消耗的时间相对来说较少。图像具体的NSST分解步骤如图1所示。

第一步:源图像经非下采样拉普拉斯金字塔变换(non-subsampled laplacian pyramid,NLP)分解(设分解层数为)得到一个低频子带图像和个高频子带图像。分解所得到的图像大小与源图像大小相同。

第二步:构造时域中的剪切波滤波器(shearlet filter,SF)。利用Meyer小波基来构造伪极化格上的频域窗函数,然后将其映射到笛卡尔坐标中,通过逆离散傅里叶变换得到最终的SF[9]。

第三步:对每个层的高频图像都构造一个相应的SF,通过卷积,得到在该尺度下所包含的各个方向的高频子带图像。

图1 NSST分解流程

图中NLP表示非下采样拉普拉斯金字塔变换;SF表示剪切波滤波器;表示子带图像系数;上标中的1,2表示第一层和第二层分解,表示个不同的方向。

1.2 脉冲发放皮层模型与赋时矩阵

脉冲发放皮层模型[10]SCM是从脉冲耦合神经元网络(pulse coupled neural network,PCNN)模型为切入点衍生出的简化模型。SCM不仅继承了PCNN适于人眼观察的优点,而且参数较少,计算复杂度较低,时间消耗较少,融合效率得以提高。

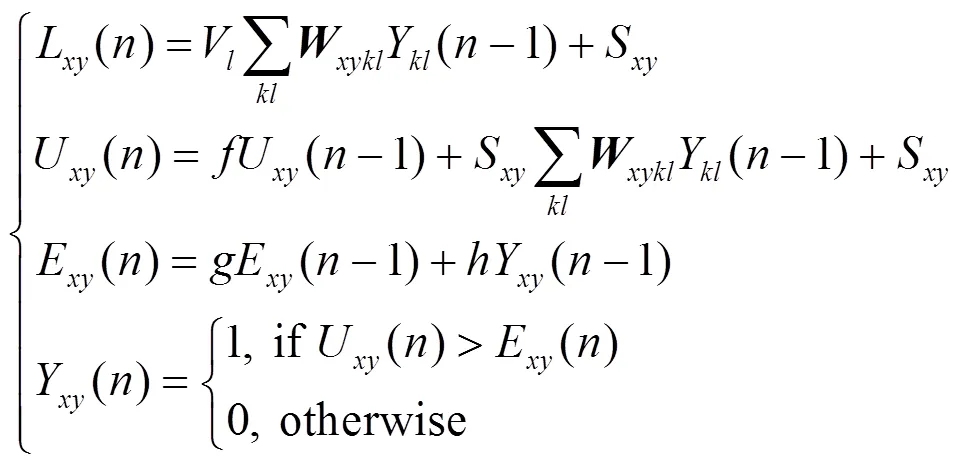

SCM模型的数学表达式如公式(1)所示:

式中:(,)为图像中像素点位置;为迭代次数;V为增益幅度;为连接权系数矩阵;Y为邻域神经元的输出;U()是神经元的内部行为;为控制U()的衰减的系数;S为神经元的外部激励;E()为动态阈值;和分别为阈值的衰减和放大系数。Y()表示第次迭代时,神经元的点火状态,当Y()=1时,称神经元点火[11]。

迭代次数的选择对于图像处理的结果起着重要作用,取值过大会增加计算量,耗费更多的时间,选择过小则会导致融合图像的视觉效果差[12]。为了得到合适的迭代次数,通常在SCM输出端加入一个赋时矩阵[13]来输出SCM第一次输出脉冲的时间,赋时矩阵的值即为迭代次数的值,但当外部输入激励S取值为0时,会导致SCM无法产生脉冲,从而使得添加赋时矩阵后进入无限迭代的过程。因此,对SCM的赋时矩阵进行了改进,添加一个判定条件:如果外部激励S为0,则直接输出赋时矩阵在对应位置处元素的值为无穷大。改进赋时矩阵()如下:

1.3 改进模糊C均值聚类FRFCM

由于模糊C均值聚类算法对噪声敏感,而传统方法常在目标函数中引入局部空间信息,但会导致计算复杂度变高,使得图像融合过程中目标提取的时间变长。因此引入雷涛提出的改进的模糊C均值聚类算法(fast and robust fuzzy C-means clustering,FRFCM)[14]进行目标提取,减少噪声对于图像的影响,增强算法的鲁棒性,同时提高目标提取的效率。

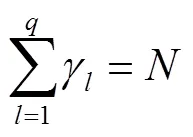

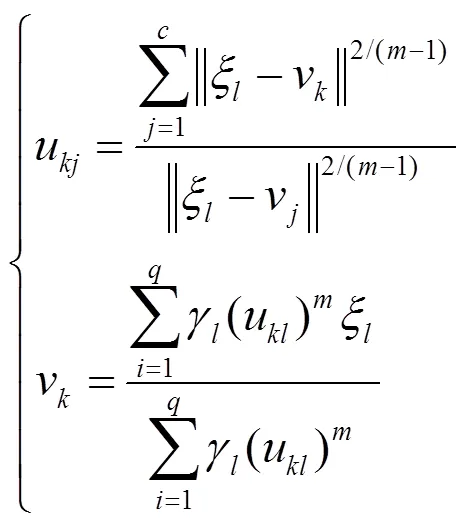

模糊C均值聚类通过得到每个样本点对所有类中心的隶属度来决定样本点的类属,从而达到分类的目的[15]。如果要通过FRFCM将样本数据划分为类,则可采用求解数学规划的方法来实现:

式中:表示聚类的数量;是每个模糊隶属度的加权指数,它决定了最终分类的模糊程度;u表示灰度值相对于聚类的模糊隶属度;v表示聚类中心;表示经形态重建后的图像中包含的灰度级的数量;远远小于。表示图像中第个灰度级,1≤≤;用来统计有效灰度级的级数,且其和为:

经形态重建后的图像定义如下:

=C() (5)

式中:C表示将图像进行形态闭合重建;表示原始图像。

上述已将FCM转化为求解数学规划的问题,要得到最终的聚类结果则需要求解这个数学规划,可利用拉格朗日乘子技术,将优化问题转换成使以下目标函数最小化的无约束优化问题:

式中:是拉格朗日乘数。因此,目标函数的最小化问题被转化为求上述拉格朗日函数的鞍点,该鞍点取FRFCM关于参数u和v的导数。方程组的具体表达式如下:

联立两个方程,可解得:

u=u(), ifx=(9)

为了获得更好的隶属度划分矩阵和加快算法的收敛速度,使用隶属度滤波来修改u。考虑到隶属度滤波的性能和算法速度之间的权衡,使用中值滤波器²:

²=med{¢} (10)

式中:med表示中值滤波。基于上述分析,引用的算法FRFCM可以总结如下:

①设定参数,包括聚类原型值、模糊化参数、滤波窗口的大小与结束时满足的阈值。

②使用公式(5)计算经形态重建后形成的新图像,然后计算的直方图。

③随机初始化隶属度划分矩阵。

④设置迭代次数=0。

⑤使用公式(8)更新聚类中心v和隶属度划分矩阵(t+1)。

⑥判断是否达到结束的条件,即是否满足max{(t)-(t+1)}<,若满足,则停止迭代,否则,设置=+1并跳回步骤⑤。

⑦使用公式(10)对隶属度划分矩阵¢进行中值滤波。

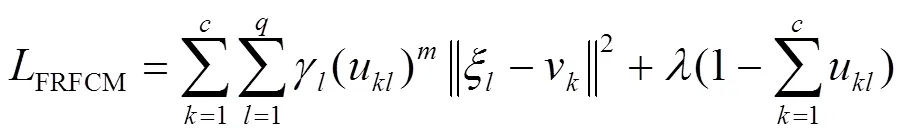

2 提出的融合方法

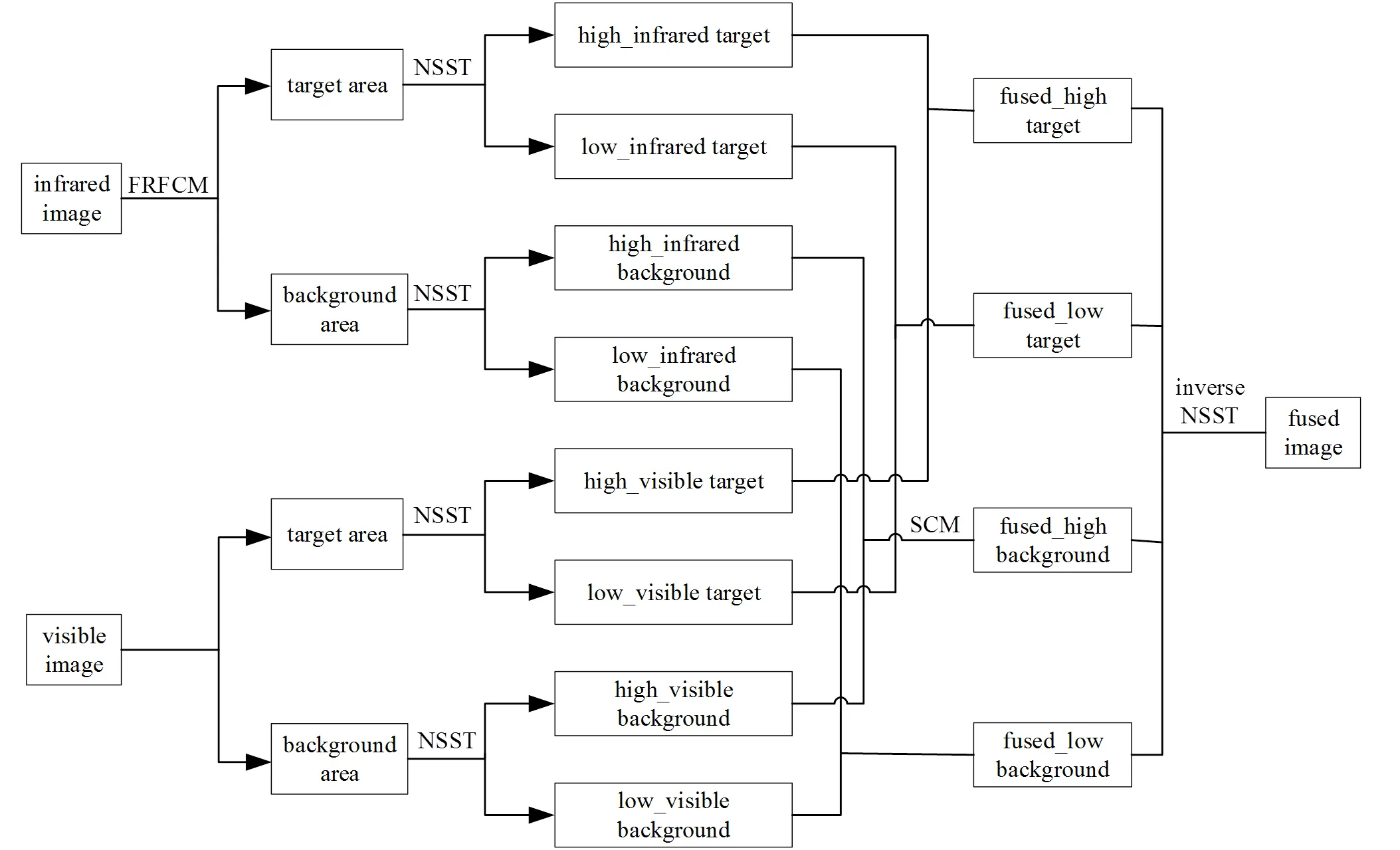

提出的融合方法如图2所示。

①使用FRFCM提取红外图像的红外目标信息,得到红外图像的目标区域和背景区域,

②将红外图像的目标区域融合到可见光图像的目标区域上,得到可见光图像的目标区域和背景区域。

③使用NSST分别对得到的红外图像与可见光图像的目标和背景区域进行分解,得到红外图像的目标区域高频系数、目标区域低频系数、背景区域高频系数、背景区域低频系数,以及可见光图像的目标区域高频系数、目标区域低频系数、背景区域高频系数、背景区域低频系数。

④对于不同的区域选用不同的融合规则,获得融合后的系数。其中,对于高频背景区域采用SCM模型进行融合;

⑤对得到的融合系数进行NSST逆变换,得到最终的融合图像。

图2 本文的图像融合方法流程

2.1 使用FRFCM提取目标区域

①以源红外图像系数的值为数据集,对其进行模糊C均值聚类,设置聚类数为2,将聚类结果中子带系数较大的那一类记为1。

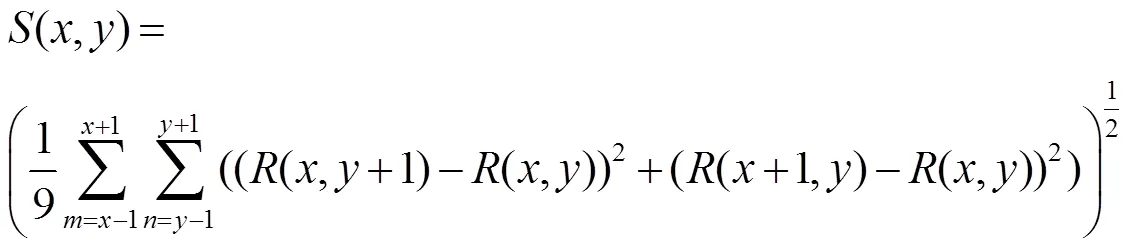

②计算源红外图像中每个子带系数所在邻域的空间频率(,):

③以中的各个元素为数据集,对其进行模糊C均值聚类,设置聚类数为2,将聚类结果中空间频率较大的那类子带系数用2表示。

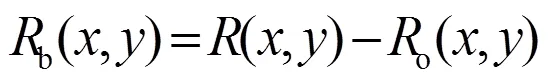

使用FCM提取源红外图像的目标区域o,则剩下的为背景区域b:

然后将提取的红外目标区域融合到可见光图像中,得到可见光图像目标区域o,融合规则为:

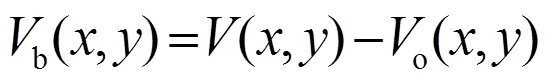

则可见光图像的背景区域b为:

2.2 低频部分融合规则

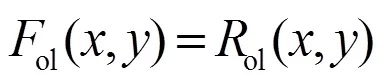

图像中低频分量携带源图像的大部分信息。目标区域的像素值较高,因而能量值高于其他区域,为了保证红外图像的目标信息最大限度地保留,选取红外图像目标区域的低频子带系数ol作为目标区域的低频融合系数[16]ol:

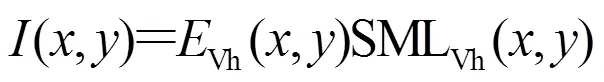

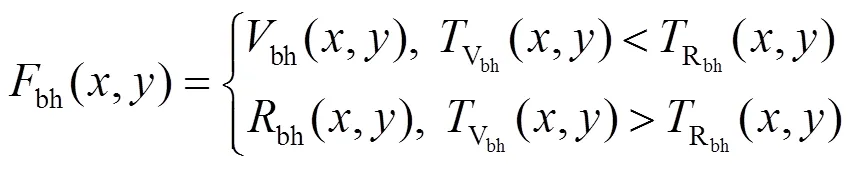

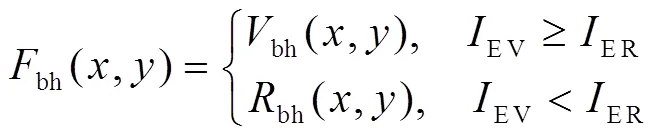

可见光图像低频系数中包含了大量的背景细节信息,其包含的背景信息在通常情况下比红外图像所包含的背景信息更丰富,因此传统方法中往往选取可见光图像的背景信息作为背景区域的融合系数,但红外图像中包含的背景信息也不可忽略,因此为使最终融合的图像保留更多源图像的有效信息,可采用比较低频子带图像系数与源图像信息熵IE的方法,让最终的融合结果偏向于信息熵较大的那类图像,从而得到背景区域的低频子带融合系数bl:

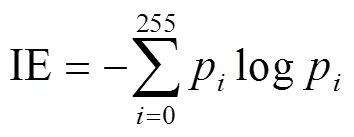

式中:IEV和IER分别是指可见光图像的信息熵和红外图像的信息熵,信息熵IE的表达式为:

式中:p为图像第级灰度值出现的概率。

2.3 高频部分融合规则

图像中的高频分量包含源图像中大量的边缘信息和细节信息,同时也包含噪声信息。高频子带系数的大小反映了源图像相邻区域之间灰度值变化的剧烈程度,其绝对值越大则说明这一点的边缘细节越突出。为保留更多的目标信息,选取红外图像目标区域的高频子带系数oh作为目标区域的高频子带融合系数oh,则有:

oh(,)=oh(,) (18)

为了保留尽可能多的有效边缘信息,并且减少噪声的影响,将背景区域高频子带系数所在的邻域的能量作为衡量边缘突出程度的指标,此外,考虑到源图像对应位置处的清晰度,用改进拉普拉斯能量和ML作为另一指标。将这两个指标结合起来,通过相乘的方法来构造出最终SCM模型的外部激励,从而得到背景区域的高频子带融合系数bl。

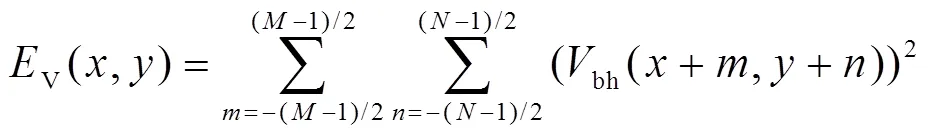

首先,计算每个背景高频子带系数所在邻域的能量(以可见光图像背景区域的高频子带为例):

接着计算每个背景区域高频子带系数在源图像对应位置处的改进拉普拉斯能量和SML:

其中和取值均为3,改进拉普拉斯算子MLVh的计算方法为:

接下来,计算SCM数学模型的外部激励,即计算区域能量与改进拉普拉斯能量和SML的乘积,输入SCM的外部激励,求得输出的赋时矩阵。

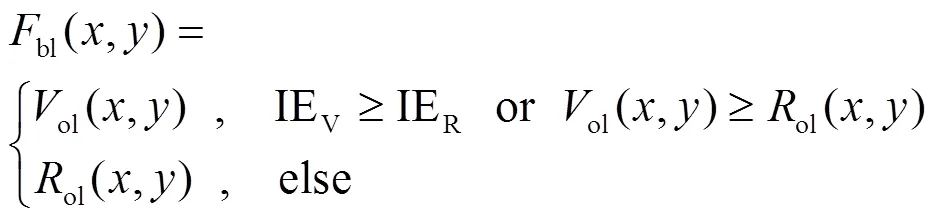

最后,采用比较信息熵的方法得到背景区域高频子带的融合系数bl,具体的方法如下:

当SCM输出的赋时矩阵V(,)≠R(,)时:

当V(,)=R(,)时:

最后将得到的融合系数oh,ol,bh和bl进行NSST逆变换,得到最后的融合图像。

3 实验结果与分析

为了保证实验数据的真实性、公平性,使用Intel 酷睿i5 6200U,2.3GHz CPU,4G内存,Windows10操作系统,MATLAB 2020a软件进行实验,选择TNO数据集中的3组红外与可见光图像进行测试。并将本文算法与其他3种算法进行比较,根据文章所述及文章名称,将这3种算法分别命名为:MST[17](multiscale transform)、IFE-VIP[18](infrared feature extraction and visual information preservation)和VSM-WLS[19](visual saliency map and weighted least square)。在本文提出的算法中,设定NSST的分解层数为4层,shearlet滤波器的大小和方向分别设定为[8,8,8,8]和[2,2,4,4]。SCM模型的阈值衰减系数设置为1;阈值放大系数设置为0.5,控制神经元内部衰减的系数设置为1。

3.1 实验结果主观评价

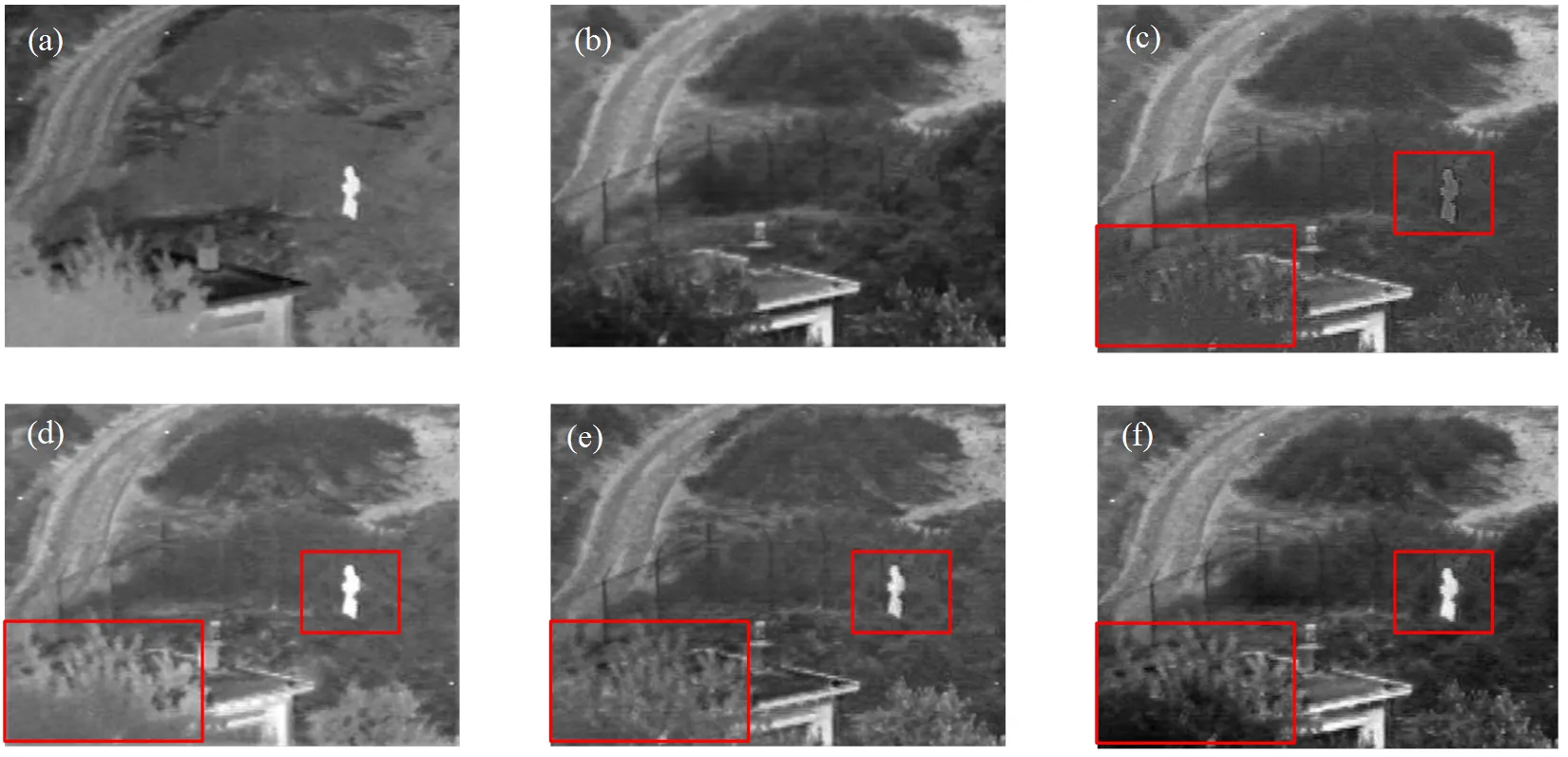

在图3中,图3(a)和图3(b)分别为源红外图像与源可见光图像。从图中可以看到,图3(c)显示了树木的纹理信息,以及道路和目标人物信息,但目标人物信息不够突出,图像整体的对比度较低。图3(d)中,可得到较为清晰的红外目标,但背景信息比较模糊,且左下角的树木纹理细节信息缺失较多,对比度较低。图3(e)中虽然可以看到清晰的目标人物信息及树木的边缘纹理信息,但与图3(f)相比,其目标人物周围存在光晕,且左下角和右下角的树木纹理没有图3(f)的清晰,对比度也没有图3(f)高。与其他方法相比,本文中所提到的算法,不仅能很好地突出红外目标,而且很好地保留了背景信息中山丘、树木等的边缘信息及纹理信息,对比度较高,融合效果更优。

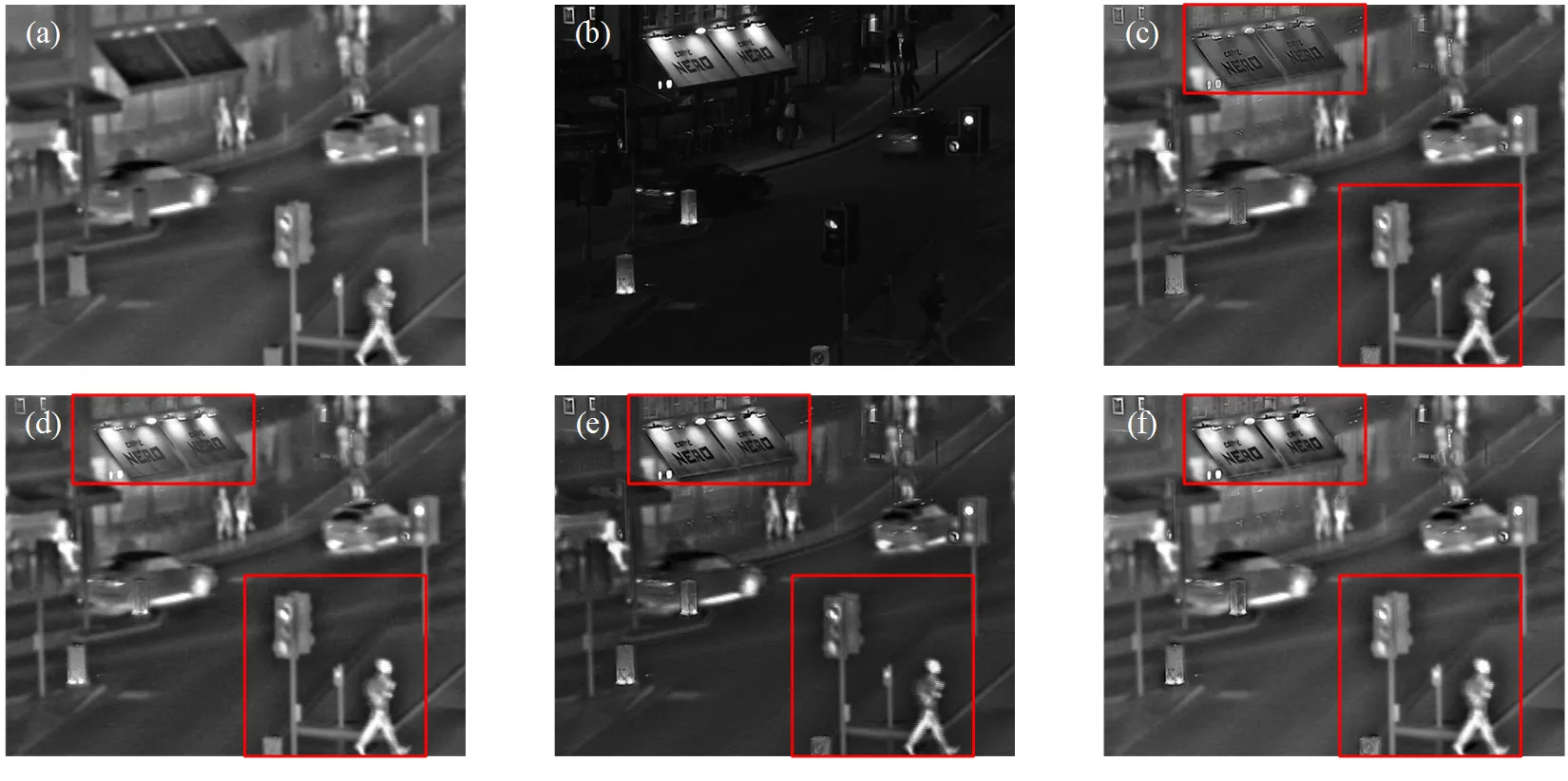

在图4中,图4(c)的目标人物及车辆等信息比较清晰,但图像上方的广告牌比较暗,广告牌上的字体与广告牌灰度接近,字体不够明显,对比度较低。图4(d)中,得到了清晰的目标信息及背景信息,广告牌上的字体也较为清晰,但与图4(e)相比,图4(d)的广告牌上的字体不够清晰,对比度也没有图4(e)高。图4(e)和图4(f)均可得到清晰的背景信息和目标信息,且对比度更高,但进行比较,可以看到虽然图4(e)足够清晰,但其背景与目标人物间的对比度较低,目标人物和车辆信息不够突出,整体图像较暗且缺乏层次感,而图4(f)的对比度更高一些,且目标人物信息突出,背景清晰,整体更有层次感。

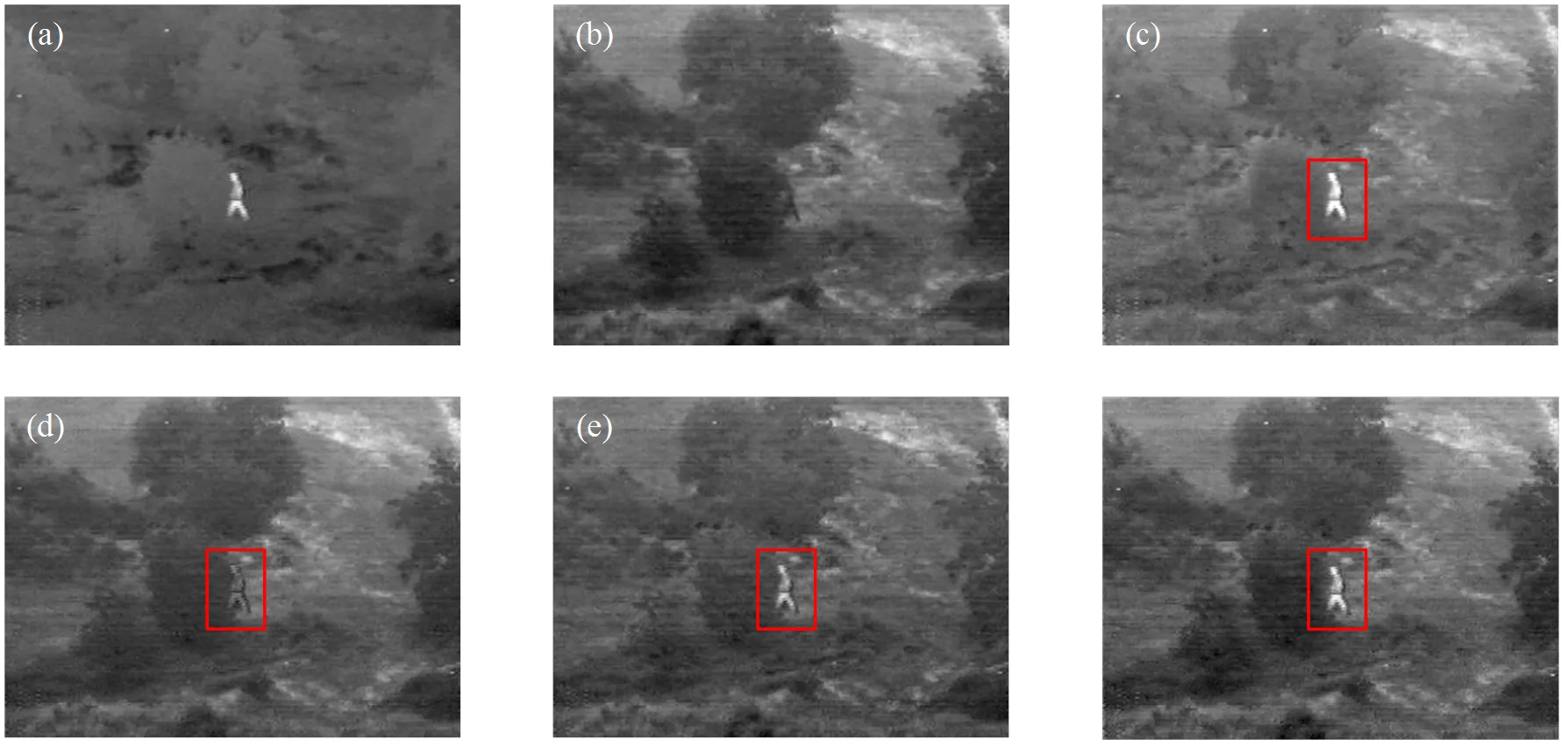

在图5中,图5(c)的目标人物信息比较清晰,但背景中的树木信息模糊,缺乏层次感,很难分辨出树木和道路。图5(d)可以看到清晰的树木信息,层次感较高,但目标人物比较模糊,与树木间的对比度较低,目标人物不易被发现。图5(e)和图5(f)均可得到清晰的树木和目标人物信息,对比度也比较高。但将图5(e)和图5(f)进行比较,会发现图5(f)的目标人物信息更加突出,树木信息也更加丰富,对比度更高。与其他几种方法相比,本文提出算法得到的融合图像视觉效果更好。

图3 第一组图像融合结果:(a) 红外图像;(b)可见光图像;(c)MST融合图像;(d)IFE-VIP融合图像;(e) VSM-WLS融合图像;(f) 本文提出算法的融合图像

图4 第二组图像融合结果:(a) 红外图像;(b) 可见光图像;(c) MST融合图像;(d) IFE-VIP融合图像;(e) VSM-WLS融合图像;(f) 本文提出算法的融合图像

图5 第三组图像融合结果:(a) 红外图像;(b) 可见光图像;(c) MST融合图像;(d) IFE-VIP融合图像;(e) VSM-WLS融合图像;(f) 本文提出算法的融合图像

3.2 实验结果客观评价

本文选用平均梯度(average gradient,AG)、标准差(standard deviation,STD)、信息熵(EN)、互信息(mutual information,MI)、结构相似度(structural similarity,SSIM)、边缘保留因子[20](edge gradient operator,AB/F)和时间(time,1)作为客观评价标准。其中,AG越大,说明图像的纹理越明显,边缘细节越突出,清晰度越好;STD越大,表明图像的识别度越高;EN越大,说明融合图像所含的信息越丰富;MI越大,表明融合图像包含越多源图像中的信息;SSIM越大,说明融合图像的结构与源图像的结构越相似;AB/F越大,说明能够保留更多的源图像边缘细节信息;1越大,说明时间损耗越大。

4种方法所得到的融合图像客观评价指标结果如表1所示。在表1的第一组融合图像中,本文所提方法得到的融合图像的信息熵没有MST方法的高,结构相似度没有IFE-VIP方法的高,但其平均梯度、标准差、信息熵和边缘保留因子的值均比其他3种方法高。说明本文所提方法的纹理细节信息更加丰富,对比度更高,得到的融合图像效果更好。

在第2组融合图像中,所提方法得到的融合图像的标准差和结构相似度没有IFE-VIP方法的高,但其平均梯度、信息熵和边缘保留因子均比其他3种方法高,说明本文所提方法得到的融合图像能保留更多源图像中的纹理细节信息,融合效果更好。

在第3组融合图像中,本文所提算法的平均梯度没有MST方法的高,结构相似度没有IFE-VIP方法的高,但其标准差、信息熵、互信息和边缘保留因子为几种方法中最优的,说明本文所提方法得到的融合图像更加清晰,对比度高,包含更多的源图像中的边缘细节信息,融合效果更好。

如表1所示,MST方法得到的融合图像的互信息在3种方法中较高,IFE-VIP方法得到的融合图像的结构相似度是4种方法中最高的,本文所提算法得到的融合图像的信息熵和边缘保留因子为4种方法中最高的,平均梯度、标准差、互信息、结构相似度的值也较高。相比其他算法,本文所提算法得到的融合图像在客观评价指标上表现较好。

表1 融合图像客观评价指标

4 总结

本文针对红外与可见光图像的成像特点,使用鲁棒性更强的FRFCM算法提取红外图像的红外目标信息,并通过融合的方法,得到可见光图像的目标区域。接着使用NSST对得到的目标和背景区域进行分解,得到各自的高低频子带系数,然后针对不同区域的不同特点,采用不同的策略进行融合,从而使融合图像中目标信息更加突出,纹理细节信息更加丰富。与其他几种融合方法相比,文中所提出的方法在主观视觉及客观评价上都表现良好,红外目标突出,纹理细节特征清晰,对比度高,融合效果较好。但本文所提方法的时间损耗未达到最低,这也是今后研究的一个方向。

[1] 王文卿, 高钰迪, 刘涵, 等. 基于低秩稀疏表示的红外与可见光图像序列融合方法[J]. 西安理工大学学报, 2019, 35(3): 276-283.

WANG W Q, GAO Y D, LIU H, et al. Infrared and visible image sequence fusion via low-rank and sparse representation[J]., 2019, 35(3): 276-283.

[2] 白玉, 侯志强, 刘晓义, 等. 基于可见光图像和红外图像决策级融合的目标检测算法[J]. 空军工程大学学报(自然科学版), 2020, 21(6): 53-59, 100.

BAI Y, HOU Z Q, LIU X Y, et al. An object detection algorithm based on decision-level fusion of visible light image and infrared images[J]., 2020, 21(6): 53-59, 100.

[3] 张林发, 张榆锋, 王琨, 等. 基于直觉模糊集和亮度增强的医学图像融合[J/OL]. 计算机应用, 2021, 41(7): 2082-2091.

ZHANG L F, ZHANG Y F, WANG K, et al. Medical image fusion with intuitionistic fuzzy set and intensity enhancement[J]., 2021, 41(7): 2082-2091.

[4] 江泽涛, 吴辉, 周哓玲. 基于改进引导滤波和2021,41(07):2082-2091.双通道脉冲发放皮层模型的红外与可见光图像融合算法[J]. 光学学报, 2018, 38(2): 0210002.

JIANG Z T, WU H, ZHOU Q L, et al. Infrared and visible image fusion algorithm based on improved guided filtering and dual-channel spiking cortical model[J]., 2018, 38(2): 0210002.

[5] 李玉峰, 尹婷婷. 采用NSCT与FCM相结合的SAR和多光谱图像融合算法[J]. 信号处理, 2017, 33(11): 1523-1529.

LI Y F, YIN T T. The SAR and multispectral image fusion algorithm based on NSCT and FCM[J]., 2017, 33(11): 1523-1529.

[6] GONG J M, XUE M L, REN F, et al. Infrared and visible image fusion based on nonsubsampled shearlet transform and fuzzy C-means clustering[J]., 2018, 27(4): 1-11

[7] Easley G, Labate D, Lim W Q. Sparse directional image representations using the discrete shearlet transform[J]., 2008, 25(1): 25-46.

[8] 高国荣, 刘艳萍. 基于非抽样Shearlet变换的红外与可见光图像融合方法[J]. 农业机械学报, 2014, 45(3): 268-274.

GAO G R, LIU Y P. Infrared and visible light image fusion algorithm based on non-subsampled Shearlet transform[J]., 2014, 45(3): 268-274.

[9] 邢笑雪. 基于NSST的图像融合算法研究[D]. 长春: 吉林大学, 2014: 24-25.

XING X X. Research on Image Fusion Algorithm Based on NSST[D]. Changchun: Jilin University, 2014: 24-25.

[10] ZHAN K, ZHANG H J, MA Y D. New spiking cortical model for invariant texture retrieval and image processing[J]., 2009, 20(12): 1980-1986.

[11] 江泽涛, 何玉婷, 张少钦. 一种基于对比度增强和柯西模糊函数的红外与弱可见光图像融合算法[J]. 光子学报, 2019, 48(6): 149-158.

JIANG Z T, HE Y T, ZHANG S Q. Infrared and low-light-level visible image fusion algorithm based on contrast enhancement and cauchy fuzzy function[J]., 2019, 48(6): 149-158.

[12] 王念一. 脉冲发放皮层模型图像融合技术研究[D]. 兰州: 兰州大学, 2014: 18-20.

WANG N Y. Spiking Cortical Mode for Image Fusion[D]. Lanzhou: Lanzhou University, 2014: 18-20.

[13] HE K J, ZHOU D M, ZHANG X J, et al. Infrared and visible image fusion combining interesting region detection and nonsubsampled contourlet transform[J]., 2018, 2018: 1-15.

[14] LEI T, JIA L, HE L, et al. Significantly fast and robust fuzzy C-means clustering algorithm based on morphological reconstruction and membership filtering)[J]., 2018: 26(5): 3027-3041.

[15] LIU Z Y, DING F, XU Y, et al. Background dominant colors extraction method based on color image quick fuzzy c-means clustering algorithm[J]., 2020, 16(5): 1073-1087.

[16] 刘帅奇, 郑伟, 赵杰, 等. 数字图像融合算法分析与应用[M]. 北京: 机械工业出版社, 2018:115-116.

LIU S Q, ZHENG W, ZHAO J, et al.[M]. Beijing: China Machine Press, 2018: 115-116.

[17] CHEN J, LI X J, LUO L B, et al. Infrared and visible image fusion based on target-enhanced multiscale transform decomposition[J]., 2020, 508: 64-78.

[18] ZHANG Y, ZHANG L J, BAI X Z, et al. Infrared and visual image fusion through infrared feature extraction and visual information preservation[J]., 2017, 83: 227-237.

[19] MA J L, ZHOU Z Q, WANG B, et al. Infrared and visible image fusion based on visual saliency map and weighted least square optimization[J]., 2017, 82: 8-17.

[20] Xydeas C S, Petrovic V. Objective image fusion performance measure[J].s, 2000, 36(4): 308-309.

Image Fusion Algorithm Based on Improved Fuzzy C-means Clustering

GONG Jiamin,WU Yijie,LIU Fang,ZHANG Yunsheng,LEI Shutao,ZHU Zehao

(,710061,)

To obtain more prominent target information and retain more textural details in infrared and visible light fusion images, an infrared and visible light image fusion algorithm based on the non-subsample shearlet transform (NSST) domain combined with a spiking cortical model (SCM) and improved fuzzy C-means clustering model (FCM) is proposed. First, the infrared target information in the source infrared image is extracted by the FCM. Subsequently, the NSST is used to decompose the target and background areas of the infrared and visible images to obtain their own high- and low-frequency sub-band images. Subsequently, different fusion strategies are adopted for different regions, and the SCM and improved time matrix are adopted for high-frequency background regions. The final fused image is obtained by using the NSST inverse transform. Simulation experiments show that, compared with other methods, the fusion image obtained by this algorithm has a prominent infrared target and intricate texture details in subjective vision, and its information entropy and edge retention factor are optimal for objective evaluation.

image fusion, non-subsampled shearlet transform, spiking cortical model, fuzzy C-means clustering, time matrix

TP391

A

1001-8891(2023)08-0849-09

2021-06-13;

2021-08-18.

巩稼民(1962-),男,博士,教授,硕士生导师,主要从事光通信与光信息技术方面的研究。E-mail:13289388729@qq.com。

国家自然科学基金(61775180),国际科技合作计划项目陕西省重点研发计划(2020KWZ-017)。