基于反馈图卷积神经网络的事件检测方法

刘浏 ,丁鲲 ,刘姗姗,刘茗

(1.国防科技大学 第六十三研究所,江苏 南京 210007;2.宿迁学院 信息工程学院,江苏 宿迁 223800)

在大数据时代,信息以爆炸式速度增长,而它们大多以非结构化文本形式存在,如微博、新闻以及军事情报等.如何有效利用文本中蕴含的有价值信息成为新的挑战.事件检测作为自然语言处理技术一个重要子任务,其目标就是要从这些不规则的文本中提取出结构化信息用以支持知识图谱、信息检索、推荐系统等下游任务.

事件检测的主要目标是识别文本中的事件触发词并对事件进行分类.触发词主要表现为动词,动词通常是一个句子的核心词汇,能够直接体现事件的类型和状态.ACE 会议(自动内容抽取测评会议)则将触发词描述为触发事件发生的词[1].例如下面的句子:

S:Many refugees haveleftUkraine.

(许多难民乌克兰.)

在句子S 中,事件检测的主要任务是识别动词“left”为触发词并将其分类为“Transport”.

深度学习在欧氏空间数据特征的挖掘上取得了成功,但是在现实应用场景中数据大多来自非欧式空间,例如社交网络中,用户之间非规则化的复杂关系.为此,有学者提出了以节点和边形成的图结构学习模型,即图神经网络(Graph Neural Network,GNN)[2].GNN模型能够学习非欧氏空间中数据之间的依赖关系,同时通过聚合邻居节点的信息进而丰富其表征能力.因此在自然语言处理领域,通常使用GNN 模型获取具有词间依赖关系的结构化信息.同时,GNN随着隐藏层深度的增加,其节点可感知更远的邻居节点信息,因此GNN能够获取长距离的节点信息.

近年来,预训练语言模型BERT[3]在文本分类、机器翻译以及自动问答等领域任务上展示了卓越性能,成为实现事件检测任务的重要技术手段.虽然BERT 相较于ELMo[4]、GPT[5]等其他预训练模型具有更强的语义理解能力和语义特征提取能力,但是BERT 无法有效捕获长距离的结构化文本特征.为此,本文提出了一种改进图神经网络模型,即反馈图卷积神经网络模型(FB-GCNs).本文的主要贡献在于:首先使用GCNs 与预训练语言模型BERT 相结合,从而提高模型捕获长距离和结构化信息的能力;其次,设计反馈网络模块用以缓解由GCNs模型带来的语义特征衰减问题;然后,通过在公开数据集上开展对比实验和消融实验,验证了本文模型的可行性和优越性.同时,消融实验也进一步验证了随着隐藏层的增加,GCNs 模型对语义信息的传递呈线性衰减趋势.

1 相关工作

与传统的统计学模型不同,深度学习模型作为具有非线性表示能力的深层次网络,能够自动挖掘数据特征,因此许多学者将其应用于事件检测任务.Chen 等[6]和Nguyen 等[7]最早将深度卷积神经网络(CNN)应用于事件检测任务,并取得了不错的效果.Nguyen 等[8]和Jagannatha 等[9]使用循环神经网络(RNN)进行事件检测,其中前者利用BiRNN 进行文本表征,然后采用联合学习模型对事件触发词和论元进行识别.后者则利用BiRNN获取词嵌入,并利用条件随机场实现对电子病历中包含的医疗事件进行检测.Hong等[10]提出了一种名为自约束学习方法,其利用生成对抗网络生成虚假特征从而解决事件检测过程中可能由伪关系引起的错误.Liu 等[11]为减少触发词标注带来的时间成本,提出了一种无须触发词标注的事件检测方法.该方法使用LSTM学习词的上下文环境特征,同时联合注意力机制获取的触发词局部信息,最终通过多任务分类器实现对事件类型的判断.然而,基于深度学习的事件检测技术依然面临着数据标注的问题,因为深度学习模型的训练严重依赖大规模的有标签实验数据的支撑.同时,它难以处理像图数据这样的非欧式空间问题.因此,许多自然语言处理的专家开始越来越关注图神经网络在事件检测任务上的应用.Nguyen 和Grishman[12]认为之前的神经网络主要研究的是文本序列特征,对文本的语义结构特征研究相对较少,因此提出基于图神经网络的事件检测方法.Cui等[13]认为经典的图神经网络忽略了依赖关系标签的信息,因此设计了一种强化边信息的图卷积神经网络用于事件检测.该方法利用边代表的节点依赖关系更新节点信息,同时又使用节点信息更新边表征.

BERT 模型凭借着强大的语义表征能力成为较成功的预训练语言模型之一.目前许多事件检测任务都是基于该模型开展研究的,并取得了显著的成果.Yang等[14]将文本中的词、位置以及段嵌入输入到BERT模型获取具有语义信息的编码,然后使用多分类器作用于编码进行触发词抽取.Wadden 等[15]利用BERT 构建一个DyGIE++框架,进行跨文本建模,并捕获句内和跨句子上下文信息.Liu 等[16]和Du 等[17]为了缓解模型对数据的依赖以及错误传播的问题,将事件抽取任务构造为基于BERT 的机器阅读理解模型.两者不同的是,前者使用非监督方法进行问题生成,而后者使用人工方式设计问题.但是这类方法往往对长距离的信息挖掘存在不足.因此本文利用预训练模型获取文本的语义特征,并输入图神经网络,从而实现语义特征和长距离的结构特征相结合.

2 事件检测模型

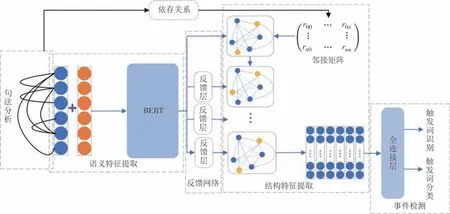

图1 为事件检测模型框架,主要由语义特征提取、结构特征提取、反馈网络以及事件检测等模块组成.语义提取模块使用预训练语言模型挖掘句子级的上下文语义信息.结构特征提取模块是使用由文本句法分析结果转化的邻接矩阵构造的图神经网络,提取文本的结构化信息.反馈网络包含多个反馈层,每个反馈层由归一化函数、激活函数组成.最后,全连接层使用多任务分类器实现对文本中的事件触发词的识别和分类.

图1 FB-GCNs模型框架图Fig.1 Illustration of FB-GCNs architecture

2.1 语义特征

语义特征提取模块主要包括词编码和BERT 模型两个部分.本文的词编码由两个部分组成,即 Token embeddings和Position embeddings.前者通过查询WordPiece embeddings 方法[17]形成的编码词典获取不同词的数值表示,其中该词典包含英文常用的30 000 个单词的编码结果.后者通过三角函数表示不同词在句子中相对位置信息.需要说明的是,由于本文重点研究句子级的事件检测任务,因此没有加入段嵌入(Segment embeddings).

BERT 预训练模型是将Token embeddings 和 Position embeddings 作为输入,使用叠加的Transformer encoder 作为语义分析的核心模块.本文使用的BERT 模型是采用文献[18]中的BERT_Base 结构,其包含Transformer Block 的层数为12,隐藏层的维度为768,Self-Attention头数为12.

2.2 结构特征

为了获取文本的结构化特征,本文使用图神经网络捕获不同词汇之间的依赖关系.首先,使用句法分析工具抽取原始文本中词间依赖关系,然后将其转化为邻接矩阵,最后使用邻接矩阵对图神经网络中节点关系进行初始化.

2.2.1 句法分析

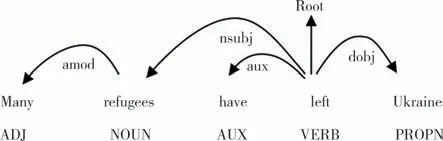

本文使用NLP工具spaCy对句子进行句法分析,并得到词之间的依存关系,如图2 所示.通常依存关系是二元非对称的,其中以动词或动词短语为中心词(Root).句子与中心词之间存在依存路径,图中的圆弧表示词之间的存在依存关系,例如(left,Ukaine)的关系为dobj,表示后者是前者的直接宾语.

图2 句法分析示例图Fig.2 An example of syntactic dependency parsing

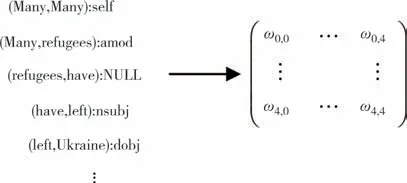

图3 基于句法依赖关系的邻接矩阵Fig.3 Adjacency matrix based on syntactic dependency

句子中的词间依赖关系具有多样性,示例中便存在5 种关系.关系的非对称性又决定了依存路径的有向性.为了能够将这种依存路径表示为可计算的邻接矩阵An×n,其元素表示为本文将存在依存路径的两个词关系值表示为1,不存在依存路径的值表示为0.依存路径分为直接和间接路径两种,图中(left,Ukaine)为直接路径,由(left,refugees)->(refugees,Many)推导的(left,Many)的路径为间接路径.

由于词间的依存关系是相互,因此在邻接矩阵的转化过程中将路径依存关系转化为对称的无向图.同时为每一个词添加环,使得自身原始信息得以保留.

2.2.2 图卷积神经网络

为便于描述,本文采用文献[12]的描述形式将图表示为G=(V,E),其中V表示节点(词向量)的集合,E表示边(词间关系)的集合.定义一个矩阵X∈Rm×n表示句子词嵌入,n表示词的数量,m表示词向量xv∈V的维度.

如图4 所示,原始的GCNs 模型中的节点向量更新是由邻居节点聚合而成,而本文则通过上一节中的邻接矩阵确定用来聚合的邻居节点.图神经网络的层次代表需要更新的次数,其中对第k+1 层节点进行更新的公式如下所示:

图4 图卷积神经网络结构图Fig.4 Illustration of GCNs architecture

2.3 反馈网络

受残差网络[19]的启发,本文设计了一种反馈网络用以缓解GCNs 模型的退化问题以及破坏xv的语义信息.如图5 所示,与上一节中在第(k+1)隐藏层的节点xv的更新公式不同,经过反馈网络后的公式为:

图5 反馈网络Fig.5 Feedback network

反馈网络通过在GCNs 模型每一层中引入由BERT 模型获取的语义信息,从而减少由GCNs 模型节点信息聚合带来的语义信息衰减和破坏.在语义特征与结构化特征融合过程中采用了归一化方法避免两者向量化计算时出现数值空间差异较大的问题,并能够加快模型收敛.同时使用权重系数对语义特征和结构特征进行调和,使其达到最优的状态.

2.4 事件检测

由于事件的类型是多样的,因此本文使用多分类器对样本中的词进行预测.GCNs 模型中的节点是对样本句中词的量化表示,因而使用如下公式:

本文将交叉熵作为损失函数,其公式如下:

式中:N表示训练batch 中的样本数量,yi表示样本的真实标签概率,表示第i个样本的被判断为类别j的概率.

3 实验

3.1 实验数据与评估指标

本文实验采用的是ACE 2005 数据集,该数据集包含来自不同领域的新闻、微博、广播等文本[20].ACE 2005数据集包含8种事件类型,33种子类型.为了实验的公平性,使用文献[21]中的方法共抽取599篇文本中的15 715个句子作为实验数据,其中14 180个句子作为训练集样本,863 个句子作为验证集样本,672个句子作为测试集样本.

本文使用精准率P(precision)、召回率R(recall)、F1三个指标对实验结果进行评估.由于事件检测由触发词识别和分类组成,因此分别使用两组相同的指标进行评估.

3.2 实验环境与模型训练参数

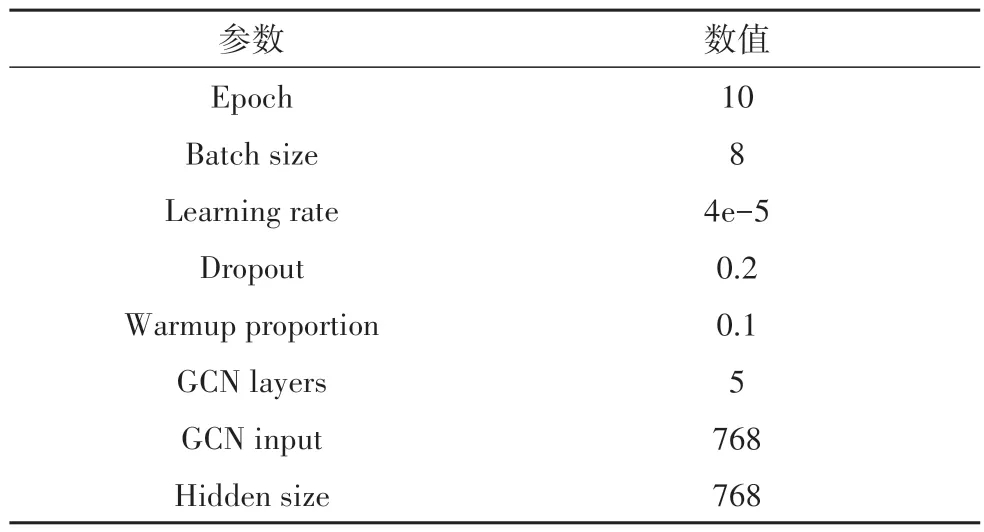

本文实验采用的编程语言是Python 3.8,使用的深度学习框架为PyTorch1.8.0+CUDA 11.1,预训练语言模型使用的是BERT-base-uncased 版本的BERT模型,图计算框架采用的是DGL 0.8.1+CUDA 11.0,句法分析工具采用的是spaCy v3.0(加载的模型为en_core_web_lg-3.2.0).FB-GCNs 模型训练的具体参数配置见表1.

表1 实验参数配置Tab.1 Parameter configurations of our experiment

3.3 实验结果与分析

本文的实验主要包括对比实验和消融实验,其中对比实验用于将FB-GCNs 模型与已有的主流事件检测模型进行性能比较,而消融实验则为了验证模型中反馈网络以及GCNs 模型结构对性能的影响程度.

3.3.1 对比试验

为了有效评估FB-GCNs 模型的性能,本文选择将其与6 种不同类型的事件检测模型进行比较,这6种模型分别是:

DMCNN[6]:是一种动态多池化卷积神经网络,用以捕获包含多事件的句子中有用信息.

TBNNAM[11]:为了避免对触发进行标注,使用注意力机制计算聚集事件类型的句子表示,从而实现了一种无须触发词的事件检测任务.

BERT_QA[17]:主要思想是通过为事件抽取不同任务设计相应的问答对,从而将多分类问题转化为机器阅读理解.

GCN-ED[12]:首次将GCNs 模型应用于事件检测任务,它除了利用句法依赖关系表征词的上下文信息,还提出了一种整合实体提及的聚合方法.

JMEE[22]:将注意力机制应用于GCNs 模型的信息聚合,从而实现事件触发词和论元的联合抽取.

Joint3EE[23]:为了防止错误传递,让命名实体识别、触发词检测以及论元分类三个任务共享BiRNN模型对句子的表示能力,进而实现三者任务的联合学习.

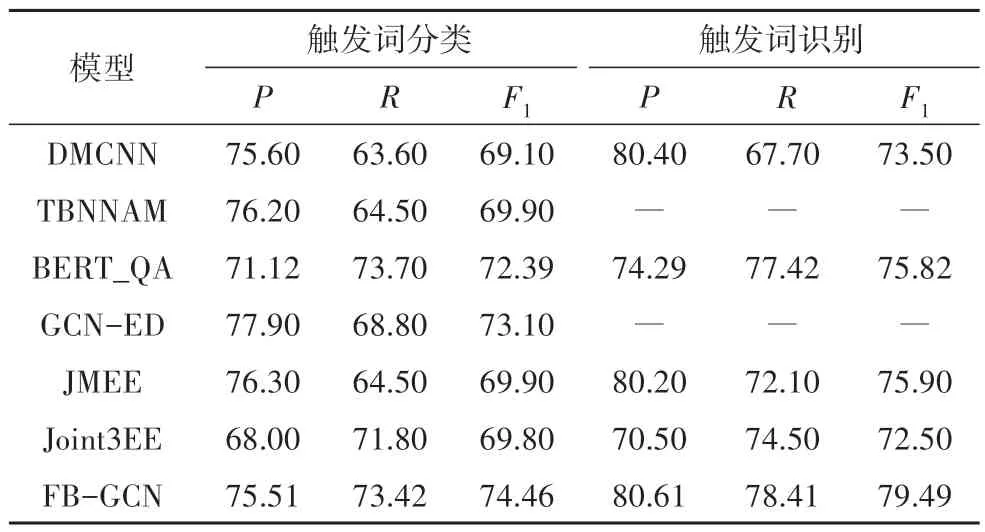

表2是本文模型以及各基准模型在ACE 2005数据集上的测试结果.该实验结果表明,本文模型相较其他模型在触发词分类上的精确率P、召回率R以及F1值分别平均提高了1.33%、4.24%及4.13%,在触发词的识别上也分别提高了4.68%、4.59%及4.79%.但是在触发词分类的精确率上相较TBNNAM、GCNED 以及JMEE 等模型有所下降,这是由于TBNNAM模型采用了无触发词标注方法,避免了有触发词标注错误给模型训练带来的影响.但是由于其没有能力捕获文本的结构化信息,因此在综合指标F1上明显弱本文模型.JMEE 模型相较于本文模型在GCNs模型的聚合上做出了改进,因此在结构化信息捕获方面具有一定优势.GCN-ED 模型也是图神经网络模型,由于其将实体信息与触发词关联起来,从而促进了对事件分类精确率的提高.但是由于它们相较本文模型在语义信息捕获能力上的不足,因此在综合指标F1值上显示出一定的劣势.

表2 ACE 2005数据集上事件检测结果Tab.2 Event detection results on ACE 2005

3.2.2 消融实验

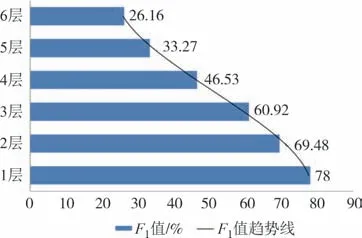

为了验证GNN 模型在语义特征上的衰减性和破坏性,这里采用不同隐藏层数量的GCNs模型在事件触发词分类和识别上的F1值作为验证指标.从图6和图7 可以看出,随着GCNs 模型隐藏层深度的不断增加,其对事件触发词分类和识别的性能呈现线性下降趋势.这表明随着模型深度的增加,GNNs 模型对语义特征具有显著的衰减和破坏作用.在不多于两个隐藏层的GCNs模型中,其性能还是保持较高的水平,这是由于首层接收的是带有语义特征的文本向量,而浅层模型在获得结构化特征的同时依然保留着部分语义信息.

图6 GNNs模型深度对触发词分类F1值影响Fig.6 Influence of GNNs model depth on F1 value of trigger classification

图7 GNN模型深度对触发词识别F1值影响Fig.7 Influence of GNN model depth on F1 value of trigger identification

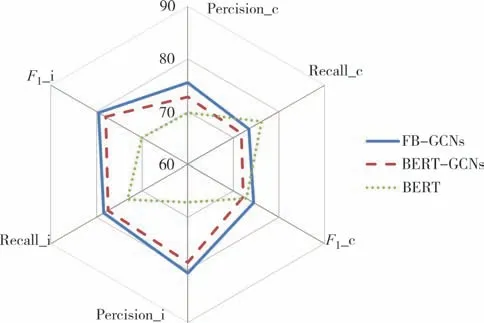

为了验证在事件检测任务中,文本的语义信息与结构信息都具有重要作用,同时也为了进一步验证本文所提反馈网络对GCNs 模型具有一定的提升作用,即能够防止语义信息的衰减和破坏,本文对FB-GCNs 模型进行消融实验.该实验主要将缺少捕获结构信息能力的BERT+FineTune 模型、失去反馈网络的BERT+GCNs 模型以及本文的完整模型FBGCNs 三者进行比较.由于在对比实验中已经与多种GNNs 模型进行比较,因此消融实验中没有重复与GNNs模型的比较.从图8可以看出,本文提出的FBGCNs 模型相较于其他两个模型具有明显的优势.由此可以表明,合理地利用语义特征和结构体特征对于事件检测具有重要的意义.

图8 消融实验结果对比Fig.8 Comparison of ablation results

4 结论

事件检测是重要的自然语言处理子任务之一,本文为了能够有效利用文本的语义和结构特征从而提升事件检测的性能,提出了基于反馈图卷积神经网络的事件检测模型.该模型通过设计一种反馈网络从而缓解了由于图神经网络节点表示的多层次聚合带来的语义信息衰减和破坏问题.最终在公开数据集上的实验结果表明,本文模型能够有效地对触发词进行识别与分类.但是本文并未对不同的图神经网络模型在事件检测任务上的性能差异进行深入研究和验证,因此未来将对图神经网络模型展开深入研究.