基于红外-反转红外图像的双分支无人机目标跟踪算法*

李邵港,高 晋,王 刚,王以政,李 椋

(1.南华大学,湖南 衡阳 421001;2.军事医学研究院军事认知与脑科学研究所,北京 100850;3.中国科学院自动化研究所,北京 100190)

0 引言

无人机行业的兴起为农业、交通、娱乐等领域带来巨大商业机会。然而,利用无人机进行扰航、走私、恐怖袭击等时有发生,对无人机的不当使用,也会对公共安全造成严重威胁。因此,对无人机目标进行监控具有重要意义。

红外传感器是基于物体表面的热辐射成像,其穿透能力强,可避免灰尘、烟雾等遮挡,且对光照变化不敏感,可在完全黑暗的环境下使用,适合视频监控等需全天候工作的应用场景,采用红外探测手段对无人机目标进行检测与跟踪具有良好的应用前景。

近年来,深度学习在目标跟踪中得到了广泛应用。在线更新目标跟踪方法在跟踪过程中使用在线更新机制不断更新目标表观模型,适应目标及背景变化。ATOM 使用IoUNet 目标检测算法中提出的目标框回归方法估计目标尺寸[1-2]。DiMP 使用模型优化器对目标的表观模型进行更新,并提出具有判别力的损失函数[3]。PrDiMP 则提出了概率回归模型并应用于DiMP 模型[4]。KYS 通过维持一个目标邻近区域的状态向量将背景信息的建模到跟踪框架中,以提高跟踪的鲁棒性[5]。与KYS 类似,KeepTrack指出仅依靠表观模型不足以区分目标和干扰物,需要对潜在目标保持跟踪[6]。多数Siamese 系列跟踪算法离线训练分类和目标框回归分支,在跟踪过程中不更新模板。Siamese 系列算法始于SINT[7]。SiamFC将深度卷积网络作为通用相似性学习器[8]。Siam-RPN 引入了目标检测算法中的候选框机制[9]。SiamRPN++设计了一种高效的深度可分离互相关操作[10]。SiamMask 提出了视觉目标跟踪和视觉目标分割的统一框架,通过像素级的分割预测结果获得更精准的目标框[11]。SiamBAN 利用全卷积网络预测搜索区域每一个点的而非锚框的信息[12]。最近,Transformer 在计算机视觉领域应用日益增多,DETR使用Transformer 进行物体检测和分割[13]。ViT 使用Transformer 进行图像分类[14]。TransT 将Transformer结构引入目标跟踪模型[15]。STARK 通过Transformer 学习鲁棒的时空联合表示并将目标跟踪建模成一个直接的边界框预测问题,提出一种全新的跟踪框架[16]。当红外图像中目标对比度反转时,目标外观发生变化,因此,本文选择在线更新方法进行改进以适应目标变化。

多数跟踪算法都是针对可见光图像设计,由于红外图像与可见光图像的差别,使得这类算法直接应用在红外目标跟踪任务中效果不佳。自2015 年的红外目标追踪挑战赛[17](thermal infrared visual object tracking challenge,VOT-TIR)以来,基于深度学习的高性能的红外目标跟踪算法已经成为一个颇受关注的研究领域。文献[18]设计了一个针对红外无人机的跟踪框架,将局部跟踪器、摄像机运动估计、目标框优化、重检测以及表观模型更新集成到统一的框架中。文献[19]认为在红外图像中,由于被跟踪的目标外观是均匀的而导致全卷积神经网络的识别能力没有得到充分利用,因此,提出一种结合随机采样和聚类前景轮廓的两阶段采样方法,以及结合外观、可靠性和距离分数的多模型FCNN(multiple-model FCNN)目标跟踪算法。

尽管现有算法针对红外图像作出改进,但其鲁棒性仍有待提升。由于红外图像根据物体热辐射成像,当无人机目标在不同温度的背景物之间穿梭时,受背景干扰,目标成像可能发生对比度反转,这给红外目标跟踪带来困难。

红外图像分辨率较低,图像中物体缺乏精细的纹理、颜色等特征。为增强红外图像特征,文献[20]结合原始红外图像与其灰度反转图像,基于伪暗原色处理实现红外图像的对比度增强及细节突出。文献[21]针对红外图像纹理细节不足和对比度下降的问题,利用显著性特征图及反转红外图像的透视图对图像进行增强。可见结合原始红外图像及其灰度反转图像能增强图像特征,提升红外目标跟踪精度。

SiamDAH(double adjust head siamese network)提出一种双分支孪生网络结构,使用不同的分支处理目标内部区域和轮廓处的特征提取[22]。观察到在图像分类任务中学习到的语义特征和在相似性匹配任务中学习到的外观特征是相辅相成的,SA-Siam 分别使用语义分支和外观分支提取不同的特征,并将两个分支的特征进行融合获得更高的跟踪性能[23]。此外,利用可见光与红外图像的互补性提升算法的性能日益成为一个研究热点[24]。文献[25]使用双流卷积神经网络分别提取可见光和红外图像特征,并通过一个由两个独立的卷积层组成的融合网络去除无用特征,以实现更高准确度和效率。mfDiMP 基于DiMP 提出一种双分支的目标跟踪模型,使用不同的分支分别提取可见光和红外图像特征并将其按通道拼接后用于预测目标状态[26]。文献[27]提出一种红外- 可见光双模态输入孪生网络跟踪方法,并提出一种模态权值自更新策略融合用于特征融合。综上所述,在算法中使用多个分支提取不同层次的特征或融合不同模态的特征能提高跟踪性能。因此,本文使用两个分支分别处理原始红外图像与反转红外图像以期获得更好的跟踪性能。

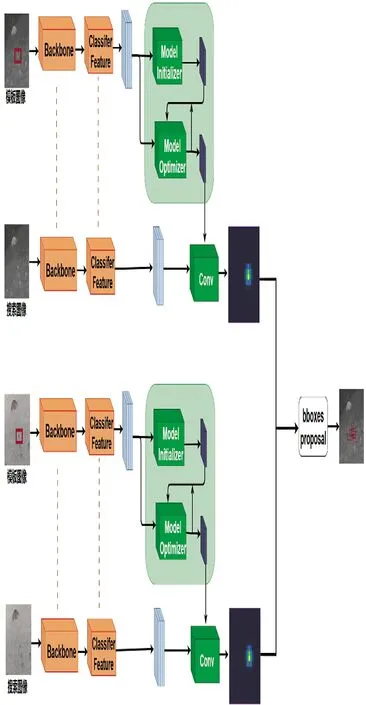

根据上述分析,本文提出一种基于红外-反转红外图像的双分支无人机目标跟踪算法,使用两个骨干网络分支分别提取原始红外图像和反转红外图像两个模态的特征。同时,为适应无人机目标的变化,选取对目标表观模型进行在线更新的SuperDiMP1 目标跟踪模型作为基准进行改进,该模型组合PrDiMP[4]的目标框回归分支和DiMP[3]的分类分支以达到更好的性能。在处理流程上,SuperDiMP 先进行分类得到目标位置,再对目标框进行回归,本文算法使用两个分类分支对不同模态进行处理得到目标位置,并将两个模态的特征进行融合输入到目标框回归分支中预测目标框。

本文的主要贡献如下:

1)设计了双分支目标跟踪网络,两个分支分别提取原始红外图像和反转红外图像的特征,在后续跟踪时分别匹配两个分支的模板特征对目标进行定位,使跟踪器对红外目标的亮度变化更具鲁棒性。

2)设计了一种高效的互相关特征融合模块,在目标框回归时,将原始红外图像与反转红外图像的特征进行融合,增强目标区域的特征,从而实现更准确的目标框回归。

1 方法

本文提出的双分支红外目标跟踪器,其核心思想为:1)双分支多层次特征提取:由特征提取网络分别对原始红外图像和反转红外图像两个模态进行多层特征提取(对应ResNet50[28]的第3 层和第4层特征),分别用于目标初定位和目标框回归;2)双分类分支:第3 层特征作为分类特征,两个模态的分类特征分别由两个分类分支处理进行初定位得到目标位置;3)基于互相关特征融合的目标框回归分支:基于IoU(intersection over union)预测进行目标框回归,选取第3 层和第4 层特征作为IoU 特征,两个模态特征经过互相关特征融合模块后输入目标框回归模块,最终由目标框回归分支根据融合后IoU 特征得到目标框;4)同步初始化,异步训练:双分支网络初始化时使用相同的预训练权重,在红外数据集上训练,进行微调。本文所提模型如图1所示。

图1 本文所提模型框架Fig.1 Framework of the proposed model

1.1 双分支分类模块

为解决红外图像中小目标易受背景杂波干扰发生对比度反转现象造成跟踪失效的问题,将原始红外图像和反转红外图像作为模型输入,提取不同模态下的图像特征,增强模型对红外目标灰度特征的辨别力。

双分支分类的流程框架如下页图2 所示,由进行特征提取的两个孪生网络以及两个分类分支构成。提取原始红外图像和反转红外图像的特征,分别输入到分类分支,分类分支对目标和背景进行区分,从而确定目标在当前帧的定位。

图2 双分支特征提取及分类模块Fig.2 Dual-branch feature extraction and classification module

具体的,给定模板图像Torg和搜索图像Sorg,先将原始红外图像Torg和Sorg反转得到反转红外图像:

使用ResNet50 作为骨干网络,选择其Block3的输出作为分类分支的输入特征,由孪生网络中的模板分支对Torg和Trev进行特征提取,搜索分支对Sorg和Srev进行特征提取得到对应骨干网络特征,该骨干网络特征Xorg3,Xrev3,Zorg3,Zrev3经过一个卷积模块得到分类特征,计算过程如下:

式中,ψorg表示针对原始红外图像的卷积模块;ψrev表示针对反转红外图像的卷积模块,两个孪生网络结构相同但不共享参数。

模板特征经过一个表观模型在线更新模块D(model predictor)后得到目标模板的表观模型forg和frev,表观模型与搜索图像特征进行卷积得到得分响应图和:

1.2 特征融合及目标框回归模块

对于在线更新的目标跟踪算法,需在跟踪过程中根据新的目标位置和尺度在当前帧中对目标进行采样,用于更新目标的表观模型,因此,准确的目标框回归对模型更新至关重要。对于易受背景干扰的红外图像小目标,为使目标框回归更准确,于是将原始红外图像与反转红外图像的特征进行融合,获得更具判别力的特征,并使用融合后的特征输入到基于IoU 预测的目标框回归模块。具体流程图如下页图3 所示。

图3 特征融合及目标框回归模块Fig.3 Feature fusion and bounding box regression module

原始红外图像和反转红外图像经过骨干网络ResNet50 进行特征提取,分别取其Block3 和Block4作为目标框回归分支的输入特征,提取模板图像和搜索图像的骨干网络特征得到Xorg3,Xorg4,Zorg3,Zorg4,Xrev3,Xrev4,Zrev3,Zrev4。原始红外图像的模板图像特征与搜索图像特征及候选框输入到一个基于调制的网络M,提取各个候选框的IoU 特征Fiou_org,对反转红外图像做同样操作得到Fiou_rev。

使用互相关融合模块CF 将原始红外图像的IoU 特征Fiou_org与反转红外图像的IoU 特征Fiou_rev融合得到Fiou:

即将两个输入分别经过线性变换后相乘。对于乘法而言,两个输入的向量中,较大的值与较大的值相乘扩大的倍数比较小的值与较小的值相差扩大的倍数更大,从而可以实现增强两个模态中强响应区域,抑制较弱响应区域的目的。由于两个模态的特征互补,当其中一个模态目标区域响应不显著,另一个模态目标区域显著时,经过互相关运算,目标区域响应不显著的模态将被增强;对于两个模态响应均显著的区域,表明该区域为目标,则经过互相关运算,该区域将被进一步增强;此外,对于两个模态中响应均不显著的区域,表明该区域是与目标无关的,经过互相关运算,该区域将被抑制;因此,对两个模态的特征使用互相关进行融合,是对目标区域增强、对背景区域抑制的过程。

1.3 训练与推理

1)损失函数。整个网络由两个模态的特征提取网络,两个分类网络及一个目标框回归网络组成。损失函数由原始红外分支和反转红外分支的目标分类损失和目标框回归损失组成:

其中,对于分类分支,离线训练时,随机选择原始红外视频序列的连续6 帧,前3 帧和后3 帧分别为和作为原始红外图像的训练帧,将其灰度值反转得到和。迭代优化表观模型在线更新模块D,得到表观模型forg和frev,该部分的误差为。用建立好的表观模型和对测试帧和进行目标和背景的分类,并计算分类误差:

2)训练细节。骨干网络使用基于Image-Net 预训练的ResNet50,使用ICCV2021 Anti-UAV 数据集[29]的test-dev 作为训练集。训练时,在原始红外图像和反转红外图像上分别训练单分支SuperDiMP 模型,之后将训练得到的权重用于初始化双分支SuperDiMP 模型,进行网络微调。两次训练均训练50轮,每轮训练均通过在训练集中采样20 000 个视频片段,学习率每15 轮降低0.2,分类损失权重β=102,迭代优化线更新模块D 时Niter=5。

3)在线跟踪。对每一帧的原始红外图像进行灰度反转,经过骨干网络提取特征后,分别输入到分类网络和目标框回归网络中。对于两个分类分支的初始帧表观模型建立、候选框生成以及更新策略与DiMP[3]一致,两个模态各生成10 个候选框。IoU 特征提取模块提取两个模态的IoU 特征,使用互相关融合模块CF 得到融合后特征,由IoU 预测模块P根据融合后的特征预测各个候选框的IoU。最终,对于每个候选框,通过5 次梯度上升迭代最大化该候选框的IoU,取IoU 最大的前3 个候选框的均值作为当前帧目标边界框的预测值。

2 实验结果与分析

2.1 数据集及评价标准

模型的训练和测试分别使用Anti-UAV[29]数据集的训练集和测试集。该数据集包含训练集testdev 和测试集test-challenge 各140 段红外视频,视频中有不同尺度的无人机目标,涉及快速运动、目标消失、目标对比度反转等挑战。图像分辨率为640×512 像素。训练时使用ImageNet 上与训练的ResNet50 作为骨干网络,以及Anti-UAV 训练集dev进行训练。

评价标准采用成功率和精确率,即对于每一帧,计算算法预测目标框与标注框的IoU 以及它们之间中心位置距离,对于成功率,IoU 阈值设置为0.5,对于精确率,中心点距离阈值设置为20 个像素。

2.2 与基准算法对比

2.2.1 整体对比

本文算法基于SuperDiMP 进行改进,选取使用Anti-UAV 训练集test-dev 微调过的SuperDiMP 作为基准算法。本文算法在Nvidia Tesla A100 上运行速度12 帧/s,其中,双分支的特征提取骨干网络速度为50 帧/s,双分支分类模块速度为125 帧/s,特征融合及目标框回归模块速度为18 帧/s。

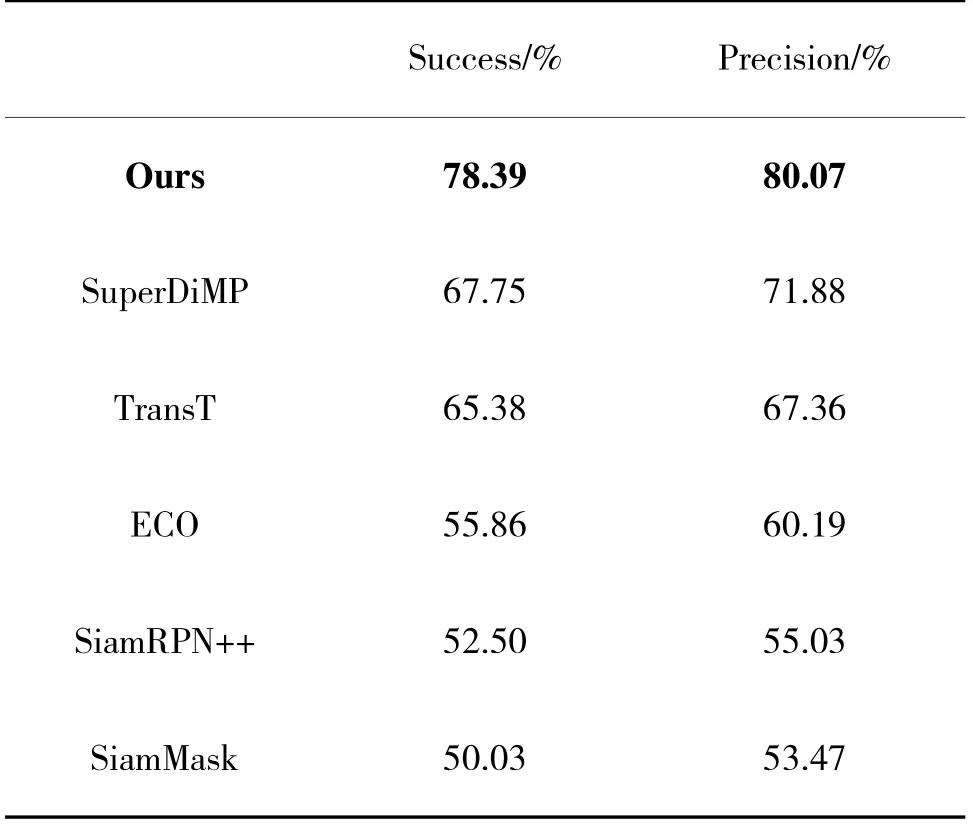

表1 是本文所提方法与基准算法的对比。从表1 可以看出,在测试集Anti-UAV test-challenge 上,本文所提算法成功率(Success)和精确率(Precision)分别达到78.39%和80.07%,较基准算法的成功率和精确率72.55%和75.55%分别提升5.84%和4.52%。

表1 Anti-UAV test-challenge 对比结果Table 1 Comparision results on Anti-UAV test-challenge

2.2.2 不同场景与目标尺寸对比

为深入分析本文算法高成功率和准确率的来源,按视频中目标的平均尺寸分类计算跟踪精确率。目标尺寸计算方法为人工标注的矩形框的面积。表2 记录了本文算法与基准算法对Anti-UAV测试集test-challenge 中不同大小目标的跟踪精确率。可以看出,对于不同尺寸的目标,本文算法均优于基准算法。

表2 不同目标尺寸跟踪精确率(%)Table 2 Tracking precision results(%)of different target sizes

将140 段视频分为不同场景,其中,净空云层73 段,建筑物背景50 段,山地背景15 段以及海面背景2 段,分别测试精确率。从表3 可以看出,本文算法在净空、云层、建筑物及海面背景均具有较高跟踪性能,而在复杂的山地背景,跟踪效果不佳。

表3 不同场景跟踪精确率(%)Table 3 Tracking precision results(%)of different scenarios

结合目标大小与场景分析,当目标尺寸大于1 600 像素时,本文算法与基准算法精确率都较高,相较于基准算法,本文算法精确率有提升但提升不大,主要是由于该类视频目标尺寸大,包含较多净空场景,跟踪难度较低。

当目标尺寸为400~900 像素、900~1 600 像素时,相较于基准算法,本文算法精确率提升显著,分别提升10.39%和7.82%。该部分视频主要由净空场景、云层背景及建筑物背景组成,对于净空背景和云层背景,两个算法均能保持稳定跟踪,而对于建筑物背景,本文算法有更高的鲁棒性。

当目标尺寸小于100 像素以及在100~400 像素之间时,相较于基准算法,本文算法精确率提升分别为3.14%及3.22%。该部分视频主要由净空背景、云层背景、山地背景、建筑物背景组成。对于净空背景和云层背景,两个算法均能保持稳定跟踪;对于小目标在山地背景的穿梭,两个算法都无法对目标进行持续跟踪;对于小目标在建筑物中穿梭,本文算法鲁棒性更高。

2.2.3 典型场景对比

Anti-UAV 数据集涵盖多种挑战,尺度变化,运动模糊,相似物干扰,目标对比度反转等。在这些挑战中,本文算法显示了优越的跟踪效果。图4 是本算法与基准算法的跟踪结果。

图4 本文算法与基准算法对比Fig.4 Comparison between the proposed method and benchmark algorithm

尺度变化。序列1 中,无人机往远处飞行,尺度逐渐变小,本文算法与基准算法均能较好地适应无人机的尺度变化,保持稳定跟踪。

对比度反转。序列2 中,无人机自右向左从温度较低的净空背景飞行穿越温度较高的建筑物,在建筑物背景中无人机对比度发生反转。基准算法无法适应该变化,而本文算法可以持续跟踪目标。

运动模糊。序列3 中,无人机目标与楼宇背景较为相似,由于镜头转动,导致图像模糊。基准算法首先漂移到目标的局部,然后跟丢,而本文算法在该场景下依然保持稳定跟踪。

相似物干扰。在序列4 中,无人机目标进入楼宇背景,存在大量窗户与无人机较为相似,在第253帧时,两个算法均能跟踪到目标,而第282 帧时,基准算法丢失目标,本文算法继续保持跟踪。

失败场景。在该数据集中,失败场景主要集中在山地背景。序列5 展示了当目标由净空背景进入山地背景时,本文算法与基准算法均出现了目标丢失。

对于图4 第2 行的对比度反转场景,其热力图如图5 所示,目标在进入建筑物背景之前,相对温度更高,目标区域灰度值更大,因此,跟踪的目标模板灰度值较大。当目标进入建筑物背景中,目标与背景间对比度发生反转,目标灰度值较低,而周围背景的灰度值较高,因此,背景的响应值较大。而在反转图像中,目标的灰度值较高,背景的灰度值低,目标区域的响应值较大。可见,反转红外图像能在该场景能与原始红外图像进行互补,提高跟踪性能。

图5 原始红外图像及反转红外图像目标置信分响应图Fig.5 Confidence responsive maps of the target objects in original infrared images and inverted infrared images

2.3 与其他算法对比

下页表4 是本文所提方法与基准算法以及以下主流算法在测试集Anti-UAV test-challenge 的对比:ECO[30],SuperDiMP,TransT[15],SiamRPN++[10],SiamMask[11]。可以看出,在测试数据集上,本文所提算法具有最佳成功率和精确率,分别达到78.39%和80.07%,均高于其他算法。

表4 Anti-UAV test-challenge 测试结果Table 4 Test results of the Anti-UAV test-challenge

2.4 不同特征融合方式对比

此外,在本文所提跟踪模型中,分别使用相加和互相关对IoU 特征进行融合,以验证本文算法的有效性及不同融合方式对算法的影响,对比结果如表5 所示。可以看出,互相关融合方法相较于相加,成功率和精确率分别提升7.3%和6.3%。这是由于互相关不仅能将目标区域的特征增强,同时非目标区域的特征会被抑制,而相加的方法,不仅对目标区域增强,也会对背景区域进行增强。

表5 Anti-UAV test-challenge 上的消融实验Table 5 Ablation experiment on Anti-UAV test-challenge

2.5 不同输入图像对比

为验证同时使用原始红外图像和反转红外图像的必要性,分别仅使用原始红外图像和仅使用反转红外图像作为模型输入进行测试,对比结果如表6 所示。可以看出,仅使用原始红外图像(Org)和仅使用反转红外图像(Rev)作为模型输入时,算法的精确率和成功率均低于同时使用原始红外图像和反转红外图像(Org+Rev)作为输入时模型的精确率和成功率。

表6 不同输入图像对比Table 6 Comparison of different input images

3 结论

本文提出了一种双分支红外目标跟踪算法,不同分支分别提取原始红外图像及反转红外图像的特征。在不同分支对目标进行匹配提高跟踪性能;双分支特征进行互相关融合增强目标区域特征使目标框回归更精准。

在ICCV2021 Anti-UAV 数据集上的实验结果表明,本文所提算法成功率和精确率均超越基准算法,在目标对比度反转等不同挑战下具备较高鲁棒性。相较于基准算法,跟踪成功率和精确率分别提升5.84%和4.52%。实验表明使用红外图像及其灰度反转图的双分支目标跟踪网络能提升红外目标跟踪的性能。

当前算法主要存在未达到实时运行速度,以及在复杂山地背景下跟踪效果不佳的问题。未来的工作重点是优化网络结构,提高算法速度;另一个是解决红外复杂背景下目标跟踪难点。