基于DeepLabV3+网络的机收大豆破碎率在线检测方法*

刘士坤,金诚谦,陈满,杨腾祥,徐金山

(1. 农业农村部南京农业机械化研究所,南京市,210014; 2. 安徽农业大学工学院,合肥市,230036)

0 引言

在大豆联合收获机作业过程中,机器参数的设置直接影响联合收获机作业质量。滚筒转速、脱离段脱离间隙、前进速度设置不当会提高机收大豆破碎含量[1-3]。现阶段,国内联合收获机作业过程中大豆破碎含量主要由机手停机后凭借肉眼观察和经验,该方法误判率高、效率低。因此,在联合收获机作业过程中在线检测大豆破碎含量,有助于驾驶员及时调整机器参数[4-6],提高联合收获机作业质量。

目前,国内对于谷物籽粒识别技术研究多以理论分析和台架试验为主[7-13]。刘爽等[14]提出利用高光谱成像系统结合机器学习提出了一种用于对大量小麦赤霉病籽粒样本快速可视化识别的算法可快速、准确对染病小麦进行识别;赵志衡等[15]针对完好花生、表皮破碎花生和果仁破损花生提出基于卷积神经网络的花生籽粒完整性识别算法,准确率达到98.18%;陈进等[16]利用基于阈值的图像分割方法,根据水稻完整籽粒、破碎籽粒、杂质不同颜色和面积特征进行快速准确识别分类。

为了实现联合收获机作业过程中大豆破碎含量在线检测,本文提出基于DeepLabV3+网络的机收大豆破碎率在线检测方法,设计大豆图像在线采集装置,对联合收获机出粮口流出的大豆进行采集、拍摄图像,研究基于DeepLabV3+网络的大豆破碎籽粒识别与分割。

1 大豆图像在线采集装置

大豆图像在线采集装置由图像采集模块和大豆采样模块组成。大豆采样模块主要由直流舵机、拨杆、挡板、采样槽等组成;图像采集模块主要由工业相机、LED光源组成,如图1所示。

笔记本电脑通过控制总线给直流舵机发送控制指令,驱动直流舵机动作带动挡板回缩,大豆采样槽释放大豆,延时100 ms,控制直流舵机动作带动拨杆拖动挡板,挡板伸出,大豆采样槽填装大豆,延时100 ms;当采样槽里大豆处于静态,笔记本电脑通过控制总线发送拍照指令给工业相机,控制工业相机采集大豆样本图像,将拍摄图像保存在文件夹内。

2 大豆籽粒检测算法

2.1 数据集制作

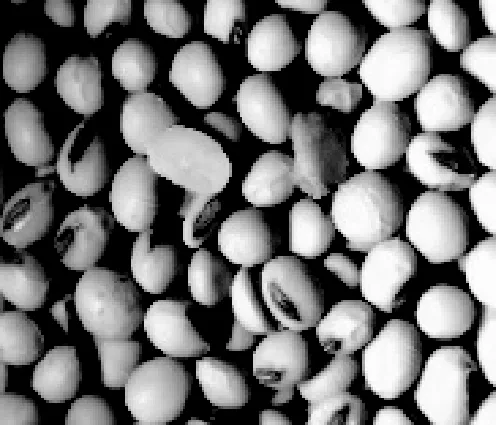

大豆样本图像采集工作于2021年10月18日使用上述装置在山东省济宁市任城区后刘村大豆试验田完成,采集大豆样本图像一共103张,图像大小为1 280 像素×1 024像素。本文主要对大豆样本图像中完整籽粒、破碎籽粒进行研究。破碎籽粒为由联合收获机收获造成裂瓣和压扁的籽粒,霉变大豆和自然破皮大豆算作完整籽粒,如图2所示。

(a) 样本图像

(b) 完整籽粒

(c) 破碎籽粒

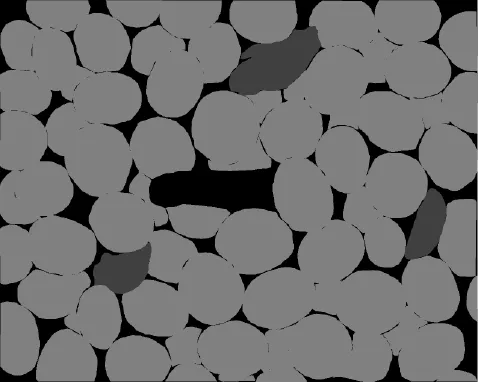

大豆样本图像中分为破碎籽粒、完整籽粒、背景三类。手工标记出图像中完整籽粒、破碎籽粒的边界,并对包括背景在内三种分类进行标记着色。完整籽粒RGB值为[128,128,128],破碎籽粒RGB值为[64,64,64],背景RGB值为[0,0,0],得到手工标记图,如图3所示,图3是图2(a)样本图像的手工标记图。采集的图像中100张用作训练数据集,3张用作测试集。将训练数据集中图像进行加黑边裁剪处理,一张分辨率为1 280像素×1 024像素的原始图像裁剪成六张分辨率为512像素×512像素的图像,共得到600张图像,以9:1的比例随机分为训练集和验证集,其中540张作为训练集,60张作为验证集。

图3 样本图像手工标记图

2.2 改进DeepLabV3+网络结构

DeepLabV3+[17]是谷歌开发的一种用于语义分割典型网络框架,由编码(Enconder)模块和解码(Deconder)模块组成。编码模块网络结构与DeepLabV3网络结构相同,利用Xception网络对输入图像进行特征提取,之后利用并行的不同空洞率的空洞卷积和池化将图像特征进行融合,在不损失信息的情况下,加大感受野。解码模块采用类似于Unet网络结构的上采样部分,融合Xception网络输出的底层特征和编码模块输出高层特征再进行双线性插值上采样将图像恢复至原图分辨率,完成图像语义分割。DeepLabV3+网络结构如图4所示。

图4 DeepLabV3+网络结构图

本文以轻量级卷积网络MobileNetV2替代编码器部分中Xception网络作为主干特征提取网络,其核心事深度可分离卷积模块,减少了模型的参数量,提高了网络收敛速度,MobileNetV2网络结构中倒残差结构使网络训练速度和提取精度更高。在此网络结构中,反向残差结构先运用1×1卷积进行升维,在采用3×3深度可分离卷积进行过滤并提取有效特征,最后使用1×1卷积进行降维;ReLu6激活函数替代ReLu激活函数避免当输出通道数较少产生严重信息损耗。MobileNetV2网络结构如图5所示。

图5 MobileNetV2网络结构图

2.3 网络训练

本文训练数据集共600张,其中训练集540 张,验证集60张。使用基于交叉熵函数作为训练集损失函数,计算公式如式(1)所示。

(1)

式中:loss——多分类交叉熵损失;

n——样本数量;

x——预测向量维度;

y——此像素点的真实值;

a——此像素点预测的概率值。

采用Dice系数差异函数作为验证集损失函数,计算公式如式(2)所示。

(2)

式中:Diceloss——Dice系数差异;

A——预测结果;

B——真实结果。

网络训练运行环境如表1所示,在该环境下构建网络、训练和预测。设置初始学习率为0.000 1,迭代次数100次。网络训练完成后,训练损失为0.111 6,验证损失为0.266 5,训练损失和验证损失曲线图如图6所示。

表1 网络训练环境表Tab. 1 Network training environment table

图6 训练损失和验证损失曲线

2.4 图像预测

首先在分辨率为1 280像素×1 024像素输入图像的右边添加一个分辨率为256像素×1 024像素的黑边,之后将图像裁剪成6张分辨率为512像素×512像素的图像;然后裁剪后的6张图像输入到训练好的DeepLabV3+网络模型进行预测;最后再将预测后的6张图像进行拼接去黑边得到输入图像的预测结果。裁剪拼接的预测原理如图7所示。

图7 裁剪拼接的预测原理

2.5 预测效果评估

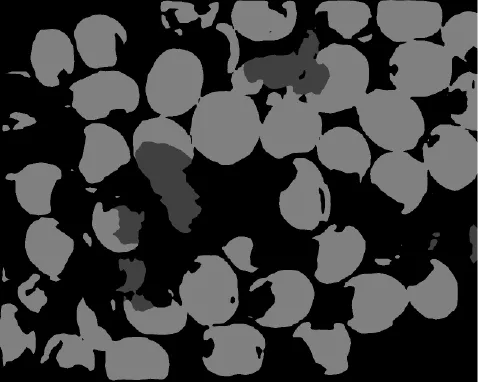

随机从测试集抽取一张大豆样本图像采用裁剪拼接的方式进行预测,预测结果如图8所示。与手工标注图相比,整张预测存在明显漏判、误判;裁剪预测的效果明显较好。

(a) 原图

(b) 手工标注图

(c) 整张预测图

(d) 裁剪预测图

本文采用的图像分割评价指标是精确率P、召回率R、综合评价指标F1。

(3)

(4)

(5)

式中:TP——将正确分类像素点预测为正确分类像素点;

FP——将错误分类像素点预测为正确分类像素点;

FN——将正确分类像素点预测为错误分类像素点。

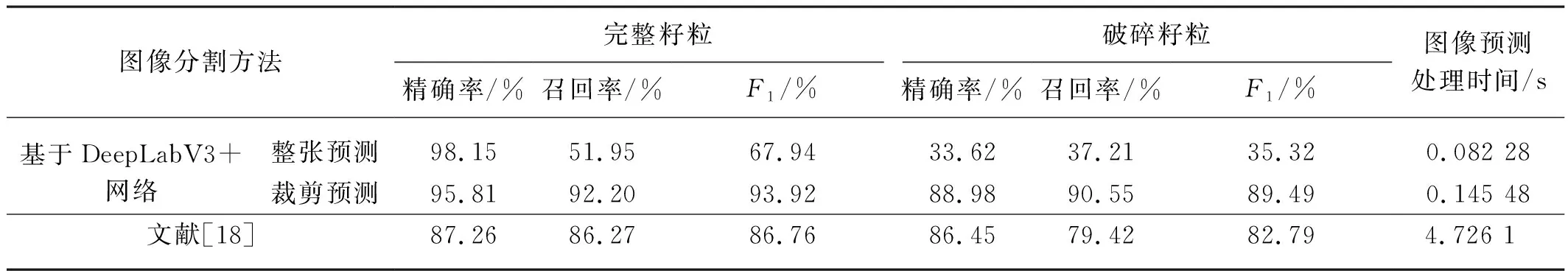

分别统计出分割结果中破碎籽粒、完整籽粒的精确率、召回率、综合评价指标F1,如表2所示。

表2 分割结果评估Tab. 2 Evaluation of segmentation results

由表2可知,与文献[18]相比,本文提出的基于DeepLabV3+网络裁剪预测的图像预测处理时间节省4.580 62 s,完整籽粒的综合评价指标提高7.16%,破碎籽粒的综合评价指标提高6.7%;与整张预测相比,本文提出的裁剪预测分割效果明显较好,完整籽粒的综合评价指标提高25.98%,破碎籽粒的综合评价指标提高54.17%,但图像预测处理时间增加0.063 2 s,这主要是因为增加裁剪和拼接操作产生一定的耗时。

3 试验与分析

3.1 破碎率量化模型

现有的大豆联合收获机作业质量检测方法中破碎率计算是通过籽粒的质量计算不适用基于图像识别的破碎率计算。根据现有的计算方法,制定了基于图像识别的破碎率量化模型,计算公式如式(6)所示。

(6)

式中:Ps——破碎率%;

Tw——预测图像中完整籽粒像素点数;

Ts——预测图像中破碎籽粒像素点数。

3.2 试验材料与试验地点

试验地点为农业农村部南京农业机械化研究所东区,试验时间为2021年11月25日,本次试验所用大豆品种为齐黄34,大豆籽粒平均含水率为11.9%,千粒籽重为235.8 g。

试验台架由粮箱、出料斗、刮板升运器、电机、搅龙和大豆采样装置组成,如图9所示。试验时,采样装置安装于出料斗下方,启动电机,大豆循环从出料斗出来,落入采样装置内。

图9 台架试验

3.3 试验方法

3.3.1 试验设计

将试验大豆分为三份,分别进行三组台架试验。每组台架试验,使用大豆破碎率在线检测方法检测40次,记录检测结果并计算平均值。参照NY/T 738—2020《大豆联合收获机作业质量》将每份大豆分成四部分人工检测出每部分大豆的破碎率并计算平均值。

3.3.2 试验步骤

将采样装置安装在试验台架出料斗下方,连接好设备并调试;取一份试验大豆倒入试验台架粮仓内;启动电机,开始自动检测,及时保存试验数据;检测40次后关闭电机,清理出粮仓内大豆;分别取剩下两份试验大豆重复试验。

3.4 试验结果分析

随机从台架试验中采集的图像中选取一张图像,使用标注软件对图像进行手工标注,如图10所示。将手工标注图与预测图验证得破碎籽粒的精确率为85.41%、召回率为84.24%、综合评价指标F1为84.22%;完整籽粒的精确率为94.49%、召回率为94.33%、综合评级指标F1为94.41%。

(a) 原图

(b) 手工标注图

(c) 预测图

采用大豆破碎率在线检测方法检测破碎率最大值为5.72%,最小值为0.11%,均值为3.21%;人工检测破碎率最大值为3.16%,最小值为2.63%,均值为2.89%。试验数据表明,相比于人工检测,采用大豆破碎率在线检测方法检测得到的破碎率均较大,破碎率平均值相对误差为0.36%,由此可见本文提出的检测方法能够成为大豆联合收获机破碎率在线检测的有效手段。

4 结论

1) 为了在大豆联合收获机作业时可以实时获取收获的大豆破碎含量,对机收大豆破碎率在线检测方法进行了研究。提出一种利用大豆图像采样装置结合基于DeepLabV3+语义分割模型的机收大豆破碎率在线检测方法。

2) 大豆图像在线采集装置通过控制直流舵机带动拨杆拖动挡板实现大豆的动态采样,利用该装置在联合收获机作业时采集大豆样本图像,通过手工标注和图像裁剪建立训练集和测试集,选择基于DeepLabV3+深度学习网络对训练集图像进行训练,建立预测分割模型分割出大豆破碎籽粒、完整籽粒,计算各分类像素数并建立破碎率量化模型计算破碎率。从测试集中随机选取一张大豆样本图像,采用综合评价评价指标评估预测分割效果,结果显示,完整籽粒综合评价指标为93.92%,破碎综合评价指标为89.49%。

3) 采用本文提出的机收大豆破碎率在线检测方法进行台架试验,试验结果表明:采用本文提出大豆破碎率在线检测方法检测结果平均值与人工检测结果平均值相对误差0.36%。

4) 本文提出的基于DeepLabV3+网络的机收大豆破碎率在线检测方法能够快速准确分割大都图像中破碎籽粒和完整籽粒并计算破碎率,为大豆联合收获机作业质量在线检测提供参考。