基于ChipGAN-ViT模型的汉绣艺术风格迁移与模拟

沙莎 李怡 蒋惠敏 陈雅卓

摘要:针对真实图像与汉绣图像在风格迁移融合过程中产生的针法工艺模糊和边界伪影问题,提出了基于ChipGAN-ViT模型的汉绣风格迁移方法。由于刺绣纹样内部与背景留白具有不同的线迹填充效果,算法首先利用ChipGAN-ViT模型对前景进行纹理重构,再利用循环生成对抗网络对风格图像和内容图像进行风格迁移;其次,采用 Sobel算子对汉绣图像进行边缘轮廓提取,以满足汉绣数字化模拟的内容图像需求;最后,对生成的风格迁移图像进行超分辨率处理获得最终汉绣数字化图像。实验结果表明:该方法可有效模拟出汉绣平顺且配色丰富的艺术特点,相比传统的ChipGAN、CNN算法迁移时间缩减了30.58%和41.52%。所提出的汉绣风格迁移方法是对风格迁移技术的有效补充,为汉绣图案的创新设计提供了新的可能。

关键词:风格迁移;生成对抗网络;ChipGAN-ViT模型;损失函数;画稿模拟

中图分类号:TS195.644 文献标志码:A 文章编号:2097-2911-(2023)02-0068-10

Transfer and Simulation of Chinese Embroidery Art Style BasedonChipGAN-ViT Model

SHA Shaa,b,LI Yic,JING Huiminc,CHEN Yazhuoc

(a. Institute of Design Innovation and Fiber Science;b. Wuhan Textile and Garment Digital Engineering TechnologyResearch Center;c. School of Fashion, Wuhan Textile University, Wuhan 430073, China)

Abstract:To address the issues of ambiguity in the stitch process and boundary artifacts during style transfer and fusion between real images and Han embroidery images, this paper proposes a method for Han embroidery style transfer based on the ChipGAN-ViT model. Firstly, the algorithm utilizes the ChipGAN-ViT model to re- construct the texture of the foreground, taking into consideration that different stitch filling effects exist between the interior of embroidery patterns and blank backgrounds. Then, a cyclic generation adversarial network is em- ployed to transfer both style and content images. Additionally, Sobel operator is utilized to extract edge contours from Han embroidery images in order to meet content image requirements for digital simulation of Han embroi- dery. Finally, super resolution processing is applied to enhance details in the style transferred image, resulting in a final digital representation of Han embroidery. Experimental results demonstrate that this approach effectively simulates smoothness and vibrant artistic features of Han embroidery while reducing migration time by 30.58% compared with traditional ChipGAN algorithms and 41.52% compared with CNN algorithms respectively. Thismethod serves as an effective supplement to style transfer technology while offering new possibilities for inno- vative design of Han embroidery patterns.

Key words: style transfer;generative adversarial networks;ChipGAN-ViT model;loss function;Draft simulation

引言

作为湖北地区独特的绣种,汉绣以其粗犷的针法,多变的造型手法和充满活力的构图在文化艺术中占据重要地位。汉绣作品注重色彩搭配,还受到传承人针法技艺水平的影响,这导致了现代实用价值较低且应用较少。随着计算机技术和图像处理方法的发展,学者已经开始对民族烙画[1]、刺绣[2]和云锦[3]等工艺美术作品进行风格迁移研究。近年来,越来越多的学者和设计师将目光聚焦于民族图案,并深入探索传统历史文化中蕴含的特色元素,致力于设计具有中国特色的民族图案[4, 5]。因此,在数字化科技赋能民族图案创新的背景下,如何在保留民族图案艺术特色基础上进行风格化迁移[6]是亟需解决并突破的问题。本文以汉绣的工艺图案为例,探索真实图案与汉绣风格之间存在的差异,并采用图像风格迁移方法增加汉绣元素及针法应用。

风格迁移方法指在保留图像语义内容不变的情况下对图像进行不同风格的艺术渲染。GAT- YS等人[7]利用深度神经网络和Gram矩阵分别提取内容和风格特征,使用中间激活层将两者进行融合,最终获得了风格化结果;JOHNSON等人[8]引入基于前馈风格化模型实现快速风格迁移,大大地提高了风格迁移的速度;ULYANOV等人[9]通过多尺度架构产生更多的并行通道,强调更复杂的网络和富有表现力的损失函数从而获得了轻量级的网络和质量相当的风格图像。以上方法主要研究对图像全局的迁移,为了实现局部风格迁移, EFROS和LEUNG[10]采用一种纹理合成的非参数方法,基于马尔科夫随机场(Markov Random Field,MRF)模型选取与待填充像素周围纹理对该点进行填充,实现局部纹理结构的填充;缪永伟等人[11]针对局部迁移对象与未迁移区域的衔接问题,提出了曼哈顿距离的求解算法,实现了边缘的平滑过渡;孙冬等人[12]提出了局部区域控制的图像样式转移算法,获得了更精细完整的目标轮廓。

在汉绣图案研究领域,许多学者主要关注于刺绣的艺术特点[13, 14]、可持续传承[15, 16]以及在现代服装中的应用[17, 18],但对于模拟汉绣图案风格的作品还不够充分。由于传统风格迁移模型容易产生针法工艺模糊和边界伪影等问题,导致迁移效果不清晰美观。因此,本文将从真实汉绣的勾形、打底和针法特征出发,首先利用ChipGAN- ViT网络来重构前景纹理,以植物为例填充齐平针的纹理,如图1所示,通过transformer提取全局像素的输入序列来增强汉绣图像的语义特征;其次,对获取到的纹理图像进行分类除杂,并使用 Sobel算子提取目标图像的轮廓以将前景与背景分离开;最后对前景和背景进行纹理填充,并将二者进行图像融合,从而生成具有真实汉绣艺术风格的高质量图像。

1汉绣风格迁移实现框架

荆州地区汉绣题材纹样种类繁多,包括动物、植物、人物、建筑等图案,背景大多都为纯色的棉麻丝毛面料等。在制作汉绣作品时,前景背景需要不同粗细、方向或角度的针法走向,如图1所示,齐平针从图案的内缘起针且针脚整齐,与图案边缘线迹无出入,齐整针密。因此,提取目标图像的边缘轮廓,对汉绣特定的针法进行纹理模拟,有利于将前景图案边缘和背景针法自然衔接,产生更加逼真,纹理平滑的艺术风格图像。本文提取齐平针的纹理特征,通过模拟该针法的走向扩充汉绣背景图像,控制汉绣背景纹理方向。

图2为本文风格模拟系统框架图。在前景合成之前,利用 Sobel算子提取收集到的图像边缘轮廓,生成不同题材的汉绣白描图,并根据形态学对画稿图像边缘进行平滑处理,模拟汉绣的画稿纹样;为了更好对前景的纹理进行填充,将ChipGAN模型中生成器替换为Vit Generator,不断的优化边缘损失和纹理损失,生成具有汉绣针法的纹理效果。

2汉绣艺术风格迁移模型

本文提出一种组合型的风格迁移模型,在原始ChipGAN网络的基础上引入了ViT(vi- sion of transformer)视觉网络,从而实现对输入图像先分类再迁移的过程。ChipGAN-ViT模型表现出高度的灵活性和扩展性,通过训练来适应不同类型的风格迁移任务,并且能够处理各种规模和复杂度的计算框架。其次,与传统方法相比,该模型能够更好的捕捉全局信息和长距离依赖关系,充分理解整体的迁移场景以更快的速度完成任务。此外,该模型还具备自动化特征提取和学习能力。通过深度学习技术,它可以从大量样本中自动提取关键特征,并将其应用于新样本上,这种自动化特征提取功能使得模型变得更智能化和高效化。总之,基于灵活性、准确性、效率、自动化特征提取以及并行计算等优点,Chip- GAN-ViT在计算机视觉领域展现了强大的潜力和优势,它不仅扩展了对深度学习框架应用范围,还为解决复杂、全局感知相关问题提供了新思路和方法。

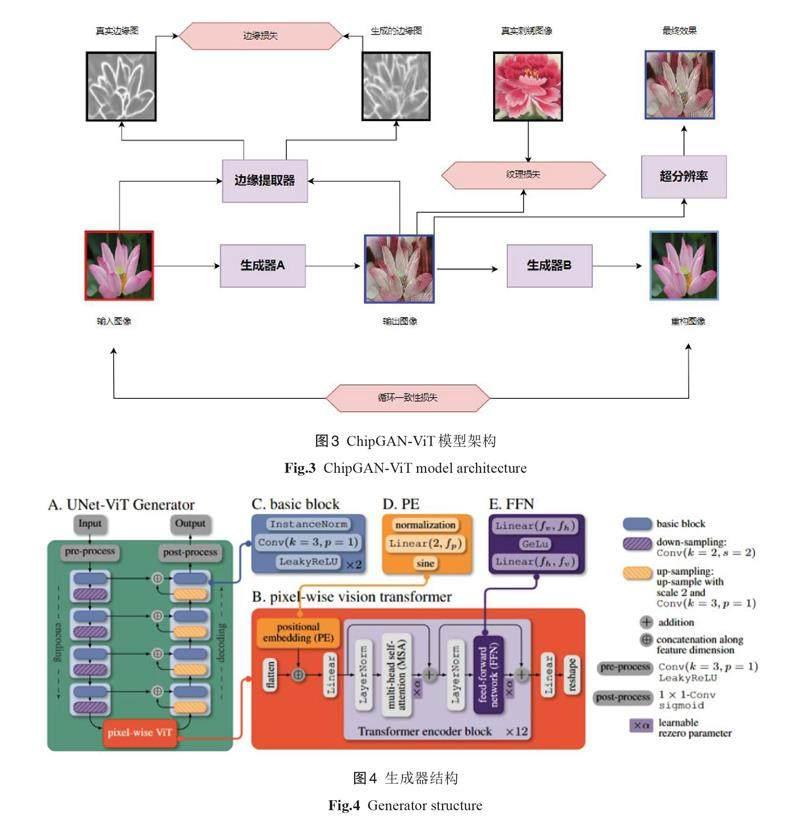

ChipGAN-ViT的工作流程如图3所示,输入真实的荷花图像,经过生成器A生成具有汉绣针法风格图像的荷花,再利用生成器B重建生成荷花的图片,计算真实的荷花图像和重构后的荷花图片的循环一致性损失,将真实的荷花图像和生成的荷花图像输入边缘提取器 Sobel,并计算笔触边缘损失;在网络结构中加入纹理损失,对输出的图像进行超分辨率处理,从而得到更大像素密度、更多纹理细节的汉绣风格迁移图像。

2.1生成器模型

ChipGAN-ViT的生成器主要由两部分构成——UNet-ViT Generator 和 Pixel-Wise Vision,如图4所示。UNet-ViT Generator由编码器(Encod- er)和解码器(Decoder)组成,首先对输入的图像x 进行预处理,通过卷积层和下采样层对矩阵图像进行特征提取;其次提取的信息经过Pixel-Wise Vision Transformer 结构,利用 PE 层将输出的图像拉平分块处理,并根据token将划分后的图像块组合成序列,通过 Transformer 特有的 Multi- head Self-attention 结构关注不同区块的重要程度,加上一个全连接层分类就形成了整个Trans- former Block结构;最后对分类得到的图像进行多层卷积和上采样转换为域Y的元素。

2.1.1 UNet-ViT Generation

UNet结构整体外观呈U 型结构,左半部分为encoding,由两个3×3的卷积层(RELU)和2×2的最大池化层组合成下采样(down-sampling);右半部分由两个3×3的卷积层(RELU)、一个上采样(up-sampling)去卷积层和特征拼接的 con- cat循环构成decoding模块。下采样模块通过收缩路径降低输入图像的分辨率,增大特征通道的数量,生成对应图像的缩略图;上采样利用反卷积法恢复图像的维度和部分特征。为了保留更多的信息特征,在编码器输出真实图像和decod- ing之前加入 Pixel-Wise Vision Transformer 模块改善图像风格迁移的效果,如图4所示。

2.1.2 Pixel-Wise Vision Transformer

Vision Transformer被称为像素级Transform- er 编码器,通过对图像进行拉平切块处理减少了在卷积过程中信息丢失的问题,针对本文的汉绣针法工艺和风格,提高了ChipGAN-ViT算法在复杂环境下对细小纹理的有效性和可行性。

该结构主要由Positional Embedding(PE)层、 Transformer Encoder block 和 FFN(前馈网络)三部分组成。首先,利用语义切块将图像像素划分为尺寸相同的区域块,由PE层对像素进行特征提取,将大小为224×244的图像分割为16×16的像素块,因此每个图片的序列长度为196。每个像素矩阵是三维的,通过线性卷积层,在每个区块特征加入位置编码Cls,输入维度的总特征数为197×768。其次,Transformer编码器的多头注意力机制(MSA)可以辨识各个区域块的特征,将特征块与其他像素信息进行映射,融合不同图片Cls特征。最后,通过 FFN 对 MSA 特征进行分类,具体计算公式如(1)-(4)所示:

式中Epos 表示PE层输入特征序列,ZL(0)、Z0、z?为不同状态下图像空间卷积矢量,xclass代表某类标签图像,xp(n)∈?(P2? C)? D 表示二维像素块,左上角1~n代表像素块编号,C为通道数维数,P为像素块大小,一共有 N 个像素块,N=HW/P2,x ∈?H ? W ? C 为输入图片;MLP表示浅层全连接神经网络,为多层感知机函数;Z为输出分类结果。

将U-Net与GAN结合起来,可以进一步提高分割结果的质量和细节。通过使用生成器来生成更精细的分割结果,判别器可以指导生成器生成更逼真的分割结果。生成器和判别器之间的对抗性训练可以推动两者相互提升,最终获得更好的分割效果。

2.2损失函数设计

2.2.1对抗损失

为了将生成的汉绣图像更加贴近真实的目标汉绣风格图片,采用对抗损失来减少输出图像分布于真实汉绣图像的标注。由于传统的交叉熵损失通常会训练学习到每一个样本,分配所有的概率到每一个实际标签上,从而导致模型的泛化能力较差。针对真实的植物数据集样本和汉绣图像样本y,模型包含了两个映射G:X→ Y和 F:Y→ X,对于生成器 G:X→ Y及判别器 Dy 二者的对抗性损失如式(5)所示:

式中G从域Y中拟合与真实植物类似的数据,Dy 判断输入的数据是真实还是虚假。其中 E(*)表示分布函数的期望值,Pdata (x)为真实的植物样本分布。当参数不断交替迭代,G 取得最大值 Dy 取得最小值时,生成样本的质量较好,取得全局最优解。

2.2.2循环一致性损失

循环一致性指输入图像经过生成模型后再经过生成器的反向模型得到的循环过程,其输出的图像与原图像一致性的过程。输入真实的荷花图像 x 和汉绣风格图像 y ,输入生成器GA 产生GA (x,y)图像;其次再经过生成器GB 得到重构图像GB (GA (x,y)x),最终输出的图像最大可能接近原图像 x ,即GB (GA (x,y),x)≈ x 。因此,循环一致性的损失定义为式(6)所示:

式中:GA、GB 分别代表A 和 B 生成器;pdata (x)、pdata (y)分别为真实的植物样本分布和汉绣图像数据集;GA(GB (y,x),y)表示重构真实植物图像; GB (GA(x,y),x)表示重构汉绣风格图像。

2.2.3边缘损失

为了确保重构的图像整体的准确性,结构损失指导网络产生突出的图像结构,利用边缘损失作为结构损失的基础,约束真实植物图像和预测植物图像之间的高频分量。在训练过程中将高频成分限制在真实边缘与生成器生成的边缘之间,定义边缘损失如式(7)所示:

式中:Lap(Ireal)和 Lap(IG)分别表示通过拉普拉斯算子从真实图像和生成器输出图像中提取的边缘图像,ε为非负阈值,用于减少噪声和提高模型的鲁棒性。

2.2.4纹理损失

纹理损失也称为风格重建损失,通常利用不同特征通道的相关性来衡量与原有图像的相似风格(色彩、纹理、饱和度等)。纹理损失函数通过感知图像在训练模型的高位特征空间中进行相似性计算,在卷积过程中提取生成器与判别器输出的特征映射图从而计算对应的格拉姆矩阵(Gram),迭代的生成输出图像,其网络的纹理损失函数为式(8)所示:

其中,G表示Gram矩阵,可训练出一个生成全局纹理的神经网络,G(F)=FFT 。根据纹理损失最小化引导生成模型输出更接近真实图像的纹理特征,从而提高生成图像的质量。

2.3汉绣画稿图的边缘提取

传统汉绣的完成首先需要汉绣设计者对图案进行构图设计,其次需根据不同对象选择相应针法,并对绣娘的缝纫技巧有较高要求。为了降低汉绣漫长的工期和传承人的刺绣难度,本文对搜集和拍摄不同类型的真实图像进行数据清洗,提取需要的汉绣纹样,生成不同题材的画稿,通过最小值法获取目标图像的边缘轮廓,最后对得到的画稿图进行齐平针的纹理填充,从而模拟真实汉绣的绣制过程。

边缘轮廓提取通常指在图像中高频分量和低频分量变化强度较大的像素区域,以灰度突变为基础划分出目标边缘。Sobel算子[19]属于一阶离散微分算子,结合了高斯平滑与微分求导计算图像灰度函数的近似梯度,具有原理简单、运行速度快、计算量小的优势。因此,采用 Sobel算子对汉绣图像进行边缘检测。假设 f(x,y)表示一幅汉绣图像,其在点 f(x,y)的梯度为矢量,定义如式(9)所示。

其中?fx,y表示梯度的模。

在 Sobel算子提取边缘轮廓前,采用高斯滤波(Gauss filtering)的方法,用卷积扫描目标图像的逐个像素,经过卷积核确定邻域像素加权平均灰度值替代中心像素点的值。Sobel算子的具体步骤如下:

(1)设置水平和垂直两个方向3×3的卷积核,同时从上到下,从左到右逐像素进行遍历,对扫描目标图像所有像素点组成的卷积核进行离散卷积运算。

(2)将两个离散卷积结果的最大值代替中心像素点的最大值,用 Pmax 表示。

(3)选取合适的阈值 t 进行二值化处理,当 Pmax ≥ t ,判断该区域为图像的轮廓,否则该区域为背景。

图5(a)为输入的原图,图5(b)为经过 Sobel 算子输出的结果图像,从图中可以看出生成的轮廓边缘清晰,纹路线条平滑,为模拟汉绣的画稿奠定基础。

图像噪声去除是改善图像视觉效果的重要手段之一,其基本的原理是设置不同大小的滤波器对目标图像进行不断的迭代获取最优解,实现边缘平滑和噪声去除的步骤。为了凸显纹样与绣底之间的色彩反差,让图案在绣面中更立体生动,根据各向异性扩散[20]对图像进行处理,增强边缘和内部的纹理特征,使最终的图像更加接近真实的画稿纹样,如图6符合刺绣前期绣底的纹样效果,且线条均匀流畅,确保图案的完整性。

3实验结果与分析

本实验在Windows10操作系统进行,计算机硬件系统为 Intel(R) Core(TM) i7-10700 CPU @2.90GHz 2.90 GHz,32GB 内存;运行环境为py- thon3.9,Pytorch和Anaconda3。实验采用爬虫的2000张数据集进行训练,其中数据集比例为训练集:验证集:测试集=8:2:2,通过图像裁剪拉平处理扩展数据集。

3.1定量结果分析

为了验证汉绣风格图像生成质量的有效性,本文使用弗雷歇距离(FID)、结构相似性(SSIM)、峰值信噪比(PSNR)、风格迁移时间(Time)作为图像生成效果的评价指标。FID 表示生成图像与真实图像之间的距离,SSIM从亮度、对比度和结构评价图片的相似性,PSNR则根据像素点的差异判断图像的失真度。ChipGAN模型、CNN 和ChipGAN-ViT模型实验结果进行对比如表1所示。

表1可得,本文ChipGAN-ViT对比 Chip- GAN 模型、CNN,弗雷歇距离数值分别减少了1.30%、2.78%;结构相似性增加了10.20%、15.37%;峰值信噪比增长了4.19%、5.90%;风格迁移时间减小了30.58%和41.52%。综合上述数据分析,本文的模型算法能够快速的生成风格化图像,生成的汉绣风格图像质量较高,验证了该方法的有效性。

3.2定性结果分析

图7展示了ChipGAN、CNN 和本文提出的ChipGAN-ViT模型风格迁移的结果。由图7(c)可以看出,根据ChipGAN模型输出的迁移结果轮廓完整,但背景色彩杂乱且不完整,无针法纹理的迁移。这源于笔触约束与循环一致性损失学习了图像的轮廓和色彩纹理,从而像素之间生成了相应的迁移。采用CNN模型生成的结果虽然实现了整体的风格迁移,但迁移的边缘产生了伪影区域和背景模糊问题,如图7(d)所示。

本文的优化模型在提取画稿边缘的基础上增加了纹理、边缘损失,由图7(e)可知,放大五倍查看细节图,前景和背景都填充齐平针的针法;前景的花瓣为嫩粉色,背景衬托绿色的荷叶,色彩边界清晰;最终的迁移效果完整的保留了画稿的轮廓及细节线条,突出了汉绣齐平针的针法工艺和热闹的主题特点,模拟出真实刺绣作品的生动立体、层次分明、色彩丰富的艺术特点。

4结论

针对风格迁移技术中汉绣艺术模拟中出现的边界伪影、针法模糊和轮廓不清晰问题,提出基于ChipGAN-ViT模型的汉绣风格迁移方法。利用循环一致性损失减小生成图像与原始图像的差异,得到更真实和自然的针法线迹。在上述基础上,加入边缘损失和纹理损失实现针法色彩填充的风格迁移。实验结果表明,本文模型相较于ChipGAN、CNN等风格迁移方法,迁移速度更快,生成的风格化图像质量更高,为风格迁移的艺术表现形式提供了更多的可能。算法迁移的结果可应用于服饰作品,文创产品制作以及非遗文化保护工作等领域。

尽管本文的迁移工作取得良好的效果,但还存在一些不足之处需要在后续工作中加以改善,例如:选择多种针法进行不同对象的迁移、迁移的结果仅限于静态的图片等。在今后的研究工作中,对不同特色的绣种进行充分的收集和分类,构建交互式的刺绣风格迁移系统,将独特而精致的刺绣纹样应用到虚拟试衣技术中,让更多的人们深刻地感受民族服饰特色之美,对传统的刺绣文化的保护与传承具有重要的意义。

参考文献:

[1]吴航,徐丹.葫芦烙画的艺术风格迁移与模拟[J].中国科技论文, 2019, 14(3):278-284.

WU Hang, XU Dan. Artistic style transfer and sim- ulation of gourd pyrography[J]. Chinese scientific and technological papers, 2019, 14(3):278-284.

[2]冯培超,钱文华,徐丹,等.苗绣艺术风格针迹模拟研究[J].图学学报, 2019, 40(4):802-809.

FENG Peichao, QIAN Wenhua, XU Dan, et al. Miao embroidery art style stitch simulation re- search[J]. Journal of Graphics, 2019, 40(4):802-809.

[3]邱雪琳,孙迎,刘正,等.基于色彩优化的云锦局部风格迁移[J].丝绸, 2022, 59(12):64-70.

QIU Xulin, SUN Ying, LIU Zheng, et al. Local style transfer of Yun brocade based on color opti- mization[J]. Journal of Silk, 2022, 59(12):64-70.

[4]何文泽.基于生成式对抗网络的民族图案生成研究[D].长春:吉林大学, 2022.1-2.

HE Wenze. Research on ethnic pattern generationbased on generative adversarial network[D].Changchun: Jilin University, 2022.1-2.

[5]秦臻,刘永红,郑栋毅.语义驱动的侗族织锦图案辅助设计路径研究[J].包装工程, 2021, 42(14):65-73.

QIN Zhen, LIU Yonghong, ZHENG Dongyi. A se- mantic-driven approach to aided design of Dong brocade patterns[J]. Journal of Packaging Engi- neering, 2021, 42(14):65-73.

[6]陈鋆纯,季铁,彭坚.基于风格特征的花瑶挑花图案智能设计路径[J].丝绸, 2023, 60(9):112-119. CHEN Yunchun, JI Tie, PENG Jian. Intelligent de- sign path of Huayao cross-stitch pattern based on style characteristics[J]. Journal of Silk, 2023, 60(9):112-119.

[7]GATYS L A, ECKER A S, BETHGE M. A neural algorithm of artistic style[J]. Journal of Vision,2015, arXiv:1508.06576.

[8]JOHNSON J, ALAHI A, FEI- FEI L. Perceptual losses for real-time style transfer and super-resolu-tion[C]// European conference on computer vi-sion, 2016.694-711.

[9]ULYANOV D, LEBEDEV V, VEDALDI A, et al. Texture networks: Feed - forward synthesis of tex- tures and stylized images[J]. arXiv e-prints, 2016,arXiv:1603.03417.

[10]EFROS A A, LEUNG,T K. Texture synthesis by non-parametric sampling[C]//Proceedings of theSeventh IEEE International Conference on Com-puter Vision, Kerkyra, Greece, 1999, 1033-1038.

[11]缪永伟,李高怡,鲍陈.基于卷积神经网络的图像局部风格迁移[J].计算机科学, 2019, 46(9):259-264.

MIAO Yongwei, LI Gaoyi, BAO Chen. Image lo- cal style transfer based on convolutional neural network[J]. Computer Science, 2019, 46(9):259-264.

[12]孙冬,时宇,高刘雅.局部图像风格迁移绘制算法[J].安徽大学学报(自然科学版), 2022, 46(3):72-78.

SUN Dong, SHI Yu, GAO Liuya. Local image style transfer rendering algorithm[J]. Journal of Anhui University (Natural Science Edition), 2022, 46(3):72-78.

[13]宋漫,刘安定,李斌.汉绣与荆楚刺绣关系考辨[J].丝绸, 2023, 60(10):124-131.

SONG Man, LIU Anding, LI Bin. Discussion on the relationship between Han embroidery and Jingchu embroidery[J]. Journal of Silk, 2023, 60(10):124-131.

[14]钟蔚.汉绣纹样的艺术特征提取研究[J].服饰导刊, 2018, 7(2):23-29.

ZHONG Wei. Research on the extraction of artis-tic features of Han embroidery patterns[J]. Fash- ion Guide, 2018, 7(2):23-29.

[15]沈艺婷.文旅融合视域下汉绣的可持续发展模式研究[J].西部皮革, 2022, 44(20):88-90.

SHEN Yiting. Study on the sustainable develop- ment model of Han embroidery from the perspec-tive of cultural and tourism integration[J]. Jour-nal of Western Leather, 2022, 44(20):88-90.

[16]颜雪晨.汉绣文化的数字化保护与传承模式[J].纺织报告, 2022, 41(6):113-115.

YAN Xuechen. Digital protection and inheri- tance mode of Han embroidery culture[J]. Textile Report, 2022, 41(6):113-115.

[17]刘丹丹.汉绣元素在现代产品设计中的应用研究[D].武汉:湖北美术学院, 2022.1-4.

LIU Dan. Research on the application of Han em- broidery elements in modern product design[D].Wuhan: Hubei Institute of Fine Arts, 2022.1-4.

[18]李素媛,何佳琦.荆楚汉绣在现代女性婚礼服设计中的应用研究[J].化纤与纺织技术, 2022, 51(2):152-155.

LI Suyan, HE Jiaqi. Research on the applicationof Jingchu and Han embroidery in modern wom- en's wedding dress design[J]. Chemical Fiber and Textile Technology, 2022, 51(2):152-155.

[19]刘源,夏春蕾.一种基于 Sobel算子的带钢表面缺陷图像边缘检测算法[J].电子测量技术, 2021, 44(3):138-143.

LIU Yuan, XIA Chunlei. An algorithm for edge detection of strip surface defect image based on Sobel operator[J]. Electronic Measurement Tech- nology, 2021, 44(3):138-143.

[20]YU J, WANG Y, SHEN Y. Noise reduction and edge detection via kernel anisotropic diffusion [J]. Pattern Recognition Letters, 2008, 29(10):1496-1503.

(责任编辑:周莉)