基于无锚的轻量化孪生网络目标跟踪算法

丁贵鹏 陶钢 庞春桥 王小峰 段桂茹

摘要: 针对运算资源受限条件下难以实现高精度、 高帧率跟踪的问题, 提出一种基于无锚的轻量化孪生网络目标跟踪算法. 首先使用修改的轻量级网络MobileNetV3作为主干网络提取特征, 在保持深度特征表达能力的同时减小网络的参数量和计算量; 然后对传统互相关操作, 提出图级联优化的深度互相关模块, 通过丰富特征响应图突出目标特征重要信息; 最后在无锚分类回归预测网络中, 采用特征共享方式减少参数量和计算量以提升跟踪速度. 在两个主流数据集OTB2015和VOT2018上进行对比实验, 实验结果表明, 该算法相比于SiamFC跟踪器有较大的精度优势, 并且在复杂跟踪场景下更具鲁棒性, 同时跟踪帧率可达175 帧/s.

关键词: 目标跟踪; 孪生网络; 轻量级网络MobileNetV3; 互相关模块; 无锚

中图分类号: TP391文献标志码: A文章编号: 1671-5489(2023)04-0890-09

Lightweight Siamese Network Target Tracking AlgorithmBased on Ananchor Free

DING Guipeng1, TAO Gang1, PANG Chunqiao1, WANG Xiaofeng1, DUAN Guiru2

(1. School of Energy and Power Engineering, Nanjing University of Science and Technology, Nanjing 210094, China;2. Military Representative Office in Jilin Region, Army General Armament Department, Jilin 132000, Jilin Province, China)

Abstract: Aiming at the problem that it was difficult to achieve high-precision and high frame rate tracking under limited computing resources, we proposed a lightweight siamese network target tracking algorithm based on ananchor free. Firstly, the modified lightweight network MobileNetV3 was used as the backbone network to extract features, and reduced parameters and computation of the network while maintaining deep feature expression capability. Secondly, for traditional cross-correlation operation, we proposed deep cross-correlation module for graph cascading optimization, which highlighted important information of target features through rich feature response graphs. Finally, feature sharing was used to reduce parameters and computation to improve tracking speed in the anchor classification regression prediction network. Comparative experiments were conducted on two mainstream datasets OTB2015 and VOT2018, the experimental results show that the algorithm has a significant accuracy advantages compared to SiamFC tracker, and is more robust in complex tracking scenes. At the same time, the tracking frame rate can reach 175 frames/s.

Keywords: target tracking; siamese network; lightweight network MobileNetV3; cross-correlation module; anchor free

目标跟踪在智能安防、 自动驾驶等领域应用广泛[1]. 近年来, 随着技术理论与硬件资源的发展, 目标跟踪在跟踪准确性和鲁棒性方面取得了巨大成功, 但由于在实际应用场景中计算机硬件运算资源通常受限, 视觉跟踪在跟踪速度方面仍存在很大的局限性. 因此, 设计一种平衡速度与精度的跟踪器具有重要意义.

目前, 目标跟踪领域研究的重点大多数为如何进一步提升跟踪准确率, 导致跟踪算法使用的网络结构越来越复杂, 需要的计算资源越来越多. 而目标跟踪应用场景是针对视频序列, 速度是跟踪的一个重要指标, 不能实现实时跟踪的算法在目标跟踪领域毫无意义. 因此, 本文在SiamFC[2]基础上, 提出一种基于无锚的轻量级孪生网络目標跟踪算法, 以在计算资源受限环境下更好地平衡跟踪精度与速度. 针对现有SiamFC网络结构, 修改轻量级网络MobileNetV3[3]作为主干网络, 使提取的特征更适合于跟踪任务, 进一步调整网络结构. 提出级联优化的深度互相关模块, 丰富特征响应图, 突出目标特征重要信息, 强化对跟踪有利的特征. 对于无锚分类回归预测网络, 采用特征共享方式减少参数量和计算量以提升跟踪速度.

1 相关工作

目标跟踪目前主要分为相关滤波类和深度学习类两大分支. 相关滤波类跟踪算法主要采用梯度直方图特征、 颜色特征等手工特征设计跟踪器, 算法推理时间快, 以KCF[4]和fDSST[5]等为代表. 但由于手工设计的浅层特征较简单, 在应对目标跟踪过程中的复杂挑战时, 稳定性较差. 由于深度特征具有更强的表达能力, 因此深度学习类跟踪算法在跟踪精度方面成果显著. 但以MDNet[6]为代表的深度网络类跟踪算法的预训练网络异常巨大, 为提升跟踪精度需使用大量高维特征, 导致跟踪的帧率只有几帧, 完全不能满足实际应用场景. 近年来, 使用深度特征的孪生网络目标跟踪算法受到广泛关注, 其在保持对首帧框选目标精准跟踪的同时, 还可以实现高速稳定的跟踪. 为进一步提升孪生网络跟踪算法的跟踪性能, 基于SiamFC已相继提出了一些更高效的改进算法, 如构建训练多个孪生网络分支的MBST[7]和使用ResNet50作为主干网络的SiamDW[8]等.

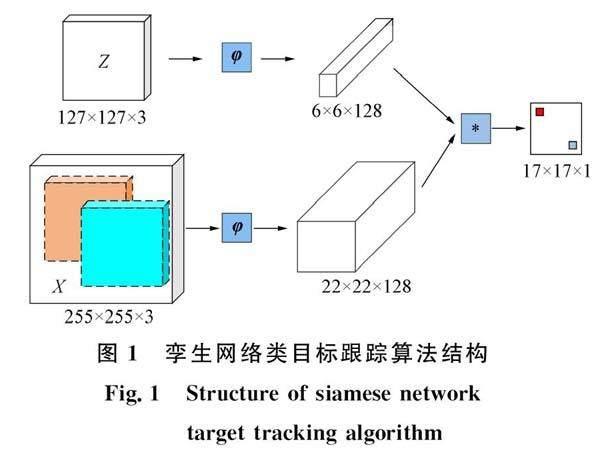

孪生网络目标跟踪算法由两支结构相同权重共享的神经网络构成, 如图1所示. 其主要思想是将目标跟踪任务转化为相似性度量问题, 通过两个相同子网络分别对首帧框选的目标模板和视频后序每一帧的搜索区域进行特征提取, 获得模板特征向量和搜索特征向量. 然后使用相似度量函数计算两路特征向量的相似性程度, 从而确定目标在搜索区域中出现的位置. 孪生网络跟踪原理的数学表达式为

f(Z,X)=φ(Z)*φ(X),(1)其中f(Z,X)表示构造的相似性度量函数, Z是视频序列首帧中框选的目标模板图像, X是视频序列每帧的搜索区域图像, φ(·)表示两支结构相同权重共享的神经网络所提取的特征向量, *表示互相关运算. 则跟踪过程为将第一帧中选定的目标模板图像和待跟踪搜索图像送入孪生网络中, 通过两支结构相同权重共享的主干网络可得到两路特征向量, 然后通过互相关运算计算相似程度. 即以模版特征向量作为卷积核对搜索特征向量进行卷积, 得到得分响应图, 特征相应得分数值的大小直接反应目标在该分数位置出现的概率. 分值最高的位置即待跟踪目标在这一帧搜索图像中的位置, 然后对特征响应图中得分最高的位置进行多尺度变化, 从而在原图中确定目标边界框.

2 算法设计

算法的整体框架如图2所示. 首先, 使用两支权值共享的轻量级网络MobileNetV3构建成孪生网络分别提取模板图像和搜索图像的深度特征; 其次, 提出图级联优化的深度互相关模块替代传统互相关操作, 通过丰富特征响应图突出目标特征重要信息; 最后, 对于图级联优化深度互相关模块输出的特征响应图, 直接通过分类回归网络以无锚方式估计目标预测框在搜索图像中的位置信息.

2.1 轻量级骨干网络MobileNetV3

目前在目标跟踪算法中使用孪生网络结构的多采用ResNet50[9]作为主干网络提取特征, 可显著提升目标跟踪的精度, 但也会使网络结构更复杂、 增加网络的计算量, 导致目标跟踪算法所需的硬件设备在计算资源上要求极高. 因此, 导致在算力较差的设备上进行跟踪时受到极大限制, 每帧所需的时间大幅度提升, 从而无法达到实时跟踪的效果. 为降低网络的复杂度而采用较简单的AlexNet作为主干网络提取特征, 确实能在速度上大幅度提升, 但由于AlexNet的网络层数较少, 不能提取到更深层的语义信息, 算法的鲁棒性较低. 所以综合考虑算法在现实设备算力受限的情况下, 达到实时跟踪以及较好的跟踪效果, 本文进行了大量的实验进行算法效果对比, 最终发现采用MobileNetV3作为主干网络可在保持良好跟踪精度的同时所需的计算量最少, 适合于算力匮乏的情况. MobileNetV3是在MobileNetV1[10]和MobileNetV2[11]上進行了优化, 保存了MobileNetV1经典的深度可分离卷积, 并在MobileNetV2的具有线性瓶颈的残差结构中引入了SE(squeeze-and-excitation)通道注意力模块, 使网络结构更稳定. 常用的神经网络参数量对比结果列于表1.

深度可分离卷积主要由深度卷积和点卷积两部分构成. 深度卷积的计算过程如图3(A)所示, 对于输入特征的各通道分别使用卷积核进行独立的卷积操作, 其中每个卷积核大小为Dk×Dk×1. 点卷积过程如图3(B)所示, 对于深度卷积输出的深度特征再进行一次卷积操作, 即采用核为1×1的标准卷积调整特征维度从而获得一个新的特征图.

MobileNetV2中的倒残差模块, 可在保证参数量较小的同时获得更丰富的特征信息, 但特征图不同通道对不同目标的响应不均衡, 可能在所有特征通道中仅有少数通道对所需关注的目标具有较高的响应, 此时网络对不同通道提取的特征赋予相同的权重会降低算法的性能. MobileNetV3为解决该问题在倒残差结构中引入了SE通道注意力机制, 根据特征的重要程度赋予不同的权重, 虽然增加了一部分参数量, 但对跟踪的时间影响不明显, 极大提高了网络对目标关键特征的敏感度.

MobileNetV3网络采用的总步长为16, 其最后的输出特征包含更多的类别信息, 更适用于对目标类别的区分, 但对于本文的跟踪, 网络需要输出的特征还需要包含足够多的空间信息, 从而有利于确定待跟踪目标的位置, 因此保留更多的空间信息极为重要. 而网络总的步长会直接影响特征图的输出尺寸及感受野的大小, 所以为保留更多的空间特征信息, 可适当减小网络步长. 如果网络步长过小又会导致特征感受野的增大, 进而导致跟踪目标的位置特征丢失明显, 跟踪的精度也会极大降低. 但感受野如果太小目标尺寸较大时, 会导致提取的特征语义不足, 使跟踪需要更大的计算负担, 极大降低了跟踪效果. 大量的对比实验表明, 在网络步长为8时, 跟踪的精度和速度等指标会更好, 所以本文最终采用的步长为8. 为保持较好的跟踪效果以及网络推理速度, 本文在MobileNetV3原网络结构上去掉了第5个stage, 并将第4个stage中最后一个卷积操作的步长改为1, 用于保留更多的深层特征信息, 将第4个stage最后一层的输出作为最终的特征图. 表2列出了本文在MobileNetV3基础上修改后的网络结构.

2.2 图级联优化的深度互相关模块

一般的孪生网络[2]目标跟踪器直接采用卷积操作代替互相关操作得到特征响应图. 因此, 孪生网络类目标跟踪器中互相关操作的本质就是标准卷积: 将孪生网络模板分支中获取的特征作为卷积核, 在搜索分支的输出特征上进行卷积, 从而得到特征响应图, 其中特征响应图每个位置即反应该位置的相似性得分. 为简化互相关操作, 目前主流孪生网络[8,12-13]采用深度可分离卷积替代互相关操作, 与原始标准卷积操作相比, 极大减少了计算量从而提升跟踪推理速度. 特征图对齐对目标跟踪非常重要, 由SiamRPN++[13]可知, 简单使用ResNet等深层网络替换AlexNet不可避免地会引入大量的填充操作, 导致提取的特征缺乏严格的平移不变性. SiamRPN++通过均匀分布的数据增强方式使目标在中心点进行偏移, 有效缓解网络因为破坏了严格平移不变性而产生的影响. 因此, 对于互相关操作不存在特征对齐问题, 本文提出级联优化的深度互相关模块.

级联优化的深度互相关模块如图2所示. 为保持特征响应图在互相关后的空间维度不变, 对深度可分离卷积DWConv增加填充Padding操作, 在搜索特征图周围填充大小为7填充数据0. 由于空间维度不变, DWConv操作后的特征响应图与搜索分支特征图空间尺寸保持一致, 通过Concat信道级联将DWConv操作后的特征响应图与搜索分支特征图进行特征融合, 再通过1×1标准卷积Conv将融合后的特征通道数调整为与搜索分支特征图通道数相同, 以作为下一个DWConv操作的输入. 本文级联优化的深度互相关模块可以丰富特征响应图, 有效突出目标特征的重要信息.

2.3 无锚分类回归预测网络

分类回归预测网络主要分为分类分支和回归分支两大部分. 分类分支主要用于区分图级联优化的深度互相关模块所输出的特征响应图中每个位置的类别, 是目标所在的前景还是图像背景. 而回归分支主要用于估计图级联优化的深度互相关模块所输出的特征响应图中前景目标的预测框. 即分类分支主要利用图级联优化的深度互相关模块所输出的特征响应图中的丰富信息解码得到16×16×2大小的分类特征图. 如果分类特征图上(w,h)所对应搜索图像X中的中心点(x,y)落在标签框内, 则分类特征图上(w,h)即对应目标前景, 否则为图像背景. 因此分类特征图中每一位置(w,h,∶)都表示一个二维向量, 即当前帧搜索图像中对应中心点处判定为前景背景的分数. 相似地, 回归分支将图级联优化的深度互相关模块所输出的特征响应图中的位置信息解码为16×16×4大小的回归特征图. 回归特征图中每一位置(w,h,∶)都表示一个四维向量t(w,h)=(l,t,r,b), 即回归特征图上(w,h)所对应搜索图像X中的中心点(x,y)到标签框上、 下、 左、 右边界的距离. 因此, 回归特征图中每一位置(w,h,∶)的计算公式为l(w,h)=x-x0, t(w,h)=y-y0, r(w,h)=x1-x, b(w,h)=y1-y,(5)其中(x0,y0)和(x1,y1)分别表示标签框的左上角和右下角坐标, (x,y)表示回归特征图上的点(w,h)在搜索图像X中的中心点.

为进一步优化分类回归预测网络, 提升跟踪速度, 本文将分类和回归两个分支的特征进行共享, 用两个分支分别进行目标前景、 背景分类和中心点到边界距离的预测. 整体损失函数为L=λ1Lcls+λ2Lreg,(6)其中: Lcls为交叉熵损失函数[14]; Lreg为交并比(IoU)损失[15]; 常数λ1和λ2为加权超参数, 在训练期间λ1和λ2都设置为1.

3 实验结果与分析

3.1 实验环境与参数配置

本文所有实验的实验环境配置如下: CPU为Intel(R) Core(TM)i5-6300HQ, 主频23 GHz, 内存8.00 GB; GPU为NVIDIA GeForce GTX1080Ti, 显存11 GB. 实验使用数据集Got-10K[16]进行模型离线训练, 共50个训练阶段, 每阶段约10 000组图片对, 使用MobilenetV3预训练模型初始化本文跟踪算法的主干网络参数. 训练过程中动量设为0.9, 采用SGD法进行优化, 学习率由10-2逐步衰减到10-5.

3.2 数据集OTB2015基准实验结果

数据集OTB2015[17]是目标跟踪领域的一个经典数据集, 其包含尺度变化、 运动模糊、 遮挡等11个跟踪挑战的100组图像序列. 数据集OTB2015使用真实边界框中目标的位置初始化第一帧, 使用跟踪准确率和成功率这两个指标对跟踪算法的性能进行量化. 准确率指在整个数据集上跟踪算法预测的中心位置与标签位置之间的像素误差小于20的帧数的比例, 成功率为跟踪算法预测框与标签的交并比大于0.5的帧数在整个数据集上的比值. 本文采用数据集OTB2015进行消融实验和定量定性分析, 验证本文算法的有效性.

3.2.1 消融实验

为验证本文算法中各结构组件的有效性, 在数据集OTB2015上分析各部分对跟踪性能的影响. 消融实验结果列于表3, 其中SiamFC为基准算法, 实验1表示替换基准算法主干网络为MobileNetV3, 实验2表示在实验1的基础上互相关操作使用本文级联优化的互相关模块, 实验3表示在实验2的基础上使用基于无锚的分类回归预测网络代替SiamFC直接预测方式的总体算法.

由表3可见: 实验1在替换基准算法主干网络为MobileNetV3后, 准确率和成功率分别提升了5.4%和2.5%; 使用本文级联优化的互相关模块的实验2相较于实验1准确率和成功率有1.8%和2.3%的增益; 最后在实验2的基础上使用基于无锚的分类回归预测网络代替直接预测方式的总体算法获得最佳跟蹤效果.

3.2.2 定量分析实验

为定量分析验证本文算法的跟踪性能, 与其他8种常见跟踪算法进行对比实验, 实验结果如图4所示. 由图4可见, 本文算法的准确率和成功率分别达到0.869和0.648, 明显优于基准算法SiamFC, 准确率和成功率分别提升了12.6%和10.4%. 由于ResNet50的特征提取能力, SiamDWrpn算法取得了更好的跟踪准确率和成功率, 但ResNet50作为特征提取的主干网络, 其模型参数量较大, 难以在资源受限环境下实际应用. 同时, 跟踪速度能达到175帧/s, 运行速度得到极大提升, 在计算资源优先的情况下极具发展潜力.

3.2.3 定性分析实验

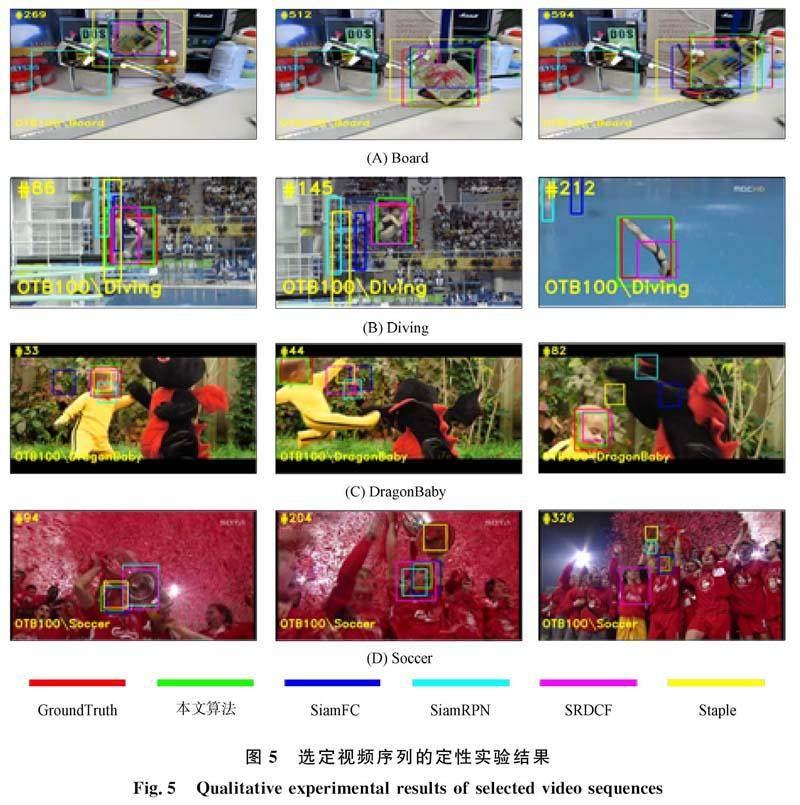

为更直观地展示本文算法的有效性, 在数据集OTB2015上选取4组视频序列将跟踪结果可视化, 从而定性分析算法性能. 这4组视频序列的跟踪难点包含了本文算法试图解决的问题, 将本文算法与SiamFC,SiamRPN,SRDCF,Staple 4种性能先进的算法进行了比较, 图5中红色框、 绿色框、 蓝色框、 青色框、 紫色框、 黄色框分别代表真实目标框、 本文算法、 SiamFC、 SiamRPN、 SRDCF、 Staple. 各算法的非紅色预测框与红色的真实目标框重叠反映了各算法的跟踪性能, 重叠度越高表明效果越好.

由图5(A)可见, 待跟踪目标为机械臂夹取的开发板, 在视频中机械臂快速移动目标物开发板, 并频繁与其他物体互相遮挡. 由可视化结果可见, 在第269帧时由于目标物在快速运动, 且背景图像中出现相似物移动过程中与目标相似背景, 青色框的SiamRPN跟踪器率先出现漂移, 丢失目标. Staple跟踪器的黄色框变大重叠率变小, 只有本文算法和SiamFC紧凑地跟踪目标. 从269~512帧时, 随着目标发生平面内旋转并伴随尺度变化, 紫色框的SRDCF跟踪器越来越小, 无法有效跟踪目标, SiamFC跟踪器的重叠率也开始变小, 本文算法与标签框仍保持较高的重叠率. 从512~594帧时, 由于目标在图像内快速运动同时进行高速旋转, 导致目标外观快速变化, SRDCF也彻底跟丢, SiamFC跟踪器出现跟踪漂移, 本文算法始终保持对目标较稳定的跟踪.

由图5(B)可见, 待跟踪目标跳水运动员在跳水过程中快速旋转并发生姿态变形. 由于目标的快速旋转, 在第86帧时, SiamFC,SiamRPN,Staple相继跟丢目标, 随着目标的进一步运动与姿态形变, 在第145帧时仅有SRDCF和本文算法能对目标保持有效跟踪, 从145~212帧, 待跟踪目标运动员进一步发生形状变化, SRDCF的紫色框与红色真实标签框之间的重叠率开始变小, 在第212帧时, SRDCF对目标的跟踪已经不十分准确, 只有本文算法一直保持对目标的紧凑稳定跟踪.

由图5(C)可见, 待跟踪目标李小龙男孩在与小怪兽战斗过程中, 由于快速运动导致目标的空间尺寸大小变化也非常频繁, 且存在旋转和运动模糊. 从初始帧到第33帧时, 目标发生了旋转, 此时SiamFC和SiamRPN的预测框率先发生漂移, 且SiamFC跟踪器彻底丢失目标, 而SiamRPN跟踪器对于目标的定位已经十分不准确, 在接下来的视频序列里, 目标发生了快速移动, 运动到第44帧时, 仅有本文算法能够定位目标, 其他算法全部跟丢; 从44~82帧过程中, 目标存在运动模糊、 旋转等跟踪挑战, 本文算法在该过程中是唯一实现稳定且紧凑跟踪目标的算法. 与对比算法相比, 本文算法可以更好应对由快速运动导致目标的空间尺寸大小变化频繁问题.

由图5(D)可见, 待跟踪球员由于手持奖杯, 在庆祝过程中不仅存在运动模糊还存在奖杯频繁遮挡的目标挑战, 而且在视频序列中还存在大量相似背景以及镜头运动导致目标角度发生变化. 从第70~94帧, 目标快速运动出现模糊和奖杯遮挡, 本文算法的绿色框在此过程中一直保持较高的重叠率, 紧凑地跟踪目标, 展现出跟踪性能的稳定. 而SiamFC和SiamRPN相继丢失跟踪目标. 在接下来的视频序列中, 由于镜头的移动以及相似物的干扰, 黄色框Staple跟踪器彻底丢失目标, 所有跟踪算法都丢失目标. SiamFC和SiamRPN找回目标但重叠率较低. 到326帧时, 只有本文算法和SiamFC可以保持对目标的跟踪. 相对而言, 本文算法与真实边界框的重叠率更高、 跟踪效果更好.

3.3 数据集VOT2018实验分析

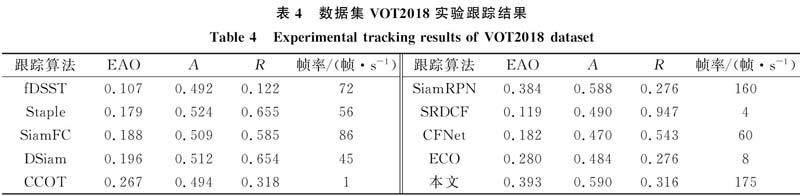

数据集VOT2018包含60组视频序列, 具有多种挑战, 是当前单目标跟踪算法性能分析的主流测试数据集. 评价指标采用期望重叠率(EAO)、 准确性(A)和鲁棒性(R), 其中准确性和期望重叠率数值越高且鲁棒性数值越低表示算法性能越好. 本文引入了ECO,SiamFC,SiamRPN,fDSST,Staple,DSiam,CCOT,SRDCF,CFNet等具有代表性的常见单目标跟踪算法, 进行跟踪性能对比. 在相同的硬件平台上使用数据集VOT2018进行对比分析. 各算法的跟踪性能量化指标列于表4.

由表4可见, 与基准算法SiamFC相比, 本文提出的跟踪算法具有较高的跟踪准确性A(0.590)、 良好的鲁棒性R(0.316), 并且与对比算法相比获得了最优的期望重叠率EAO(0.393). 本文算法相比于SiamFC基准算法不仅有效改善了跟踪准确性, 而且还可以以高达175帧/s的跟踪速度稳定跟踪. 同时, 相比于SiamRPN基准算法期望重叠率提高了2.3%. 因此, 本文算法能更好地平衡跟踪精度与速度, 具有更大的应用空间.

综上所述, 为更好地平衡跟踪速度与精度, 在SiamFC基准算法基础上本文提出了一种基于无锚的轻量化孪生网络目标跟踪算法. 先使用修改的MobileNetV3作为主干网络提取特征, 然后针对互相关操作提出一种图级联优化的深度互相关模块获取特征响应图, 最后通过分类回归网络以无锚的方式对特征响应图预测目标边界框. 本文算法在数据集OTB2015和VOT2018上相比于基准算法SiamFC取得了更好的速度与精度率. 实验结果表明, 本文算法在保持良好跟踪性能的同时大幅度提升了跟踪速度, 有效解决了速度和精度的平衡问题, 在计算资源受限环境下具有一定的应用价值.

參考文献

[1]李玺, 查宇飞, 张天柱, 等. 深度学习的目标跟踪算法综述 [J]. 中国图象图形学报, 2019, 24(12): 2057-2080. (LI X, CHA Y F, ZHANG T Z, et al. Overview of Deep Learning Target Tracking Algorithms [J]. Chinese Journal of Image and Graphics, 2019, 24(12): 2057-2080.)

[2]BERTINETTO L, VALMADRE J, HENRIQUES J F, et al. Fully-Convolutional Siamese Networks for Object Tracking [C]//European Conference on Computer Vision. Berlin: Springer, 2016: 850-865.

[3]HOWARD A, SANDLER M, CHU G, et al. Searching for Mobilenetv3 [C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Piscataway, NJ: IEEE, 2019: 1314-1324.

[4]HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-Speed Tracking with Kernelized Correlation Filters [J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 37(3): 583-596.

[5]MARTIN D, GUSTAV H, FAHAD S K, et al. Discriminative Scale Space Tracking [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1561-1575.

[6]NAM H, HAN B. Learning Multi-domain Convolutional Neural Networks for Visual Tracking [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2016: 4293-4302.

[7]LI Z X, BILODEAU G A, BOUACHIR W. Multi-branch Siamese Networks with Online Selection for Object Tracking [C]//International Symposium on Visual Computing. Berlin: Springer, 2018: 309-319.

[8]ZHANG Z P, PENG H W. Deeper and Wider Siamese Networks for Real-Time Visual Tracking [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2019: 4591-4600.

[9]HE K M, ZHANG X Y, REN S Q, et al. Deep Residual Learning for Image Recognition [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2016: 770-778.

[10]HOWARD A G, ZHU M L, CHEN B, et al. Mobilenets: Efficient Convolutional Neural Networks for Mobile Vision Applications [EB/OL]. (2017-04-17)[2022-01-10]. https://arxiv.org/abs1704.04861.

[11]SANDLER M, HOWARD A, ZHU M L, et al. Mobilenetv2: Inverted Residuals and Linear Bottlenecks [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2018: 4510-4520.

[12]XU Y D, WANG Z Y, LI Z X, et al. Siamfc++: Towards Robust and Accurate Visual Tracking with Target Estimation Guidelines [J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(7): 12549-12556.

[13]LI B, WU W, WANG Q, et al. Siamrpn++: Evolution of Siamese Visual Tracking with Very Deep Networks [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2019: 4282-4291.

[14]HU K, ZHANG Z Z, NIU X R, et al. Retinal Vessel Segmentation of Color Fundus Images Using Multiscale Convolutional Neural Network with an Improved Cross-Entropy Loss Function [J]. Neurocomputing, 2018, 309: 179-191.

[15]YU J H, JIANG Y N, WANG Z Y, et al. Unitbox: An Advanced Object Detection Network [C]//Proceedings of the 24th ACM International Conference on Multimedia. New York: ACM, 2016: 516-520.

[16]HUANG L H, ZHAO X, HUANG K Q. Got-10k: A Large High-Diversity Benchmark for Generic Object Tracking in the Wild [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 43(5): 1562-1577.

[17]WU Y, LIM J W, YANG M H. Object Tracking Benchmark [J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 37(9): 1834-1848.

(責任编辑: 韩 啸)

收稿日期: 2022-08-07.

第一作者简介: 丁贵鹏(1982—), 男, 汉族, 博士研究生, 从事视觉观瞄系统设计的研究, E-mail: dingguipeng@163.com. 通信作者简介: 陶 钢(1962—), 男, 汉族, 研究员, 从事火炮设计与研发的研究, E-mail: taogang@njust.edu.cn.

基金项目: 国家自然科学基金天文联合基金项目(批准号: U1731240).

吉林大学学报(理学版)2023年4期