税权均衡:算法决策对纳税人权利的冲击与回应

杨小强 王 森

内容提要:算法决策正成为“互联网+税务”以及智慧税务建设的一部分,一方面它提升了税收征管的效率,另一方面受算法规则不透明、“黑箱”属性以及难于解释等因素的影响,国家税权呈现扩张趋势。纳税人的基本权利,如知情权、陈述与申辩权以及救济权在一定程度上受到侵害。我国《个人信息保护法》规定了自然人对算法的解释权,但这在税收征管领域因双方主体地位不平等而难以直接适用。为此,可以引入税权均衡理论,考量如何在算法自动化决策场景下,平衡纳税人税权与国家税权的关系,并通过权利制约权力、权力制约权力、纳税人救济制度三个方面对其进行回应。

一、导 论

大数据时代,我国各地税务部门积极探索建设智慧税务。智慧税务是以大数据和人工智能技术为依托,以机器学习、神经网络等数据分析为切入点的新型治税模式。(1)参见谢波峰、尹天惠:《智慧税务的实践现状和发展探索》,载《国际税收》2021年第10期。其中,算法在数据分析中发挥着核心作用。(2)参见梁振文:《算法解释权的构造与法治保障路径——以社会信用体系建设为场景》,载《吉首大学学报(社会科学版)》2021年第1期。随着金税四期工程的开展,理论上税务算法将可以覆盖税收征管行为的全过程。(3)参见《〈关于进一步深化税收征管改革的意见〉相关要点》,载http://www.chinatax.gov.cn/chinatax/n810341/n2340339/c5162731/content.html,最后访问时间:2022年4月20日。具体表现为税务机关通过机器学习、贝叶斯算法等模型对纳税人的个人信息进行收集、共享、分析,针对税务计算、税务异常预警等作出自动化处理。实践中,算法自动化决策对税收征管体系建设的影响日益明显。一方面,高效、精准的算法有助于提高税收征管效率与精准度,但另一方面,算法规则的不透明、“黑箱”属性、算法歧视等先天特性使国家税权得到了扩张,这对纳税人的知情权和救济权等权利带来风险,加剧了国家与纳税人之间的信息不对称。可见,智慧税务的建设既离不开算法技术的支持,也需要对算法决策做出相应的规制。

目前,学界对算法风险规制的讨论主要限于平等的个人与自动化决策者,如网络运营者与用户之间,对于公法领域行政相对人算法权利保护的研究呈现散状化、碎片化态势。我国《个人信息保护法》(以下简称《个保法》)为自然人行使算法权利提供了法律依据。综合来看,自然人算法权利的内涵包括知情权、自决权以及解释说明权等权利。(4)参见温昱:《算法权利的本质与出路——基于算法权利与个人信息权的理论分疏与功能暗合》,载《华中科技大学学报(社会科学版)》2022年第1期。当算法作为行政机关的决策工具时,其属于公权力行使的一部分。具体到税收征管领域,国家税权具有强制性、无偿性、固定性等特征,(5)参见徐楠芝:《论税权的法律逻辑——基于法权论的视角》,载《税务与经济》2019年第3期。税务机关可以借助算法行使税务处罚、税务检查、强制执行等权力。对于代表国家意志、履行征税职责的税收机关,纳税人难以依据《个保法》的规定,直接拒绝税务机关基于算法自动化决策作出的税收决定。

面对人工智能技术的强势融入,纳税人权利与国家税权之间的平衡被打破。传统意义上的纳税人权利,在税务算法自动化决策场景下亟须完善。纳税人权利和国家税权的平衡源于“税权均衡”理论,核心要求是通过制定法律限制国家税权,以保护纳税人税权。(6)参见翟中玉:《法治中国视阈下税权平衡的概念及其价值》,载《河北法学》2018年第6期。当前域外以德国、法国等欧洲国家为代表,面对人工智能技术在税收征管领域的扩张,不仅从立法上确认纳税人算法权利,而且也加强对税务算法的内外部监督。“法与时转则治,治与世宜则有功。”(7)高华平、王齐洲、张三夕译注:《韩非子》,中华书局2010年版,第234页。本文以税权均衡理论为切入点,通过分析税务算法自动化决策对纳税人权利的挑战,就我国现行税收法律制度进行检视,并对未来的治理路径作出探讨。

二、税权均衡理论及其应然要求

税收国家内含着国家税权和纳税人税权公平配置的法律意义。国家税权和纳税人税权之间处于一种互相博弈的征纳税权关系。(8)参见前引〔6〕,翟中玉文。当下,各地税务机关将大数据、区块链等智能技术应用于识别纳税人风险、甄别增值税欺诈等税收征管领域的重点难题。(9)比如,厦门市税务局和厦门市公安局联合研发警税人工智能作战平台,打击虚开发票、骗取留抵退税等涉税违法犯罪活动。与商业领域的人工智能技术追求效率不同,在税收领域应用的人工智能技术具有双重目的,即在追求提升征管效率的同时,也利用智能技术的中立性限制税务机关的裁量行为。(10)参见陈亮、薛茜:《行政公开视域下行政决策算法化的法律规制》,载《理论月刊》2021年第3期。然而,由于算法黑箱、算法不透明、算法歧视等固有特征,算法的使用反而增加了税收征管的不确定性以及差异性,使国家税权呈现扩张趋势。比如,荷兰税务机关开发Systeem Risico Indicatie(SYRI)软件检测社会福利、税收等领域的欺诈行为。由于SYRI算法规则不透明而且纳税人无法核查其正确性,该软件被指违反了《欧洲人权公约》第8条的规定,即人人享有使自己的隐私和家庭生活、住宅以及通信获得尊重的权利。(11)See The Hague District Court, Judgment of 5 February 2020, NL:RBDHA:2020:1878, available at https://uitspraken.rechtspraak.nl/inziendocument?id=ECLI:NL:RBDHA:2020:1878,last visited on Apr.20,2022.面对算法自动化决策场景下,国家税权与纳税人税权的不平衡,为了重塑征纳税权平衡的目标,应当强调的两个方面是:第一,保护纳税人权利,赋予纳税人对抗性权利;第二,限制税务机关权力,加强税务执法的内部约束与外部监督。

(一)赋予纳税人对抗性权利

税权均衡理论要求,赋予纳税人的权利需要具有对抗性。(12)参见徐健、王广辉:《税务检查制度的公权和私权的平衡——兼论〈税收征管法〉第四章的修改》,载《河南社会科学》2021年第11期。在算法自动化决策场景下,税务机关通过对纳税人数据进行抓取、分析,作出影响纳税人的税务决定。由于算法规则的不透明以及隐匿性等特征,算法决策结果的正当性可能会受到挑战。为防范算法对纳税人权利的侵蚀,需要赋予纳税人对抗性的算法权利。比如,纳税人可以对算法的运算规则提出异议,也可以对不利于自己的算法决策结果提出质疑。这种对抗性可以从我国税收征管法治建设中找到依据。我国《税收征收管理法》第8条第4款规定:“纳税人、扣缴义务人对税务机关所作出的决定,享有陈述权、申辩权……”我国《关于纳税人权利与义务的公告》(以下简称《公告》)列举了多项纳税人的基本权利,比如知情权、陈述与申辩权以及依法要求听证等权利。这些对抗性权利构成算法自动化决策场景下纳税人权利的基础。此外,以纳税人为中心的治税思想,也体现出我国税收取之于民、用之于民、造福于民的本质。(13)参见曹阳、黎远松:《构建以纳税人为中心的税收法治理念及其实践路径》,载《税务研究》2021年第9期。

(二)税务算法的内部约束与外部监督

在税权均衡理论下,国家税权须得到一定程度的限制。(14)参见赵宇、赖勤学:《宪政维度的纳税人权利思考》,载《当代经济研究》2005年第1期。具体到算法自动化决策场景下,主要表现为税务算法的内部约束与外部监督两个方面。

首先,对算法自动化决策的内部约束成为合理配置税务执法权限的基础。所谓内部约束,主要是通过人工智能技术内部的更新换代,使算法决策主体能够及时发现算法程序中的风险点,规范算法自动化决策的运作。其次,与内部约束相配套,建立相应的外部监督机制。按照我国的税务监督体系,依据监督主体不同,外部监督可分为国家立法机关的监督、国家税务机关的监督、审计监督、群众监督以及社会监督等类型。为了增强纳税人的监督,在明确规定纳税人权利、增强算法可解释性的同时,通过行业监督、政府监督等模式,规制税务机关的算法自动化决策行为。

三、算法决策对税收征管的挑战

当前,机器学习、神经网络等各种智能技术已经广泛应用于税收征管领域,提高了纳税服务和税收风险管理的智能化水平。比如法国税务机关报告,2019年法国税务审计中约有20%的工作任务由人工智能技术完成,2020年该数值增加到35%。2022年预计有50%的税务审计由机器学习等工具完成。(15)See A.Léchenet, French tax authority pushes for automated controls despite mixed results, Algorithm Watch,available at https://algorithmwatch.org/en/france-tax-automated-dgfip/,last visited on Apr.20,2022.据统计,因使用人工智能审计,法国2019年财政收入同2018年相比增加了16.3%,即大约增加了8亿欧元。(16)See Statements of the Ministry of Finance, available at https://kiosque.bercy.gouv.fr/alyas/msite/view/ lettre-daj/13553,last visited on Apr.20,2022.然而,税务算法的运行也正潜移默化地影响着纳税人的基本权利。比如,“荷兰育儿津贴事件”揭开了荷兰税务局利用算法歧视和侵犯福利津贴领取者权利的遮羞布。这一事件被荷兰立法者描述为“前所未有的不公正”。(17)See Dutch Childcare Allowance Scandal,available at https://www.cnbc.com/2021/01/15/dutch-government-resigns-after-childcare-benefits-scandal-.html,last visited on Apr.20,2022.荷兰税务机关利用风险评估软件,将数千个育儿津贴领取者识别为欺诈者,并要求其退还2013年至2019年期间领取的津贴费用。事实上,因风险评估软件的算法存在歧视性,该结果是不公正的。在荷兰,只有少量税务机关的官员可以访问税务评估系统,普通的税务工作人员无法将决策理由告知津贴领取者,使得领取者在面对税务机关的偿还要求时,无法行使救济权。此外,评估软件还会通过使用以前的输出数据作为系统的新输入数据,并不断调整特定输入的权重来分析风险行为。比如荷兰税务机关使用过量“非荷兰籍”津贴领取者作为该系统的输入数据,在其他条件相同的情况下,被定性为“非荷兰籍”可能会导致更高的欺诈风险。整体而言,在算法自动化决策下,税收征管面临着如下挑战:

(一)算法自动化决策侵犯纳税人的基本权利

1.算法不透明侵蚀纳税人的知情权

纳税人知情权是公领域的一项信息权利。(18)参见王婷婷、杨雨竹:《纳税人知情权保障的美国经验和中国进路》,载《税务与经济》2018年第2期。与一般意义上的知情权不同,税法领域的知情权强调纳税人获取税务机关征税信息的权利,比如了解国家税收法律法规以及与纳税程序有关的情况。我国在《公告》《行政复议法》《行政诉讼法》中均不同程度地规定了对纳税人知情权的保护。(19)《公告》14项权利中的第一项权利即知情权,《行政复议法》第23条第2款、《行政诉讼法》第34条均规定了知情权。

智慧税务下,税务机关采用神经网络等先进数据挖掘技术为纳税人画像,揭示某类型纳税人的征管趋势。从技术的角度看,纳税人对算法的知情权可以分为两个方面。一方面,是纳税人对机器学习等智能技术所依据数据的知情权;另一方面,是纳税人对算法运算规则的知情权。实践中,算法规则的不透明使得纳税人的知情权难以得到有效保障。在“荷兰育儿津贴事件”中,税务机关没有向津贴领取者解释风险评估系统(RMS)的运算规则,比如获取并筛选数据的方式、利用数据的范围等。算法的不可理解性使得津贴领取者对自己如何被列为骗取津贴的对象缺乏认知,并影响了后续正当权利的行使。(20)See Final report of the Parliamentary Inquiry Committee on Childcare Allowance,available at https://www. houseofrepresentatives. nl/sites/default/files/atoms/files/verslag_pok_definitief-en-gb.docx.pdf,last visited on Apr.20,2022.在算法自动化决策中,纳税人所面临的专业化壁垒、信息不对称程度都比传统信息化决策时代高得多。对算法规则和相关数据的知情,是纳税人行使其他权利的前提。“欲诚其意者,先致其知。”(21)朱熹:《四书章句集注》,中华书局1983年版,第3页。伴随着我国智慧税务的推广,税务机关将会更加广泛地收集纳税人信息,也会在越来越多的领域推广算法自动化决策,保障纳税人的知情权将是维系纳税人与税务机关之间信任关系的基石。(22)参见杜亚斌:《预算透明何以提升政府信任——基于跨国数据的多层模型分析》,载《经济社会体制比较》2022年第1期。

2.算法自动化架空纳税人的救济权

休厄特(Lord Hewart)认为:“正义不仅应该得到伸张,而且必须公开地、毫无疑问地以能够被人们看见的方式实现。”(23)The origins of “Justice must be seen to be done”,available at https://www.barandbench.com/columns/the-origins-of-justice-must-be-seen-to-be-done, last visited on Apr.20, 2022.正义要求行为人拥有伸张正义的途径与现实机会。在传统执法过程中,税务机关对其作出的税务决定负有说明理由之义务,以阐述其行为的合法性和合理性。这对于保障纳税人的救济权,如陈述与申辩权、听证权、上诉权等一系列正当程序权利具有重要意义。然而,在算法自动化决策下,算法自身的专业性、涉密性等特征赋予税务机关拒绝说明其决定理由的“正当性”。(24)参见雷刚、喻少如:《算法正当程序:算法决策程序对正当程序的冲击与回应》,载《电子政务》2021年第12期。同时,在算法自动化决策场景下,所有信息与内容即时生成决策结果,无法分离决策的程序、步骤和方式,纳税人只能被动接受自动化算法输出的税务结果,无法实质性地参与到税务决策过程中。比如,在“荷兰育儿津贴事件”中,算法系统只能由税务机关的少数高级官员访问,即便是税务人员也大多无法获得算法的决策规则,更无法将决策依据传达给行政相对人,客观上构成了算法黑箱。这种行为剥夺了行政相对人参与行政决策过程的权利,加重了其与税务机关之间的信息不对称。

(二)算法自动化决策悖离税收正义

税法作为财富分割的利器,要求采取对纳税人影响最小的方式实现,以平衡纳税人与国家之间的利益,从而兼顾税收公平与税收效率。(25)参见单飞跃:《纳税便利原则研究》,载《中国法学》2019年第1期。税收公平与税收效率是税收正义的两个重要面向,(26)参见胡元聪、曲君宇:《数字人民币对税收正义的影响研判及因应对策——以涉税信息利用为切入点》,载《税务研究》2021年第5期。同时也是税权均衡理论对税收主体的回应。然而,算法自动化决策引发的对纳税人信息的强监管效应将会影响税收正义的实现。

1.算法错误影响税收征管效率

在大数据时代,所有与纳税人交易行为有关的数据都被置于税务系统的监控之下。若仅由人工处理纳税人数据,不仅会面临效率低下的困境,也会影响税收执法的准确性。税务算法依靠智能模型进行自动化分析,一定程度上可以降低我国税收征管成本。然而,算法自动化决策的应用并不能够必然提升税收征管效率,相反算法规则的思维固化以及不透明等特征还会抵消算法系统提升行政效率的作用。比如,由于测量税务数据的口径存在差异,对同一类型经济事项的统计可能因部门、行业的不同而有所差异。(27)参见郑甫华、邓永勤、周超:《运用“税务助手”驱动智慧税务建设的思考》,载《税收经济研究》2021年第5期。依靠该类数据,算法模型做出的税务决策可能存在识别不精准、影响数据挖掘分析成效等问题。从博弈论来看,一个可持续的制度需要满足个体理性,否则将难以继续实施下去。(28)参见刘小山、唐晓嘉:《基于囚徒困境博弈的理性、信息与合作分析》,载《西南大学学报(社会科学版)》2019年第1期。税收国家下,国家与纳税人之间的征纳关系处于博弈状态,算法信息公开不足会导致纳税人对税务机关的信任不足,从而对税务机关的征管效率产生影响。正如欧盟《人工智能白皮书》所倡导的,通过提升算法透明度,使纳税人能够对税务机关使用的算法进行一定程度的监督,建立国家与纳税人之间的平衡互动机制,从而提高公共服务的质量。(29)See White Paper on Artificial Intelligence—A European Approach to Excellence and Trust, available at https://commission.europa.eu/system/files/2020-02/commission-white-paper-artificial-intelligence-feb2020_en.pdf,last visited on Apr.20, 2022.

2.算法“黑箱”威胁税收公平

智慧税务整合了数字化、智能化的概念,通过将算法嵌入税收信息化应用、数字化应用,对纳税人数据进行自动分析和处理。税收实践显示,以数学形式或计算机代码表达意见的算法并非完全客观。具体来说,数据的偏差以及算法透明度缺失共同对税收公平构成挑战。一方面,算法所依托的数据并不能保证完全客观公正。在传统税收执法中,为了确保税收执法的个案公正,税务机关需要考虑与纳税人和案件具有因果关系的因素,选择范围较为明确。在算法自动化决策下,税务机关可以利用随机森林模型、支持矢量机器学习等技术,抓取与纳税人相关的所有数据。这些数据中,有的与决策目的不相关,有的则因灵活度高、表达方式丰富而易使算法在对其分析时产生歧义。可以说,这些模型的应用逻辑不是传统的因果关系,而是依靠相关关系对税务问题进行分析预测。这种缺乏因果关系的评估容易给纳税人贴上群体化标签。(30)参见前引〔27〕,郑甫华等文。另一方面,在税务算法的开发和设计中,决策者或制作者的个人偏好会夹带在算法的特征选择、损失函数选择、超参数调节等方式中。(31)参见胡小伟:《人工智能时代算法风险的法律规制论纲》,载《湖北大学学报(哲学社会科学版)》2021年第2期。相较于传统的税收决策分析,算法所具有的错误和偏见不容易被分析和评估,纳税人难以理解或修正算法决策的结果。比如,在“荷兰育儿津贴事件”中,荷兰税务机关多次以“国籍”作为识别福利费诈骗的权重因素之一,得出了悖离事实的不公正结果。

四、域外规制税务算法的制度考察

目前,比利时、法国、德国以及荷兰等国家正广泛使用机器学习等人工智能技术采集纳税人数据、自动验证纳税申报或预测纳税人风险指数。人工智能的使用降低了税收征管成本,提高了税收执法效率。但税务算法实践也表明,税务机关使用人工智能可能会侵害纳税人的隐私权、数据权以及平等权等权利。2018年生效的欧盟《通用数据保护条例》(GDPR)为欧盟纳税人对抗税务算法自动化决策提供了法律依据。为了进一步减轻税务算法对纳税人的不利影响,部分国家专门在税法领域出台了规制税务算法风险的措施。比如《德国税法通则》(The Fiscal Code of Germany)专门规定了税务机关使用人工智能、计算机等工具做出税收裁决的标准以及保护纳税人算法权利的具体措施。(32)参见《德国税法通则》,载https://www.gesetze-im-internet.de/englisch_ao/,最后访问时间:2022年5月12日。可见,以德国为代表的欧盟成员国在纳税人算法权利保障方面既有欧盟层面的综合性的GDPR,又有各国层面的专门的税收法案来呼吁强化算法自动化决策下纳税人的权利保护。受制于税收征管安全、国家秘密保护等因素的影响,不论是GDPR,还是专门的税收法案,仍然存在诸多局限之处。但作为算法权利保护的先驱,欧盟的经验和教训值得我国借鉴和警醒。总体上,欧盟对纳税人算法权利的保护制度主要包括赋予纳税人算法权利和建立算法监督机制两个方面。

(一)赋予纳税人算法权利

GDPR规定,自然人享有限制其数据被自动处理的权利,具体包括知情权、访问权、更正权、删除权、限制处理权、数据移植权、反对权以及与自动决策和分析有关的其他权利。(33)参见冯冠霖、闫一新、张红艳、郭启勇:《个人隐私信息保护之中欧比较》,载《中国信息化》2021年第6期。最初,纳税人的算法权利属于广义的公民算法权利的一部分,随着税务算法决策以及纳税人权利的发展,纳税人算法权利逐步演化为公民算法权利在财政税收领域的“具体化”。这是指纳税人享有的旨在规范税务机关算法权力行使、防范税收征管权力滥用风险的权利类型,具体包括知情权、纠错权、人工干预权以及救济权等权利。

1.透明度:保护纳税人知情权

纳税人知情权的内涵应当做广义的理解,既包括纳税人对数据、算法规则的有效知悉,也包括纳税人对数据信息的主动访问,两者均与税务算法信息的公开、透明无法分开。信息透明的黄金标准是数据主体掌握了算法决策的依据,包括影响算法输入、输出和推动算法决策的主要因素。(34)See Highly Automated Vehicles: Federal Perspectives on the Deployment of Safety Technology,available at https://www.nhtsa.gov/congressional-testimonies/highly-automated-vehicles-federal-perspectives-deployment-safety,last visited on Apr. 20,2022.首先,GDPR第13、14条规定了算法决策者收集数据主体个人数据时应作出的解释要求,包括数据收集的用途、法律依据、访问数据权、数据存储的期限以及是否存在自动化决策等,为算法决策者设定了向数据主体披露算法信息的义务。《德国税法通则》第32条a款和b款明确承认了GDPR第13条和第14条规定的算法决策者对数据主体的披露义务。然而,《德国税法通则》在GDPR的基础上增加了限制向纳税人解释的情形。依据GDPR 第 23(1)(e)条,当纳税人数据涉及税务欺诈活动时,数据主体的权利将受到严格限制。受GDPR第 23(1)(e)条例外条款的影响,《德国税法通则》在第32条a款和b款中规定,如果披露规则危及税收职能的有效履行,税务机关可以不公布自动化评估系统的“细节”。如果披露算法信息会阻碍行政部门的调查,税务机关可以不向纳税人提供信息。限制情形的泛化扩大了税务机关解释的自由裁量权,影响了对纳税人知情权的保护。其次,GDPR第15条规定数据主体有权访问其正在被自动化处理的数据。《德国税法通则》第32条c款规定了纳税人对数据的访问权。但当数据属于经算法处理或经算法输出的情况时,纳税人将被拒绝访问。(35)See D.Hadwick & S.Lan, Lessons to Be Learned from the Dutch Childcare Allowance Scandal: A Comparative Review of Algorithmic Governance by Tax Administrations in the Netherlands, France and Germany, 13 World Tax Journal 4 (2021).整体而言,GDPR为保护数据主体对算法决策的知情权提供了法律框架,但GDPR的相关条款并没有进一步明确有效的解释标准,实践中成员国在具体落实至税收领域时,也常通过例外条款的设置减损对纳税人知情权的保障。

2.比例原则:赋予纳税人纠错权

GDPR第16条规定,数据主体有权要求算法控制者更正其不准确的个人数据。同时,数据主体有权以补充声明等方式完善有瑕疵的个人数据。实践中,纳税人的错误可以分为“善意”和“欺诈”两种类型。为了预防纳税人因“善意”错误受到算法决策的不利影响,法国《建设信任社会服务国家法》规定了行政相对人的纠错权。如果自然人或法人在行政部门规定的期限内主动或应税务机关要求改正错误,则不会受到处罚或被剥夺相关权益。“善意”错误不包括延迟申报、延迟支付等严重疏忽的过失。(36)参见法国《建设信任社会服务国家法》,载https://www.legifrance.gouv.fr/codes/article_lc/LEGIARTI000037309224/,最后访问时间:2022年5月10日。为了保障纳税人纠错权的行使,法国税务机关在税务信息网站中披露了常见的“善意”错误。(37)参见前引〔35〕,D.Hadwick、S.Lan文。从比例原则来看,鉴于税收或公共福利的目的是调整收入分配,对错误行为的适当容忍符合手段与目的之间的理性平衡。相比之下,德国对纳税人的纠错权保护则颇具争议。《德国税法通则》第129条允许税务机关随时纠正行政行为的印刷错误、计算错误和类似的明显错误,第173条允许纳税人在纳税申报时撤销或修改错误,但不包括因纳税人的严重疏忽而导致的错误。可以发现,税务机关和纳税人的容错范围略有不同,纳税人不享有纠正“类似的明显错误”的权利。为了弥补这种不平等,实践中只要纳税人在收到税务机关通知之前主动改正错误,便不会受到处罚。此外,德国税务机关还可以在纳税人不知情的情况下主动纠正其善意的错误。整体而言,区分“善意”和“欺诈”赋予纳税人纠错权,这与法国和德国减少公共开支以及提升税务机关征管效率的目标是一致的,使得税务机关能够集中精力处理严重的税务欺诈类案件。

3.辅助决策:给予纳税人人工干预权

“如果算法会作出影响人类生活的重大决策,则‘人’对决策过程的参与非常关键。”(38)Government use of artificial intelligence in New Zealand,available at https://www.cs.otago.ac.nz/research/ai/AI-Law/NZLF%20report.pdf,last visited on Apr.20,2022.算法工具作为一种类人化模型,并不能完全契合于各个场景的决策。GDPR第22条规定,数据主体有权拒绝仅基于自动化处理作出的决定,意即具有法律效力的自动化决策需要有适当的人工参与等保障措施。实践中,许多采用税务算法决策的国家都为纳税人设置了人工干预权。在德国,算法自动化仅对纳税人评估结果起到辅助作用,起决定性作用的仍然是税务机关。(39)参见前引〔35〕,D.Hadwick、S.Lan文。纳税人若对风险评估结果有异议,可以要求税务机关介入决策。(40)参见《德国税法通则》第150条、第155条。为方便纳税人行使,税务机关直接将请求人工干预的选项嵌入纳税申报系统中。(41)参见《德国税法通则》第150条第7款。然而,如果税务机关在审查后认为没有必要进行人工处理,则纳税人的数据将仍然需要在自动化算法下被评估,不能选择退出适用自动化风险评估系统。(42)参见《德国税法通则》第155条。这一定程度上弱化了人工干预的救济功能。与德国为纳税人提供的事后人工干预不同,法国引入了行政相对人的审计权,为纳税人提供了事前引入人工干预算法决策的可能性。(43)See Art.L-123-1 ESSOC Law,转引自前引〔35〕,D.Hadwick、S.Lan文。在事后人工干预的情形下,算法分析可能会影响人工干预的决策结果,而在事前人工干预的情形下,人工介入有助于减少这种不确定的预测,更有助于保障纳税人的算法权利。

4.正当程序:保障纳税人救济权

随着算法在税收领域的普及,纳税人算法权利已成为欧盟纳税人最为重要的权利之一。作为一项纳税人积极主动地获取算法决策信息、防止税务算法不利影响的权利,纳税人的算法权利还需要依托必要的救济途径来予以保障。对此,在德国,当税务机关向纳税人作出不利的行政决定时,不仅需要向纳税人指出其违反的法律规范,还须给予纳税人陈述申辩的机会。比如,《德国税法通则》第364a条规定,纳税人可以通过行政诉讼的方式与税务机关就异议裁决进行讨论。在法国,当纳税人对税务机关的算法决策有异议时,除了可以向财政管理部门提出书面异议外,还可以通过向财政调解员求助或向经济和预算部请求调解等方式与税务机关进行沟通。(44)参见Livre des procédures fiscales,载https://www.legifrance.gouv.fr/codes/section_lc/LEGITEXT000006069583/LEGISCTA000006147338/#LEGISCTA000006147338,最后访问时间:2022年4月20日。德国和法国的纳税人均可以免费启动纠纷解决机制,并对税务机关、法院等部门的处理时间作出限制,以确保纳税人可以快速解决争议。

(二)建立税务算法监督机制

1.公平原则:监督算法歧视和偏见

算法自动化决策并非完全“技术中立”。在使用机器学习等算法时,需要管理的最大外部性因素便是歧视问题,特别是因数据不准确而引起的间接性歧视。由于算法不断从历史数据中分析,有偏见的数据经过反复循环很可能会诱发歧视性的结果。比如,荷兰税务机关在利用风险评估软件分析检测社保欺诈对象时,抽样分析了较多的非荷兰籍的津贴领取人,并据此推断出该类人群具有较高的欺诈风险,这导致在之后的风险评估中,算法将会处理更多的非荷兰籍行政相对人的数据。这与荷兰并没有在法律中规定减少数据偏见的解决措施有关。相反,《德国税法通则》从多个方面规定了监督算法正常运行的措施。比如,《德国税法通则》第155条第4款将税务机关完全自动化决策限定在与纳税评估程序、预扣税款和预付款有关的行政行为及其附属职能上。上述行政行为复杂程度较低,自动化决策在该类领域的适用将不容易产生错误或偏见,这在一定程度上增强了数据用途的法律确定性。与此同时,《德国税法通则》第88条要求税务机关定期检查自动化风险评估系统,并随机抽取足量的算法决策结果进行核查,以确定算法模型是否实现了决策者的目标。然而,该条款的可操作性不强。首先,德国并没有在税法中明确随机核查的数量标准,也不需要税务机关公布定期审查的结果,这一定程度上降低了审查的作用和效果。其次,尽管德国存在监督算法决策的审查机制,但纵观《德国税法通则》,“偏见”或“歧视”两个概念均没有出现在法条中。可以说,德国税务机关并未充分考虑算法决策监督与歧视或偏见的关联性。这对法国来说尤其如此。当前,法国税务机关可以从社交媒体、共享经济和电子平台上收集数据并进行数据匹配和网络分析。(45)参见Décret n° 2021-148 du 11 février 2021 portant modalités de mise en œuvre par la direction générale des finances publiques et la direction générale des douanes et droits indirects de traitements informatisés et automatisés permettant la collecte et l’exploitation de données rendues publiques sur les sites internet des opérateurs de plateforme en ligne,载https://www.legifrance.gouv.fr/loda/id/JORFTEXT000043129895/,最后访问时间:2022年4月20日。这些数据的准确性较低,可能会产生带有偏见或错误的决策结果。

2.隐私权:监督算法数据安全

随着算法在税收征管领域的推广,税务机关一直在扩大纳税人的数据来源,例如依靠电信供应商、社交媒体或电子市场提供的数据做出税收征管决策,这加剧了纳税人隐私和数据保护与税收征管之间的冲突关系。GDPR第6条规定了算法决策者处理数据的合法情形,其中与税收领域相关的是第e项。该条款规定,如果为了公共利益或行使算法决策者的法定权力而必须实施数据处理,则该行为是合法的。GDPR作为欧盟保护纳税人数据权的约束性框架,各成员国税务机关的大多数隐私政策都来源于GDPR的规定。然而,由于GDPR法律规范较为粗略,欧盟成员国可以通过进一步立法措施限制GDPR规定的义务和权利的范围。基于此,各国税务机关可以在不违反GDPR的基础上,自由使用数据驱动技术、机器学习等人工智能进行数据分析。这使得数据安全的监督措施效果不彰。

3.专门化:算法的外部监督

GDPR第51条第1款规定:“每个成员国应规定一个或多个独立的公共机构负责监督本条例的适用情况,以保护自然人在数据处理方面的基本权利和自由,并促进个人数据在欧盟内部的自由流动。”与来自税务机关的监督相匹配,自法国在增值税领域实施机器学习等人工智能技术以来,法国数据保护局(CNIL)一直监测税务部门使用人工智能算法的情况。(46)参见Délibération 2019-079 du 20 juin 2019,载https://www.legifrance.gouv.fr/cnil/id/CNILTEXT000039438758/,最后访问时间:2022年4月20日。为了减轻人工智能技术对纳税人隐私和数据保护权利的不利影响,CNIL对法国实施的每一项人工智能工具都进行了纳税人权利影响评估,并提出了具体的防范风险的措施,(47)参见CNIL Délibération no.2019-114 du 12 Septembre 2019 portant avis sur le projet d’article 9 du projet de loi de finances pour 2020,载https://www.legifrance.gouv.fr/cnil/id/CNILTEXT000039167079/,最后访问时间:2022年4月20日。主要涉及行政部门可以保留纳税人数据的时间段、人工智能工具的适用范围和适用情形以及数据的准确性和安全性等方面。相比之下,英国、西班牙等国家则建立专门的人工智能监督机构,负责开发、监督和监测人工智能项目。(48)See Spain to create Europe’s first supervisory agency for artificial intelligence,available at https://www.engage.hoganlovells.com/knowledgeservices/news/ai-algorithms-part-6-spain-to-create-europes-first-supervisory-agency-for-artificial-intelligence,last visited on Apr.20, 2022.比如,英国成立了数据伦理和创新临时中心(CDEI),分析和预测算法是否存在偏见的问题,并预估算法对特定领域的危害。

从以上分析可以看到,欧盟对纳税人算法权利的保障采取了统一的法典式保障与各成员国具体细化规则相结合的路径,为纳税人提供了从立法规范到司法救济、从内部监督到外部监督的较为全面的保护措施。然而,虽然纳税人在形式上享有对算法的知情权、纠错权、人工干预权、数据和隐私权等权利,但税务机关的告知、披露等义务并非具有绝对的“强制性”,这使得纳税人算法权利的保障在实质上难以有效实现。这对我国在智慧税务建设背景下如何具体规制税务算法具有一定的启示意义。

五、我国规制税务算法的立法现状及完善

(一)规制税务算法的立法现状及问题

1.纳税人算法权利的法律保障不足

在我国,2021年实施的《个保法》最早以法律形式确立了自然人的算法权利。根据该法第24条,个人认为自动化决策对其权益造成重大影响的,有权拒绝个人信息处理者仅通过自动化决策的方式作出决定。然而,《个保法》的核心要义是保证个体的信息自决,重在守护个人信息主体的“数字化人格”,难以应对算法在税收等公共领域进行决策的特殊性。(49)参见王苑:《个人信息保护在民法中的表达——兼论民法与个人信息保护法之关系》,载《华东政法大学学报》2021年第2期。当算法运用于税收征管领域时,其属于公权力行使的一部分。对于代表国家意志、行使税权职责的税收机关,纳税人无法依据《个保法》的规定,直接拒绝税务机关基于算法自动化决策作出的税收决定。

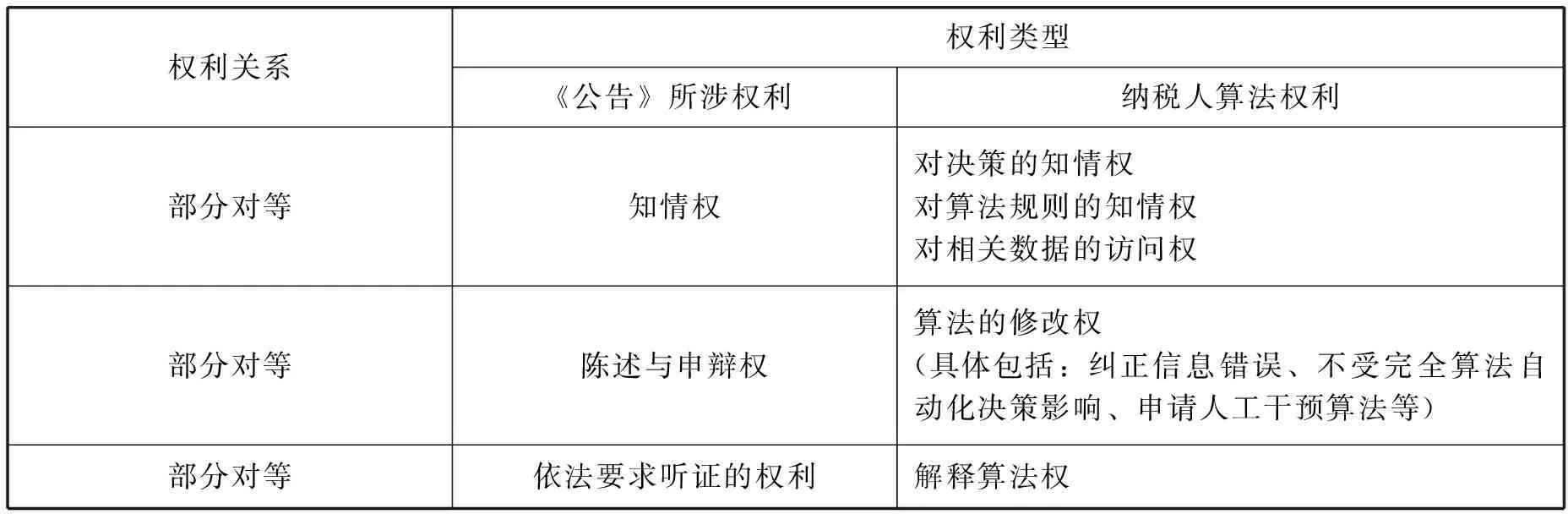

与纳税人算法权利密切相关的概念是“纳税人权利”。纳税人权利通常是指在税收征管关系中与纳税人义务相对应的一系列权利。当前,我国《税收征收管理法》第8条以及《公告》对纳税人的权利义务进行了较为详细的规定。但是,现有的纳税人权利保护体系在算法自动化决策场景下略有不足。比如《公告》中提到的“知情权”仅局限于纳税人在传统征税过程中行政程序上的权利。在算法自动化决策下,由于税务执法过程的瞬时性和自动性,纳税人对征税活动享有的权利将难以得到落实。从表1中可以看出,纳税人算法权利与《公告》所列的纳税人权利并非处于完全对等的状态。这使得纳税人在现行法律下面临着保障缺位的困境。

表1 纳税人权利与纳税人算法权利的比较

2.税务算法监督规则的缺失

2022年3月,《互联网信息服务算法推荐管理规定》(以下简称《规定》)正式生效。该规定旨在规制互联网信息服务主体的算法推荐活动,但并不能直接适用于税收征管领域的算法决策活动。在我国,与算法监管有关的法律法规主要有《民法典·总则编》《电子商务法》《新一代人工智能发展规划的通知》(以下简称《规划通知》)和《新一代人工智能治理原则——发展负责任的人工智能》(以下简称《负责任的人工智能》)等。根据《规划通知》,对人工智能“实行设计问责和应用监督并重的双层监管结构,实现对人工智能算法设计、产品开发和成果应用等的全流程监管”。在《负责任的人工智能》中,进一步提出了明确研发者、使用者和受用者的责任,确保人类的知情权。除上述专门规制人工智能发展的法律规定外,《电子商务法》及《民法典·总则编》等法律也以间接方式体现了对人工智能技术的规制。如根据《电子商务法》第18条,电子商务经营者应同时向消费者提供符合其兴趣爱好、消费习惯以及不针对其个人特征的信息,以防止出现“信息茧房”。以上法律和规范性文件概括性地规定了算法运作的整体规则,为规制我国税务算法奠定了基础。然而,整体而言,对算法治理主体的权利和责任划分尚不明晰,与税收征管直接相关的算法规范尚处于空白状态。比如,《规定》要求互联网信息服务主体公开算法运算规则,但对于公开内容、公开程序、公开对象等均没有进一步细化的规定。

(二)完善纳税人算法权利保护制度

从税权均衡理论来看,对纳税人权利的保护以及国家税权的限制,是规制算法权力的有力手段。面对人工智能时代背景下智慧税务转型,算法自动化决策的模糊性导致税务机关与纳税人之间出现权利配置的不对称状态。为此,可以考虑从税权均衡理论角度,在立法上规定纳税人的算法权利,同时限制税务机关的征税权力,使两者处于动态平衡状态,构建以纳税人为中心的人工智能技术应用体系。

1.以权利规制权力:立法保障纳税人算法权利

人民主权原则要求,税收作为同人民生活和生存息息相关的事项,应置于人民的监督之下。(50)参见刘丽:《税的宪政思考与纳税人权利的保障》,载《湘潭大学学报(哲学社会科学版)》2006年第2期。税收种类、开征方式等问题均应凸显“人民”的主体地位,反映纳税人的意见。(51)参见李仁福:《论人民主权原则对税收的影响》,载《重庆税务》2003年第2期。为此,可以在《税收征收管理法》或《公告》中,明确赋予纳税人算法权利,明确权利内涵。

第一,纳税人算法权利首先表现为纳税人的知情权,具体包括对算法所涉数据以及算法规则的知情权。税收法定原则是依法治税须坚持的首要原则。税务机关依据明确的法律授权,代表国家行使征税权,其要求课税要素须有明确的法律规定,征管程序须具有正当性。允许纳税人知悉税务机关获取的数据,可以有效减少决策的错误和不一致。(52)See Tina Ehrke-Rabel, Big Data in Tax Collection and Enforcement,Tax and the Digital Economy: Challenges and Proposals for Reform, Kluwer Law International B.V., 2019,pp.283-300.因此,为全面有效地保护纳税人的知情权,应当完善立法保障,在法律中明确规定纳税人对算法的知情范围。首先,可以在《税收征收管理法》中要求税务机关在收集纳税人数据以及启动数据处理后,告知纳税人获取数据的用途以及是否存在算法决策。其次,鉴于算法的影响因素和设计标准对算法规则有重要影响,可以制定一般的税务算法影响因素和设计标准,对禁止参考的因素作出负面清单,确保纳税人有效知悉。

第二,纳税人算法权利要求保障纳税人对算法自动化决策的修改权。首先,可以借鉴法国的做法赋予纳税人“纠错权”,纳税人可以在发现数据错误时,要求税务机关根据其提供的准确数据或在删除错误数据后重新进行决策。其次,考虑到纳税人与税务机关之间的不平等关系,在产生不可逆的算法侵害后,再寻求救济可达到的补救效果有限,因此,可以考虑赋予纳税人参与算法影响评估的权利。算法影响评估是既有税收制度资源的衍伸,参考纳税人权利和利益的影响评估机制,其目的在于让税务机关采用某项算法自动化决策前,应当采取书面、网上征求意见或召开座谈会、论证会等多种形式,使得纳税人、研究人员和决策者共同参与影响评估,赋予纳税人在算法实施前表达诉求、发现问题,甚至反对使用算法的机会。此外,可以赋予纳税人申请人工干预算法决策的权利。在纳税人发现算法自动化决策不适用于自己的税务处理,并减损了自身合法权利和利益时,可以向税务机关申请转为人工决策。同时,也可以在税收风险分析等智能模型中加入人工反馈纠错机制,将算法分析结果作为支持税收决策的依据之一,而非决定因素。申言之,将税务风险评分大于阈值的对象推送给税务机关工作人员,由其做出进一步处理。税务算法作为一种公权力行使的工具,不应是税务机关单方用来影响纳税人的工具,而要体现出科学、民主、法治的执法特征。

第三,纳税人算法权利要求保障纳税人对算法决策的解释权。赋予纳税人对算法的解释权,是纳税人知情权的必要回应,也是实现平等原则的需要。在我国,《税收征收管理法》《公告》等对税务机关在作出行政行为时向纳税人的说明义务做出了要求。基于正当程序原则,税务机关在行政行为作出前要对纳税人解释算法规则。首先,可以在《税收征收管理法》中,明确税务机关的解释内容和标准。具体来说,可以由税务机关设计统一的算法解释客体,使得算法解释对象不因税务机关的不同而有所差异。其次,对于解释标准,需要在算法决策透明度与税务机关征管效率之间寻求平衡,以“适当透明”作为算法决策透明度标准。目前对算法透明存在着不同的立场。有人认为,算法透明是法律人对技术不理解的假象,公开算法会损害相关利益,而且由于算法的专业性以及复杂性,数据主体也无法准确理解算法,公开算法无意义。(53)参见李天助:《算法解释权检视——对属性、构造及本土化的再思》,载《贵州师范大学学报(社会科学版)》2021年第5期。有人认为,当算法运用至公领域时,其代表一种国家权力。算法自动化决策进一步削弱了纳税人个人与行政部门之间的社会契约中的议价能力。为了维护行政相对人利益,应当将算法源代码予以公布。(54)参见李婕:《公共服务领域算法解释权之构建》,载《求是学刊》2021年第3期。研究表明,提高机构信任度最有效的驱动力是改善公共服务的可及性和质量。(55)See Eurofound, Societal change and trust in institutions,available at https://www.eurofound.europa.eu/publications/report/2018/societal-change-and-trust-in-institutions,last visited on Apr.20, 2022.对公共机构信任度较高的国家,其逃税水平较低,增值税缺口也较小。从比例原则角度来看,公开算法符合“手段”与“目的”之间的正当性。考虑到算法的专业性和复杂性,以及算法涉及商业秘密、国家秘密等因素,完全的、绝对的透明并不是平衡纳税人与税务机关的最佳方式。皮尤报告指出:算法必须是易于理解、预测以及控制的,以保证用户能够知悉算法处理的影响。(56)See Public Attitudes Toward Computer Algorithms,available at https://www.pewresearch.org/internet/2018/11/16/public-attitudes-toward-computer-algorithms/,last visited on Apr.20, 2022.因此,适当透明以纳税人“可理解”为标准较为适宜。具体来说,税务机关应以清晰平实的语言向纳税人作出书面解释。(57)参见GDPR第12条。相应地,可以对税务机关的信息披露义务作出规定,减少自动决策过程中的歧视与侵害风险。

2.以权力制约权力:加强对税务算法决策的监督

第一,完善算法决策的干预机制。随着人工智能技术的深入发展,即便是算法模型的开发者也难以准确解释算法,系统错误更难以发现。因此,首先,可以在算法规制标准中设置智能纠错机制,应用“补丁”作为算法“生命周期管理”的一部分,对系统错误及时进行自我修复。(58)See D.Bentley,Taxpayer Rights and Protections in a Digital Global Environment,in R.Brederode ed., Ethics and Taxation,Springer Singapore,pp.251-291,available at https://doi.org/10.1007/978-981-15-0089-3_11,last visited on Apr.20,2022.其次,可以完善对税务算法的问责机制。目前,我国尚没有统一的“算法审查委员会”。在算法技术广泛运用于公共领域的背景下,政府规制将是推动算法风险协同规制的应然选择。就我国税务算法来说,当前税务机关的算法模型制作多处于外包状态,为了便于算法工具的审查管理,税务机关可以加强对人工智能专业技术人员的培养,通过与专业人员合作开发算法,由知悉税收征管规则并擅长人工智能技术的人员联合监督税务算法设计运行。长远来看,可以通过设立算法规制委员会,对算法的内在逻辑尤其是可能的算法歧视进行专业审查。也可以将量能课税原则以及正义原则编码,植入到算法模型中,以防对特定个人或群体的不公平推断和“标签化”。(59)参见解正山:《算法决策规制——以算法“解释权”为中心》,载《现代法学》2020年第1期。同时在算法审查委员会中配备税法相关的专业人员,以回应纳税人对算法规制的诉求。

第二,合理限制算法在税收征管领域的运用范围。行政权力有着诸多不可让渡的空间,应当尽量减少由算法直接作出行政决定的情况。(60)参见胡敏洁:《自动化行政的法律控制》,载《行政法学研究》2019年第2期。为避免税务机关利用算法自动扩大其权力,可以在《税收征收管理法》中明确人工智能模型在税收决策制定中的辅助地位。对于只能由税务机关作出的行政行为,应当限制算法自动化决策的适用。正如新南威尔士大学本尼特·摩西(Bennett Moses)教授所言,人工智能可能主要用于不需要专家解释的决策,这仍然是人类的一项专利。(61)See Bennett Moses, Lyria, Artificial Intelligence in the Courts, Legal Academia and Legal Practice (August 7, 2017), 91(7)Australian Law Journal 561,561-574 (2017).具体来说,可以根据税收执法内容、自由裁量程度以及算法的适用性进行区分。对于税务机关拥有较大裁量权的执法事项,可以交由算法自动化决策进行分析,反之,则应严格交由税务机关进行人工执法,防止出现执法错误。如果算法的运算规则以及参考因素复杂,很难准确界定影响因素,出于决策准确性考虑,也不适于应用算法。(62)See B.De Martino, D.Kumaran, B.Seymour & R.J.Dolan, Frames, Biases, and Rational Decision-making in the Human Brain, 313 Science 684, 684-687(2006).

第三,适度保护原始纳税人的数据。隐私和保密是数字化和人工智能时代两个最具争议性的问题。所有的税务系统都在不同程度上保护机密的税务信息,防止未经授权的访问、浏览和发布纳税人信息。算法的运行以获取数据为基础。算法规制本身就体现着对数据收集、利用层面的规制。(63)参见于淼:《数字经济视域下算法权力的风险及法律规制》,载《社会科学战线》2022年第2期。有效的算法规制离不开对数据的保护。然而,纳税人算法权利并非用来增强纳税人对税收的对抗权,不能妨碍正常的税收征管,也必须防范纳税人滥用数据保护的权利。数据作为人工智能技术的基础,若对数据主体的保护超过必要限度,则可能会影响人工智能技术的发展,进而影响算法正面效应的发挥。国外实践表明,税务机关可以利用掌握的信息为纳税人提供商业便利。比如,在新西兰,税务机关可以掌握纳税人从分娩、退休到死亡的数据,也充分利用上述数据为纳税人提供一系列的服务,对纳税人的经营发展起到积极作用。(64)参见前引〔58〕,D.Bentley文。因此,在适度保护纳税人数据的基础上,税务机关可以利用区块链等技术优势,加强与其他部门的纳税人信息数据共享,真正实现税收治理体系的现代化。

3.构建救济制度:纳税人算法权利的请求权保障

传统税收执法下,纳税人可以通过行政复议或行政诉讼使自己的权利得到救济。在纳税人算法权利的司法救济方面,算法决策在理论上也可以构成复议、诉讼的审查对象。算法决策的错误可能来自数据错误或者系统本身的错误。就数据错误而言,纳税人可以先行使纠错权,要求税务机关修正错误数据,若税务机关拒绝修改,则可以提起行政诉讼。就系统错误而言,因为算法更多地发挥了“辅助”税务机关决策的功能,所以,算法决策的相应责任也应由税务机关及其工作人员承担。值得一提的是,税务算法作为一种关涉所有纳税人的公权力工具,若纳税人起诉事由并非由于自己的权益受到某种侵害,而是为了促进算法规则的公开透明,维护纳税人的公共利益,则纳税人的诉讼应当属于公益诉讼的范畴。此时,纳税人与讼争的算法工具是否具有直接的利害关系将不影响诉讼的开展。当前设立税务法院的呼声甚嚣尘上,面对税务算法的专业性与税务案件的复杂性,可以考虑由专门的税务法院或税务法庭进行审理。

六、结 论

在智慧税务的建设下,人工智能技术的引入不仅可以提升税收征管的效率,而且有利于提高纳税人的满意度水平。但是,通过审视我国立法和执法实践发现,我国规制人工智能算法决策的法律制度未能得到足够重视。在税收领域,这突出表现为算法决策下税务机关公权力的扩张,纳税人权利受到一定程度的侵害。既有研究往往从某一侧面分析自然人是否享有算法解释权等算法权利。本文尝试在税收征管范围内,将纳税人的算法权利界定为知情权、纠错权以及解释算法权等权利集合,并与一般意义上的纳税人知情权、陈述与申辩权以及救济权等权利进行对应。我国人工智能技术正在嵌入社会生活治理的方方面面,算法规制之路尚在探索之中。这就要求对算法自动化决策在税收领域的适用进行限制与规范化。税权均衡理论源自税收国家,旨在通过税收制度设计维系纳税人权利与国家税权的平衡。为此,可以通过立法赋予纳税人算法权利,并加强税务算法的内外部监督,避免算法自动化决策对纳税人生产经营活动的干扰。这是智慧税务建设的应然要求,以此促进税务机关负责任地应用算法自动化决策。