基于深度学习的宫颈原位腺癌图像识别方法

刘 畅,郑宇超,谢文倩,李 晨,李晓晗

1中国医科大学附属盛京医院病理科,沈阳 110004 2东北大学医学与生物信息工程学院,沈阳 110819

宫颈癌是女性生殖系统最常见的恶性肿瘤之一,《2020年全球癌症数据报告》显示,宫颈癌发病率、死亡率分别居所有恶性肿瘤第7、9位,严重影响女性的身体健康[1]。随着宫颈癌筛查的普及,宫颈鳞癌发病率已明显下降,宫颈腺癌及其癌前病变发病率逐渐升高[2]。宫颈原位腺癌(cervical adenocarcinomainsitu, CAIS)是发生于宫颈腺上皮内的癌前病变,组织学表现由肿瘤性上皮代替颈管表面和内部腺体的正常上皮,其多见于30~40岁女性,侵袭性较高级别鳞状上皮内病变高[3-5]。CAIS起病隐匿,临床症状不典型,组织病理学检查是确诊CAIS的金标准。目前常通过宫颈细胞学、阴道镜下多点活检以及颈管诊刮等联合筛查方法以实现CAIS的早期诊断[6-7],但人工阅片病理诊断工作效率较低,且高负荷的工作易引起阅片者视觉疲劳,导致漏诊、误诊,影响诊断结果的准确性。

近年来随着医工融合领域的兴起,计算机辅助诊断和图像识别技术在病理学研究中得到了广泛应用[8]。国内外许多研究者在提高宫颈细胞学智能诊断领域取得重大研究进展[9-12]。本研究探讨应用深度学习算法构建CAIS病理图像智能识别模型的可行性,以辅助临床医师进行CAIS病理诊断,减少误诊率、漏诊率。

1 材料与方法

1.1 材料来源与数据集分组

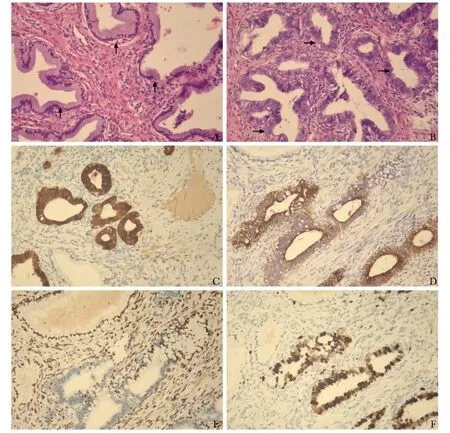

回顾性收集2019年1月至2021年12月中国医科大学附属盛京医院病理科保存的CAIS患者阴道镜多点活检和手术锥切活检病理切片(包括免疫组化)、慢性宫颈炎患者正常宫颈管腺体HE染色病理切片。纳入标准:CAIS、慢性宫颈炎的诊断均由2名具有10年以上工作经验的病理科医生完成,其中CAIS诊断标准:细胞核增大、深染、异型性,可见核上移、核分裂或凋亡小体增多等;免疫组化示P16弥漫表达和Ki-67指数增高(图1)。排除标准:出现切片制作不良、细胞变形、染色不均匀等情况。

图1 宫颈原位腺癌组织病理图像(×100)

取CAIS和慢性宫颈炎病理切片,由2名经验丰富的病理科医师进行标注。通过图像采集系统采集图像(显微镜型号Axio Scope.A1),采集倍数为100倍(分辨率为3840×2160)。按4∶3∶3的比例随机分为训练集、验证集和测试集。其中训练集数据用于训练模型,验证集数据用于模型参数调试及模型对病理图像分类能力的初步评估,测试集数据用于最终模型的性能评定。

本研究已通过中国医科大学附属盛京医院伦理审查委员会审批(审批号:2022PS841K),并豁免患者知情同意。

1.2 方法

1.2.1 迁移学习

传统机器学习算法对数据有严格要求(如需服从相同的分布),临床许多数据并不完全满足该假设,导致机器学习应用受限。与此同时,研究者常无法获取足够的样本量,出现因网络结构训练不足导致的模型过拟合现象。迁移学习是将在特定领域/任务中学习的知识或模式应用于不同领域/场景的方法[13-15],其可有效解决数据不满足需求和样本受限的问题。延伸至神经网络中,研究人员可直接使用经过训练的模型,从中选取可使用的结构层,将其输出结果作为输入信息,进而训练为一个参数更少、规模更小的网络结构。这些小规模的网络结构仅需明确具体问题的内部关系,通过预训练对隐含模式进行学习即可达到较好的性能。目前迁移学习的应用方法主要包括两种:一种为根据具体需求对预训练网络结构的参数进行微调;另一种是将预训练的网络结构作为特征提取器,基于提取的特征对新的分类器进行训练。本研究采取第一种方法进行迁移学习,即对在ImageNet数据集中预训练的网络结构进行参数微调。在实际操作中,冻结了除全连接层以外的其他网络参数,仅对最终网络层的超参数进行调整,从而达到适应宫颈病理图像学习的目的。

1.2.2 模型训练与构建

基于训练集、验证集数据,利用迁移学习的方法进行模型训练和参数调试,构建可对CAIS病理图像进行识别的卷积神经网络(convolutional neural networks, CNN)二分类模型。模型的训练过程分为前向传播和反向传播2个阶段[16]共5个操作步骤:(1)加载已完成预训练的VGG16、VGG19、Inception V3、Xception、ResNet50和DenseNet201网络结构,并将其权重初始化。(2)输入训练数据,经卷积层、下采样层、全连接层处理后获取输出结果。(3)计算输出值与标签值的误差,若误差不满足要求,则进入第4步,即反向传播过程;否则进入第5步。(4)在误差降低的方向上对权重进行更新,评估模型的性能是否得到改善。若无改善,则衰减学习率,返回至第2步,进行下一轮迭代流程(若有改善,进入下一步)。(5)保存CNN网络结构各层权重和阈值,完成模型训练。本研究采取指数衰减学习率进行模型训练和参数调试,获取最优模型。相关参数设置:衰减步长为5,衰减率为0.1,初始学习率为0.0001,优化器为Adam,损失函数为Categorical Crossentropy。初始输入图像尺寸为224×224×3,批量数为128,共进行100次迭代。

1.2.3 集成学习

集成修剪是从一组已完成训练的个体学习器中,选取一个子集进行集成学习。其具有2个优势,其一为使用更小规模的数据完成集成结果,不仅可减小模型的存储量,还可减少学习器输出的计算量,提高工作效率;其二可提高模型的泛化性能,甚至可能优于使用全部个体学习器进行集成后获得的模型。本研究采用加权投票法将多个学习器进行集成。首先筛选出测试集中识别性能较好的单一网络,以各模型的准确率为权重,然后两两组合进行集成。

1.3 评价指标

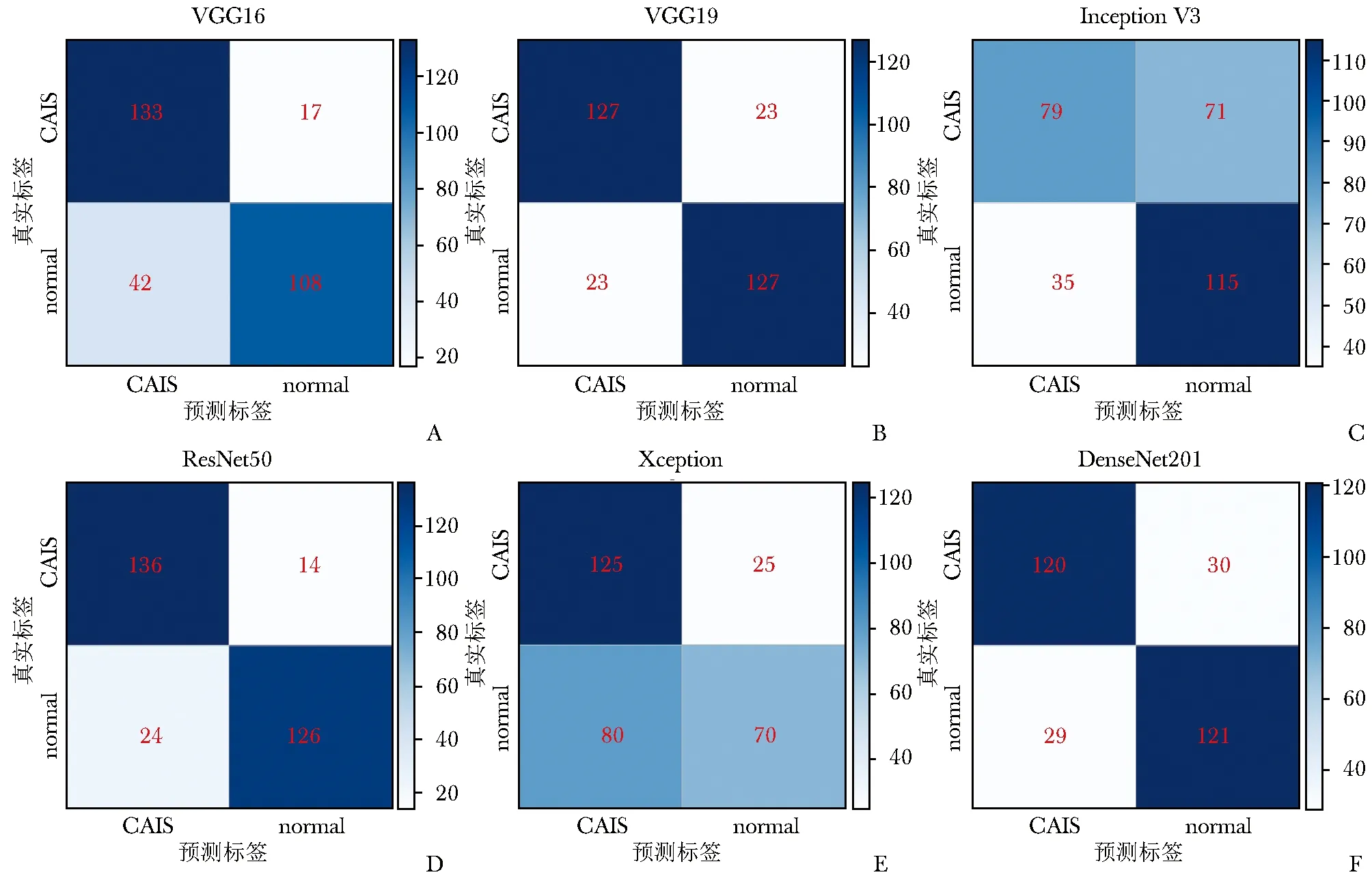

基于测试集数据对模型的分类效果进行评价,评价指标为运算时间、准确率、精确率、召回率、F1值、受试者操作特征(receiver operating characteristic, ROC)曲线下面积(area under the curve,AUC),并通过混淆矩阵进行可视化展示。混淆矩阵是评价模型性能的常用方法,在人工智能领域中,通常用于监督学习,其通过n行×n列的矩阵形式展示模型的精度。矩阵中的行和列分别表示数据的实际类别和预测类别,每行的数据总数表示该类别数据的实际数目,每列的数据总数表示预测为该类别数据的数目。颜色越深表示模型对图像识别的准确率越高。

1.4 统计学处理

采用Python3.9.0软件进行统计学分析,并输出模型对病理图像识别结果的混淆矩阵及ROC曲线图,输出图片识别效果的AUC。准确率、精确率、召回率、F1值以百分数表示。

2 结果

2.1 病理图像数据集

共入选符合纳入和排除标准的CAIS病理切片104张(52例患者)、慢性宫颈炎正常宫颈管腺体病理切片90张(45例患者),收集CAIS、正常宫颈管腺体病理图像各500张。训练集、验证集、测试集中分别包含宫颈原位腺癌图像200张、150张、150张,包含正常宫颈管腺体图片200张、150张、150张。

2.2 模型评价

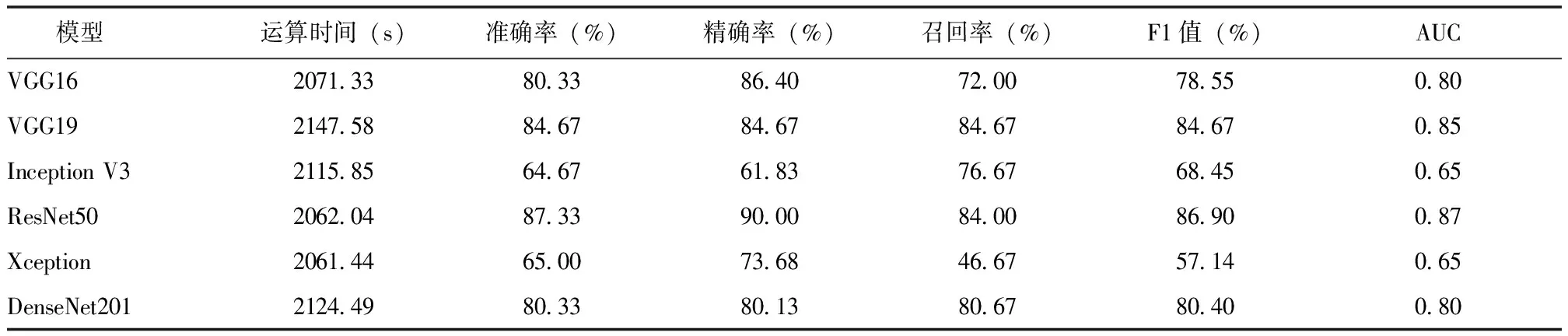

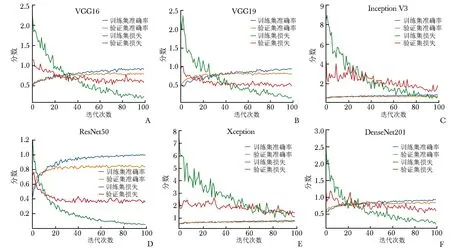

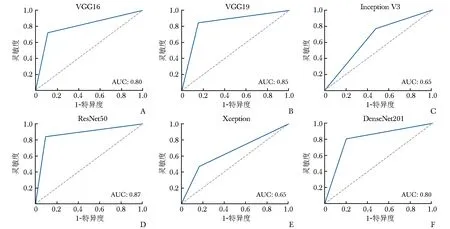

6种模型的训练结果见图2,ROC曲线分析结果见图3。VGG16、VGG19、ResNet50、DenseNet201模型识别CAIS病理图像的准确率和精确率均高于80%,其中VGG19模型的召回率最高,达84.67%。ResNet50模型的准确率、精确率、F1值及AUC均最高,召回率居第2位,运算时间较短,该模型的整体性能最佳,VGG19模型次之,Inception V3与Xception模型对CAIS病理图像的识别能力最差,准确率均低于70%(表1)。混淆矩阵进一步验证了上述结果,见图4。

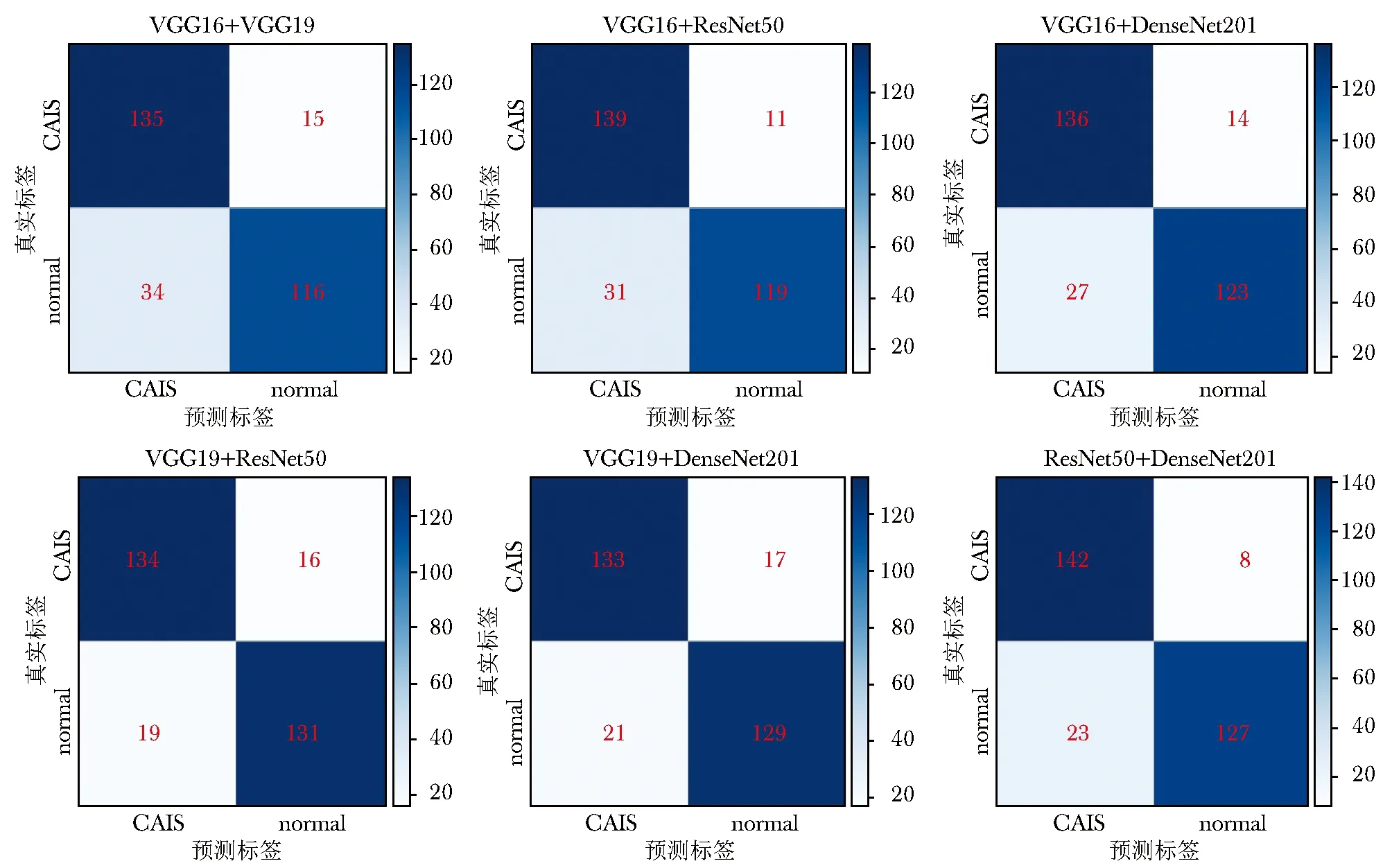

图4 6种模型对测试集图像识别效果的混淆矩阵

表1 6种模型对测试集图像识别效果的评价指标

图2 6种模型训练结果

图3 6种模型对测试集图像识别效果的受试者操作特征曲线图

2.3 集成学习模型性能评价

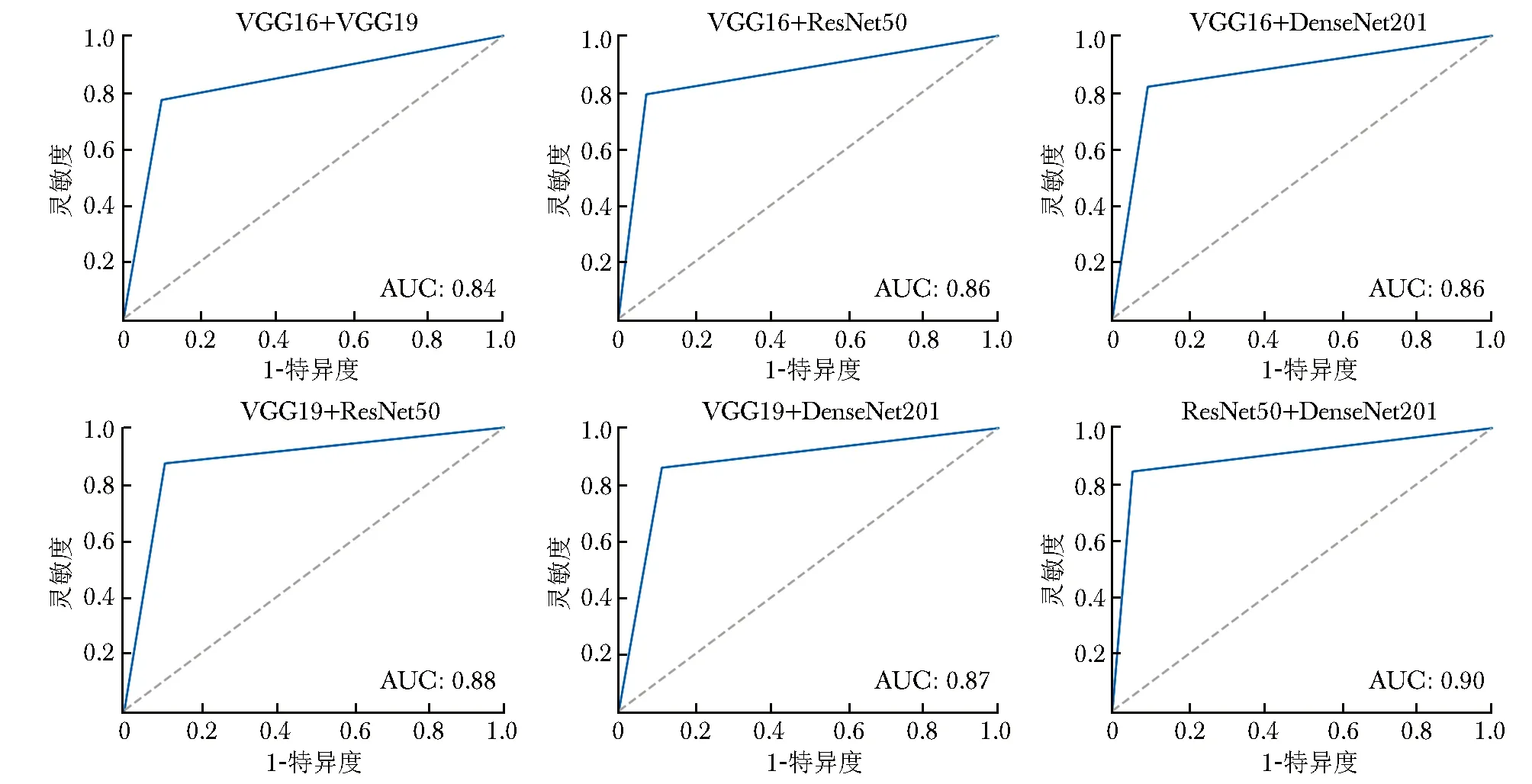

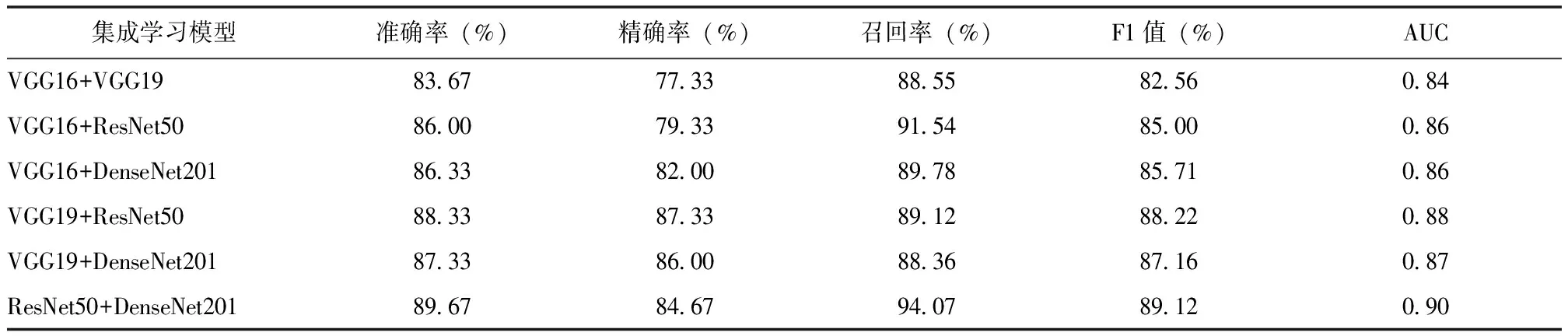

从迁移学习训练的6种网络模型中,选取2种模型作为个体学习器进行集成。在模型选取时,首先将图像分类效果较差的Inception V3和Xception模型剔除,然后选取余4个模型两两进行组合,共构建6个集成学习模型。本研究以图像识别准确率为最重要的观察指标,优先考虑将准确率进行加权。结果显示,与单个模型比较,集成学习的模型对CAIS病理图像的识别能力明显提升(表2)。其中ResNet50与DenseNet201集成模型的准确率、召回率、F1值、AUC均最高,整体性能最优,其次为ResNet50与VGG19相集成。集成学习模型对测试集CAIS图像识别结果的ROC曲线见图5,混淆矩阵见图6。

图5 集成学习模型的受试者操作特征曲线图

图6 集成学习模型对测试集图像识别效果的混淆矩阵

表2 6种集成学习模型对测试集图像识别效果的评价指标

3 讨论

本研究基于迁移学习技术,通过6种网络结构探究了构建CAIS病理图像智能识别方法的可行性,结果显示ResNet50模型在AIS病理图像的识别中准确率(87.33%)、精确率(90.00%)、F1值(86.90%)及AUC(0.87)均最高,召回率(84.00%)居第2位,系统运算时间较短(2062.04 s),其整体性能最佳。进一步将单个模型进行组合,构建集成学习模型,结果表明将ResNet50与DenseNet201相集成得到的模型具有更高的CAIS病理图像识别能力。

病理图像的精准识别可为CAIS早期诊断提供重要参考依据。传统人工阅片的病理诊断方法需病理医师通过显微镜对病理图像进行观察,该方法工作量大、耗时长、主观性强、易漏诊,尤其CAIS起病隐匿,病变位于颈管处,活检取材局限,增加漏诊的概率。近年来,人工智能在宫颈病变病理图像识别领域已有较多研究发表[17],涉及图像分割[3]、融合及可视化[4-5]。Sato等[18]基于深度学习算法实现宫颈癌前病变、原位癌、浸润性癌图像三分类,准确度为50%。Asiedu等[8]将宫颈醋白实验和碘实验图像提取的颜色和纹理特征相结合,构建宫颈病变图像的支持向量机(support vector machine, SVM)分类器,实现了鳞状上皮内病变和非鳞状上皮内病变图像二分类,经测试模型的特异度为78.6%,准确度为80.0%[8]。目前,人工智能在CAIS图像识别中的研究较缺乏。

本研究对6种经典CNN网络结构进行了训练,以期构建可识别正常宫颈管腺体和CAIS病理图像的分类模型。VGG16、VGG19、ResNet50、Inception V3、Xception和DenseNet201均为经典的迁移学习网络结构。VGGNet是Simonyan和Zisserman于2014年提出的CNN模型,在当年的ImageNet大规模视觉识别挑战赛(ImageNet Large-Scale Visual Recognition Challenge, ILSVRC)中,荣获分类任务第二名、定位任务第一名[19-20]。VGG16、VGG19结构相似,仅在网络深度方面存在差异,该网络论证了CNN的深度能够在一定程度上影响网络的性能表现[19],但缺点是资源耗费大、训练时间久、存储容量高。Inception模块是GoogLeNet的核心组成单元[21],其基本组成架构主要包括4个部分:1×1卷积层、3×3卷积层、5×5卷积层、3×3最大池化层。Inception V3利用拆解(Factorization)的思想对之前的版本进行了改进,使参数量降低了33%,其优势是多视野,可纳入多尺度信息,但牺牲了网络深度,导致一些有价值的信息提取不充分。Xception由Chollet提出,其主要创新是引入了深度可分离卷积,将通道卷积与空间卷积分离,提高了训练效率并缩短运算时间,在数据集较大的情况下,其训练效果优于Inception V3[22]。DenseNet201由清华大学黄高博士于2017年提出,核心思想为密集连接,即某层的输入信息除包含前一层的输出信息外,亦包含前面所有层的输出信息,以保证在神经网络前向传递中,每一层均可与前面所有层直接进行连接,其在减少参数量的同时加强了特征之间的传递效率。ResNet50模型于2015年由Kaiming首次提出,该模型在当年的ImageNet比赛分类任务中获得冠军,其基础模块为残差块(residual block),分为直接映射和残差映射两部分。在直接映射部分,上层的网络输出可被直接传至下一层,不增加任何附加参数;反向传播时,下一层网络的梯度可直接传递给上一层,以有效解决深层网络梯度消失的问题[23]。ResNet50系列模型最大的优势是引入了残差结构,在不断增加卷积层数的同时可兼顾模型准确率的提升[24]。Al-Haija等[25]基于ResNet50建立的乳腺组织病理图像迁移学习模型,可实现乳腺病理图像良恶性二分类,准确率高达99%。本研究结果显示,VGG19模型具有较高的图像识别召回率,而ResNet50模型的准确率、精确率、F1值及AUC均最高,其整体性能最优,提示VGG19与ResNet50可较好地实现AIS病理图像识别。这得益于VGG19与ResNet50的结构优势,使其对小数据集具有更高的适应性以及深层网络对病理学图像较高的特征提取能力。

模型集成学习是将多个学习器相结合,以提高模型的鲁棒性和泛化能力,更高效地完成图像识别、分类、预测任务。但在模型集成过程中需考虑模型构架的可读性、可测试性以及代码生成方式等问题。在单个模型的基础上,本研究进行集成学习,以进一步提高分类模型的性能。由于在单个模型的迁移学习阶段,Inception V3与Xception对CAIS图像识别的性能最差,集成学习时首先将其剔除。其余4个模型两两进行集成。本研究结果显示,ResNet50与DenseNet201相集成的模型具有更高的准确率、召回率、F1值和AUC,与单个模型相比,准确率、召回率、F1值及AUC均有不同程度的提高。从网络结构来看,ResNet50的残差结构加强了深层网络的图像特征提取能力,DenseNet201的抗过拟合能力和泛化性能十分强大,此2种网络相结合可优势互补,发挥整体更强的图像识别能力。尤其在病理学诊断最看重的图像识别准确率方面,集成网络的效果更胜一筹。

本研究局限性:(1)受限于病理切片的数量,仍可能导致模型过拟合现象;(2)模型的训练数据和验证数据均来自中国医科大学附属盛京医院,缺乏多中心样本数据对模型性能进行外部验证。

综上所述,基于迁移学习和CNN可实现对CAIS图像进行智能识别,以辅助病理医师阅片,提高宫颈癌早诊率。本研究再次证实人工智能在病理图像识别中具有较大的优势和较好的应用潜力,后续将致力于提高CAIS病理图像识别的精确度、提升模型性能、建立CAIS图像数据库相关研究,并促进相应研究成果于临床落地,真正服务于临床,惠及广大患者。

作者贡献:刘畅负责研究设计、临床病理数据收集、病理诊断判读与论文撰写;郑宇超负责研究设计、模型构建与数据分析;谢文倩负责临床病理数据收集与图像采集;李晨、李晓晗负责指导研究设计与论文审校。

利益冲突:所有作者均声明不存在利益冲突