基于图卷积和自然实体知识的问答式情感分析研究

施重阳,胡光怡

(北京理工大学 计算机学院,北京 100081)

0 前言

近年来,用户对线上产品的评价和商家对用户反馈的响应关乎商家的长期发展,文本评论情感分析引起了研究者们的广泛关注。问答式情感分析是情感分析研究的新兴热点之一,问答式评论文本中问题和回答之间的结构关联至关重要。传统的情感分析方法不能直接应用于问答式风格的情感分析任务中,且在先前问答式情感分析的研究中,问答式评论文本里的双向语法依赖关系、问答结构、多阶隐式语义信息等隐式关联没有得到充分的利用,尤其是拥有特定语法的中文文本。

先前的问答式情感分析研究仍存在以下问题:

(1) 如图1所示,基于依存语法树的图嵌入模型的学习训练过程与文本情感特征提取模型是独立的,导致两部分模型无法端到端地进行信息提取和情感特征学习训练,故而无法通过后期特征提取阶段的学习来更新前期语法信息的提取过程,导致图嵌入模型所提取出的语法信息对后期模型的辅助能力十分依赖于前期图嵌入模型的学习效率,在两部分之间产生的训练误差无法进一步缩小。

图1 问题图(a)

(2) 在新的数据出现时,两部分模型无法进行统一的权重更新以适应承载更多的信息。

(3) 如图2所示,Hu等人[1]的研究只考虑了依存语法树中词语之间的单向依赖关系,即从词语指向其所依赖词语的方向,没有考虑所依赖的词语指向当前词语方向的信息。

图2 问题图(b)

为了解决上述问题,实现端到端的训练,更好地学习依存语法树中的句法结构信息,本文尝试借助图神经网络在依存语法树基础上对问答式文本对进行建模,并在图神经网络中引入卷积操作。与此同时,由于问答文本中问题对应答案的这种特点,若模型能够了解自然世界中更多的实体信息和实体间的关联信息,便能在拥有知识背景的前提下,更加明白问题和回答中一些专有名词的含义,也更能明白用户的关注点在哪里。例如,在文本对[Q: ‘这款笔记本怎么样?’,A: ‘一个月前购买的,笔记本散热功能不错,但是电池的续航能力不太行。’]中,如果能知道“笔记本”是什么、“电池”是什么、“散热”表达的是什么内容,“续航”表示什么样的现象或行为等先验知识,在模型中引入更多语义内容,对于文本的内容理解和情感倾向分析会更加简单。因此本研究结合实体和自然知识信息,为问答文本对引入常识知识背景,将自然知识学习模型与图卷积神经网络进行融合,这有利于问答式情感分析研究。

本文提出了知识-图卷积双重网络模型E-QAGCN(Enhanced Question-Answering Graph Convolution Network),对文本内容进行双重初始化,分别进行自然语言知识背景下的特征提取学习和依存语法树中语法信息引导的特征提取学习,最终进行情感信息的汇总。这是首次在问答式情感分析任务中尝试利用图卷积神经网络对文本进行建模,模型的构建基于依存语法树结构,同时考虑到词语之间的依赖关系,将与词语相关联的信息融入向量表示中,并通过多层卷积操作对文本进行了深层次的特征提取,在三个领域的数据集上的实验结果验证了该模型的有效性。

1 相关工作

情感分析早期主要以单词、语句、篇章或属性为粒度进行情感分析,通过机器学习、情感词典等方法对整个文本进行情感倾向的评定。Wilson等人[2]构建了情感词典,为每一个词语都标注上先验极性。Li等人[3]关注两种评论文本,提出了集成的方法和协同训练的算法来进行情感分类。Kim[4]在语言模型的基础之上,主体使用卷积神经网络(Convolutional Neural Network,CNN),证明了其在语句情感分析任务上的优越性。Wang等人[5]研究带噪声标签的句子级情感分类学习问题,提出了一种新的DNN模型来处理训练过程中的噪声标签。Ma等人[6]将常识知识集成到循环编码器中,解决了面向对象的情感分析和面向属性的情感分析难题。Wu等人[7]提出了一种新的用户和产品信息编码框架,采用两个独立的层次神经网络来生成两种表。Wang等人[8]搭建了主体为长短时记忆网络(Long Short-Term Memory,LSTM)的网络模型,将各种属性作为输入,使用注意力机制判别句子中各个部分的重要程度。Sun等人[9]提出了一种新的属性级情感分析的解决方案,将其转化为一个句子进行分类,同时微调预训练的BERT(Bidirectional Encoder Representations from Transformers)模型。Tian等人[10]提出了情感知识增强的情感分析预训练方法,为多种情感分析任务提供了统一的情感表达方式。

问答式情感分析研究在2018年第一次被Shen等人[11]提出,与传统的评论情感分析相比,问答式评论文本可以提供更多信息,更具说服力。同时,对问答式评论文本对进行分析具备其特殊的挑战性。Shen等人[11]搭建层级匹配网络,采用双向匹配的方法挖掘问题和回答之间的情感信息,并使用自注意力机制获取整个文本对的情感极性。Wang等人[12]提出了一个新的研究课题即属性级问答式的情感分析,同时构建了一个加强的双向注意网络解决问题与回答之间的语义匹配和数据噪声问题。Hu等人[1]搭建了基于语法结构和上下文语义信息的双重残差网络,结合依存语法树和图嵌入对问答式情感分析任务进行建模。

2 基于图卷积和知识的双重网络模型

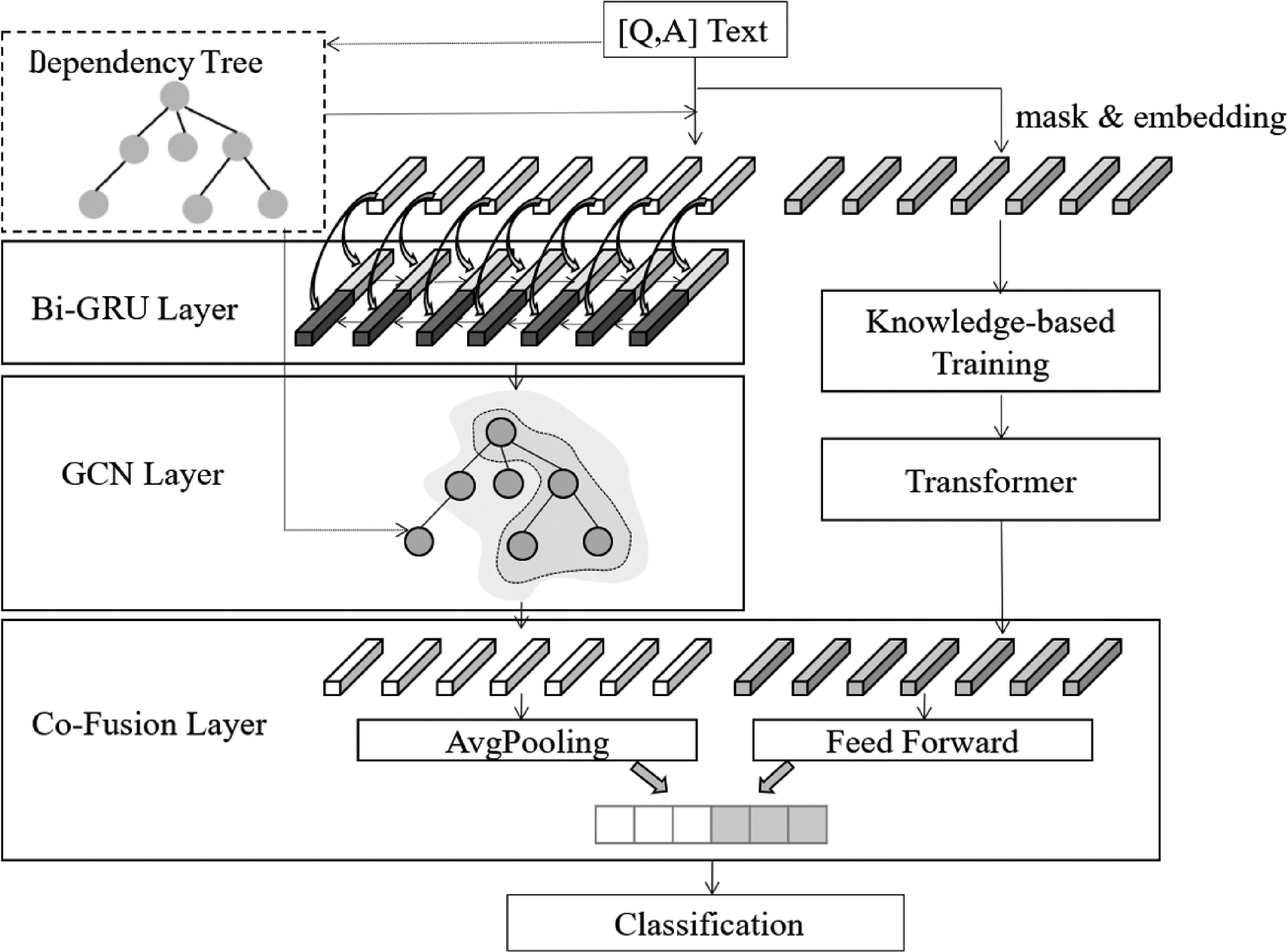

本节从文本在双重网络模型中的流通过程的角度出发,将着重介绍自然知识表征学习的结合过程以及联合图卷积的双重神经网络架构E-QAGCN,模型架构图如图3所示。

图3 框架图

2.1 引入先验自然知识的表征学习研究方法

本节借助预训练语言模型ERNIE(Enhanced Representation through Knowledge Integration)[18],使用多层Transformer,借助自然界的先验知识进行问答式情感分析研究。在BERT语言模型中,对所使用数据的处理只是对单个字符进行屏蔽,没有考虑字符与字符之间的关联,这种方式在英文等单个单词为最小表达粒度的语言中较为适用,但是在中文语言环境下,会导致语言模型学习到的语义表示出现信息混乱和内容匮乏的问题。因此,除了对字符进行随机屏蔽外,ERNIE模型还采用了短语级和实体级的屏蔽训练机制对高级语义知识内容进行建模。

首先在字符级别进行15%的屏蔽,之后对预训练模型进行更深一步的训练。在短语级屏蔽机制中,使用依存语法分析工具对文本进行词语提取,在同一文本被工具分割后的词语中随机选取几个词语进行屏蔽,预测同一短语中的所有字符表示,在这一阶段,词语信息被编码到嵌入向量空间中。在实体级屏蔽机制中,对包括著名人物的姓名、地标性地点名称、组织专属名称、产品名、产品属性信息等在内的实体信息进行屏蔽。预训练时所用到的训练数据包括百度百科等百科类数据、资讯等中文语料、论坛中的对话类数据等。在问答式情感分析研究中,研究形式为文本分类,但究其根本是对话模式的文本数据,引入额外的对话形式的数据信息更有利于问答式情感分析的研究。ERNIE模型进一步使用中文对话语言模型对对话类数据进行建模,采用问题-回答的对话文本结构,进一步强化对话响应和语义表达能力,适合用于解决当前任务。

文本分词和屏蔽处理后的结果会进行随机初始化,然后作为多层Transformer编码器模型的输入,经过多个Transformer层特征提取得到最终的文本词语语义表示Xz={Xz1,Xz2,…,Xzk},其中每一个Transformer层包含一个多头自注意力层和一个前馈神经网络层。初始输入层中Q,K,V三者相同,均为文本词语语义表示Xz={Xz1,Xz2,…,Xzk},随着层数的加深和训练的深入会有所变化。

(1)

经过语言模型训练得到整个文本的输出和每个单词的输出,作为图卷积双重网络的语义输入。

2.2 基于语法和语义的图卷积双重网络模型

本节使用图卷积神经网络实现对依存语法树中的关联信息的提取以辅助完成问答式情感分析,以求能够在保证实验效果的前提下实现端到端的模型训练和更新。在本网络模型中,语义知识表示向量Xv由语言模型得到,带有语法辅助的语法语义向量表示Xc={Xc1,Xc2,…,Xck}由词语语义表示Xt={Xt1,Xt2,…,Xtk}经过双向门控循环单元网络(Bidirectional Gated Recurrent Unit,BiGRU)和图卷积神经网络编码得到,语义知识向量表示和基于依存语法树得到的语法语义向量表示会进行信息整合,之后经过前向压缩层输出,进而进行预测和分类。

整合问答文本对中的问题文本Xq={Xq1,Xq2,…,Xqm}和回答文本Xa={Xa1,Xa2,…,Xan}并进行初始化得到词语语义表示Xt={Xt1,Xt2,…,Xtk},此处初始化使用的中文预训练词向量是Li等人[13]以百度百科数据为语料进行训练得到的。将前向编码隐藏层结果和后向编码隐藏层结果进行向量维度方向上的相应并行拼接,得到BiGRU模拟人类阅读方式进行训练学习得到的上下文语义隐藏表示{h01,h02,…,h0k}。

接下来,上述上下文语义隐藏表示{h01,h02,…,h0k}会经过图卷积神经网络,在此过程中,模型会对文本进行基于依存语法树的局部强化编码。文本被解析为一棵依存语法树后可被看作是一个连通图,节点和边分别表示文本中的词语和它们之间的依赖关系。本节不再将依存语法树看成一个有向图,而是将依存语法树看成一个无向图。对于依存语法树中任何一个词语来说,无论是依赖于当前词语的词语,还是当前词语所依赖的词语,都看作当前词语一阶连接词语,与当前词语有着某种关联关系。若吸纳周围一阶词语的语义信息,不仅可以利用所依赖的词语来丰富当前词语的内涵,还可以利用依赖于当前词语的所有词语来增强当前词语的表达。

从语料中提取的结构不再是三元组,而是利用邻接矩阵的方式记录与当前词语的连接关系,在当前文本的所有词语中,若与当前词语有所关联,则标记为1,若没有关联,则标记为0。结合依存语法树和文本序列可以得到k×k的邻接矩阵Dij,Dij的值为0或1,当Dij=1时,表示两个节点之间存在依存关系。

经过多阶的图卷积网络信息增强后得到语法语义向量表示Xc={Xc1,Xc2,…,Xck},通过对依存语法树中路径传播的应用,集成了句法连接信息和多阶语义信息。不仅在依存语法树中直接关联的词语间信息得到整合,在语法树中的多阶关联关系也得到了聚合。

在此之后进行了平均池化操作,这一步骤将图卷积神经网络的多阶信息进行了进一步的汇总,相当于将整个图的信息汇聚到一个节点。

语义知识向量表示和得到的语法语义向量表示会经过合并层在向量维度进行拼接,期望将在大量语料中训练学习得到的结果Xv与在当前特定领域的小语料中得到的结果进行结合。在此过程中,为语义知识表示和语法语义表示分配了同样的权重,对于最终结果的贡献度相同。

3 实验数据和实验设置

3.1 实验数据集

本文所使用的中文问答式情感分析数据集QASA来自Shen等人[11]的开源数据。数据集来自三个领域,分别是美妆、电子产品和鞋类。

3.2 实验参数设定

采用Li等人[13]提供的中文预训练词向量“sgns.baidubaike.bigram-char”进行上下文语义表示初始化,所有文本的依存分析均来自于百度的中文文本处理工具Baidu-aip。由于本研究的图卷积神经网络取依存语法树中的节点作为输入,因此这部分模型以依存语法分析工具得到的文本分割结果作为输入,而预训练语言模型部分使用其特定的分割形式作为输入。

3.3 实验对比模型介绍

本文选择了以下基线方法来与本研究提出的模型进行比较。

(1)LSTM: 长短时记忆网络(LSTM),一种改良后的RNN模型。

(2)BiLSTM: 双向长短时记忆网络(BiLSTM),一种双向LSTM模型。

(3)TextCNN[4]: 卷积神经网络(CNN),传统深层神经网络的变种之一。

(4)Transformer[14]: 模型采用了残差连接、多头自注意力机制、位置编码等机制。

(5)DPCNN[15]: 深层层次卷积神经网络模型(Deep Pyramid Convolutional Neural Networks for Text Categorization,DPCNN),采用区域嵌入编码、等长卷积机制、固定特征图数量、二分之一池化等机制。

(6)BM[11]: 双向匹配模型(Bidirectional-Match,BM),来自Shen等人的研究方法,采用双向问答匹配机制,使用注意力机制与将文本对中的两个文本进行匹配以互相参考并提取重要信息。

(7)HMN[11]: 层级匹配网络模型(Hierarchical Matching Network,HMN),除了双向问答匹配机制,还采用了句子分割和层级自注意力机制,通过自注意力匹配层学习随机生成的匹配向量的重要程度。

(8)TextGCN[16]: 图卷积神经网络(Graph Convolutional Network,GCN),一种从图类数据中提取特征的网络模型,计算当前词语和周围词语的平均值对文本的局部片段进行编码。

(9)CDT[17]: 卷积依存网络模型(Convolution over Dependency Tree Model,CDT),一个借助依存语法树解决属性级情感分析的图卷积神经网络模型,使用GCN进一步结合文本句法进行多阶属性提取。

(10)ERNIE[18]: 知识集成的增强语义表示模型,由百度在2019年提出的针对中文的语言模型,通过知识屏蔽语言模型来增强的语言语义表示。

(11)DepTLCN[1]: 基于语法结构和上下文语义信息的双重残差网络,结合依存语法树和图嵌入对问答式情感分析任务进行建模。

(12)TextINT[19]: 归纳文本图神经网络(Inductive Text Classification via Graph Neural Networks),其中包含三个关键部分,包括文本图构造、基于图的文字交互和输出层,基于门控图神经网络对文本进行整合分类。

(13)RGAT[20]: 关系注意力图神经网络(Relational Graph Attention Network),借助标签特征更好地捕获词语与词语之间的关系。

4 实验结果和分析

4.1 实验评估指标

在本研究中使用准确率(Accuracy)和Macro-F1值来对模型在问答式情感分析任务中的表现进行评估。

4.2 实验结果分析

表1中列出了所有的基线模型和研究所提出的方法模型的实验结果,结果均以百分制的形式给出。

表1 整体实验结果 (单位: %)

由表1数据可以看出,本文提出的模型优于其他基线模型。为实现图神经网络模型的研究,本文选取前沿的图神经网络,并将其作为额外的基线模型应用于情感分析的模型。

TextGCN基于文档-词语关系建图,而CDT根据句法关系建图,其中邻接矩阵是根据依存语法树中的连接关系得到的,因此可能导致TextGCN在此问题上表现平平,基于语法树的CDT效果相对较好,同时也间接证明了依存语法树中句法信息在辅助情感分析问题上的有效性。由实验结果可见,RGAT对于本问答式情感分析的分类效果要明显优于TextINT,与CDT模型效果相差不大。由于图卷积神经网络类模型的训练速度要快于需要大量计算的图注意力类模型,在本文研究与拥有自然知识背景的预训练模型结合时,选用了图卷积神经网络来对依存语法树上的内容进行编码。从基于图神经网络的模型效果来看,基于图神经网络的模型在本任务上的效果参差不齐,不同的模型之间的效果差别很大,因此在研究图神经网络时,如何更好地利用图中的关联信息以及如何更合适地对图类数据进行编码的问题十分关键。

本实验在问答式情感分析任务上进行了进一步的探究,基于图卷积神经网络,与知识背景模型相结合,实现了以端到端的方式对依存语法树中的语法信息和语义信息的同时提取,成功将此种方法应用到了问答式情感分析任务中,达到了同期业界最优效果。

4.3 参数实验

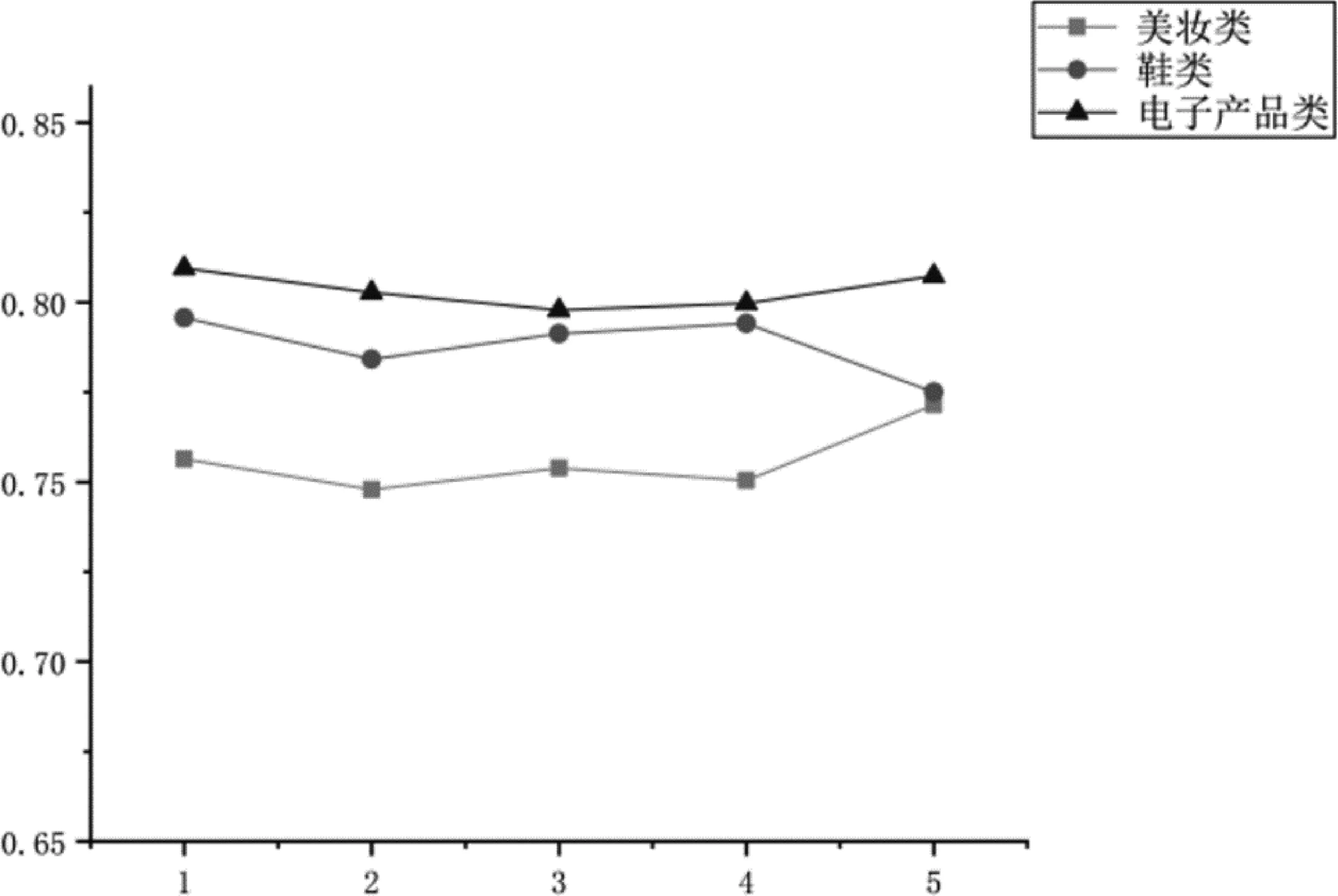

图卷积操作的层数关系到模型对于依存语法树中的关联信息的提炼和整合,为了探究在无向图中是否经历多阶的信息流通,保证在其他参数相同的情况下取不同图卷积操作层数进行了实验。实验结果如折线如图4所示,图中横坐标为卷积层数,纵坐标显示的是Macro-F1的变化情况。当图卷积操作有5层时,训练速度较快,同时较快得到最优效果模型。从图中可以看出,在电子产品类领域中,当层数从2层增加到3层或是4层时,最优模型整体出现了下降的趋势,但是当层数达到5层时又呈上涨趋势;鞋类与电子产品类情况恰恰相反;美妆类呈上升—下降—上升趋势。

图4 不同卷积层数下的Macro-F1值

随着模型层数的减少,最优效果模型的训练时间相差不多,最优效果模型的准确率也会根据不同数据集而变化。总体来说,最优模型结果相差不大,在一个较小的范围内波动,增加层数时准确率有可能上升或下降,故本研究选取2层为最终模型的图卷积层数。

除此之外,还对模型内部隐藏层维度对实验的影响进行了探究,结果如图5所示,其中横坐标为隐藏层层数,左侧纵坐标为Macro-F1的变化情况,右侧纵坐标为准确率的变化情况。从数据可以看出,对于美妆类数据来说,维度取100时准确率和Macro-F1效果最佳。隐藏层的维度在一定程度上会影响模型的效果,其效果会根据不同的数据而变化。

图5 不同隐藏层下的变化情况

4.4 消融实验

我们进行了消融实验, 以验证模型细节的有效性,分别对除去图卷积模块的部分模型ERNIE,除去自然知识和平均池化权重模块之外的部分模型QAGCN(-ap),以及基础模块Bi-GRU进行了实验对比。由实验数据可以看出,引入图卷积模块比单独的ERNIE模型效果更好,并且,意外地发现平均池化权重层在图卷积模块中至关重要,除去这一部分后模型的效果甚至与BiGRU差不多。除此之外,将预训练模型与下游任务结合的常用方式是将两者上下联通,实现端到端的训练,同时更新预训练模型的模型参数,但本任务中,在与ERNIE模型进行结合时发现,直接在ERNIE模型的基础之上应用图卷积神经网络需要耗费更多的时间和空间去训练,而将ERNIE模型与GCN进行前期并行计算,可以大大地缩短训练的时间和节省训练数据所需要的硬件空间。模型本身在整合自然知识和自然语言后拥有的强大的语言表达能力,使得本任务具备提升潜能,同时训练速度也很快。因此,在本实验中进行了消融实验以验证GCN在本任务中的效果,在与单纯ERNIE模型进行对比时发现,引入图卷积神经网络模块对于整体的训练是更加有益的,结果如表2中实验结果所示,说明利用图卷积神经网络对于依存语法树中连通信息的学习是有效的,利用在图上进行卷积操作的方法是可行的,并且能够帮助在问答式情感分析任务中更好地理解问答文本对的内涵。实验数据验证了在ERNIE模型的基础之上增加图卷积神经网络部分是有效的。

表2 消融实验结果

5 结论

本文详细介绍了基于中文依存语法树的图卷积神经网络对文本进行编码建模的方法,搭建了知识-图卷积双重网络E-QAGCN模型。E-QAGCN模型中图卷积神经网络结合依存语法树得到语法语义表示;同时借助知识背景模型的微调得到知识语义表示,将知识信息和语义信息引导得到的语义表示进行结合。在三个领域的中文问答式情感分析数据集上的实验结果验证,图卷积神经网络和先验自然知识引入在问答式情感分析研究中具备有效性,并通过将基于图神经网络的情感分析的最新模型应用到本任务中进行比较,验证本文的实验模型达到了同期任务的最优效果。