基于Rcnn+Char_SegNet的藏文乌梅长文本识别

才让当知,黄鹤鸣,李鑫元,张会云

(1. 青海师范大学 计算机学院,青海 西宁 810008;2. 青海师范大学 省部共建藏语智能信息处理及应用国家重点实验室,青海 西宁 810008;3. 青海师范大学 藏文信息处理教育部重点实验室,青海 西宁 810008)

0 引言

藏文化是中华民族文化的重要组成部分,信息化手段能有效地保护藏文化。藏文文字识别是藏文信息化的重要研究内容,该文字识别技术在即时翻译、古籍文献保护以及办公自动化等领域都得以广泛应用。

藏文书写经过千余年的发展,主要分为乌金和乌梅两种字体[1]。这两种字体在书写风格上分别类似于汉字中的正楷与草书。乌金和乌梅这两大类字体可以再细分为八大类乌金体和六大类乌梅体。乌金体的使用范围比乌梅体更加广泛,但一些行书、公告和佛经仍有存在乌梅体书写的情况。为了完善藏文文字系统的研究,本文将乌梅朱匝体作为主要识别对象。

传统的印刷体藏文识别包括文本矫正、分割、规范化以及识别等流程[2]。但在乌梅朱匝体字体中,元音符号和下加字母的宽度比基字大,导致元音字母和下加字母经常会前后字符笔画粘连、交错现象严重,无法正确分割[3]。针对这种情况,本研究提出了基于Rcnn+Char_SegNet的乌梅朱匝体长文本印刷体识别方法。该方法将朱匝体长文本图像视为图像序列识别问题,并在CRNN框架[4]的基础上分别引入循环连接技术和字丁切分模块,增强了特征提取和标签对齐能力。

同时,Rcnn+Char_SegNet方法对朱匝体文本图像不再进行分割,直接对长文本图像进行识别,丢弃了粘连字符分割的环节,简化了印刷体藏文识别流程,提高了乌梅朱匝体印刷体识别效率。

1 相关工作

乌金和乌梅是藏文书写中两种常用字体,因此,藏文印刷体识别主要分为乌金和乌梅印刷体识别。

1.1 藏文乌金印刷体识别

相较于藏文乌梅体,乌金体更容易被分割和识别,只需采用传统的识别方法就能达到较实用的识别效果,实际样本的识别率能达到99.15%[5]。

在传统的藏文乌金印刷体识别过程中,首先采用图像矫正算法对倾斜的文本图像进行矫正;其次,通过投影法[6]、连通域法和滴水算法[7]等方法对文本图像进行分割;接着,对分割后的藏文字丁或者音节进行规范化,统一所有文本图像的宽高;最后,通过设计不同的分类器对规范后的文本图像进行识别[8]。

目前,藏文乌金体识别运用的主流方法是深度学习。在文献[9-10]中采用CRNN的网络框架对自然场景下的藏文进行了识别,文献[9]中单字识别率达到了83.63%,而文献[10]中运用F1值评价指标,其识别率为67%。虽然二者均采用了端到端的识别方法,但自然场景下的字体多样性、背景复杂性以及形状多样性使得识别难度增加,因此仍有提升的空间。

1.2 藏文乌梅印刷体识别

藏文乌梅朱匝体字体中,字与字之间粘连和交错严重,无法正确分割识别字符图像。因此文献[11]中采用Gabor滤波器对藏文字符进行特征提取,最后通过ART2神经网络对30个手写乌梅辅音字母进行分类,正确率在89%~98%之间。但此研究工作只限于特定人手写的单个藏文乌梅字母识别,并没有扩展到对乌梅体长文本的识别。

2 乌梅长文本印刷体识别框架

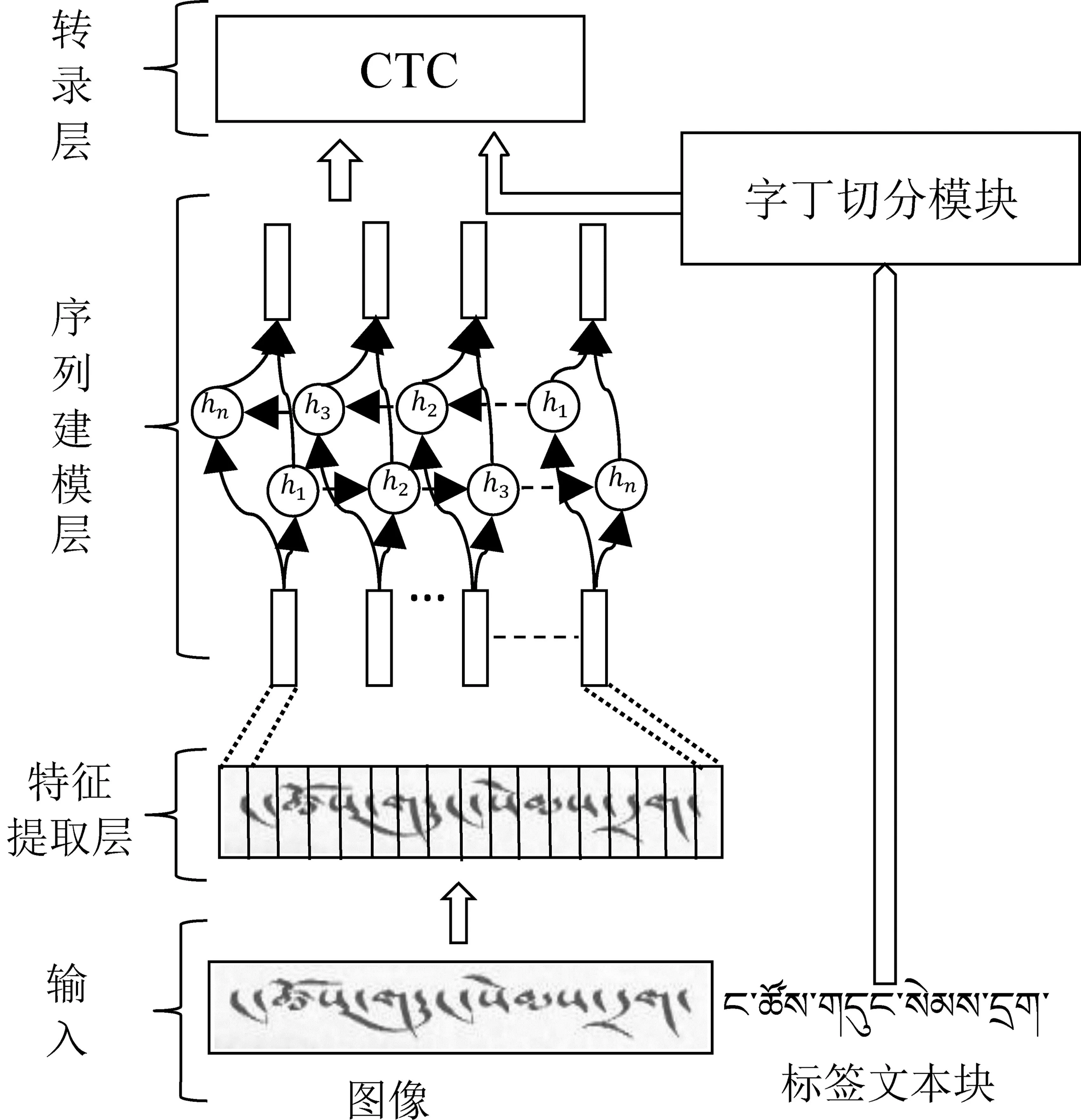

针对藏文乌梅朱匝体的书写特点,本研究提出了Rcnn+Char_SegNet的乌梅长文本印刷体识别方法。如图1所示,该方法主要分为四个阶段: 特征提取层、序列建模层、字丁切分(Character Segmentation, Char_seg)模块和转录层。

图1 基于Rcnn+Char_SegNet的藏文乌梅长文本识别框架

最后,将Softmax层的分类结果和字丁级标签共同输入CTC解码器。CTC解码器将字丁切分模块输出的字丁级标签作为参考值,对Softmax层分类的结果进行编辑,并输出CTC编辑完成后的识别结果。

2.1 特征提取层

在CRNN框架中,底层的特征提取网络为标准的CNN网络。而在乌梅朱匝体长文本印刷体识别框架中特征提取主要由循环卷积网络(Rcnn)完成,如图2(a)所示。在循环卷积层中以T为时间步长展开循环连接单元,可以得到深度为T+1的前馈子网络,如图2(b)所示。循环连接单元可以通过调节其相邻的单元,增强模型提取上下文信息的能力[12]。

图2 Rcnn网络

循环连接单元随着时间而变化,对于循环卷积层中第k个特征图上位于(i,j)的单元而言,在时间t时刻循环连接单元zijk的输入如式(1)所示。

(1)

式(1)描述了循环卷积层的动态特性。其中的第一项用于CNN,第二项则用于循环连接。前馈和循环连接都具有局部连接性,均可在不同位置之间共享权重。

该循环连接单元的激活函数为线性整流函数(ReLU),如式(2)所示。

R(zijk(t))=max(zijk(t),0)

(2)

完成该循环连接单元状态的激活后,采用局部响应归一化函数(LRN)对特征进行归一化操作,如式(3)所示。

(3)

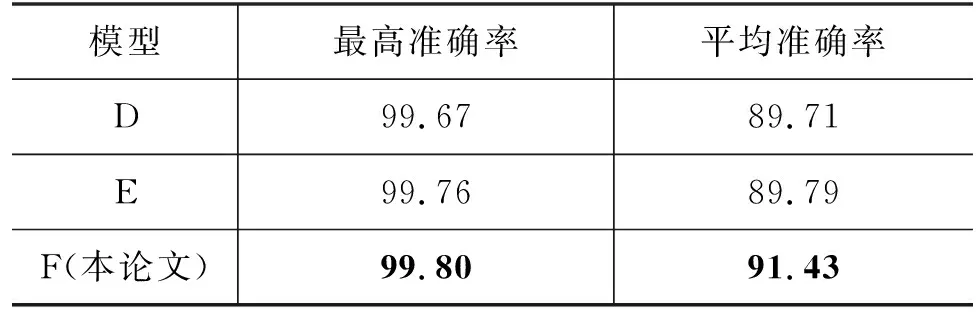

其中,i,j表示像素的位置,k为当前图层中特征映射的总数,N是位于(i,j)位置的特征图数,通常N 相较于CNN,Rcnn具有以下两个优点: (1)Rcnn可以使每个单元在当前层中任意大的区域里合并上下文信息,并且随着时间步长的增加,每个单元的状态会受到其他单元的影响;(2)虽然循环连接增加了网络深度,但由于其和CNN有相同的权值共享能力,因此参数和网络复杂度基本不变。 循环连接层的卷积层、最大池化层和激活函数层作用于局部区域,具有平移不变性。因此,Rcnn提取的特征序列x=[x1,….,xT]与特征图上从左到右对应的顺序相同,如图3所示。 图3 特征提取 通过传统的字符分割算法很难提取藏文乌梅朱匝体图像中每个藏文字丁的特征。因此,首先需要对乌梅朱匝体长文本图片做“切片”处理;其次,拼接每个“切片”后的片段作为建模网络的输入特征序列,从而将难以分割的朱匝体文字图像作为一个预测时间序列问题处理。 在这些特征序列中,每个向量都与输入图像上的一个接受域相关联,因此,可以将这些向量看作是该字段的特征向量。 作为基于Rcnn+Char_ SegNet的藏文乌梅朱匝体长文本印刷体识别框架的序列建模层,BiLSTM对每个特征序列x预测标签y,其中x是Rcnn提取的特征序列。BiLSTM由两个双向的LSTM组成。LSTM是一种为解决RNN中存在的梯度消失和限制存储上下文范围等问题而设计的网络。一个LSTM内部单元,由一个存储单元和三个门组成,即输入、输出和遗忘门,如图4所示。 图4 LSTM内部单元 首先,通过遗忘门决定对输入中要丢弃的信息ft,即: ft=σ(Wf·[ht-1,xt]+bf) (4) 其中,σ为Sigmoid函数,其输出值为0或1。当值为0时表示丢弃,值为1时表示通过。ft通过和上一时刻存储单元的状态ct-1点乘选择信息通过的量。 最后,输出LSTM内部单元的状态ht。它是由输出门ot和当前存储单元的状态ct决定,即: LSTM无法编码序列从后到前的信息,为了更好地描述特征序列X从前到后或者从后到前排列的局部图像区域特征,采用BiLSTM网络双向分析特征序列,捕获两个方向的长期依赖关系[13],如图5所示。 图5 BiLSTM BiLSTM通过双向编码输出隐向量Z=z1,…,zn。其中,对特征序列x分别进行前向和后向计算得到hF和hB。每个向量z都是由前向计算结果hF和反向计算结果hB两个向量拼接得到的。BiLSTM具有很强的捕获序列双向上下文信息和处理任意长度序列的能力[14],适合对乌梅朱匝体长文本印刷体进行特征序列编码。 字丁切分模块是将藏文文本块标签按字丁切分的过程。在基于CRNN的汉文或英文识别中,其长文本标签能自动按字或字母切分,而对藏文长文本却无法自动切分,其结果不符合图像特征从左到右依次采样的顺序。 因此本研究以字丁为单位对藏文乌梅朱匝体长文本图像进行标注,这相当于英文中字母级单位的标注方式,有利于图像和标签对齐。藏文文本按字丁切分有助于控制Rcnn训练的字数长度,避免处理过长的序列,如图6所示。在藏文乌梅朱匝体长文本识别中,这种字丁级标注方式更适用于网络对图像特征从左到右的提取过程。 图6 字丁标签序列 藏文构建字符的Unicode编码区间为0F71~0F88和0F8D 0FBC。为了不破坏多层字丁叠加结构,同时实现按列字丁切分,本研究设计了一种简单高效的藏文字丁切分算法,如图7所示。 图7 字丁切分模块 转录层是CTC模型把序列建模层BiLSTM对每帧的预测序列y=[y1,…,yn]转换为标签序列L=(l1,l2,…,ln)的过程,如图8所示。 图8 CTC解码 L=B(argmaxP(π|Y)) (9) (10) 本节通过实验来验证基于Rcnn+Char_SegNet的乌梅朱匝体长文本印刷体识别方法的有效性,将Rcnn和字丁切分模块(Char_Seg)嵌入到最先进的识别网络框架CRNN中进行性能比较。 目前,没有公开的印刷体藏文乌梅朱匝体标注数据集,为了验证Rcnn+Char_SegNet的有效性,本研究自行构建了Cursive Script-C517数据集。首先,搜集包含藏文小说、医学、历史以及新闻等题材的文本语料;接着,对文本语料进行数据清洗,将文本按五个音节长度分块;最后,将5个音节文本块转为图像,长宽都统一为300×50 ,并建立文本标签。 Cursive Script-C517数据集包含40 000个训练图像和8 038个测试图像,部分数据示例见图9。 图9 Cursive Script-C517中部分样本 在中英文长文本识别中,文字长度为10或11时效果最好[17]。按纵向字丁切分的长度来计算,五个藏文音节的长度相当于10或11个汉字或英文的长度,所以本研究选取了5个藏文音节。 本研究的评价指标为最高准确率(MAX)和平均准确率(AVG)。MAX和AVG计算方式见式(11)、式(12)所示。Rcnn+Char_SegNet模型总共迭代10 000次,每10次迭代输出一个结果,用A=[a1,a2,…,aN]表示输出的准确率。 其中,N是迭代的总次数,an表示第n次的准确率。 Rcnn+Char_SegNet模型的主要参数详见表1。 表1 模型参数 目前还未发现藏文乌梅朱匝体长文本识别的相关文献,因此没有可对比的实验。本论文中所有的实验数据是用不同的识别框架在Cursive Script-C517数据集上得到的。 为了后续表述方便,每个模型框架将以不同的大写字母表示,各个字母对应的模型如表2所示。 表2 模型查询表 为了验证Rcnn的特征提取能力,本研究将Rcnn与基于注意力机制的识别框架相结合得到模型C。该模型与主流的识别框架A和B在Cursive Script-C517测试数据集上的性能对比见图10。 图10 基于Attention解码的测试正确率趋势 可以看出: 与Vgg16和ResNet19为特征提取的主干网络相比,Rcnn的网络收敛和学习速度更快,并且网络更加稳定。 三个模型的最高准确率和平均准确率对比见表3。 表3 基于Attention的解码测试结果 (单位: %) 由表3可知模型C的最高准确率达到了99.57%,但平均准确率只有72.37%,其原因是藏文按字符切分的文本长度远大于最佳识别长度。有关研究表明中英文的文本长度为10或11时识别效果最好。而Cursive Script-C517数据集中藏文乌梅朱匝体长文本的音节长度为5,一个藏文音节一般由1~7个字符组成,其平均字符长度在30左右。因此,由于藏文文本按默认字符切分的长度远大于中英文,所以基于Attention的方法对过长文本的识别效果并不理想。 除了基于Attention的解码模型,基于CTC的解码模型也很常见。将顶层的Attention替换为CTC进行训练,测试结果见图11。可以看出: 同模型框架D和E相比,解码模型为CTC时,底层特征提取网络为Rcnn时,整个网络框架的训练更稳定。 解码方式为CTC时,用于特征提取的Rcnn网络同样发挥了较强的特征提取能力,最高准确率和平均准确率分别提高了0.13和1.72个百分点,见表4。 表4 基于CTC的解码测试结果 (单位: %) 相比基于Attention的解码模型,基于CTC模型的解码能力更强,最高准确率提高了0.23个百分点,平均准确率提高了19.06个百分点,见表5。 表5 Attention和CTC解码对比结果 (单位: %) 因为基于Attention的解码模型中没有标签与序列之间的对应关系,所以在没有大量训练数据的情况下,难以获取字符的序列关系。而在基于CTC的模型中,标签与特征序列之间能够严格对齐,更有利于区分每个文本图像的特征和长文本识别。 词典是一组标签序列,起约束预测的作用,例如,拼写检查[18]。在基于词典的模式中,是通过选择具有最高概率的标签序列来进行预测。在数据库Cursive Script-C517中,有藏文字丁和字符两种类别词典库,分别有469种字丁和71种字符。本实验主要分析两种不同的标注方式对识别的影响,见表6。 表6 词典库的比较 (单位: %) 从表6可以看出: (1)标注单位为字丁时,最高正确率达99.80%,比字符级词典高0.16个百分点,说明CTC对齐方式符合字丁从左到右在水平方向上的排列;(2)标注单位为字符时,平均识别率低于字符级0.45个百分点。 图12 词典库对识别的影响 同时,字符的个数少于字丁的个数,字符标注方式降低了模型的计算复杂度,使模型的训练时间减少了13.63%,如图13所示。 图13 词典库对模型训练时间的影响 表7 识别错误结果分析 为了提高乌梅朱匝体长文本识别率,本研究提出了一种新的神经网络框架Rcnn+Char_SegNet。该方法在Cursive Script-C517数据集上得到了比基线更好的结果,这说明本模型可以提高字符图像提取特征的能力,在字符粘连片段上能提取更长期的上下文依赖信息,所以具有更好的预测能力。 在未来的工作中,计划研究模型中间建模层对印刷体乌梅的影响,从而进一步改进其性能。另外,Cursive Script-C517需要扩充字符类别,增加更具多样性的样本,以便更好地验证模型的泛化能力。

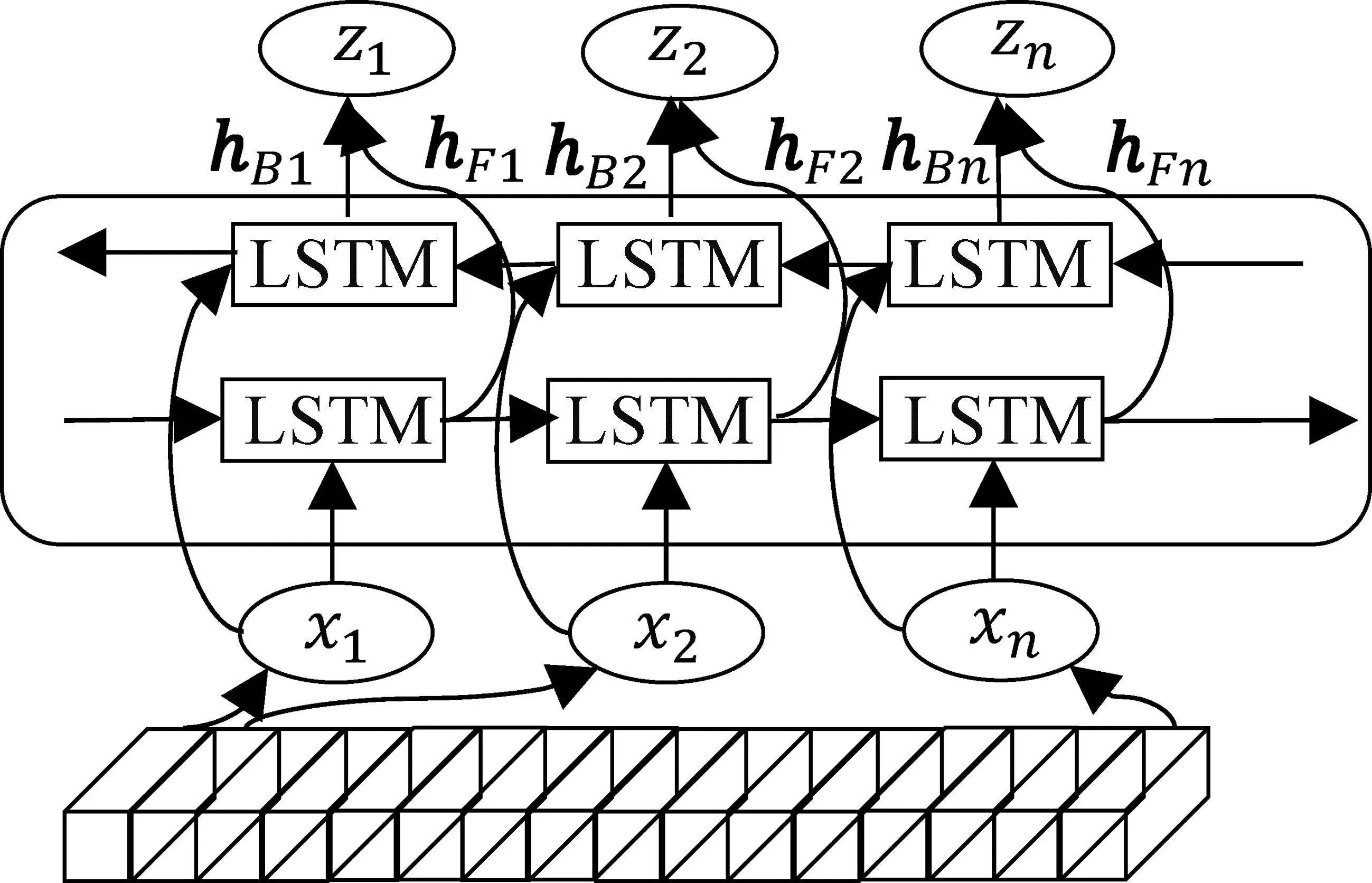

2.2 序列建模层

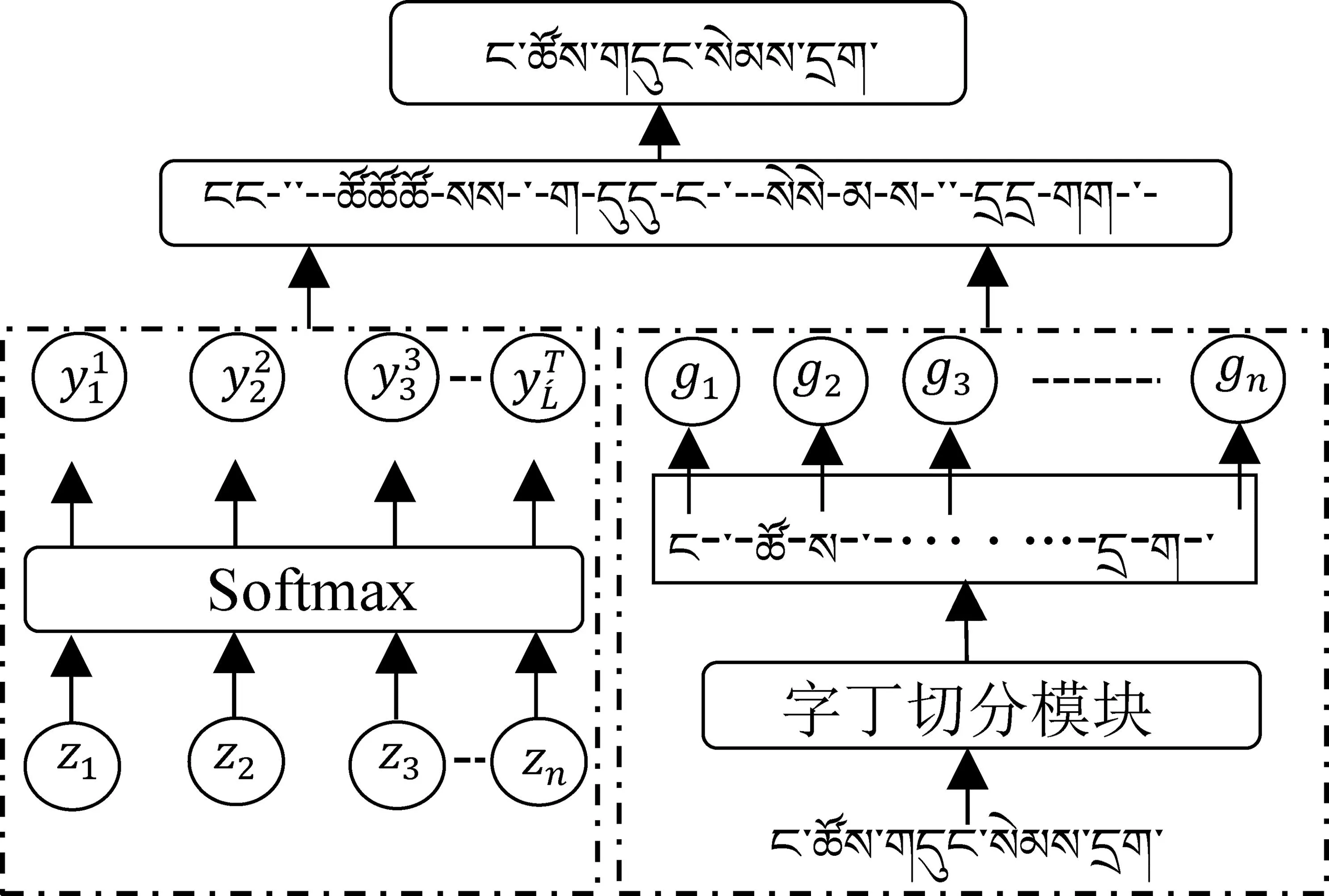

2.3 字丁切分模块

2.4 转录层

3 实验与分析

3.1 乌梅标注数据集构建

3.2 实验细节说明

3.3 对比实验

3.4 转录方式对识别的影响

3.5 不同词典库对识别的影响

3.6 错误分析

4 总结与展望