结合特征学习与注意力机制的服装图像分割

顾梅花, 刘 杰, 李立瑶, 崔 琳

(西安工程大学 电子信息学院, 陕西 西安 710048)

电子商务飞速发展的时代,网店商家与买家群体越来越多,人们更倾向于在线上选购心仪服装。网购服装逐渐成为一种主流消费趋势,各大购物平台推出了“以图搜图”的服装检索功能[1-3],服装图像分割作为服装检索的前期工作,其分割精度在很大程度上影响着检索结果的准确性[4-6]。然而,实际应用中服装图像大多来源于网络、广告片段、影视截图、实景拍摄等,服装的款式与风格繁多,背景复杂,对服装图像分割的干扰较为明显,且因拍摄的距离、角度与着装人体姿态的不同,容易产生衣物小尺寸、皱褶以及遮挡等问题,会使得服装图像分割准确率较低,针对这些问题,国内外学者从不同角度展开了研究工作。

文献[7]采用形态学预处理方法结合Canny算子对服装图像进行轮廓提取,但由于服装本身内容细节复杂,提取的服装轮廓信息准确率较低。文献[8]提出一种Fashion-16模型,采用卷积神经网络提取服装特征,依据softmax函数处理划分服装类别,结合局部敏感哈希思想实现同类别检索,提取目标服装的区域特征与类别属性;文献[9]提出了一种融合自适应局部特征与改进模糊C均值(FCM)的服装图像分割算法,通过减少内部区域噪声提高了服装图像的分割精度,但这2种方法只考虑了简单背景下的服装图像分割,无法保证复杂背景下的服装图像分割效果。文献[10]提出一种基于先验知识融合颜色和纹理特征的无监督分割算法,对服装图像进行分块处理,提升图像分割的准确性,但该方法未解决遮挡对图像分割造成的影响问题。文献[11]提出一种结合标签优化和语义分割的服装图像检索方法,通过构建视觉风格分析概率模型进行标签优化,提升了对少数民族服装图像分割性能,但并不适合于一般服装目标的分割。文献[12]提出一种基于超像素融合和姿态估计相结合的服装图像分割方法,采用一种层次超像素融合策略,提升了服装的分割性能,但未考虑服装发生形变对分割准确度的影响。

为解决上述问题,文献[13]采用Mask R-CNN[14]模型训练DeepFashion2数据集,经ResNet网络获取图像中的服装信息,结合区域建议网络(RPN)与感兴趣区域对齐(RoIAlign)处理将特征输入不同的预测分支,可实现不同场景下服装图像的检测、分割与检索,但未对小尺寸服装与遮挡服装的分割问题给出解决方案。本文在文献[13]的研究基础上,通过对Mask R-CNN模型的网络结构进行优化,改善复杂背景下小尺寸服装与遮挡服装图像分割准确率低的问题。首先采用增强特征金字塔网络优化Mask R-CNN模型对图像中多尺度服装特征的学习能力,提升对小尺寸服装的分割准确度;其次在类别分支、边界框回归分支与掩膜预测分支分别引入通道注意力模块以及空间注意力模块,结合图像的上下文特征与空间信息,强化各分支对图像中服装区域特征的关注度,提升遮挡服装的分割准确度。

1 方法概述

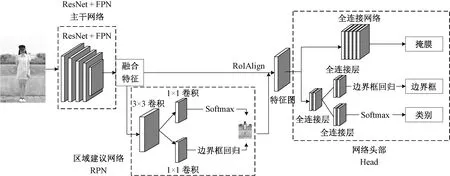

Mask R-CNN[14]通过在Faster R-CNN模型[15]的网络头部添加一个用于预测目标掩膜(Mask)的分支,与边界框回归和类别预测并行处理,完成对图像中目标区域的实例分割任务。Mask R-CNN模型主要包括ResNet+FPN主干网络、RPN、RoIAlign处理、网络头部(Head)共4个部分,将其应用于服装图像分割任务中,整体网络结构如图1所示。

图1 Mask R-CNN服装图像分割模型结构示意图Fig.1 Model structure image of Mask R-CNN garment segmentation

由图1可知,Mask R-CNN将特征金字塔网络FPN[16]与ResNet50结合,主干网络提取输入服装图像特征,融合多层特征信息后,经RPN获得感兴趣的区域,通过RoIAlign处理将所有感兴趣区域(RoI)都池化成相同大小的特征图,最后进行分类、回归和掩膜预测,实现对服装图像的实例分割,图2示出Mask R-CNN模型对服装图像的分割效果。

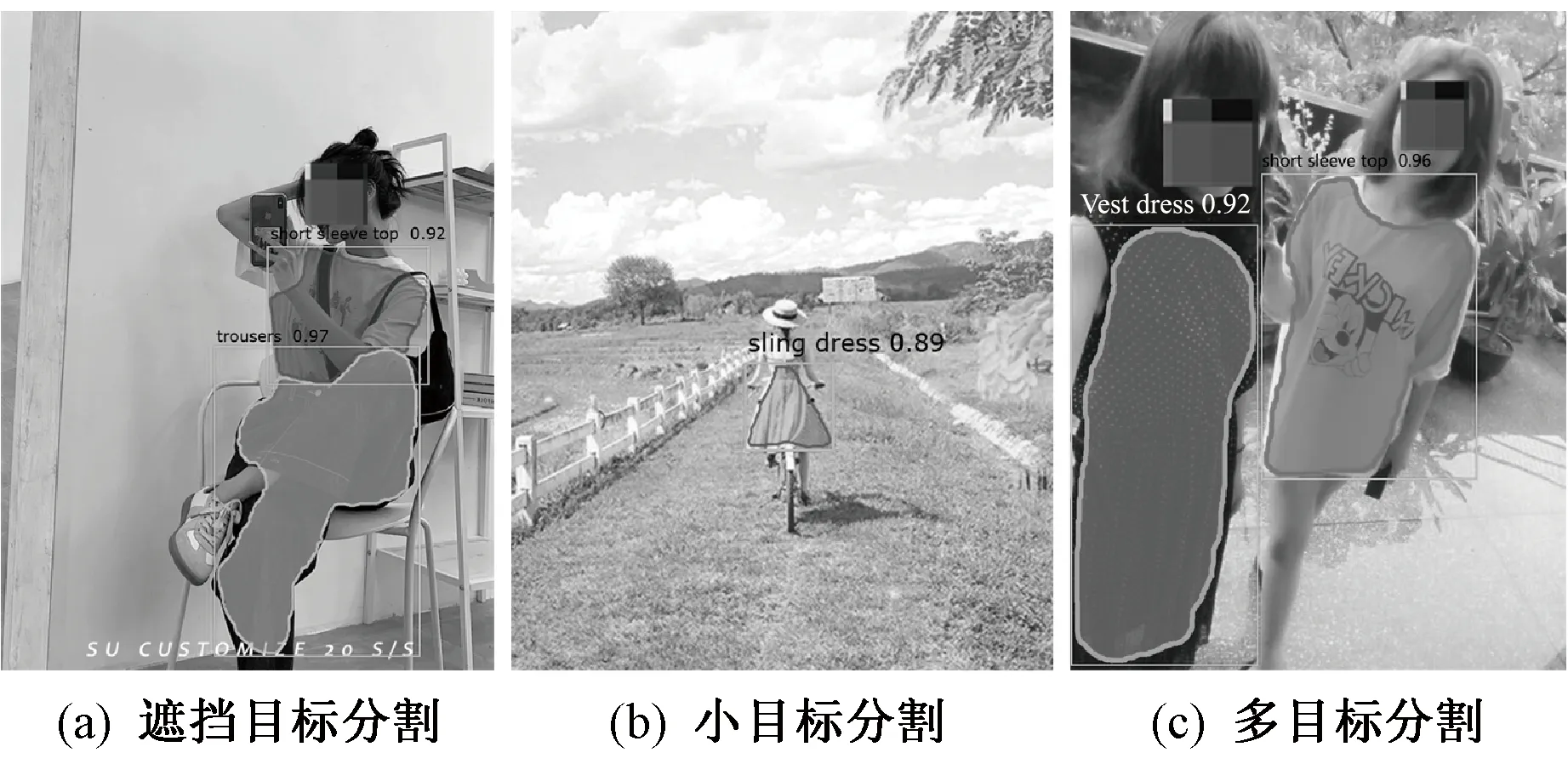

从图2可看出,Mask R-CNN能够检测出不同场景下的服装图像,并生成对应掩膜覆盖服装区域,提取出图像中感兴趣的服装目标,但仍然存在以下问题:1)图2(a)中短袖的右上部受非目标物遮挡无法有效分割,且长裤区域对应掩膜的边缘拟合性不是很好;2)图2(b)中吊带连衣裙的框选未能将连衣裙整体纳入预测区域,丢失部分服装信息;3)图2(c)中左侧背心裙因拍摄角度造成服装区域的不规则形变,影响模型的分割效果。

图2 Mask R-CNN服装图像分割效果Fig.2 Clothing image segmentation of Mask R-CNN. (a) Occlusion target segmentation;(b) Small target segmentation;(c) Multi-objective segmentation

通过分析,Mask R-CNN在特征学习过程中存在3个缺陷:1)融合过程未考虑多层特征之间的语义差异,导致服装特征表达能力较低;2)顶层高级特征降维后造成服装特征信息的丢失;3)根据目标大小启发式选择不同层级生成对应的RoI特征,忽略了不同层级特征对于同一RoI的描述。另外,Mask R-CNN直接通过全连接层将输入的特征信息用于目标预测任务,忽略了服装图像的空间相关性,在多目标检测与分割任务中,对存在相互遮挡的目标处理效果略有欠缺。

针对上述问题,本文提出一种结合改进多尺度特征学习策略与双重注意力机制的服装图像分割方法,提取丰富的多尺度服装特征信息,并加强对重要服装区域的关注度,可明显改善小尺寸与遮挡对服装图像分割精度的影响,且能较为准确地提取图像中的服装区域。

2 改进多尺度特征学习策略

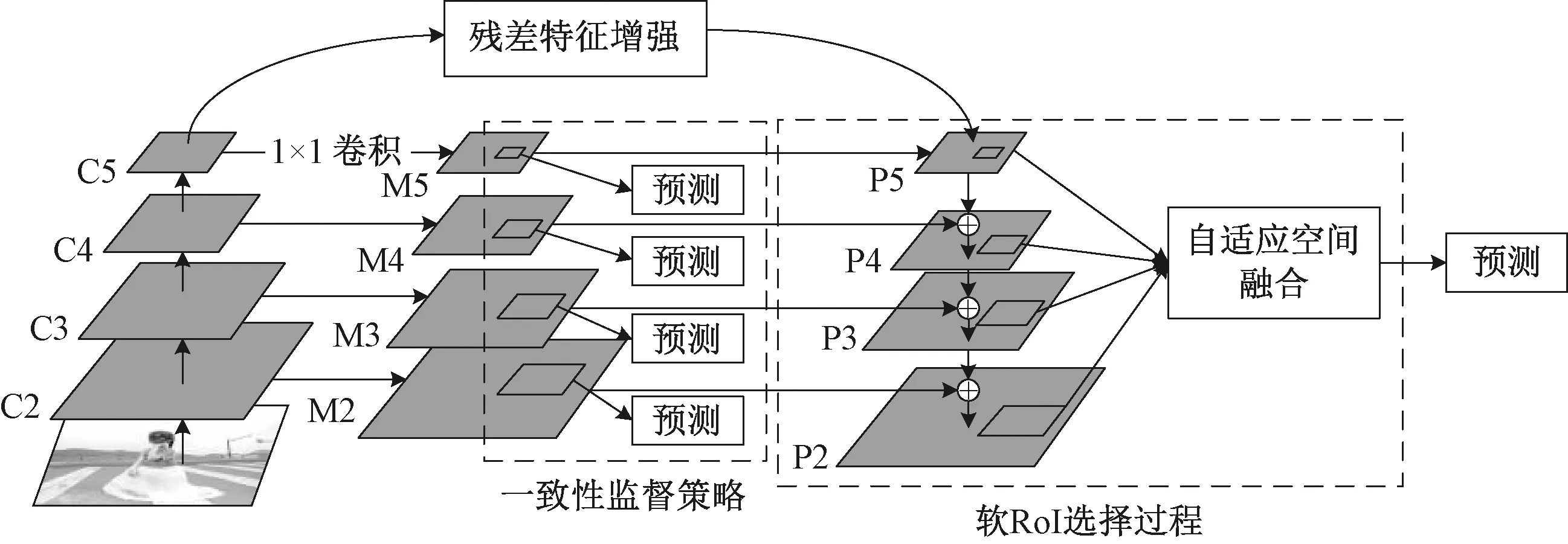

本文采用增强特征金字塔网络(AugFPN)[17]优化Mask R-CNN模型对服装图像多尺度特征的学习能力,通过一致监督策略缩小特征融合前不同尺度服装特征的语义差距;在融合过程中通过增强残差特征,提取比例不变的上下文信息,减少最高层级服装特征在映射过程中出现的信息缺失;最后采用软RoI选择,使模型在特征融合后能够自适应地获取更优的RoI特征,通过自适应空间融合改善服装目标区域边界特征的拟合问题,优化模型对不同尺寸服装图像的识别与分割效果。AugFPN模块的整体网络结构如图3所示。

图3 AguFPN模块网络结构Fig.3 Module network structure of AugFPN

特征融合前,AugFPN通过对多尺度服装特征执行同一规则进行监督,缩小不同层级间语义特征的差异。{C2,C3,C4,C5}表示用于构建特征金字塔的特征,首先,输入服装图像经主干网络处理,生成多尺度特征{M2,M3,M4,M5};然后在特征金字塔{P2,P3,P4,P5}上使用RPN生成RoIs,并采用RoIAlign方法获取各RoI在不同层级上的特征映射;再对特征结果进行分类、回归和掩膜预测处理,获取对应的辅助损失;最后通过共享不同层级的预测参数,促使特征映射过程在相同监督下学习相似的语义信息。损失函数计算公式如下:

式中:LRCNN为Mask R-CNN的损失,Lcls,M、Lbox,M与Lmask,M分别为特征图{M2,M3,M4,M5}经分类、回归与掩膜预测处理的辅助损失;Lcls,P、Lbox,P与Lmask,P为对应于金字塔特征层{P2,P3,P4,P5}的辅助损失;pM、dM和qM分别表示特征图上的预测结果;pP、dP和qP为对应于金字塔特征的预测结果;t*、b*和e*分别表示目标分类、边界框回归和掩膜的真实标注;引入的λ用于平衡辅助损失与原始损失之间的权重,β和γ分别用于平衡边界框回归、掩膜预测与分类之间的权重;其中,对[t*>0]的定义如下:

辅助分支仅存在于模型的测试阶段,预测过程仅采用特征金字塔上的分支进行预测,这种训练方式可避免额外参数的引入,使计算量的增加仅存在于推理阶段。

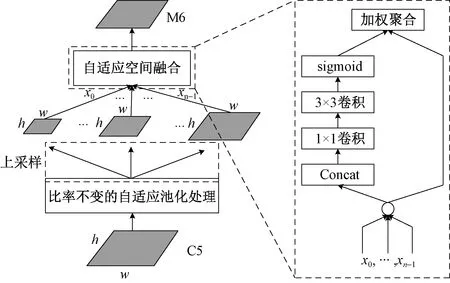

对于原FPN存在的因高层特征降维造成信息丢失的问题,AugFPN引入残差特征增强(RFE)模块,结合服装图像的空间上下文信息优化最高层级的特征表示,从而减少特征融合过程中对高层特征的信息损失,残差特征增强原理如图4所示。

图4 残差特征增强原理Fig.4 Principle of residual feature enhancement

图4中,RFE模块直接采用C5层作为输入,避免了因特征降维造成的信息损失,C5的尺度为S=h×w,首先对输入的C5层特征进行比率不变的自适应池化处理,生成不同规模的上下文特征图{a0S,a1S,…,an-1S};然后采用1×1卷积保持通道数为256,再经过上采样处理恢复至原尺寸;最后融合上下文特征生成新的特征层M6,其中自适应空间融合模块对每个特征生成对应的空间权重,依据模型在训练过程中学习到的权重信息相加;将M6与M5求和更新M5;最后将更新后的M5继续与其他低层信息融合,构建新的特征金字塔。

原FPN中RoI对应的特征根据RoI的尺度选择对应提取的层,小尺寸服装目标对应在低层级特征图上获取特征,而大尺寸服装目标在高层级特征图上获取特征,这种单一的映射关系会导致2个尺寸非常接近的服装目标被映射到不同的特征层级上。AugFPN采用软RoI选择在特征融合后自适应地学习更好的RoI特征,首先对建议对应的所有层级上的特征进行池化,然后对池化之后的特征进行自适应特征融合,即对于任意RoI,在不同层级上选择性捕获对应的RoI特征,通过训练调整空间权重,并依据权重信息融合同一RoI的多尺度特征作为最优特征。该方法补偿了从单层金字塔中获取RoI特征产生的信息损失,改善了Mask R-CNN对不同尺寸服装图像分割的边缘拟合效果。

3 双重注意力机制

本文在Mask R-CNN的预测分支中引入注意力机制,增强各分支对图像中服装区域特征的关注度,其中,类别分支加入通道注意力模块,加强特征图之间的相关性,边界回归框与掩膜预测分支分别引入空间注意力机制,提升关键区域的特征表达能力,从而增强模型对服装区域的特征提取能力。

在Mask R-CNN模型的类别预测分支添加通道注意力模块[18],结合通道权重调整分支对服装目标的关注度,确定特征图上需要重点关注的内容,强化预测过程中对特征信息的理解能力,以及模型对服装目标的关注度,从而提高模型对不同服装类别的辨识能力。改进后的类别预测分支流程如图5所示,首先将输入特征X通过通道注意力模块加强服装目标的关注度;然后将得到的输出特征与输入特征X进行结合,融合为表征服装图像的特征;最后通过全连接层与softmax函数对服装类别进行预测。

图5 结合通道注意力的类别预测分支流程图Fig.5 Flow chart of category prediction branch combined with channel attention

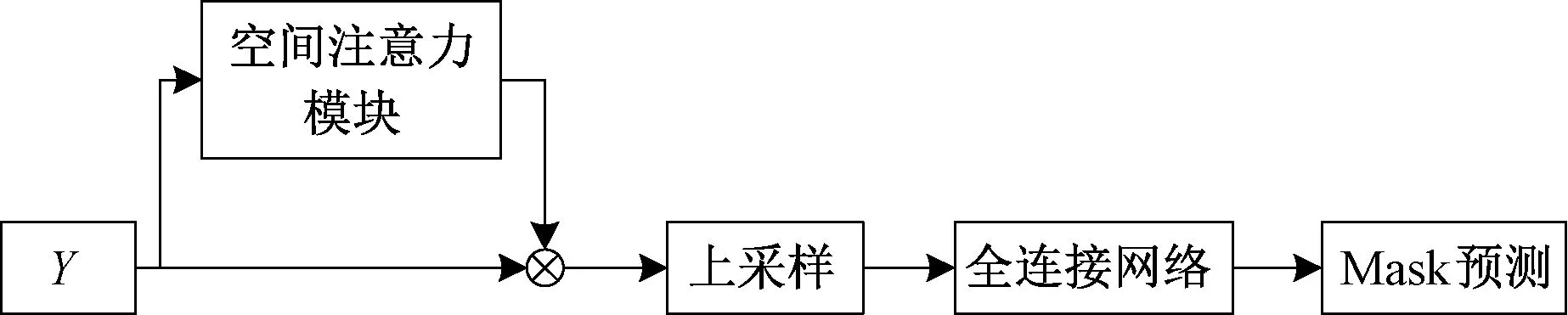

在Mask R-CNN模型的边界框回归与掩膜预测分支分别引入空间注意力模块[19],依据服装目标的存在感知度生成与特征层同等大小的掩膜信息,其中每个元素分别对应于原特征中各个像素上的权重,通过不断学习调整模型对服装目标区域的关注度,确定需要重点关注的位置,强化模型分支的特征理解能力,改善因服装间的遮挡问题所产生的目标区域不规则形变对服装检测与分割精度造成的影响。处理流程分别如图6、7所示。

图6首先将输入的特征X通过空间注意力模块强化特征信息,然后将得到的输出特征与输入特征X进行相乘获得表征服装边界框的最终特征,最后经过全连接层将特征映射到样本标记空间,通过边界框的回归对边界框进行预测。图7将所获得的特征向量Y首先通过空间注意力模块使得低分辨率的服装图像输入特征转换为高分辨率的特征对,然后经过上采样输入到全连接网络中,最后对服装图像的掩模进行预测。

图6 结合空间注意力的边界框回归分支流程图Fig.6 Flow chart of bounding box regression branch combined with spatial attention

图7 结合空间注意力的掩膜预测分支流程图Fig.7 Flow chart of mask prediction branch combined with spatial attention

4 实验与分析

4.1 实验条件

4.1.1 数据集

本文选用DeepFashion2[13]数据集,其中包含49.1万张图片与80.1万个服装实例,划分为13种服装类型,样本分布情况如表1所示。DeepFashion2通过改变服装图像的尺寸、遮挡、缩放和视角变量,丰富数据集中服装图像标注信息,可支持服装识别、分割与检索、关键点标记、姿态估计等任务。

表1 DeepFashion2数据集样本分布情况Tab.1 The sample distribution of DeepFashion2 dataset

4.1.2 实验环境与设置

实验在Intel(R) Core(TM) CPU 2.90GHz、Nvidia GeForece RTX 2070 Super显卡,RAM为16 G的硬件环境下进行,编译环境为Python3.7,实验工具为Microsoft Visual Studio 2018。选用Pytorch框架搭建Mask R-CNN模型,训练过程采用迁移学习的方法,将Mask R-CNN在COCO数据集下得到的权重应用于服装图像分割的初始训练。以8:2的比例从DeepFashion2数据集中选取训练集与测试集,训练集包含39.2万张图片,测试集包含9.8万张图片。

针对训练过程中存在数据格式不匹配的问题,即DeepFashion2数据集的json文件不能直接用于Mask R-CNN模型,通过数据类型转换的方法将json文件转换为COCO格式。设置初始学习率为0.000 01,每经过2 000次迭代附加0.1倍,继续学习调整权重参数,获取适用于提取图像中服装区域的分割模型。

4.2 结果分析

为了验证本文算法在服装图像分割任务中的有效性,采用Mask R-CNN[13]、FCIS[20]作为对比算法,从定性、定量2个方面对所提算法进行评估。

(二)现实中出现的一系列问题也使得全额拨款事业单位进行资产管理成为一项必然的活动。中国地缘辽阔,政府机构庞杂,事业单位在数量上较之别的国家要多很多。如果不能从资金的角度对事业单位活动进行提前管理,出现问题以后再追责,那么就已经造成了对社会的伤害。而且随着改革的深入,资产管理过程中出现了一系列的问题,包括:资金使用不规范,资金去向不明,国有资产大量流失,这些问题迫使加强全额拨款事业单位的资产管理成为一项必然的活动。

4.2.1 定性分析

图8示出各种分割算法对小尺寸、多目标、仰角服装图像的实例分割效果比较以及本文算法对应的服装区域提取结果。其中,Mask R-CNN+表示在Mask R-CNN中采用AugFPN优化后的模型,本文算法表示在Mask R-CNN+中引入注意力机制后的模型。

由图8可知,4种模型均能提取出图像中的服装目标区域。如图8小尺寸图像所示,FCIS算法仅保留了图中吊带裙的中心区域;Mask R-CNN的分割效果优于FCIS,但丢失了吊带部分,易产生类别混淆问题;与之相比,Mask R-CNN+检测到更多吊带裙的上半身区域,整体效果略优于原Mask R-CNN,同样未包含吊带部分;本文算法引入注意力机制优化Mask R-CNN+,保留了吊带裙的上半身特征,包含吊带部分,在小尺寸服装图像分割任务中能获得较为丰富的服装实例区域。

图8中多目标图像分割结果中,FCIS与Mask R-CNN都能检测到多个目标的存在,但对于左侧的背心连衣裙分割效果不佳,未能保留短袖上衣的左边袖口部分;Mask R-CNN+与本文算法弥补了上述缺陷,补偿了短袖皱褶袖口与领口部分的信息;本文算法在模特手臂的影响下依然能提取到较为完整的皱褶袖口区域,实现了多目标服装实例分割任务。

图8仰角图像展示了仰角服装图像的分割结果,FCIS算法对在图像中面积占比较大的服装区域保留较好,但短裤折边处未能得到有效检测;Mask R-CNN的分割效果略好于FCIS,且在短袖上衣领口与左肩处的分割效果较好,但受拍摄角度影响,右肩部分未能入镜,使得模型在处理过程中出现错误分割;Mask R-CNN+与本文算法在领口与右肩部分的上衣保留了较多的区域信息;此外,本文算法对短裤区域的处理效果较好,能够识别到短裤的折边区域,虽然在左侧腰部出现部分未能分割的服装区域,但根据图8中第5列对应的实例分割提取结果,能够直观判断服装类别。

图8 各算法对小尺寸、多目标以及仰角服装图像的分割效果比较Fig.8 Comparison of segmentation effect for clothing image with small size (a), multi-target (b) and elevation angle (c) using different algorithms

图9示出了不同算法对非目标遮挡、多目标间相互遮挡、多人互相遮挡情况下的服装图像分割效果比较以及本文算法对应的服装区域提取结果。

考虑到不同服装间存在的遮挡问题,观察图9的多目标间相互遮挡子图,可知Mask R-CNN对衣领与短裤的分割效果略优于FCIS,但两者均丢失了部分衣领区域;Mask R-CNN+与本文算法在分割结果中保留了服装的衣领部分,在上衣左上角受人体遮挡的区域,左侧衣袖的分割效果得到了明显改善;本文算法能够检测并分割出短裤的折边部分,对互相遮挡的服装图像有较好的分割效果。

图9多人相互遮挡情况图所示的多人服装图像分割结果中,FCIS算法与Mask R-CNN受图中左侧人物头发的影响,未能将左袖纳入预测的服装区域中,而Mask R-CNN+能够避免人物发型的干扰,提取到上衣左袖的部分区域,本文算法在Mask R-CNN+基础上引入注意力机制,进一步降低了遮挡问题对服装图像分割准确性的影响,提取到信息更加丰富的服装实例分割结果。

图9 各算法对遮挡服装图像的分割效果比较Fig.9 Comparison of segmentation effect for occlusion clothing image using different algorithms. (a) NON target occlusion; (b) Multi target occlusion; (c) People target occlusion

4.2.2 定量分析

为进一步评估本文算法的性能,采用掩膜交并比Iou、平均精度AP以及平均精度均值MAP3个常用的图像分割评价指标分析算法精度。

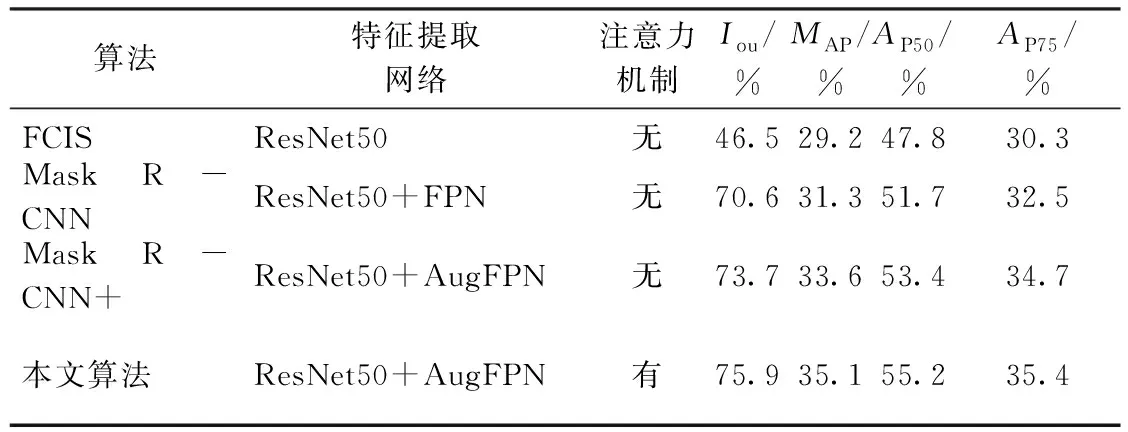

将本文算法的服装图像分割精度与Mask R-CNN[13]、FCIS[20],Mask R-CNN+进行对比,结果如表2所示。评价指标AP50和AP75分别表示Iou值取50%和75%所对应的AP值。

表2 各算法分割精度对比Tab.2 Comparison of each model segmentation precision

由表2可知,由于多尺度特征的引入,Mask R-CNN通过解耦实现对服装分类、边界框和Mask的同步预测,与经典分割模型FCIS相比优势较为明显;结合AugFPN强化模型对多尺度服装特征的学习能力后,Mask R-CNN+的各项指标均获得进一步提升,MAP提升了约2.3%;引入注意力机制后,本文算法在Iou等于50%与75%的情况下的AP值均明显优于原模型,平均精度MAP比Mask R-CNN+提高了1.5%,比Mask R-CNN提高了3.8%。

综上所述,本文算法能够有效实现多尺寸服装图像与遮挡服装图像的分割任务,改善了Mask R-CNN模型在小尺寸服装图像分割方面存在的漏检、漏分割现象;在遮挡情况下能够预测出丰富的特征信息,提取到效果较好的服装区域,有效提升了不同场景下服装图像分割的准确度。

5 结束语

本文提出了一种基于改进特征学习与注意力机制的服装图像分割方法。该方法采用增强特征金字塔网络优化Mask R-CNN模型对多尺度服装图像特征的学习能力,通过统一监督策略缩小特征融合前不同尺度特征之间的语义差距,在融合过程中通过增强残差特征,提取比例不变的上下文信息,减少金字塔最高层级特征在映射过程中的信息缺失,通过软RoI选择,使模型在特征融合后能够自适应地获取更优的RoI特征,有效提升了模型对不同尺寸服装图像的识别与分割效果;另外,通过引入双重注意力机制,增强各预测分支对图像中服装区域特征的关注度,有效改善了遮挡对分割效果的不利影响,实现了多尺寸服装图像与遮挡服装图像更精确的实例分割。