基于数据安全能力中台功能体系设计与安全分析场景研究

马波勇

(中国太平洋保险(集团)股份有限公司 上海市 200233)

1 数据中台及数据中台的价值

当前各行业的数据呈现出爆炸式的发展态势,数据将对行业未来的发展产生深远的影响,一度成为未来的核心资产[1]。数据中台技术主要依据过程数据为核心的发展要义,实现了海量数据的综合收集和综合整理,便于对数据内容进行综合的整理和加工计算,最终使其成为重要的核心数据资产,为高效的信息服务提供了技术支持[2]。中台从技术战略角度出发,将数据加工和数据处理进行规范化建设。从实践端来说,有了统一的中台,也就有了统一的数据规范。对于大数据相关的需求出发,可以从相对唯一的业务数据出口进行业务迭代,此时不需要为每个部门都进行定制开发,减少了人力资源的浪费。

2 基于数据中台的安全能力架构

数据安全中台以云化安全资源池为核心,提供了核心技术基础[3]。以IDPRR五大能力为抓手,将网络数据、客户数据、企业数据为防护对象,构建贯穿数据生命周期六大环节的安全体系[4],实现数据安全服务“可管控、可隐秘、可保护、可监视、可审计”的五大目标。其核心的基础架构示意如图1所示。

图1:基于数据中台的安全能力架构

3 数据治理的核心要要义

3.1 数据治理核心驱动力

(1)数据标准规范化:规范化的数据收集架构是所有业务开展的基础核心,其数据业务的内容涵盖流程规范文档以及信息项定义等要素;

(2)数据关系脉络化:针对数据间流转和数据之间的依赖关系而开展的深度分析;

(3)数据质量度量化:参照着数据管理平台的数据收集质量,实现良好的数据质量校核和数据综合分析,进而强化数据问题的追踪质量;

(4)数据服务电子化:数据平台提供了精准的数据服务渠道。

3.2 数据治理核心技术

(1)统一数据标准:对数据进行分类、口径、模型等规则的标准化统一管理。

(2)元数据管理:以建立企业级数据模型、指标体系为切入,将业务分类、业务规则、数据立方体纳入元数据管理。

(3)数据质量管理:建立跨专业、全过程的数据质量管理体系,保障数据信息的准确、规范、完整、一致。

(4)数据生命周期管理:参照着数据中台全生命周期的服务要素,将数据的使用频度和使用资源进行了合理化的分配。

(5)数据安全管控:对整个数据管理过程中,全过程数据资产进行环境控制、访问控制以及人员权限的综合管控,最大限度的保证平台安全。

数据治理中心应具备统一管理、分租户部署实例和管理的能力[5]。根据敏感数据分类分级要求,实现对敏感数据的风险识别以及数据安全风险评估及合规性检测。通过对数据进行分类、分级的自定义实现敏感数据分级、分类管理,利用敏感信息的标识按敏感信息类别、子类及范围进行分类[6]。其中数据分级的核心原则主要有:各级界限明确原则,参照着数据敏感度而进行的数据级别划分;就高不就低原则,如果同一批的数据属性中的字段分级不相同,则按照最高级别的属性参数信息进行综合管控。

4 数据中台访问控制中心

访问控制中心依据数据全生命周期的管理要素进行管控,目前在数据编码中认可度最高的标准为DAMA标准,实现了数据采集、数据存储、数据使用到数据消亡的全过程管[7]。整个业务流程当中,元数据管理是关键的核心,因此在基础业务的架构上还需要充分保证数据存储的完整性和一致性。数据质量管理更加强调运用数据特征度量来精确判定数据价值,更加注重数据清洗后的整合、分析与价值利用,使其倾向于通过持续治理来有改进数据质量、创造新的价值。

同时,数据中台的开放共享使得数据安全与合规问题更加严重,因此需要在数据全生命周期内强化数据分级分类管理、强制数据鉴权访问,保证数据资产能够在使用的过程中具有着适当的认证和控制[8]。访问控制中心需具备统一管理、分租户部署实例和管理的能力。同时在业务经营的过程中,建立起统一的数据安全管理控制策略库能够显著的提升安全事件的处置效率,并提供相关的查询、关联、追溯等服务能力。策略库具体包括但不限于:敏感数据脱敏策略、水印溯源策略、数据模糊化策略、数据加密策略等。

5 数据监测中心

数据监测中心主要对异常操作和数据泄露监测,通过对外接口异常行为监测、对外接口数据安全分析、应用数据安全威胁监测分析、大数据平台数据流转分析形成安全风险和态势视图。数据监测中心具备统一管理、分租户部署实例和管理的能力。利用敏感数据脱敏策略、水印溯源、数据模糊化、数据加密建立数据安全管控能力中心。

数据可视化是开展安全分析的关键核心,在数据可视化的安全分析平台中,通过建立统一的数据传输口径,能够灵活、高效的开展探索式的业务分析,帮助用户始终保持安全业务的核心洞察力,并将数据决策快速覆盖相关人员及应用场景当中。数据可视化分析为上层应用如查询搜索、信息比对、关联分析、统计分析、智能预测等应用提供统一的访问接口和查询界面。可无缝完成上层应用的对接,如可视化图表分析工具,GIS应用,图片识别应用等。

6 基于数据中台的Webshell后门数据安全风险识别监测

WebShell是黑客常用的恶意脚本,其本质是建立在Web服务器上而生成的恶意代码,通过计算机指令的形式形成恶意脚本,并通过网页的形式发布命令,进而对网站服务器进行远程的操控。

WebShell具有以下两种隐蔽特性:

(1)恶意WebShell只会被少数几个恶意攻击人员访问,普通人员不会访问WebShell(因为不知道有这个页面的存在),且访问次数也远远小于正常页面;

(2)正常Web页面彼此之间会通过超文本协议互相链接,引导用户一步步点击访问系统,WebShell因为隐藏自身的需要不会与其它页面互相链接,以免暴露自己。

基于上述特性,本文通过对出入度、访问量等多个维度,建立多模型融合算法进行攻击检测。本文检测方法是假设对外Web系统被攻陷植入WebShell后,出现的异常场景:

(1)访问量:恶意WebShell只会被少数几个恶意攻击人员访问,普通人员不会访问WebShell,且访问次数也远远小于正常页面。

(2)访问关系:正常Web页面彼此之间会通过超文本协议互相链接,引导用户一步步点击访问系统,WebShell因为隐藏自身的需要不会与其它页面互相链接,以免暴露自己。

(3)页面响应:WebShell是用来帮助攻击者控制Web系统和操作系统,因此在访问过程中必然会返回一些系统的敏感信息,这些信息虽然内容难以预测,但从统计角度,和Web系统的返回信息特征存在明显差异。

7 人工智能模型的应用

首先过滤日志中响应值非200、500的不存在页面,调用path规约生成用于页面特征抽取的预处理数据。并且对所有页面的参数信息进行实时的特征提取,其主要的特征涵盖:入度、出度、初次访问时间、最新访问时间、页面曝光天数、页面出现过天数等。

根据GMM、Local Outlier Factor、Isolation Forest算法分别计算出的各URI异常分数值,取各算法最异常的URI交集,生成疑似WebShell进行告警。

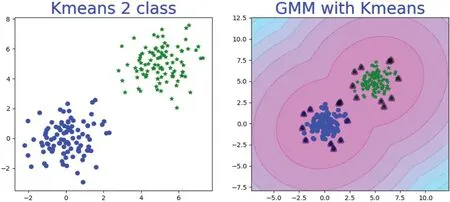

7.1 GMM高斯混合模型

利用Kmeans模型对输入的维度进行聚类前处理,对聚好的类分别求高斯分布,其计算原理为:

加权平均的复合化结果如图2所示。

图2:K-Means和GMM示意图

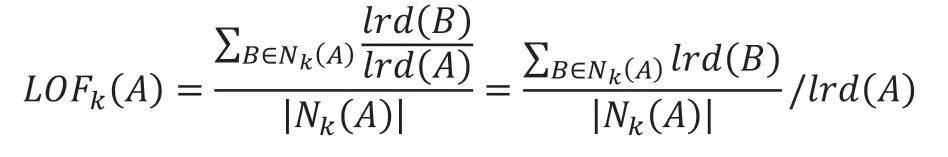

7.2 Local Outlier Factor

针对点A的位置甚至多个关联的k点,并且综合的计算A点到这些位置上的欧式距离,并且将其记作为是Nk(A),计算原理为:

求出局部可达密度:

同时采用相同的计算方法进行关联迭代计算,最终得到异常因子:

7.3 Isolation Forest孤立森林模型

孤立森林从算法属性上属于是非监督算法,但是其底层架构仍旧是决策树算法,通过建立n个决策树模型能够对模型进行及时得中台数据的异常系数值,其结果的示意图如图3所示。

图3:孤立森林模型示意图

利用上述模型做组合模型处理,给每一个模型添加阈值,使其具有决策机制(即判断是否为异常)对新输入的数据综合三个模型的投票,三个模型都认为是异常的数据最异常,两个次之,一个的异常可能性最小,都判别为不异常的,判别为正常。

8 混合模型介绍

8.1 单高斯模型

当中台样本数据X是一维数据时,高斯分布的数据形式主要遵循概率密度函数:

其中,μ为数据要素的期望值,σ为数据标准差。

当样本数据是多维的数据类型时,高斯的数据分布主要遵循的是下述概率密度函数:

其中,μ为数据均值(期望),∑为协方差(Covariance),D为数据维度。

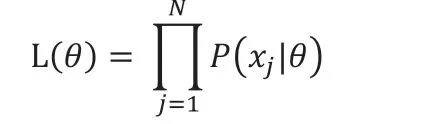

8.2 高斯混合模型

高斯混合模型主要由多个高斯子模型复合而成,子模型同时也是隐形变量,使用混合模型的原因主要是因为其具有着良好的数学性质和计算性能,所以用混合高斯分布可以更好的描述问题,模型对比结果如图4所示。

图4:模型结果对比图

其主要的流程中,首先需要定义如下信息:表示第j个观测数据属于第个子模型的概率。

8.3 模型参数学习

针对着单高斯模型,可以使用最大似然法来估算参数θ的值,其计算原理为:

似然函数由概率密度函数给出:

由于每个点发生的概率都很小,乘积会变得极其小,不利于计算和观察,因此采用Maximum Log-Likelihood来计算:

对于高斯混合模型,Log-Likelihood函数是:

由于log里还需要进行求和操作,因此还需要不断的进行迭代来进行综合求解。

9 结语

近年来,数据对于人们日常生活产生的重要影响逐渐的深入人心,因此保护用户数据安全也已经逐渐成为人们日常行为活动的主要看重点。本文的研究内容中从基本的数据安全概念作为文章探讨的出发点,分别分析了在中台体系下大数据安全体系和安全应用的技术路径,并结合着人工智能算法开展了数据处理,以促进数据管理质量的提升。

——媒体中台建设的特点和误区