地面目标多角度SAR 数据集构建与目标识别方法

朱岱寅,耿 哲,俞 翔,韩胜亮,杨卫星,吕吉明,叶 铮,闫 贺

(1.南京航空航天大学电子信息工程学院,南京 211106;2.南京工程学院计算机工程学院,南京 211167)

目标识别是雷达成像的核心目的之一,其准确性直接影响作战人员能否对目标敌我属性及战场态势做出正确判断。近年来,合成孔径雷达(Synthetic aperture radar,SAR)图像分辨率已经提升至亚分米量级,为解决低能见度条件下的目标识别和分类问题创造了条件。然而,由于SAR 图像信噪比随雷达作用距离增加而下降,且其幅度值随目标观测角度变化而发生随机起伏,SAR 目标识别在技术难度上远超光学图像。SAR 目标识别算法的分类准确性、鲁棒性以及迁移、泛化能力主要取决于训练样本的数量、质量和多样化程度[1]。

目前,在军用车辆SAR 图像目标识别领域应用最为广泛的开源数据集是美国国防高级研究计划局(Defense Advanced Research Projects Agency,DARPA)和美国空军研究实验室(Air Force Research Laboratory,AFRL)于20 世纪90 年代中期公布的运动和静止目标获取与识别(Moving and stationary target acquisition and recognition,MSTAR)数据集[2]。该数据集包含自行榴弹炮、坦克和装甲车等10 大类22 小类地面军事目标的360°圆周SAR 图像,俯仰角包含15°、17°、30°、45°四种情况,方位角间隔为1°~5°,图像分辨率为30 cm×30 cm。虽然MSTAR 数据集自公开发布以来支撑了大量目标识别相关研究,其局限性也日益凸显,主要包括:目标种类少、观测角度步进间距大、成像条件过于理想以及不同俯仰角条件下的观测样本杂波背景相关程度高等[1,3-4]。针对上述问题,部分国外研究机构已经针对MSTAR 数据集中包含的目标自主构建了SAR 数据集,并在对目标识别算法进行评估时采用双数据集模式[5-8]。

在民用车辆目标SAR 图像识别方面,最具有代表性的机载圆周SAR 数据集为美国AFRL 和俄亥俄州立大学的研究人员在2006—2008 年间针对AFRL 内部停车场中停放的6 大类59 个车辆目标(轿车、皮卡和SUV 等)构建的GOTCHA 数据集[9]。该数据集充分考虑目标位姿变化与变形,例如车辆启动、车门开合、后备箱开闭以及遮阳布覆盖等[10]。GOTCHA 数据集中的目标与俄亥俄州立大学2010 年公布的民用车辆(Civilian vehicle,CV)仿真SAR 数据集CV Data Dome 存在对应关系[11],有利于研究人员对实测与仿真SAR 图像样本之间的误差进行分析,从而对目标CAD 模型及电磁散射模型进行修正。

近年来,中国国内发布的SAR 目标数据集以星载SAR 系统获取的船舶目标图像为主[12]。2019年起,中国科学院遥感所、中国科学院空天信息创新研究院(空天院)、复旦大学等研究机构先后公布了基于中国高分国产卫星数据的SAR 目标检测识别数据集。2021 年,空天院的研究人员提出了SAR 目标散射拓扑特性的表征建模和学习计算方法,在星载SAR 图像飞机目标识别问题中展现出优良的性能[13]。2022 年4 月,在上海举办的雷达图像解译技术研讨会上,空天院的研究人员宣布该机构已经构建了一套基于高分国产卫星数据的SAR目标检测识别数据集[13]。

相比于星载SAR,机载SAR 成本低、机动性强,能够在短时间内对感兴趣的地面场景进行多角度实时成像。然而,公开发表的文献中鲜有针对地面车辆目标录取的机载圆周SAR 数据集。为了填补这一空白,南京航空航天大学雷达探测与成像技术研究团队利用自主研制的多旋翼无人机(Unmanned aerial vehicle,UAV)机载高分辨率微小型SAR 系统[14-15]开展了多角度SAR 目标回波数据的采集工作,构建了多种类复杂地面目标SAR 图像数据集。与大型机载SAR 系统相比,微型SAR 系统具有轻小型化、低功耗、低成本和机动性强的特点。然而,小型无人机平台运动轨迹极易受到不稳定气流的影响,且由于载荷限制无法搭载高精度的运动和姿态测量模块,这些因素所导致的运动误差将严重影响SAR 图像聚焦质量。鉴于此,本文针对运动补偿及自聚焦处理问题展开研究,提出了基于极坐标格式算法(Polar format algorithm,PFA)及后向投影(Back proejction,BP)算法的新型二维自聚焦高精成像算法[15-19]。

2022 年,南航雷达探测与成像技术研究团队依托该数据集开展了一系列基于人工智能的目标识别方法研究。在前期仿真实验中,主要考虑了4种典型神经网络模型:VGG-16(大型神经网络)、ResNet-18(中 型 神 经 网 络)、AConvNet[20](小 型 神经网络-A)以及AlexNet 风格的SAMPLE 网络[21](小型神经网络-B)。实验结果表明,虽然上述神经网络在MSTAR 十类目标分类问题中均取得了接近100%的分类准确率,其MiniSAR 数据集9 类目标分类准确率尚存在较大提升空间。具体说来,以31°俯仰角数据作为训练样本,37°俯仰角样本作为测试样本时,ResNet-18 取得了90%目标分类准确率,略优于其他网络。而在37°俯仰角数据作为训练样本,45°俯仰角样本用作测试样本时,SAMPLE 网络获得的分类准确率最高,约为80%。上述结果一方面反映了SAR 图像聚焦质量对于神经网络目标分类准确率的重要影响,另一方面也验证了依托单一数据集(例如样本种类数量有限、成像条件高度理想化的MSTAR 数据集)开展SAR 目标分类深度学习算法研发及性能评估所存在的缺点。与此同时,ResNet-18 和SAMPLE 网络的出色表现也从侧面证实了欧美军方研究人员近年来提出的一个新的SAR 目标分类算法研发思路:在以低细粒度为特征的SAR 图像目标分类方面,包含海量参数的大型神经网络与中小型网络相比并无明显优势[1,8,21-22],因而不能照搬光学图像分类问题的解决方案。本文所提MiniSAR 数据集的数据录取环境与实际应用场景较为接近,可以用作MSTAR 数据集的辅助数据集,为研发鲁棒性高、泛化能力强的SAR 目标识别算法提供高质量多源SAR 图像样本支撑,从而有效规避训练数据有限导致的神经网络过拟合问题。

1 微型SAR 系统高分辨率成像处理算法

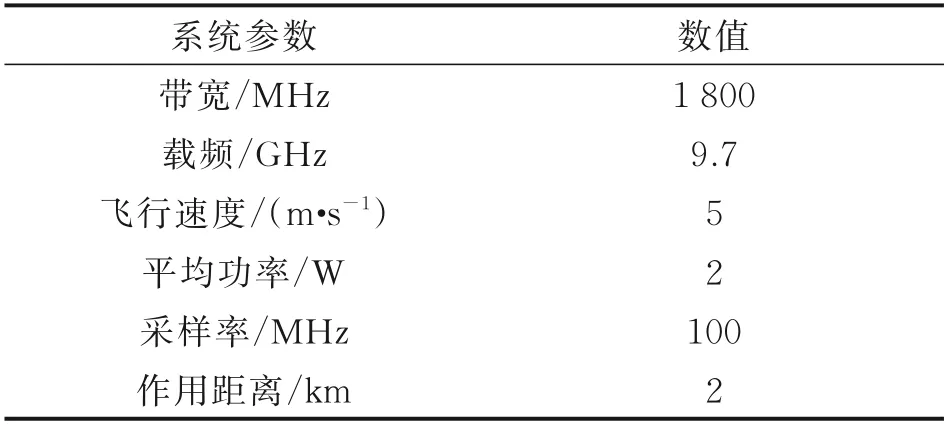

无人机载微型SAR 能够安全可靠地针对特定目标完成圆周SAR 数据的录取工作,且具有成本低、灵活性高和实验可重复性好等优势。同固定翼无人机相比,多旋翼无人机更适用于圆周成像。国际上比较具有代表性的微型SAR 系统包括美国波音公司、Insitu 公司以及ImSAR 公司2006 年共同研发的Ku 波段NanoSAR 以及德国弗劳恩霍夫高频物理与雷达技术研究所(FHR)2012 年研发的W 波段SARape。其中,NanoSAR 质量仅为0.9 kg,分辨率0.3 m,而SARape 质量为8 kg,分辨率0.15 m。中国针对无人机载SAR 系统的研制虽然从2010 年前后才开始,但是发展迅速,中科院电子所、中国电科集团38 所、北京理工大学等多家单位均自主研制出了高分辨率的微型SAR 系统。本实验使用的X/Ku 波段NUAA MiniSAR 系统为南航雷达探测与成像技术研究团队于2017 年自主研发,采用调频连续波体制,分辨率0.1 m,质量仅为5 kg,达到国际领先水平。其主要参数如表1 所示。搭载平台为八旋翼无人机,系统近照如图1(a,b)所示,获取的红外图像、SAR 图像和光学图像在图1(c)中给出。

表1 X 波段MiniSAR 主要系统参数Table 1 MiniSAR system parameters of the X band

图1 南航MiniSAR 实验系统[15]Fig.1 NUAA MiniSAR system for experiment

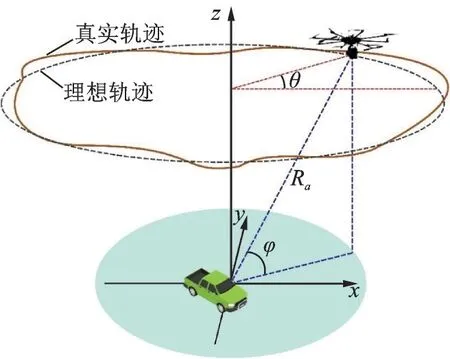

圆周模式的微型SAR 数据采集几何关系如图2 所示。图中:θ为方位角;Ra为雷达到场景中心的距离;φ为俯仰角。由于多旋翼无人机平台体积小、质量轻,其运动轨迹受气流影响较大,在合成孔径时间内的航迹通常存在非线性问题。鉴于此,针对运动补偿及自聚焦处理问题展开研究,提出了极坐标格式算法(Polar format algorithm,PFA)和反投影(Back projection,BP)算法这两种新型二维自聚焦高精成像算法。

图2 基于多旋翼无人机的微型SAR 圆周轨迹飞行示意图Fig.2 Circular flight path of multirotor UAV-borne MiniSAR system

(1)自聚焦极坐标格式成像算法

PFA 成像不依赖理想直线轨迹假设,非常适合微型SAR 圆周成像处理。然而,PFA 成像质量取决于运动测量系统是否能提供雷达平台与目标之间的确切相对位置。由于平台载荷的限制,小型多旋翼无人机无法搭载高精度惯性导航系统(Inertial navigation system,INS)和全球定位系统(Global positioning system,GPS),因此位置测量误差较大。相比于大型机载平台,小型无人机的圆周航迹更为复杂多变,运动误差在引起方位相位误差和图像方位散焦的同时也会导致额外的距离徙动,造成严重的距离向散焦。因此,相位梯度自聚焦算法(Phase gradient autofocus,PGA)等常规一维自聚焦方法无法满足无人机载微型SAR 的高精度成像要求。

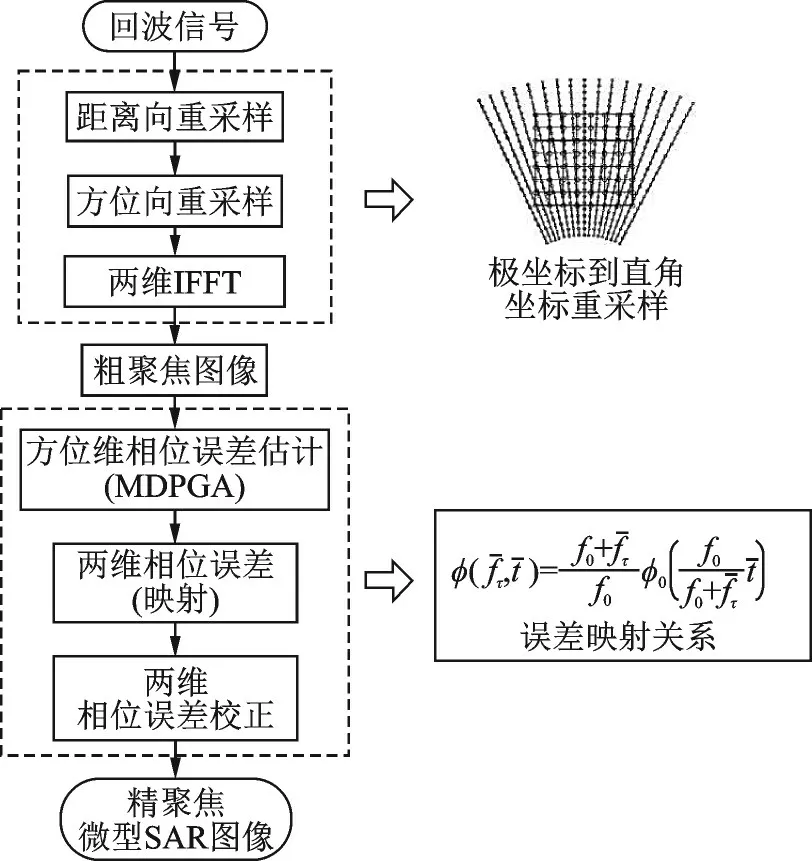

针对上述问题,本文提出基于PFA 粗聚焦和多孔径PGA 精聚焦的信号处理方案。首先利用PFA 对SAR 图像进行粗聚焦处理,然后利用Mapdrift-PGA(MDPGA)算法估计方位向误差,继而对距离徙动误差进行估计,最终完成两维运动补偿。MDPGA 算法的核心步骤如下:(1)将极坐标重采样后的数据在方位向分成多个子孔径;(2)利用PGA 算法对子孔径内二阶及以上高阶非线性相位误差进行估计;(3)利用MD 算法对相邻子孔径间的相对偏移量进行估计,求取相对线性误差;(4)通过对各子孔径相对误差进行拼接获取全孔径方位相位误差。基于PFA 算法的圆周轨迹微型SAR高分辨成像处理流程图如图3 所示。图中:f0为载频;fˉτ为 距 离 频 率;φ0为 方 位 相 位 误 差;tˉ为 方 位时间。

图3 基于PFA 算法的圆周轨迹微型SAR 高分辨成像处理流程图Fig.3 Flowchart of circular path MiniSAR high-resolution imaging process based on PFA algorithm

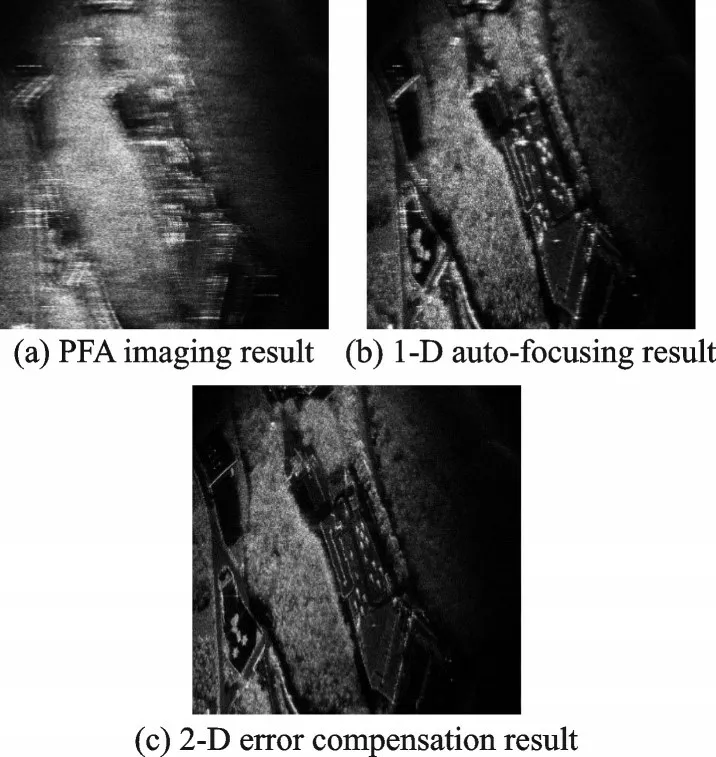

图4 对比了多旋翼无人机机载微型SAR 数据不同成像处理方法得到的结果。其中,图4(a)为未经运动补偿处理的PFA 成像结果,图4(b,c)分别为一维和二维运动补偿处理结果。可以看出,本文提出的二维运动补偿算法拥有更好的高分辨率SAR 图像聚焦效果。同时,本方法可映射至可编程门阵列(Field programmable gate array,FPGA)技术,实现多组MiniSAR 数据高速并行处理与实时成像。

图4 多旋翼无人机机载微型SAR 数据不同成像处理方法结果对比Fig.4 Comparison of results obtained by applying different image processing approaches to the data collected by the multirotor UAV-borne SAR system

(2)自聚焦后向投影成像算法

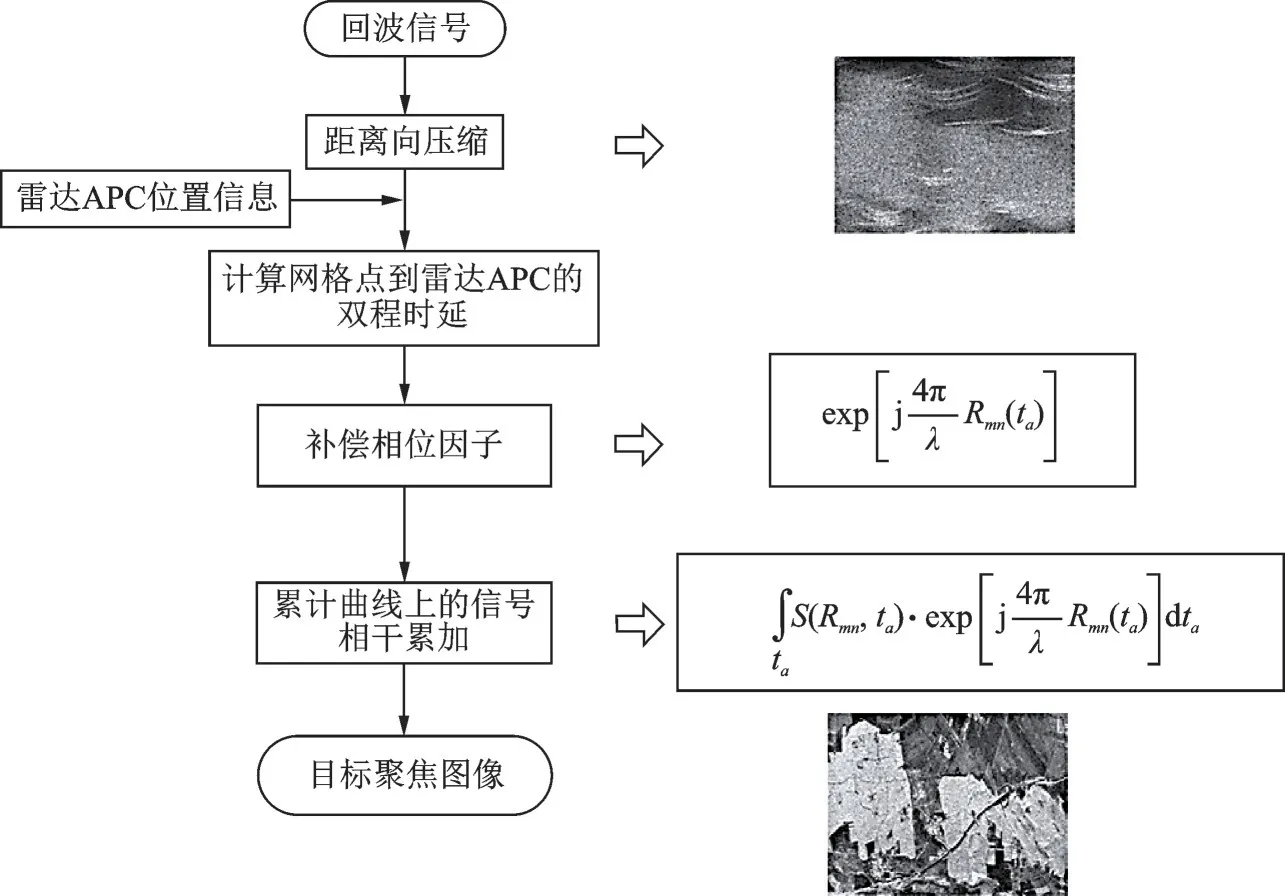

BP 算法成像的基本原理是对感兴趣区域(Region of interest,RoI)中所有像素点的回波信号沿方位向作相干叠加处理。圆周轨迹飞行对应的BP算法流程图如图5 所示。图中:APC 指天线相位中心;Rmn为网格点到雷达的距离;λ为波长;ta为慢时间。首先,将观测场景离散成网格并计算每个网格点(即像素点)的坐标,然后根据雷达每个发射脉冲时刻与每个网格点的距离计算出双程时延、对应距离以及补偿相位因子。由于离散采样,根据时延估算的距离与采样点真实位置之间通常存在一定偏差,因此需通过补零插值等手段对距离向匹配滤波信号进行细化。将插值得到像素点信号乘以补偿相位,再沿方位向进行相干叠加,即可得到每个像素点的值。然而,小型无人机平台容易受到气流扰动影响而偏离理想圆周轨迹,再加上非均匀传播介质所导致的回波时延误差等因素,高分辨情况下MiniSAR 运动测量单元提供的位置信息精度有时无法满足相干性需求,严重影响SAR 图像聚焦质量。

图5 圆周轨迹下BP 成像流程图Fig.5 Flowchart of BP imaging for circular flight path

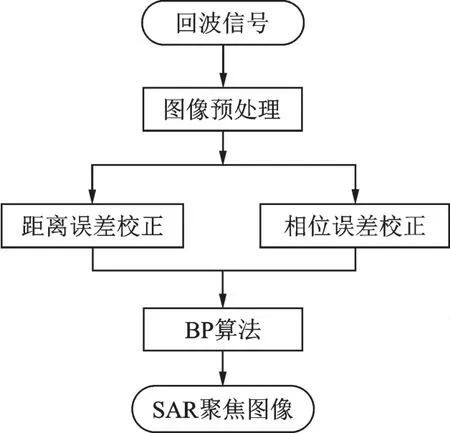

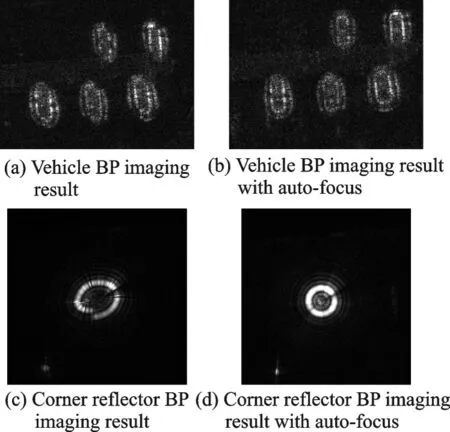

为了对上述测距误差和相位误差进行补偿,本文提出了特显点自聚焦算法,算法流程如图6 所示。该算法基本思路如下:(1)利用距离向脉冲压缩根据SAR 平台理想轨迹实现粗成像,确定特显点在成像网格中应在的位置;(2)对回波信号进行距离向傅里叶变换并提取特显点曲线;(3)求取特显点实际位置与理想位置之间的距离和相位误差并进行相应补偿;(4)利用BP 算法对完成特显点自聚焦处理的SAR 回波数据进行成像。车辆目标和角反射器常规BP 成像与特显点自聚焦BP 成像结果对比图在图7 中给出。可以看出,特显点自聚焦算法能够有效对距离和相位误差进行补偿,显著改善图像散焦问题。

图6 特显点自聚焦算法流程Fig.6 Flowchart of auto-focusing by exploiting the dominant scatterer

图7 常规BP 成像与特显点自聚焦BP 成像结果对比Fig.7 Comparison of results of conventional BP imaging and modified BP imaging with auto-focus by exploiting the dominant scatterer

2 目标数据集

大部分用于目标识别的神经网络都是针对光学图像设计研发的,与之配套的开源目标识别数据集十分丰富,包括Places365、80 Million Tiny Images、ImageNet-22k、CIFAR-100、LSUN 等[23]。其中,LSUN 和斯坦福车辆数据集共包含200 万个车辆目标光学图像样本。与之相比,可用于SAR图像目标识别的训练样本十分稀少。从20 世纪90年代至今,国内外车辆目标识别相关研究主要依托美国录取并公开的少量军用、民用车辆SAR 数据集。另一方面,由于SAR 图像主要反映目标电磁散射特性,肉眼可辨识度较差,再加上SAR 图像信噪比随雷达作用距离增加而下降,且其幅度值随目标观测角度变化而发生随机起伏,SAR 目标识别在技术难度上远超光学图像。新兴的深度学习算法为解决多角度目标电磁信息提取过程中的瓶颈问题创造了条件。然而,深度神经网络的研发需要大量高质量、多角度的训练样本作为支撑。因此,构建拥有自主知识产权的多角度SAR 目标数据集是研发高性能目标识别算法的前提。

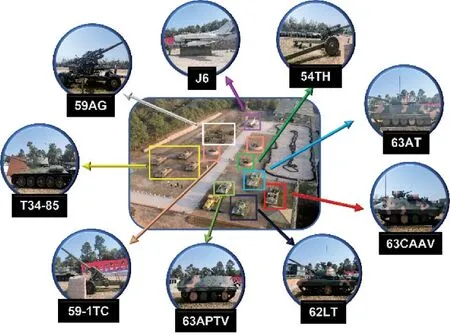

2021—2022 年间,本文利用前文所述MiniSAR 系统在南京某国防园内开展了两次外场试飞实验,针对园区内坦克、装甲车等典型地面军事目标开展了多俯仰角全方位观测,录取了大量回波数据,初步构建了包含9 类目标的圆周SAR 目标数据集。MiniSAR 系统成像模式为聚束模式,飞行高度400~500 m,飞行速度5 m/s,方位角覆盖0°~360°,观测俯仰 角包含15°、26°、31°、37°和45°,外场实验观测场景如图8 所示。对应的军事目标种类在表2 中列出,其中8 类为地面军事目标,1 类为飞行器。本数据集利用LabelImg 软件对目标进行标注,结果保存为XML 格式。

图8 各类目标实拍图Fig.8 Electro-optical images of targets

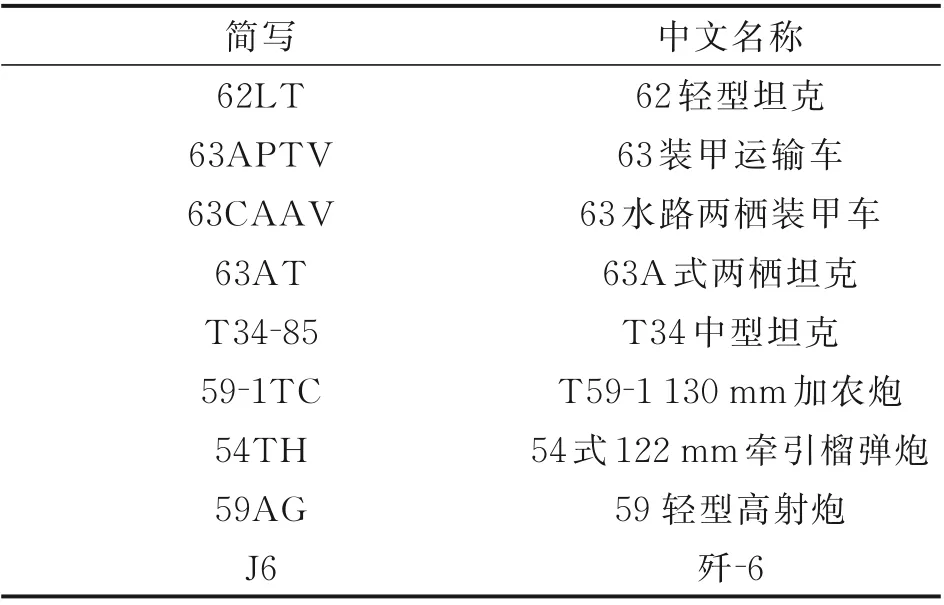

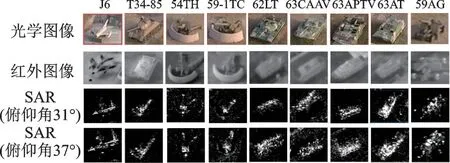

表2 数据集地面目标种类列表Table 2 List of ground targets included in the dataset

图9(a)给出了数据集中单幅图像的矩形框标注示例,图9(b)给出的是图9(a)图中某一目标(62轻型坦克)的标注信息截图。每个XML 文件包含图像中所有目标的存储路径、文件名、像素大小、目标类别以及目标锚框位置等信息。

图9 目标标注示意图Fig.9 Image annotation for targets

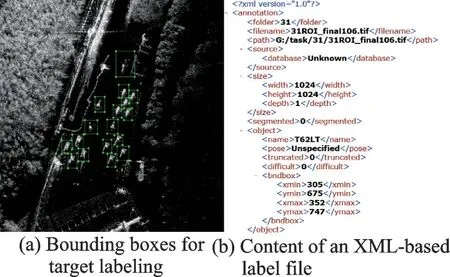

图10 给出了课题组利用无人机平台搭载光学相机、红外传感器和MiniSAR 系统获取的9 类目标光学图像、红外图像以及SAR 图像样本对比图。可以看出,光学图像与红外图像所包含的信息比SAR 图像更为直观。然而,光学和红外图像的分辨率随传感器到目标距离的增加而降低,SAR 图像分辨率则不受距离影响,在远距离成像时有显著优势。因此,红外图像与SAR 图像之间的异源信息融合有助于提升复杂场景中运动与静止目标识别的鲁棒性。本文利用同一无人机平台获取的SAR 图像和红外图像样本能够有效支撑基于异源信息融合的目标识别研究。

图10 各类目标光学图像、红外图像及SAR 图像切片Fig.10 Electro-optical, infrared and SAR image chips of targets

3 基于数据集开展的目标识别方法

SAR 目标识别常用的统计机器学习方法包括主成分分析(Principal component analysis,PCA)、支持向量机(Support vector machine,SVM)、K 近邻(K-nearest neighbor,KNN)、自适应增强(Adaptive boosting,AdaBoost)以及基于属性散射中心(Attribute scattering center,ASC)的目标识别方法等。新兴的深度学习算法在分类准确性方面优于统计机器学习方法,但是存在物理可解释性较差的问题。

目前,国内外目标识别方法相关研究主要依托公开版MSTAR 数据集。MSTAR 项目在1995至1997 年间共进行过3 次数据采集,仅前两次采集的数据就包含36 类目标,但是开源数据集中仅包含10 大类目标。在基于深度学习的SAR ATR算法研发方面,15°/17°俯仰角观测数据分别作为训练/测试样本的标准工作条件(Standard operation condition,SOC)MSTAR 十类目标分类准确率早在2016 年就已突破99%。另一方面,涉及大俯仰角变化、目标刚性变形、子型号识别和低信杂比情形的扩展工作条件(Extended operation condition,EOC)目标分类问题仍亟待解决。具体说来,美国莱特州立大学及AFRL 的研究人员于2016 年 提 出 了AFRLeNet,取 得 了99.4% 的MSTAR SOC 十类目标分类准确率[24]。同年,复旦大学的研究人员提出了新型深度卷积神经网络A-ConvNets,其SOC 及两类扩展工作条件(EOC-1,EOC-2)的分类准确率分别达到了99.1%、96.1%和98.9%[20]。其中,EOC-1 指训练/测试样本分别为17°/30°俯仰角观测数据时4 类目标分类问题,EOC-2 主要关注15°和17°俯仰角获取的BMP2 及T72 子型号样本分类问题。2021 年,国防科技大学的研究人员提出将目标部件模型和深度学习算法有机结合起来,首先利用双向卷积循环网络按照目标部件ASC 模型提取目标局部特征,然后利用全卷积网络提取目标全局特征,继而通过融合局部和全局特征对目标种类进行判决,最终取得了高于99%的EOC-1 识别准确率[25]。

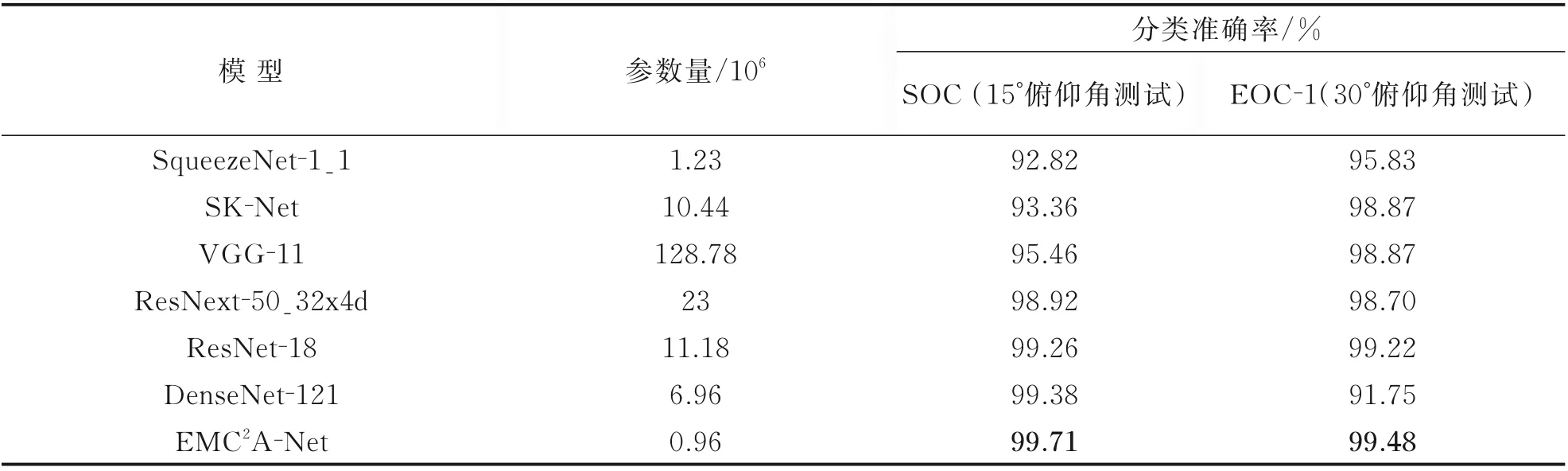

需要指出的是,由于公开版MSTAR 数据集仅有4 类目标包含30°俯仰角观测数据,文献[20,25]中所获得的接近100%的EOC 识别准确率均由3类/4 类目标30°俯仰角标准目标形态相关数据评估得到。在采用45°俯仰角和目标刚性变形数据(如炮塔旋转等)进行测试时,上述深度学习算法分类准确率约为77%。2021 年,本课题组研究人员提出了基于仿真SAR 数据先验知识和元学习的目标识别方法,3 类目标45°俯仰角样本分类准确率达到79.3%,略高于其他深度学习算法[26]。17°俯仰角SAR 图像作为训练样本时,其他常见深度学习网络的MSTAR SOC 及EOC-1 目标分类准确率在表3 中给出。其中,文献[27]中新近提出的EMC2A-Net 在神经网络模型参数数量及分类准确率上都具有较为明显的优势。

表3 现有深度学习网络的时间成本及分类准确率(MSTAR)Table 3 Time efficiency and classification accuracy provided by existing deep learning networks (MSTAR)

综上所述,虽然MSTAR 数据集SOC 十类目标分类准确率早在2016 年就已突破99%,但是涉及45°俯仰角观测样本及目标刚性变形的EOC3类/4 类目标识别问题仍亟待解决。特别地,单纯依赖深度学习算法取得的3 类目标45°俯仰角识别准确率最高仅为80%。虽然一些研究人员利用字典学习法、稀疏表示法等方法获得了高于90%的3类 目 标45°俯 仰 角 识 别 准 确 率[28],但 是 由 于MSTAR 相关样本种类数量限制,其泛化能力仍有待验证。同时,文献[29]提出的SAR 目标分类算法大多单纯依托公开版MSTAR 数据集评估算法的分类准确性,对实际工程应用环境中陌生目标和杂波背景的潜在影响,以及深度神经网络模型提取目标特征图的内在机理缺乏系统深入的分析。

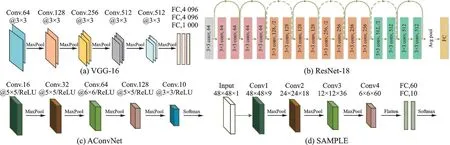

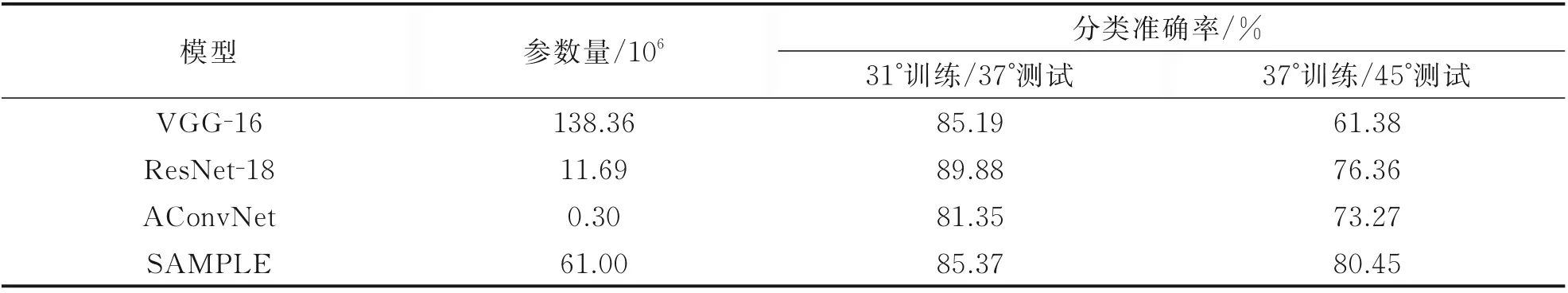

为了解决上述问题,南航雷达探测与成像技术研究团队依托自主研制的无人机载高分辨率微小型SAR 系统,通过研发新型高精度微型SAR 成像算法及运动误差补偿算法,初步构建了拥有自主知识产权的9 类典型军事目标圆周MiniSAR 数据集,并利用该数据集开展了一系列目标识别方法研究。本文在前期仿真实验中主要考虑4 种极具代表性的 神 经 网 络 模 型:VGG-16、ResNet-18、AConvNet[20]以 及AlexNet 风 格 的SAMPLE 网 络[21]。其中,VGG-16 代表模型训练时间成本高的大型神经网络,ResNet-18 代表中型神经网络,AConvNet和SAMPLE 网络代表训练时间成本低的小型神经网络。这些网络模型的框架图在图11 中给出。实验结果表明,虽然上述经典深度神经网络在MSTAR 数据集目标分类问题上展现出优越的性能,这些网络并不能有效地解决MiniSAR 数据集目标分类问题。31°及37°俯仰角MiniSAR 图像分别作为训练和测试样本时,VGG-16、ResNet18、AConvNet、SAMPLE 等4 种 经 典 深 度 学 习 网 络MiniSAR 数据集9 类目标分类准确率在表4 中给出。其中,31°和37°俯仰角所对应的样本数分别为5 009 和4 915。可以看出,ResNet18 取得的准确率最高,为89.88%。而AConvNet 获得的分类准确率最低,为81.35%。作为对比,37°及45°俯仰角MiniSAR 图像分别作为训练和测试样本时上述4种神经网络的识别准确率也在表4 中给出。AlexNet 风格的SAMPLE 网络[21]取得的准确率最高,为80.45%,而拥有上亿参数量的大型神经网络VGG16 的识别准确率仅为61.38%。37°及45°俯仰角数据分别作为训练和测试数据时目标分类准确率较低的主要原因是无人机平台在圆周飞行过程中偏离理想航迹的运动轨迹并未得到精准补偿,各俯仰角获得的SAR 图像样本聚焦质量起伏较大。因此,本文将对所提运动补偿及二维自聚焦算法进行进一步改良,以期在后续外场采样实验中提升SAR 图像样本的质量。

图11 神经网络模型框架图Fig.11 Diagrams of neural network models

表4 现有深度学习网络MiniSAR 数据集分类准确率Table 4 Classification accuracy for MiniSAR dataset provided by existing deep learning networks

表4 中的结果充分证明了依托单一种类的SAR 数据集对神经网络进行性能评估存在一定的片面性。与此同时,表4 中给出的实验结果也从侧面佐证了欧美军方研究人员在近年来提出并反复验证的一个重要观点:虽然包含海量参数的大型神经网络在高细粒度光学图像识别任务中展现出中小型网络无法比拟的优越性,在以低细粒度为特征的SAR 图像分类方面,小型网络的性 能 有 时 优 于 大 型 神 经 网 络[1,8,21-22]。本 领 域 的研究人员应该认识到,SAR 图像与光学图像在成像原理方面存在本质区别,不能完全照搬光学图像识别的研究思路。只有以高质量多源SAR 数据集作为数据支撑,才能针对SAR 目标识别问题提出工程实用性强的神经网络模型设计方案,有效规避训练数据有限导致的神经网络过拟合问题。

在实际工程应用场景中,地面目标不一定处于理想静止状态及标准位姿。为了防止目标识别算法在训练过程中过于偏重杂波背景信息而忽略目标本身的关键特征,笔者计划后期充分利用无人机载微型SAR 机动性强的优势,针对多种可移动目标开展不同观测场景(公路、沙地、草地和泥地等)下的全方位圆周SAR 数据录取,从而构建杂波背景及目标运动状态/形态富于变化的大型地面目标SAR 图像样本库,为面向工程应用的地面目标分类算法研发提供数据支持。其次,笔者拟利用同一无人机搭载的微型SAR 系统和红外成像系统针对多类地面目标进行成像并构建平行数据集,继而通过红外成像与SAR 图像之间的异源信息融合提升复杂场景中目标识别的鲁棒性。

4 结 论

本文介绍了南航雷达探测与成像技术研究团队利用自主研制的无人机载高分辨率MiniSAR 系统针对9 类地面军事目标录取圆周SAR 数据并构建数据集的主要流程,以及依托该数据集所开展的基于人工智能的目标识别方法的研究工作。本文通过对一系列实验结果进行深入分析得到如下结论:

(1)SAR 图像聚焦质量对于深度神经网络的目标分类准确率具有重要影响。本文所提基于极坐标格式算法及后向投影算法的新型二维自聚焦高精成像算法能够有效改善无人机非线性运动以及运动模块测量误差所导致的SAR 图像散焦问题,有效地提升了SAR 图像训练样本质量。另一方面,无人机平台随机抖动而导致的偶发性运动补偿误差及图像散焦问题仍未能得到彻底解决,表明本文所提自聚焦算法仍存在一定的改进空间。

(2)虽然美国90 年代末期公布的MSTAR 数据集对SAR 目标分类算法的研发起到了重要的促进作用,但是该数据集也存在多类目标关键角度样本缺失、成像条件高度理想化等问题。因此,单纯依托该数据集开展基于深度学习的SAR 目标算法研究工作存在一定的局限性。与MSTAR 数据集相比,本文所提地面目标多角度MiniSAR 数据集的数据录取环境与SAR 目标识别实际工程应用场景更为接近,能够为研发鲁棒性高、泛化能力强的SAR 目标识别深度学习算法提供有力的数据支撑,有效避免神经网络模型设计过程中可能出现的过拟合问题。