融合多尺度特征的遥感影像道路提取方法

赫晓慧,宋定君,李盼乐,田智慧,周广胜

(1.郑州大学 地球科学与技术学院,郑州 450052;2.郑州大学 信息工程学院,郑州 450001;3.中国气象科学研究院郑州大学生态气象联合实验室郑州 450052)

0 概述

随着地球空间信息技术的发展以及卫星数量的增加,研究人员可以获得具有丰富空间信息和光谱信息的遥感影像数据。这些数据被广泛应用于天气预报[1]、农业研究[2]、交通监控[3]等领域。在卫星图像空间分辨率得到极大提高的条件下,利用遥感影像提取的道路也会具有高分辨率和覆盖范围广的特点,对城市规划、交通运输管理、出行路线选择等方面均具有重要的指导意义。

在图形图像处理中,越来越多的研究人员将深度学习方法应用于边缘检测[4]、图像分类[5]、语义分割[6]等任务中。在面向遥感影像数据中的道路提取任务时,主要涉及卷积神经网络(Convolutional Neural Networks,CNN)[7]和全卷积神经网络(Fully Convolutional Network,FCN)2 种网络。研究人员利用CNN 聚焦到更深层的处理遥感影像问题中,相较于需要手动提取浅层特征的传统方法[8-10],使用CNN 的方法具有时间复杂度小的优势。文献[11]基于CNN 提取全局上下文特征,实现了遥感影像的高效分类。文献[12]提出一种基于CNN 的遥感影像分类方法,可以从高空间分辨率遥感影像中提取道路。遥感影像与自然影像不同,其通常包含比背景更小及更分散的对象,虽然CNN 利用图像级的分类应用在遥感影像道路提取任务,但是采用的局部处理策略仍然使提取的道路信息存在误差。

越来越多的研究人员将深度学习方法应用于像素分类任务[13-14]。文献[6]提出FCN 网络,能够对每一个像素进行分类,从而得到像素级的分类结果。FCN 相比CNN 解除了对输入图像大小的限制,大量减少了模型参数量,提高了效率。

目前,许多出色的语义分割网络均是FCN 的改进版本。文献[15]在FCN 的基础上通过全局平均池化和特征融合操作引入更多上下文信息,并使用辅助损失函数提高训练精度。文献[16]基于FCN 提出U-net 网络结构,目前多用于遥感影像分割任务中,能够对任意大小的影像进行卷积操作,在面向高分辨率遥感影像道路提取任务[17]中能够利用U-net 进行全局特征表达。为进一步提高特征提取能力,WANG 等[18-19]使 用空洞卷 积(Dilated Convolution,DC)扩大感受野,使卷积输出包含较大范围信息,同时保持特征图尺寸不变。D-LinkNet[20]充分融入了DC 的特性,使道路分割结果有一定的提升。但高分辨率遥感影像中的道路具有多尺度特性,不同尺度的道路特征包括局部拐角、宏观线条、交叉点等,多尺度信息收集会明显改善提取结果的质量。文献[21]通过使用多尺度卷积神经网络将空间特征与光谱特征相结合,促进原始数据集转换为包含多尺度空间信息的金字塔,以捕获丰富的空间信息。多孔空间金字塔池化(Atrous Spatial Pyramid Pooling,ASPP)模块[22]通过并行多个不同比例的空洞卷积将多尺度信息整合到ASPP 中,以获得精细的分割结果,文献[23]通过使用ASPP 模块提高对道路的预测能力。随着网络的加深,ResNet[24]和DRSNet[25]等通过残差模块优化网络结构及提升网络性能。文献[26]使用带有残差模块的U-net,通过向前传播,从图像中提取道路区域。目前,虽然已有许多基于深度学习的道路提取方法,但针对深度网络模型而言,池化操作的重复使用降低了特征图分辨率,通过上采样得到预测结果的精度有待提高,且没有考虑多尺度融合的特性。此外,使用下采样操作提取抽象的语义信息作为特征使遥感影像中高分辨率的细节语义信息容易丢失,导致提取结果存在细节缺失、边缘模糊等问题。最后,空洞卷积堆叠使用会导致大部分像素无法参与运算,形成网格效应,无法准确提取小型道路特征,因此在复杂道路提取任务中不同尺度特征的预测效果受限。

针对上述问题,本文基于深度残差网络模型提出一种融合多尺度特征的遥感影响道路的提取方法。在特征提取和特征融合方面进行方法设计,采用混合空洞卷积的方式,定义新的卷积核处理数据间的距离,实现感受野指数级增长。在网络编码器与解码器间融入ASPP 模块整合全局信息,通过将提取特征加权映射到ASPP 模块,得到更准确的预测结果。

1 本文方法

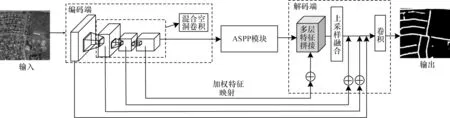

本文方法的框架如图1 所示。首先,在特征提取阶段利用融入混合空洞卷积增大感受野的方式提取特征,增强多尺度特征融合模块中道路信息之间的联系。其次,将提取特征作为所设计的ASPP 模块的输入并进行加权映射,ASPP 模块对不同尺度形状的道路有更好的检测性能,体现在提高分辨率时,多尺度特征融合后的预测结果能够有效利用全局信息条件下不同尺度间的特征,更好地识别出正确的道路信息。

图1 本文方法的框架Fig.1 Framework of method in this paper

1.1 特征提取网络模型

本文模型以ResUnet[26]为基础架构,结合了U-net和残差网络。在只有有限训练数据的情况下,训练深度神经网络变得非常困难,而且在深度残差网络的残差模块中,步长固定会使感受野变小,从而只能捕捉到遥感影像局部信息,在无法得到全局信息时会导致分割错误、不能进行多尺度问题的处理。

针对以上问题,基于ResUnet 引入空洞卷积层,在不做池化操作损失特征信息的情况下增大感受野且不丢失分辨率。每个卷积输出包含比普通卷积更大范围的特征,有利于获取遥感影像中道路特征的细节信息。在新的特征提取模型DC-ResUnet 中扩大感受野可以检测分割更多道路目标,当分辨率提高后可以精确定位道路目标。在卷积神经网络中,将各卷积层输出特征图上的像素点映射到输入图片上的像素范围大小称为感受野。

二维一般卷积公式如式(1)所示:

其中:F(x,y)表示卷积层的输出;s[x,y]表示卷积层的输入;Q[i,j]表示卷积核大小;X和Y表示影像的尺寸。

当卷积层为q时,感受野为Rq,表达式如式(2)所示:

其中:Rq-1为上一层卷积的感受野;Qq-1为上一层卷积核的大小;S为步长。

在如图2 所示的残差结构中引入空洞率(Dilation Rate,DR)。

图2 残差结构Fig.2 Residual structure

如图3 所示,其中超参数Rate 定义了卷积核处理数据时各值的间距,相比一般卷积,混合空洞卷积采用的卷积核大小为3×3 像素。在残差结构中以梯度的形式设计串联3 层,初步由Rate=1、Rate=2、Rate=3 组成,在更大的范围内获取道路信息,同时避免出现网格问题,在实验过程中通过调节这3 组超参数实现参数变换。通过设计混合空洞卷积的方式实现特征增强,其中较小的Rate 与最近的像素相关,较大的Rate 与远程像素相关,从而保证获取道路详细信息。为避免提取特征的分辨率下降,每一层卷积的padding 值与所设置的空洞率维持一致。本文提出的特征提取结构通过设计混合空洞卷积的方式实现了特征增强,能够保证获取道路详细信息。

图3 混合空洞卷积Fig.3 Hybrid atrous convolution

残差结构中空洞卷积表达式如式(3)所示:

其中:D表示空洞卷积的空洞率。

在设置不同空洞率时,感受野会不同,每种空洞卷积能提取对应尺度的特征图,从而获取遥感影像多尺度特征的上下文信息。空洞卷积在尺寸为3×3像素的卷积核中依据超参数填充0,插0 的部分将不参与卷积运算,其运算量和标准卷积相同,即没有增加额外的计算量。当卷积核大小固定,在卷积层叠加时感受野呈现指数级的增长,残差结构中空洞卷积的感受野表达式如式(4)所示:

空洞卷积实际卷积核大小为:

其中:k为原始卷积核大小;r为空洞卷积参数;(r-1)的值为填充0 的个数。通过调节一定范围区间的空洞率,可以有效地控制残差结构中感受野的变换,获取道路细节信息,为融合多尺度特征做足了准备。本文所提出DC-ResUnet 特征提取模型充分利用了这一特性。

1.2 多尺度特征融合网络模型

在遥感影像道路提取的过程中,要充分考虑道路周围其他对象的影响,引入足够的上下文信息及不同感受野下的全局信息。在语义分割方法中需要利用网络深层特征图中的语义信息帮助分类,同时也需要网络浅层特征图中的位置信息帮助定位。由于浅层与深层分辨率一个偏高一个偏低,所以本文设计多尺度特征融合方法将浅层的细节特征与深层的语义特征相结合,凸显两者各自的优势,从而充分利用空间信息提升复杂遥感影像场景下的解析能力。

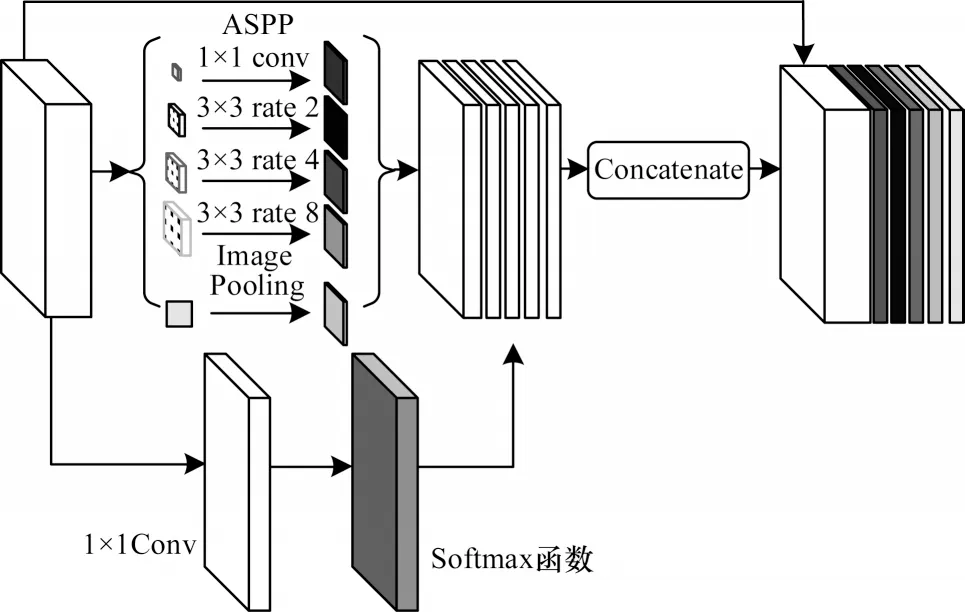

在DC-ResUnet 模型中融入ASPP 模块,将网络中输出的语义特征输入到ASPP 模块中,通过改进并行深度为5 的多个不同比例空洞卷积核、一个尺寸为1×1 像素卷积核以及1 个全局平均池化,得到多尺度特征图,并对其进行融合。针对遥感影像中道路特征具有多尺度的特性,为避免在使用过高的空洞率时忽略小型线性道路的信息,本文设计ASPP 模块中的空洞率分别为2、4、8。ASPP 模块主要借助层级获取全局先验信息,与深度卷积神经网络相结合可以起到很好的优化作用。ASPP 模块的结构如表1所示。

表1 ASPP 模块的结构Table 1 Structure of ASPP module

在特征提取阶段,不同的层级用Mi表示。分别将得到的特征图输入到尺寸为1×1 像素的卷积中,进行通道维度上的降维,通过批归一化(Batch Normalization,BN)和ReLU 激活函数的融合,使用加快模型收敛速度,并对特征图进行整合可以保留更多原图信息,通过双线性插值将特征图尺寸恢复。此外,在DC-ResUnet 编码器提取的特征t4中生成一个具有尺度特征匹配的权重分布,使预测过程中每一个神经元可以有相当大小的感受野尺度契合。

权重分布的表达式如式(6)所示:

在网络结构中使t4与ASPP 模块中每一层得到的特征图一样通过尺寸为1×1 像素的卷积进行通道上的升降维,保证在后续融合的过程中特征图在维度上的尺寸相同。此外,经过Softmax 函数运算得到Mk,特征Mk的每个通道Mki表示在对应层级上的加权映射。多尺度融合模块的框架如图4 所示。

图4 多尺度融合模块的框架Fig.4 Framework of multi-scale fusion module

在多尺度融合模块中,Mki为编码器输出经过加权映射的高层语义特征,t5为通过ASPP 模块融合后上采样输出的特征。随后进行特征拼接,此过程主要在融合过程的通道维度上组成一个特征图。特征拼接的表达式如式(7)所示:

图5 所示为多尺度特征融合的网络结构,可以看出,浅层的细节特征与高层的语义特征进行融合(即上下文信息合并的过程),能够充分利用浅层的特征(比如在提取道路任务中的边缘信息、纹理信息等),改善随着网络的加深,高层网络输出的特征图分辨率逐渐变小而导致的上下文信息损失。最后,对融合后的特征进行3 次上采样聚合,将融合后特征进一步整合得到最后的特征输出,输出的卷积层设计由BN、ReLU 以及Dropout 组成。利用多尺度融合的方式,将编码部分t1~t4作为特征融合的具体模块,其通道数用表示,m表示层数,i表示具体的通道数目。最后,t4的输出特征经过Softmax 层后,再与ASPP 模块输出结果整合,t2、t3和t4通道数由尺寸为3×3 像素的卷积核控制,其余的由尺寸为1×1 像素的卷积核控制。最后将不同层级的融合特征上采样到原始输出大小,与ASPP 模块的输出特征进行拼接。输出的256 个特征映射是通过对tconcatenate上采样聚合和残差模块中所用到的激活函数计算获得。

图5 多尺度特征融合的网络结构Fig.5 Network structure of multi-scale feature fusion

ni的计算公式如式(8)所示:

其中:*表示每次的上采样聚合,聚合后通过跳跃连接到残差模块中。残差模块使用了线性整流函数ReLU 作为激活函数,使用ReLU 激活函数可以避免出现梯度弥散的问题,在输入x>0 时可以控制梯度饱和效应的情况出现。ReLU 激活函数的表达式如式(9)所示:

2 实验结果与分析

本实验基于Keras 深度学习框架设计实现,使用Pycharm 及Anaconda 软件进行程序的编写,实验基于Linux 运行环 境,CPU 为2 个24 核Hygon C86 7165 24-core Processor 处理 器,GPU 采用了ASPEED Graphics Family 16 GB。在此基础上,利用遥感影像数据进行网络训练、测试和验证,印证所提方法面向遥感影像道路提取的突出优势。

2.1 实验数据集与预处理实验

本文实验使用Cheng_Data_Road[27]和Zimbabwe_Data_Roads 这2 个道路数据集,针对地形复杂的地区,该数据集能够提供更加充分的特征信息。Cheng_Data_Roads 数据集涵盖了城市、郊区以及农村地区,其中,224 张遥感影像是从Google Earth 下载的。数据集中的标签均由手动创建,包含大约47 341 公里的道路,其中影像尺寸至少为600×600 像素。Zimbabwe_Data_Roads 是根据Zimbabwe 国家公路特点专门建立的数据集,此数据集通过Bing Maps 收集构建,其相对应的标签由OpenStreetMap标注生成,共包含248 张影像数据,涵盖的城市道路类型远多于Cheng_Data_Roads 数据集,每张影像的尺寸为1 500×1 500 像素。本文对这两套数据均进行了初步的筛选,剔除了影像与标签相差较大的部分,将每张影像以及对应的标签裁剪为224×224 像素,并分别划分为训练集、验证集和测试集。

2.2 评价指标与实验策略

为更好地表征本文方法的性能,选取了语义分割任务中较常用的几种评价指标[28],包括准确率(Precision)、召回率(Recall)、F1 值和交并比(Intersection over Union,IoU)。在定义它们之前,先用混淆矩阵表示每个像素点分类结果的实际意义:混淆矩阵中TTP表示预测为正样本,实际预测正确(正确提取的道路);FFP表示预测为正样本,实际预测错误(错误提取的道路);FFN表示预测为负样本,实际预测错误(预测为背景实际为道路);TTN表示预测为负样本,实际预测正确(预测为背景实际为背景)。本文采用的评价指标公式如下:

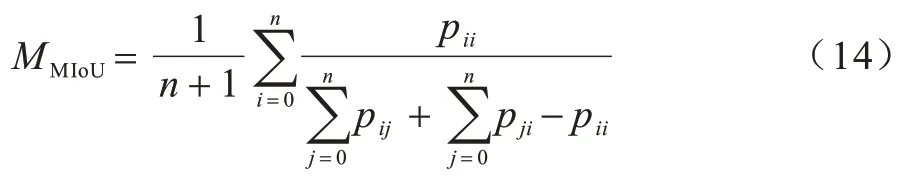

由于本文只针对道路提取,因此只涉及道路和背景两类,在训练过程中保存验证集IoU 指标较高的模型作为最终模型,并使用平均交并比[29](Mean Intersection over Union,MIoU)来评价模型在数据集上的分割效果,计算出遥感影像预测结果与影像真实值的交集和并集之比,MIoU 的表达式如式(14)所示:

其中:n代表标签标记的类别;n+1 表示背景的总类别;pii表示实际为i类预测的像素数量;pij表示实际为i类但预测为j类的像素数量;pji表示实际为j类但预测为i类的像素数量。MIoU 的取值范围为[0,1],MIoU 的值越大,说明预测结果越准确。

本文实验是提取道路二分类问题,此类问题通常采用二分类交叉熵损失函数:

其中:yi为第i个像素的真实值;yi代表该像素属于正样本和负样本的真实概率;ai为第i个像素的预测值,ai取值落于(0,1)内,ai越趋近于1 代表其属于正样本的概率越高。训练的过程即通过不断调整网络的权值参数,使Loss 达到最小的过程。实验采用带动量的随机梯度下降方法进行训练,设置初始学习率为0.000 1,动量为0.96,迭代次数为20 000 次。

2.3 实验结果

2.3.1 Cheng_Data_Roads 数据集实验结果

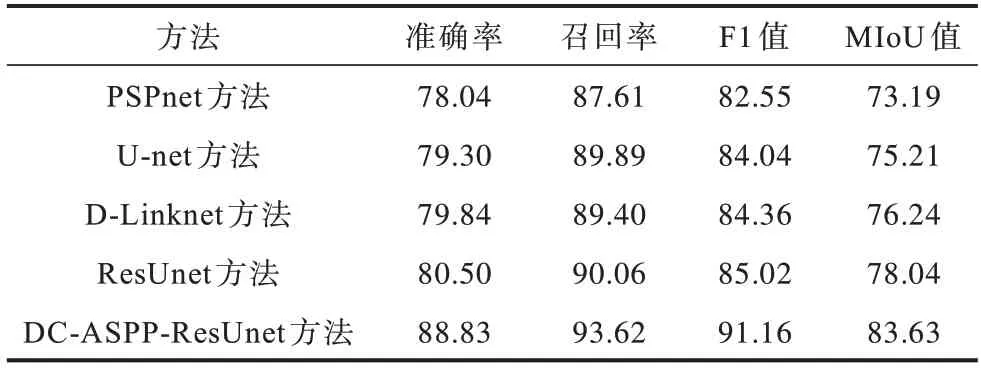

为验证所提方法在Cheng_Data_Roads 数据集下提取道路的有效性,与常用的语义分割方法包括PSPnet[15]、U-net[16]、D-Linknet[21]以 及ResUnet[26]进 行对比实验,实验结果如表2 所示。

表2 不同方法在Cheng_Data_Roads数据集下的实验结果Table 2 Experimental results of different methods under Cheng_Data_Roads data set %

如表2 所示,由于U-net 与D-Linknet 采用编解码网络结构,将编码器中提取的特征复制到相应的解码器中进行融合,因此F1 值相对于PSPnet 高2 个百分点,但对于遥感影像中复杂的道路提取任务,其表现仍然有待提高。PSPnet 在高层语义特征上使用金字塔池化融合全局与局部特征,这在一定程度上弥补了普通卷积神经网络只能获取固定范围特征信息的缺陷,但连续的下采样依旧导致浅层信息丢失过多,所以F1 值和MIoU 值较低。ResUnet 由残差网络与U-net 组成,相比U-net,其表达能力更好。但其在遥感影像提取道路任务中,由于损失了一部分分辨率,导致复杂道路细节部分无法展现。基于ResUnet改进的DC-ASPP-ResUnet 能够获取更加丰富的道路特征信息,并且能够在扩大感受野的同时控制特征映射权重,极大提高道路提取准确率。DC-ASPPResUnet 的各项指标相较于其他方法均高出至少3 个百分点,其召回率、F1 值和MIoU 值与ResUnet 相比分别高出至少3、6 和5 个百分点。

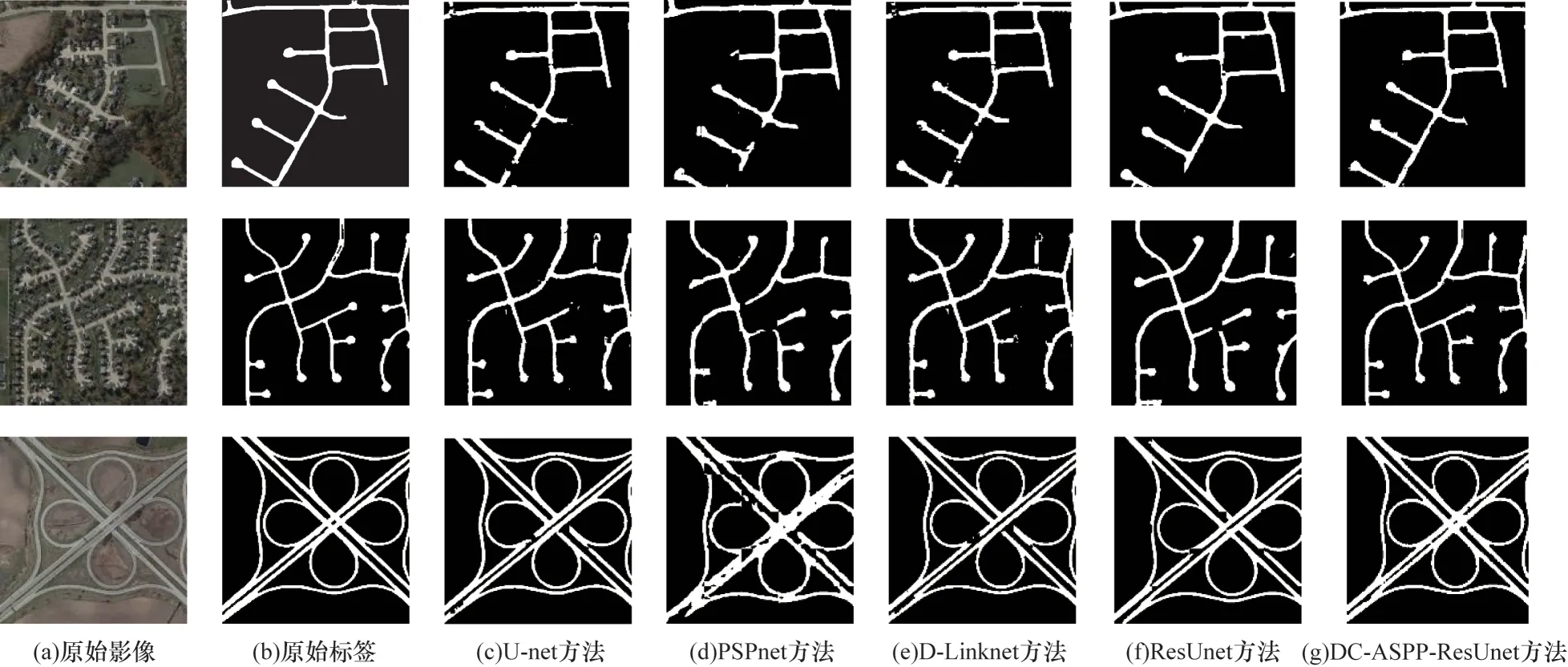

图6 展示了不同方法在Cheng Data-Roods 数据集下提取道路的结果。由图6 可知,U-net 无法对遮挡严重的道路进行提取,且边缘细节部分处理也不到 位。PSPnet、D-Linknet 和ResUnet 无法完 整提取道路交汇连接处,对于小目标道路的提取也较为困难。针对道路整体结构、形状以及模型的泛化性和鲁棒性,PSPnet、D-Linknet 和ResUnet 这3 个方法均存在不同程序的问题,而DC-ASPP-ResUnet 的预测结果展现出相对平滑和完整的道路结构,并且在道路交汇和连接处的提取也很准确,很少出现不连续和错误识别的情况。实验表明,与上述网络相比,本文方法提高了道路提取结果的整体效果。

图6 不同方法在Cheng_Data_Roads 数据集下的结果展示1Fig.6 Results display of different methods under Cheng_Data_Roads data set 1

2.3.2 Zimbabwe_Data_Roads 数据集实验结果

为进一步验证本文方法在不同路况下的表现,改用Zimbabwe_Data_Roads 影像数据集,该数据集中的影像比Cheng_Data_Roads 具有更高的分辨率,道路更加复杂多变,宽窄变换更加频繁,且有不同程度的遮挡情况,所以该数据集与显示的城市道路情况更加契合。在这样的条件下,道路提取任务也会变得更加困难。不同方法在该数据集下的实验结果如表3 所示。由表3 可以看出,本文所设计的DCASPP-ResUnet 在各项实验指标对比中至少比其他方法高2 个百分点。PSPnet 在此数据集中的表现优于U-net,这是因为PSPnet 通过金字塔池化聚合不同区域的上下文信息,提高了获取全局信息的能力。

表3 不同方法在Zimbabwe_Data_Roads数据集下的实验结果Table 3 Experimental results of different methods under Zimbabwe_Data_Roads data set %

图7 所示为不同方法在Zimbabwe_Data_Roads数据集下的结果展示。由图7 可知,与U-net 和PSPnet 相 比,DC-ASPP-ResUnet 可以更 准确地识别道路区域,几乎没有不干净的点状。相比较DLinknet 和ResUnet 的道路提取结果,DC-ASPPResUnet 可以更完整地提取道路,这着重体现在道路的边缘和交汇处可以克服由于地物尺度导致的差异性。所以,这进一步表明在面对复杂的遥感影像数据集时,所提方法可以更好地关注道路细节、边缘以及不连续等问题。

图7 不同方法在Zimbabwe_Data_Roads 数据集下的结果展示1Fig.7 Results display of different methods under Zimbabwe_Data_Roads data set 1

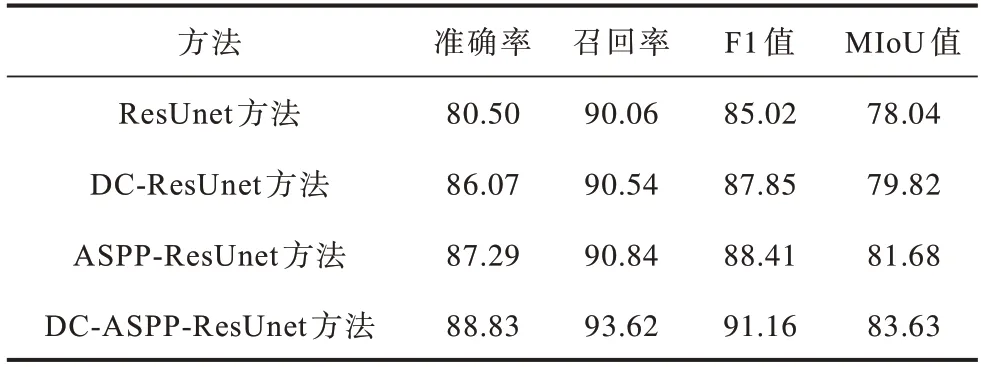

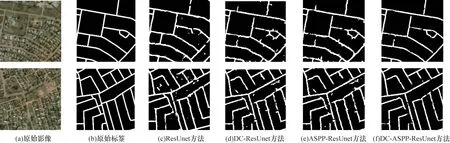

2.3.3 本文方法的结果分析

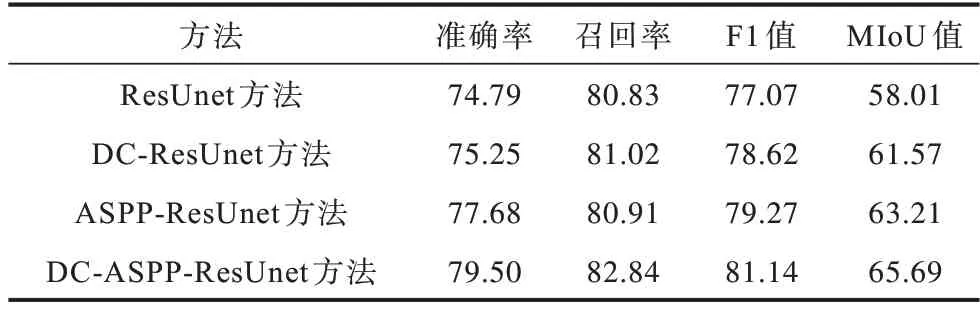

为更好地验证本文所提DC-ASPP-ResUnet 道路提取方法中各模块对网络有效性的影响,分别将深度残差网络ResUnet[26]、融合混合空洞卷积的DC-ResUnet、融 合ASPP 模块的ASPP-ResUnet以及所提出的DC-ASPP-ResUnet 在Cheng_Data_Road 和Zimbabwe_Data_Roads 数据集下进行对比实验。实验结果如表4 和表5 所示,其中准确率表明检测到的道路像素数值是参考原始影像和标签中的道路像素的概率,而召回率表明原始影像和标签中所有道路像素的数值被准确检测的概率。

表4 Cheng_Data_Roads 数据集下的实验结果Table 4 Experiment results under Cheng_Data_Roads date set %

表5 Zimbabwe_Data_Roads 数据集下的实验结果Table 5 Experiment results under Zimbabwe_Data_Roads date set %

通过表4 和表5 可以看出,DC-ResUnet 和ASPPResUnet 在2 个数据集上的各项评价指标数值均高于ResUnet。在Cheng_Data_Roads 数据集上DCResUnet 和ASPP-ResUnet 的F1 值 和MIoU 值 与ResUnet 相 比,分别高 出2.83 和1.78 个百分 点;在Zimbabwe_Data_Roads 数据集 上,与ResUnet 相 比,至少高1.55 和3.56 个百分点。由图8 和图9 可以看出,DC-ResUnet 和ASPP-ResUnet 相 比ResUnet 的 提取道路完整性有一定的提升,尤其是能够准确预测在道路局部拐点位置。与ResUnet 相比,DC-ASPPResUnet 在道路提取完整性上有较大提升,提升效果比DC-ResUnet 和ASPP-ResUnet 更 优,在Cheng_Data_Roads 数据集上的F1 值和MIoU 值分别提高了6.14 和5.59 个百分 点;在Zimbabwe_Data_Roads 数据集上的F1 值和MIoU 值分别提高了4.07 和7.68 个百分点。主要原因是DC-ASPP-ResUnet 通过结合优化特征提取和融合多尺度特征2 个模块,并利用提取特征加权映射到ASPP 模块的方式进行浅层和深层道路特征信息的多尺度特征融合,可以更完整地凸显道路整体结构。由图8 和图9 可以看出,DC-ASPP-ResUnet 能够更准确地预测道路的宏观线条和交叉点,并且能够消除大部分的点状,即像素的识别分类能力更强。

图8 不同方法在Cheng_Data_Roads 数据集下的结果展示2Fig.8 Results display of different methods under Cheng_Data_Roads data set 2

图9 不同方法在Zimbabwe_Data_Roads 数据集下的结果展示2Fig.9 Results display of different methods under Zimbabwe_Data_Roads data set 2

2.3.4 DC 自参数分析

由于本文网络采用了混合空洞卷积的架构,因此在增大空洞率的同时能够评估数值是否有所提升。为保证感受野的连贯性,串联的空洞卷积空洞率之间的公约数需小于1,以增大最后一层的参数为基准。用Di表示调节的参数,比如D的初始值分为别为1、2、3。

如图10 和图11 所示,在增大参数值的条件下,无论是在Cheng_Data_Roads 数据集还是道路更复杂的Zimbabwe_Data_Roads 数据集下,本文方法的F1 值和MIoU 值均表现出持续上升的趋势。为防止过拟合的发生,把D参数值控制在8 以内。这是因为通过提高参数值会使感受野逐步增大,且获取道路不同尺度的信息范围也逐渐变大,所以预测结果呈现上升趋势,最终感受野覆盖整个特征区域,并在D1=6、D2=7、D3=8 时结果最优,即达到峰值。利用混合空洞卷积的思想设计残差模块以扩大感受野的范围,逐渐增大的空洞率能够使计算更密集,增强对不同尺度特征的学习。将提取特征在输入ASPP 模块之后输出,并进行多尺度的特征融合,可以最大程度地保留道路上下文信息,且提取效果也有较大提升,保留了道路的细节特征信息。

图10 Cheng_Data_Roads 数据集的自参数分析Fig.10 Self-parameter analysis of Cheng_Data_Roads date set

图11 Zimbabwe_Data_Roads 数据集的自参数分析Fig.11 Self-parameter analysis of Zimbabwe_Data_Roads date set

3 结束语

本文提出基于深度残差网络的多尺度特征融合遥感影像道路提取方法。通过在特征提取阶段设计混合空洞卷积以增大感受野,引入ASPP 模块获得多种不同尺度的特征信息,从而捕获更完整的道路信息。提取的特征经过上采样得到与输入图像一致的大小,与通过加权映射的浅层特征进行特征融合,提高预测精度。在Cheng_Data_Roads 和Zimbabwe_Data_Roads 两种数据集上的实验结果表明,与现有的ResUnet、PSPnet、U-net 等方法相比,本文方法提取的道路更具完整性和连续性,所得到的预测结果噪声更少。下一步将通过探索更符合的注意力机制,提升本文方法的适用范围,使其能够应用在建筑物、河流、农田等多场景的提取任务中。