基于T2DR-Net和互信息的光学-CT图像配准方法研究

崔建良,陈春晓,陈志颖,姜睿林

(南京航空航天大学生物医学工程系,南京 211106)

引言

荧光分子断层成像技术[1](fluoresence molecular tomography,FMT)是光学分子成像的重要分支[2],它通过向生物体注射特异性荧光探针[3],并利用外源激发光使荧光分子发出荧光,实现对目标区域的显影。FMT成像具有灵敏度高、无电离辐射、可实时动态成像等优点,在肿瘤早期检测、药物疗效评估等方面具有广泛的应用[4-6]。然而,在进行活体小动物FMT成像时,为了获得小动物体内光源的结构信息,需要进行二维光学图像与三维CT图像的配准。通过FMT和CT双模态数据的配准及图像融合,不仅可以获取生物体组织的结构信息,而且可以深入到细胞和分子水平对病灶进行检测[7]。

FMT和CT图像的配准,即实现FMT系统中的二维白光图像与三维CT图像的配准。目前,2D-3D图像配准大致分为基于特征的配准和基于灰度的配准[8]。基于特征的配准往往需要人工参与,精确性和鲁棒性低[9]。基于灰度的配准[10]是利用投影算法获取3D图像的投影像,然后利用搜索算法获得最优的相似性测度,进而得到配准参数。在二维和三维图像配准的研究中,顾吉、焦培峰等[11-12]利用CT体数据的数字影像重建图像(digitally reconstructed radiograph, DRR)实现X光和CT图像的配准。李玲芝等[13]提出了由混合几何和图像密度特征构成的相似度度量函数,对术前CT和术中X射线图像进行快速2D-3D配准。王杨[14]针对归一化互相关算法信息单一、收敛域较小的问题,引入高斯拉普拉斯二阶微分算子和一阶Sobel算子作为相似性测度进行配准。此外,蒙特卡洛方法[15]、遗传算法[16]、退火算法[17]等作为搜索策略也广泛应用于2D-3D图像配准中。

近年来,深度学习在图像处理方面取得了显著的成就,在图像配准方面也显示出独有的优势[18]。在医学图像的配准方面,基于卷积神经网络框架,曾安[19]实现了CT-MR图像的配准;沈延延[20]实现了双X射线影像2D-3D的配准;陈向前[9]实现了盆骨CT图像与X光图像的配准。为了实现FMT成像系统中生物体内荧光图像与CT图像的融合,本研究提出了基于T2DR-Net和互信息的光学-CT图像配准方法。

1 材料与方法

本研究提出的光学-CT图像配准模型主要分为基于T2DR-Net的粗配准和基于互信息的精配准两个部分,见图1。其中粗配准主要包括FMT白光图像纹理转换模块、CT数据投影模块及DenseReg-Net配准模块,精配准主要包括空间几何变换模块及互信息配准模块。

图1 基于T2DR-Net和互信息的光学-CT图像配准框架Fig.1 Optical-CT image registration framework based on T2DR-Net and mutual information

1.1 基于CycleGAN的小鼠纹理迁移模型

课题组研制的FMT系统(animal optical imaging system, AOIS,南京航空航天大学)可获取相同坐标系下小鼠体表的二维白光图像、荧光图像以及融合图像,见图2(a)—图2(c)。结合CT数据,通过白光图像或荧光图像与CT图像的配准,利用CT数据体表的荧光分布逆向求解,便可得到小鼠体内光源的大小和位置,见图2(d)—图2(f)。由于白光图像的纹理更接近CT图像,因此,本研究首先利用白光图像与CT图像配准,然后进一步实现荧光图像与CT图像的配准和融合。然而,FMT白光图像不能准确获得其相对于CT图像的旋转参数,而CT体数据可以通过平移和旋转得到不同角度的投影图,因此,选择CT数据二维投影像作为DenseReg-Net实现二维白光图像与三维CT图像配准的样本集。

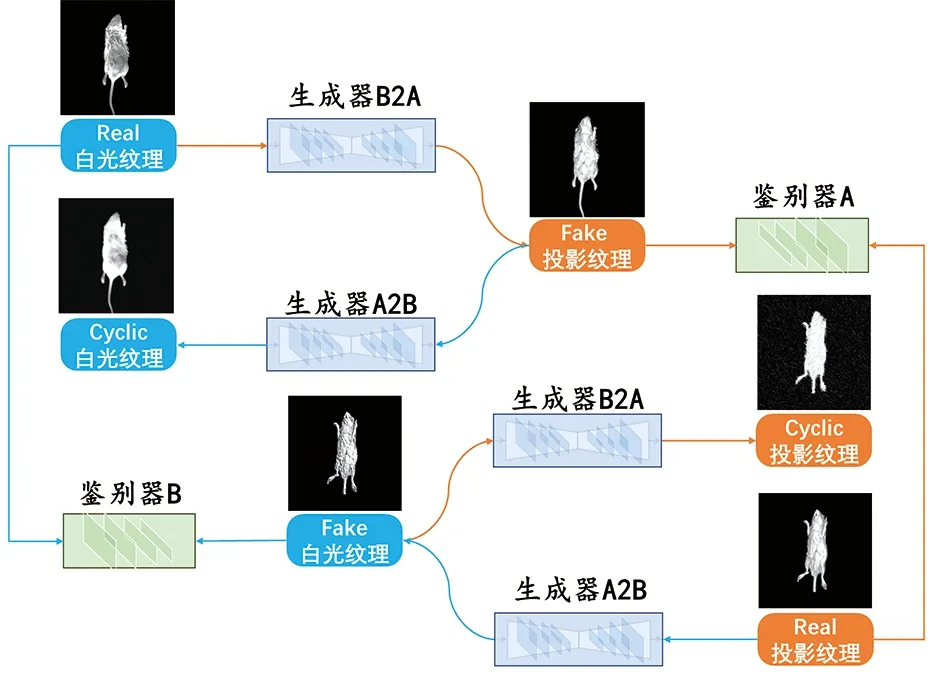

由图2可知,小鼠FMT白光图像与CT数据二维投影像的纹理仍存在较大差异,为了降低图像纹理信息对DenseReg-Net模型预测结果产生的干扰,本研究设计了基于CycleGAN的小鼠纹理迁移网络,进行白光图像和CT数据二维投影像间的纹理转换,网络结构见图3。

图2 FMT在体光源重建流程(a).FMT白光图像;(b).FMT荧光图像;(c).白光-荧光融合图像;(d).CT体数据;(e)FMT-CT融合图像;(f).在体光源重建Fig.2 In vivo light source reconstruction process of FMT (a).white light image of FMT;(b).fluorescence image of FMT; (c).fusion image of white light image and fluorescence image;(d).volume data of CT;(e).fusion image of FMT and CT;(f).in vivo light source reconstruction

图3 基于CycleGAN的小鼠纹理迁移网络Fig.3 Mouse texture transfer network based on CycleGAN

在CycleGAN模型中,生成器A2B将CT数据二维投影像纹理转化为FMT白光图像纹理,生成器B2A将FMT白光图像纹理转化为CT数据二维投影像纹理,两个生成器形成对偶学习的架构。鉴别器A的作用是分辨输入图像的纹理是真实的投影像纹理还是生成器生成的投影像纹理,从而引导生成器B2A生成更加真实的CT数据二维投影像纹理。鉴别器B则引导生成器A2B生成更加真实的FMT白光纹理。除去生成器和鉴别器之间的生成对抗外,模型还添加了循环生成图像与真实图像之间的循环重建损失[21],用于约束图像转化过程的结构一致性。

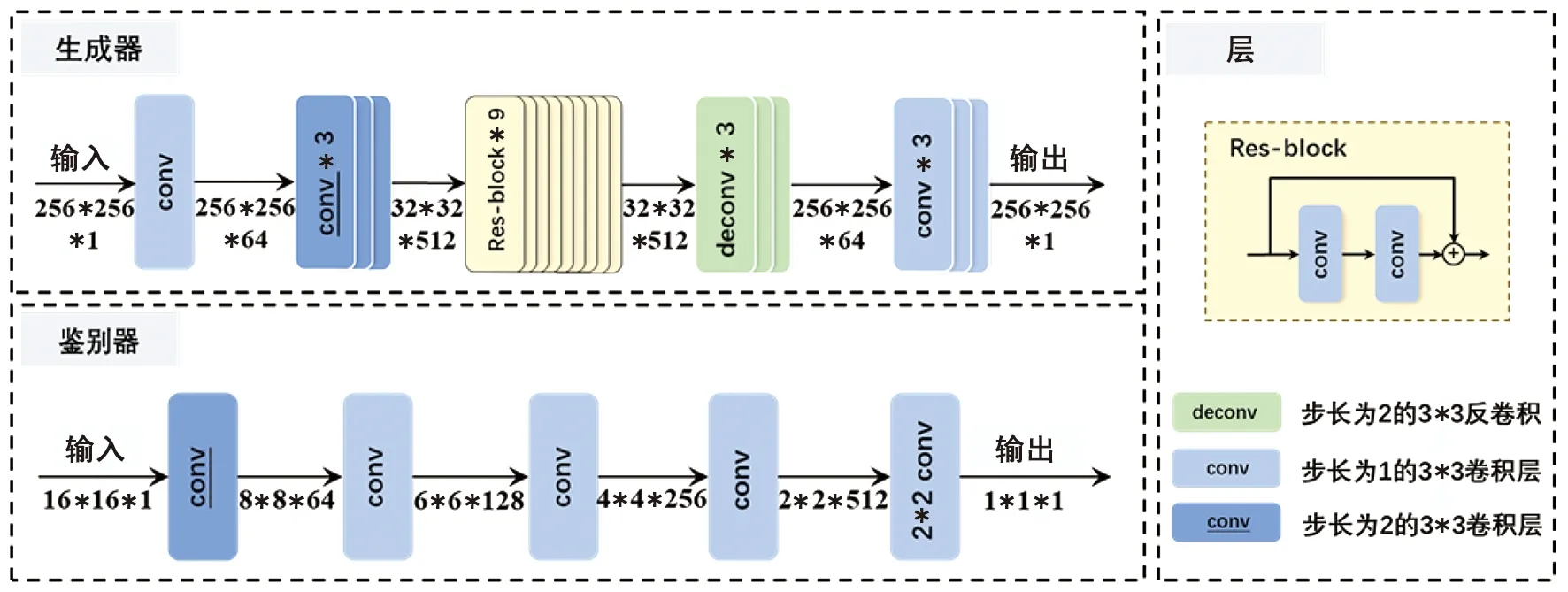

本研究设计的生成器和鉴别器结构见图4。生成器由编码器、转换器和解码器构成。其中编码器利用卷积神经网络从输入图像中提取特征,将图像压缩成512个32×32的特征图;转换器借助Res-Block结构通过组合图像的不相近特征,将图像在FMT白光域的特征图转换为CT数据二维投影域中的特征图;解码器利用反卷积层[22]从特征向量中还原出低级别的特征并重构图像。鉴别器取真实图像和生成器输出图像的前景部分进行分割切块[23],利用五层卷积从16*16的切块图像中提取特征,并判断其纹理是否与CT数据二维投影像的纹理一致。

图4 生成器及鉴别器网络结构图Fig.4 The network structure of generator and discriminator

基于CycleGAN的小鼠纹理迁移网络的目标函数为:

L(G,F,DX,DY)=LGAN(G,DY,X,Y)+

LGAN(F,DX,Y,X)+λ·Lcyc(G,F)

(1)

其中,X是指FMT白光图像,Y是指CT数据的二维投影像,G是生成器B2A,F是生成器A2B,DX是判别器B,DY是判别器A。对式(1),期望通过训练实现以下目标:

(2)

式(1)中,LGAN(G,DY,X,Y)是为了使生成器B2A依据FMT白光图像生成的投影像纹理与真实的投影像纹理尽可能相似,其表达式为:

LGAN(G,DY,X,Y)=Ey~pdata[logDY(y)]+

Ex~pdata[log(1-DY(G(x)))]

(3)

LGAN(F,DX,Y,X)是为了使生成器A2B 生成的FMT白光图像纹理与真实的白光图像纹理尽可能相似,其表达式为:

LGAN(F,DX,Y,X)=Ex~pdata[logDx(x)]+

Ey~pdata[log (1-DX(G(y)))]

(4)

Lcyc(G,F)是两个生成器之间的循环损失,使生成器A2B和B2A的输入和输出结构保持一致,其表达式为:

(5)

1.2 基于DenseReg-Net的双模态图像粗配准

在进行FMT白光图像与小鼠CT图像粗配准时,通常是对CT体数据进行空间变化,生成二维投影像,然后根据相似性测度进行2D-2D图像配准,从而得到二维图像与三维体数据间的配准参数,但这种配准方法耗时长,实际应用具有一定的局限性。为此,本研究提出了基于Dense-Block的2D-3D图像配准网络DenseReg-Net,网络结构见图5。DenseReg-Net网络将2D-3D的配准视作分类问题,其输入是CT体数据图2(d)绕x、y、z三个轴旋转得到的投影像,分类标签分别是投影像绕x、y、z三个轴的旋转参数θx、θy、θz,并以1°为一类进行分类。

图5 DenseReg-Net网络结构图Fig.5 The network structure of DenseReg-Net

图像输入DenseReg-Net网络后,经过四层步长为2的卷积层进行下采样来提取图像浅层特征,并整合特征信息,然后通过两个连续的密集连接块—卷积—均值池化结构以提取图像深层特征并进行特征融合,最后通过一层卷积层和一个全局均值池化层得到输出结果。网络核心部分是Dense-Block模块,Dense-Block块中的两个相连的卷积层作为一个子块,其中第一个卷积层进行1*1的卷积操作,用于合并输入特征,第二个卷积层进行3*3的卷积操作,用于提取特征。任何两个子块间都有直接连接,即网络中每一子块的输入都是前面所有子块输出的并集,而这一层学习到的特征也会被直接传递到后面的所有层作为输入。Dense-Block具有缓解梯度消失、加强特征传播、减少过拟合及参数个数等优势。

1.3 基于互信息的双模态图像精配准

1.4 数据集获取及预处理

取实验室饲养的ICR磁性小鼠,实验前用5%水合氯醛(400 mg/kg,腹腔注射)将其麻醉并采集CT数据和FMT白光图像。在此期间所有的动物实验程序都按照南京航空航天大学动物保护与伦理委员会批准的程序进行。

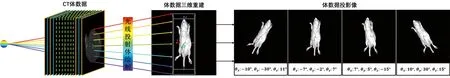

1.4.1CT数据二维投影像获取及预处理 使用苏州海斯菲德信息科技有限公司的CT设备Hiscan VM(分辨率35 μm;X射线源40~80 kV,40 W;探测器1 500×1 128)获取小鼠CT图像2 091张。使用光线投射算法进行CT图像三维重建,然后对三维重建结果绕x、y和z轴依次进行旋转,获取其旋转后的CT投影像,见图6。采集CT和FMT双模态图像时,小鼠姿态尽量保持一致,根据摆放时可能产生的位置误差,设置误差范围分别为θx(-10°,10°),θy(-30°,30°),θz(-15°,15°),每旋转1°获取一张图像,共得到39 711张CT投影像。同时设置DenseReg-Net分类网络对θx的分类数为11,对θy的分类数为61,对θz的分类数为31。

图6 体数据三维重建及投影结果Fig.6 3D reconstruction of volume data and projection results

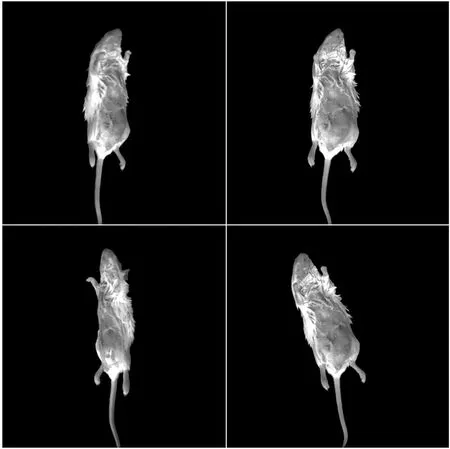

1.4.2FMT白光图像获取及预处理 利用课题组研制的活体小动物三维荧光成像系统AOIS(250 W氙灯光源,PI1024B型CCD,分辨率1 024×1 024,单个像素尺寸13 μm×13 μm)获取不同角度下的1 330张白光图像,见图7。

图7 利用AOIS系统获取的白光图像Fig.7 White light images of obtained by AOIS system

1.5 参数设置及训练策略

实验中用于网络训练的硬件配置:CPU型号Intel Core i9-9900X,主频3.5 GHz,20核;显卡为NVIDIA GeForce GTX 2080Ti,11 G;内存为64 G,频率2 666 MHz。软件环境:操作系统为Windows 10,64位;深度学习框架为TensorFlow-GPU 1.13.0;使用Cuda10和Cudnn7.4进行网络训练加速;Pycharm2019作为IDE,采用的编程语言为Python,同时用于数据处理的软件包括Matlab R2019a,Microsoft Visual Studio 2010,Microsoft Visual Studio 2015等。

1.5.1小鼠纹理迁移网络训练策略 实验的样本集为1 330张光学图像和39 711张CT投影像。在进行CycleGAN的小鼠纹理迁移网络训练时,将FMT白光图像1 330张按照9:1的比例进行分配,即训练集1 197张图像,测试集133张图像,并将训练集使用旋转、翻转等图像增强方式将其扩展5倍至5 985张图像。同时从CT体数据投影像中随机挑选5 985张图像作为训练集的标签,133张图像作为测试集的标签。网络训练设置的批处理大小(Batch Size)为20。神经网络卷积层的参数使用He方法进行初始化,网络使用Adam优化器进行梯度更新,学习率初始设置为0.0001,每训练10个epoch学习率减少5%。

1.5.2DenseReg-Net网络训练策略 进行DenseReg-Net网络训练时,将39 711张CT投影像按照4:1的比例进行分配,即训练集31 768张,测试集7 942张。训练设置的批处理(Batch Size)大小为25。神经网络卷积层的参数使用截断的正态分布进行初始化,方差设置为0.1,L2正则化系数为0.005。网络使用Adam优化器进行梯度更新,学习率初始设置为0.01,每训练10 000个epoch学习率减少4%。DenseReg-Net训练用到的损失函数包含两部分,分别是交叉熵损失函数和L2范数正则项。

2 实验结果及分析

2.1 小鼠纹理迁移结果

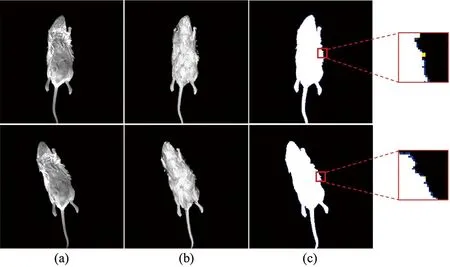

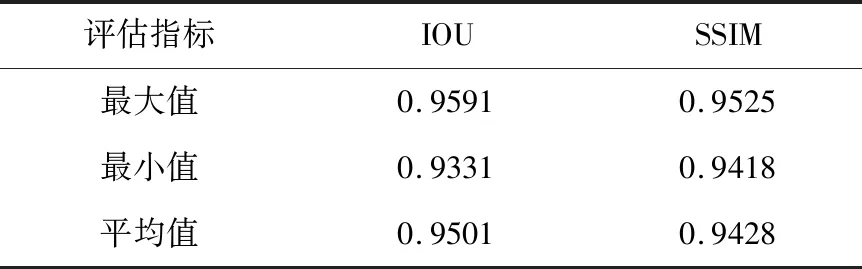

基于CycleGAN的小鼠纹理迁移模型实验结果见图8,其中图8(a)和图8 (b)分别为FMT原始白光图像和使用CycleGAN网络进行纹理迁移后的图像。图8(c)是两种图像二值化处理后的融合图像。图8(c)放大以后可以看出,两种图像在边界处存在细微的差异,见图中黄色和蓝色所示部分。两种风格二值图像的结构相似性[25](structural similarity, SSIM)和交并比[26](intersection over union, IOU)见表1。由表1数据可知,经过CycleGAN纹理转换的图像与原图像的IOU和SSIM均达到0.9以上。

图8 基于CycleGAN的小鼠纹理迁移模型实验结果 (a).原图像;(b).纹理迁移结果;(c).原图与迁移结果融合图像Fig.8 Experimental results of mouse texture transfer model based on CycleGAN(a).original Images; (b).results of texture transfer; (c).fusion image of original images and texture transferred images

表1 基于CycleGAN的小鼠纹理迁移模型结果Table 1 Results of mouse texture transfer model based on CycleGAN

2.2 图像配准结果

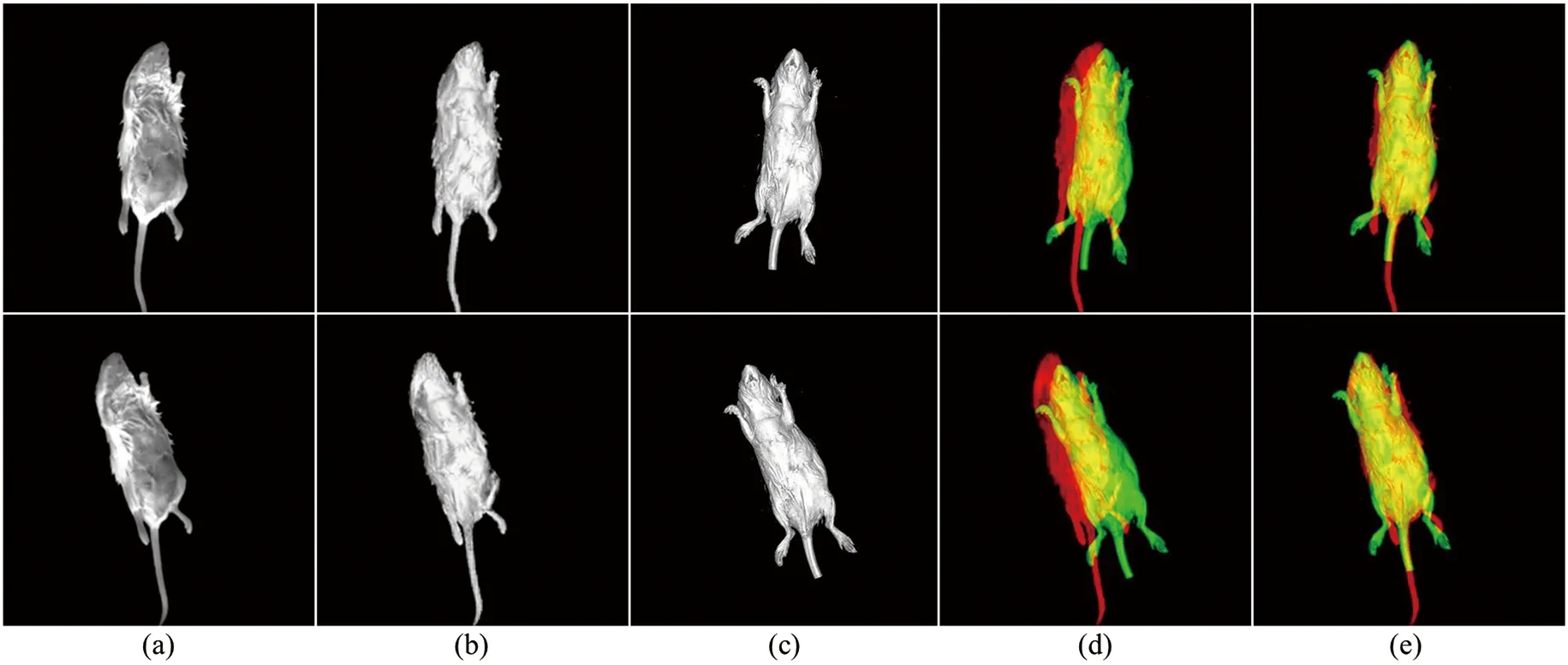

图9给出配准流程中的部分示例,其中图9(a)为待配准图像,经过小鼠纹理迁移模型得到图9(b)的结果,图9(c)是基于DenseReg-Net粗配准的结果。通过图9(d)的粗配准融合结果可以看出,利用DenseReg-Net模型进行粗配准后,仍有较大的误差,粗配准结果经互信息方法进行精配准后,见图9(e),配准精度有了很大的提高。

图9 基于T2DR-Net和互信息的图像配准流程(a).待配准图像;(b).纹理迁移结果;(c).粗配准结果;(d).粗配准融合结果;(e).精配准融合结果Fig.9 Image registration process based on T2DR-Net and mutual information(a).images to be registered;(b).results of texture transfer;(c).rough registration results;(d).fusion results of rough registration;(e).fusion results of fine registration

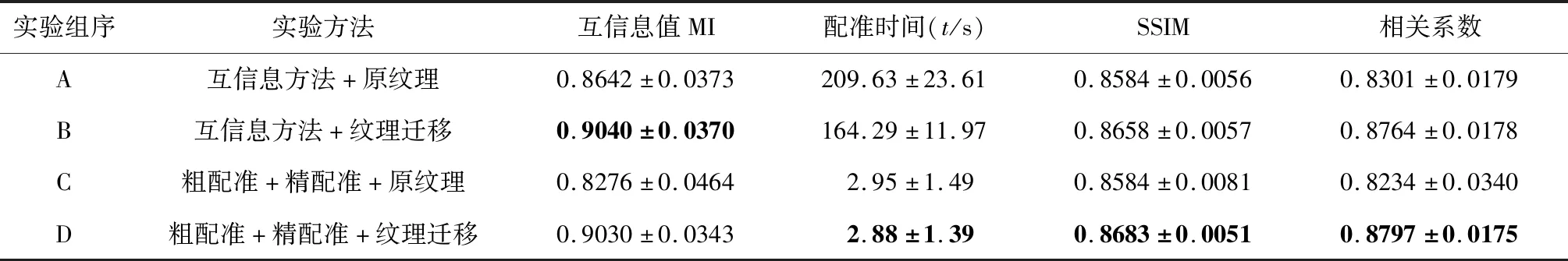

为了验证本研究提出的白光图像与CT图像的配准方法,设计了“互信息方法+原纹理”、“互信息方法+纹理迁移”、“粗配准+精配准+原纹理”和“粗配准+精配准+纹理迁移”四组对照实验,配准结果见图10,并以互信息值、配准时间、SSIM和相关系数作为客观评价指标,评价结果见表2。

图10 不同方法FMT白光-CT图像配准的结果(a).互信息+原纹理;(b).互信息+纹理迁移;(c).粗配准+精配准+原纹理;(d).粗配准+精配准+纹理迁移Fig.10 Registration results of white light images of FMT and CT images with different methods(a).mutual information with original texture; (b).mutual information with texture transferred; (c).rough and fine registration with original texture; (d).rough and fine registration with texture transferred

由表2的四组对照实验可知,在进行白光和CT两种模态图像配准前,利用CycleGAN网络对白光图像进行纹理转换,生成类似CT投影像的二维图像,可以降低不同风格图像配准时由于纹理带来的干扰,有效提高图像配准的精度;其次,利用本研究提出的基于DenseReg-Net的粗配准和基于互信息的精配准方法,在保证配准精度的情况下,配准速度有了很大提升。

表2 不同方法FMT白光图像与CT图像的配准结果Table 2 Registration results of white light images of FMT and CT images with different methods

3 讨论

FMT白光图像和CT图像配准是FMT成像系统的重点和难点之一。见图2(a)和图2(d),FMT光学图像和CT图像在成像原理、图像风格以及图像维度等方面存在较大差异,传统方法对其配准存在配准精度不高、容易陷入局部最优解而导致配准稳定性差、配准时间长以及需要人工参与旋转过程等问题。基于此,本研究提出了一种基于T2DR-Net和互信息的图像配准方法来实现FMT白光图像和CT图像的高精度快速配准。本研究对比了各核心模块对FMT白光图像和CT图像配准结果的影响。

3.1 基于CycleGAN的小鼠纹理迁移模块

本研究提出的小鼠纹理迁移模块结果见图8和表1,本模块在保证结构信息基本不变的前提下改变了小鼠的纹理。通过对比表2中A/B和C/D这两组对照实验的结果可以得出,使用经过小鼠纹理迁移模型进行风格转换后图像的配准效果,基于互信息的传统方法和本研究提出的方法,在互信息值、SSIM、相关系数和配准时间等指标上均优于直接使用FMT白光图像进行配准的结果。由此可见,针对不同风格图像进行配准时,采用风格迁移对图像进行预处理,可以有效降低图像配准的难度,提升配准精度和配准速度。

3.2 基于DenseReg-Net的粗配准模块

将进行风格迁移后的FMT白光图像送入DenseReg-Net得到粗配准结果,并与原图进行图像融合后发现,配准结果在位置和角度上还存在一些误差,见图9(d)。究其原因,本研究采用DenseReg-Net训练时,以1°为一类进行划分,当角度小于1°时,其识别能力将大幅度减弱。虽然DenseReg-Net得到的粗配准结果存在一定的误差,但利用DenseReg-Net训练后的模型进行粗配准,能够有效降低配准所需要的时间。

3.3 精配准模块

为减少粗配准阶段的误差,本研究在DenseReg-Net后添加了基于互信息的精配准模块。添加此模块后,其配准结果见图9(e)。对比图9(d)和图9(e)的结果可知,精配准模块对粗配准的结果进行校正后,配准精度有了很大的提升,能够达到AOIS系统配准要求。

通过对比B/D这组对照实验可以得到,本研究提出的基于T2DR-Net和互信息的图像配准方法虽然在互信息值方面略低于传统的基于互信息的图像配准方法,但是其SSIM和相关系数都优于传统方法,并且其配准速度提升了大约60倍,基本上能够满足实时性的要求。除此之外,本研究方法实验结果的标准差更小,证明本方法的鲁棒性更好,配准效果更加稳定。另外,通过对比A/C两组对照实验可以得出,在未经过风格转化时,“互信息方法+原纹理”的结果优于“粗配准+精配准+原纹理”的方法,说明神经网络对训练集图像的纹理特征敏感,使用未经过风格转化的图像进行测试时,原纹理会对其产生干扰,影响最终的配准结果。从而进一步证明了采用神经网络模型实现不同风格图像配准时引入迁移模块的必要性。

4 结论

针对二维光学和三维CT图像成像原理、图像风格以及图像维度不同而导致配准困难的问题,本研究提出了一种基于T2DR-Net和互信息的光学—CT图像配准方法。该方法将2D-3D图像配准分解为基于T2DR-Net的粗配准和基于互信息的精配准两个阶段,在粗配准阶段利用DenseReg-Net提取图像深层特征以获取配准参数,并将基于CycleGAN的纹理迁移方法引入到粗配准阶段以提高配准精度;在精配准阶段利用Powell算法进一步进行配准校正,得到最终的配准参数。实验表明,本研究提出的配准方法能够在保证较高配准精度的情况下大幅度提高配准速度。