基于移动边缘计算的车联网资源分配方案研究

欧阳中辉,冯韶华,凌云峰,陈青华

(海军航空大学, 山东 烟台 264001)

1 引言

随着近年来,智能化各军种联合作战体系的建设已成为各国军队的发展趋势。为实现对多兵种多编队的作战资源进行辅助指挥及决策,实时观测战场态势,军用通信系统的发展至关重要。未来战争对军用5G、军用物联网等战场通信有更高要求,作战系统必须具备快速的信息交互能力和强大的计算能力,能低时延地完成各作战单元的海量数据处理和分析。

智能化战场通信的问题主要体现在通信传播、通信时延以及能耗3个方面。军队由于数据传输稳定性差,保密要求高等特点,加上数据集中式的指挥中心并不能适应复杂多变的战场环境,现阶段以云计算应用为核心的指挥信息系统大大受限,无法满足海量数据的处理。使用边缘计算在靠近数据源的位置进行处理,可以很好地解决这一问题,也与现阶段改革使作战单位要有独立行动能力的目标相符。

得益于现代通信事业的不断发展,边缘计算近年来得到了迅速发展。在国外,美国国防部高级研究计划局(DARPA)2017年资助了DCOMP重点项目,探究边缘计算在军事领域应用;2019年,亚马逊以AWS Greengrass进军边缘计算设备,走在行业前面。同期微软、谷歌也聚焦于边缘的人工智能应用和边缘物联网设备开发两大领域。在国内,除了腾讯、阿里、百度等公司开始研究边缘计算外,我国还从国家层面对边缘计算展开了政策规划和科研布局。其实自从疫情以来,远程办公室进行大量的数据处理和存储,而运用边缘服务端能减少网络宽带承受的巨大压力,即靠近源的数据处理的方法,就是边缘计算一种体现。

车联网领域是边缘计算重要的研究热点,本文以现代民用物联网发展作为背景,为提供低时延的移动服务,对资源分配、任务卸载优化,提出了一种基于分层MEC(mobile edge computing)的车联网方案,致力于战场环境智能特种车辆的指挥决策提供有效方法,也希望为其他军事装备类似功能的升级改造贡献思路。

2 边缘计算车联网系统

2.1 边缘计算网络构架

车联网(internet of vehicles)是由车辆位置、速度和路线等信息构成的巨大网络,是互联网的一种扩展范式。随着第五代移动通信技术的突飞猛进,依托军用5G、WIFI等无线通信技术建造稳定的军事车联网已成为可能。

传统特种车辆网络中,车辆上的基础装备设施都配备了智能设备,特种车辆通过智能设备从周围收集信息,再通过无线通信设备统一上传到指挥中枢的云端进行处理,但由于计算能力受限、传输时延过大等问题,作战单位得不到及时反馈,严重影响战时行动。移动边缘计算(mobile edge computing,MEC)使计算任务能够在网络边缘执行,已经成为云计算的有效补充。在MEC技术的推动下,智能设备上的计算任务被卸载到边缘计算设备(edge computing device,ECD)上,这些设备比云平台更接近智能设备,由于每个ECD中都有一台服务器通过将工作负载卸载到ECD来辅助数据处理,数据传输时间大大缩短,车联网用户的体验质量得到了极大的提高。

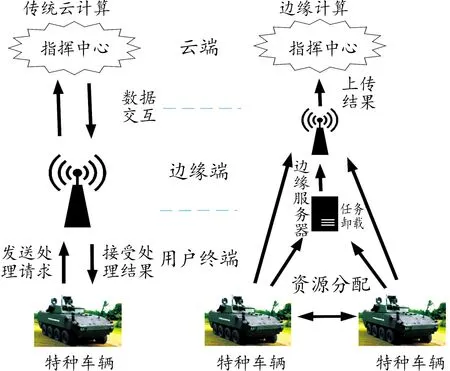

以民用车联网络架构的基本原理和思路为参考,建设特种车辆网络架构。在传统的车联网框架中,从云扩展到边缘端,设计了一种基于MEC的层次化车联网网络体系结构,其原理如图1所示。在自底向上的视图中,该体系结构可明确看出边缘计算架构和传统云计算架构的区别。

图1 车联网网络体系结构原理示意图Fig.1 Schematic diagram of vehicle networking edge computing framework

该体系结构由3层组成:用户终端、边缘端和云端。

1) 用户终端:该层由路边单元和路边单元通信范围内的车辆组成。在作战方面即有位置动态感知和数据传输接入点的特种车辆组成。

2) 边缘端:每个基站配备一个MEC服务器,为那些卸载的任务提供管理和计算服务。每个MEC服务器包含一定的资源计算能力。

3) 云端:云层是远离车辆,拥有一系列多功能服务组成的系统,一般部署在指挥终端。在传统的基于云的指挥中枢中,这个层负责控制和处理信息,但在边缘计算架构中的指挥中枢,为指挥作战,并不要求大量数据实时收发,可缓解通信拥堵或通信干扰的情况。

2.2 边缘服务器模块

资源分配和资源计算功能是通过MEC设备内各部分模块的协作实现的,如图2所示。

图2 边缘服务器模块示意图Fig.2 Edge server module diagram

MEC预处理管理器对任务进行分类,并标记优先级和相关信息,如数据包头中的源/目标MAC地址、IP地址、TCP/UDP端口。此外,它还负责重新排序任务。

MEC任务处理器是资源分配的决策者。为重新排序的任务分配适当数量的计算资源,负责基本的运营维护。

虚拟化基础设施用以承载各类MEC应用资源和负责执行移动边缘平台接收到的流量规则,并实现流量转发。该管理器将计算资源划分为几个大的资源集,每个资源集包含几个小的资源块。本文将资源集命名为“RS”,资源块命名为“RB”。

MEC平台提供一系列功能,用以实现MEC应用在特定虚拟化基础设施上运行并使提供移动边缘服务。

在MEC服务器的帮助下,终端可以利用车载网络最边缘较近的处理能力,车辆的计算任务不会被卸载到远程集中的云服务器上,而是在附近分布灵活的MEC服务器上进行处理。该体系结构保证了延迟和移动性的要求,更好地处理来自车辆的大容量数据,同时降低了核心网络负载。

与一些集中控制系统不同,在该分散式系统中,决策可以在每个MEC服务器的协调器中独立、智能地进行,实现分布式自主管理。此外,MEC编配器中功能管理器的特殊设计使其更适合于面向计算的车联网场景中的任务处理。

2.3 系统建立

设路边单元均匀分布在道路上,道路为双向的,每个路边单元都能辐射相同面积的区域。在道路上中,每辆战车都以其各自的速度自然行驶,取n辆车的平均行驶速度为={,,…,},每辆车都有一定处理数据能力,也可同时收发计算数据。

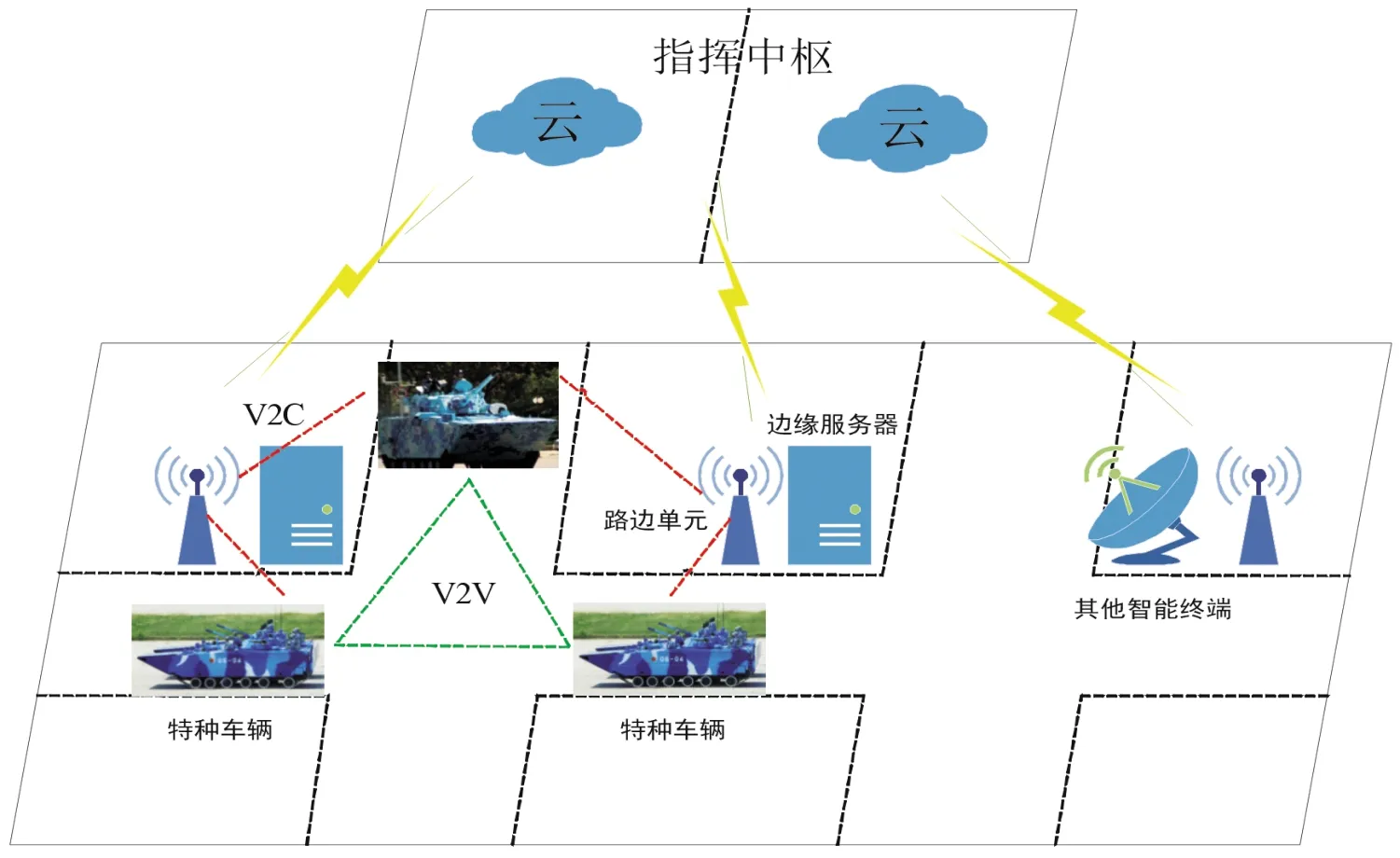

在整个系统通信过程中,特种车辆与基础设施之间通信,车与车之间通信和车与网络之间通信等均采用V2X(vehicles to everything)技术。如图3所示的车联网边缘计算过程。

图3 系统通信技术流程框图Fig.3 System communication flow chart

开始时,车辆可将计算任务卸载到离车最近的路边单元和其他空闲的车载终端,进行资源分配和数据处理。对于数据量较小的任务,任务分配卸载到不同车辆的车载终端上进行处理;对于数据量较大的任务,任务卸载到路边单元处的边缘服务器上进行处理,边缘服务器经过任务分类、标记、排序和调度4个步骤,具体处理流程如表1所示,最后通过车辆所在区域的路边单元传回车辆用户端。由于车速不同,车辆会在不同的路边单元间来回切换。边缘服务器也将处理后的任务结果上传云端进行数据存储。本文不考虑车辆之间的交互能力和计算能力,只研究车辆终端-路边单元-边缘端该过程的系统。

表1 MEC服务器处理流程Table 1 MEC server processing flow chart

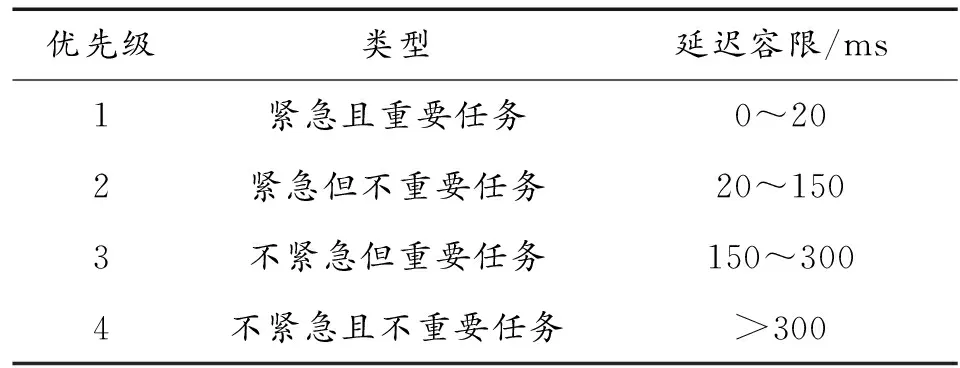

在V2X通信中,计算任务的时效性主要体现在延迟容忍度上,不同的任务有不同的时延要求,将任务的延迟容忍度划分为4个等级,如表2所示。

表2 任务优先级分类Table 2 Task priority classification table

3 边缘计算网络优化算法

3.1 任务优先级算法

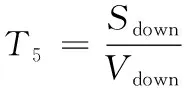

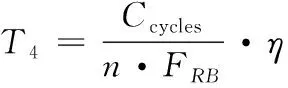

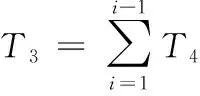

本小节研究处理最小化任务的总延迟。总延迟由5个部分组成,设任务从车辆传递到路边单元的延迟为;任务重新排序的延迟为;任务排完序后,需等待前面任务执行完的等待时间延迟为;任务执行时间为;任务通过路边单元返回车辆终端的延迟为。车辆单元和路边单元都采用C-V2X无线技术进行通信。由于路边单元通过有线连接获得MEC服务器的计算资源,因此它们之间的传输延迟可以忽略不计。

设系统4个优先级为={1,2,3,4}。设处理相同优先级任务所需要的资源、时间等都是则每个部分的完成延迟可以表示为

(1)

(2)

(3)

(4)

=++++

(5)

其中:、分别表示优先级为的上传和下载的数据的大小。、是任务的上传和下载阶段的传输速率。表示计算优先级为的任务所需的CPU周期。是提供的计算能力。是通过资源分配算法为任务分配的数目。表示用于计算任务的负载状态。导入的任务流遵循参数的泊松分布。延迟由重排序算法提供。

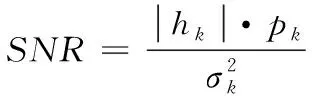

现实情况信号传输需要考虑瑞利衰落、阴影衰落和路径损耗等情况。战场环境甚至要考虑大规模电磁干扰情况。假设车辆数量上有足够的正交无线信道,则忽略车辆之间的干扰。通信原理香农公式如下:

=·log(1+)

(6)

(7)

由于车辆的高机动性,车辆的位置变化迅速,并且在任务处理期间车辆可以通过多个路边单元。在任务卸载和结果下载的时刻,从车辆到路边单元的距离是不同的。从上段的参数介绍可以看出,车辆与路边单元的距离直接影响信噪比的大小,信噪比的大小直接影响传输速率。通过这种方法,可将车辆的机动性问题建模为车辆与路边单元之间的距离对信噪比的影响,即车辆位置对传输速率的影响。

3.2 资源分配优化算法

网络优化资源分配算法包含2个子算法,即任务重排序子算法和资源分配子算法。前者采用优化后的Q’学习算法进行重新排序任务,后者采用传统的Q学习算法为已经重新排序好的任务分配计算资源。

任务以到达率的泊松分布传输到MEC服务器。MEC编排器将任务标识为不同的优先级,然后重新排序任务。

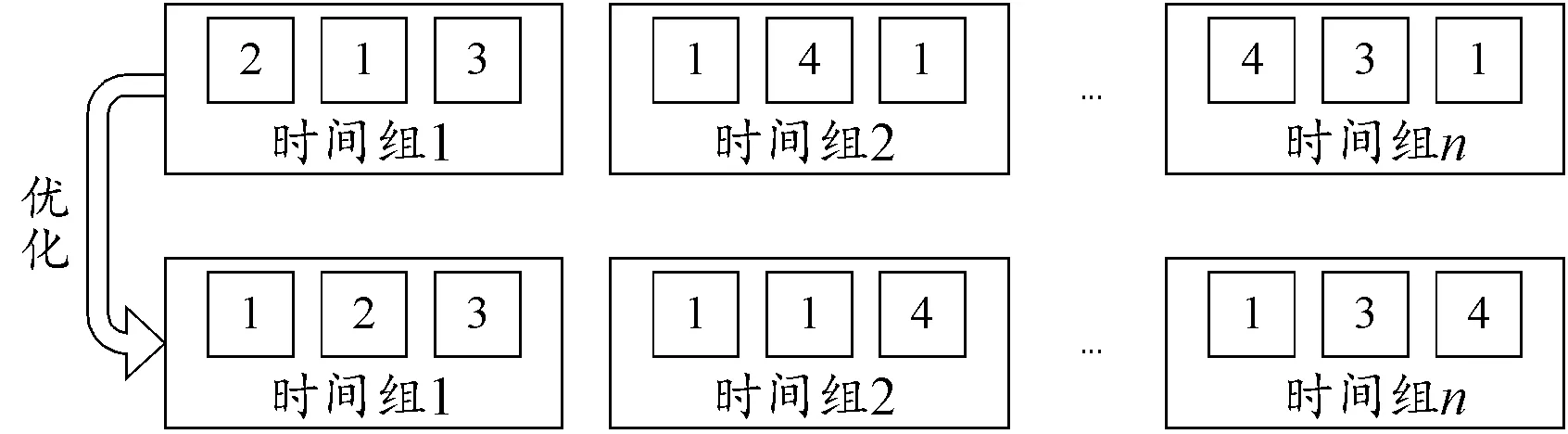

未改进的重排序子算法采用传统的基于Q学习的重排序算法。传统Q学习算法的原理为按优先级对任务进行排序,保证任务的优先执行。但是,低优先级任务必须在队列结束时等待很长时间,从而导致超时。为了解决这一问题,需要对算法进行改进,根据时间组和分数值两个概念,优化新的排序方法此表示为Q’学习算法。Q’学习算法的重排序流程如图4所示。

图4 Q’学习算法重排序流程框图Fig.4 Q’learning algorithm reordering flow chart

图4中,MEC预处理管理器将每个任务按到达顺序划分为一个时间组,早到的时间组总是优先于晚到的时间组。重新排序过程发生在时间组中,对同一时间组中的任务重新排序。这种机制确保低优先级任务不会一直处于等待状态。

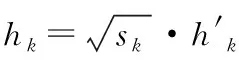

结果值综合表达了任务的到达时刻和优先级,如公式所示:

(8)

式中:为任务的优先级;为任务的实际到达时刻;、分别为任务所在时间组中第一个和最后一个任务的到达时刻;为结果值的一个因子。

分层车联网网络中的MEC环境是复杂多变的。此外,由于车辆分布和资源需求的规律性,利用机器学习学习规律是可行的。因此,考虑通过强化学习来解决资源分配问题。

Q学习算法作为一种典型的强化学习算法,能够以较低的复杂度解决相同的资源分配问题。MEC平台管理器充当行动选择的代理。虚拟化基础架构管理器提供算法所需环境的参数。

Q学习算法最初是由Watkins等提出的一种无模型的值函数强化学习算法。该算法可用马尔科夫决策过程框架来形式化描述。通过定义状态空间、行为空间和报酬函数,将资源优化配置问题建模为一个马尔可夫决策过程,该过程的应用如下:

1) 状态空间。由于代理一直在分配MEC服务器的计算资源,因此需要及时更新可用资源。将状态空间设计如下:

={,}

(9)

={steate,state,…,state}

(10)

={,,…,}

(11)

状态空间包括两部分,和。前者是每个的负载状态,后者是每个上剩余的数量,是的数量。

2) 行为空间。在系统中,代理必须决定选择哪个和。规定为一个任务选择的必须集中在同一个中,并且和的具体选择取决于代理的选择。此外,结合优先级给出了分配数的上界。因此,动作空间可以表示为:

={,,…,}

(12)

式中动作空间表示当前循环的动作选择。∈{0,1},取=1,这有助于找出哪些被选中。表示整个MEC服务器中的总数。

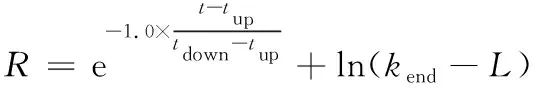

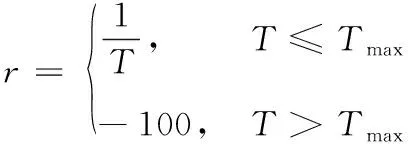

3) 报酬函数。奖励值是在做出行动决策后,来自环境的反馈。根据式(7),该算法优化目标是最小化完成总延迟。大的奖励值是首选,因此定义奖励值是延迟的倒数,对于超过延迟容差最大值的任务,定义其奖励值为-100。奖励函数总结如下:

(13)

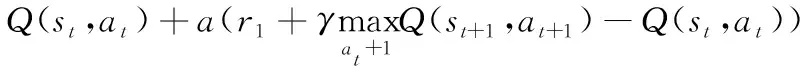

因此,选择Q学习算法来作为最佳的资源分配策略。Q学习算法选择状态动作值函数(,)作为估计函数。Q学习的基本思想是用时差法求(,),值如式(14):

(14)

式(14)中:为学习效率,用于控制收敛。越大,前一训练效果保持的越少是折现系数。越大,越重视长期奖励;越小,越重视即时奖励。在Q学习中,每个(,)都有Q表的相应位置,根据Q表查询结果即可得到对应的结果。

在基于Q’学习算法优化任务重排序之后,用具有资源分配的传统Q学习算法分配计算资源。这样,代理就可以通过查询Q表,自主地为不同优先级的任务分配资源。

4 仿真与分析

4.1 仿真条件设定

由MEC分层架构,设一个基站包含一个MEC服务器,MEC服务器下有3个路边单元。在每个路边单元的覆盖区域内,有多辆特种战车连续生成计算任务。

设MEC服务器输入的计算任务与参数服从泊松分布。设所有路边单元具有相同的传输功率26 dBm,覆盖半径500 m,所有车辆具有相同的传输功率23 dBm,所有车辆以相同的平均速度5 m/s行驶,信道带宽为10 MHz,高斯功率0.01 W。

设上传数据大小为{0.5,1,3,6}Mbits,下载数据大小为{0.25,0.5,1.5,3}Kbits,CPU所需周期为{1,2,3,4}×10周,结果因子为30,最大值为{20,150,300,500}。资源集数量为3,每个中资源块数量分别为3、6、9,计算能力均为10 GHz。

4.2 绩效考核结果

设为02,为04,全局值由每次的值组成,则延迟性能越好,全局值越高。根据式(13)和式(14),当奖励值和值的设置不变时,值与奖励值正相关,而奖励值与延迟负相关。因此,延迟越小,回报越大,值越高。全局值结果如图5所示。

图5 全局Q值结果曲线Fig.5 Global algorithm comparison

从图5可以看出,Q’学习算法相对于Q学习算法的奖励值轨迹更好,收敛速度更快,当回合数为6 000时Q’学习算法已经收敛于最优解了,其全局Q值高于Q学习算法,这表明所提出的重排序算法是可行的。

4.3 重排序算法比较

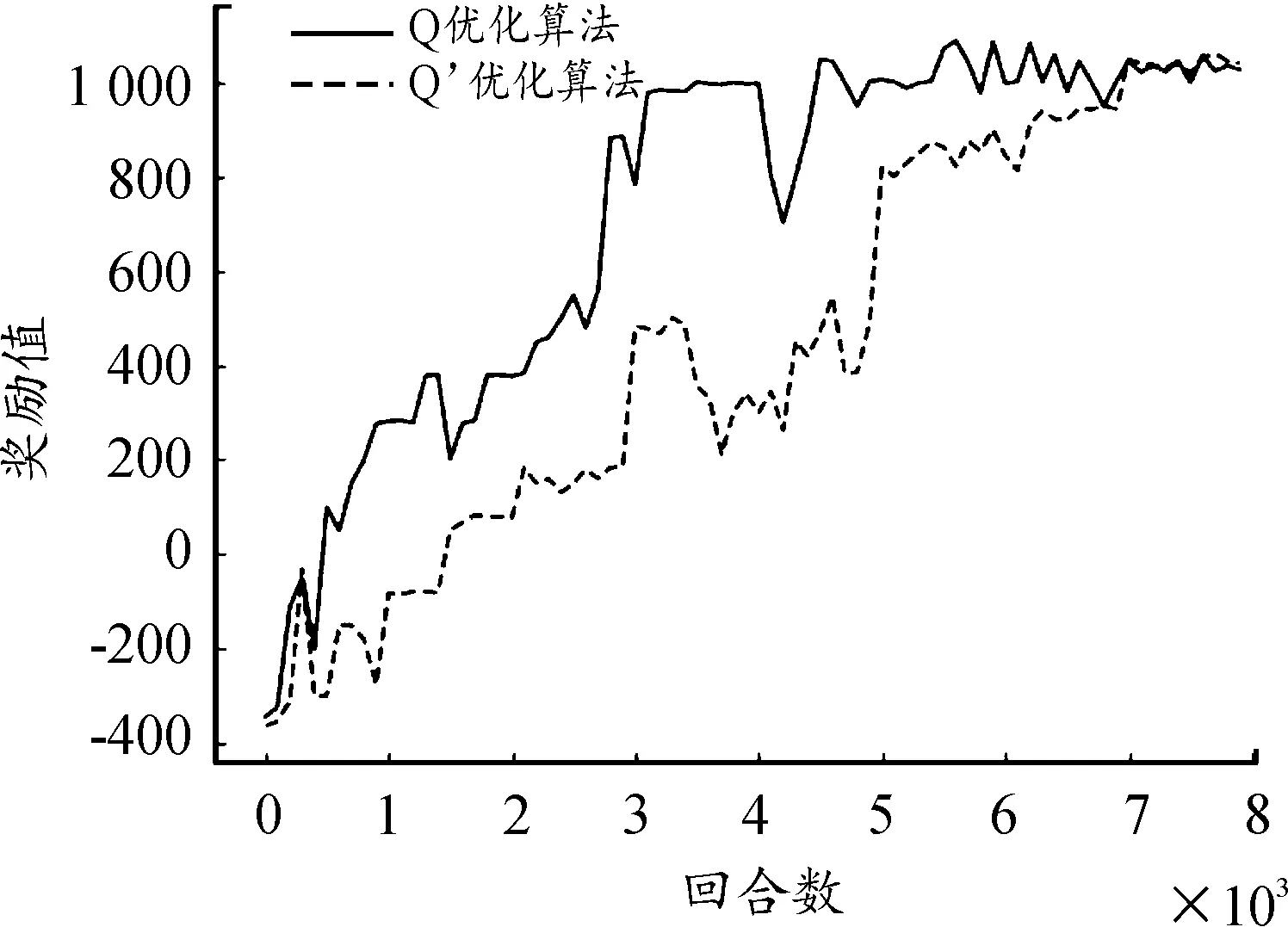

传统的基于Q学习和Q’学习算法2种重排序机制的资源分配算法,比较2种排序算法的中断概率(完成延迟时大于延迟容限最大值的概率),如图6所示。

图6 不同重排序方案下4个优先级的中断概率直方图Fig.6 Outage probability of four priorities under different reordering schemes

图6显示了不同排序算法对不同优先级任务的中断概率的影响。对于优先级为1的任务,Q’学习算法的中断概率略低于Q学习算法,保持在2%。对于优先级为2、3和4的任务,发现Q’学习算法显著降低了中断概率,这反映了时间组和得分值的有效性。

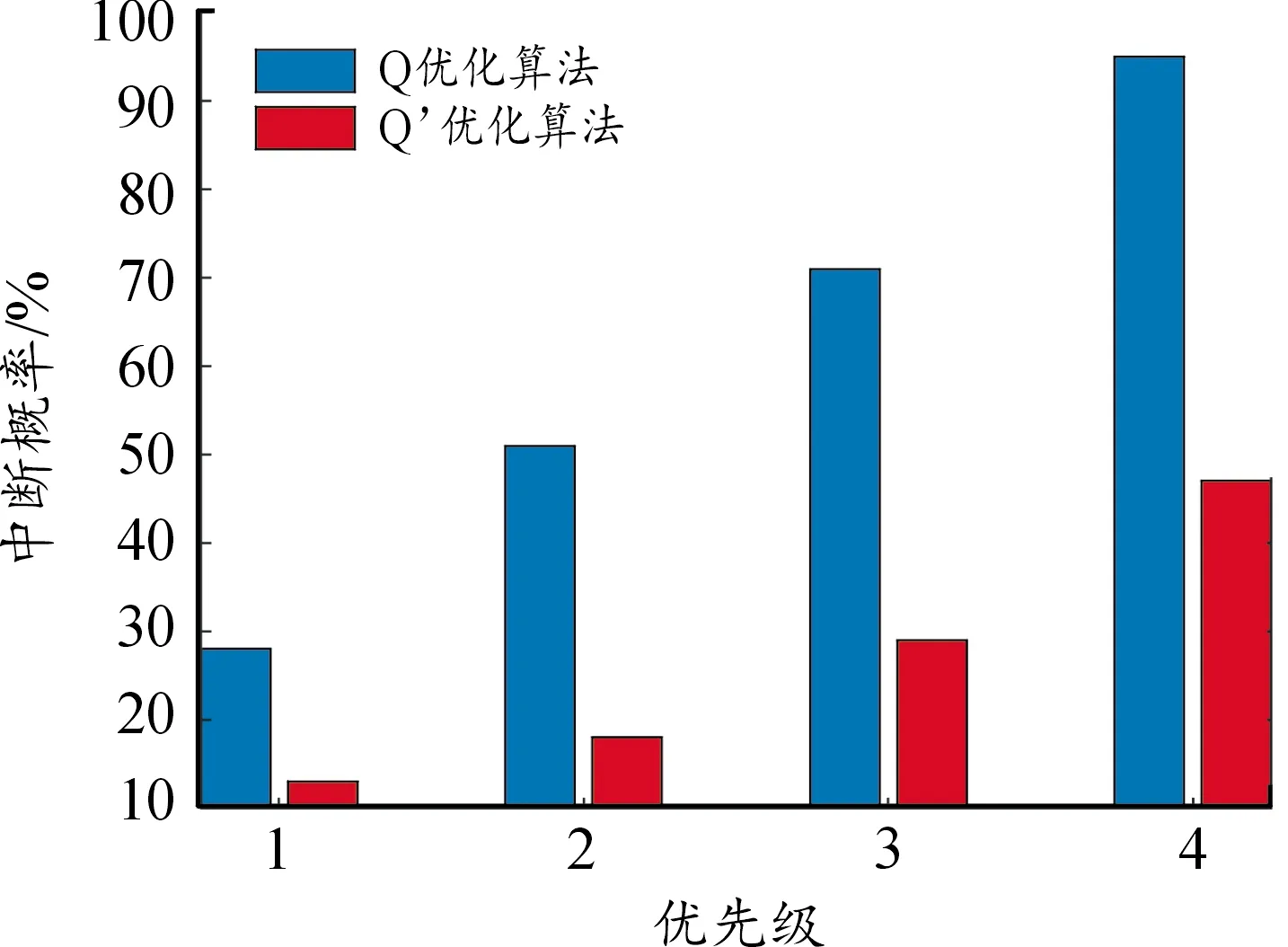

不同任务到达率的效果下的不同排序算法的中断概率如图7所示。由图7可以发现,Q’学习算法中断概率低于Q学习算法,当每秒到达MEC服务器的任务数超过90个,中断概率大幅度提高,表明发生拥塞,导致处理效率显著降低。

图7 任务到达率的影响λ不同重排序方案下的中断概率曲线Fig.7 Impact of task arrival rate λ outage probability under different reordering schemes

4.4 资源分配算法性能比较

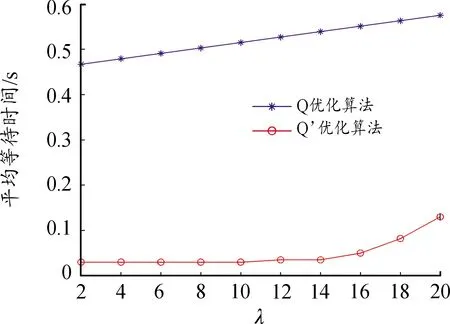

为了验证本文优化的的的资源分配方案的延迟性能,对Q学习算法和Q’学习算法效果进行了仿真。平均等待时间如图8所示。

图8 平均等待时间曲线Fig.8 Average waiting time comparison chart

图8为评估平均等待时间和任务到达率之间的关系。Q学习算法只按优先级对任务进行重新排序,低优先级的任务会等待很长时间,Q’学习算法在平均等待时间上具有更低的值和更平缓的趋势。

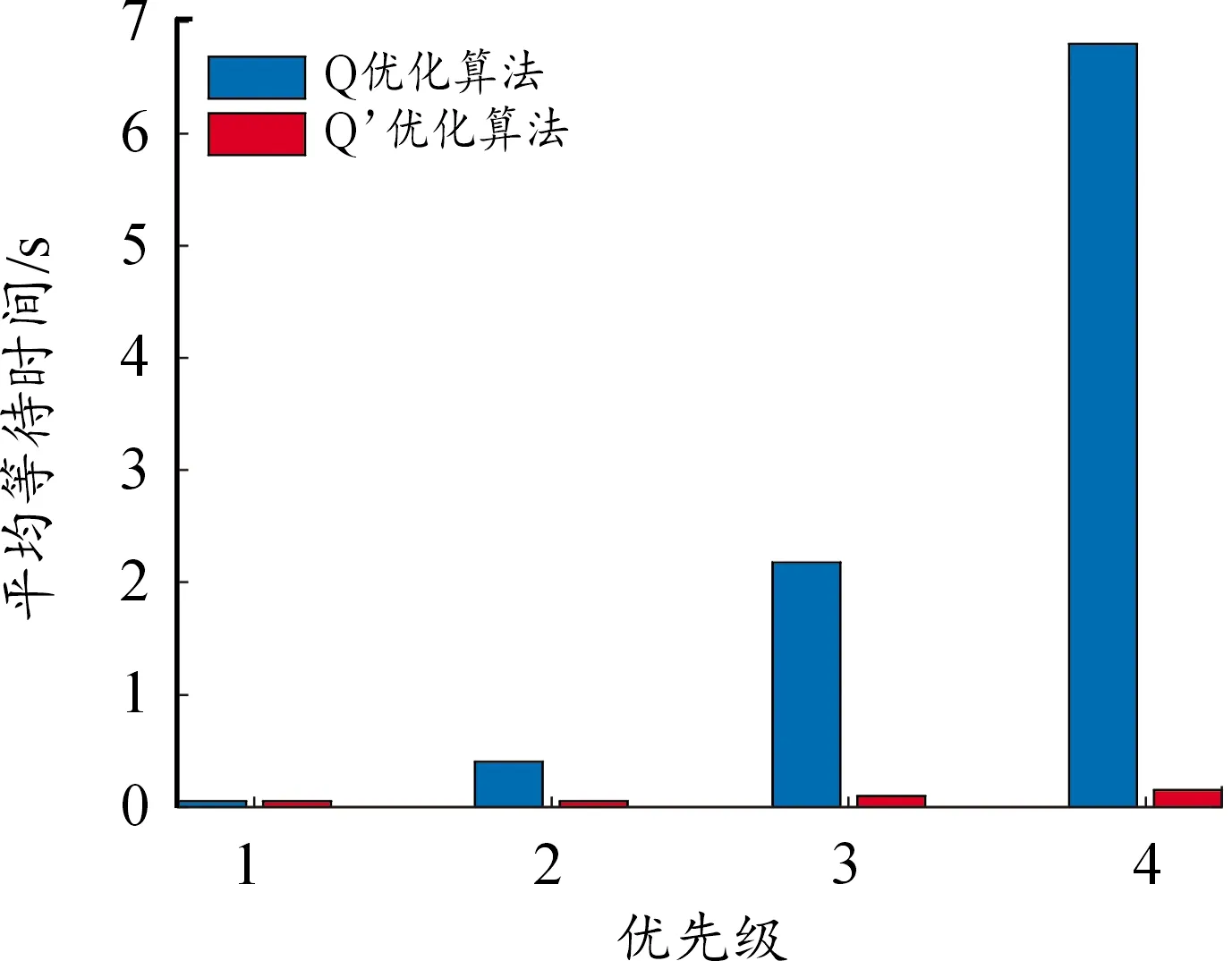

每个优先级任务的不同算法的平均完成延迟如图9所示。由图9可得:Q学习算法忽略了低优先级任务的延迟要求,低优先级任务的调度机制过于死板。Q’学习算法的平均完成时延最低,此外,其在保证高优先级任务优先执行的同时,控制了低优先级任务平均完成延迟的上升趋势。仿真结果表明:Q’学习算法能够有效地降低平均时延,应用该算法的方案可以更智能、更合理地分配资源。

图9 平均完成延迟直方图Fig.9 Average completion delay comparison

5 结论

针对移动边缘计算的延迟问题,对资源分配采用Q学习算法,任务重排序采用优化后的Q’学习算法,设计了一种能有效作用于边缘服务器模块的资源分配方案。基于传统Q学习算法,借鉴时间组和分数值2个概念优化得出了Q’学习算法,对其性能进行仿真,经过仿真对比可知,Q’学习算法在多方面的中断概率、平均时延都优于传统Q学习算法,证明优化方案的可行性。