统计学习基础算法剖析*

摘 要 以华东师范大学出版社出版的《人工智能基础(高中版)》为例,立足机器学习的数学基础,在对普通高中信息技术选择性必修模块“人工智能初步”现行教材涉及的有关统计学习算法系统进行分析的基础上,对教材阐释的算法模型进行分析归纳,针对当前现有学习资料没有讲解或忽略的有关算法要点进行补充证明,对有关算法引用的数学定理进行补充,为高中信息技术教师融会贯通地掌握统计学习基础算法提供有参考价值的路径和建议。

关键词 高中;人工智能基础;统计学习;机器学习;基础算法

中图分类号:G633.67 文献标识码:B

文章编号:1671-489X(2022)09-0077-03

0 引言

华东师范大学出版社出版的《人工智能基础(高中版)》依据新版课程标准,遴选贴近高中生学习生活的案例,相对系统全面地概述了机器学习的基础算法。由于人工智能初步课程涉及较多的高等数学知识,对于课程的有效实施造成一定困难。为破解当前高中人工智能基础算法教学存在的问题,本文依据课标对教材涵盖的传统机器学习(也称“统计学习”)算法原理进行了较系统的归纳及贯通分析,力求为一线教师高效快速地掌握教材涉及的统计学习算法提供参考。

1 算法剖析

统计学习是机器学习的基础,教材《人工智能基础(高中版)》用三章篇幅(第二章“察异辨花”、第六章“分门别类”、第七章“理解文本”)相对系统地阐释了感知机、支持向量机、K均值聚类、非概率潜在语义分析等经典案例,基于教材涉及的统计学习案例,对正则化、支持向量机、感知机及主成分分析等经典统计学习基础算法进行解析归纳。

1.1 正则化

机器学习的目标是期望风险最小化,根据大数定律,通常采用模型关于训练数据集的平均损失即经验风险来估计期望风险。由于训练样本数目很有限,需要在经验风险上增加正则化项或者惩罚项来构建结构风险函数。最基本的正则化方法就是在原始目标(或代价)函数中增加惩罚项,对复杂度高的模型进行数学意义上的“惩罚”。正则化可从不同角度分析其由来。

1.1.1 基于约束条件最优化

在通过最小化目标函数优化权重系数的模型中(如线性回归、神经网络等),通常模型的复杂度可通过VC维衡量,VC维与权重系数的分量数量成线性关系,由此减少权重系数的分量个数就能限制模型的复杂度,即把权重系数向量中的一些元素设置为0,因此可以用L0范数来进行数学表示。但由此带来一个NP问题需放松约束条件,为达到近似效果,可以不严格要求权重w某些分量为0,而用L1或L2范数来近似L0范数。为方便统一运算,通常用权重w的L2范数平方取代L2范数,只需调整C的取值即可。参照带不等式约束的凸规划问题数学模型,构造广义拉格朗日函数,原问题就转化为求广义拉格朗日函数的上确界即极小极大问题。为便于观察约束的作用,将拉格朗日乘子取固定值,因此,广义拉格朗日函数仍可被视为原问题的解,即形成结构风险函数。

1.1.2 基于谱范数

为限定函数的变化速度,德国数学家利普希茨定义了利普希茨连续,即要求连续函数f(x)在一定的定义域范围内使得任意两个元素x1和x2都能够满足,则函数f(x)的利普希茨常数为K,K<1,称函数f(x)为压缩映射。若f(x)的定义域为实数集合,则等价于f(x)在某邻域内的导数绝对值不能超过K。利普希茨连续限制函数在区间上不能有超过线性的变化速度,即相当于限制输入噪声引起的输出波动。如以单层的全连接神经网络为例,其模型为f(Wx+b),f是激活函数,而W,b是参数矩阵/向量。设全连接神经网络正向传播函数满足利普希茨连续性,则:

(1.1)

让x1,x2充分接近,将不等式左边用一阶项泰勒展开,忽略无穷小项,近似得到:

若要满足该不等式成立,则要求?f/?x这一项(每个元素)的绝对值必须不能超过某个常数。因为机器学习中使用的激活函数均满足“导数有上下界”,因此,?f/?x这一项是一个常数,可忽略它,剩下来只需考虑,最终保证C足够小。

矩阵谱范数的定义:

根据瑞利商的定义推证出矩阵W的谱范数等于W的最大奇异值。而由柯西不等式可得:

很明显,提供了的一个上界,可理解为是最准确的C,只要控制C足够小,就能控制由输入噪声引起的输出值突变,提高泛化能力。由于容易计算,可以直接取,因此,单层神经网络的结构风险函数为:

1.2 线性支持向量机

线性可分支持向量机的学习策略是求间隔最大化,即求解唯一超平面,将不同类的样本完全划分开。然而对于线性不可分样本数据,很难确定一个超平面做到完全线性可分。为此,默许支持向量机在一些样本上发生错误,引入软间隔将线性不可分样本数据忽略掉。通过引入松弛变量ξi,可将线性可分支持向量机转为线性支持向量机,每个样本不满足约束的程度都对应由一个松弛变量来表示。线性支持向量机同线性可分支持向量机数学模型一样,仍是一个凸二次规划问题。

理论上支持向量机目标函数也可以用合页损失函数来构建,即经验风险+正则化项,由合页损失函数构成结构风险函数。因为合页损失函数在参数的实际学习优化中是动态变化的(与感知机的误分类点构建的损失函数类似),所以在实践中多采用将目标函数引入松弛变量带约束条件的数学模型进行优化求解。

首先,给该问题的每一个约束指定一个拉格朗日乘子,以乘子为加权系数,将等式或不等式约束增加到目标函数中,使目标函数f(x)在可行域内大于或等于构建的拉格朗日函数。由此,求构建的拉格朗日函数对目标函数f(x)的自变量x的下确界,就转化为拉格朗日对偶函数。因为原问题(原问题与拉格朗日函数的上确界是等价的)与对偶问题满足强对偶条件,所以拉格朗日对偶函数最优解即为原问题最优解。

通常在求解凸规划问题时要涉及KKT条件,对软间隔支持向量机,KKT条件的核心是松弛互补条件[αi(yif(xi)-1+ξi)=0]。若松弛互补条件对于可行解

在约束区域内部,则约束不起作用;若可行解在约束边界上,则不等式约束转为等式约束。如果样本xi不在约束边界上,αi=0,则约束失效;如果样本xi

在约束边界上,αi>0,则约束边界上样本点理论上均为支持向量。

对任意训练样本(xi,yi),总有αi=0或yif(xi)=

1-ξi,但两式不能同时成立(同时成立会导致权重向量w最优解为0,可用反证法证明)。若αi=0,则对应样本不会对f(x)产生影响,即对超平面方程不发生作用,相当于屏蔽掉对应的样本。若yif(xi)=

1-ξi(即ɑi不等于0),则该样本可能是实际支持向量。若αi<C,则ξi=0(因μi>0),则该样本位于最大间隔边界。若αi=C,则μi=0,若ξi≤1,则该样本落在最大间隔内部;若ξi>1,则该样本被错误分类。由于此情况αi=C引起的ξi的随意性,虽然也应该属于软间隔的支持向量,但由于其线性不可分,因此不能起到优化固定f(x)参数的作用。同时可设定C为任意小的惩罚值,会将ξi近似屏蔽掉。由此看出,软间隔支持向量机的参数优化仅与实际支持向量(位于最大间隔边界)有关,而忽略软间隔支持向量。

1.3 感知机

感知机损失函数是求误分类的全部样本到超平面的距离之和最小。感知机学习算法的原始表达形式为求以下目标函数极小化问题的解:

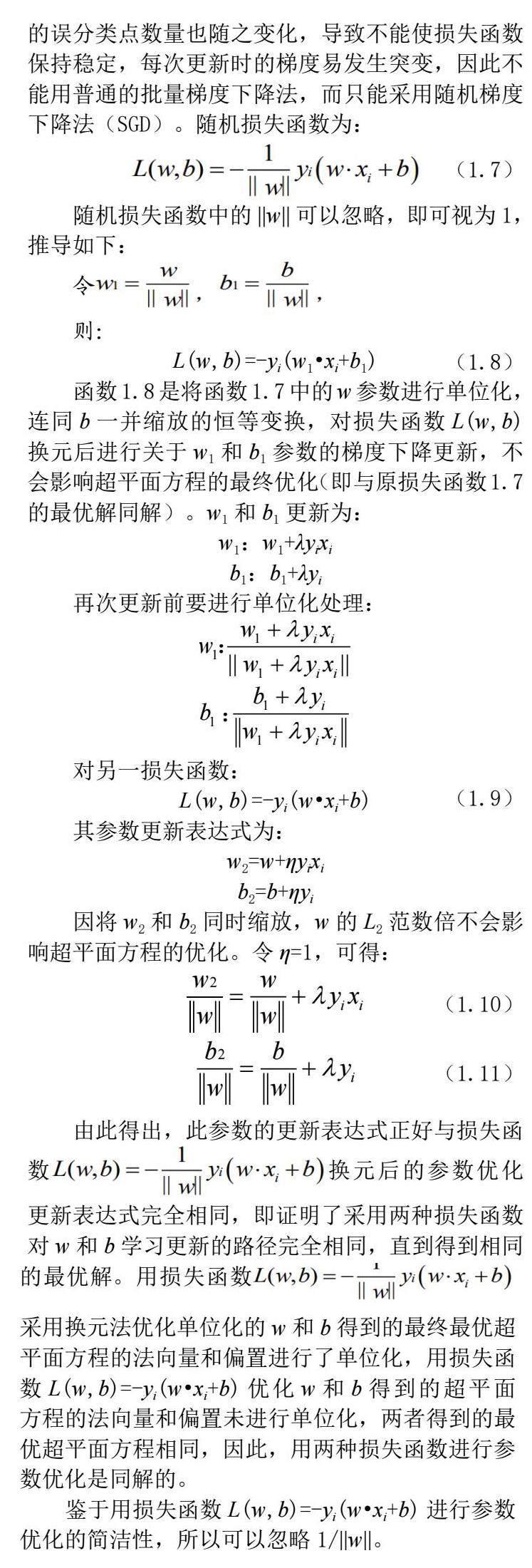

用基于所有样本梯度和均值的批量梯度下降法(BGD)求感知机的最优解是行不通的,如采用标准梯度下降法,由于参与损失函数优化的误分类点在参数优化过程中是动态更新的,而构建损失函数的误分类点数量也随之变化,导致不能使损失函数保持稳定,每次更新时的梯度易发生突变,因此不能用普通的批量梯度下降法,而只能采用随机梯度下降法(SGD)。随机损失函数为:

随机损失函数中的||w||可以忽略,即可视为1,推导如下:

令

则:

L(w,b)=-yi(w1·xi+b1)

函数1.8是将函数1.7中的w参数进行单位化,连同b一并缩放的恒等变换,对损失函数L(w,b)换元后进行关于w1和b1参数的梯度下降更新,不会影响超平面方程的最终优化(即与原损失函数1.7的最优解同解)。w1和b1更新为:

w1:w1+λyixi

b1:b1+λyi

再次更新前要进行单位化处理:

对另一损失函数:

L(w,b)=-yi(w·xi+b)

其参数更新表达式为:

w2=w+ηyixi

b2=b+ηyi

因将w2和b2同时缩放,w的L2范数倍不会影响超平面方程的优化。令η=1,可得:

由此得出,此参数的更新表达式正好与损失函数换元后的参数优化更新表达式完全相同,即证明了采用两种损失函数对w和b学习更新的路径完全相同,直到得到相同的最优解。用损失函数采用换元法优化单位化的w和b得到的最终最优超平面方程的法向量和偏置进行了单位化,用损失函数L(w,b)=-yi(w·xi+b)优化w和b得到的超平面方程的法向量和偏置未进行单位化,两者得到的最优超平面方程相同,因此,用两种损失函数进行参数优化是同解的。

鉴于用损失函数L(w,b)=-yi(w·xi+b)进行参数优化的简洁性,所以可以忽略1/||w||。

1.4 主成分分析

主成分分析的常规思路是采取将数据点投影到待定的投影轴上以实现数据的降维,用投影轴上的值作为样本点的替代值,要求所选定的投影轴使点集投影的离散度越大越好,可用方差来衡量,方差越大越好,即计算数据投影点与原点的带符号距离,这个带符号距离就最佳的替代值,通常采用直接投影法。

为便于理解,可借助一个与投影轴线相垂直的过空间原点的超平面,假设它的方程为ωTx=0,设ω为单位基向量。数据点x到超平面ωTx=0的带符号距离可用f(x)表示,其表达式为f(x)=ωTx,将点映射成它到某超平面的带符号距离和投影法的几何原理是等同的,只不过前者的优势在于计算更简单(主成分分析算法后续的推导过程在此略)。

2 结束语

统计学习是深度学习的基础,高中学生在学习中受到现有数学课程滞后等因素制约。高中人工智能初步有关算法教学是一项系统而又有待于深入研究的课题,但随着人工智能课程的不断推进以及配套数学基础课程的同步开设,在现行教材修订的基础上,高中人工智能课程必将进入更加全面有效的实施阶段。

参考文献

[1] 陈玉琨,汤晓鸥.人工智能基础(高中版)[M].上海:华东师范大学出版社,2018.

[2] 李航.统计学习方法[M].2版.北京:清华大学出版社,2019:112-132.

[3] 雷明.机器学习的数学[M].北京:人民邮电出版社,2021:201-217.

*项目来源:2021年度山东省教育教学研究一般课题“中小学人工智能课程内容设计与实施范例研究”(课题编号:2021JXY383)。

作者:穆明,淄博市基础教育研究院,高级教师,研究方向为机器学习算法(255033)。