基于卷积姿态机和GrabCut的服装图像轮廓分割方法

游小荣,李淑芳,熊宗志

(1.常州纺织服装职业技术学院,江苏 常州 213164; 2.常州市生态纺织技术重点实验室,江苏 常州 213164)

图像分割技术作为图像处理预处理部分,在织物疵点检验、织物图案轮廓提取、服装轮廓提取、服装图像轮廓提取、服装图像检索等方面得到广泛应用[1],是计算机视觉热点研究领域之一。图像分割技术方法众多,大致可分为基于边缘、阈值、区域、图论、基因编码、聚类、神经网络等[2],这些方法在不同场景中均得到应用。近年来,随着深度学习的快速发展,很多学者将深度学习应用到了图像分割这一领域,分割效果改善显著。

图像分割技术在服装图像轮廓提取方面也有许多研究,具体包括:基于阈值分割方法,如项明等[3]借助Otsu和高斯混合模型对服装图像进行分割,发现此法对于纹理服装图像分割效果一般;郭鑫鹏等[4]充分考虑了色彩和纹理特征,但服装图像背景复杂及颜色或纹理编号较大时,分割效果欠佳;基于分水岭区域合并等区域分割算法,对复杂前景的服装图像分割效果不佳[5-6];基于聚类算法在服装图像分割中的应用,在特定场合能够取得不错的[7-9]分割效果,但通用性一般;基于图论的处理方法,特别是借助GrabCut或OneCut算法分割服装图像,能够很好地提取出感兴趣区域,且边缘处理效果好,但普遍存在需要人工标注以及复杂背景下分割精度一般的问题[10-11];基于机器学习[12-13]和深度学习方法[14-15]在图像分割中的应用,通用性明显增强,但定位后提取前景图像效果一般,边缘上存在一定误差。

本文针对GrabCut算法需要人工干预和复杂背景分割精度不高的问题,提出了基于卷积姿态机(Convolutional Pose Machines)和GrabCut的服装图像轮廓分割方法,其中,卷积姿态机(CPM)网络深度学习方法用于获得GrabCut算法所需的初始矩形框,而GrabCut算法则用于将服装从图像中分离出来,最终达到服装图像大批量自动分割的目的。

1 GrabCut算法

GrabCut算法是一种基于图论的图像分割算法,具有边缘提取效果好、精度高的优点,常用于从图像中提取前景目标,但其也存在2个方面不足[12]:①需要用户少量人工交互,不能实现批量图片自动处理。②单一背景和复杂背景提取效果差别大。

对单一背景图像采用GrabCut算法,提取效果较好,如图1所示。

图1 单一背景提取效果图Fig.1 Single background extraction effect picture. (a) Original picture; (b) After extraction

对复杂背景采用GrabCut算法,提取效果不理想,如图2所示,提取图片受背景干扰严重,对初始矩形框选择要求高。

图2 复杂背景提取效果图Fig.2 Complex background extraction effect picture. (a) Original picture;(b) Complex after extraction

GrabCut算法具体实现过程如下:

步骤1:用户在目标图像中创建一个包含前景目标的矩形框,矩形框外面即为初始背景,并将前景部分设为空集。

步骤2:采用高斯混合模型对背景和前景目标进行建模,计算高斯混合模型参数。

步骤3:根据高斯混合模型参数,计算最小能量值,进行图像分割。

步骤4:跳转至步骤2,迭代执行,实现能量最小化目标,直至收敛。

步骤5:完成边界优化与分割。

2 卷积姿态机算法

为了更好地定位图片中的服装,解决GrabCut算法存在的不足,本文使用卷积姿态机算法[16]来实现图片中服装对象的精确定位,并自动输出包含前景目标的初始框。卷积姿态机算法是在姿态机算法基础上,增加了卷积神经网络,结合了姿态机算法和卷积神经网络的优点,其网络结构如图3所示。

图3 卷积姿态机网络结构Fig.3 Convolution pose machines network structure

从结构可以看出,卷积姿态机网络结构由1个初始阶段和N个(本文N取6)强化阶段组成。初始阶段采用原始图作为输入,经过卷积网络结构后会产生信度图,在强化阶段,采用原始图或经过卷积神经网络处理产生的特征图,以及每个阶段产生的信度图、同时融合高斯函数模板产生的居中映射(Center Map)图作为串联输入,并经过卷积神经网络处理,产生新的信度图,并作为下一阶段的数据,循环往复,直至结束。

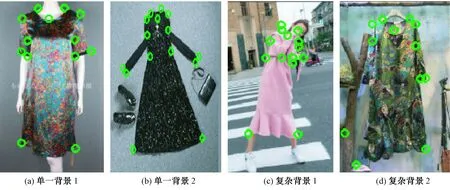

采用卷积姿态机网络处理后得到各服装的关键点,无论是单一背景还是复杂背景,含服装的图像都能得到不错的定位效果,结果如图4所示。

图4 卷积姿态机处理后服装定位效果Fig.4 Clothing positioning effect after convolution posture machine processing (a) Single background 1; (b) Single background 2; (c) Complex background 1; (d) Complex background 2

3 本文方法

为了解决GrabCut算法存在的不足,本文提出了基于卷积姿态机和GrabCut的服装图像轮廓分割方法,具体流程如图5所示。首先选用天池FashionAI数据集,训练卷积姿态机网络,训练完成后输出服装关键点模型;然后输入待测图片,根据训练好的服装关键点模型输出服装关键点信息,再根据这些服装关键点信息计算得到初始矩形框;最后以此初始矩形框作为Grabcut算法的输入,并根据Grabcut算法输出服装图像轮廓分割的结果。图6示出本文方法各阶段产生的对比图像。

图5 基于卷积姿态机和GrabCut的服装图像轮廓分割方法Fig.5 Garment image contour segmentation method based on convolution pose machine and GrabCut

图6 本文方法各阶段产生的对比图像Fig.6 Contrast images generated in each stage of this method. (a) Original image; (b) Image processed by convolution attitude machine; (c) Image forming a rectangular frame; (d) Image segmented by GrabCut

4 结果与分析

图像分割质量评价方法很多,常见包括像素精确度(Pixel Accuracy, PA)、均像素精度(Mean Pixel Accuracy,MPA)、均交并比(Mean Intersection over Union, MIoU)以及频权交并比(Frequency Weighted Intersection over Union, FWIoU)等[17]。其中,均交并比(MIoU)是对交并比指标求平均计算得来,而交并比是真实区域与预测区域的交集像素数量与真实区域与预测区域的并集像素数量的比值。由于均交并比具有简洁性的特点,且代表性强,因此本文选用均交并比(MIoU)作为图像分割质量好坏的评价指标。

分别对1 000张单一背景服装图像和复杂背景图像采用本文方法进行服装图像轮廓分割,并和传统基于人工交互GrabCut进行对比,得到如表1所示的实验结果。

表1 单一/复杂背景下本文方法与GrabCut方法对比Tab.1 Comparison between this method and Grab Cut method under single/ complex background

表1示出,在单一背景下,本文方法和传统基于人工交互GrabCut方法相比,均交并比(MIoU)下降1.42%,非常接近;但在复杂背景下,由于本文基于卷积姿态机对服装进行了很好的关键点定位且人工交互具有一定主观性,其分割效果反而比传统基于人工交互GrabCut方法要好,均交并比(MIoU)提升了2.12%。

此外,本文方法也存在少数分割效果不太精确的情况,如图7所示。这是因为这些图片中包含其他非真实的服装关键点信息,导致服装关键点定位发生一定偏差,所以才会出现分割效果不理想的情况,在后续的研究中,需要对卷积姿态机网络进一步进行训练优化,提升服装关键点定位效果。

图7 分割效果不理想的情况Fig.7 Segmentation effect is not ideal. (a) Original image; (b) Image processed by convolution attitude machine; (c) Image forming a rectangular frame; (d) Image segmented by GrabCut

5 结 论

针对传统基于GrabCut算法进行服装图像分割需要人工交互的不足,本文提出了一种基于卷积姿态机(Convolutional Pose Machines)和GrabCut的服装图像轮廓分割方法,该方法采用卷积姿态机实现服装在图像中的关键点定位,形成矩形框后,作为GrabCut算法的初始矩形框,经过GrabCut算法处理后,分割出服装图像。结果表明,该方法不仅能解决需要人工交互的问题,实现自动提取图像的目的,而且对复杂背景的图像分割也具有很好的分割效果,对于大批量服装图像自动分割处理,具有较强的实用性。