基于深度图推理的卫星背板部件检测方法

陈奥,解永春,王勇,李林峰

1.北京控制工程研究所,北京 100190

2.空间智能控制技术重点实验室,北京 100190

在轨服务操作通常是指服务航天器与目标航天器完成交会对接后,服务航天器利用所携带的机械臂对目标航天器进行末端操作的过程,包括对寿命末期或者故障航天器的在轨故障修复、模块更换、燃料加注、以及辅助离轨等[1]。在轨加注是指服务航天器在空间轨道上,为目标航天器补充推进剂,是一种典型的在轨服务操作。在轨加注在降低空间运输成本以及任务风险方面起着重要的作用,对于提高空间资产使用效益、保障飞行器在轨安全可靠运行具有重大意义。

已有的在轨加注通过遥操作或在人员监控下完成,自主等级低。国外典型的在轨加注任务有“轨道快车(Orbital Express,OE)”和“机器人燃料加注任务(Robotic Refueling Mission,RRM)”。2007年,在“轨道快车”任务中,服务航天器ASTRO向目标航天器NEXTSat传输了肼燃料,还利用机械臂为NEXTSat安装了一块电池,这些操作是在人员监控下完成的,依赖于地面指令[2]。2013年,在第三阶段的“机器人燃料加注任务(Robotic Refueling Mission-3,RRM-3)”中,安装于国际空间站外部的机械臂完成了一系列加注操作的在轨演示,包括开启燃料加注工具启动锁、抓取并取出锁线切割工具、切割阀门螺帽锁线、放回切割工具、抓取连接管工具、移动连接管工具至模拟卫星燃料阀处、将连接管插入模拟卫星燃料阀、乙醇燃料传输等,上述操作由遥操作完成,并且需要地面人员向机械臂操作系统发送精确的加注指令[3]。国内典型的在轨加注任务有“天源一号”“实践十七号”和“天舟一号-天宫二号”任务。2016年,“天源一号”完成了液体燃料的管理和加注工作,验证了多项在轨加注关键技术。同年,“实践十七号”卫星完成的无毒推进剂二硝酰胺铵的在轨加注试验。2017年,“天舟一号”货运飞船对“天宫二号”空间实验舱进行多次推进剂补加工作。以上国内的3次在轨加注,研究的重点是在空间环境下的推进剂管理与加注,并没有对在轨加注中的相关操作技术展开研究。虽然美国航天机构在在轨加注相关技术方面的研究更加全面、起步较早,但整个加注过程并不是全自主的,仍依赖于地面指令或是空间站航天员的遥操作。中国处于起步阶段,在推进剂管理方面积累了许多经验,而在自主在轨加注操作方面仍是空白。

视觉感知系统在在轨加注中起着重要的作用,可以感知操作任务周围环境并提供给控制系统。在轨加注中的视觉感知方法随着在轨加注控制方法的改进和加注任务需求的增加而发展。基于可见光成像的目标探测技术,因具有技术相对成熟、图像分辨率高、目标特征丰富、系统功耗小等优点,被广泛应用于空间目标形态识别。在早期的加注任务中,如“轨道快车”任务,视觉感知系统要对目标航天器上的合作标志器进行测量,引导机械臂完成加注操作,类似涉及合作目标测量的任务还有日本的ETS-VII计划[4]。“机器人燃料加注任务”,通过遥操作的方式完成,因此其视觉感知系统仅需要提供监控视频,而不需要做测量。随着在轨加注自主化程度的不断提高,视觉感知系统需要向控制系统提供操作对象的相对位置和姿态等信息。对于非合作目标的感知和测量的研究,各国尚处于地面试验阶段,研究的对象具有较明显的图像特征特点,如点、直线、圆和曲线等,且需要提供一些先验信息。总的来看,当前用于在轨加注的视觉感知方法智能程度低,无法感知复杂形态的卫星部件、无法适应复杂不确定的空间环境,此外,一般很难精确测量目标位姿。

随着人工智能的发展,深度强化学习(Deep Reinforcement Learning,DRL)在地面机器人操作中显示出了巨大的潜力[5]。经过多次重复的探索训练,机器人可以学得一种适应于环境的控制策略,从而高效地完成给定任务,这种深度强化学习方法为实现自主在轨加注提供了一种思路。利用深度学习(Deep Learning,DL)方法从传感器数据提取当前场景的状态特征,是深度强化学习的关键点之一。在在轨加注任务中,一种重要的传感器数据是相机或激光设备采集的当前场景的图像。相较于传统视觉感知方法,基于深度学习的图像感知方法能够自主感知复杂外形的目标,具备一定的鲁棒性和泛化性,无需精确计算目标位姿信息。因此,基于深度学习的视觉感知是在轨加注的一个重要发展方向,目前未见相关研究,但是基于深度学习的视觉感知已在其他领域有了广泛应用,例如自动驾驶[6]、人脸识别[7]和工业装配等。

在基于深度学习的视觉感知中,广泛采用的是卷积神经网络(Convolutional Neural Network,CNN)。在卷积神经网络中,采用层级的卷积层和池化层来逐级提取融合输入图像的特征,最终完成目标识别、检测和分割等任务,代表性的网络有ResNet[8],Faster R-CNN[9]和Mask R-CNN。Mask R-CNN由FAIR(Facebook AI Research)的何凯明等[10]于2017年提出,该网络在Faster R-CNN的基础上添加了一个掩模分支来做语义分割,Mask R-CNN在MS COCO数据集上的表现超越了MNC[11]和FCIS[12],是如今最成熟的目标检测分割算法。卷积神经网络属于联结主义,因此缺乏逻辑推理能力,只能对见过的模式进行特征提取。也就是说,对于那些未经训练的模式,尽管它们在更高层级的图像层上,且与训练过的模式高度相关,仍然无法被训练好的网络识别。

图神经网络(Graph Neural Network,GNN)可以用来处理相互关联的数据,也就是说图神经网络可以帮助理解数据之间的语义关系或空间关系,这赋予了网络逻辑推理能力,弥补了卷积神经网络的不足。相互关联的数据常用图结构表示,与欧几里得数据相比,图结构数据不规则、复杂,对数据的描述能力非常强大,典型的图结构数据就是知识图谱。GNN的起源可追溯至“先深度学习”时期,GNN被广泛用于社交网络[13]、搜索与推荐系统[14]、金融风险控制和信号灯预测等。以搜索与推荐系统为例,知识图谱的引入,使得互联网逐步从仅包含网页与网页之间超链接的文档万维网转变为包含大量描述各种实体和实体之间丰富关系的数据万维网,大大提升了搜索效率。文献[15]利用GNN作为推理模块来对深度神经网络进行扩展,并在视觉问答系统中取得了很好的结果。然而,GNN的隐藏状态更新函数需满足压缩函数的条件,这极大地限制了其表示能力;其梯度下降过程需迭代多次,计算代价很大;基于不动点的收敛导致结点间的隐藏状态存在较多信息共享,从而导致结点的隐藏状态过于光滑[16]。为了解决上述问题,学者们又提出了门控图网络(Gated Graph Neural Network,GGNN)和图卷积网络(Graph Convolutional Network,GCN)。

然而很少有人对知识图谱在视觉感知方面的应用开展研究。文献[17-18]利用嵌入知识的表示来识别细粒鸟类物种,文献[19]采用GCN识别多标签图像,文献[20]引入先验知识图谱提高了目标检测正确率。上述研究构造的知识图结构都比较简单,大多是基于物体间的语义关系。知识图谱广泛存在于视觉感知任务中,表示了物体和物体间的关系,主要包括语义关系和空间位置关系这两大类。

在轨加注面临非结构复杂环境,其特点为范围广、光照复杂和动态性强,例如:在服务航天器与目标航天器接触时,随着太阳照射角度变化,会产生复杂的光照情形。空间机械臂在这样的环境下自主完成操作任务时,需要具备自主识别和定位能力,实现对操作环境的实时、准确认知。相比于传统识别技术,深度学习能够自主提取复杂环境特征,实现完全基于样本的学习,具备一定的鲁棒性和适应性。然而基于卷积神经网络的目标检测方法,对相似实例的检测精确率低,对光照变化敏感,大大限制了基于深度学习的视觉感知方法在在轨加注任务中的应用。

本文针对在轨加注任务,提出了基于深度图推理(Deep Graph Reasoning Method,DGRM)的卫星背板部件的检测方法。相关研究的最初结果见文献[21],文献[21]对3种简单的目标的检测分割给出了数学仿真结果。相较于文献[21],本文对图卷积网络的结构展开了更加深入的研究,细化了图网络结构,给出了整体算法的流程图,在物理仿真中完整地验证了基于深度图推理的目标检测方法的正确性,并在实验室条件下验证了提出的方法对光照变化的强适应性和相似实例的高识别率。

1 检测方法

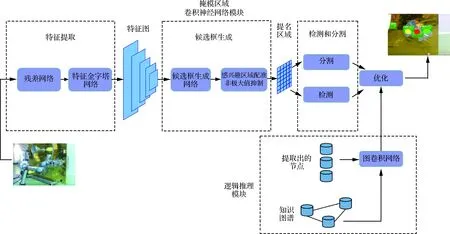

本文主要以Mask R-CNN为基础的卷积神经网络框架来提取图像特征,并在此基础上加入了基于知识图谱的逻辑推理模块,在提取的特征中融入先验信息来进一步做推理,以实现对相似部件的检测,并提高网络在光照变化的情况下的鲁棒性。

这里给出本文提出的基于深度图推理的卫星背板部件检测方法的流程图,如图1所示,包含2个主要模块:基于Mask R-CNN的表示学习模块和基于图卷积网络的逻辑推理模块,下面分别对这2个模块进行介绍。图中掩模区域卷积神经网络模块表示Mask R-CNN。

图1 基于深度图推理的卫星背板部件检测方法流程图

1.1 基于Mask R-CNN的表示学习

Mask R-CNN具备强大的图像特征提取能力,可以对目标进行像素级的精确定位,满足在轨加注的精细操作任务需求,因此采用Mask R-CNN来学习图像表征。Mask R-CNN包含3个主要模块:特征提取模块、候选框生成模块以及检测和分割模块,如图1中的Mask R-CNN部分所示。特征提取模块从输入图像中提取出多层级的特征,候选框生成模块基于提取出的多层级特征生成一系列候选框,最后,检测和分割模块基于多层级特征和候选框,实现对目标的识别、定位与分割。

1) 特征提取

Mask R-CNN以ResNet-FPN作为特征提取网络,ResNet-FPN具备强大的特征提取能力,可以用来识别结构复杂的卫星背板部件。ResNet-FPN在ResNet的基础上添加了一个特征金字塔网络(Feature Pyramid Network,FPN)结构。

ResNet是一种残差网络,由He[10]提出,其核心是在一般的深层神经网络中引入跳层连接,即恒等影射来解决神经网络随着层数的加深而出现的退化现象。神经网络可以通过自我学习将一些卷积层映射F设置为很小的数,即F(x)≈0,这就保证可将前面网络层的信息x,通过跳层结构传递至下一层网络,即F(x)+x≈x,从而保留每层网络提取到的特征图的关键信息。本方案采用了ResNet-50结构来提取特征,ResNet-50是融入跳层连接的50层卷积神经网络。

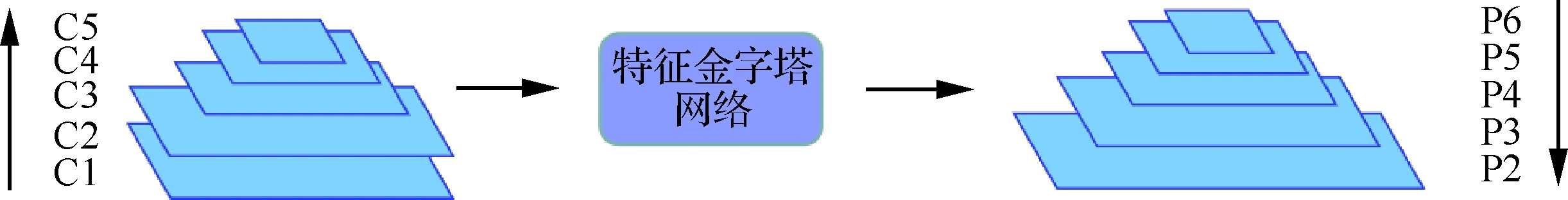

FPN[22]采用具有横向连接且自上而下的路径方法将ResNet-50浅层高分辨率、弱语义特征图与高层低分辨率、强语义特征图相融合,使得所有尺度上的特征图都具备强大的表示能力,其示意图如图2所示,其中C1~C5是由ResNet-50生成的5个不同尺度的特征图,P2~P6是经由FPN融合相邻特征图的表达能力更强的新的特征图,FPN由卷积操作和池化操作构成。

图2 FPN的多尺度特征融合过程

2) 候选框生成

Mask R-CNN采用RPN(Region Proposal Network)来生成候选框。RPN在ResNet-FPN生成的多个特征层面P2~P6上,都生成了相应的候选区域,这些候选框的尺寸各不相同,RPN由卷积操作和全连接操作构成。由于后续的检测和分割模块需要以固定尺寸的特征图作为输入,因此采用了RoIAlign将候选框的特征图归一化为相同尺寸,相较于采用量化操作的RoIPooling,RoIAlign在输出候选框坐标时,采用双线性内插算法,这解决了归一化前后特征图不对齐的问题。经过上述RPN的计算和RoIAlign操作后,会得到多达上万的候选框,大多数候选框存在相互交叠的情况,因此采用非极大值抑制(Non-Maximum Suppression,NMS)算法可以去除交并比高的候选框,保留少数关键的候选框RoI。

3) 检测和分割

检测和分割模块主要由卷积操作和全连接操作构成,候选框RoI被分别送入检测和分割分支,检测分支对候选框进行目标分类和定位,分割分支对候选框进行目标像素级分类,即目标分割,两条分支构成一个多任务学习网络,在训练过程中,两个分割的损失同时在最终的损失函数L中体现,互相促进各任务的学习。

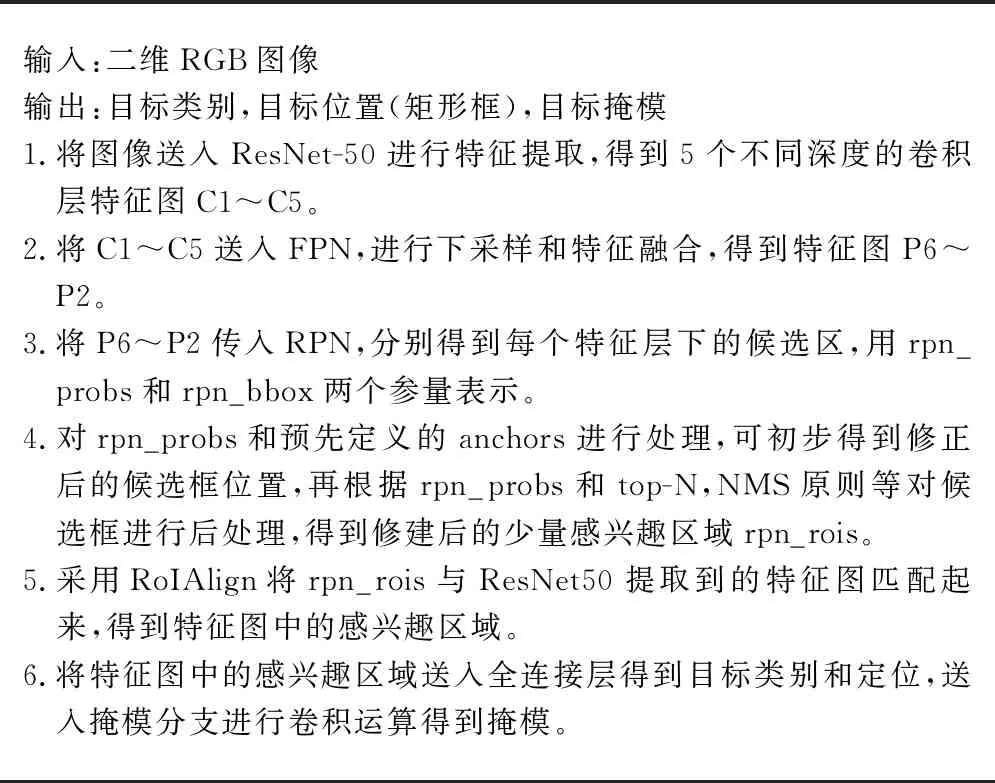

定义多任务损失L=Lcls+Lbox+Lmask,采用梯度下降法来学习网络参数。其中Lcls、Lbox的定义和Faster R-CNN的定义一致,衡量了分类代价和定位代价。由于分割分支实际是对感兴趣像素点的分类,因此Lmask定义为平均二值交叉熵损失。在测试时,整个算法的伪代码如算法1所示。

算法1 Mask R-CNN算法伪代码

输入:二维RGB图像输出:目标类别,目标位置(矩形框),目标掩模1.将图像送入ResNet-50进行特征提取,得到5个不同深度的卷积层特征图C1~C5。2.将C1~C5送入FPN,进行下采样和特征融合,得到特征图P6~P2。3.将P6~P2传入RPN,分别得到每个特征层下的候选区,用rpn_probs和rpn_bbox两个参量表示。4.对rpn_probs和预先定义的anchors进行处理,可初步得到修正后的候选框位置,再根据rpn_probs和top-N,NMS原则等对候选框进行后处理,得到修建后的少量感兴趣区域rpn_rois。5.采用RoIAlign将rpn_rois与ResNet50提取到的特征图匹配起来,得到特征图中的感兴趣区域。6.将特征图中的感兴趣区域送入全连接层得到目标类别和定位,送入掩模分支进行卷积运算得到掩模。

1.2 基于图卷积网络的逻辑推理

本文在基于Mask R-CNN的表示学习的基础上,提出了基于图卷积网络的逻辑推理模块。

图像中的单个目标是由各具特征的子部件组合而成,且各目标都不是孤立存在的,具有一定的排布关系,将这些结构化信息与卷积神经网络提取到的图像表征相结合,可以实现相似实例的检测分割,并保证网络在复杂光照条件下的鲁棒性。知识图谱可以将先验信息融入特征提取过程中,利用图卷积则可以对知识图谱进行操作,在图节点间传播先验信息,增强关键节点,削弱不相关的节点。

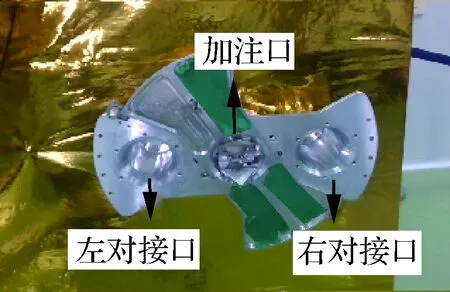

卫星背板上的部件的正确检测对于加注操作任务来说至关重要,尤其是加注口的正确检测,正确的识别与定位为加注工具的对接及加注提供了保障,实验中用到的加注端结构如图3所示,从左至右依次为左对接口、加注口和右对接口。记表示学习模块检测到的左对接口、加注口、右对接口、10 N发动机和490 N发动机为知识图谱的节点。

图3 加注端上的目标

逻辑推理模块通过构建知识图谱G={X,A},并利用GCN做逻辑推理。在知识图谱G的构建时,对基于卷积神经网络的表示学习模块学到的特征进行抽取,组成节点初始特征X∈RN×9,N为表示学习模块检测到的目标的数量,当检测到2个以上的目标时,需要进行进一步的逻辑推理。对每一个目标,抽取学到的9维特征来初始化节点特征,具体的,若xi表示第i个目标的节点特征,那么将xi的第i个元素设置为检测到的实例为“目标i”的置信度,将xi的第6~9个元素设置为“目标i”的边界框坐标。考虑到各目标具有确定的位置关系,引入一个非标准的单位上三角矩阵A∈RN×N作为邻接矩阵,其对角线元素为0。本文设计的知识图谱是变结构的,其结构由检测到的目标的数量N决定,相比于固定结构的知识图谱,检测精确率和运行效率更高。

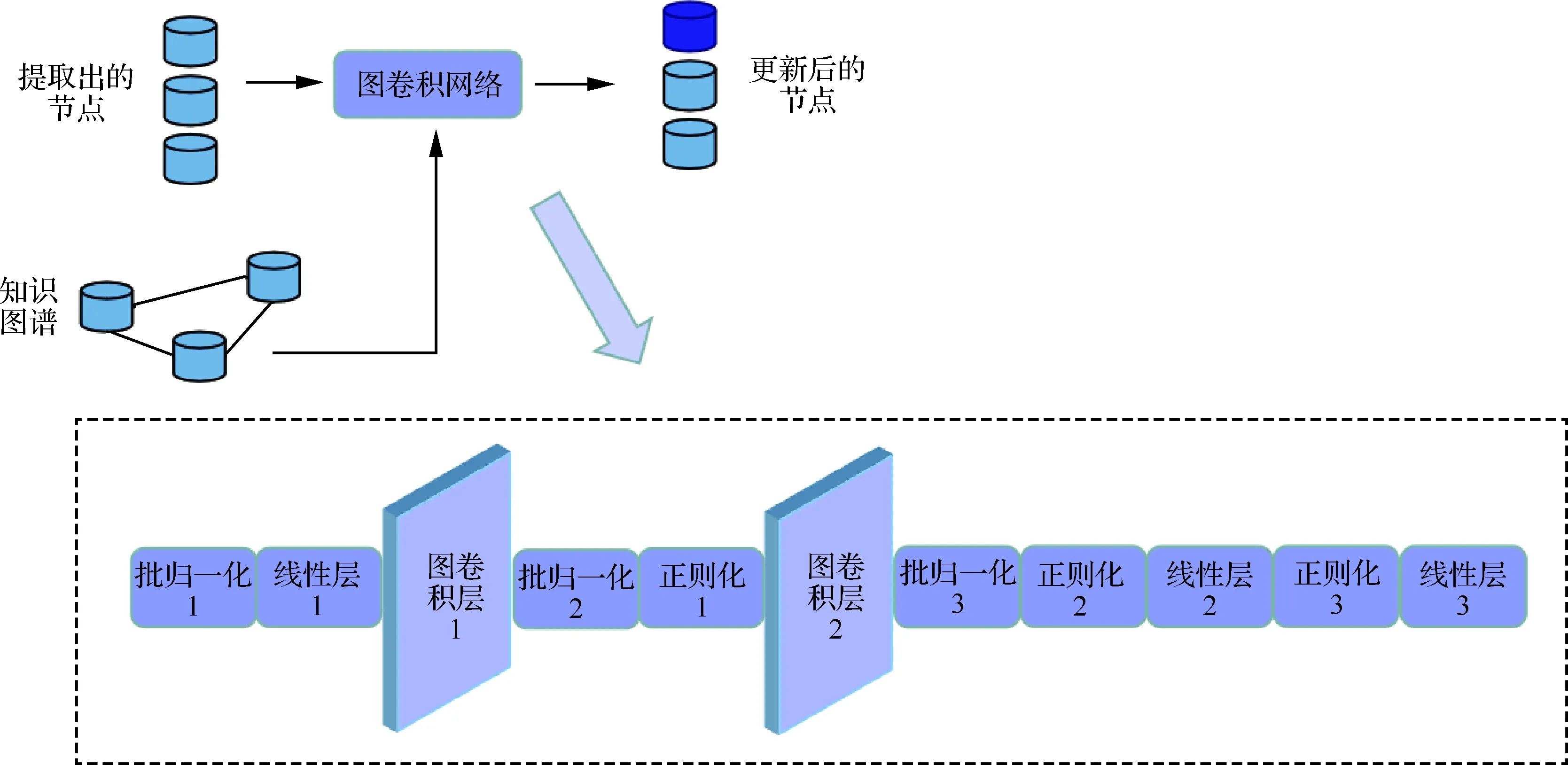

在构建知识图谱G后,采用图卷积网络实现先验知识在节点间的传播并对节点特征进行更新。设计的图卷积网络结构如图4所示,图卷积网络包含2层图卷积层,3个全连接层,3次批归一化(Batch Normalization,BN)操作以及2次非线性变换操作。其中图卷积层1将节点特征维数由9维扩增至12维,图卷积层2将12维特征压缩提取为6维,图卷积层的计算公式为[23]

图4 GCN的网络结构

(1)

在逻辑推理模块,图网络解决的实际是分类问题,因此,选取交叉熵损失来训练网络,一个批的交叉熵损失为

(2)

式中:m为批内样本个数;n为每个样本的维数;p为数据的真实概率分布;p(xi)表示样本的真实标签;q为数据的预测概率分布;q(xi)表示网络的实际输出。

2 数学仿真

在本文提出的基于深度图推理的卫星背板部件检测方法中,逻辑推理模块是提高检测方法鲁棒性的重要部分。因此,在数学仿真中重点验证了该模块的有效性,认为基于卷积神经网络的表示学习部分是已经完成训练的,即可获得实例的检测置信度以及其边界框的坐标。本节内容是根据文献[21]仿真得到的,仅对对接口和加注口的推理检测进行仿真。

根据成像原理,采用数学仿真方法生成目标孔的坐标(像素坐标系下的坐标)和置信度,即世界坐标系和图像坐标系的变换关系。在本任务中,假定目标都在同一个平面上,建立世界坐标系,取ZW=0,那么摄像机模型为

(3)

(4)

在仿真中,在一定的约束下随机生成n、o、p,再根据给定的目标在世界坐标系下的坐标XW、YW,便可生成目标在图像坐标系下的坐标u、v。

为了使GCN能够正确检测卷积神经网络无法处理的相似实例,即提高加注端3个孔的检测率,降低误检率和漏检率,本文按照一定比例生成了检测正确的目标、误检的目标(分类错误)和漏检目标(测到了但置信度比较低),这3类情况在真实物理仿真中最为最常见,最后以npy文件格式存储这些生成数据。

在训练阶段,读取npy文件中的数据作为网络结点的初始特征,按照式(2)定义的损失函数训练设计的图卷积网络。图5表示了训练过程中损失函数变化,横坐标为训练次数,纵坐标为损失函数的值,损失函数收敛的比较快,在约300次训练后,就收敛到了极小值。相较于卷积神经网络,图网络结构层数较浅,参数较少,收敛的更快。

图5 训练过程中图卷积网络的损失函数的变化(数学仿真)

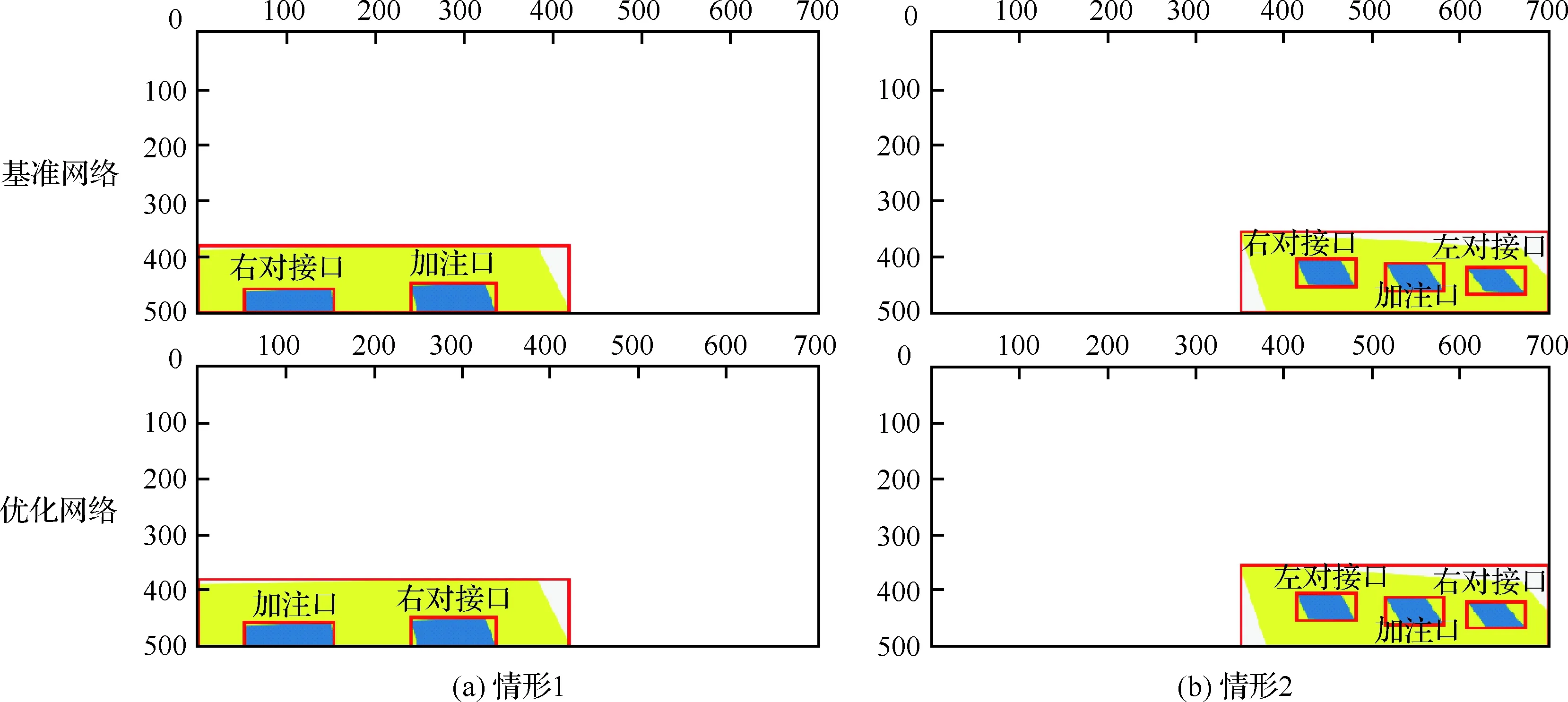

图6和图7分别给出了漏检和误检情况下的仿真结果,横纵坐标轴模拟了图像坐标系下的横纵坐标轴。

图6是漏检情况下的仿真结果,图6(a)和图6(b) 的第1行和第2行分别都表示了仿真生成数据模拟的基于Mask R-CNN的表示学习模块(基准网络)和基于知识图谱的逻辑推理模块(优化网络)对相同输入图像的检测结果。在图6(a)中,基准网络没有检测到“加注口”,但是优化网络却可以正确检测到“加注口”。而在图6(b)中,在图7中,基准网络没有检测到“右对接口”,而优化网络正确的检测到了“右对接口”。

图6 基准网络和优化网络对加注端的漏检结果

图7是误检情况下的仿真结果,图7(a)和图7(b)的第1行和第2行分别都表示了仿真生成数据模拟的基于Mask R-CNN的表示学习模块(基准网络)和基于知识图谱的逻辑推理模块(优化网络)。在图7(a)中,基准网络将“加注口”检测为了“右对接口”,而将“右对接口”检测为“加注口”,这对后续操作很不利,优化模块则正确检测出了“右对接口”和“加注口”。在图7(b)中,基准网络错误的检测了“左对接口”和“右对接口”,优化网络则将“左对接口”和“右对接口”正确的定位出来了。

图7 基准网络和优化网络对加注端的误检结果

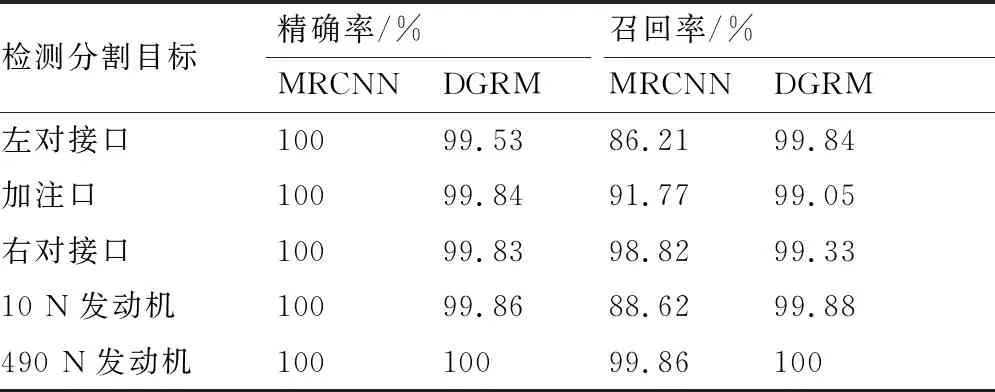

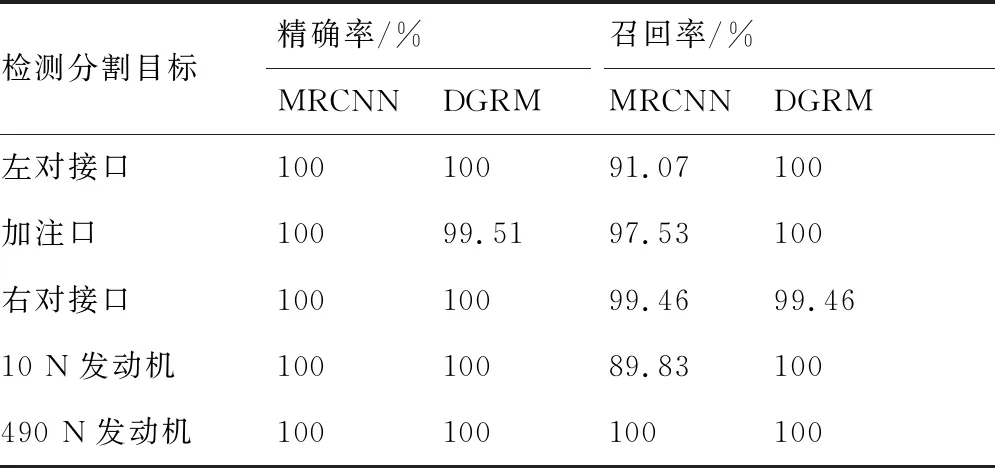

表1和表2分别对训练阶段及测试阶段的基准网络和优化模块的目标检测正确率进行了统计,可以看到优化模块对相似实例的检测率有了显著的改善,且模型具有较好的泛化性。

表1 基准网络和优化模块对加注端的检测精确率(训练阶段)

表2 基准网络和优化模块对加注端的检测精确率(测试阶段)

3 物理仿真

为了验证本文提出的基于深度图推理的卫星背板部件检测方法对相似部件的检测效果,以及算法在复杂光照下的检测效果,搭建了地面物理演示实验系统和算法平台,并制备了训练和测试数据集。

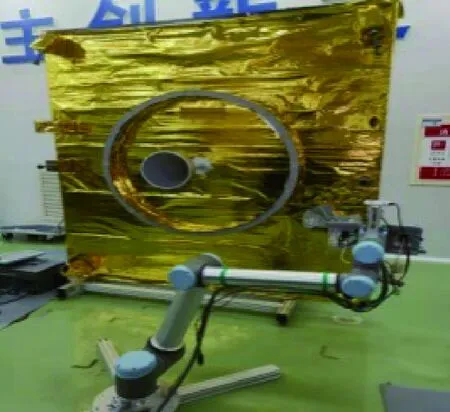

1) 地面物理演示实验系统

地面物理演示实验系统主要根据在轨加注的学习训练环境的情况进行设计,用于模拟空间机械臂对受体航天器的在轨加注过程,如图8所示。

图8 物理实验系统

系统主要包括以下几个部分:模拟空间机器人的UR10工业机械臂,末端配置单目手眼相机和六维力传感器;模拟受体航天器的模拟卫星端面,端面配置有对接环、10 N发动机、490 N发动机和天线等;模拟燃料加注装置,包括加注主动端和被动端;用于网络训练的智能算法服务器;其他供配电系统。

2) 算法平台

硬件环境主要包括:1块64位、16核CPU;1块P40显卡;1个IntelRealSense D435相机。软件环境包括:Ubuntu 16.04.5 LTS操作系统;Caffe2深度学习平台;编程语言为Python3.6。

3) 数据集

为了训练基于Mask R-CNN的表示学习模块,使用手眼相机采集2 500张不同角度卫星端面图像并使用Labelme软件进行标注,共标注了背板上的5类关键目标,分别是10 N发动机、490 N 发动机、左对接口、加注孔、右对接口,记上述2 500张图像为训练样本集I。

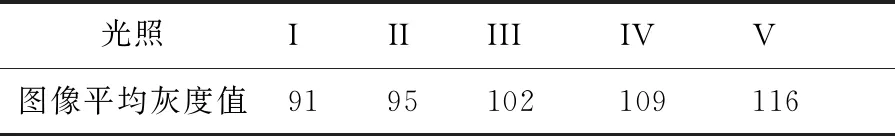

为了训练基于图卷积网络的逻辑推理模块并验证算法在复杂光照下的检测效果,在实验室环境下,通过调节光照亮度,模拟了5种不同的光照环境,在5种光照环境下,通过示教学习,让机械臂在相同的运动轨迹下采集模拟卫星端面的图像,这样可以排除如成像角度和运动模糊等因素对算法检测效果的影响。5种光照环境下,采集到的图像的平均灰度值如表3所示。

表3 5种光照环境下图像的平均灰度值

分别在5种光照环境下采集图像,并从光照I环境下采集到的样本随机抽取30%数量的图像,从光照V环境下采集到的样本随机抽取30%数量的图像,一同作为训练样本,来训练图卷积网络,这部分训练样本共包含483张图像,记为训练样本集II。而用光照I环境下采集的剩下70%数量的图像,光照II、III、IV环境下采集到的全部图像,以及光照V环境下采集的剩下70%数量的图像来测试提出的基于深度图推理的卫星背板部件检测方法,这部分样本共包含3 626张图像,记为测试样本集。

4) 训练与测试

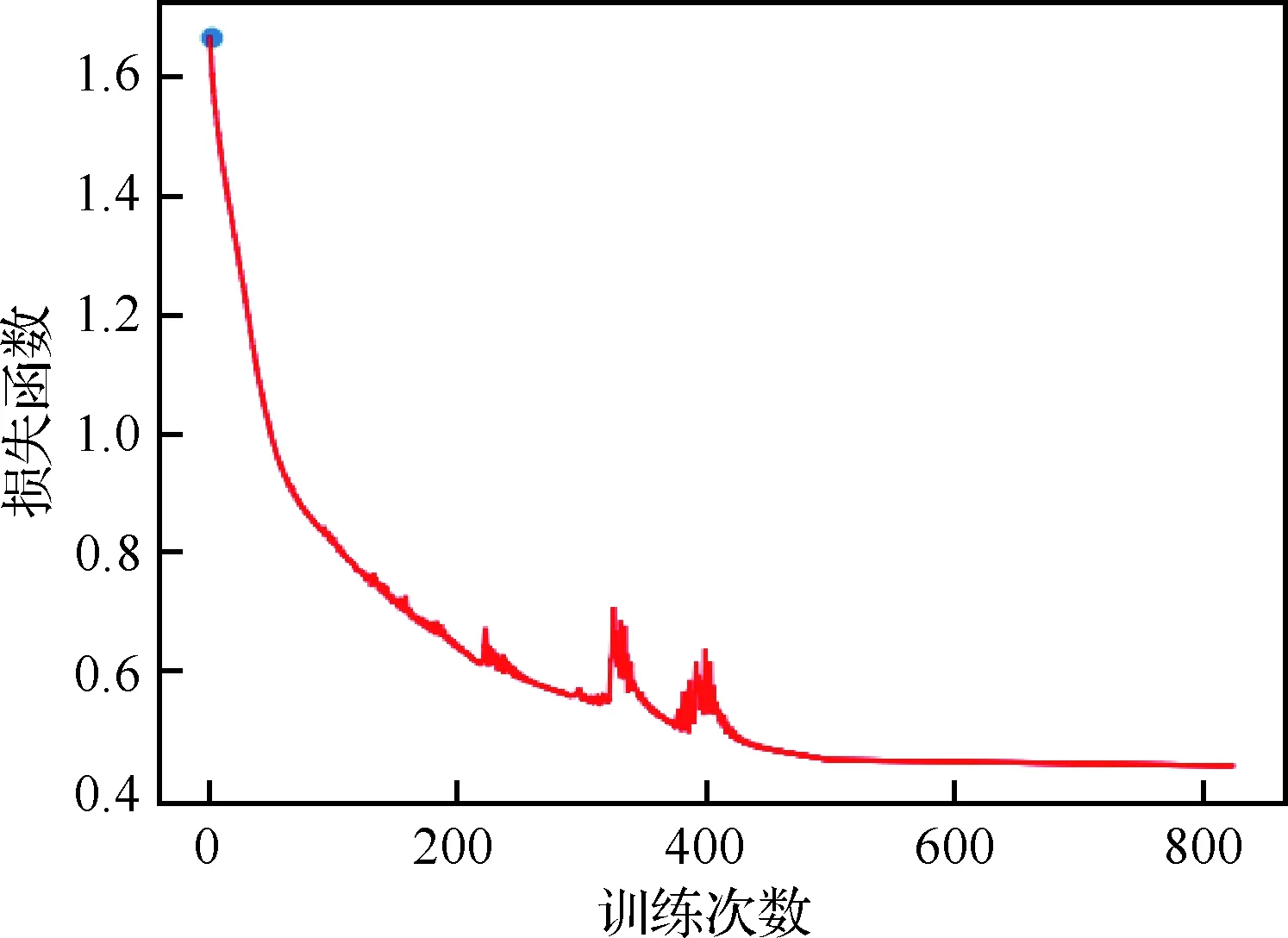

在训练过程中,分别训练Mask R-CNN和图卷积网络。利用训练样本集I训练Mask R-CNN时,用梯度下降法不断优化网络参数以使损失函数下降,初始学习率lr=0.02,并按照0.000 1的衰减率减少,在第60 000次和第80 000次衰减学习率,批内样本数为512;在训练好的Mask R-CNN的基础上训练图卷积网络,将训练样本集II送入训练好的Mask R-CNN网络,并将检测到的加注端上的目标的置信度和边界框坐标抽象为图卷积网络的初始特征,采用Adam优化方法训练图卷积网络至损失函数收敛,初始学习率lr=0.01,每500次训练步衰减0.1的学习率,在10 000 次循环后,损失降到了0.006 254,损失函数的变化如图9所示,横坐标为训练的次数,纵坐标为损失函数的值。

图9 训练过程中图卷积网络的损失函数的变化(物理仿真)

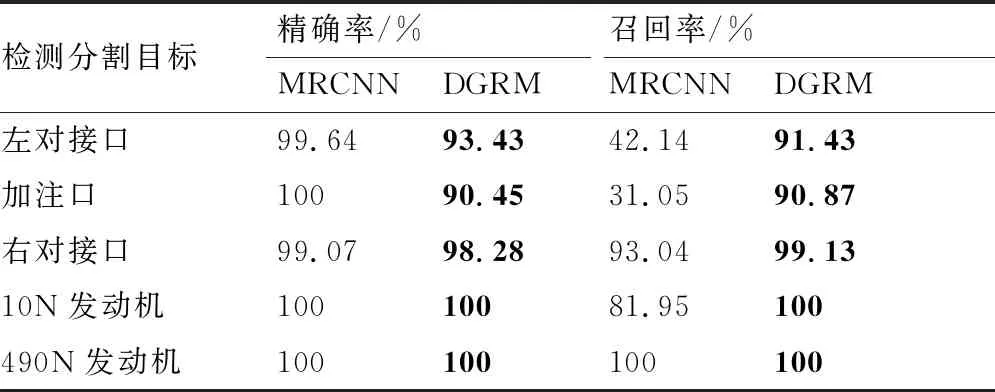

为了评估提出的基于深度图推理的卫星背板部件检测方法的有效性,分别采用提出的方法(记为DGRM)和Mask R-CNN(记为MRCNN)对测试样本集进行了目标的检测和分割,并就加注端上的左对接口、加注口、右对接口、490 N发动机、10 N发动机这5类关键目标的精确率(Precision)和召回率(Recall)这2个指标进行比较(检测阈值 thresh=0.95)。精确率反应了目标的误检测情况,而召回率反应了目标的漏检测情况。精确率和召回率的计算公式为

(5)

(6)

式中:TP表示分类正确且分类结果为正样本;FP表示分类错误且分类结果为正样本;FN表示分类错误且分类结果为负样本,正样本表示计算指标时所考虑的样本类别,而负样本表示除了正样本以外的其他样本类别,以计算10 N发动机的精确率为例,正样本为10 N发动机,而2个对接口,一个加注口和490 N发动机均为负样本。结果如表4~表8所示。

表4 光照I下样本检测的精确率和召回率

表6 光照III下样本检测的精确率和召回率

表7 光照IV下样本检测的精确率和召回率

表8 光照V下样本检测的精确率和召回率

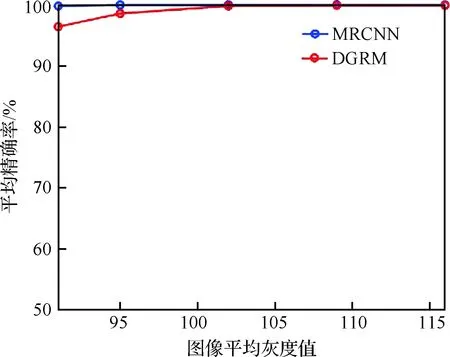

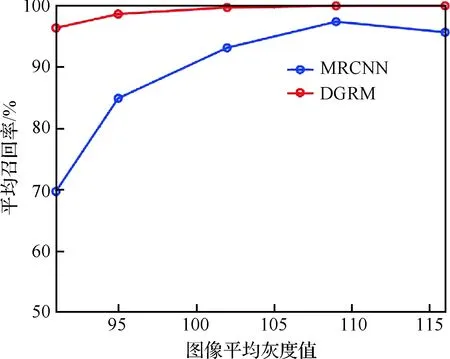

在不同的光照强度下,MRCNN和DGRM对卫星背板上的5类关键目标的平均检测精确率和召回率分别如图10和图11所示,以5种光照强度下采集到的图像的平均灰度值为横坐标来表示不同的光照强度,横纵坐标均为无单位常量。

图10 光照I~光照V下MRCNN和DGRM检测平均精确率

图11 光照I~光照V下MRCNN和DGRM检测平均召回率

随着光照强度由暗到明(光照I~光照V),MRCNN方法,除了在光照I下,对左对接口的检测精确率为99.64%,对右对接口的检测精确率为99.07%,在光照I~光照V下,对其他各类目标的检测精确率均为100%,这说明在变化的光照下,MRCNN对背板上的各类目标几乎不存在误检测的情况,这是因为各类目标的外形差异较大,而MRCNN具备良好的复杂目标特征提取性能;采用MRCNN方法,变化的光照对各类目标检测的召回率产生了不同的影响,对于右对接口、加注口和10 N发动机这3类目标,随着光照的增强,其召回率先提升后稳定,对于左对接口,随着光照的增强,其召回率先由62.22%(光照I)提升至99.06%(光照IV),后降低至91.07%(光照V),对于490 N发动机,其召回率稳定在100%(光照III下为99.86%),这可能是因为490 N发动机的尺寸明显大于其他4类目标,且由相对粗糙的材料制造,对光照的反射弱于其他4类目标,光照对于大尺寸、光反射性能弱的目标的漏检影响更小。

综上所述,变化的光照影响MRCNN对目标的检测效率,在本实验中,主要体现在影响了目标检测的召回率。

在相同的光照强度下,相较于MRCNN,DGRM大幅提高了目标检测的召回率,见图11;对于精确率而言,尽管在光照I和光照II下,DGRM对目标检测的平均精确率略低于MRCNN方法,但仍高于96%,在可接受的范围内。

随着光照强度由暗到明(光照I~光照V),DGRM对目标检测的平均精确率和平均召回率是逐渐提升的,但幅度不大,总体来说较稳定,且均高于96%。这说明,在变化的光照环境下,DGRM具有更优的目标检测效率,也就是说,DGRM是一种适用于一定范围变化光照下的一种高效目标检测方法。

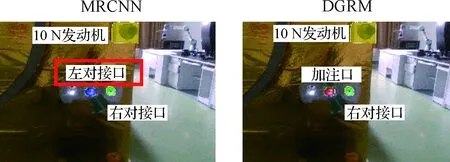

给出光照I~光照V下,MRCNN和DGRM对相同图像(仅光照不同)的检测结果,如图12所示。图中蓝色、红色、绿色、黄色、白色掩模分别表示左对接口、加注口、右对接口、10 N发动机和490 N发动机(图13和图14相同)。

图12的图像结果和表5~表9数据结果一致,即变化的光照对MRCNN的检测召回率有影响,而DGRM在变化的光照下的检测召回率较高且稳定。在光照I和光照II下,尽管DGRM未能将加注口正确的检测出来,但是,相较于MRCNN,也分别正确检测出右对接口和左对接口。

图12 光照I~光照V下MRCNN和DGRM的检测分割结果

在光照I下,MRCNN和DGRM对相同图像(仅光照不同)的检测结果,如图13所示。

如图13所示,MRCNN将加注口错误的识别为左对接口,而DGRM识别结果正确,这说明DGRM可以对有效地区分相似实例。

图13 光照I下MRCNN和DGRM对相似实例的检测分割结果

MRCNN和DGRM对模拟卫星端面的检测分割结果如图14所示。可以看到,相较于MRCNN,DGRM对复杂形状的目标均有良好的检测效果。

图14 MRCNN和DGRM的检测分割结果

4 结 论

1) 本文采用的基于深度学习的方法,可以有效地检测复杂形状的目标,不依赖于手工设计的特征。

2) 相较于基于卷积神经网络的目标检测方法,本文提出的基于深度图推理的方法提高了复杂光照环境下部件的检测正确率。

3) 本文提出的基于深度图推理方法可以有效地区分外形相似的不同部件。

4) 本文提出的基于深度图推理方法的有效性在数学仿真和物理仿真中均得到了验证。