面向图神经网络的对抗攻击与防御综述

陈晋音,张敦杰,黄国瀚,林翔,鲍亮

面向图神经网络的对抗攻击与防御综述

陈晋音1,2,张敦杰2,黄国瀚2,林翔2,鲍亮3

(1.浙江工业大学网络空间安全研究院,浙江 杭州 310023;2. 浙江工业大学信息工程学院,浙江 杭州 310023;3. 信息网络安全公安部重点实验室,上海 200000)

面向已有的图神经网络的攻击与防御方法,较全面地综述了图神经网络对抗攻防技术与鲁棒性分析。首先,综述了图神经网络在不同任务下的对抗攻击与基于不同策略的防御方法,并全面介绍了鲁棒性分析技术;随后,介绍了常用的基准数据集与评价指标;最后,提出了未来可能的研究方向和发展趋势。

图神经网络;对抗攻击;防御算法;鲁棒性分析

1 引言

随着人工智能技术的研究与发展,深度学习在自然语言处理[1-3]、图像识别[4]、信号处理[5]、物体识别[6]等领域中表现不俗,卷积神经网络就是其中的典型代表之一。图数据由于其强大的表达能力,在现实生活中有着广泛的应用[7]。但是基于图结构不具有平移不变性,每一个节点周围结构可能大不相同,这使传统的深度学习模型难以发挥作用。针对具有不规则的空间结构的图数据,研究人员[8-11]尝试将神经网络推广用以处理任意结构的图,图神经网络[12-16]应运而生。

图神经网络可以巧妙地从图数据中提取特征,而这些被提取出来的特征可以完成许多图数据分析任务,如节点分类[17-18]、链路预测[19-20]、社区发现[21-22]和图分类[23]等。这些图数据分析任务又被广泛应用于社交网络[24]、推荐系统[25-26]、电子商务网络[27]等实际场景。假如应用于这些实际场景的图神经网络算法存在明显的漏洞,可能会带来严重的后果。例如,在电子商务领域,网络水军的存在给真实用户带来了极大的困扰和误导;在社交网络中,一则虚假消息如果不能被有效地检测出,有可能导致谣言散播,造成不良影响。因此,图神经网络的安全性问题也是研究热点之一。

在对图神经网络的安全性研究过程中,研究者发现:图神经网络很容易被一些微小的扰动迷惑,这类扰动被定义为对抗性扰动。对抗攻击发生在模型的测试阶段,攻击者根据模型结构精心设计微小的扰动,并将其添加在原始数据中,从而使图神经网络模型误判,达到愚弄图神经网络模型的目的。而通过对图神经网络的攻击研究可以发现图神经网络存在的缺陷。根据这些漏洞提出相应的防御措施来增强模型的鲁棒性显得尤为重要。Zügner等[28]首次提出在图上进行对抗攻击,他们提出的NETTACK算法通过重要的数据特征(如度分布)选择候选的连边和特征,在评估函数的指导下选择修改得分最高的连边或特征来生成微小的对抗性扰动,并更新对抗性网络,以此使图神经网络失效。之后,面向图神经网络的对抗攻击方法的研究相继展开:Dai[29]、Wang[30]、Zhou[31]、Bojchevski[32]、Sun[33]、Chen[34-37]等[38-45]纷纷加入了对抗攻击的研究行列。此外,面向图神经网络的防御方法的研究陆续展开,如Dai[29]等尝试在训练中随机丢弃一些连边来达到一定的防御目的;Feng[46]、Chen[47]等利用对抗训练来使模型对对抗攻击具有一定的鲁棒性;而其他研究者分别从不同的角度提出了相应的防御方法[48-56]。

Jin等[57]对现有的对抗攻击方法进行了一系列的描述和详细分类。同样地,Sun等[58]详细阐述了面向图卷积网络的对抗攻击方法。Chen等[59]根据攻击的不同应用场景和防御的不同原理分别对其进行了系统的分类,并强调了相关评价指标的重要性,对其进行了全面的调查和总结。值得注意的是,他们的研究主要集中于分析现有的对抗攻击和防御方法原理并对其分类。本文针对图挖掘的不同应用任务,分别详细介绍现有的对抗攻击、防御方法与相应的评价指标,并重点介绍模型鲁棒性分析技术,最后总结图挖掘攻防未来可能的研究方向。

本文旨在针对不同的攻击分类标准与防御策略分别定义对抗攻击与防御,并对已有的面向图神经网络的对抗攻击和防御方法、常用数据集及评价指标进行系统综述,并展望面向图神经网络攻防方法未来的可能研究方向和发展趋势。图神经网络鲁棒性分析方法作为面向图神经网络的防御方法中的一个分支,对模型或数据安全给出了更多的理论性分析与评估,本文同样对当前图神经网络的鲁棒性分析方法进行了详细的描述和分析。

2 图神经网络攻防理论分析

本节首先介绍了图神经网络常见的图数据类型和主要的下游图分析任务,随后给出了图神经网络攻击的统一建模,最后分别介绍了图神经网络攻击与防御的理论定义,并根据攻击与防御方法的不同层面进行分类与分析。

2.1 图神经网络

2.1.1 图数据的类型

在实际应用中,根据不同数据本身的特性,图具有多种表现形式,本节进一步介绍不同类型的图数据。

同构图与异构图:在实际应用中,节点与连边往往存在多种类型。由多个类型的节点/连边构成的图称为异构图,如开放学术图(OAG)[64]存在论文、作者、领域、机构和地点5个类型的节点。类似于上述的Facebook数据集[61],若图仅包含一个类型的节点与连边,则称之为同构图。

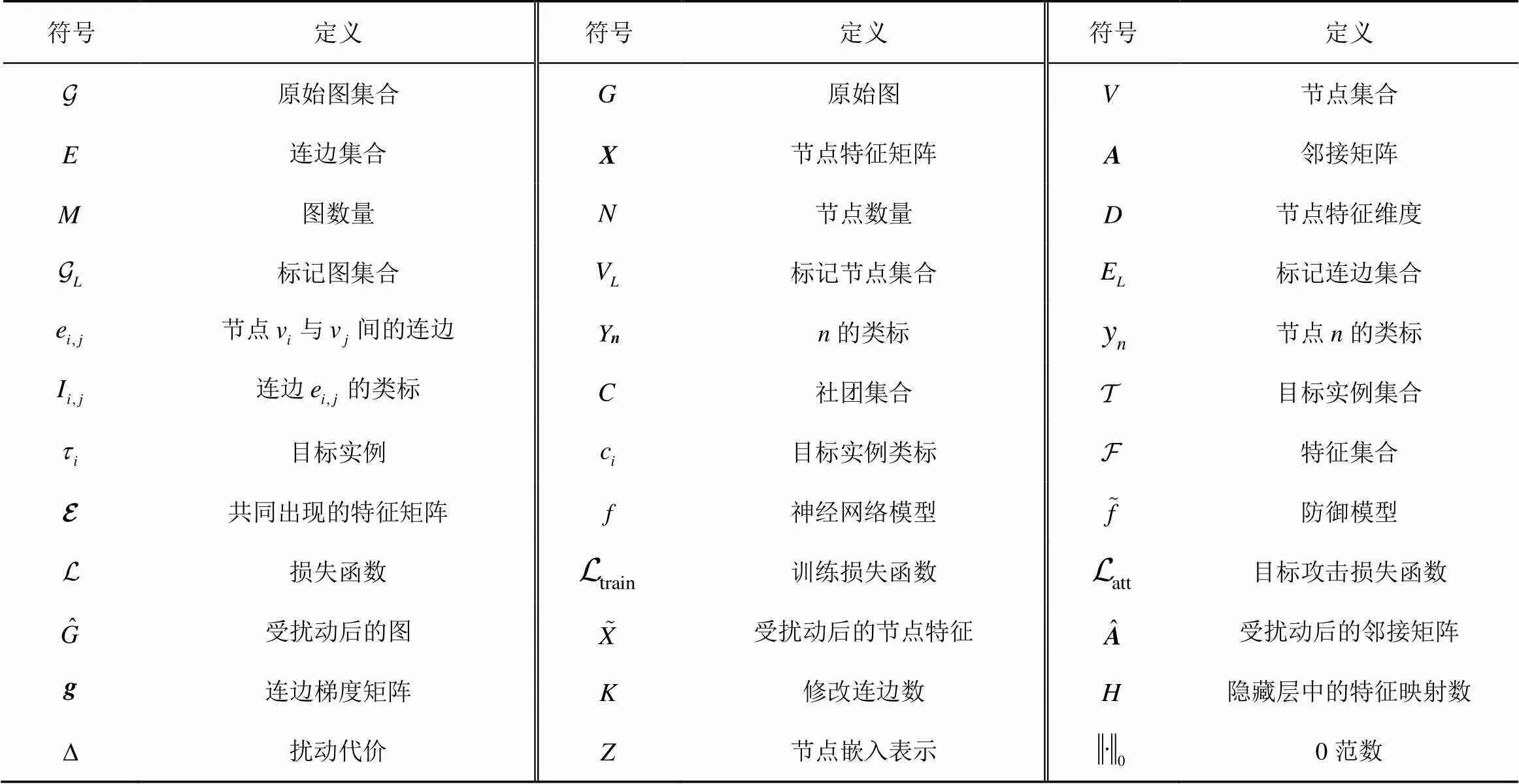

表1 常用符号及定义

2.1.2 不同的下游任务

图神经网络的发展促进了许多下游的图分析任务的应用,本节根据下游分析任务关注的不同目标(节点、连边、图和社区结构),主要介绍4类图挖掘任务:节点分类任务、链路预测任务、图分类任务和社区检测任务。

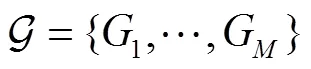

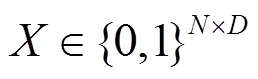

图分析任务学习的统一表示为

2.2 攻击统一建模

(3)

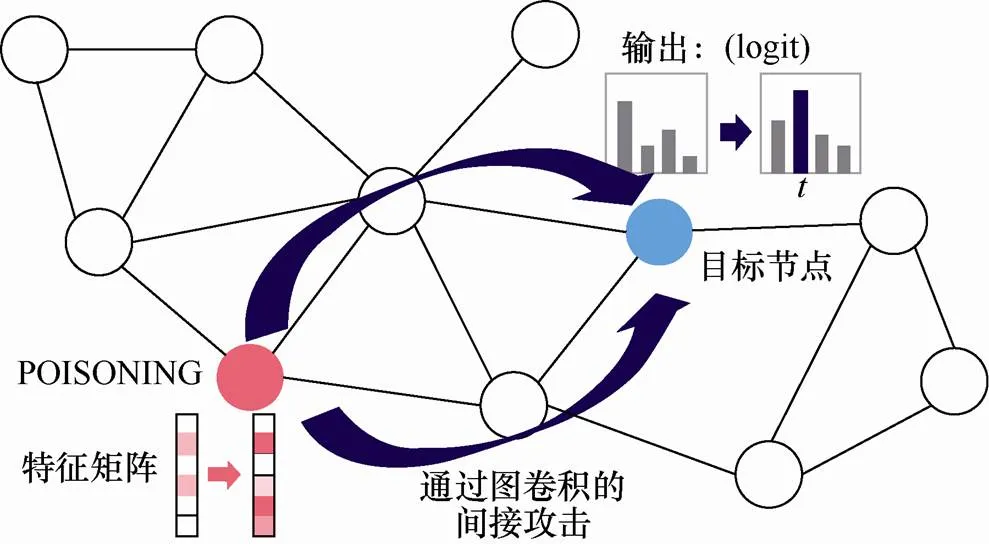

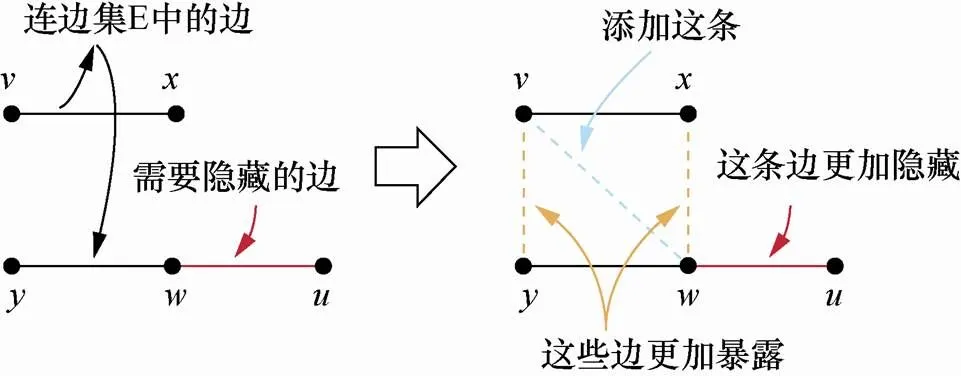

图1为对抗攻击的示意图(以修改连边为例),图2为攻击前后对后续任务的影响示意图。

图1 针对图卷积神经网络的对抗攻击

Figure1 Adversarial attack on graph neural network

2.3 图神经网络攻击原理

2.3.1 不同知识背景的攻击

白盒攻击:目标模型的参数、训练数据、类标和预测输出均可知,攻击者根据这些已知信息进行攻击策略的选择,如利用模型的梯度信息产生攻击。在实际情况中往往无法获得这些信息,因此白盒攻击常用于评估目标模型在极端恶劣的情况下的鲁棒性。

图2 对抗攻击对后续任务的影响

Figure2 Impacts of adversarial attacks on downstream tasks

黑盒攻击:攻击者对目标模型的参数、训练数据、类标和预测输出均不可知,仅通过目标模型的输入和输出信息实施攻击,因此黑盒攻击更具有挑战性。

灰盒攻击:在模型结构不能完全已知情况下,使用带有类标的数据训练一个替代模型,近似目标模型结构,并对此模型实施白盒攻击生成,完成对真实目标模型的攻击,称之为灰盒攻击。

2.3.2 不同攻击策略

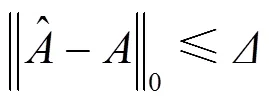

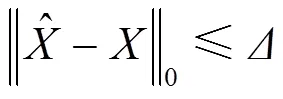

修改连边:图数据的拓扑结构在很大限度上决定了图的特性,在指定的攻击代价下增/删网络中的连边数量以达到对图数据拓扑结构的攻击,往往能对图神经网络产生明显的影响。连边攻击的代价可以表示为

添加虚假节点及对应连边:攻击者为了保存网络原有节点与连边的信息,通过向网络中添加虚假节点和对应的部分连边实现攻击,添加虚假节点通常伴随着对应连边的增加,其攻击代价可以表示为

2.3.3 不同的攻击能力

2.3.4 不同的攻击目标

无目标攻击:以节点分类任务为例,无目标攻击并不关心目标样本的预测结果,只要预测是错误的,就认为攻击成功。

目标攻击:要求图神经网络将目标样本误分类成攻击者指定的类标。从难度上来说,有目标攻击的实现难于无目标攻击。

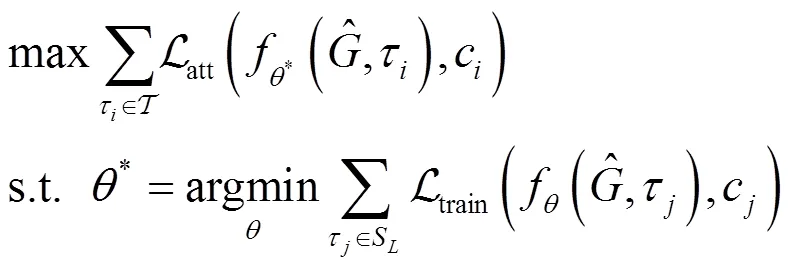

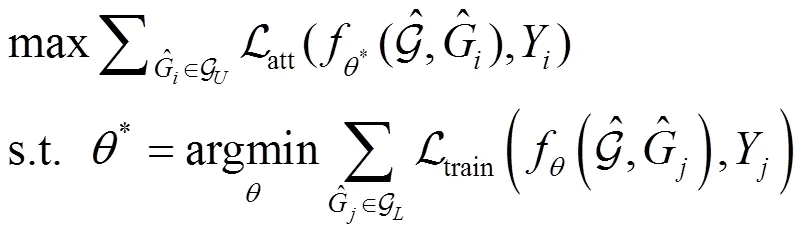

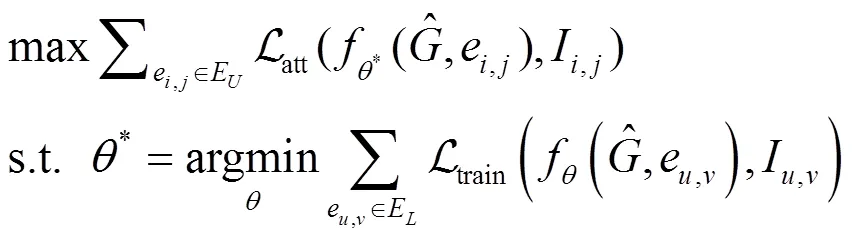

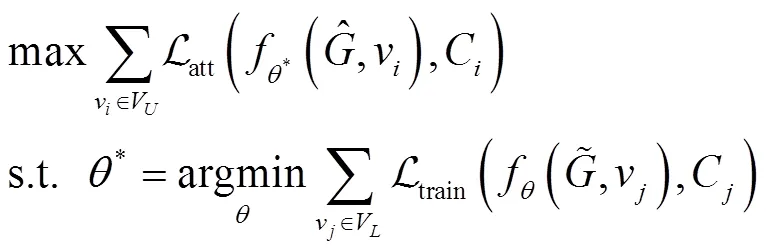

2.3.5 不同的攻击任务

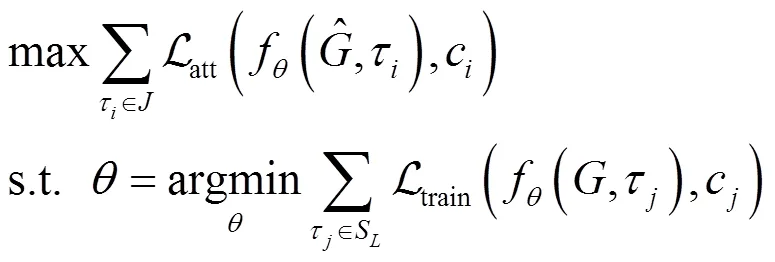

根据上文所述的图攻击能力,中毒攻击需要改变目标模型的参数,这使中毒攻击相较于对抗攻击更加复杂。本文以中毒攻击为例,介绍攻击不同图神经网络任务的原理。

以多个网络作为输入,实现对某个网络的攻击。

其中,表示连边存在状态,值为0或1,根据现有信息降低存在连边的可能性。

其中,C为节点v所属的社团。

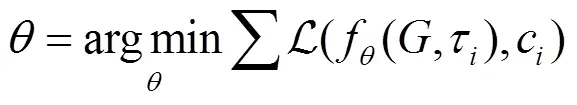

2.4 图神经网络防御原理

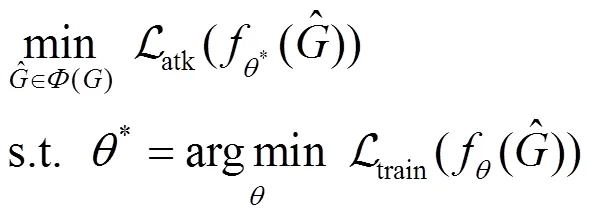

随着图神经网络攻击研究的逐步深入,面向图神经网缉私的防御方法的研究也进展迅速,针对不同的对象提出了防御策略,可将防御问题描述如下。

本节根据防御策略的不同对当前的防御方法进行系统分类,并对一些面向图神经网络的鲁棒性方法进行原理分析。

2.4.1 不同的防御策略

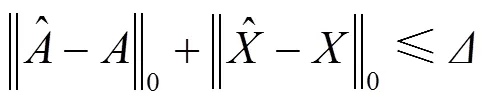

1) 对抗训练:常用防御方法之一,将对抗样本打上正确类标对模型进行训练,使模型具备对应攻击方法的防御能力,该防御方法受对抗攻击方法的限制,即对未知的对抗攻击无法实现对抗训练完成防御。对抗训练分为两种类型。

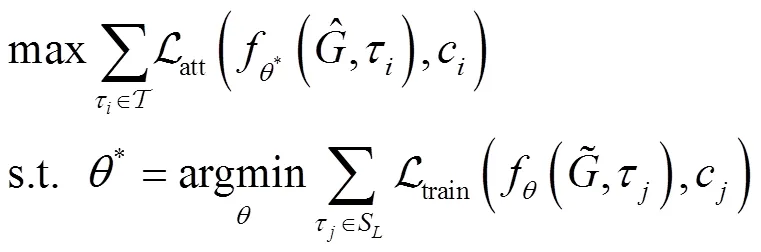

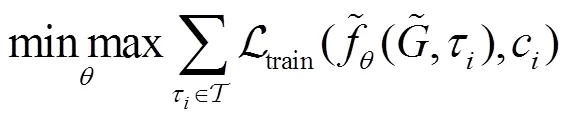

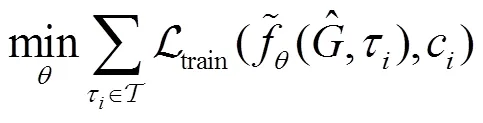

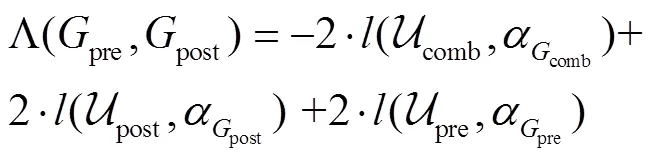

①在两种相反的目标函数(最小化和最大化)的指导下,在连续的最小−最大博弈中逐步优化模型,目标可以描述为

2) 对抗性扰动检测:一些工作更侧重于对抗性攻击的检测,此类方法通过研究对抗性样本和干净样本之间的差异实现对抗性扰动检测。对抗性扰动检测虽然不能起到直接防御的作用,但是可以作为一种对应图神经网络攻击的监控手段,提前发现对抗性扰动以更有效率地进行下一步的防御措施。

3) 启发式:此类方法在可接受的花费(指计算时间和空间)下给出图神经网络训练中待解决组合优化问题的每一个实例的一个可行解。

4) 图纯化:此类方法主要用于防御中毒攻击。图纯化方法将受到中毒攻击的图数据进行纯化,然后在纯化后的图上训练图神经网络模型。

5) 注意力机制:此类方法学习一种注意力机制,用来区分对抗性扰动和干净的样本,通过惩罚对抗性节点或连边上的权重来训练出鲁棒的图神经网络模型。

2.4.2 面向图神经网络的鲁棒性分析

图神经网络的鲁棒性分析同样是攻防研究的重点方向,可以理解为图神经网络的鲁棒性分析是图神经网络防御研究的一个方向。与其他防御方法不同,面向图神经网络的鲁棒性分析在防御对抗攻击的同时,对模型或数据的安全性进行评估。这种评估可以衡量不同网络结构和图深度模型对对抗扰动的敏感性,在网络结构重要性分析和图深度模型的可解释性研究中均具有关键性作用。

3 面向图神经网络的对抗攻击方法

上文对图神经网络攻击方法从不同几个方面进行了分类,并给出了对应的原理分析,为了加深对图神经网络攻击的理解,本节总结图神经网络攻击的相关研究,并详细介绍现有图神经网络攻击技术,对算法中一些和图神经网络攻击相关性较弱的部分只进行简单的探讨。不同攻击方法的侧重点不同,根据攻击所针对的任务类型,可以将这些方法分为:针对节点分类的攻击方法、针对图分类的攻击方法、针对链路预测的攻击方法和针对社区检测的攻击方法。需要指出的是,图神经网络攻击方法可以在不同的分类标准上做出多种分类结果,由于同种攻击目标任务的攻击方法在攻击结果上有更高的相似性,本节以不同的攻击目标任务作为分类标准,对现有的图神经网络攻击方法进行回顾。表2是对图神经网络攻击方法的归纳,为保证行文的流畅性,本节的论述主要是按时间顺序组织的[67]。

3.1 节点分类攻击

3.1.1 NETTACK

针对节点分类任务,Zügner等[28]首次提出在图上进行对抗性攻击,并提出了NETTACK算法,迭代生成对抗性网络,以此对GCN[68]进行攻击。为了确保对抗扰动不明显,本节从3个角度分析扰动大小限制问题。

(1)修改代价:为了确保攻击者不能完全修改图数据,算法首先通过一个代价限制允许的变化数量,限制节点属性和邻接矩阵的改变量的总和不能大于一个上限。

3.1.2 RL-S2V

表2 对抗攻击算法分类

图3 GeneticAlg示意

Figure 3 Illustration of GeneticAlg

图4 GradArgmax示意

Figure 4 Illustration of GradArgmax

3.1.3 FGA

3.1.4 Greedy-GAN

Wang等[30]指出,在很多情景下,攻击现有的网络结构或特征矩阵是不现实的。他们通过恶意添加虚假节点,并将虚假节点连接到已有节点实现对图数据的攻击。针对假节点邻接矩阵和特征矩阵设计中的离散输入空间问题,本文提出了一种贪婪算法来生成恶意节点的连边及其对应特征,以最小化目标节点的分类精度。为了确保扰动的隐蔽性,Greedy-GAN通过添加一个判别器,利用判别器与攻击者的迭代训练确保虚假节点与真实节点的相似性。

3.1.5 ADW

3.1.6 Metattack

Zügner等[40]研究了针对节点分类的图神经网络,扰乱离散图结构的训练中毒问题。文章提出了首个破坏全局节点分类性能的中毒攻击Metattack,并将其表示为一个二次优化问题。

Metattack的核心思想是使用元梯度来解决上述问题,本质上是将图结构作为超参数,构造元梯度来优化。

3.1.7 控制图结构的图分类攻击

3.1.8 DAGAER

Avishek等[70]将对抗性攻击视为一个生成模型问题,他们提出一种统一的编码器−解码器框架(DAGAER)来生成对抗性样本的完整分布,能够有效地为单个给定的输入生成一组不同的攻击。

图5 DAGAER的主要组成部分与上代对抗性例子

Figure 5 The main components of DAGAER and the forward generation of an adversarial example

3.1.9 IG-FGSM/JSMA

Wu等[71]证明通过引入综合梯度可以很容易地解决图数据攻击中的离散性问题,该梯度可以准确地反映扰动某些特征或连边的效果,同时可充分利用并行计算提高效率。他们提出两种梯度攻击方法IG-FGSM与IG-JSMA,前者基于目标模型的损失函数获得梯度,而后者根据GCN模型输出的预测结果获得梯度。不同于FGA的梯度攻击,该方法考虑到对节点属性的攻击,根据梯度计算连边与节点属性的重要性,选择更重要的修改项(连边或属性),进一步实现攻击操作。

3.1.10 梯度投影攻击

Xu等[72]提出了一种新的基于梯度的攻击方法,使处理离散图数据变得更加容易。他们提出一阶攻击生成框架的两种攻击场景:①攻击一个预定义的GNN;②攻击一个可再训练的GNN。针对这两种场景,利用一阶优化,提出两种新的拓扑攻击:投影梯度下降(PGD)拓扑攻击和最小最大(Min-max)拓扑攻击。

3.1.11 GF-Attack

GF-Attack通过构造对应的图滤波器来描述图嵌入模型,以黑箱攻击方式仅对图过滤器进行攻击,改变节点的特征值,进而影响网络嵌入方法的输出结果。

3.1.12 ReWatt

Ma等[39]指出,图神经网络的攻击通常是通过添加或删除一些边来实现的,即使修改的边的数量很少,也可能会引起注意,因此提出了一个图形重布线的操作(ReWatt)实现对图神经网络的攻击,它对图的影响相对不明显。ReWatt使用强化学习来学习基于重布线操作的攻击策略。这种策略的一个明显优点是它不会改变图的节点数、边数和总度。然而,单一的添加或删除操作可能会改变这些属性。

3.1.13 NIPA

3.1.14 GUA

3.1.15 POISONPROBE

Takahashi等[74]指出,在图卷积分类器中,一个节点的分类结果可能会受到它邻居节点的影响。他们提出POISONPROBE,如图6所示,该方法攻击目标节点两跳甚至多跳邻居节点的节点特征,实现对目标节点的有效攻击。

图6 通过毒害单一节点的非直接对抗攻击

Figure 6 Indirect adversarial attack by poisoning a single node

POISONPROBE首先给出了中毒节点的选择方法:定义中毒效率分数,类似于将中毒信息从候选者传递到目标路径的带宽,如果分数很小,中毒信息将通过路径缩小,限制扰动的大小。POISONPROBE算法由外环和内环两部分组成。内环发现较小的扰动,在几个参数固定的情况下可以达到预期的目标攻击。然后,外环利用二叉搜索迭代地发现参数。如果内部循环成功找到对抗的扰动,它将降低内环中初始常数λ。

3.1.16 MGA

3.2 链路预测攻击

3.2.1 Triads Attack

图7 CTR的主要思想说明

Figure 7 Illustration of the main idea of the CTR

图8 OTC的主要思想说明

Figure 8 Illustration of the main idea of the OTC

3.2.2 IGA

针对链路预测任务,Chen等[35]提出了一种基于已训练的图形自动编码器(GAE)中梯度信息的迭代梯度攻击(IGA)。IGA针对现实网络的复杂性和网络攻击的局限性,提出了无限攻击和单节点攻击两种对抗攻击策略,对GAE的损失函数计算得到损失函数关于连边的梯度矩阵,根据梯度矩阵对应位置元素的正负值与绝对值选择需要修改的连边来实现攻击。

3.2.3 Opt-Attack

3.2.4 Approx-Local

Zhou等[31]系统地研究攻击者操纵链路预测的能力,通过删除有限数量观察到的连边子集,以最小化一组目标链路的总加权相似度得分;重点研究了相似性度量的两个重要子类:仅利用目标链路的局部信息的局部度量和使用全局网络信息的全局度量。

对于局部度量,他们提出了一种最小化局部度量上界的算法,对应于在基数约束下最大化子模函数,确定了两种特殊情况:① 攻击单个连边,确保对所有局部度量的最佳攻击;② 攻击一组节点而第二种情况确保对共同邻居度(CND,common neighbor degree)指标的最佳攻击。对于全局度量,证明即使在攻击单个连边时,最小化Katz相似度和最大化ACT全局相似性度量都是NP困难的。针对这两个问题,他们分别提出了有效的贪婪算法(Greedy-Katz)和启发式算法((Local-ACT)。

3.2.5 TGA

3.3 图分类攻击

图分类常见于对生物结构的分类任务,通过学习图整体结构的低维嵌入对图整体进行分类。针对图分类的攻击,旨在使图分类器分类错误,从而降低图分类模型的准确率和召回率。与节点分类攻击相比,针对图分类模型的攻击研究相对较少。

3.3.1 RL-S2V

在3.1.2节中,Dai等[29]除了对节点分类任务进行了攻击。在图分类任务中,RL-S2V利用图分类模型得到马尔可夫决策过程(MDP)中的奖励值,GeneticAlg和GradArgmax通过图分类模型的损失函数计算适应性分数与梯度。

3.3.2 多层次图池化神经网络的对抗性攻击

Tang等[79]探讨了多层次图池化(HGP)神经网络的脆弱性,提出了对基于多层次GCN的图分类模型的对抗攻击。多层次GCN图分类模型中的多层次池化算子倾向于保留对图分类更重要的节点,作者利用一个卷积算子和池化算子构建代理模型,并将其池化算子保留的节点设置为攻击目标,基于梯度方法添加/删除连边或修改节点特征以产生对抗样本,从而欺骗多层GCN中的池化算子,使其保留错误节点。在扰动的隐蔽性层面,作者通过编辑距离[80]与二阶DELTACON0图距离[81]限制在图结构上的扰动,并以L1范数对节点特征扰动加以限制。

3.3.3 PA后门攻击

Zhang等[82]针对基于GNN的图分类提出了一种基于子图的黑盒后门攻击,生成随机子图作为后门触发器,具体使用4个参数设定后门攻击:①设置子图节点数目作为触发器大小;②子图中连边总数与节点对数的比值为触发器密度;③采用优先依附模型生成具有与真实图相似幂律分布的后门触发器;④以测试图被毒化的分数作为中毒强度。一旦攻击者向测试图注入一个预定义的后门触发器,GNN分类器就会预测攻击者为测试图选择的目标类标。

3.3.4 GTA

3.4 社区检测攻击

3.4.1 Q-Attack

3.4.2 EPA

3.4.3 EDA

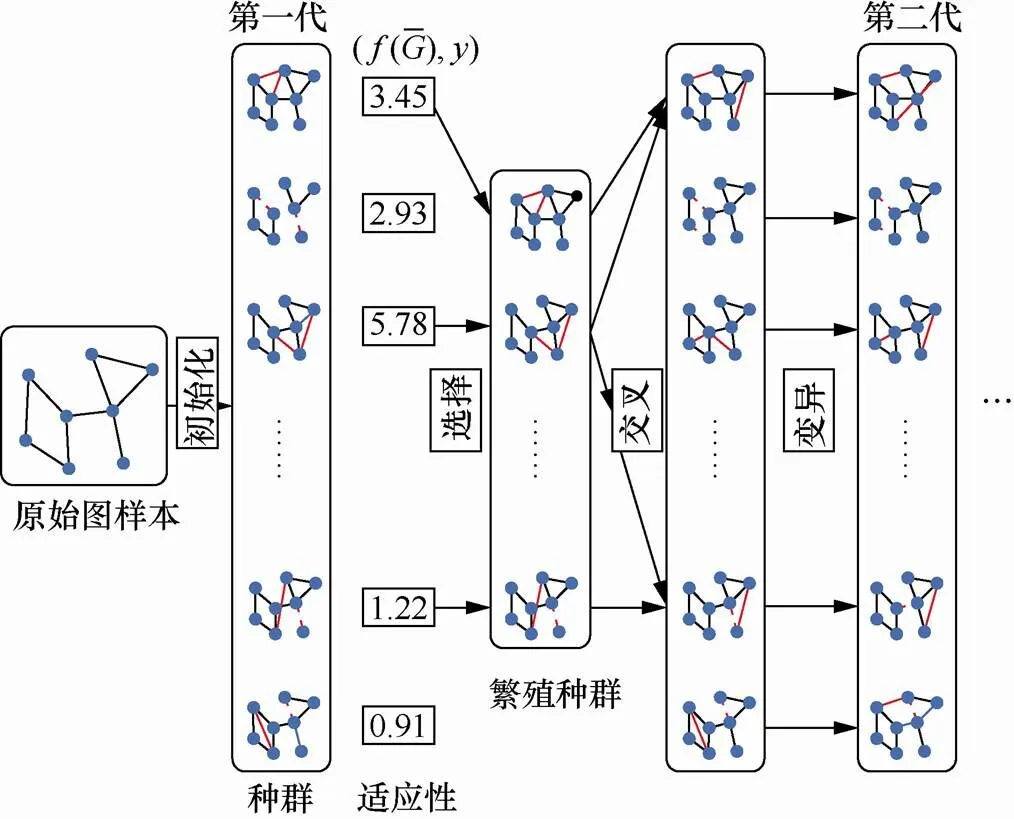

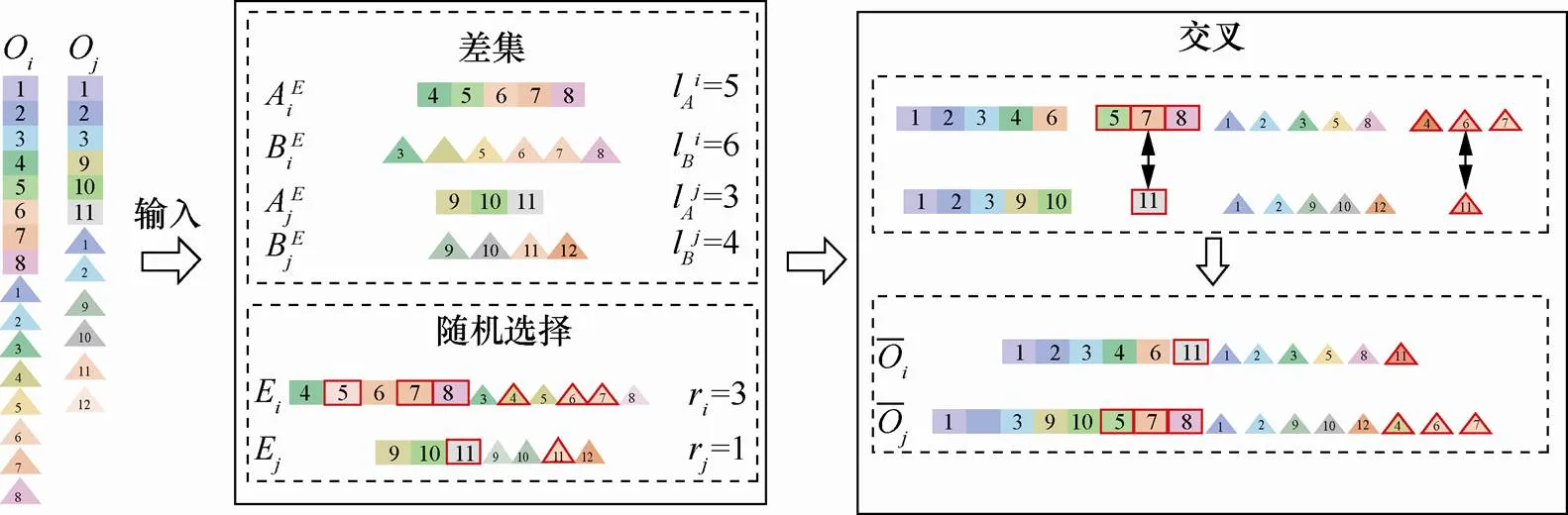

Yu等[85]提出了一种新的无监督网络嵌入攻击策略EDA,以嵌入向量间的欧几里得距离为参考,采用遗传算法(GA)寻找EDA的最优解。EDA算法由3部分组成:网络编码、适应度选择、交叉和变异操作。①选择翻转后的连边作为基因,基因的组合作为个体,表示对抗性扰动的不同解,不同的个体组成一个种群;②通过攻击获取嵌入空间中向量欧几里得距离的相对变化,并通过所提出的自适应度函数计算个体的适应度;③选择适应度较高的个体作为亲本,通过交叉和变异操作产生新的个体,最终实现对图数据的攻击。

3.4.4 CD-Attack

图9 不相等交叉示意

Figure 9 Illustration of non-equal crossover operation

3.4.5 DICE

4 面向图神经网络的防御方法

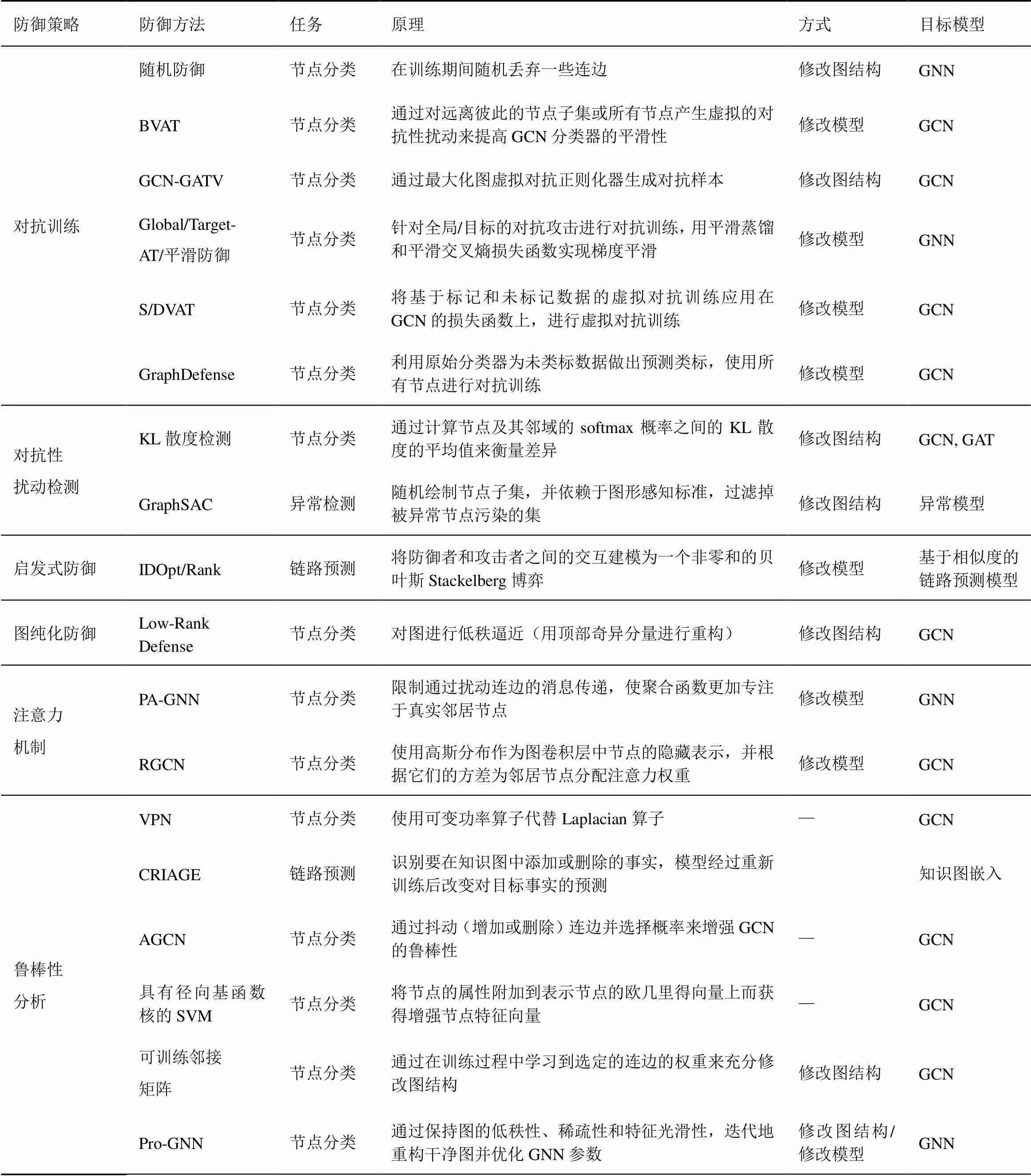

上文以不同攻击目标任务为分类标准,详细介绍了现有图神经网络攻击技术,本节以不同的防御策略作为分类标准,将现有的面向图神经网络防御方法分为:对抗性训练、对抗性扰动检测、启发式防御、图纯化防御和注意力机制。本节按照上述分类标准对现有图神经网络防御方法进一步展开,并详细介绍部分面向图神经网络的鲁棒性分析方法。一些经典的防御方法如表3所示。

4.1 对抗性训练

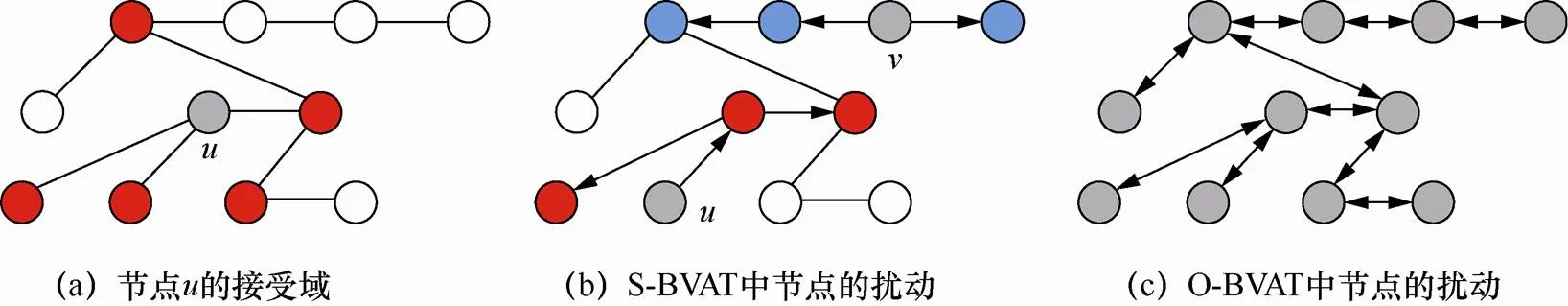

4.1.1 BVAT

4.1.2 GCN-GATV

Feng等[46]提出图对抗训练(GAT)的方法以及GAT的扩展GATV。GAT的每次迭代可以看作在进行一个极小极大的博弈:①从干净样本中生成图的对抗性扰动,最大限度地破坏连接节点之间的平滑性;②增加一个正则化器,通过激励对抗样本和对应干净样本预测结果之间的平滑性来最小化图神经网络在图对抗样本上的目标函数,提升模型对于通过图传播扰动的鲁棒性。

与GAT相比,GATV可以看作3个玩家共同玩两个极大极小游戏,在训练目标函数中额外加入一个虚拟对抗正则化器。当图对抗性扰动是输入特征变化的方向时,可以最大限度地攻击图对抗性正则化器,通过在当前的模型参数下最大化图对抗正则化器来生成虚拟对抗样本,平滑每个干净样本周围的预测分布,进一步增强模型的鲁棒性。

4.1.3 平滑防御

表3 防御方法分类

图10 BVAT扰动示意

Figure 10 Illustration of perturbations for BVAT

4.1.4 S/DVAT

Sun等[48]指出,GCN中的参数更新仅来自标记节点,缺乏对未标记数据的利用。作者将基于标记和未标记数据的虚拟对抗训练(VAT)应用在GCN的损失函数上,对稀疏特征与稠密特征进行了虚拟对抗扰动,提出GCNSVAT与GCNDVAT算法来提高GCN的局部平滑性。

他们对GCN的局部频谱卷积的一阶逼近进行了重点分析,并在GCN的基本损失函数上添加虚拟对抗损失,形成了GCNVAT算法。在此基础上,根据节点特征的稀疏特性,GCNSVAT对每个节点的特定稀疏元素进行虚拟对抗扰动,而GCNDVAT将稀疏特征矩阵转换为稠密特征矩阵来扰动每一个特征元素。实验表明,经过虚拟对抗训练的GCN模型的性能得到了进一步的提升。

4.1.5 Graph Defense

4.2 对抗性扰动检测

此类方法通过研究对抗性样本和干净样本之间的差异来对对抗性扰动进行检测。

4.2.1 KL散度差异检测

4.2.2 GraphSAC

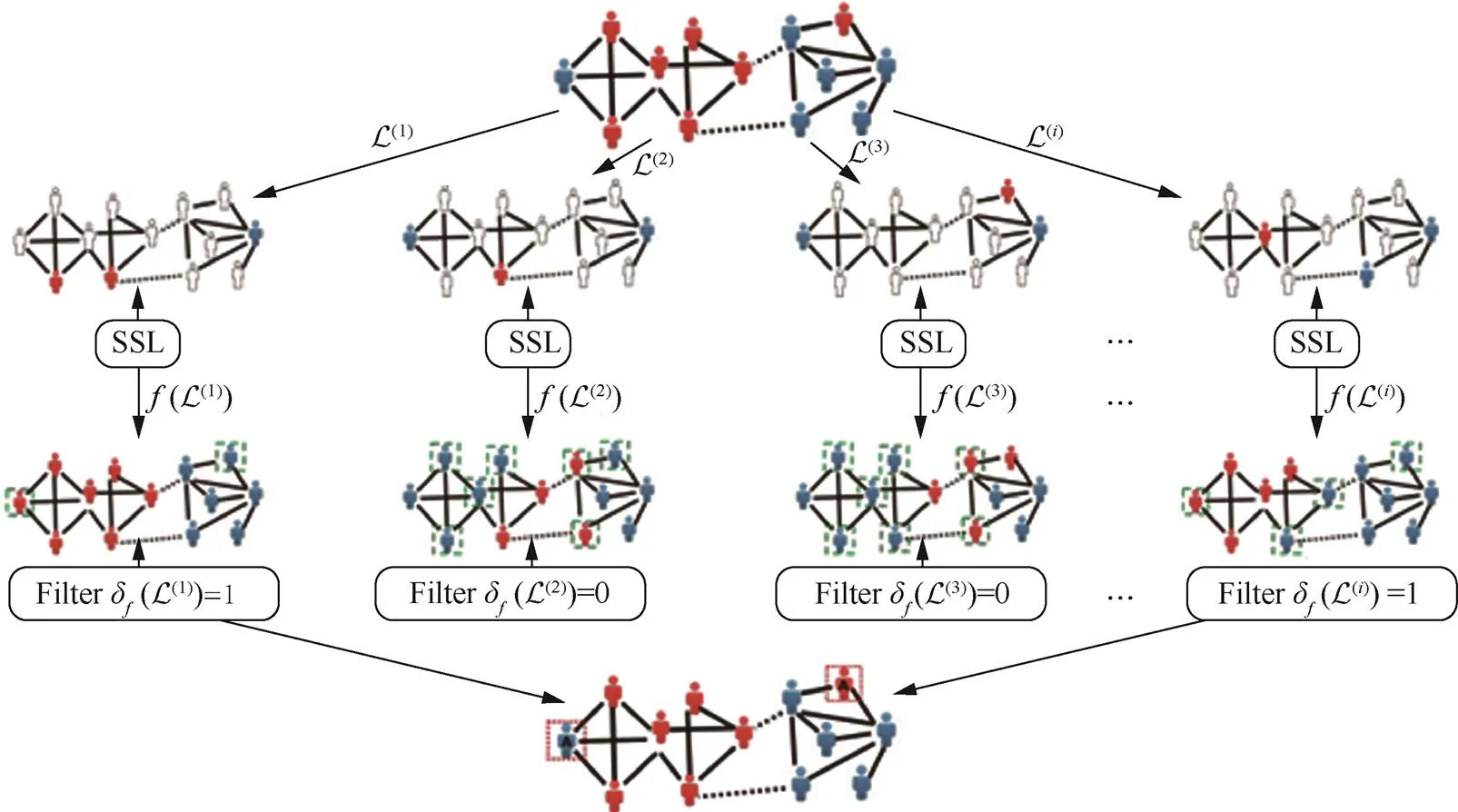

Ioannidis等[90]提出的GraphSAC随机绘制节点子集,依赖于图感知标准,在使用半监督学习(SSL)模块估计每个节点的标称类标分布之前过滤掉被异常节点污染的集合。由于每次绘制的复杂性与连边的数量呈线性增长关系,GraphSAC通过限定所需的绘制数量,实现高效的SSL。

图11展示了GraphSAC的运作过程,第一行表示可用的图和类标。第二行表示采样的类标。第三行的SSL模块包含输出预测类标。第四行的绿色虚线表示分类不正确的节点。第五行的过滤器判断损失函数是否包含异常。第六行的红色框表示含有大量错误分类节点的预测被丢弃。最后通过结合来自干净子集的预测结果来检测异常。

4.3 启发式防御

Zhou等[91]为了提高基于相似性的链路预测的鲁棒性,提出一种新的方法来准确地度量被查询连边的存在可能。他们定义分析者(防御者)与攻击者两个概念,将分析者和攻击者之间的交互建模为一个非零和的贝叶斯Stackelberg博弈,分析者首先提交一组可靠的查询,攻击者在观察分析者的决策后选择要删除的连边集。文章提出了两种防御方法。①独立损伤优化IDOpt:将防御者的问题表示为可利用标准技术线性化的非线性整数规划,利用其解得到在独立损伤近似下的防御者对称度量最优;②独立损害排序IDRank:根据累积损害对每个连边的重要性进行排序,避免了优化问题,显著提高了可伸缩性。

4.4 图纯化防御

图11 GraphSAC的运作过程

Figure 11 OperationprocessofGraphSAC

4.5 注意力机制

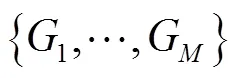

4.5.1 PA-GNN

4.5.2 RGCN

Zhu等[52]提出一种鲁棒的图神经网络RGCN,不同于以往的GCN,RGCN采用高斯分布替代特征向量作为每个卷积层中节点的隐藏表示。当图受到攻击时,RGCN可以自动地吸收高斯分布的方差变化带来的不利影响。为了弥补对抗性攻击在GCN中的传播,RGCN使用一种基于方差的注意机制,在执行卷积时根据节点邻域的方差分配不同的权值。在以前的GCN中,当一个节点受到攻击时,这种对抗效应会通过卷积传播到它的邻居,从而影响图数据的很大一部分。在RGCN中,由于被攻击的节点对其他节点的影响往往方差较大,权值较小,这种传播的影响会大大降低。

图12 PA-GNN的整体框架

Figure 12 Overall framework of PA-GNN

4.6 面向图神经网络的鲁棒性分析

图神经网络的鲁棒性分析属于图神经网络防御研究的一个方向,差别在于图神经网络的鲁棒性分析对模型或数据安全给出了更多的理论性分析与评估。本节对几种有效的图神经网络鲁棒性分析方法进行介绍。

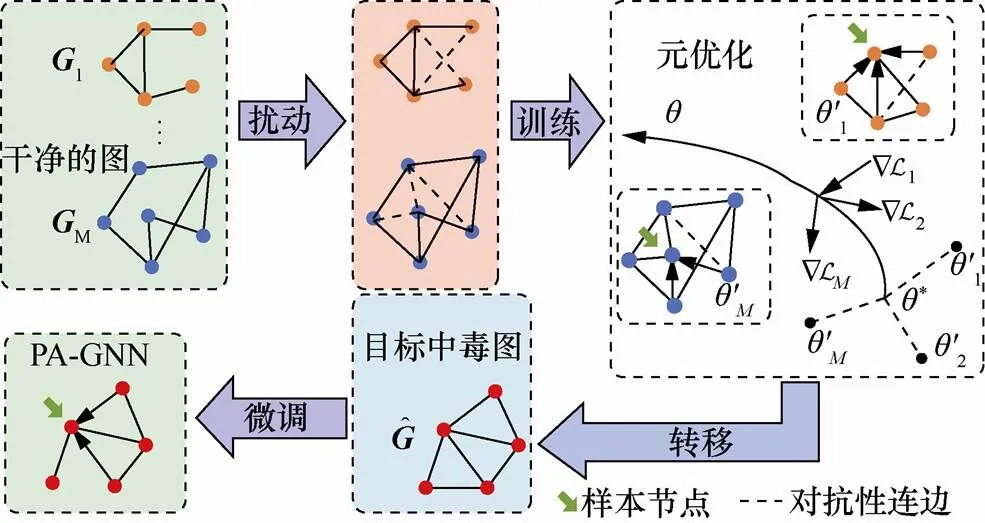

4.6.1 VPN

Jin等[53]强调了现有GCN的基本构建块Laplacian算子的缺陷:①空间域中信息融合范围有限;②离群特征值会模糊稀疏状态下的Laplacian或邻接矩阵的频谱,削弱有用的频谱信号。为了提高图频谱特征应对噪声的鲁棒性,他们提出了可变幂算子,它可以被看作提取隐藏在局部不规则状态下频谱的核函数,将GCN中的图卷子算子替换为可变幂算子,得到可变幂网络(VPN),同时学习不同距离处的特征变换函数和全局影响参数,提升图神经网络的鲁棒性。

图13 距离为k的可变幂算子

Figure 13 A variable power of distance

4.6.2 CRIAGE

Pezeshkpour等[92]指出,大部分现有的嵌入方法主要侧重于提高准确性,而忽略了鲁棒性分析和可解释性等方面。他们针对知识图,提出链路预测模型的对抗性修正方法CRIAGE,在模型重训练后,确定要添加到知识图中或从中删除的事实,从而更改目标事实的预测。使用泰勒展开近似嵌入的变化来评估单个修改对图的影响,确定最具影响力的预测事实,并评估模型对添加虚假事实的敏感性。为了避免对所有可能的事实进行组合搜索,训练了一个网络来解码它们对应的图组件嵌入,使用基于梯度的优化来识别对抗性修改。

4.6.3 AGCN

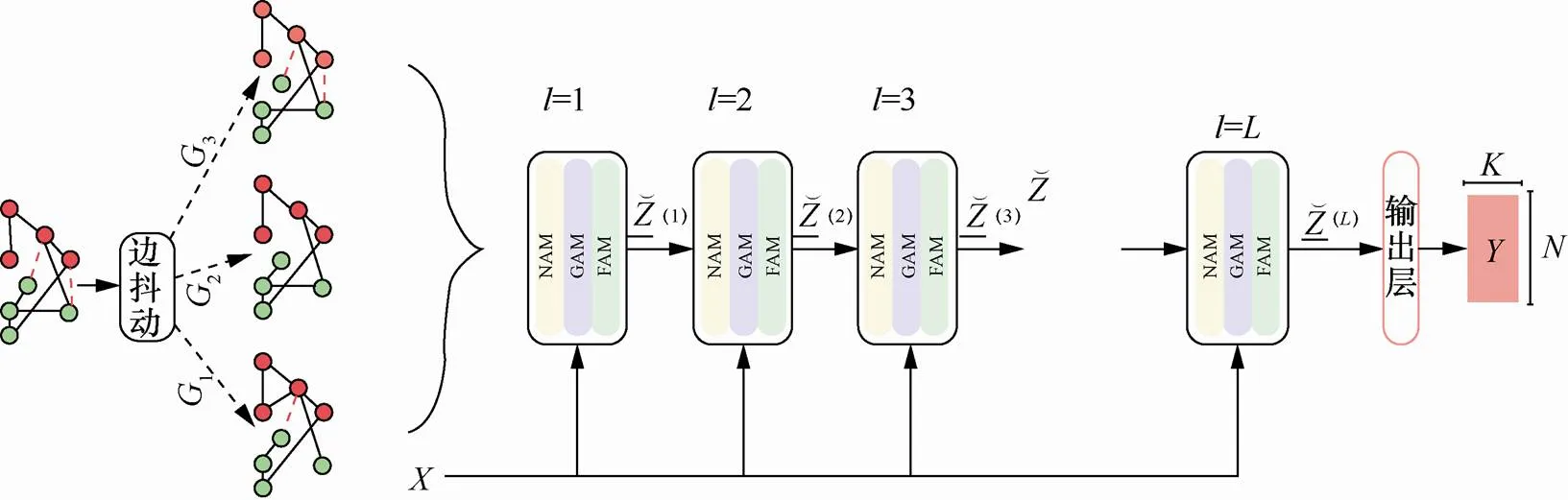

Ioannidis等[54]提出自适应图卷积网络(AGCN),给定被扰动的无权图,通过概率选取抖动(增加或删除)连边来绘制多个辅助图,增强GCN的鲁棒性。

图14 CRIAGE的示意

Figure 14 Illustration of CRIAGE

图15 AGCN的框架

Figure 15 The framework of AGCN

4.6.4 具有径向基核函数的SVM

4.6.5 可训练邻接矩阵

Wu等[56]指出,如GCN这类图模型的弱点在于这些模型本质上是根据图结构来聚集特征,在对目标节点进行预测时,此类模型严重依赖最近的邻居信息。他们提出使邻接矩阵可训练的防御方法,在训练过程中不断学习连边的权值,以改变攻击者制作的对抗样本,从而使其在普通GCN上制造的攻击无效;根据Jaccard相似度评分度量特征的相似性,并以此观察修改连边/节点特征、增/删连边等攻击的特征,对上述防御方法的有效性进行了大量的理论分析。他们还提出,对图的邻接矩阵进行简单的预处理就可以识别攻击后的连边,通过移除连接低相似度节点的连边,能够在不降低GCN模型准确性的情况下防御有针对性地对抗攻击。

4.6.6 Pro-GNN

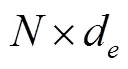

Jin等[93]指出,真实世界的图形共享一些内在属性。例如,许多现实世界的图是低秩和稀疏的,两个相邻节点的特征往往是相似的。实际上,许多对抗攻击很可能会违反这些图的性质。作者应用最先进的图中毒攻击metattack来扰动图数据并可视化metattack前后的图属性。

如图16所示,在图16(a)中,metattack放大了邻接矩阵的奇异值,图16(b)说明metattack快速增加了邻接矩阵的秩。此外,当分别从扰动图中移除对抗边和正常边时,可以观察到移除对抗边比移除正常边降低秩的速度更快,如图16(c)所示。图16(d)中描绘了受攻击图的连通节点特征差异的密度分布,发现metattack倾向于连接特征差异较大的节点。

作者进一步提出了一个通用框架Pro-GNN,该框架可以从受这些特性指导的扰动图联合学习结构图和鲁棒图神经网络模型。Pro-GNN通过保持图的低秩性、稀疏性和特征光滑性,以中毒图为基础,迭代地重构干净图,并通过交替模式求解优化问题,同时更新重构图上的GNN参数,减少对抗性结构的负面影响。

4.6.7 鲁棒性分析研究总结

鲁棒性分析研究同样提高了图神经网络模型的鲁棒性,这些工作更加注重模型鲁棒性的理论分析。例如,通过发现已有GCN模型的理论缺陷[53,56]、挖掘图对模型的作用影响[54-,55,92]和探索真实图数据的性质特征[89]来更深层次地研究图神经网络的鲁棒性。然而,现有的图神经网络鲁棒性分析研究还相对缺乏,如何更进一步通过理论分析来解释对抗攻击对图神经网络的影响,并从根本上增强图神经网络的鲁棒性,这是未来值得探索的一个方向。

图16 对抗性攻击导致邻接矩阵属性变化的一个示例

Figure 16 An illustrative example on the property changes of the adjacency matrix by adversarial attacks

5 数据集及评价指标

已有的面向图挖掘算法的对抗攻防方法研究,采用相对固定的数据集与评价指标,方便不同方法之间的性能比较,因此本节总结了常用的数据集和评价指标。

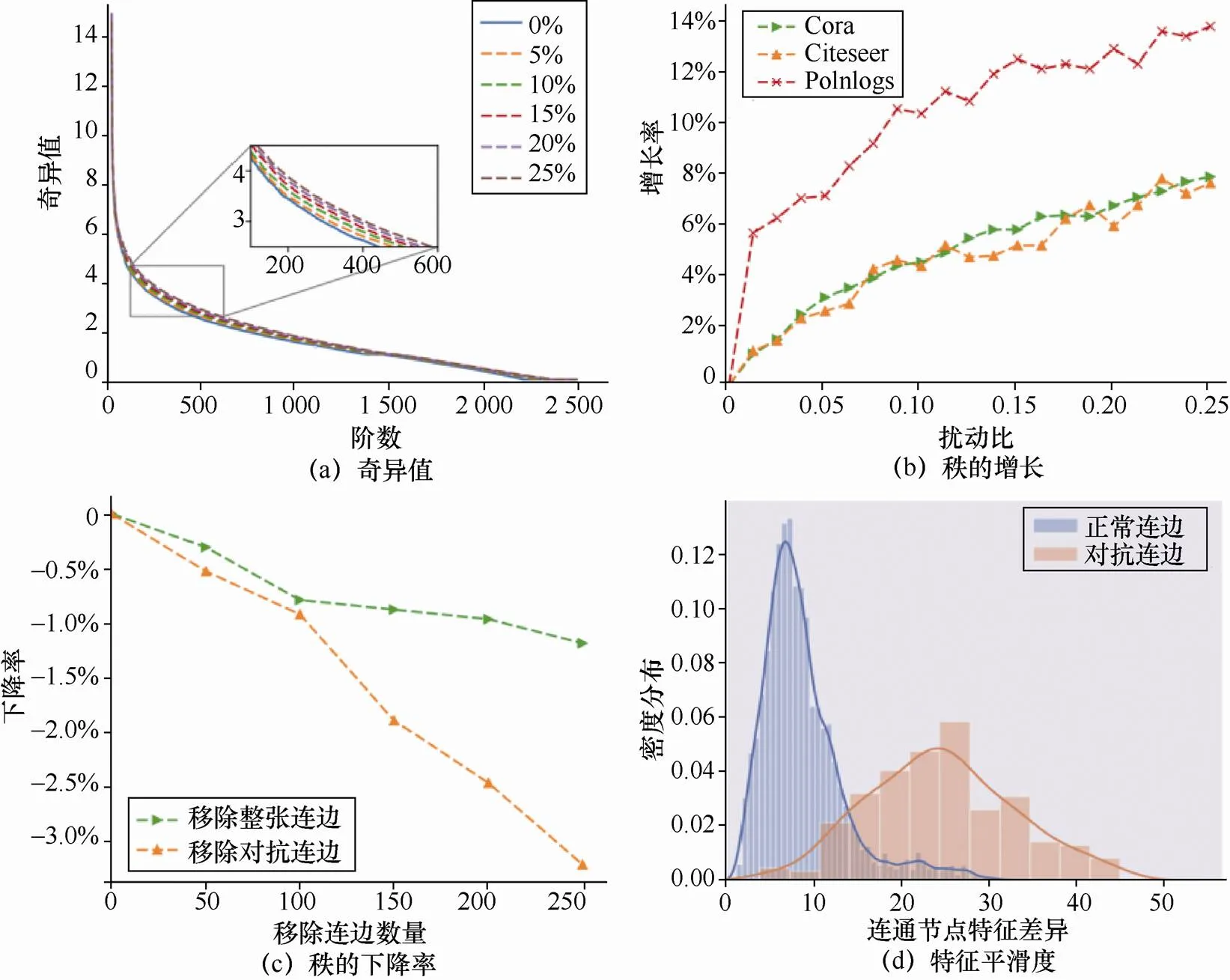

5.1 数据集

图神经网络研究中常见的数据集有引文网络数据集、社交网络数据集、生物−化学数据集等类别的数据集。这些数据集详细内容及结构如表4所示,其中,对于生物−化学数据集,本文展示了每个数据集中的平均节点数和连边数。前4个引文数据集与PolBlogs是最常用的节点分类任务数据集,Reddit、Facebook与Google+ 数据集也被用于节点分类攻击的工作[69,89]。此外,Cora和Citesser数据集也被文献[94]应用到链路预测攻击问题中。由于存在多种大小的Facebook数据集,表4中省略了它的统计数据[95-103]。Email、Dolphin、Karate和Football数据集常出现在社区检测任务[26,37]中。生物−化学数据集通常包含多个图,因此被广泛应用于图分类任务。

5.2 评价指标

图分析、对抗攻击或防御方法的效果需要通过不同的评价指标来衡量。本节首先介绍了图分析任务中的常用指标,随后从对抗攻击效果、攻击隐蔽性和防御性能3个角度介绍了攻防工作中提出的一些新的度量标准。

5.2.1 图分析任务中的常用指标

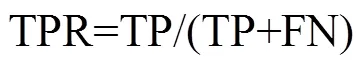

图神经网络的下游任务大多以分类问题为主,如节点分类、图分类。若把连边的存在情况视为连边类标,链路预测任务也可以归为分类问题。分类问题通常是一个二类或多类分类问题。现有的基于准确度的度量方法如准确率、F1评分、AUC等是从不同的角度反映分类精度的。本节介绍常用的几种不同的准确度指标。

表4 数据集内容

注:NC(node classification);LP(link prediction);CD(community detection);GC(graph classification)

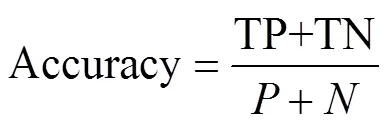

准确度(Accuracy):该领域研究中较为常见的技术指标,它表示正确的预测占所有实例的百分比。

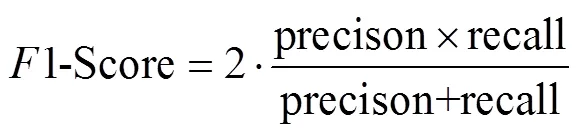

1-score:分类问题的一个衡量指标,为精密度precision和召回率recall的调和平均数。

5.2.2 对抗攻击评价指标

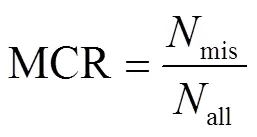

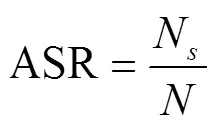

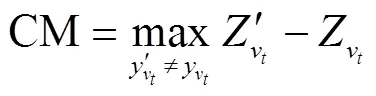

误分类率为对抗攻击评价的最直接体现,反映了攻击对目标模型性能的下降程度。为了从不同角度衡量图神经网络的攻击性能,已有的工作在图数据的攻击中提出或使用了以下评价指标。

平均修改连边数(AML,average modified links)[24]:描述攻击模型成功时,网络的平均修改的连边数,即攻击成功所需要付出的代价。

分类裕度(CM,classification margin)[28]:体现了模型错误分类目标节点并且到正确类别边界具有的最大距离。

平均最坏情况裕度(AWM,averaged worst- case margin):最坏情况裕度(WM,worst case margin)是分类裕度的最小值[104],WM的平均值是在训练过程中对一小批节点进行动态计算得到的。

鲁棒性能(RM,robustness merit)[71]:计算GNN攻击前/后的精度差值,对模型的鲁棒性进行评价。

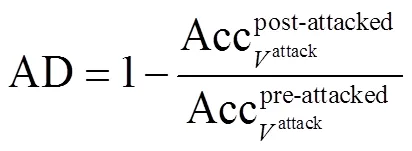

攻击恶化(AD,attack deterioration)[53]:评估对预测模型的攻击效果,由于GNN的空间范围限制,任何添加/删除的边只能影响原始网络中空间范围内的节点。

5.2.3 隐蔽性评价指标

图结构具有离散性,因此无法使用图像领域中的评价指标来衡量无穷小的细微变化。为了确保在图数据上的攻击是不容易觉察的,已有工作提出了几种扰动隐蔽性评价指标来衡量对抗扰动的大小。

5.2.4 防御方法评价指标

为了检验图神经网络防御方法的效果,研究人员提出了以下几种防御性能评价指标。

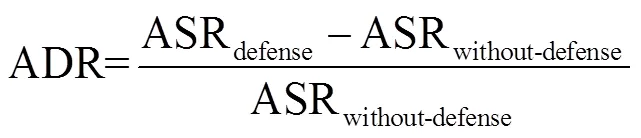

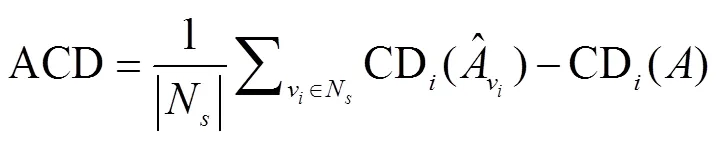

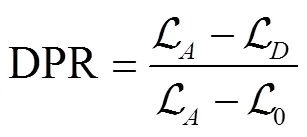

平均防御率(ADR,average defense rate)[47]:表示为有/无防御情况下ASR的差值与无防御下ASR的比值。ADR值越大,防御效果越好。

平均置信度差(ACD,average confidence different)[47]:表示节点在攻击前/后的平均置信度差。

损害预防率(DPR,damage prevention rate)[91]:用于评估防御方法可以容忍的攻击数量。

6 未来的研究方向

上文全面回顾了近年来关于图神经网络对抗攻击与防御的方法,详细描述了现有的攻防技术细节。本节就图神经网络未来的研究方向做出更多一般性的讨论。

6.1 攻击方法

攻击隐蔽性:本文总结的针对图神经网络的对抗攻击方法主要利用图数据和模型的信息来修改图的结构或节点属性,通过添加扰动使图神经网络模型失效。由于在修改图结构时可能会将两个完全无关节点相连或产生孤立节点,且在网络结构稀疏的情况下修改连边容易被察觉,此类攻击方法存在隐蔽性不强的问题。如何以更隐蔽的方式和更小的代价对图神经模型进行有效攻击是未来可以研究的方向之一。

攻击效率:现有的图神经网络攻击方法常用的数据集为Cora与Citeseer,两者都是小规模图,当面对大规模图时,现有的方法往往很难高效率地实现攻击。在大规模图中,如何筛选出与攻击目标高度相关的图信息,仅利用少量信息实现对整个图的有效攻击,同样是未来值得思考的。

攻击可行性:从表2可以看出,大部分现有的攻击算法是基于攻击者对目标模型与数据有完备知识条件下建立的,属于白盒或灰盒攻击,而真正的黑盒攻击相对较为缺乏。除此之外,在很多场景下,如社交网络的攻击,修改已有连边与节点属性是难以实现的。这些问题可以归结为攻击在实际场景下的可行性。在未来的研究中,可以将重心放在如何利用图的某个部分训练一个替代模型,学习对图数据攻击的一般模式,以避开攻击的知识背景限制,并实现更符合真实应用场景的攻击策略上。

6.2 防御方法

防御任务多样化:针对图神经网络的防御方法通过对抗性训练、对抗性扰动检测、启发式防御、图纯化防御或引入注意力机制等多种手段进行,从表3可以看出,大多数方法针对节点分类任务进行防御。研究对其他图神经网络下游任务的防御,或研究现有防御方法在其他任务中的可迁移性是研究人员未来值得考虑的方向。

防御可行性:防御成本可以作为图神经网络防御方法可行性分析的一个指标,现有的防御方法大多关注提高模型的防御能力,而忽略了对防御成本的研究。在现实场景应用中,大规模的图数据将为高成本的防御方法带来严峻的挑战。通过更多的鲁棒性理论分析,研究在低防御成本下实现高效的防御,提高防御方法的可行性,这也是一个有价值的研究方向。

7 结束语

图神经网络是处理图数据的主要方法之一。随着图神经网络在具有不规则空间结构的图数据(如社交网络、知识图谱等)处理中得到广泛应用,图神经网络的安全问题逐渐成为研究热点。本文总结了面向图神经网络的对抗攻击、防御方法和相应的评价指标,综述了图神经模型的鲁棒性分析方法。分别总结了当前图神经网络攻防方法的局限性,并对未来的研究方向进行讨论。最后,通过引用的参考文献为本课题的研究指明更广阔的前景。

[1]DENG L, LIU Y. A joint introduction to natural language processing and to deep learning[C]//Deep Learning in Natural Language Processing. Springer, Singapore, 2018: 1-22.

[2]COLLOBERT R, WESTON J, BOTTOU L, et al. Natural language processing (almost) from scratch[J]. Journal of Machine Learning Research, 2011, 12(8): 2493-2537.

[3]XIONG W, DROPPO J, HUANG X, et al. Achieving human parity in conversational speech recognition[J]. arXiv Preprint Arxiv: 1610.05256, 2016.

[4]LITJENS G, KOOI T, BEJNORDI B E, et al. A survey on deep learning in medical image analysis[J]. Medical Image Analysis, 2017, 42: 60-88.

[5]MOUSAVI A, BARANIUK R G. Learning to invert: signal recovery via deep convolutional networks[C]//2017 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). 2017: 2272-2276.

[6]KRISHNAMURTHY B, SARKAR M. Deep-learning network architecture for object detection: U.S. Patent 10,152,655[P]. 2018-12-11.

[7]GOYAL P, FERRARA E. Graph embedding techniques, applications, and performance: a survey[J]. Knowledge-Based Systems, 2018, 151: 78-94.

[8]FRASCONI P, GORI M, SPERDUTI A. A general framework for adaptive processing of data structures[J]. IEEE Transactions on Neural Networks, 1998, 9(5): 768-786.

[9]SPERDUTI A, STARITA A. Supervised neural networks for the classification of structures[J]. IEEE Transactions on Neural Networks, 1997, 8(3): 714-735.

[10]GORI M, MONFARDINI G, SCARSELLI F. A new model for learning in graph domains[C]//2005 IEEE International Joint Conference on Neural Networks. 2005: 729-734.

[11]SCARSELLI F, GORI M, TSOI A C, et al. The graph neural network model[J]. IEEE Transactions on Neural Networks, 2008, 20(1): 61-80.

[12]BRUNA J, ZAREMBA W, SZLAM A, et al. Spectral networks and locally connected networks on graphs[C]//2nd International Conference on Learning Representations. 2014.

[13]DEFFERRARD M, BRESSON X,VANDERGHEYNST P. Convolutional neural networks on graphs with fast localized spectral filtering[C]//Advances in Neural Information Processing Systems 29. 2016: 3837-3845.

[14]VELIČKOVIĆ P, CUCURULL G, CASANOVA A, et al. Graph attention networks[J]. arXiv preprint arXiv:1710.10903, 2017.

[15]CAO S, LU W, XU Q. Deep neural networks for learning graph representations[C]// Proceedings of the 30th AAAI Conference on Artificial Intelligence. 2016: 1145-1152.

[16]KIPF T N, WELLING M. Variational graph auto-encoders[J]. arXiv preprint arXiv:1611.07308, 2016.

[17]TANG J, QU M, MEI Q. Pte: Predictive text embedding through large-scale heterogeneous text networks[C]//Proceedings of the 21th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. 2015: 1165-1174.

[18]WANG S, TANG J, AGGARWAL C, et al. Linked document embedding for classification[C]// Proceedings of the 25th ACM International on Conference on Information and Knowledge Management. 2016: 115-124.

[19]PEROZZI B, AL-RFOU R, SKIENA S. Deepwalk: Online learning of social representations[C]//Proceedings of the 20th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. 2014: 701-710.

[20]WANG S, TANG J, AGGARWAL C, et al. Signed network embedding in social media[C]//Proceedings of the 2017 SIAM International Conference on Data Mining. 2017: 327-335.

[21]TIAN F, GAO B, CUI Q, et al. Learning deep representations for graph clustering[C]//Proceedings of the Twenty-Eighth AAAI Conference on Artificial Intelligence. 2014: 1293-1299.

[22]ALLAB K, LABIOD L, NADIF M. A semi-NMF-PCA unified framework for data clustering[J]. IEEE Transactions on Knowledge and Data Engineering, 2016, 29(1): 2-16.

[23]LEE J B, ROSSI R, KONG X. Graph classification using structural attention[C]//Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery. 2018: 1666-1674.

[24]PEI Y, CHAKRABORTY N, SYCARA K. Nonnegative matrix tri-factorization with graph regularization for community detection in social networks[C]//Proceedings of the Twenty-Fourth International Joint Conference on Artificial Intelligence. 2015: 2083-2089.

[25]CHEN L, LIU Y, ZHENG Z, et al.Heterogeneous neural attentive factorization machine for rating prediction[C]//Proceedings of the 27th ACM International Conference on Information and Knowledge Management. 2018: 833-842.

[26]XIE F, CHEN L, YE Y, ET AL.Factorization machine based service recommendation on heterogeneous information networks[C]//2018 IEEE International Conference on Web Services, ser. ICWS ’18. 2018: 115-122.

[27]WANG J, HUANG P, ZHAO H, et al. Billion-scale commodity embedding for e-commerce recommendation in Alibaba[C]//Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining, ser. KDD ’18. 2018: 839-848.

[28]ZÜGNER D, AKBARNEJAD A, AND GÜNNEMANN S. Adversarial attacks on neural networks for graph data[C]//Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining, ser. KDD ’18. 2018: 2847C2856.

[29]DAI H, LI H, TIAN T, et al. Adversarial attack on graph structured data[C]//Proceedings of the 35th International Conference on Machine Learning, ser. ICML ’18. 2018: 1123-1132.

[30]WANG X, EATON J, HSIEH C J, et al. Attack graph convolutional networks by adding fake nodes[J]. arXiv preprint arXiv:1810.10751, 2018.

[31]ZHOU K, MICHALAK T P, WANIEK M, et al. Attacking similarity-based link prediction in social networks[C]//Proceedings of the 18th International Conference on Autonomous Agents and MultiAgent Systems, ser. AAMAS ’19. 2019: 305-313.

[32]BOJCHEVSKI A AND GÜNNEMANN S. Adversarial attacks on node embeddings via graph poisoning[C]//Proceedings of the 36th International Conference on Machine Learning, ICML 2019. 2019: 695-704.

[33]SUN Y, WANG S, TANG X, et al. Node injection attacks on graphs via reinforcement learning[J]. arXiv preprint arXiv:1909.06543, 2019.

[34]CHEN J, WU Y, XU X, et al. Fast gradient attack on network embedding[J]. arXiv preprint arXiv:1809.02797, 2018.

[35]CHEN J, LIN X, SHI Z, et al. Link prediction adversarial attack via iterative gradient attack[J]. IEEE Transactions on Computational Social Systems, 2020, 7(4): 1081-1094.

[36]CHEN J, CHEN L, CHEN Y, et al. Ga-based Q-attack on community detection[J]. IEEE Transactions on Computational Social Systems, 2019, 6(3): 491-503.

[37]CHEN J, CHEN Y, CHEN L, et al. Multiscale evolutionary perturbation attack on community detection[J]. IEEE Transactions on Computational Social Systems, 2021, 8(1): 62-75.

[38]CHANG H, RONG Y, XU T, et al. A restricted black-box adversarial framework towards attacking graph embedding models[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2020: 3389-3396.

[39]MA Y, WANG S, WU L, et al. Attacking graph convolutional networks via rewiring[J]. arXiv preprint arXiv:1906.03750, 2019.

[40]ZÜGNER D AND GÜNNEMANN S. Adversarial attacks on graph neural networks via meta learning[C]//7th International Conference on Learning Representations, ser. ICLR ’19. 2019.

[41]SUN M, TANG J, LI H, et al. Data poisoning attack against unsupervised node embedding methods[J]. arXiv preprint arXiv:1810.12881, 2018.

[42]WANIEK M, ZHOU K, VOROBEYCHIK Y, et al. Attack tolerance of link prediction algorithms: How to hide your relations in a social network[J]. arXiv preprint arXiv:1809.00152, 2018.

[43]FARD A M, WANG K, AND YU P. Limiting link disclosure in social network analysis through subgraph-wise perturbation[C]// 15th International Conference on Extending Database Technology, ser. EDBT ’12. 2012: 109-119.

[44]FARD A AND WANG K. Neighborhood randomization for link privacy in social network analysis[J]. World Wide Web, 2015, 18(1): 9-32.

[45]LI J, ZHANG H, HAN Z, et al. Adversarial attack on community detection by hiding individuals[C]//WWW ’20: The Web Conference 2020. 2020: 917-927.

[46]FENG F, HE X, TANG J, et al. Graph adversarial training: Dynamically regularizing based on graph structure[J]. IEEE Transactions on Knowledge and Data Engineering. 2019.

[47]CHEN J, LIN X, XIONG H, et al. Smoothing adversarial training for gnn[J]. IEEE Transactions on Computational Social Systems, 2020.

[48]SUN K, LIN Z, GUO H, Et al. Virtual adversarial training on graph convolutional networks in node classification[C]//Pattern Recognition and Computer Vision - Second Chinese Conference, PRCV 2019. 2019: 431-443.

[49]ZHANG Y, KHAN S, AND COATES M. Comparing and detecting adversarial attacks for graph deep learning[C]//Proc Representation Learning on Graphs and Manifolds Workshop, Int Conf Learning Representations. 2019.

[50]ENTEZARI N, AL-SAYOURI S A, DARVISHZADEH A, et al. All you need is low (rank): Defending against adversarial attacks on graphs[C]//WSDM ’20: The Thirteenth ACM International Conference on Web Search and Data Mining. 2020: 169-177.

[51]TANG X, LI Y, SUN Y, et al. Transferring robustness for graph neural network against poisoning attacks[C]//WSDM ’20: The Thirteenth ACM International Conference on Web Search and Data Mining. 2020: 600-608.

[52]ZHU D, ZHANG Z, CUI P, et al. Robust graph convolutional networks against adversarial attacks[C]//Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. 2019: 1399-1407.

[53]JIN M, CHANG H, ZHU W, ET AL. Power up! robust graph convolutional network against evasion attacks based on graph powering[J]. arXiv preprint arXiv:1905.10029, 2019.

[54]IOANNIDIS V N AND GIANNAKIS G B. Edge dithering for robust adaptive graph convolutional networks[J]. arXiv preprint arXiv:1910.09590, 2019.

[55]MILLER B A, ÇAMURCU M, GOMEZ A J, et al. Improving robustness to attacks against vertex classification[C]//15th International Workshop on Mining and Learning with Graphs. 2019.

[56]WU H, WANG C, TYSHETSKIY Y, et al. Adversarial examples for graph data: Deep insights into attack and defense[C]//Proceedings of the Twenty-Eighth International Joint Conference on Artificial Intelligence. 2019: 4816-4823.

[57]JIN W, LI Y, XU H, et al. Adversarial attacks and defenses on graphs: a review and empirical study[J]. arXiv preprint arXiv:2003.00653, 2020.

[58]SUN L, DOU Y, YANG C, et al. Adversarial attack and defense on graph data: A survey[J]. arXiv preprint arXiv:1812.10528, 2018.

[59]CHEN L, LI J, PENG J, et al. A survey of adversarial learning on graph[J]. arXiv preprint arXiv: 2003.05730, 2020.

[60]DOMENICO M, LIMA A, MOUGEL P, et al. The anatomy of a scientific rumor[J]. Scientific Reports, 2013, 3(10): 65.

[61]LESKOVEC J, KLEINBERG J, FALOUTSOS C. Graph evolution: Densification and shrinking diameters[J]. ACM Transactions on Knowledge Discovery from Data (TKDD). 2006,1.

[62]LI Y, YU R, SHAHAB CI, et al. Diffusion convolutional recurrent neural network: Data-driven traffic forecasting[C]//6th International Conference on Learning Representations. 2018.

[63]GONG Y, ZHU Y, DUAN L, et al.Exact-k recommendation via maximal clique optimization[C]//Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining, KDD 2019. 2019: 617-626.

[64]TANG J, ZHANG J, YAO L, et al.Arnetminer: extraction and mining of academic social networks[C]//Proceedings of the 14th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. 2008: 990-998.

[65]ADAMIC L A AND GLANCE N. The political blogosphere and the 2004 us election: divided they blog[C]//Proceedings of the 3rd International Workshop on Link Discovery. 2005: 36-43.

[66]DEBNATH A K, COMPADRE R L, DEBNATH G, et al. Structure-activity relationship of mutagenic aromatic and heteroaromatic nitro compounds. correlation with molecular orbital energies and hydrophobicity[J]. Journal of Medicinal Chemistry, 1991, 34(2): 786-797.

[67]GOODFELLOW I, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]//Advances in Neural Information Processing Systems 27: Annual Conference on Neural Information Processing Systems 2014. 2014: 2672-2680.

[68]KIPF T N, WELLING M. Semi-supervised classification with graph convolutional networks[C]//International Conference on Learning Representations, ser. ICLR ’17. 2017.

[69]WANG B AND GONG N. Attacking graphbased classification via manipulating the graph structure[C]//Proceedings of the 2019 ACM SIGSAC Conference on Computer and Communications Security. 2019: 2023-2040.

[70]AVISHEK J, CIANFLFLONE A, HAMILTION W. Generalizable adversarial attacks using generative models[J].arXiv preprint arXiv:1905.10864, 2019.

[71]WU H, WANG C, TYSHETSKIY Y,et al. Adversarial examples for graph data: deep insights into attack and defense[C]//Proceedings of the Twenty-Eighth International Joint Conference on Artificial Intelligence, IJCAI 2019. 2019: 4816-4823.

[72]XU K, CHEN H, LIU S, et al. Topology attack and defense for graph neural networks: An optimization perspective[C]//Proceedings of the Twenty-Eighth International Joint Conference on Artificial Intelligence, IJCAI 2019. 2019: 3961-3967.

[73]ZANG X, XIE Y, CHEN J,et al. Graph universal adversarial attacks: A few bad actors ruin graph learning models[J]. arXiv preprint arXiv:2002.04784, 2020.

[74]TAKAHASHI T. Indirect adversarial attacks via poisoning neighbors for graph convolutional networks[C]//2019 IEEE International Conference on Big Data (Big Data). 2019: 1395-1400.

[75]CHEN J, CHEN Y, ZHENG H, et al.Mga: Momentum gradient attack on network[J]. arXiv preprint arXiv:2002.11320, 2020.

[76]WANIEK M, ZHOU K, VOROBEYCHIK Y, et al. Attack tolerance of link prediction algorithms: How to hide your relations in a social network[J].arXiv preprint arXiv:1809.00152, 2018.

[77]QIU J, DONG Y, MA H, et al. Network embedding as matrix factorization[C]//Proceedings of the Eleventh ACM International Conference on Web Search and Data Mining, WSDM 2018. 2018: 459-467.

[78]CHEN J, ZHANG J, CHEN Z, et al. Time-aware gradient attack on dynamic network link prediction[J]. arXiv preprint arXiv: 1911.10561, 2019.

[79]TANG H, MA G, CHEN Y, et al. Adversarial attack on hierarchical graph pooling neural networks[J]. arXiv preprint arXiv:2005.11560, 2020.

[80]BÁLEK M, GOODALL A. Large networks and graph limits[J]. Comput Sci Rev, 2013, 10: 35-46.

[81]FALOUTSOS C, KOUTRA D, VOGELSTEIN J.Deltacon: A principled massive-graph similarity function[C]//Proceedings of the 13th SIAM International Conference on Data Mining. 2013: 162-170.

[82]ZHANG Z, JIA J, WANG B,et al. Backdoor attacks to graph neural networks[J]. arXiv preprint arXiv:2006.11165, 2020.

[83]XI Z, PANG R, JI S, et al. Graph backdoor[C]//USENIX Security. 2021.

[84]CORDELLA L, FOGGIA P, SANSONE C, et al. A (sub)graph isomorphism algorithm for matching large graphs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2004, 26(10): 1367-1372.

[85]YU S, ZHENG J, CHEN J, et al. Unsupervised euclidean distance attack on network embedding[C]//5th IEEE International Conference on Data Science in Cyberspace. 2020: 71-77.

[86]LI J, ZHANG H, HAN Z, et al. Adversarial attack on community detection by hiding individuals[C]//WWW ’20: The Web Conference 2020. 2020: 917-927.

[87]WANIEK M, MICHALAK T, WOOLDRIDGE M, et al. Hiding individuals and communities in a social network[J]. Nature Human Behaviour, 2018, 2(2): 139-147.

[88]DENG Z, DONG Y, ZHU J. Batch virtual adversarial training for graph convolutional networks[J]. arXiv preprint arXiv:1902.09192, 2019.

[89]WANG X, LIU X, HSIEH C. Graphdefense: Towards robust graph convolutional networks[J]. arXiv preprint arXiv:1911.04429, 2019.

[90]IOANNIDIS V, BERBERIDIS D, AND GIANNAKIS B. Graphsac: Detecting anomalies in large-scale graphs[J]. arXiv preprint arXiv: 1910.09589, 2019.

[91]ZHOU K, MICHALAK T, VOROBEYCHIK Y, et al. Adversarial robustness of similarity-based link prediction[J]. arXiv preprint arXiv:1909.01432, 2019.

[92]PEZESHKPOUR P, IRVINE C, TIAN Y, et al. Investigating robustness and interpretability of link prediction via adversarial modifications[C]//Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. 2019: 3336-3347.

[93]JIN W, MA Y, LIU X, et al.Graph structure learning for robust graph neural networks[C]//KDD ’20: The 26th ACM SIGKDD Conference on Knowledge Discovery and Data Mining, Virtual Even. 2020: 66-74.

[94]SUN M, TANG J, LI H, et al. Data poisoning attack against unsupervised node embedding methods[J]. arXiv preprint arXiv: 1810.12881, 2018.

[95]SEN P, NAMATA G, BILGIC M, et al. Collective classification in network data[J]. AI Magazine, 2008, 29(3): 93.

[96]MCCALLUM A, NIGAM K, RENNIE J, et al. Automating the construction of internet portals with machine learning[J]. Information Retrieval, 2000, 3(2): 127-163.

[97]HAMILTON W, YING Z, AND LESKOVEC J. Inductive representation learning on large graphs[C]//Advances in Neural Information Processing Systems 30: Annual Conference on Neural Information Processing Systems 2017. 2017: 1024-1034.

[98]LUSSEAU D, SCHNEIDER K, BOISSEAU O, et al. The bottlenose dolphin community of doubtful sound features a large proportion of long-lasting associations[J]. Behavioral Ecology and Sociobiology, 2003, 54(4): 396-405.

[99]ZACHARY W. An information flow model for conflict and fission in small groups[J]. Journal of anthropological research, 1977, 33(4): 452-473.

[100]GIRVAN M AND NEWMAN M. Community structure in social and biological networks[C]//Proceedings of the National Academy of Sciences. 2002:7821-7826.

[101]BORGWARDT K, ONG C, SCHOENAUER S, et al. Protein function prediction via graph kernels[J]. Bioinformatics, 2005, 21(1): 47-56.

[102]WALE N, KARYPIS G. Comparison of descriptor spaces for chemical compound retrieval and classification[C]//Proceedings of the 6th IEEE International Conference on Data Mining (ICDM 2006). 2006: 678-689.

[103]DOBSON P, DOIG A. Distinguishing enzyme structures from non-enzymes without alignments[J]. Journal of molecular biology, 2003, 330(4): 771-783.

[104]ZUGNER D AND GUNNEMANN S. Certifiable robustness and robust training for graph convolutional networks[C]//Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. 2019: 246-256.

Adversarial attack and defense on graph neural networks: a survey

CHEN Jinyin1,2, ZHANG Dunjie2, HUANG Guohan2, LIN Xiang2,BAO Liang3

1. Institute of Cyberspace Security, Zhejiang University of Technology, Hangzhou 310023, China 2.The College of Information Engineering, Zhejiang University of Technology, Hangzhou 310023, China 3.Key Lab of Information Network Security, Ministry of Public Security, Shanghai 200000, China

For the numerous existing adversarial attack and defense methods on GNN, the main adversarial attack and defense algorithms of GNN were reviewed comprehensively, as well as robustness analysis techniques. Besides, the commonly used benchmark datasets and evaluation metrics in the security research of GNN were introduced. In conclusion, some insights on the future research direction of adversarial attacks and the trend of development were put forward.

graph neural networks, adversarial attack, defense algorithms, robustness analysis

TP29

A

10.11959/j.issn.2096−109x.2021051

2020−07−02;

2020−10−09

鲍亮,baoliang@stars.org.cn

国家自然科学基金(62072406);浙江省自然科学基金(LY19F020025);信息网络安全公安部重点实验室开放课题项目(C20604)

The National Natural Science Foundation of China (62072406), The Natural Science Foundation of Zhejiang Province (LY19F020025), Key Lab of Information Network Security, Ministry of Public Security (C20604)

陈晋音, 张敦杰, 黄国瀚, 等. 面向图神经网络的对抗攻击与防御综述[J]. 网络与信息安全学报, 2021, 7(3): 1-28.

CHEN J Y, ZHANG D J, HUANG G H, et al. Adversarial attack and defense on graph neural networks: a survey[J]. Chinese Journal of Network and Information Security, 2021, 7(3): 1-28.

陈晋音(1982− ),女,浙江象山人,博士,浙江工业大学副教授,主要研究方向为人工智能安全、图数据挖掘和进化计算。

张敦杰(1997− ),男,浙江苍南人,浙江工业大学硕士生,主要研究方向为数据挖掘与应用、智能计算。

黄国瀚(1997− ),男,浙江台州人,浙江工业大学硕士生,主要研究方向为图数据挖掘和人工智能安全。

林翔(1996− ),男,浙江宁波人,浙江工业大学硕士生,主要研究方向为图数据挖掘与应用。

鲍亮(1983− ),男,安徽寿县人,公安部第三研究所助理研究员,主要研究方向为信息网络安全、网络防护技术、网络攻击数据分析。