人工神经网络的发展及展望

(山西药科职业学院,山西太原 030031)

人工神经网络作为人工智能的核心技术,在人脸识别、语音识别、图像识别、自动驾驶等领域得到广泛应用,随着人工智能技术的发展,其重要性日益凸显,值得深入研究。

1 人工神经网络含义

人工神经网络(artificial neural networks,ANN)是一种模仿动物神经网络行为特征进行分布式并行信息处理的算法数学模型。人工神经网络利用计算机技术,参考动物大脑神经网络进行信息处理的系统,其核心是数学算法,通过计算机软、硬件实现。

人工神经单元的数学模型:

式中:a——激活函数;wi——第i个输入的权重,i∈[1,n];xi——第i个输入,i∈[1,n];b——神经单元对信号的反应灵敏度;y——神经单元的输出。

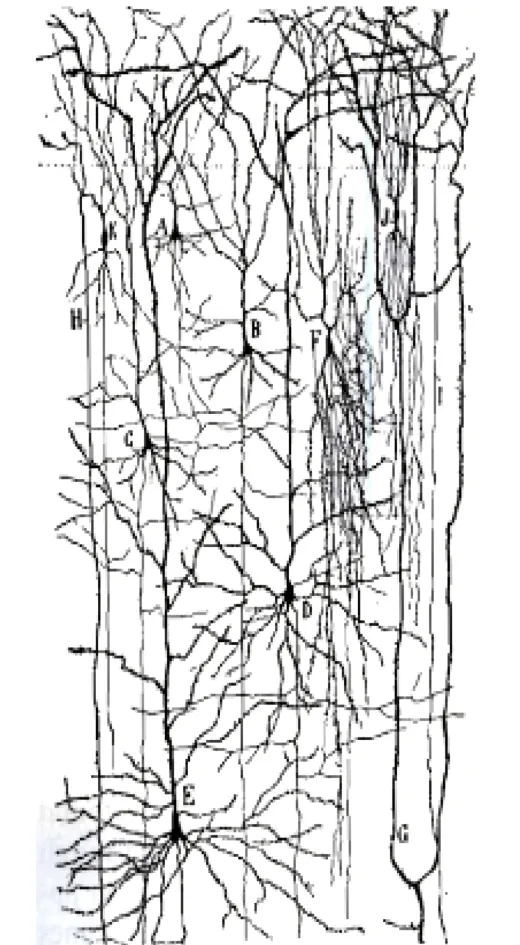

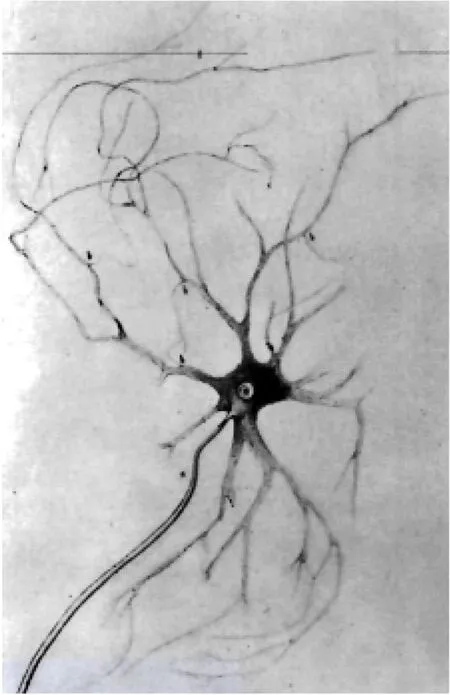

大脑神经细胞如图1所示,神经系统如图2所示。

图1 大脑神经细胞

图2 大脑神经网络

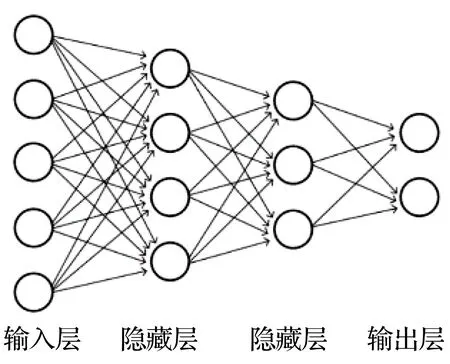

人工神经网络如图3所示。

图3 人工神经网络

由图1~图3可知,人工神经单元的运作方式模拟了大脑神经细胞的运作方式,大脑神经网络的组织结构也是人工神经网络产生的重要灵感来源[1]。

2 人工神经网络应用

人工神经网络能够解决较多问题,主要是回归和分类两大类问题。分类是按照某种特定规则,将数据划分为若干类,与传统分类不同的是,人工神经网络能够自行寻找规则,不需要事先指定。回归是进行数据拟合,寻找数据变化的规律,进行未知数据的预测。

常见的人脸识别、图像分割、垃圾电子邮件标注、自动垃圾分类等属于分类问题,通过人脸判断年龄、通过前几次的比赛成绩预测下一次的成绩、通过一只股票的历史数据预测未来的走势属于回归问题。

现阶段,人工神经网络还应用于语音识别翻译、图像识别、文本分析、智能机器人、企业管理、市场分析、决策优化、自动驾驶等方面。

3 人工神经网络的发展历史

人工神经网络的发展过程从1943诞生以来经历过若干次的高潮与低谷。

3.1 诞生

1943年,沃伦·麦卡洛克和沃尔特·皮茨发表了名为《神经活动中内在思想的逻辑演算》的论文,在论文中提出了人工神经网络的概念以及人工神经元的数学模型(MP模型)[2]。普遍认为,MP模型是人工神经网络的起点,为了纪念,MP模型以麦卡洛克和皮茨的单词首字母命名。

最初的MP模型没有调整权值的算法。1949年,赫布出版了《行为的组织》一书,在书中提出了神经网络中的信息是通过连接权值进行存储的。自此之后,权值的调整算法的研究得以展开,目前的神经网络,其不同功能的实现是通过调整人工神经网络的权值实现的。

3.2 第一次研究热潮

1957年,罗森布拉特提出了“感知器”的概念。本质上,感知器仍然是MP模型,但引入了学习的概念,通过误差学习算法由人工调整权值,不断优化感知器的输出,使预测结果与实际结果逐渐接近,直至一致。可以认为感知器是第一个真正意义上的人工神经网络。感知器的提出,掀起了20世纪60年代的神经网络研究热潮。当时人们认为只要将大量的神经单元组合在一起就可以解决任何问题。

3.3 第一次低潮

1969年,明斯基和佩珀特出版了《感知器》一书,在书中明斯基指出,感知器只能解决简单的线性问题,解决非线性问题必须使用多层网络,而多层网络的实际作用无法证明。由于明斯基在人工智能领域的巨大影响力,这一观点对人工神经网络的研究造成了直接冲击,相关研究迅速进入低潮。

3.4 第二次研究热潮

1982年,霍普菲尔德提出了Hopfield神经网络(HNN),并于1984年设计出了该网络的电子线路,为模型的可用性提供了物理证明。

1985年,辛顿和塞诺夫斯基提出了玻尔兹曼机(BM),并于1986年提出了改进后的受限玻尔兹曼机(RBM)。RBM实际上是两层的神经网络,在此基础上又发展出了深度玻尔兹曼机(DBM,堆叠的受限玻尔兹曼机)和深度置信网络(DBN,堆叠的受限玻尔兹曼机加BP算法)。

1986年,鲁梅尔哈特、辛顿和威廉姆斯发表了《利用误差反向传播进行学习表征》,重新发现了BP算法(误差反向传播算法)[3]。误差反向传播算法目前仍是人工神经网络中非常基础的算法之一,在现有人工神经网络模型中得到了广泛应用。

3.5 第二次低潮

BP算法使人工神经网络具有了自学能力和概括能力,但也存在明显的缺陷,即在网络层数较多时,容易陷入局部最优解,也容易产生过拟合,并且当时的计算机系统也不能支持庞大的数据集运算。

1995年,科琳娜·科尔特斯和弗拉基米尔·瓦普尼克提出了支持向量机(SVM),该方法没有局部最优问题,并且可以在样本数量较少的情况下,也能获得较为理想的结果,因此在BP算法发展遇到瓶颈时,部分研究人员转向了SVM的研究。

3.6 第三次研究热潮

2006年,杰夫·辛顿(即之前提出BP算法的辛顿)研究小组提出了深度网络(deep network)和深度学习(deep learning)概念,深度网络即多层次的人工神经网络。随着计算机技术的飞速发展,计算机的计算速度有了极大提高,大数据、云计算成为现实。

实际上在人工神经网络发展的低潮期,还有很多研究者在坚持相关的研究工作。卷积神经网络的发明人杨立昆坚持研究人工神经网络,并于1998年发表了《基于梯度学习的文件识别》[4],也因此被称为卷积神经网络之父。

目前,已经提出的深度网络模型主要有卷积神经网络CNN、循环神经网络RNN及LSTM、递归张量神经网络RNTN、自动编码器AutoEncoder、生成对抗网络GAN、图神经网络(GNN)等。深度网络模型都可以应用于生产实际,并取得了良好的效果,如人脸支付、自动门禁、自动驾驶等各类应用。根据目前的情况分析,此次研究热潮还将持续一段时间。

4 人工神经网络的发展方向

(1)现有人工神经网络在神经单元的激活与抑制中处于静态,即网络参数确定之后,对于同样的输入,神经单元的输出是固定的。但从人脑的神经系统运行过程分析,神经元的激活与抑制是动态的,在不同的状态下,即使输入相同,神经元的激活与抑制也会发生变化,产生不同的结果。人工神经网络下一步也应实现动态的激活与抑制机制,以实现更完善的功能。

(2)由于大脑神经网络的复杂性,目前神经科学研究仍未能揭示大脑神经网络的详细工作机理,因此人工神经网络并不是对大脑神经网络的全真模拟,而是利用数学技术结合计算机编程所建立的智能系统,能够在某一方面产生类似大脑神经网络的功能。

神经科学的研究会为人工神经网络的构建提供灵感,人工神经网络技术也会为神经科学的研究提供一些思路或启发,两者相辅相成,互相促进发展。

(3)人工神经网络发展已有近80年历史,近年来人工神经网络的应用呈现出爆发式增长的态势,但并没有产生过多的创新算法。目前使用的算法多数都是多年前提出的,是在经典模型上的扩展设计而来,全新模型的建立比较少。未来应在人工神经网络模型创新方面进一步研究。