基于加权背景感知框架的相关滤波视觉跟踪算法

朱凌云

(中兴通讯股份有限公司 有线研究院, 江苏 南京 210012)

0 引言

视觉跟踪是计算机视觉领域中经典的研究课题有着广泛的应用.视觉跟踪是通过检测或者告知第一帧图像中目标的初始位置,在整个视觉序列中估计目标的轨迹,从而对目标进行定位的算法.近年来,视觉跟踪取得了较大的突破,但跟踪过程中目标可能发生剧烈形变、光照、被其他物体部分或完全遮挡、背景干扰等复杂情况,因此视觉跟踪仍面临严峻的挑战.

Bolme等人首次将相关滤波方法应用到视觉跟踪中,利用单通道特征求解最小二乘快速学习到相关滤波器,相关滤波器(Correlation Filter,CF)已被广泛认可为解决视觉跟踪问题的一种稳定且有效的方法[1].Heriques等人利用图像的循环结构[2],提出了一种核化的相关滤波方法,解决了训练样本缺乏问题,同时在计算速率上达到了很好的实时性.在前景周围循环移动采样策略,在频率域中学习到CF跟踪器,会产生很高的计算代价.这些移动的图像块通过频率域相关循环特性立即生成,作为训练滤波器的负样本.Galoogahi 等人提出所有的移动图像块都会产生边界效应,从而影响CF跟踪器对跟踪性能[3].很多学者们陆续提出利用多通道特征或者多特征融合的跟踪方法提高跟踪效果,比如HOG特征和多颜色属性特征.Liu等人提出基于部分的跟踪技术以降低对部分遮挡的敏感度,并更好地保留目标结构[4].为了解决跟踪过程中目标形变问题,Danelljan提出了一种自适应多尺度的DSST跟踪方法[5].Mueller等人提出了Context-Aware Correlation Filter(CACF)框架.该框架是一种基于上下文信息的跟踪方法[6-7],从而提高跟踪效果.Galoogahi等人提出了Background-Aware Correlation Filter(BACF)框架[3],该框架对跟踪性能可以媲美许多经典的CF跟踪器.但BACF框架没有对复杂背景环境信息进行区别处理,即BACF框架同等地对待每个背景图像块,认为整个背景区域在跟踪算法中的贡献一致,忽视了背景区域在目标跟踪中的重要性.在实际视觉序列中,背景区域普遍包含十分复杂的信息,有目的地对不同的区域进行细化,有利于提高跟踪器的鲁棒性.

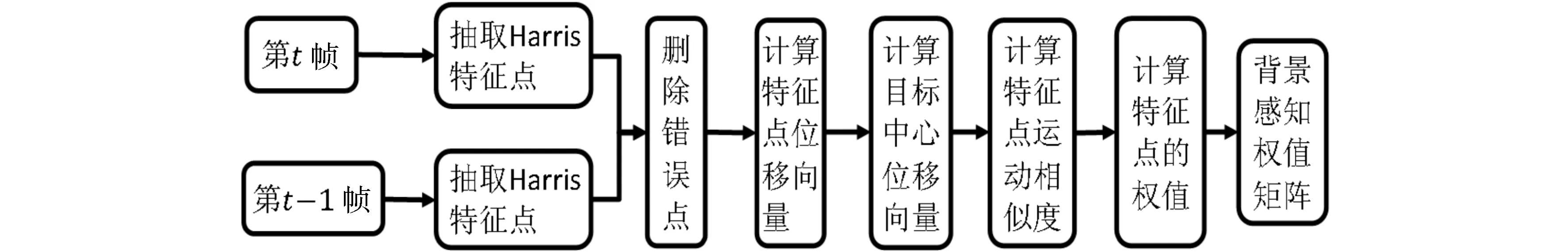

为了充分发挥背景信息的作用,本文利用动态分区的思想,根据背景中不同区域与跟踪目标运动相似度大小,对不同区域赋予不同的权值,提出基于加权背景感知框架的相关滤波(Weighted Background-Aware Correlation Filter,WBACF)视觉跟踪算法,WBACF跟踪流程如图1所示.通过加权背景信息,WBACF框架跟踪器可以获得很好的跟踪结果.

图1 WBACF跟踪流程图

本文的主要工作如下:

1) 提出了基于加权背景感知的视觉跟踪框架,可以有效利用背景信息,进一步提高CF视觉跟踪器的性能;

2) 在主流数据集上的测试结果表明提出的加权背景感知框架是可行的, 并对WBACF框架做了全面的评估,验证该框架的跟踪效果,如图2所示.

图2 WBACF跟踪效果图

1 经典CF算法

在空间域中,通过最小化公式(1),学习得到多通道CF,

(1)

其中xk∈RD表示向量图像的第k个通道,hk∈RD表示需学习的相关滤波器,K表示特征通道的数目,y∈RD表示预期的相关响应,λ表示正则化常数,*表示空间相关运算.在空间域中,式(1)还可以用岭回归的目标函数表达,

(2)

其中y(j)表示y的第j个元素,[△τj]表示圆形移动运算.式(2)主要通过圆形移动运算从D-1个前景图像块中学习得到相关滤波器,这种方法能够很完美地学习前景目标,但是容易出现过拟合、限制滤波器的性能等问题.然而,跟踪目标的出现都伴随着复杂的背景环境,这些背景信息可以被用作负样本训练.根据背景中的不同图像区域的重要性不同,赋予不同的权值,提出基于加权背景感知框架的相关滤波视觉跟踪算法,能够得到鲁棒性更好的跟踪效果.

2 加权背景感知的CF跟踪算法

2.1 背景感知

通常把整幅图像分为2类区域,前景区域和背景区域. 前景区域比较单一,是只包含目标物体的区域;根据运动相似度划分,背景区域又细分为支撑区域、无关区域及干扰区域[8].支撑区域是与跟踪对象的运动方向基本一致或相同的图像区域;无关区域是始终静止不动的区域;干扰区域是与目标运动方向偏差较大,以及有遮挡的图像区域.

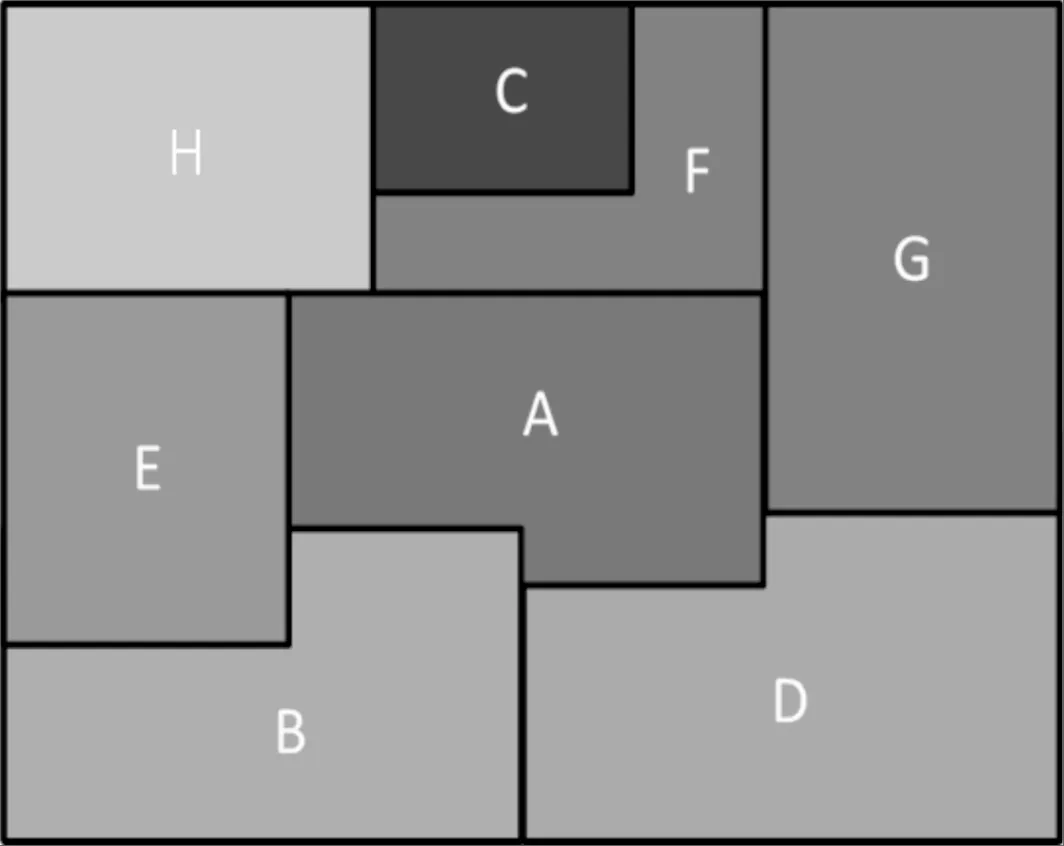

如图3图像区域划分示意图所示,将图像划分成A、B、C、D、E、F、G、H不同区域.可以看出B,D和E区域为支撑区域,C、H区域是无关区域,F和G区域为干扰区域.可知各图像区域的形状并不固定,区域之间没有显著的空间界限.在跟踪过程中,由于每帧图像的背景区域是动态变化的,因此各区域的划分亦是随时间动态变化的.在视频序列中,跟踪目标的位置是随时间变化而变化的,例如上一帧的目标区域可能变成无关区域,当前帧的无关区域也可能变为支撑区域,甚至转变成目标区域.通过计算不同区域内的像素与目标之间运动相似度,构建一个权值矩阵,与目标运动相似度越高的区域, 其像素获得权值就越高,反之就越低.

图3 图像区域划分示意图

2.2 背景感知的BACF框架

复杂的背景环境对跟踪算法的跟踪性能有较大影响,例如,在背景变化太快且混乱时,背景信息对目标跟踪成功与否十分重要.如BACF框架所示,通过最小化式(3)学习多通道背景感知CF跟踪器:

(3)

其中P是从信号xk裁剪出D个元素形成D×T二元矩阵,xk∈RD,y∈RD,hk∈RD,T≫D,T为x的长度.对于跟踪算法x,y,h分别为空间内的训练样本,y是以兴趣目标为中心峰值的相关输出,h是空间尺寸远小于训练样本的相关滤波器.Pxk[△τj]将循环移位运算应用于裁剪运算之后的训练样本上,从整帧图像中找出大小为D的所有可能的图像块.相关输出为峰值对应是跟踪目标(正样本)裁剪图像块,相关输出为零对应是背景内容(负样本)裁剪图像块.

为了提高计算效率,通常在频率域中学习CF,WBACF框架即可表示为:

(4)

2.3 加权背景感知的WBACF框架

在背景感知框架中,式(4)中给出数据矩阵P,即裁剪得到的背景图像块.加权背景感知针对BACF框架易忽略不同区域背景信息的重要性问题,综合考虑背景环境中不同区域对跟踪目标的贡献权值,形成WBACF框架.因此,含有背景感知的图像块被定义为:

B=WP

(5)

其中B为加权背景感知所有可能的图像块,W为背景感知信息对应的权值矩阵.

图4 计算权值矩阵流程图

根据背景区域的运动方向与目标中心的运动方向之间的相似度大小,影响背景区域对跟踪目标的定位,相似度越高的背景区域,包含的有用信息越多,即应赋予较高权值,相似度越低的背景区域,包含的有用信息越少,即应赋予较低权值,对于相似度为零的背景区域,其权值应为零.通过每个背景区域的权值形成一个背景感知权值矩阵.为了获得跟踪的实时性,采用Lucas-Kanade稀疏光流算法计算离散点的权重,再通过插值获得背景感知的权值矩阵.

为了提高跟踪算法对复杂背景下姿态、尺度、光照、遮挡等问题的鲁棒性,跟踪模型及权值矩阵自适应更新策略如下:

Xad=(1-η1)Xt-1+η1Xt

(6)

Wad=(1-η2)Wt-1+η2Wt

(7)

其中η1,η2是分别是模型、权值矩阵的学习率.

3 实验结果及分析

本节对WBACF跟踪框架进行评估,在公共测试集OTB-50和OTB-100(部分)上进行实验.在相同实验设置下,比较WBACF跟踪框架和BACF跟踪框架的性能.

3.1 实验设置

根据传统CF参数设置,本文采用4×4大小的31通道HOG特征,正则化参数λ设置为0.001,尺度数目为5,尺度变化率为1.01,模型和权值矩阵的学习率分别为0.0125,0.3.本文实验代码是在BACF算法的基础上改写而成,因此在保证算法实时性的同时,能够有效提高算法跟踪性能.

3.2 实验评价

3.2.1 定性评价

图5 12个视频序列展示WBACF框架的跟踪效果

本节从OTB-100数据集中挑选出12个视频序列展示WBACF框架的跟踪效果.12个视频序列分别是BlurBody,BlurFace,Bolt,Boy,CarScale,Dog1,David,Singer1,FaceOcc1,Walking2,Woman,Lemming.如图5所示,给出12个视频序列上的跟踪结果,定性地分析WBACF算法在不同情况下的跟踪效果.12个视频序列分别包括运动模糊、快速移动、尺度变化、光照变化、目标遮挡、复杂背景等场景变化问题,WBACF算法都能够展示较好地跟踪效果.下面从不同场景变化角度来分析WBACF算法的跟踪效果.

1) 运动模糊: 图5(a)、(b)两行可以看出视频序列中跟踪目标人物都发生移动且图像模糊不清,如图5(a)中的215帧和316帧,图5(b)中106帧和316帧,相比其他跟踪算法,WBACF跟踪算法能够快速地跟踪上目标,并且表现出更好的准确度.

2) 快速移动:图5(c)、(d)两行视频序列Bolt,Boy都是快速移动的跟踪目标,跟踪目标在快速移动的过程中发生姿态形变,如视频序列Bolt中的58帧和100帧,视频序列Boy中的106帧和228帧,男孩在扭转的过程中,身体特征发生较大变化,WBACF算法能够准确地跟踪目标.

3) 尺度变化: 如图5(e)所示,在视频序列CarScale中,汽车由远向近行驶的过程中,汽车的外观大小不断变大,WBACF展示了其他算法都更加准确的跟踪效果.如图5(f)所示,在视频序列Dog1中,玩具狗在摄像头前不断晃动,外观大小也不断发生变化,同样WBACF给出了更加准确的跟踪效果.

4) 光照变化: 如图5(g) David视频序列所示,跟踪目标从黑暗的地方走到有灯光的区域,如303帧、434帧和595帧可以看出发生不同程度的光照变化,并伴随着一定的姿态变化,如图5(h) Singer1视频序列所示,光照变化较大,在这种非常具有挑战性的情况下,WBACF也能取得很好的跟踪效果.

5) 目标遮挡:如图5(i) FaceOcc1视频序列中33帧、120帧、237帧、452帧,图5(j) Walking2视频序列中189帧和195帧,都发生不同程度的遮挡,在这种场景下,WBACF并未发生漂移,并能展示出很好的跟踪效果.

6) 复杂背景: 如图5(k)(l) Woman,Lemming视频序列所示,跟踪目标在移动过程中,背景复杂而又多变,在图5(k)第8帧和246帧中,背景颜色分别和跟踪目标的上衣和裤子颜色接近,WBACF能够实现准确的跟踪效果,说明WBACF对于背景感知信息具有较强的辨别能力.

3.2.2 定量评价

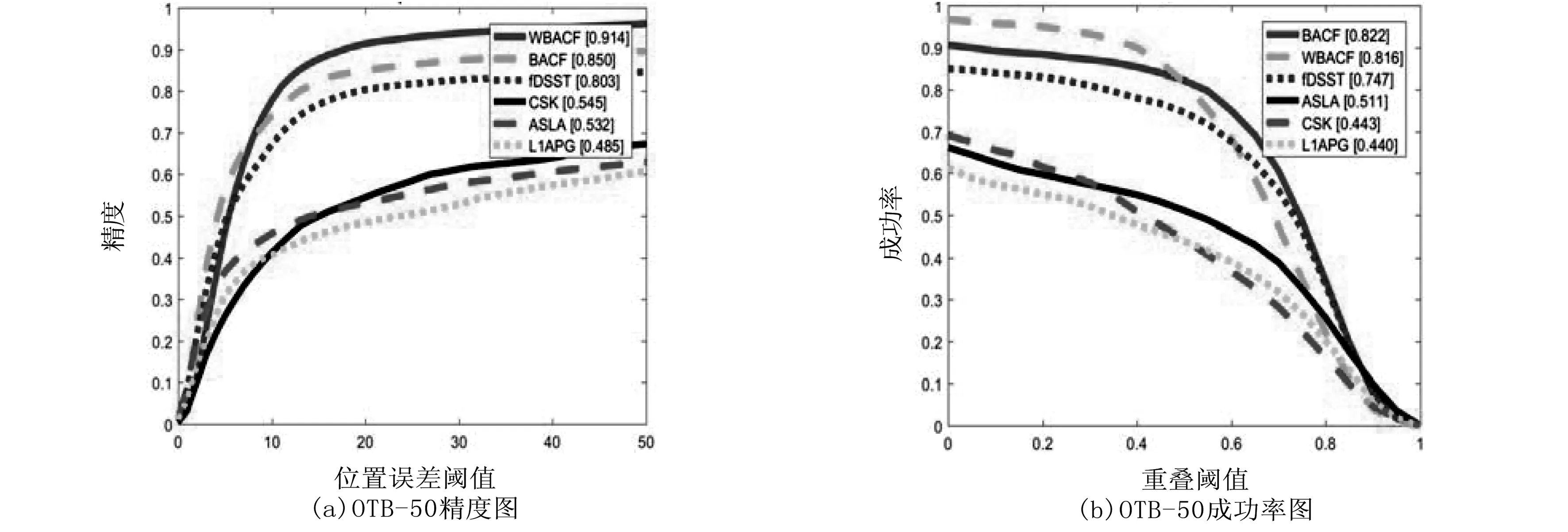

本节使用精度和成功率两种测评方法对跟踪算法进行性能测评.中心位置误差(Center Location Error,CLE)是指跟踪目标中心位置与实际中心位置的平均欧氏距离,通常使用精度图(Precision Plot)表示.边界框重合率(Bounding Box Overlap)指跟踪目标的边界框和实际物体边界框的交集,通常用成功率图(Success Plot)来表示.这两种性能评估方法被称作一次性评估(One-Pass Evaluation,OPE).如图6所示,WBACF在OTB-50数据集上的跟踪结果,如图6(a)跟踪精度图所示,相比与BACF的跟踪精度结果,WBACF框架的跟踪精度明显提高,如图6(b)跟踪成功率图所示,与BACF跟踪成功率相比,WBACF的跟踪成功效果稍稍有些落后,但是并不影响其整体性能,相比于其他几个跟踪算法,WBACF有很多优势.

图6 WBACF在OTB-50数据集上平均总体性能

图7 WBACF在OTB-50数据集上6个属性平均性能

如图7所示,给出WBACF在OTB-50数据集上6个属性平均性能,提出的WBACF在OTB-50数据集上提高了基准BACF的跟踪性能,并在运动模糊(图7(a))、快速移动(图7(b))、尺度变化(图7(c))、光照变化(图7(d))、目标遮挡(图7(e))、复杂背景(图7(f))等6个属性情境中,跟踪效果具有明显的提高.如图7(a)图像模糊跟踪效果所示,WBACF相比BACF提高了0.109,如图7(b)快速移动跟踪效果所示,WBACF相比BACF提高了0.069,如图7(c)尺度变化跟踪效果所示,WBACF相比BACF提高了0.117,如图7(d)光照变化跟踪效果所示,WBACF相比BACF提高了0.062,如图7(e)目标遮挡跟踪效果所示,WBACF相比BACF提高了0.09,如图7(f)复杂背景跟踪效果所示,WBACF相比BACF提高了0.039.这也证实加权背景感知信息,能够有效地处理背景感知信息.

4 结束语

提出一种基于加权背景感知框架的相关滤波视觉跟踪算法.该算法根据背景中不同区域与跟踪目标运动相似度的大小,赋予背景区域不同的权值,计算权值矩阵,从而训练出合适的相关滤波器,可以充分利用背景感知信息,实现良好的跟踪效果.通过在基准测试集OTB-50和OTB-100(部分)上进行实验,结果表明WBACF可以明显提高相关滤波器的鲁棒性,其跟踪速度与BACF框架相当,跟踪精度和成功率较后者有所提高.对于OTB-50数据集中运动模糊、快速移动、尺度变化、光照变化、目标遮挡、复杂背景等几类场景能实现较好的跟踪效果.