结合重检测机制的多卷积层特征响应跟踪算法

张 晶,黄浩淼

1.昆明理工大学 信息工程与自动化学院,昆明650500

2.云南省人工智能重点实验室(昆明理工大学),昆明650500

3.云南枭润科技服务有限公司,昆明650500

在计算机视觉领域中目标跟踪是研究的热点,并且在信息物理融合系统(cyber physical systems)的感知层中也得到了广泛的应用。然而对于目标严重变化、快速移动、长时间遮挡后再出现等复杂场景下,跟踪仍然面临很大的挑战性。因此,研究者提出了许多优秀的判别式与生成式目标跟踪算法[1-2],比如引入循环矩阵和核概念的算法(circulant structure of tracking-by-detection with kernel,CSK)[3]首先对训练样本中前景和背景进行密集采样,再由分类器循环移位样本从而快速检测出目标,提高了算法的速度,但由于只提取灰度特征,导致CSK 算法在复杂情景下不能更好体现目标外观模型,容易跟踪失败。CN(adaptive color attributes for real-time visual tracking)[4]提取多通道颜色信息经过快速傅里叶变换与核函数映射,得出目标最大响应值,同时该算法使用PCA(principal component analysis)降维技术大大减少颜色维度,提高跟踪的实时性,但也屏蔽了部分目标信息,对于光照强度下鲁棒性较差。KCF(high-speed tracking with kernelized correlation filters)[5]在CSK 的基础上,提取多通道HOG(histogram of gradient)特征替换灰度特征,然后高斯核函数简化特征矩阵,提高算法的鲁棒性,但目标尺度发生变化后,跟踪框容易漂移。DSST(discriminative scale space tracking)[6]构建33 层金字塔特征向量,再由尺度滤波器求响应值应对目标尺度变化,在解决目标尺度变化问题的同时跟踪精度也很高,但目标快速运动环境下跟踪效果不佳。以上相关滤波器算法在目标快速运动跟踪过程中,滤波器都容易因为边界效应而导致跟踪失败。Kalal 等人提出了跟踪与检测结合的TLD(tracking learning detection)算法[7],该算法通过正负样本在线学习机制检测样本,由TLD检测器筛除错误样本,避免快速运动后边界效应的影响,但检测器使用循环采样矩形框的方式,降低了算法的实时性。Danelljan等提出空间约束相关滤波器(spatially regularized correlation filter,SRDCF)[8],构建滤波器的过程中引入正则化因子,得到较大的检测区域,提高边界效应中边缘物体检测的鲁棒性,但在目标完全遮挡时容易出现跟踪丢失。在目标严重形变、长时期遮挡等复杂情景下,传统跟踪算法使用手工特征无法提取目标高级的语义信息,容易跟踪失败,而深度学习方法能更优地表述目标特征,因此,Ma 等人提出了HCF(hierarchical convolutional features for visual tracking)[9]方法,根据分层卷积特征训练不同的相关滤波器,使用高层特征找到目标所在的区域范围,然后由粗到精通过低层特征实现精确定位,从而有效地结合卷积层的空间位置信息,但在遮挡和物体变形的情况下鲁棒性较差。Nam 等人提出TCNN(tree convolutional neural network)[10]方法,使用树形的结构管理具有CNN(convolutional neural network)特征的目标外观模型,通过加权平均模型的候选框预测目标位置,可以适应目标的快速变化,但模型较为复杂后降低了跟踪的实时性。Danelljan等人提出了ECO(efficient convolution operators for tracking)[11]方法,通过高维特征图的集成,减少了特征的复杂度,解决高维度的参数空间过拟合,并引入相似性的度量方法对模型参数进行更新,提高算法的跟踪速度。Chen 等人提出MFKCF(single target tracking algorithm based on multi-fuzzy kernel fusion)[12]方法,首先将模糊理论应用到核函数中,然后通过核映射空间融合多种模糊核函数,提高算法的鲁棒性。Wang 等人提出基于分块检测的跟踪算法(scale adaptive correlation tracking method for circular target based on block detection)[13],通过边缘特征点与轮廓拟合解决了目标遮挡的问题,但光照强度发生变化时影响该算法提取边缘特征,从而导致跟踪框漂移。

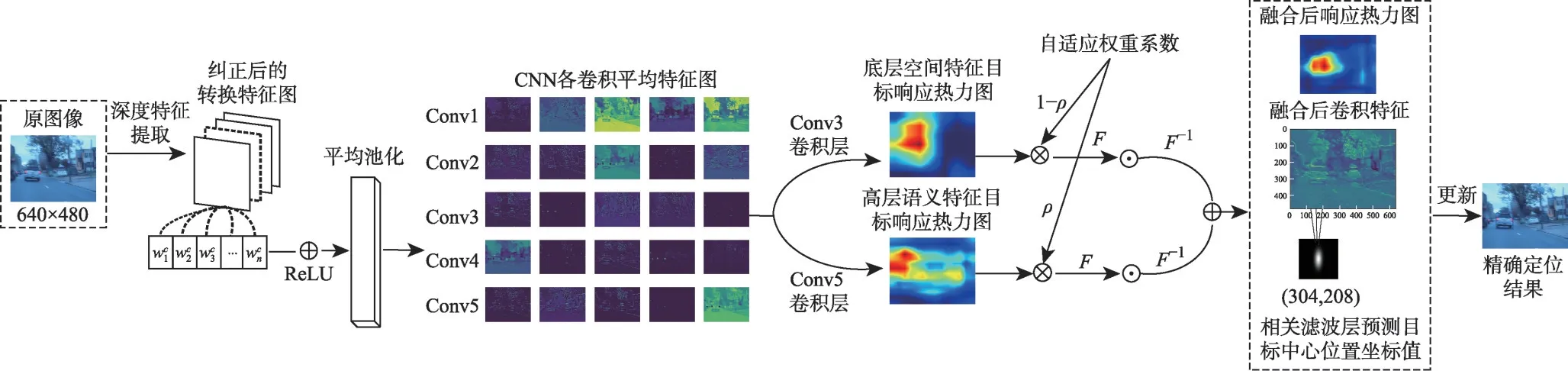

深度特征和相关滤波器的结合,得到了更精确的跟踪效果,但目标与背景信息特征相似,快速运动后跟踪模型仍然会受到背景信息干扰而更新失败;同时目标长时间遮挡后,由于缺乏重检测机制使得跟踪漂移。本文在目标检测区域的图像分块处理后建立混合高斯模型,将块图像内服从高斯分布的像素点分别与该模型进行匹配,由每一帧图像不断调整模型参数,提高自适应区分背景和目标的能力,再根据文献[9]中卷积层Conv3的底层特征有较高的空间分辨率可对目标进行精确定位,Conv5的高层特征包含着目标语义信息可以应对重大的形变和环境变化,本文提出梯度加权的类激活映射得到CNN 的多卷积层特征图来训练出多卷积层滤波器,然后融合第3层Conv3卷积层和第5层Conv5卷积层滤波器的响应值来预测目标位置,从而避免目标快速运动引起边界效应后,跟踪过程受到背景信息的干扰;同时本文利用重检测机制约束滤波器融合的响应值,得到平滑输出响应结果,提高算法的鲁棒性。

1 核相关滤波跟踪算法

1.1 卷积特征提取

深度卷积网络中存在池化的过程,随着卷积层级的加深,特征的空间分辨率逐步降低为原输入图像尺寸224×224 的1/32,则在VGG(visual geometry group)网络结构[14]中Conv5-4 卷积层的空间尺寸是7×7,由于特征图尺寸太小,没法对目标进行精确的定位,因此对特征图进行升采样将图像缩放到一个固定合适的尺寸上。

其中,h代表升采样前的特征图,i代表特征图位置,γ代表域的特征向量,a是插值的权值。

1.2 核相关滤波器构建

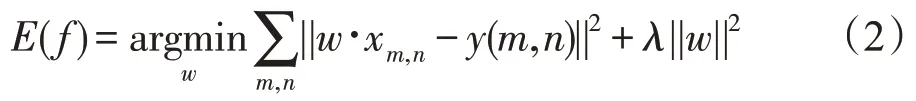

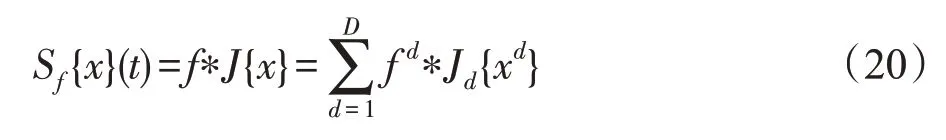

每个卷积层的输出可以作为多个通道提取的特征,假设其尺寸为M×N×D,M、N和D分别代表图像特征的宽和高和特征的通道数,由于所有循环移位的训练样本都有一个高斯函数标签,故构造核相关滤波器的目标函数为:

其中,y(m,n)=exp代表在(m,n)处像素的标签,λ为正则化参数,防止过拟合现象,w为相关滤波器。然后将目标函数经过FFT 变换转换到频域,求解后可以得到卷积层的d通道下滤波器目标函数的最优解为:

其中,Y(M,N)表示频域上的高斯标签,当给定下一帧图像块Z的尺寸M×N×D,提取图像的特征后,相关滤波器的目标响应可以表示为:

最后,通过搜索卷积层中响应的最大值就可以估计出目标位置。

1.3 滤波器模型更新

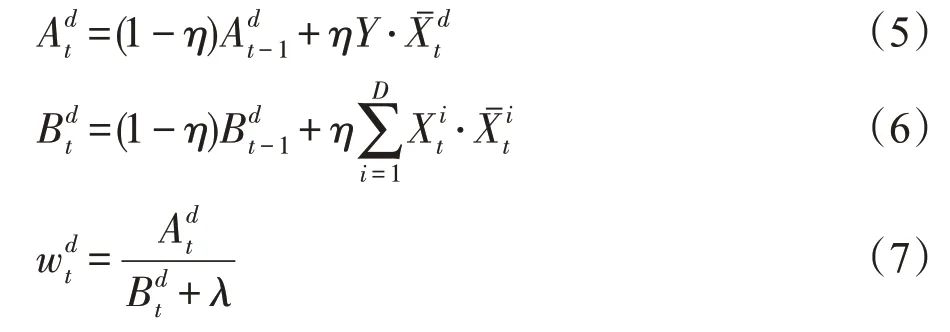

卷积层的最优滤波器可以通过最小化所有错误输出的跟踪结果来更新,但涉及到在每一个位置(m,n)处求解一个D×D的线性方程组,而且深度特征的通道通常都特别多,导致计算量很大。因此,采用移动平均分别更新滤波器的分子分母:

其中,η为学习率。同时根据视频帧之间具有连续性,通过每两帧对目标模型进行更新,提高了算法的跟踪速度,防止模型的过拟合和跟踪漂移。

2 结合重检测机制的多卷积层特征响应跟踪算法

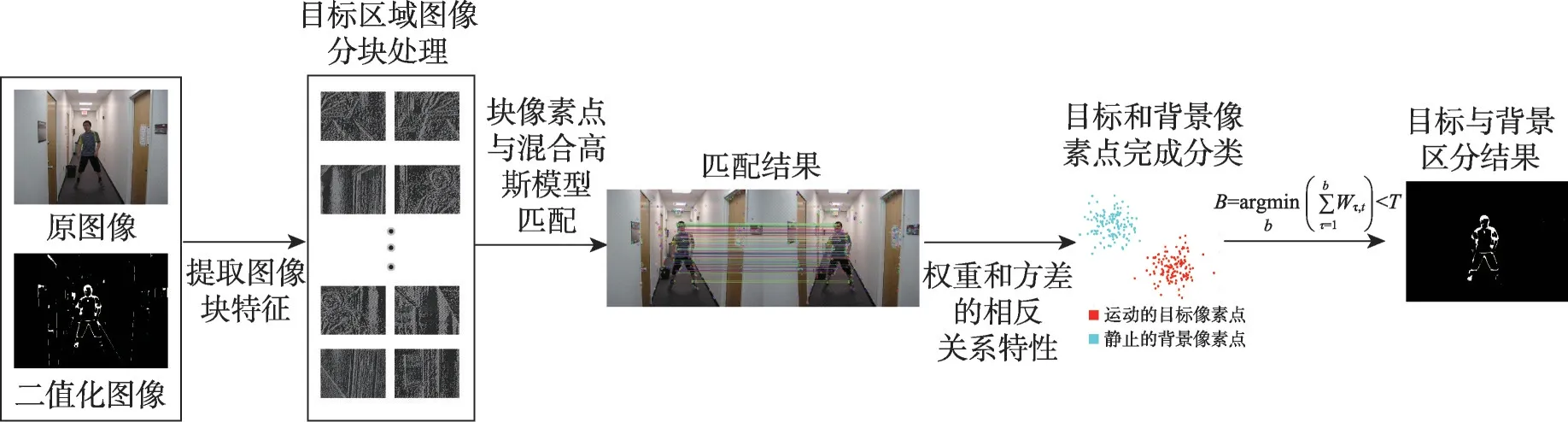

2.1 自适应区分图像中目标与背景

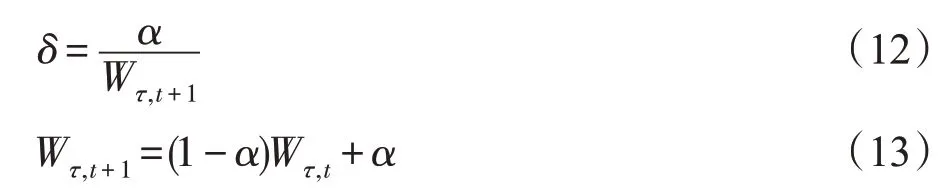

目标快速运动导致图像模糊产生边界效应,滤波器目标响应容易受到背景信息的干扰,导致跟踪失败。本文利用混合高斯模型[15]对复杂情景下目标和背景信息区分能力强的优点,首先对检测区域中图像进行均匀分块,然后根据块图像中心像素点的分布特征建立起混合高斯模型,再对于块图像内剩余像素点分别与模型进行匹配,若匹配成功则为背景像素点,否则为目标像素点,最后下一帧输入图像不断更新该混合高斯模型,提高跟踪器对图像边缘处目标与背景的区分能力。

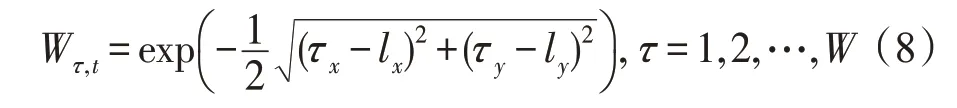

检测区域依据网格均分采样N×N共W块图像,根据区域内第τ块图像距离矩形框中心位置越近,其图像块特征得分权重值越高,进而弱化矩形框内边缘处图像中包含的背景信息对跟踪器分类影响,第τ块图像权重值公式如下:

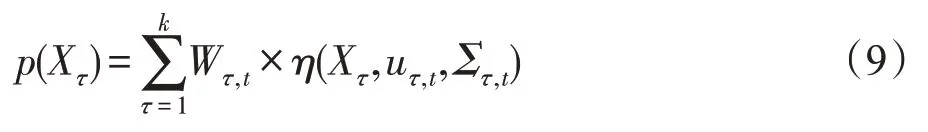

其中,(lx,ly)为矩形框的中心位置坐标,(τx,τy)为网格均分中第τ块图像的中心位置坐标。再结合第τ块图像压缩的特征权重值构建混合高斯模型,假设块中心的每个像素点序列为X1,X2,…,XW,建立k个高斯分布的混合模型,则像素点的高斯概率密度函数公式为:

其中,k为该像素点对应的高斯模型的数目,Wτ,t是第t帧时的第τ块图像权重值,uτ,t是第t帧时的第τ块图像的期望,Στ,t是第t帧时的第τ块图像的协方差值,η()是高斯概率密度方程,表示为:

下一步对当前帧服从式(9)的图像块内剩余像素点,若满足以下条件:

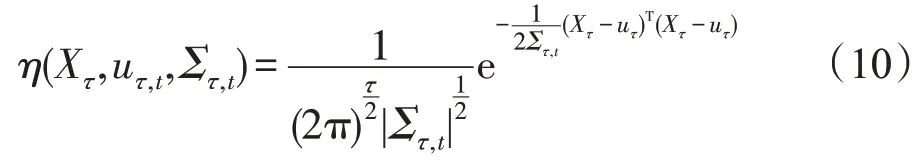

则判定该点匹配成功,将匹配的高斯模型进行更新:

其中,α为背景更新的学习率,δ为权值学习率,对于不匹配的高斯模型降低权重值Wτ,t,并对高斯模型方差和均值进行更新:

其中,δ学习率越小,均值和方差更新得越快,对目标跟踪效果越好,通过每一帧图像块的像素点与混合高斯模型匹配过程中,不断地更新高斯分布函数,最终得到随目标变化的高斯模型。当图像目标区域内的像素点匹配结束,相对静止的背景像素点高斯分布的方差小,其对应的权重偏大,而运动的目标像素点方差更大,权重偏小,本文按照权重与方差的比值进行降序排列,由设定阈值ξ=0.7 选出B个服从高斯分布像素点判断为最优目标像素点:

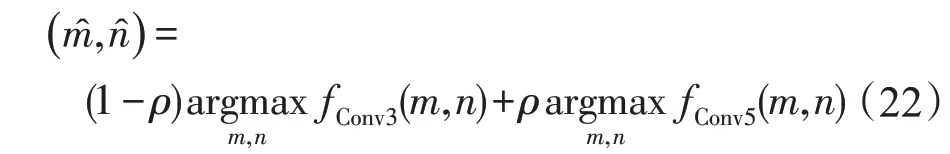

图1为图像内目标与背景进行区分的具体过程。

2.2 融合卷积层滤波器对目标响应

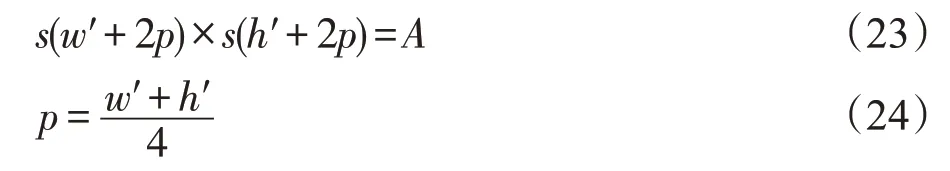

从2.1节获得图像处理的目标区域后,VGG网络卷积层中提取的目标区域CNN 特征具有噪声,导致形成的特征图存在局部激活性和稀疏性。本文借鉴梯度加权的类激活映射[16]思想将目标像素空间梯度引入导向反向传播中使特征图谱中突出细粒度细节,减少图像的噪声对目标模型产生定位误差,从而弱化CNN 卷积层在特征映射时噪声的影响;然后将映射后的深度特征图训练出卷积层所对应的滤波器;接下来为了结合Conv5 高层特征的语义信息和Conv3 底层特征的空间细节来处理目标严重变化情况,通过融合卷积层中第3 层Conv3 和第5 层Conv5滤波器的目标响应位置,达到定位更鲁棒的滤波器模型。

首先将标记了目标区域的图像作为输入,设置目标区域的梯度为1,其余的梯度为0。然后计算目标区域c的像素空间梯度yc与卷积层的γ个特征映射Aγ之间偏导数即,利用CNN全局平均池化的卷积特征映射直接输入到滤波器的导向反向传播中训练,具体通过卷积层产生γ个特征映射,根据全局平均池化将这些映射的特征图进行空间池化和线性变换反馈得到目标位置的重要性权重:

Fig.1 Process diagram of distinguishing target from background in image图1 图像内区分目标与背景的过程图

然后通过ReLU对映射的特征图线性加权组合,关注目标具有积极影响的特征,增加目标位置定位的性能,得到:

从而获得目标区域c宽度为u和高度为v的混合特征图,特征图中每个特征层都有单独的分辨率Nd,引入插值模型将特征图转移到连续空间域t∈[0,T],插值模型定义如下:

其中,d是通道数,bd是周期T>0 插值核函数,特征图中插入的特征层。本文用J{x}表示整个插入的特征图,通过训练连续的周期多通道卷积滤波器f=(f1,f2,…,f D)预测目标位置响应结果的得分Sf{x}(t),即:

因此,最小化目标函数学习得到新的滤波器公式如下:

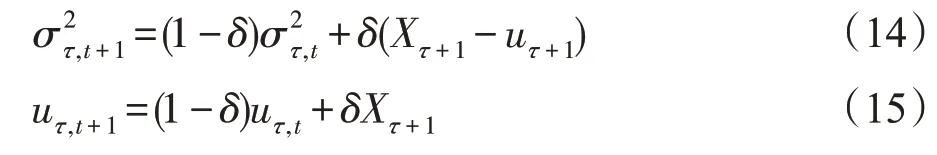

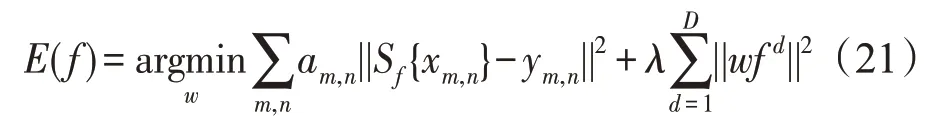

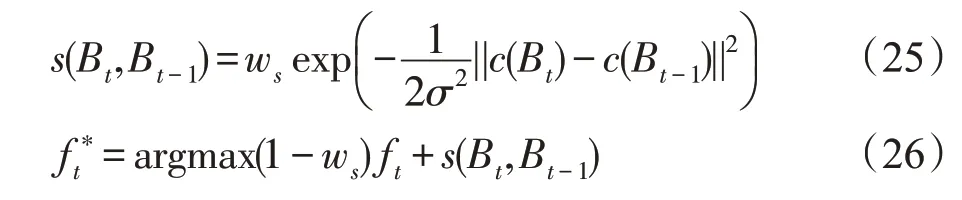

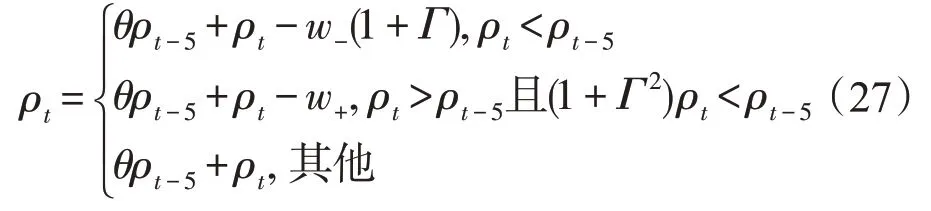

其中,ym,n是xm,n样本像素标签的检测得分,am,n是样本xm,n的权重,由数据项加权的分类误差构成,取最大分数作为位置响应值。下一步依据自适应权重分配系数ρ融合卷积层中Conv3 和Conv5 对目标响应结果进行输出:

2.3 结合重检测机制的目标响应

约束模型中滤波器的目标位置响应值,得到平滑调整的输出结果,从而构建出强跟踪器。传统的跟踪算法[7]检测机制都假设目标运动轨迹平滑,对当前帧目标位置周围进行全局搜索,导致样本数量大。本文进行改进后采用半径更小的局部窗搜索图像,根据候选矩形框内图像纹理特征约束排除那些不太可能包含目标的矩形框,减少了检测的误匹配,从而高效搜索整帧。

假设滤波器确定目标响应区域的大小(m,n,w′,h′),通过包含上下文信息的(w′+2p)×(h′+2p)的图像进行扩展得到重检测机制的多尺度信息:

其中,s=1.02 是尺度变换系数,然后按照尺度扫描产生大量的滑动矩形框,本文根据文献[7],利用TLD检测器的级联分类器过滤掉那些与目标区域相似度和重叠度低的滑动矩形框,然后将过滤后的样本作为置信度高的矩形框样本,来约束卷积层滤波器的目标响应位置,得到平滑输出的跟踪结果:

Fig.2 Process diagram of filter's fusion response to target position图2 滤波器对目标位置融合响应的过程图

其中,ws表示平滑约束项,最后跟踪器得到平滑输出结果,由滤波器响应ft和检测机制矩形框约束项s(Bt,Bt-1)组成。

2.4 模型更新

对目标进行长时间跟踪时,由于每一帧图像都要计算2.2节自适应权重系数ρ,导致算法的实时性降低。因此本文提出一种新的权重参数更新方法,同时为了防止模型过拟合,每隔5帧时对权重参数进行更新,对应于第t帧的权重自适应调整公式为:

其中,θ、Γ、w-、w+是调整因子,若ρ一直减小,最后可能小于零,则复杂环境下跟踪模型没有考虑到高层特征的语义信息,导致跟踪失败;若ρ一直增大,则影响跟踪模型对目标的精确定位,导致跟踪框漂移,因此本文设定两个阈值来约束ρ,这样就避免权重的过大过小问题影响跟踪效果。

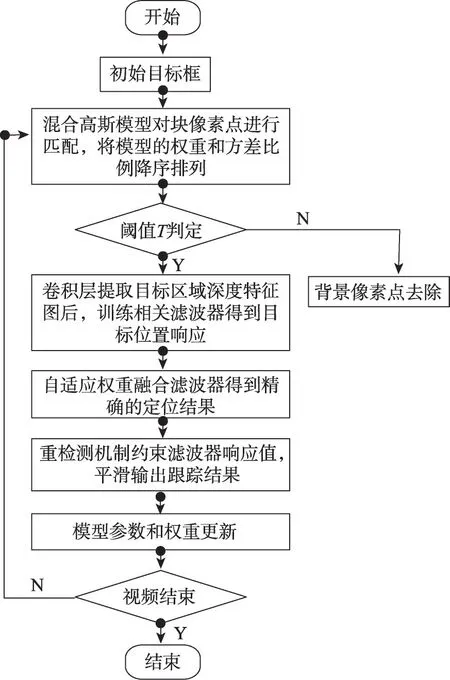

2.5 算法流程

输入:上一帧目标位置p0(m,n)。

输出:下一帧目标位置pt(m,n),更新自适应权重系数ρ,模型更新后滤波器。

步骤1人工划分第一帧的目标中心。

步骤2对图像分块提取特征,根据混合高斯模型对块像素点进行匹配,通过式(16)判断出目标像素点。

步骤3获得目标区域,通过式(18)得到深度特征图,再与滤波器模型进行卷积操作,通过式(22)融合目标位置响应值。

步骤4由式(26)重检测机制约束滤波器的响应值,得到平滑输出的跟踪结果。

步骤5使用式(27)对2.2 节自适应权重系数进行更新,并用目标函数训练滤波器。

步骤6依次重复步骤2~步骤5,直到视频结束为止。图3是本文算法流程图。

3 实验结果

Fig.3 Flow chart of proposed algorithm图3 本文算法流程图

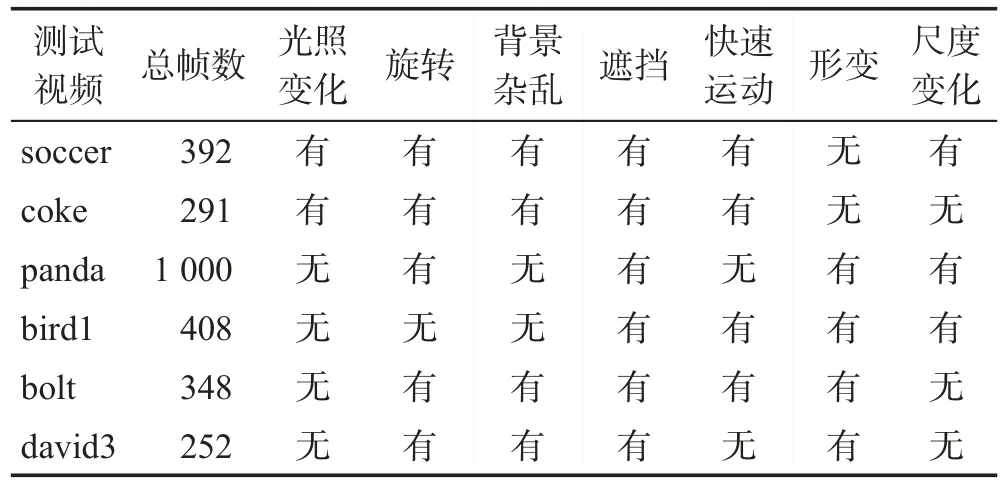

本文算法与HCF 算法、TCNN 算法、TLD 算法、DSST 算法、CN 算法进行实验分析。在目标跟踪测试集网站上(http://www.visual-tracking.net)选择了6个实验测试视频,如表1 所示,共有2 691 帧,实验测试视频序列包括光照变化、旋转、背景杂乱、遮挡、快速运动等背景环境。

Table 1 Test video sequence表1 测试视频序列

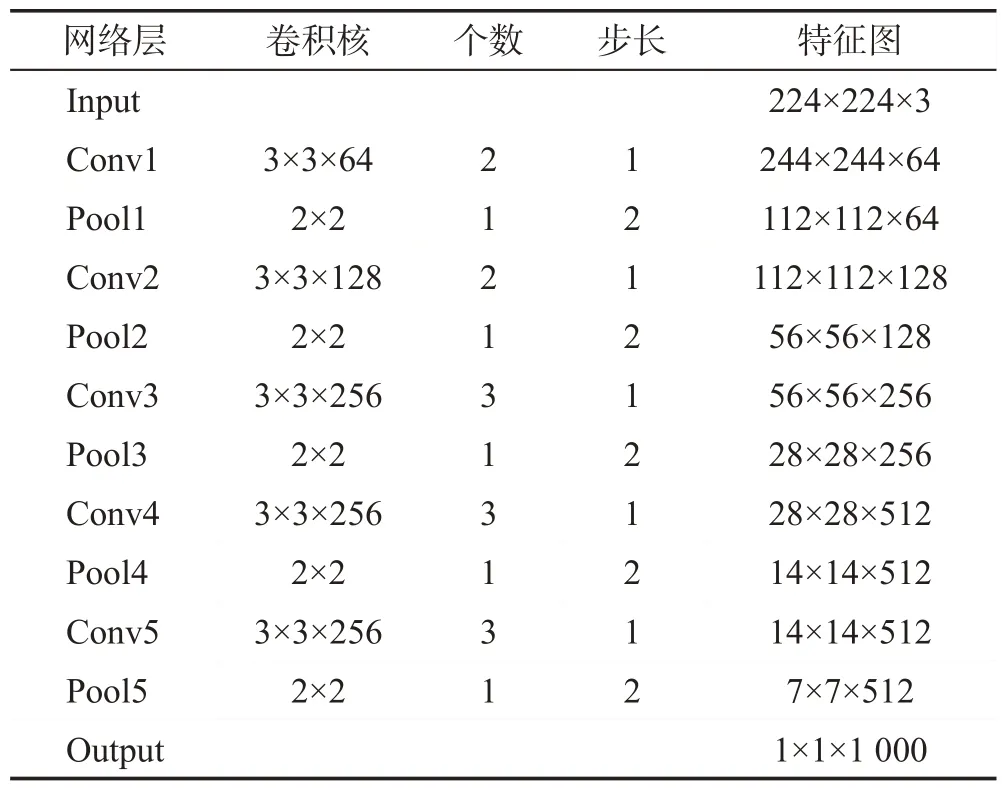

本文算法输入包含上下文信息的224×224×3 图像,经过卷积、池化、全连接操作后由Softmax层得到1 000 个分类结果,然后提取Conv5 和Conv3 的平均特征图输入卷积层滤波器中训练得到目标响应结果。其中网络偏置初始值设为0,VGG 网络参数、输入输出、卷积核的元素设置见表2。

Table 2 VGG network structure表2 VGG网络结构

本文实验环境的处理器为Intel®i5-4210 2.60 GHz,内存为4 GB。对本文权重更新参数调整因子取θ=0,Γ=0.05,w-=w+=1,背景更新的学习率取a=0.025,平滑约束项取ws=0.2,初始化混合高斯模型的块图像权重值Wτ,t取0.1,块图像的协方差值Στ,t取15,块图像的期望uτ,t取像素点的平均值。本文算法从成功率图、精度图和帧率FPS三方面评测标准来比较上述6种算法,使用文献[17]给出的测试视频中Ground truth 作为实际目标框来计算得到成功率图和精度图[18-19],将跟踪算法输出跟踪框的中心位置与实际跟踪框的中心位置进行欧氏距离计算,得到精确图SSE=,其中(gxi,gyi)和(rxi,ryi)分别为本文算法得到的跟踪框中心位置坐标和实际的跟踪框中心位置坐标;通过计算跟踪算法每帧的跟踪框重叠度,然后将大于给定阈值的帧数除以总帧数得到成功率图S=,其中Bg和Br分别为本文算法得到的跟踪框面积和实际的跟踪框面积。接下来通过本文实验结果以及视频测试序列部分截图对6种不同的跟踪算法进行实验分析。

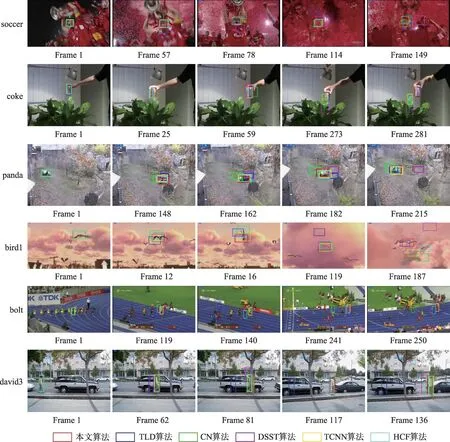

实验中本文算法用红色表示,TLD 算法用蓝色表示,CN 算法用绿色表示,DSST 算法用紫色表示,TCNN算法用黄色表示,HCF算法用青色表示。

3.1 跟踪结果定性分析

在实验测试视频中,本文选择soccer测试视频具有遮挡、背景杂乱、快速运动的情景,图4 第1 行是soccer测试视频跟踪结果的截图,从Frame 57、Frame 78可以看出,目标的衣服与背景的颜色相似,在快速运动中,由于目标姿态的变化产生边界效应,导致CN算法的目标颜色模型和DSST 算法的相关滤波器模型更新受到背景信息的干扰,对目标颜色特征和HOG 特征的描述变差,影响跟踪框准确表征目标区域,从而跟踪框发生偏移;从Frame 114、Frame 149可以看出,目标被彩带遮挡时,DSST 算法跟踪框积累偏移误差后跟踪失败,HCF 算法不能有效区分目标与背景信息,使跟踪器发生漂移。选择coke 测试视频具有光照变化、旋转、遮挡的情景,图4 第2 行是coke 测试视频跟踪结果的截图,从Frame 25 可以看出,光线变强时,影响TLD跟踪框内特征点通过光流法计算前后向误差,导致特征点预测的跟踪框缩小;从Frame 273、Frame 281 可以看出,目标发生完全遮挡后,CN 算法和DSST 算法对伪目标叶子进行滤波器训练并更新目标模型,导致跟踪失败,TCNN 树状模型根据上一帧伪目标叶子的位置得到检测后的候选框,导致跟踪框不稳健,HCF算法缺乏重检测机制无法持续跟踪到目标,TLD 算法通过检测器的跟踪失败恢复机制重新找到目标区域。选择panda 测试视频具有形变、旋转、遮挡的情景,图4第3行是panda测试视频跟踪结果的截图,从Frame 148、Frame 162、Frame 182、Frame 215可以看出,目标旋转时影响CN算法和DSST 算法提取目标颜色特征和HOG 特征,导致跟踪框漂移,DSST算法引入过多背景信息的响应导致跟踪失败,TCNN算法通过Tree的结构对多个CNN模型进行权重计算,选出候选框,可以适应目标的快速变换。选择bird1 测试视频具有快速运动、形变、遮挡的情景,图4 第4 行是bird1 测试视频跟踪结果的截图,从Frame 12、Frame 16可以看出,目标发生形变后,由于翅膀的摆动,CN算法、TLD算法和HCF算法跟踪框漂移;从Frame 119、Frame 187可以看出,目标被彩云完全长时间遮挡后,CN 算法和DSST 算法滤波器对背景信息进行滤波响应,最后跟踪失败,TCNN算法通过多个模型检测候选框,但无法对目标进行位置确定从而跟踪失败,HCF 算法使用的特征模型不能应对长期遮挡的目标。选择bolt 测试视频具有快速运动、旋转、形变的情景,图4 第5 行是bolt测试视频跟踪结果的截图,从Frame 241、Frame 250可以看出,目标旋转时,影响CN算法和DSST算法对目标提取特征进行训练从而跟踪失败。选择david3测试视频具有背景杂乱、旋转、遮挡的情景,图4 第6行是david3 测试视频跟踪结果的截图,从Frame 81看到DSST 算法受到树的遮挡导致跟踪框偏移;从Frame 117、Frame 136 可以看出,目标发生旋转后,CN 算法、TLD 算法和DSST 算法提取目标单一的手工特征导致跟踪框漂移,TCNN算法提取目标深度特征后,通过树的结构模型避免了最近帧的过拟合,HCF 算法通过深度特征训练不同的滤波器,从粗到精对目标位置进行预测。

Fig.4 Screenshot of part of video tracking sequence图4 视频跟踪序列部分截图

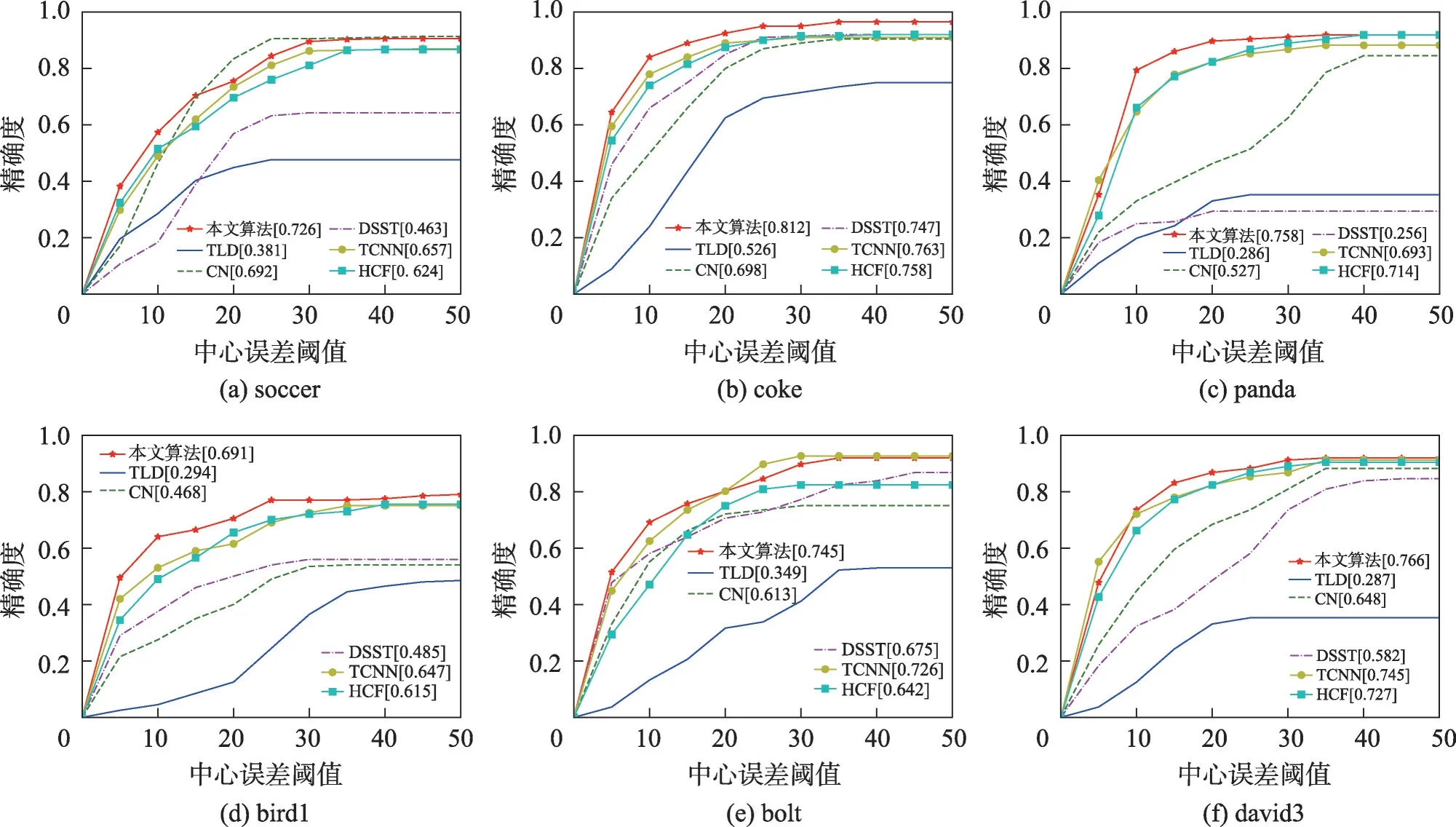

Fig.5 Accuracy chart of test video图5 测试视频的精度图

从以上视频帧中看出,本文算法在以上情景下跟踪效果更鲁棒,本文采用多层次的深度卷积特征表征目标,并根据不同的卷积层语义信息和空间信息不同,通过自适应训练多层的相关滤波器,由Conv5 卷积层滤波器的响应区域融合Conv3 卷积层滤波器的初始响应位置,得到目标精确定位的结果。另外从bolt测试视频中Frame 241、Frame 250可以看出,本文通过混合高斯模型进行像素点匹配,有效地区分目标和背景,避免了相似物的干扰。从bird1测试视频中Frame 119、Frame 187 可以看出,本文重检测机制输出的矩形框平滑约束滤波器的位置响应,重新找到目标区域。

3.2 跟踪结果定量分析

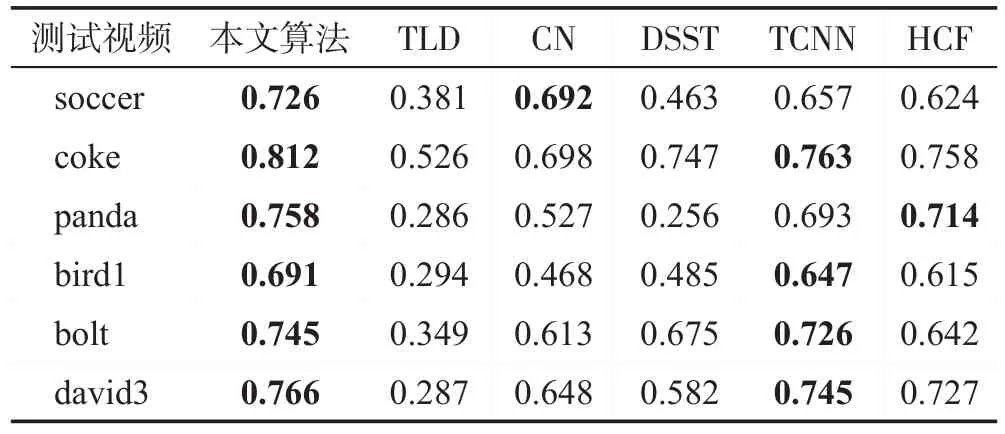

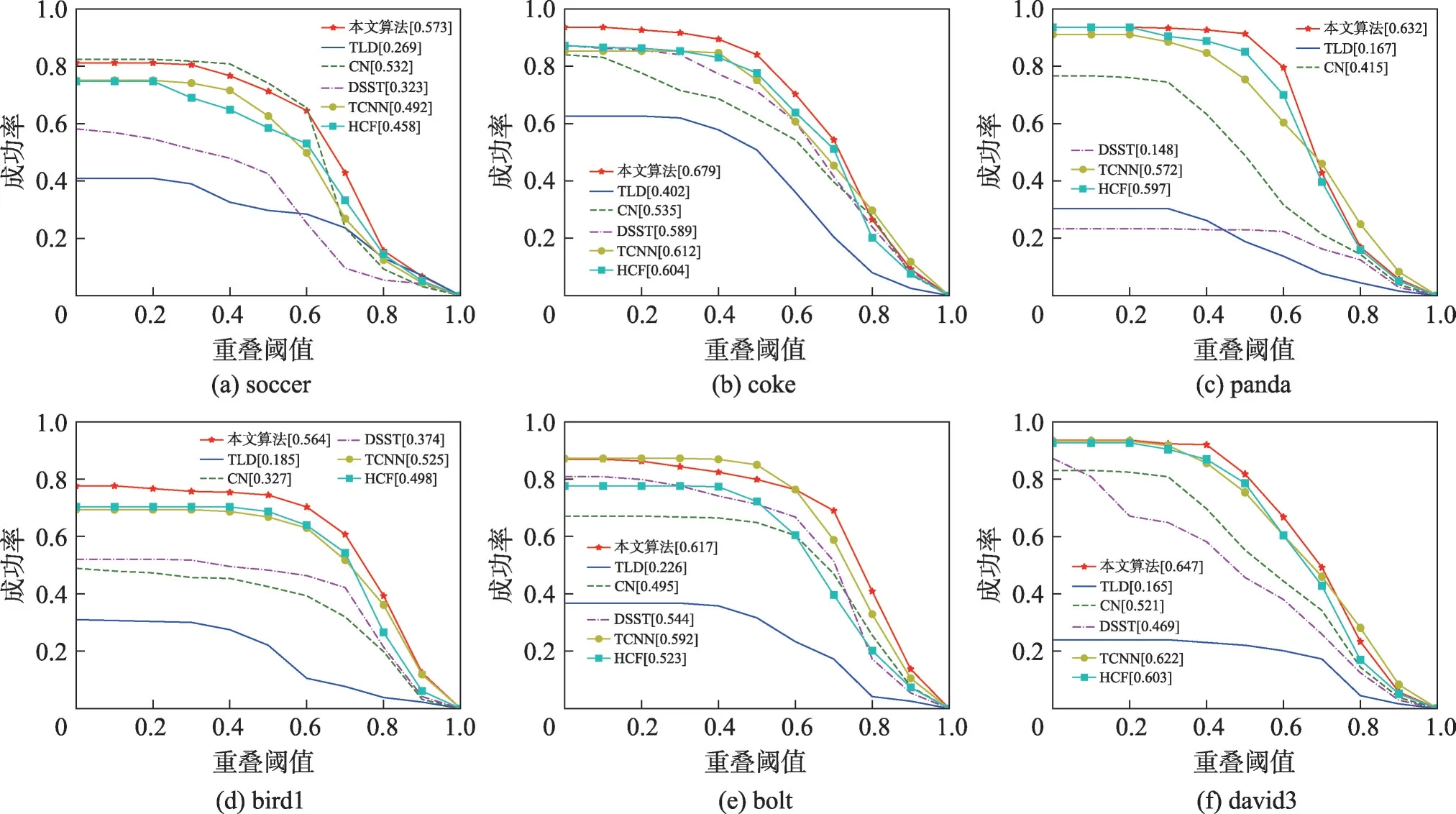

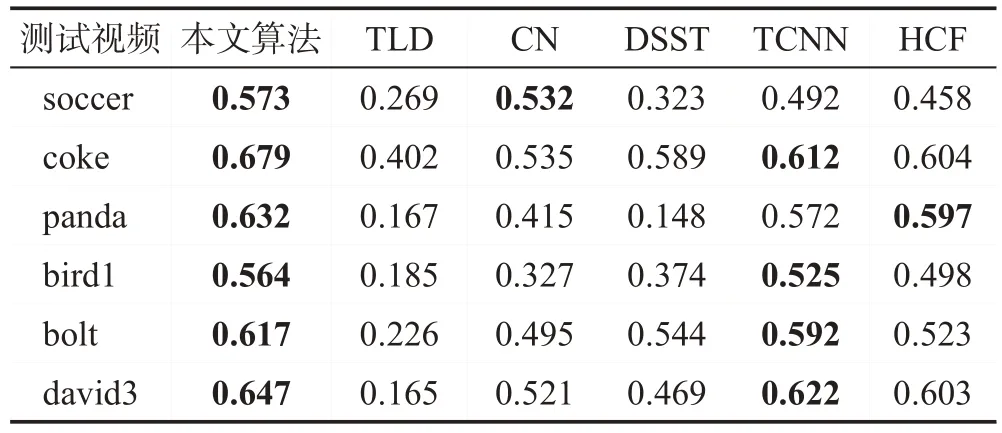

图5、表3 为6 种算法的精确度,图6、表4 为6 种算法的成功率。从表3和表4的soccer实验精确度和成功率得到,本文算法精确度为0.726,成功率为0.573,比次优的CN 算法分别提高了4.7%和7.2%。从图6的soccer实验成功率图得到,在重叠阈值大于0.7时,本文算法和CN算法比其他算法的成功率高,主要是在目标遮挡时,DSST 算法跟踪失败,HCF 算法和TCNN 算法跟踪框漂移,CN 算法通过目标颜色特征进行跟踪,避免背景信息的干扰。本文算法根据混合高斯模型有效区分了目标与背景信息;在重叠阈值小于0.7 时,本文算法、TCNN 算法和HCF 算法比CN 算法和DSST 算法的成功率高,主要是在目标快速移动时,产生的边界效应影响了CN 算法和DSST算法滤波器对位置响应,导致运动模型更新失败。从表3和表4的coke实验精确度和成功率得到,本文算法精确度为0.812,成功率为0.679,比次优的TCNN 算法分别提高了6.1%和9.8%。从图5 的coke实验精度图得到,本文算法比其他算法的精确度高,主要是视频中存在光照变化导致TLD 跟踪框缩小,相关滤波算法的滤波器对叶子进行训练响应,导致目标跟踪失败,深度学习算法模型得出错误的候选框,而本文算法通过梯度加权的类激活映射得到深度特征图,然后多层滤波器融合特征图响应,得到目标精确定位的结果。从表3和表4的panda实验精确度和成功率得到,本文算法精确度为0.758,成功率为0.632,比次优的HCF 算法分别提高了5.8%和5.5%。从图6 的panda 实验成功率图得到,深度学习算法比相关滤波算法的成功率高,主要是因为深度特征比手工特征对目标的表述更鲁棒。从表3 和表4 的bird1 实验精确度和成功率得到,本文算法精确度为0.691,成功率为0.564,比次优的TCNN 算法分别提高了6.4%和6.9%。从图5 的bird1 实验精度图得到,本文算法比其他算法的精度高,主要是在目标完全遮挡时,其他算法被背景信息进行错误响应,导致目标跟踪失败,而本文算法通过重检测机制平滑约束滤波器的响应值,重新找到图像中目标位置。从表3和表4的bolt实验精确度和成功率得到,本文算法精确度为0.745,成功率为0.617,比次优的TCNN 算法分别提高了2.6%和4.1%。从图6 的bolt 实验成功率图得到,本文算法比其他算法的成功率高,主要原因是其他算法对目标周围进行采样时,决策边界位置正负样本存在模糊性,HCF算法跟踪框发生漂移,而CN 算法、DSST 算法跟踪失败,本文通过对Conv3 和Conv5层分别自适应训练相关滤波器,缓解采样模糊时的模型更新问题,并通过融合响应来预测目标位置。从表3 和表4 的david3 实验精确度和成功率得到,本文算法精确度为0.766,成功率为0.647,比次优的TCNN 算法分别提高了2.7%和3.9%。从图5 的david3实验精度图得到,深度学习算法比相关滤波算法的成功率高,主要是深度学习算法采用卷积层对目标提取特征,得到更优的表观模型,避免了目标旋转和背景杂乱导致的背景信息干扰。

Table 3 Average center error rate(accuracy)of 6 algorithms表3 6种算法的平均中心误差率(精确度)

Fig.6 Success rate graph of test video图6 测试视频的成功率图

Table 4 Average overlap rate(success rate)of 6 algorithms表4 6种算法的平均重叠率(成功率)

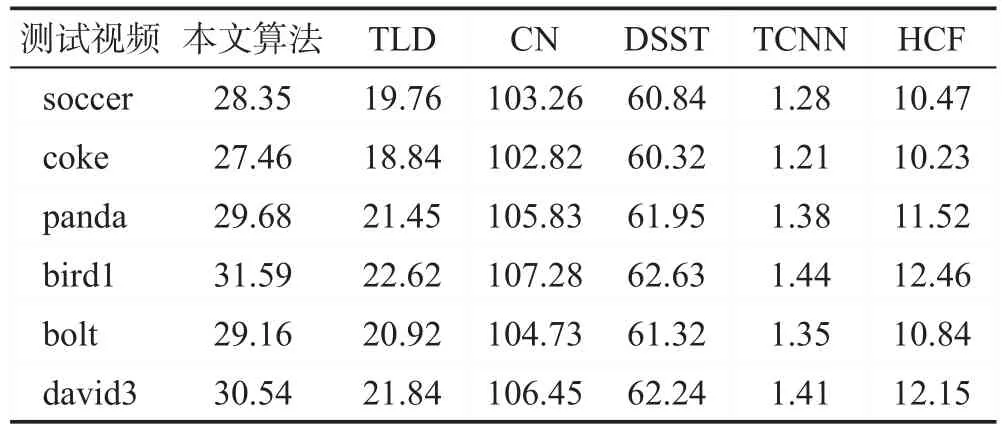

3.3 算法跟踪速率分析

从表5 得到,CN 算法在CSK 算法上融入颜色特征后,使用主成成分降维,跟踪的实时性最好,平均帧率达到105.06 f/s;DSST算法通过对高斯核函数转为频域计算,并提出滤波器更新机制,从而跟踪的实时性得到提高;TLD算法通过网格循环采样矩形框,计算每个矩形框的重叠度和相似度使得TLD算法实时性一般;HCF提取多个卷积层的特征训练滤波器,增加模型的复杂度,通过每一帧对滤波器进行更新使算法的实时性较差;TCNN算法对目标进行多层卷积提取深度特征,并需要对每一帧进行树形判断,导致实时性最差,平均帧率为1.35 f/s;本文算法选取局部窗搜索的方式,大大减少检测器学习和训练的滑动矩形框,并通过一种新的自适应权重更新方法降低计算的复杂性,减少高维度参数空间的过拟合,使平均帧率达到29.46 f/s。

Table 5 Comparison of average frame rate of 6 algorithms表5 6种算法的平均帧率对比 f/s

4 结束语

本文算法融合多卷积层的深度特征后,能够处理环境中目标快速变化并防止跟踪器漂移;检测器机制可以有效应对目标长时间遮挡情景下的持续跟踪问题。提出了一种结合重检测机制的多卷积层特征响应跟踪算法,首先将分块处理后图像内服从高斯分布的块像素点分别与混合高斯模型匹配,然后获得目标区域并由加权梯度的类激活映射出深度特征图,再利用卷积层中第3 层Conv3 和第5 层Conv5提取深度特征图并训练相关滤波器,自适应权重系数融合Conv5 高层特征滤波器和Conv3 底层特征滤波器的目标位置响应值,重检测机制约束该响应值,得到平滑输出的跟踪结果,提高了跟踪算法的鲁棒性,同时本文通过对模型权重更新,减少了模型参数之间的过拟合。实验结果表明,本文算法对于目标严重形变、旋转、长期遮挡等情景跟踪结果更鲁棒。然而,本文算法跟踪速度较差,下一步的研究方向是通过端对端的更新策略提高跟踪算法的实时性。