异构网络表示学习方法综述

王建霞 刘梦琳 许云峰 张妍

摘 要:现实生活中存在的网络大多是包含多种类型节点和边的异构网络,比同构网络融合了更多信息且包含更丰富的语义信息。异构网络表示学习拥有强大的建模能力,可以有效解决异构网络的异质性,并将异构网络中丰富的结构和语义信息嵌入到低维节点表示中,以便于下游任务应用。通过对当前国内外异构网络表示学习方法进行归纳分析,综述了异构网络表示学习方法的研究现状,对比了各类别模型之间的特点,介绍了异构网络表示学习的相关应用,并对异构网络表示学习方法的发展趋势进行了总结与展望,提出今后可在以下方面进行深入探讨:1)避免预先定义元路径,应充分释放模型的自动学习能力;2)设计适用于动态和大规模网络的异构网络表示学习方法。

关键词:计算机神经网络;异构网络;表示学习;图神经网络;建模能力

中图分类号:TP311.13 文献标识码:A

文章编号:1008-1542(2021)01-0048-12

现实世界的数据集大多是以图形或网络等数据结构表示,其中对象及其之间的关系分别由节点和边来体现。例如社交网络[1-2]、物理系统[3]、交通网络[4-5]、引文网络[6-7]、推荐系统[8-9]、知识图[10]等。

网络中的节点拥有丰富的属性信息(如图像、文本等),形成典型的复杂信息网络。基于复杂信息网络的普遍存在性,对信息网络进行研究和分析具有很高的应用价值。

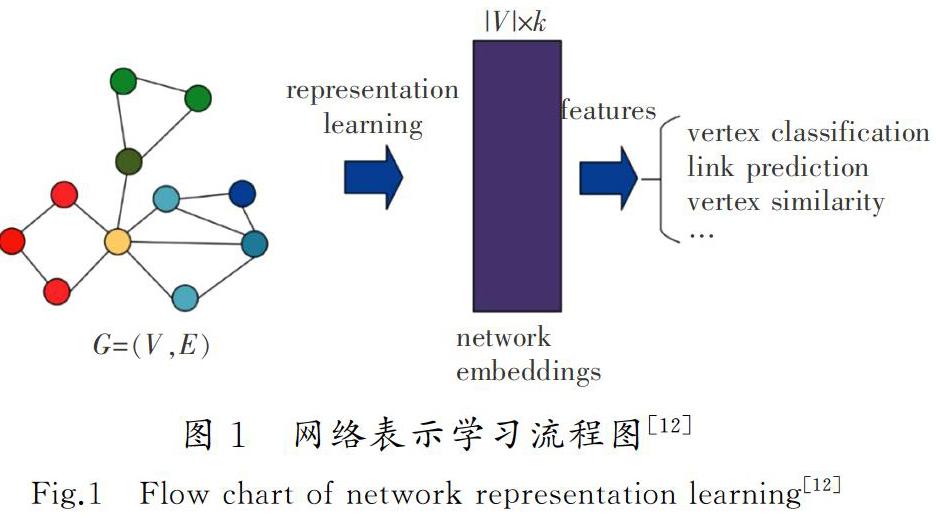

信息网络属于不规则的非欧几里德数据,如何有效地提取信息成为值得研究的课题。近些年来,网络表示学习在结构特征提取方面显示出强大的潜力。如图1所示,网络表示学习方法从复杂的信息网络中学习每个实体的特征信息,将其表示为低维稠密的实数向量,以应用于下游机器的学习任务[11]。

目前大多数网络表示学习方法都集中在同构网络上,只考虑一种节点对象和一种连接关系,忽略了网络的异质性。然而,现实生活中存在更多的是包含多种类型的节点以及边的异构网络。相比同构网络,异构网络融合了更多信息且包含更丰富的语义信息。若直接将异构网络当作同构网络去处理,很容易造成信息的丢失,影响下游任务的效果,所以近年来越来越多针对异构网络的表示学习方法被设计出来。CHANG等[13]设计了一个深度表示学习模型以捕捉网络中异质数据之间的复杂交互。FU等[14]利用神经网络模型捕获了异构网络中豐富的关系语义学习节点的表示。

当前,包含不同类型的节点和连接关系的异构网络的表示学习综述相对较少。周慧等[15]介绍了基于网络结构的异构网络嵌入方法,但缺少对图神经网络方法的介绍。本文系统地介绍了异构网络表示学习相关方法的模型,分为基于网络结构的嵌入方法和图神经网络方法2大类,并细分为4个小类别,分别是基于随机游走方法、基于一阶/二阶相似度方法、基于图注意力网络方法和基于图卷积网络方法,对比了各模型的优缺点和应用场景。同时,还整理了开源实现的表示学习模型以及常用的数据集供研究者参考。异构网络表示学习方法分类如图2所示。

1 异构网络表示学习的基本定义

异构网络表示学习公式中常见符号及其含义如表1所示。

定义1 异构信息网络(HIN,简称异构网络)[16]

如图3 a)和图3 b)所示,异构网络(IMDB数据集)由多种类型的对象(演员(A)、电影(M)、导演(D))和关系(电影(M)与导演(D)之间的拍摄关系,演员(A)与电影(M)之间的角色扮演关系)组成。在异构网络中,2个对象可以通过不同的语义路径

进行连接,这种连接方式称为元路径。

如图3 c)所示,通过多条元路径(例如,moive-actor-moive(MAM)和movie-director-movie(MDM))连接2部电影。不同的元路径揭示不同的语义,MAM表示共同角色关系,而MDM则表示他们由同一导演制作。给定一条元路径P,每个节点都有一组基于元路径的邻居,可以在异构网络中揭示多种结构信息和丰富的语义信息。

定义3 基于元路径的邻居(Meta-path based neighbors)

在异构网络中给定一个节点v和一条元路径P,将节点v基于元路径的邻居NPv定义为通过元路径P与节点v连接的一组节点,节点的邻居包括自己。

以图3 d)为例,给定元路径MAM,M1基于元路径的邻居包括M1(自己),M2和M3。类似地,M1的基于元路径MDM的邻居包括M1和M2。

定义4 网络表示学习[18]

2 异构网络表示学习方法介绍

异构网络表示学习方法是将异构网络中丰富的结构信息和语义信息嵌入到低维节点表示中,便于下游任务应用。随着深度学习的兴起,图神经网络(GNN)成为近年来异构网络表示学习领域中的热门研究方向。与基于网络结构的嵌入方法相比,图神经网络方法通过聚合节点自身属性信息以及邻居节点信息得到节点的嵌入表示。

2.1 基于网络结构的嵌入方法

基于网络结构的嵌入方法单纯利用网络中拓扑结构的相似性生成节点嵌入向量,根据获取相似性方式的不同,分为基于随机游走方法和基于一阶/二阶相似度方法,各模型的主要特点如表2所示。

2.1.1 基于随机游走方法

metapath2vec模型是DONG等[20]在2017年提出的一种用于异构网络的节点嵌入方法。该方法使用基于元路径的随机游走策略,从异构网络获取每个顶点的异构邻居。即给定一条元路径P,第i步的转移概率为

metapath2vec模型使用基于元路径随机游走和skim-gram的方式解决了异构网络的异质性问题,提供了异构网络表示学习研究的基本思路。

HERec模型[21]利用一种类型约束策略过滤节点序列,捕获异构网络中反映的复杂语义。通过一些对称的元路径将异构网络变成同构网络,然后在同构网络中根据node2vec方法[25]优化以下目标函数,学习单条元路径下节点的嵌入如式(2)所示:

式中:f是将节点映射到低维特征空间上的函数;NPv表示在给定一条元路径的情况下节点v的邻居。最后融合各条元路径的信息得到最终的节点表示。

不同于metapath2vec和HERec,按照给定元路径模式游走的方式,HIN2Vec模型[17]完全随机选择游走节点,只要节点有连接均可游走。HIN2Vec模型采用基于随机游走和负采样的方法生成符合目标关系的点边序列。如图4所示,假设随机游走得到序列P1,P2,A1,P3,A1,目标关系包含元路径长度不大于2的所有关系,那么对于节点P1,可以产生训练数据(P1,P2,P-P)和(P1,A1,P-P-A)。然后HIN2Vec模型将节点和节点间的关系简化成二分类问题,即给定2个节点x,y,通过预测节点之间是否存在确定的关系r,将分类问题作为优化目标学习节点表示。

metapath2vec,HERec和HIN2Vec是异构网络表示学习的3个早期工作,为之后的工作提供参考。HU等[26]设计了一种通过结合基于元路径上下文的三向神经交互模型(MCRec)。该模型通过使用基于优先级的采样技术选择高质量的节点序列构建基于元路径的上下文,并利用共同注意力机制相互改善基于元路径的上下文和节点的表示。

LU等[27]提出了一种可感知关系结构的异构网络嵌入模型(RHINE),包含2种与结构相关的度量,这些度量将异类关系区分为2类:从属关系(AR)和交互关系(IR)且专门为处理AR和IR量身定制了不同模型,可以更好地捕获网络的结构和语义。

在网络表示学习中,负采样是一项重要操作。通过提高负采样的效率,找到有代表的负样本,可以大大提高模型的性能。为了找到有代表性的负样本,HU等[28]将图对抗网络[29](GAN)引入到异构网络表示学习中,提出了一种新的用于异构网络嵌入的框架(HeGAN)。HeGAN根据关系类型使用GAN生成更具代表性的负样本。研究表明,无论是在分类、聚类还是链接预测任务中,HeGAN方法显著优于metapath2vec方法和HIN2Vec方法[28]。

2.1.2 基于一阶/二阶相似度方法

TANG等[22]在LINE算法[30]的基础上进行改进,提出了一种半监督的文本数据表示学习方法,即预测文本嵌入(PTE)。PTE模型首先将异构网络分解为一组二部图网络,然后通过捕获二部图网络的二阶相似度学习节点的嵌入表示。PTE模型的目标函数为

SHI等[23]发现之前很多算法都是把不同类型的节点映射到同一低维空间中,容易造成信息丢失,故提出一种新的嵌入式学习框架(AspEm),通过对异构网络进行多个方面的划分,实现了在避免信息丢失的情况下,获得高质量的节点嵌入表示,如图5所示。图5 a)图例可以分解成图5 b)中2个方面的子图。AspEm还设计有一个不兼容信息的度量方法,为嵌入学习选取合适的方面。给定一个方面a,目标函数为

AspEm方法虽然独立地获取了不同方面的信息,但是完全禁止了跨方面的联合学习。SHI等[24]对AspEm方法进行改进,提出HEER算法。HEER算法允许不兼容的信息在联合学习过程中进行不同程度的协作。HEER算法的基本思想:在节点表示的基础上建立边的表示,并且为不同類型的边采用不同的度量空间,通过结合边的表示和不同的度量空间,学习异构网络节点和边的嵌入表示。

2.2 图神经网络方法

近年来,随着图神经网络(GNN)的兴起,以图卷积网络(graph convolutional network)和图注意力网络(graph attention network)为代表的图神经网络被广泛应用于异构网络表示学习中。与同构网络不同,异构网络通常需要考虑不同关系下邻居信息的差异。因此,异构图神经网络方法通常采用层次聚合的方式,即节点级别的聚合以及语义级别的聚合。图神经网络方法的主要特点如表3所示。

2.2.1 基于图注意力网络方法

近年来,深度学习引入了注意力机制,注意力机制的潜力在各个领域得到了充分证明。WANG等[19]首次将注意力机制引入异构图神经网络中研究,并提出一种基于层次注意力的异构图神经网络模型(HAN)。HAN模型嵌入架构如图6所示,总体包括2部分:1)将所有类型的节点投影到统一的特征空间中,并通过节点级别注意力学习基于元路径的邻居节点的权重;2)利用语义级别注意力学习每条元路径的权重,并通过相应的聚合操作得到最终的节点表示。

HAN节点级别的聚合:如图6 a)所示,节点级注意力旨在学习给定元路径下不同邻居节点的重要性,然后通过加权平均学习节点在某条元路径下的表示。

HAN语义级别的聚合(如图6 b)所示):

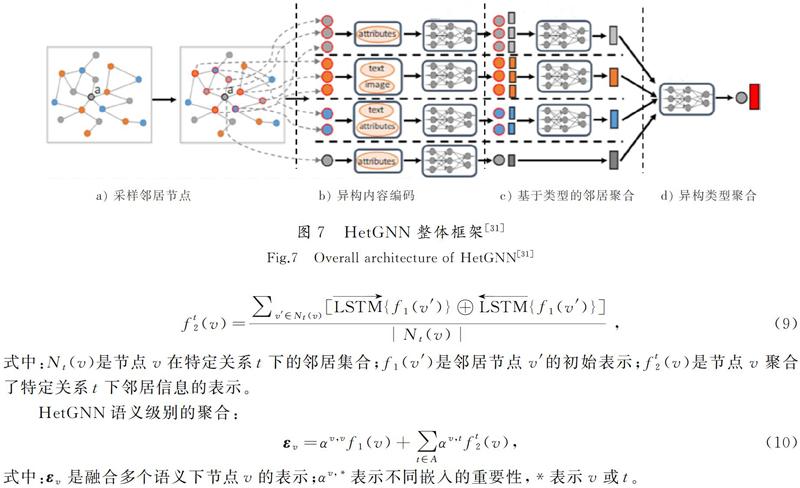

ZHANG等[31]发现很少有网络可以同时考虑异构网络的结构信息以及每个节点的异构内容信息,故提出一种异构图神经网络模型(HetGNN)解决此问题。HetGNN首先引入带有重启策略的随机游走方法为每个节点(见图7中节点a)采样固定长度的异构邻居,然后利用节点异构内容编码器编码节点的异构内容,从而得到节点的初始嵌入表示。

目前大多基于元路径的表示学习方法舍弃了元路径内部的节点信息,只考虑元路径的起始节点和末尾节点,造成信息丢失。为了解决上述问题,FU等[32]提出了MAGNN模型,MAGNN模型框架如图8所示。首先将异构网络的节点属性信息映射到同一个隐层的向量空间,然后使用注意力机制将元路径内部的语义信息纳入考虑,最后使用注意力机制聚合多条元路径信息得到最终的节点表示。

MAGNN节点级别的聚合:

MAGNN将元路径实例中所有节点的特征纳入考虑。

元路径间的聚合即语义级别的聚合,目的是组合所有元路径包含的语义信息。如式(14)所示,MAGNN使用线性转换和一层非线性函数,将节点嵌入映射到所需维度的向量空间。

式中:βP表示各条元路径的重要性;[WTHX]hPAv代表类型为A的节点的最终表示;[WTHX]Wo代表线性转换的权重矩阵。

MAGNN和其他模型在链接预测任务中的性能见表4。由表4可知,MAGNN的性能大大优于其他模型,其中最强大的基础模型是metapath2vec,而MAGNN比metapath2vec得分更高,表明考虑单条元路径是欠佳的。在GNN基准中,HAN获得最佳结果,因为HAN考虑了网络的异质性并结合多条元路径。MAGNN与HAN相比改进了约6%,结果表明元路径的内部信息对节点嵌入至关重要。

2.2.2 基于图卷积网络方法

大多异构网络表示学习方法都需要预先指定元路径, 但需要很强的先验知识,元路径的选择在极大程度上会影响模型的效果。YUN等[33]提出了一种能够生成新的图数据结构的图变换网络(GTNs),旨在解决异构网络分析中如何选取合适元路径的问题。

GTNs模型架构如图9所示,GTNs通过GT层将原始图数据[WTHX]A∈RN×N×|R|转换成新的图数据[WTHX]A(l)∈RN×N×C,然后在新圖数据上进行卷积操作学习有效的节点表示。其中,GT层可以识别原始图数据中未连接节点之间的有用连接,并生成对任务有用的元路径。

1) GTNs节点级别的聚合

GTNs采用GCN的聚合方式.针对第i条元路径,通过聚合得到该元路径下的节点表示为[WTHX]Zi:

2) GTNs语义级别的聚合

将多条元路径下的节点表示拼接起来得到最终节点表示[WTHX]Z:

其中:‖表示连接操作;C代表通道数。

预定义的元路径和通过GTNs模型学习到的排名最高的元路径之间的比较见表5。由表5可知,GTNs模型找到了重要的元路径,这些元路径与按领域知识预先定义的元路径一致。此外,GTNs还发现所有类型节点之间的新的相关元路径。

3 应 用

3.1 常用数据集

众多测试算法性能的数据集见表6,数据集包括3类,分别是引文网络、社交网络和电影数据。对于每个数据集,表中给出了数据集来源,分别统计了该数据集的边的类型、节点数、边数、标签类别数量,是否含有特征以及元路径,方便研究者选择适合模型的数据集。

3.2 开源实现

表7整理了具有代表性模型的开源实现,供研究者快速学习或复现验证模型效果。

3.3 实际应用

异构网络表示学习方法可以应用到许多实际任务中,可以宽泛地将应用分为3类,即节点分类、节点聚类和链接预测。

1) 节点分类 其大多属于半监督的学习任务,即原始数据中给定某些节点对应的类别,通过学习已有标签的数据信息,从而预测没有标签的节点属于哪一个类别。通常先抽取节点的属性或结构特征为节点生成嵌入信息,然后应用逻辑回归等分类器为对应节点预测标签。节点分类应用领域十分广泛。如,在新闻和推特中,对短文本进行分类,帮助用户找到相关信息[34];在社交网络中预测部分用户的标签信息;在生物领域中,对蛋白质生物功能进行标记。最近实验数据[19,31-33]表明,融入属性信息的异构图神经网络模型对节点分类的精度都要高于基础模型metapath2vec,表明利用异构节点特征的GNN架构可以得到更好的嵌入表示,对提高下游任务有很大的帮助。

2) 节点聚类 按照某个特定标准(如距离准则)把一个数据集分割成不同的类或簇,使得同一个簇内的数据对象的相似性尽可能大,同时不在同一个簇中数据对象的差异性也尽可能大。节点聚类算法可以用来为社交网络中的用户自动划分好友分组,为蛋白质网络中的各类蛋白质依照它们之间的联系自动聚类。研究[32]表明,在节点聚类任务中,node2vec[22]优于传统的异构模型[20-21],这是由于node2vec作为一种基于偏随机游走方法,迫使图中靠近的节点在嵌入空间中也靠近[35],从而对节点的位置信息进行编码,同时这个特性也极大促进了K-Means算法的发展。

3) 链接预测 旨在预测网络中丢失的边,或者未来可能会出现的边。在生物领域中,由于目前有很多蛋白质人们都不熟悉,因而实验时间和金钱成本高,需要较准确的预测以降低成本。例如文献[36—40]预测可以发生相互作用的蛋白质,为疾病的发生和大规模的治疗设计提供有价值的见解。链接预测在社交网络也得到广泛应用,例如向用户推荐商品[41-42]或熟人。由表4可知,MAGNN[32]模型在链接预测方面的效果最好,这是由于MAGNN不仅聚合多条元路径的信息还考虑元路径内部的语义信息。

4 总结与展望

现有的异构网络表示学习方法包括基于随机游走方法、基于一阶/二阶相似度方法、基于图注意力网络方法和基于图卷积网络方法4个类别。本文综合比较了方法模型各自的特点,并给出了异构网络表示学习中的经典数据集和常用模型的开源实现项目。

随着社会的不断进步,现实世界网络将变得更加复杂,如何有效聚合网络中丰富的信息辅助表征向量的学习,同时降低模型的复杂度是今后研究的一个方向。基于GNN的异构网络表示学习方法需解决以下问题:

1) 避免预先定义元路径。目前大多数异构网络表示学习方法都需要预先人为定义元路径,需要很强的先验知识且耗费很大的人力。最近提出的GTNs[33]可以识别原始图数据中未连接节点之间的有用连接,自适应地学习到合适长度的元路径,并且实验表明,在节点分类任务上GTNs的效果要优于HAN模型。

2) 适应动态网络。真实世界的网络具有动态性,节点以及节点之间复杂的交互信息无时无刻不在更新,而现有的异构网络表示学习方法大都针对静态网络,设计能够高效融合交互信息的动态异构网络表示方法具有很高的实用价值。

3) 适应大规模复杂信息网络。现实世界的网络有上亿节点,如OAG数据集[43]含有10亿多个节点和连接关系,而现有的异构网络表示学习方法仅适用于小规模数据网络。因此,设计具有可扩展性的方法也是未来研究的一个方向。

参考文献/References:

[1] HAMILTON W, YING Z, LESKOVEC J. Inductive representation learning on large graphs[C]//Advances in Neural Information Processing Systems. Long Beach:NIPS, 2017: 1024-1034.

[2] WANG D, CUI P, ZHU W. Structural deep network embedding[C]//Proceedings of the 22nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York : ACM, 2016: 1225-1234.

[3] BATTAGLIA P, PASCANU R, LAI M, et al.Interaction networks for learning about objects, relations and physics[C]//Advances in Neural Information Processing Systems. Barcelona : NIPS, 2016: 4502-4510.

[4] LI Yaguang, YU R, SHAHABI C, et al. Diffusion Convolutional Recurrent Neural Network: Data-Driven Traffic Forecasting[EB/OL].[2018-02-22]. https://arxiv.org/abs/1707.01926.

[5] ZHANG J, SHI X, XIE J, et al. Gaan: Gated Attention Networks for Learning on Large and Spatiotemporal Graphs[EB/OL].[2018-03-20]. https://arxiv.org/abs/1803.07294.

[6] ATWOOD J, TOWSLEY D. Diffusion-convolutional neural networks[C]//Advances in Neural Information Processing Systems. Barcelona: NIPS, 2016: 1993-2001.

[7] BERG R, KIPF T N, WELLING M. Graph Convolutional Matrix Completion[EB/OL].[2017-10-25].https://arxiv.org/abs/1706.02263.

[8] LU Y, FANG Y, SHI C. Meta-learning on heterogeneous information networks for cold-start recommendation[C]//Proceedings of the 26th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. New York : ACM, 2020: 1563-1573.

[9] ZHANG J, SHI X, ZHAO S, et al. Star-gcn: Stacked and Reconstructed Graph Convolutional Networks for Recommender Systems[EB/OL].[2019-05-27].https://arxiv.org/abs/1905.13129.

[10]SUN Z, DENG Z H, NIE J Y, et al. Rotate: Knowledge Graph Embedding by Relational Rotation in Complex Space[EB/OL].[2019-02-26]. https://arxiv.org/abs/1902.10197.

[11]魯军豪, 许云峰. 信息网络表示学习方法综述[J]. 河北科技大学学报, 2020, 41(2): 133-147.

LU Junhao,XU Yunfeng.A survey of information network representation learning[J].Journal of Hebei University of Science and Technology,2020,41(2):133-147.

[12]涂存超, 杨成, 刘知远, 等. 网络表示学习综述[J]. 中国科学:信息科学, 2017, 47(8): 980-996.

TU Cunchao, YANG Cheng, LIU Zhiyuan, et al. Network representation learning: An overview[J]. Scientia Sinica Informationis, 2017, 47(8): 980-996.

[13]CHANG S, HAN W, TANG J, et al. Heterogeneous network embedding via deep architectures[C]//Proceedings of the 21th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining.New York: ACM, 2015: 119-128.

[14]FU T, LEE W C, LEI Z. HIN2Vec: Explore meta-paths in heterogeneous information networks for representation learning[C]//Proceedings of the 2017 ACM on Conference on Information and Knowledge Management. Singapore: ACM, 2017: 1797-1806.

[15]周慧,趙中英,李超.面向异质信息网络的表示学习方法研究综述[J]. 计算机科学与探索, 2019, 13(7): 1081-1093.

ZHOU Hui, ZHAO Zhongying, LI Chao. Survey on representation learning methods oriented onheterogeneous information networks[J]. Journal of Frontiers of Computer Science and Technology, 2019, 13(7): 1081-1093.

[16]SHI C, LI Y, ZHANG J, et al. A survey of heterogeneous information network analysis[J]. IEEE Transactions on Knowledge and Data Engineering, 2016, 29(1): 17-37.

[17]SUN Y Z, HAN J W, YAN X F, et al. PathSim: Meta path-based top-k similarity search in heterogeneous information networks[J]. Proceedings of the VLDB Endowment, 2011, 4(11): 992-1003.

[18]ZHANG Daokun, YIN Jie, ZHU Xingquan, et al. Network representation learning: A survey[J]. IEEE Transactions on Big Data, 2017.doi:10.1109/TBDATA.2018.2850013.

[19]WANG X, JI H, SHI C, et al. Heterogeneous graph attention network[C]//The World Wide Web Conference. Geneva:WWW, 2019: 2022-2032.

[20]DONG Y, CHAWLA N V, SWAMI A. Metapath2vec: Scalable representation learning for heterogeneous networks[C]//Proceedings of the 23rd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York: ACM, 2017: 135-144.

[21]SHI Chuan, HU Binbin, ZHAO W X, et al. Heterogeneous information network embedding for recommendation[J]. IEEE Transactions on Knowledge and Data Engineering, 2018, 31(2): 357-370.

[22]TANG J, QU M, MEI Q. PTE: Predictive text embedding through large-scale heterogeneous text networks[C]//Proceedings of the 21th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining.New York: ACM, 2015: 1165-1174.

[23]SHI Y, GUI H, ZHU Q, et al. AspEm: Embedding learning by aspects in heterogeneous information networks[C]//Proceedings of the 2018 SIAM International Conference on Data Mining. California: SIAM, 2018: 144-152.

[24]SHI Y, GUI H, GUO F, et al. Easing embedding learning by comprehensive transcription of heterogeneous information networks[C]//Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. New York: ACM, 2018: 2190-2199.

[25]GROVER A, LESKOVEC J. node2vec: Scalable feature learning for networks[C]//Proceedings of the 22nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York: ACM, 2016: 855-864.

[26]HU B, SHI C, ZHAO W X, et al. Leveraging meta-path based context for Top-N recommendation with a neural co-attention model[C]//Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining.New York: ACM, 2018: 1531-1540.

[27]LU Yuanfu, SHI Chuan, HU Linmei, et al. Relation structure-aware heterogeneous information network embedding[J]. IEEE Transactions on Knowledge and Data Engineering, 2019.http://arxiv.org/abs/1905.08027.

[28]HU B, FANG Y, SHI C. Adversarial learning on heterogeneous information networks[C]//Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. New York: ACM, 2019: 120-129.

[29]GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial networks[J]. Advances in Neural Information Processing Systems, 2014, 3: 2672-2680.

[30]TANG J, QU M, WANG M, et al. LINE: Large-scale information network embedding[C]//Proceedings of the 24th International Conference on World Wide Web. Geneva:WWW,2015: 1067-1077.

[31]ZHANG C, SONG D, HUANG C, et al. Heterogeneous graph neural network[C]//Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining.New York: ACM, 2019: 793-803.

[32]FU X, ZHANG J, MENG Z, et al. MAGNN: Metapath aggregated graph neural network for heterogeneous graph embedding[C]//Proceedings of the Web Conference 2020. Geneva: WWW, 2020: 2331-2341.

[33]YUN S, JEONG M, KIM R, et al. Graph transformer networks[C]//Advances in Neural Information Processing Systems. Vancouver: NIPS, 2019: 11983-11993.

[34]HU L, YANG T, SHI C, et al. Heterogeneous graph attention networks for semi-supervised short text classification[C]//Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP). Hong Kong: EMNLP-IJCNLP, 2019: 4823-4832.

[35]YOU Jiaxuan, YING R, LESKOVEC J. Position-Aware Graph Neural Networks[EB/OL].[2019-06-13]. https://arxiv.org/abs/1906.04817.

[36]SHOEMAKER B A, PANCHENKO A R. Deciphering protein-protein interactions. Part I. experimental techniques and databases[J]. Plos Computational Biology, 2007, 3(3): e42.

[37]LI Hang, GONG Xinjun, YU Hua, et al. Deep neural network based predictions of protein interactions using primary sequences[J]. Molecules, 2018, 23(8): 1923.

[38]ZHANG Zhaopeng, RUAN Jishou, GAO Jianzhao, et al. Predicting essential proteins from protein-protein interactions using order statistics[J]. Journal of Theoretical Biology, 2019, 480: 274-283.

[39]LOPAMUDRA D, ANIRBAN M. A classification-based approach to prediction of dengue virus and human protein-protein interactions using amino acid composition and conjoint triad features[C]//2019 IEEE Region 10 Symposium (TENSYMP). Kolkata: IEEE, 2019: 373-378.

[40]BELTRAN J C, VALDEZ P, NAVAL P. Predicting protein-protein interactions based on biological information using extreme gradient boosting[C]//2019 IEEE Conference on Computational Intelligence in Bioinformatics and Computational Biology (CIBCB). Siena:IEEE, 2019: 1-6.

[41]FAN S, ZHU J, HAN X, et al. Metapath-guided heterogeneous graph neural network for intent recommendation[C]//Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. New York: ACM ,2019: 2478-2486.

[42]FAN W, MA Y, LI Q, et al. Graph neural networks for social recommendation[C]//The World Wide Web Conference. New York: ACM , 2019: 417-426.

[43] HU Z, DONG Y, WANG K, et al. Heterogeneous graph transformer[C]//Proceedings of the Web Conference. New York: ACM, 2020: 2704-2710.