基于可控方向值方图算法的掌纹图像特征提取技术

【摘要】采用多通滤波检测器实现对掌纹图像的特征信息采集,对采集的掌纹图像进行不同层次的特征信息分割,通过深层特征提取方法实现对掌纹图像特征融合处理。构建掌纹图像的可控方向值二维融合调度模型,结合多维多视角图像的分割先验知识,建立掌纹图像特征提取的可控方向值方图;分析掌纹图像的浅层特征信息和深层特征信息,对各层特征信息实现信息融合;利用可控方向值方图融合算法实现对掌纹图像特征提取和识别优化。仿真结果表明,采用该方法进行掌纹图像特征提取的精度较高、误分率较小,提高了对掌纹图像的识别和检测能力。

【关键词】可控方向值方图;掌纹图像;特征提取;图像分割

〔中图分类号〕TP391 〔文献标识码〕A 〔文章编号〕1674-3229(202004- 0024一05

0 引言

掌纹同指纹一样,都是人体的重要生物特征。随着图像处理技术的发展,利用智能图像特征分析方法提取人体的生物特征信息,完成图像特征的提取和有效的数据融合,全面地将个体特征提供给识别系统,实现了特征提取技术在身份鉴定和辨识等领域的广泛应用[1]。

对掌纹图像特征提取的传统方法主要有模糊信息处理法、基于支持向量机学习法以及基于图像分割的特征提取方法等,构建掌纹图像特征提取的图模型结构,通过二维和三维空间分布式重构,实现掌纹图像特征提取。传统方法进行特征提取的适应度不高、精度不好[2-4]。

针对上述问题,本文引入可控方向值方图算法提取掌纹图像特征,在掌纹图像特征(边缘轮廓等)的分割处理上采用深层特征融合,结合多维多视角图像分割构建可控方向值二维融合调度模型,从而实现掌纹图像特征的提取。

1 掌纹图像采集和分割预处理

1.1 掌纹图像采集模型

结合小波多尺度分解[5]方法实现掌纹图像中关键特征分解重构,并用矢量量化图像的小波变换系统,采用图像编码技术,构建掌纹图像的特征提取模型,如图1所示。

图1 掌纹图像特征提取模型

根据图1所示的掌纹图像特征提取模型,采用特征图的细化操作方法,获得掌纹的纹理特征信息,根据掌纹图像的纹理分布的字典集[6],采用迭代深层特征信息融合的方法,得到掌纹图像特征提取的纹理字典集为:

其中,f为掌纹图像特征参数,△g为深层提取的特征信息参数,y(j)为构造特征图信息融合参数模型,通过学习图像块的数据特征得到掌纹信息增强的寻优模型描述为:

其中,pi(t)为掌纹的语义相关性融合特征函数,△p(t)为语义分割网络分布的结构特性,采用多层网络结构分析的方法,得到输出的zi(t),zj(t)表示掌纹图像的特征提取视觉分布点,采用空间区域映射和线性融合的方法,得到掌纹图像的多层次纹理分布结果为:

其中,hn为提取掌纹的纹理稀疏特征分量,采集的掌纹图像进行不同层次的特征信息分割,采用深层特征提取方法实现纹理信息衍射分析,提高掌纹图像的识别能力[7]。

1.2 掌纹图像分割

采用深层特征融合完成掌纹图像的分割处理,采用边缘轮廓提取方法构建掌纹图像的超维信息特征分割模型,通过三维信息空间重构,进行掌纹图像的信息增强处理[8],提取掌紋图像的稀疏性特征解集,通过模糊度寻优,得到掌纹图像的自相关特征匹配模型为:

其中,df为掌纹图像的稀疏度融合特征分量,dfi,j为掌纹图像的超分辨融合分布系数,以像素点j为中心进行掌纹图像的小波多尺度融合和线性分割。初始化掌纹图像的纹理特征点,对于每个掌纹图像的特征点K的近邻点[9],得到掌纹纹理融合解析控制函数为:

其中,i为掌纹图像的纹理信息分割的阈值,R为一个规范常量,sj为掌纹图像的多维特征空间融合系数,gi为掌纹图像边缘特征子集,通过离散线性序列融合[10],得到掌纹图像深度学习的纹理映射特征分布函数为:

其中,k(a)为掌纹图像特征提取的子空间映射函数,构建掌纹的模板匹配模型,根据线性分割结果,得到掌纹图像的边缘轮廓子集,得到子集信息分量为:

其中,гv为掌纹匹配模型参数,lx为纹理分布函数值,构建掌纹图像的深层次纹理映射模型,提高掌纹图像的信息融合和特征辨识能力[11]。

2 掌纹图像特征提取优化

2.1 掌纹图像可控方向值二维融合

构建掌纹图像的可控方向值二维融合调度模型,结合多维多视角图像分割的先验知识,建立掌纹图像特征提取的可控方向值方图,采用平衡语义标签分布插值运算的方法[12],得到掌纹图像的可控方向值分布维数为m,在掌纹数据库中采用线性匹配滤波检测的方法,得到掌纹图像的可控方向下的纹理分布序列为Aj(j=1,2,…,n),d=[d1d2…dn]表示掌纹图像可控方向值的差异度,dj≥0,∑j=1dj=1,dj表示掌纹图像可控的相似度分布距离,结合光流信息检测的方法,得到掌纹分布序列模板匹配输出为:

选择直方图模板匹配方法,得到掌纹的可控方向值方图为:

p(v)=Jc+Ω(X)+U(9)

其中,Jc为可控方向值方图的模糊度函数,Ω(X)是融合光流场检测增强系数,采用空间区域模型动态切换的方法,提取掌纹图像的相似度信息,得到T次迭代后的模糊度系数,得出掌纹图像可控模糊参数为:

其中,J(x)为掌纹图像的目标直方图重建系数,I(x)为掌纹分布的光流场幅度图。根据上述分析,构建掌纹图像可控方向值二维融合模型[13]。

2.2 掌纹图像特征提取输出

采用相似性区域合并的方法,构建掌纹图像可控方向的Kalman滤波分析模型,结合区域等效直方图分析方法[14],得到掌纹图像的稀疏特征点用I(i,j)描述,得到目标模板I(k)(i,j)表示如下:

其中,k表示出区域等效直方图的等效区域控制系数,采用邻域加权控制的方法,得到掌纹图像可控方向的分层特征提取输出为:

M=I(K)(i,j)+d(z)+he(12)

其中,d(z)为掌纹图像的灰度特征分布参数,he为当前处理区域函数,对每个窗口的直方图实现加权控制,结合纹理稳态识别的方法,得到模板匹配的差异度函数为:

其中,hk、gk代表图像融合和滤波系数,若Xi为原始掌纹纹理线性分布序列,yi、zi分别为掌纹特征融合系数,其面积为Ai。根据匹配模板直方图分析和线性跟踪识别,得到掌纹图像的特征提取输出的迭代函数为:

zd=rw+(gy+ge)(14)

其中,rw为掌纹图像特征提取的可控方向值方图参数,gy,ge为掌纹图像的浅层特征信息和深层特征信息,采用线性特征序列加权控制的方法[15],实现掌纹图像加权稳定性控制,在最佳特征匹配下,得到掌纹图像的边缘特征提取输出为:

Φ=zd+(λ+v)+cn(15)

其中,掌纹图像的边缘信息加权系数λ,v均为常数,且λ>0,cn为输出的控制权系数,掌纹图像的特征提取的分布面积为:

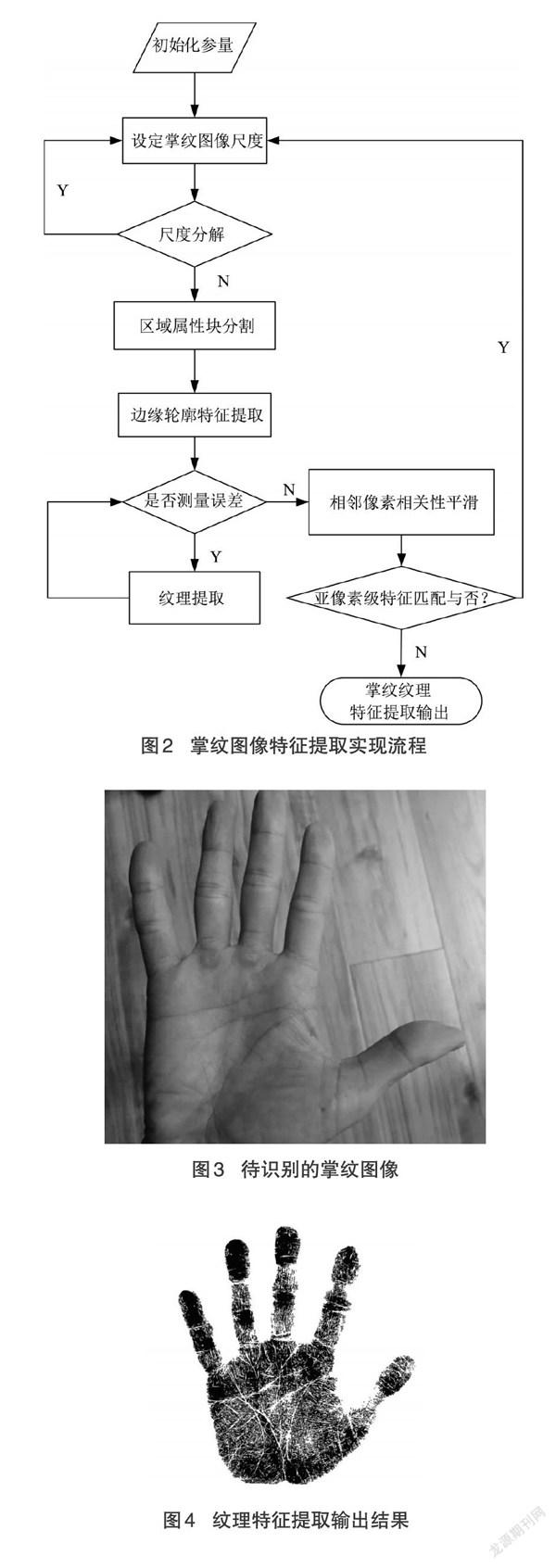

其中,I(s)為掌纹图像的灰度直方图,vr是符号函数,Gσ是误差系数,综上分析,采用可控方向值方图融合算法,实现对掌纹图像特征提取和识别优化[16]。实现流程如图2所示。

3 仿真测试

为了验证本文方法提取掌纹特征的应用性能,采用Matlab进行掌纹特征提取算法的仿真测试分析,掌纹的采集样本数为1200,掌纹纹理特征分布的训练集规模为500,模板匹配系数为0.38,掌纹纹理的相似度系数为0.014,得到待识别的掌纹图像如图3所示。

图3为待识别的掌纹图像,得到的掌纹图像纹理特征提取结果输出如图4所示。

图2 掌纹图像特征提取实现流程

图3 待识别的掌纹图像

图4 纹理特征提取输出结果

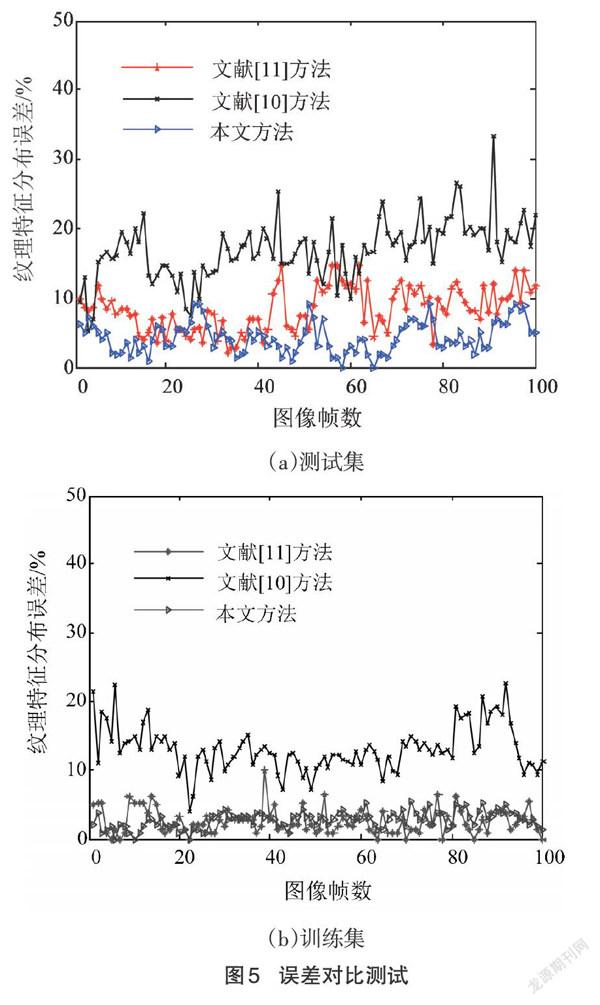

分析图4可知,本文方法能有效实现掌纹图像的纹理特征提取,特征聚类性较好。为进一步验证本文方法的应用性能,对比本文方法和文献[10]中改进的掌纹特征提取方法、文献[11]中基于形态学滤波和邻域搜索的掌纹提取方法,测试掌纹特征提取纹理分布误差,结果如图5所示。

图5 误差对比测试

分析上述仿真结果可知,用本文方法进行掌纹图像特征提取和识别,误差较小,且波动振荡性低于传统方法。

4 结语

为了利用特征分布的差异性实现人体生物特征编码识别,有效提取方向特征的稳定性信息,本文提出基于可控方向值方图算法的掌纹图像特征提取技术。基于小波变换的矢量量化方法,使其在图像分析和处理等方面的优异性得到体现。仿真测试结果表明,本文方法对掌纹图像特征提取的聚类性较好,识别误差较低。

[参考文献]

[1]何正义,曾宪华,郭姜.一种集成卷积神经网络和深信网的步态识别与模拟方法[J].山东大学学报(工学版),2018,48(3):88-95.

[2]郭伟,邢宇哲,曲海成.高置信度互补学习的实时目标跟踪[J].中国图象图形学报,2019,24(8):1315-1326.

[3]吴明珠,陈瑛,李兴民.基于Stein-Weiss函数的彩色掌纹特征识别算法[J].计算机应用研究,2020,37 (4):322-326.

[4]WU Y,LIM J,YANGM H.Object tracking benchmark[J].IEEE Transactions on Pattern Analysis and Machine Intelli-gence,2015,37(9):1834-1848.

[5]周友行,刘汉江,赵晗妘,等.基于像元相互关系的FCM聚类分割算法[J].仪器仪表学报,2019,40(9):124-131.

[6]余祥伟,薛东剑,陈凤娇.融合多尺度边缘检测的小波贝叶斯SAR图像滤波[J].遥感信息,2019,34(5):120-125.

[7]姚启芳.基于模糊聚类的养生旅游资源信息检索方法[J].廊坊师范学院学报(自然科学版),2020,20(1):81-85.

[8]窦方正,孙汉昌,孙显,等.基于DBN与对象融合的遥感图像变化检测方法[J].计算机工程,2018,44 (4):294-298+304.

[9]孙佳美,吴成茂.正则化图形模糊聚类及鲁棒分割算法[J].计算机工程与应用,2019,55(11):179-186.

[10]滕少华,罗江,费伦科一种改进的掌纹线方向特征提取方法[J].江西师范大学学报(自然科学版),2018,42(3):311-316.

[11]李海燕,潘培哲,唐一吟,等.基于形态学滤波和邻域搜索的掌纹主线提取方法[J].计算机应用与软件,2018,35(8):254-259.

[12]蔡俊,赵超,沈晓波,等.基于卷积神经网络的Canny算法优化[J].廊坊师范学院学报(自然科学版),2019,19(4):23-26+44.

[13]李俊杰,高翠芳,黄芳.墓于优化采样支持向量机的指纹二值化方法[J].东北师大学报(自然科学版),2018,50(4):59-65.

[14]刘炳初,赵越岭,王浩,等.智能考勤系统的设计[J].辽宁工业大学学报(自然科学版),2018,38(6):364-367.

[15]刘珍珍,刘云清,颜飞.指纹图像干湿度评价及亮度自动调节方法研究[J].长春理工大学学报(自然科学版),2018,41(5):83-87.

[16]杜柏圣.卷积网络的无监督特征提取对人脸识别的研究[J].计算机技术与发展,2018,28(6):17-20.

[收稿日期]2021-07-09

[基金项目]福建省教育厅中青年科技项目(JAT191931)

[作者简介]胡海锋(1972-),男,硕士,闽西职业技术学院信息与制造学院副教授,研究方向:计算机科学。