一种多模态与多尺度的废弃物目标分割算法

汪 涛

(1.闽江学院计算机与控制工程学院,福建 福州 350108;2.福建省信息处理与智能控制重点实验室(闽江学院), 福建 福州 350108)

0 引 言

近年来,我国的生活垃圾清运量以每年约5%的速度持续增长,截至2018年底已达到2.28亿t[1]。伴随着世界各国对垃圾分类的大力倡导,国内外研究者提出了一系列基于计算机视觉的智能化垃圾分类、检测与分割算法[2-6]。垃圾废弃物分割指的是在给定的输入图像中,通过算法自动将图像中的每个像素根据其语义类别是否属于垃圾进行分类[7]。除语义分割外,还可对每个垃圾物体实例进行检测和分割[8]。由于垃圾废弃物在家庭、办公室和校园等不同环境中随处可见,基于图像的垃圾废弃物目标分割在智能机器人抓取、物体三维姿态估计、基于内容的图像检索等场景下有着广泛的应用。然而,与一般物体相比,垃圾废弃物分割有其特殊性和难度。首先,垃圾废弃物往往是不完整或污损的,因此其表观特征的变化较一般物体更大。要判断一个物品是否是垃圾,往往存在一定的歧义性,需要结合图像中的空间上下文才能准确预测。例如,一节5号电池放在桌上时一般是有用的,但扔在地上时很可能就是垃圾。因此,本文提出一种基于多模态RGBD[9]特征与多尺度支持向量机[10]的废弃物目标分割算法。首先,基于RGBD相机所拍摄的深度图像,可提取关于场景和物体间空间几何关系的深度特征,作为表观特征的补充。在表观特征变化较大,因而导致算法准确率降低的情况下尤为有用。其次,对图像进行多尺度的超像素过分割,并在不同尺度下训练基于样本学习的分类器,可以更好地融合图像中的空间上下文信息。粗尺度下,分类器主要学习物体与场景的整体空间布局关系;细尺度下,分类器主要学习如何还原物体的精细边缘轮廓形状。由于垃圾废弃物的定义较为宽泛,其物理尺寸也大小各异。训练多尺度下的分割算法,可对不同大小的垃圾物体都有较好的分割效果。

近年来,基于计算机视觉的智能化垃圾分类、检测、分割等技术受到了研究人员广泛关注。例如,Yang和Thung所提出的TrashNet数据集是在图像垃圾分类问题上最早提出的数据集之一[2],作者比较了支持向量机与类AlexNet卷积神经网络[11]在垃圾分类问题上的性能。Rad等人提出了一种基于OverFeat[12]的街道垃圾检测算法[4]。Bai等人提出了一种基于深度学习的草地垃圾检测算法[5]。上述方法均不涉及输出更加精细的目标分割任务。在废弃物目标分割方面,浙江工业大学的张剑华等人提出在RGBD多模态数据中基于自适应投影与深度学习的固体废物分割算法[6,13]。本文采用的闽江学院垃圾废弃物数据集[7]中,废弃物目标表观特征变化更大,图像背景也更加复杂。

在图像语义分割领域,基于深度学习的算法已成为主流。其中最有代表性的工作是UC Berkeley的Long等人提出的全卷积网络[14]。在此基础上,人们提出了各种网络设计,以提高全卷积网络学习图像空间上下文的能力,以及输出形状细节的精细程度,如Zhao等人提出的金字塔场景解析网络PSPNet[15]与Chen等人提出的深度标记DeepLab算法等[16]。卷积神经网络对部署的硬件环境要求较高,在没有GPU的运算环境下预测效率偏低。本文算法采用基于超像素与支持向量机分类器的技术路线[17],不仅模型的训练速度更快,还可在仅使用CPU的运算环境下达到接近实时的预测效率。

1 算法模型设计

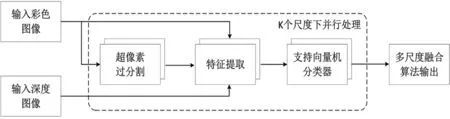

根据基于超像素与样本学习的图像分割算法基本流程[17],设计一个由超像素过分割、特征提取、支持向量机分类器在多尺度下同时处理输入的彩色与深度图像的算法模型,结构如图1所示。该算法的主要特点是在多尺度下并行处理,并通过逐像素加权求和的方式融合不同尺度下的目标分割结果。彩色图像同时用于生成超像素与提取表观特征,深度图像用于提取深度特征。生成超像素并提取特征后,可采用任何基于监督或非监督学习的分类器对每个超像素进行分类。因支持向量机分类器训练简单、模型简洁、预测效率高,本文采用支持向量机作为分类器。

图1 算法模型框架图

1.1 问题描述与数据预处理

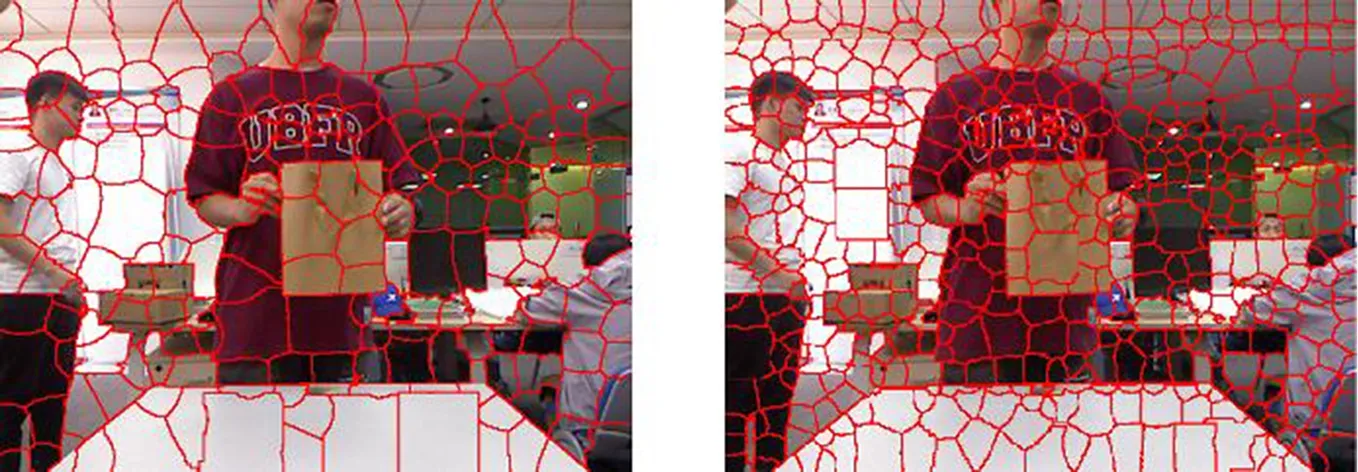

图2 使用SLIC算法设置超像素个数为200(左)和500(右)时的过分割结果

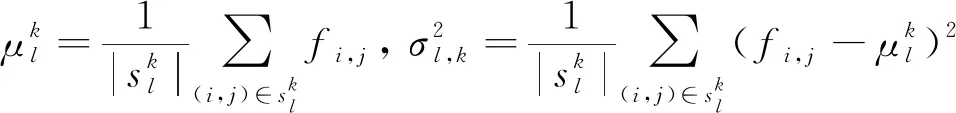

1.2 多模态特征提取

(1)

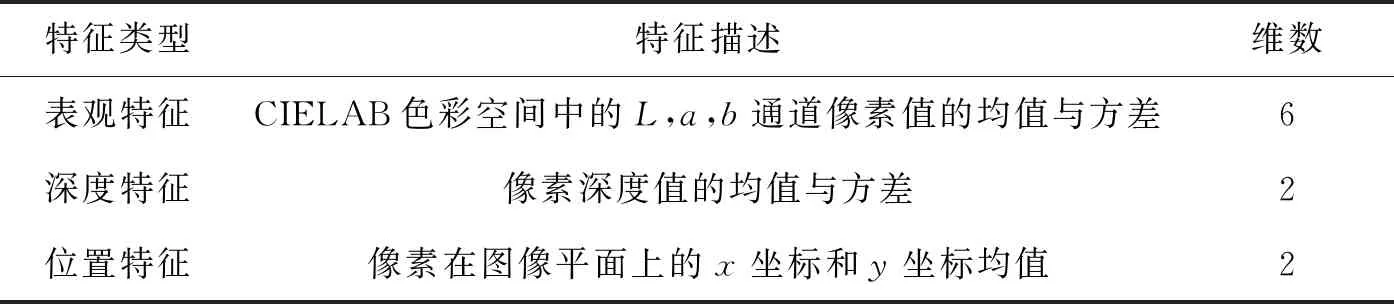

表1 超像素特征

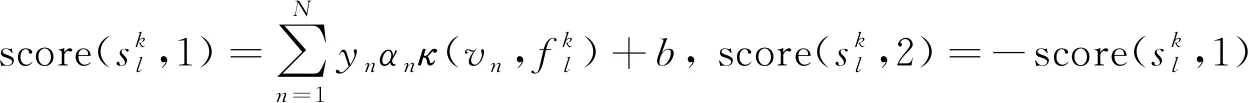

1.3 基于多尺度支持向量机的目标分割

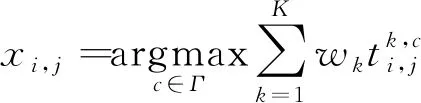

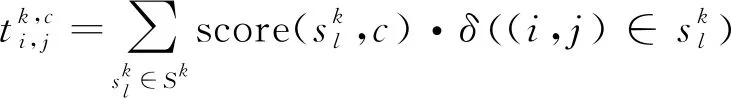

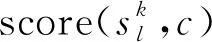

可采用任意基于样本学习的分类器作为超像素分类器。同时,对不同尺度下的超像素分类预测结果进行融合。具体而言,将全图的目标分割结果x在像素(i,j)位置上的值记为xi,j,则xi,j应根据式(2)由多尺度融合得到:

(2)

(3)

(4)

其中,vn为训练集特征中的支持向量,N为支持向量的个数,αn和yn∈{1,-1}分别为该支持向量的对偶系数与真实类别标签,b为偏置系数,κ(v,v')=exp(-γ||v-v'||2)为径向基函数,γ>0是其参数。当类别数C>2时,可使用一对一或一对多策略[19]获得置信分数。

2 实验结果及分析

2.1 实验数据集

为验证本文提出目标分割算法的有效性与训练、预测效率,在闽江学院垃圾废弃物(MJU-Waste)数据集上测试方法性能。MJU-Waste数据集包含垃圾废弃物和背景2个语义类别标签,总计2 475幅分辨率为640×480的彩色图像与其所对应的深度图像。据作者所知,该数据集是目前唯一公开发布的RGBD垃圾废弃物分割数据集。数据集在实验室场景下使用Microsoft Kinect RGBD相机[9]拍摄,每幅图像中都有采集者手持垃圾废弃物,握持的姿势随意。每幅图像中平均有1.02个废弃物,废弃物都是在闽江学院校园内收集的,主要包括快递包装、塑料袋、饮料瓶、餐盒、废旧生活用品等,部分物品如图3所示。完整的数据集可从网上下载[7]。本文采用该数据集提供的训练、验证与测试集,分别包含1 485、248和742幅图像。

图3 闽江学院垃圾废弃物(MJU-Waste)数据集中的废弃物示例

2.2 评价指标

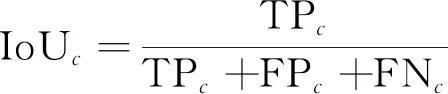

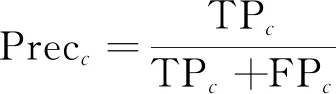

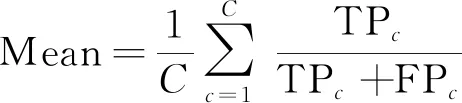

沿用当前通用的图像语义分割方法[14-16]中的设定,实验采用如下评价指标:废弃物类别交并比(IoU)、废弃物和背景类别的平均交并比(mIoU)、废弃物类别像素精确度(prec)与平均像素精确度(mean)。用TP、FP和FN分别表示真正类(true positives)、假正类(false positives)和假负类(false negatives)像素数,则上述指标可表示为:

1)类别交并比。类别c的交并比定义为该类别模型预测与真实标注的交集像素数除以并集像素数,由式(5)给出:

(5)

2)平均交并比。平均交并比是C个类别的交并比的平均值,由式(6)给出:

(6)

3)类别像素精确度。类别c的像素精确度为该类别的模型预测中正确的像素比例,由式(7)给出:

(7)

4)平均像素精确度。平均像素精确度是C个类别的像素精确度的平均值,由式(8)给出:

(8)

由于目标分割问题中的背景像素数通常占多数,因此上述指标中IoU和Prec对错分类的像素较mIoU和Mean更敏感,指标值更低,也能更好地反映前景目标的分割效果。

2.3 实验结果

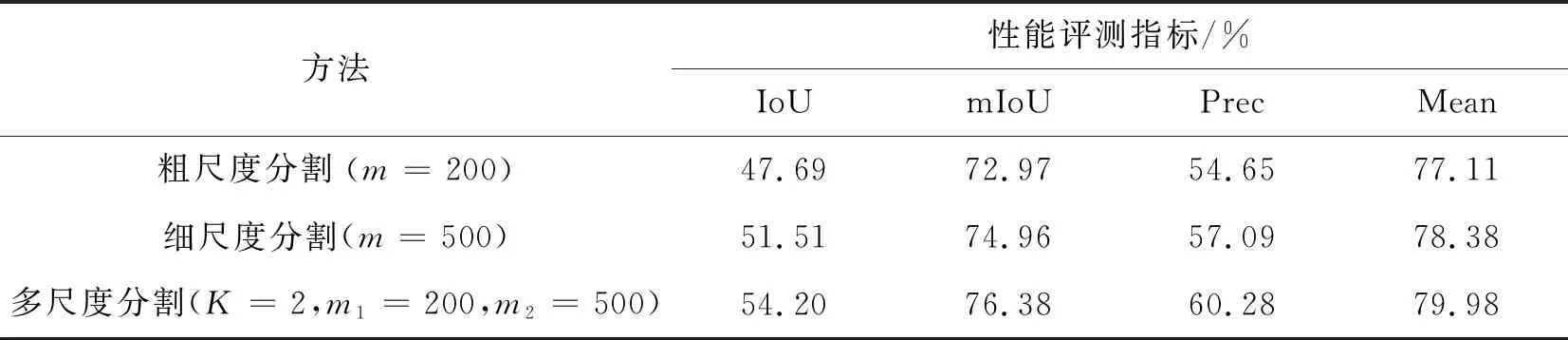

表2给出本文算法在单尺度和多尺度下进行目标分割的性能指标对比。其中,单尺度分割分别选取了使用SLIC算法设置超像素个数m为200和500时的结果。超像素个数为200对应粗尺度分割结果,超像素个数为500对应细尺度分割结果。多尺度分割则将上述两种分割结果进行融合。相比在单尺度下进行目标分割,多尺度分割中反映前景目标分割效果的IoU和Prec均有显著提高,分别比单尺度下性能较优的细尺度分割提高2.69%和3.19%。同时反映前景和背景分割效果的mIoU和Mean也分别提高1.42%和1.60%。

表2 单尺度和多尺度分割的性能比较

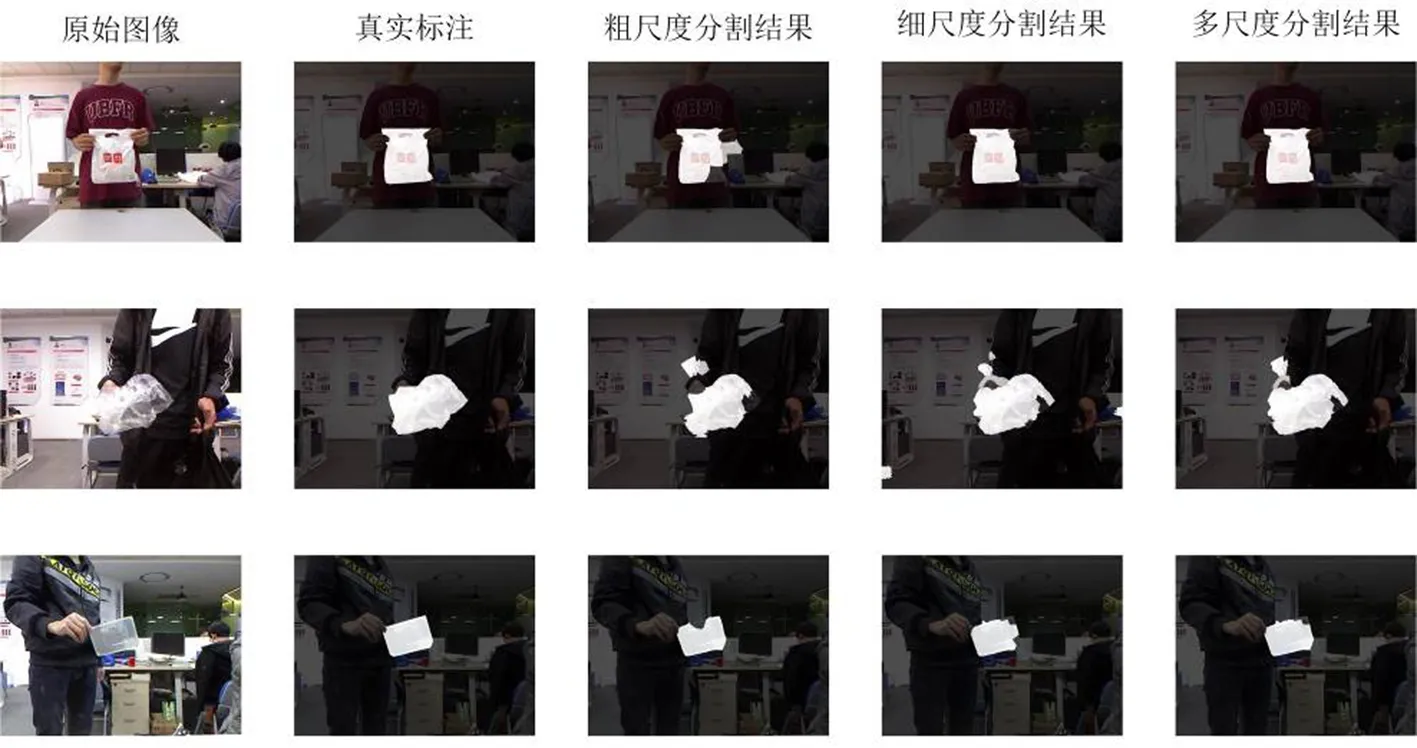

为直观比较单尺度和多尺度分割的性能差异,图4展示了数据集中部分图像采用粗尺度分割(m=200)、细尺度分割(m=500)和多尺度分割(K=2,m1=200,m2=500)的结果。图中可见,粗尺度分割时因超像素面积较大,在刻画物体形状细节上的效果较差。细尺度分割在一定程度上缓解了这一问题,但由于超像素的面积较小,无法获取较大图像区域内的空间上下文信息,因此在远离废弃物区域出现了一些错分类。多尺度分割既能较好地获取图像的空间上下文信息,又能较准确地还原物体的边缘轮廓形状,因此取得了较好的分割效果。

图4 单尺度和多尺度分割的结果比较

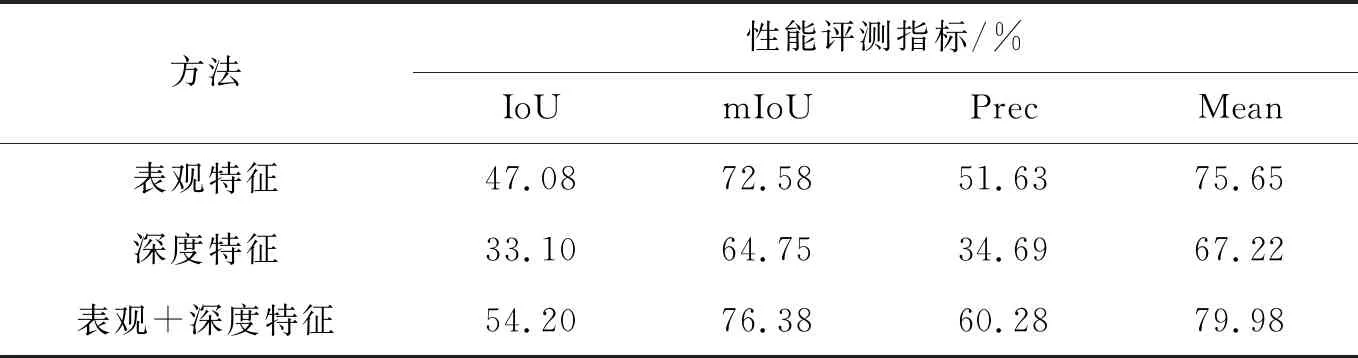

为了解深度特征对目标分割性能指标的影响,表3给出了单独提取表观特征、单独提取深度特征与同时提取表观和深度特征3种情况下的算法模型性能比较。单独提取深度特征时并不能得到比表观特征更好的效果,其主要原因是深度特征所包含的信息相对单一。然而,深度特征中所包含的立体几何信息能对表观特征起到补充作用。因此,同时提取表观与深度特征时,算法的性能最优。其中,IoU和Prec较单独提取表观特征时分别显著提高了7.12%和8.65%,mIoU和Mean也提高了3.80%和4.33%。

表3 表观特征与深度特征对算法性能的影响

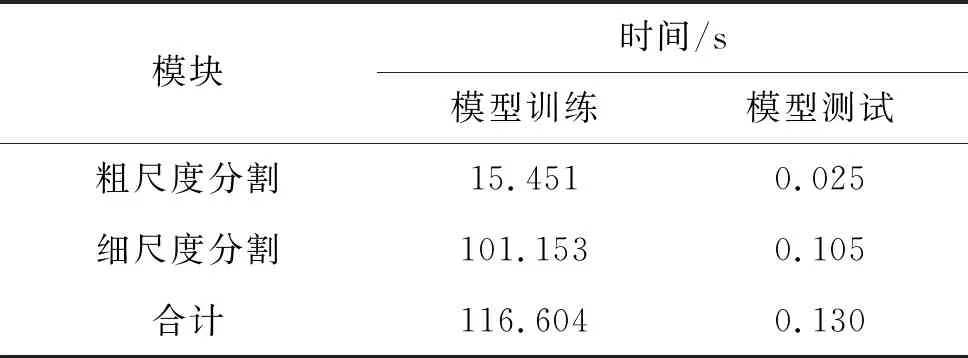

本文算法的训练和部署时间开销均不高。虽然基于卷积神经网络的方法能取得更好的分割效果[7],但其训练时间通常需要数小时以上,且部署环境需要GPU才可能有较高的预测效率。表4列出了本文算法的模型训练与测试开销。算法通过MATLAB软件进行仿真,并未进行特别优化。测试环境的计算机配置为i9-9900ks 4.00GHz CPU,64GB DDR4内存。使用MJU-Waste数据集的1 485幅图像进行训练时,粗尺度和细尺度分割模型的训练时间分别仅需约15 s、约101 s,未经压缩的模型大小分别为3.6 MB与8.6 MB。由于模型测试时,粗尺度和细尺度分割可并行计算,因此本文算法与单独进行相对较慢的细尺度分割相比,在多核心CPU上并不会显著增加模型测试开销。表4列出的时间不包含超像素过分割的开销,如配合快速SLIC算法[20](20 ms,50 fps),以速度较慢的细尺度分割105 ms加上超像素分割所需的约20 ms,本文算法可在仅使用CPU的运算环境下基本实现接近实时运算(125 ms,8 fps)。如需进一步降低运算开销,可通过灵活控制超像素个数,牺牲部分性能来实现。

表4 模型训练与预测的运算开销

3 结语

本文提出一种基于多模态特征与多尺度支持向量机的废弃物目标分割方法。该方法首先对输入的彩色图像进行不同尺度下的超像素过分割,然后在每个超像素上提取表观和深度特征,并训练支持向量机作为超像素分类器。实验表明,多尺度下模型的目标分割性能明显优于单尺度下的性能。本文方法分割准确率较高,训练和部署要求低,并有较好的实时性。