基于多级深度网络的高清晰度红外电子变倍算法*

杨 明,王 璇,高宏伟,2

(1 北华航天工业学院双创中心, 河北廊坊 065000;2 榆林学院现代设计与先进制造技术研究中心, 陕西榆林 719000)

0 引言

现有的红外制导武器大都采用“发射前锁定,发射后不管”模式,发射前操作手锁定目标精度的高低将直接影响最终武器系统命中目标的精度[1]。为了降低操作手的捕获误差,往往通过加强操作手捕控操作训练,提高操控的熟练程度以及对目标区域的熟悉程度。提高捕控精度,虽然能在一定程度上减小操作手的捕控误差,但该方法十分依赖操作手的经验与技术,而且还存在主观性强、重复性低、效率低下等缺点。

为了提升弱小区域的显示质量,目前装备大多采用多视场光学变焦和数码变焦两种设计模式进行变倍。前者是通过大视场捕获目标,小视场瞄准跟踪目标,但这无疑增加了光学系统设计复杂性,以及加工装调难度,无法满足现有导引头小型化、模块化、低成本的设计要求;后者则是通过相应的软件算法设计对低分辨图像进行超分辨重建,估计出相应的高分辨图像。可以看出,采用超分辨重建电子变倍提升图像质量是目前最经济可行的方案,然而目前武器装备的电子变焦功能大多采用插值放大,虽然一定程度上放大了目标区域的尺寸,但并不能提供纹理清晰的高分辨图像[2]。

基于插值的方法假设像素的灰度值是连续变化的,并利用邻近像素的灰度值计算待插值像素的灰度值,该方法简单易行,但重建图像高频信息缺失,图像过于模糊。基于学习的超分辨重建算法则是通过算法模型学习出先验知识,如稀疏特征、邻域嵌入、低秩等进行特征学习[3]。由于图像先验知识依赖于实际问题的约束,所以基于知识重建的方法鲁棒性不高。

近年来,以卷积神经网络为代表的深度网络强调模型的深度,通过将低层次特征进行逐层组合优化,获得更加抽象的高层次特征,增强目标模型的表征能力,如VGG、ResNet等[4]都极大地提升了单帧图像超分辨率重建的效果,然而大多数深度学习方法都没有充分利用图像局部特征,且硬件资源有限,很难通过简单的增加网络深度的策略提高重建图像质量[5]。

为了让卷积神经网络更好的胜任红外导引头或光电跟踪系统电子变倍任务,适应现代战争对精确打击与远程攻击能力的要求,文中重新设计卷积神经网络的结构,通过将低层次特征和高层次特征聚合连接形成新的特征,并采用双参数损失函数来优化训练深度网络,提高网络模型的泛化能力。仿真实验与挂飞验证结果表明,文中所提出的电子变倍方法能够生成具有丰富细节而清晰的高分辨红外图像,增强了目标锁定的精度。

1 深度残差网络

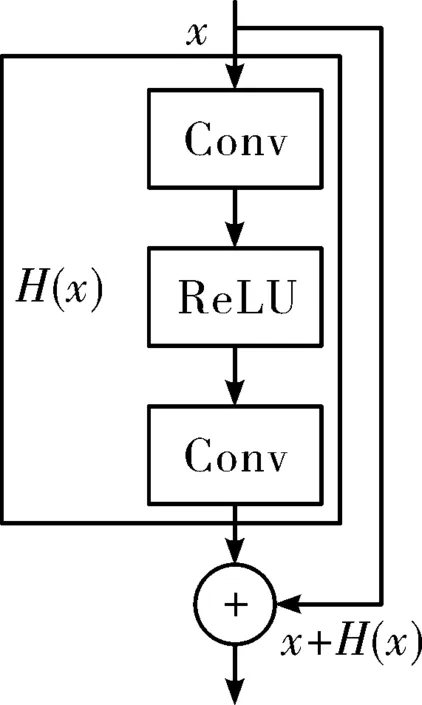

众所周知,理论上深度模型网络越深,其表达能力越强,能处理的训练数据也更多;实际上,网络越深,其优化过程越困难,误差回传会导致梯度消失问题[5]。为了解决网络越深精度迅速退化的问题,He等提出了深度残差网络(deep residual network resnet)[6],其模型结构如图1所示,其中Conv与ReLU分别表示卷积算子与线性整流函数。假定xl与yl分别表示第l层的输入与输出;网络恒等映射函数为H(xl);f(yl)为相应激活函数,可以得到:

图1 恒等映射

(1)

若模型为恒等映射,其f(yl)=yl,H(xl)=xl,代入式(1)可以看出:

xl+1=xl+F(xl,wl)

(2)

因此,递归推导可以得到第L层的输出结果,如式(3)所示。

(3)

若l=0,则x0表示模型中第一层的输入原始信号。可以看出,第L层的输出结果则是所有层的残差之和,即多级联网络进行堆叠而成。当采用反向传播优化求解时,其代价函数可以表示为:

2 多层次特征耦合网络

虽然深度残差网络可以利用恒等映射提升网络的深度,提高深度特征的表征能力。但对于硬件余量有限的武器装备,提升深度将增加网络复杂度,很难通过简单增加网络深度的策略提高重建图像质量。由于图像的低层次局部特征具有丰富细节信息,深度特征具有较强的结构表征能力[7]。因此,文中提出了一种多层次特征耦合网络,通过将低层次特征和高层次特征聚合连接形成新的特征,并采用双参数损失函数来优化训练深度网络,提高网络模型的泛化能力。

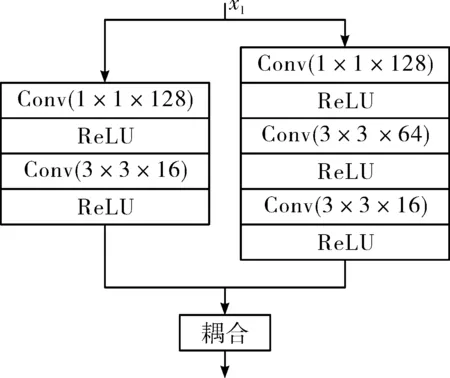

2.1 特征耦合模块

特征耦合能增加模块间的依赖性,降低模块独立性,提升目标的表征能力[8]。为了学习到图像中更丰富的深层次特征,文中采用特征耦合将网络的低分辨特征与深度特征进行融合,并采用一个跨连接操作将低层次特征与高层次特征以端到端用多层的方式级联起来,然后输入到上采样模块,其子网络模块如图2所示,该模块设计的耦合操作由两个不同层次的特征获取最优特征表示,采用1×1卷积层实现不同层次特征交互和信息整合,并采用3×3卷积核对不同维度下的特征进行计算,增加网络的深度,以提取更多的区域细节。

图2 特征耦合

直接对原始低分辨图像进行多层卷积,上采样模块实现了多层次卷积特征图的融合,经过多个卷积层后,得到r2个特征图,其中r表示超分辨放大倍率。通过将各像素对应的r2通道的特征排列成r×r的子图像,经像素重整模块得到大小为rH×rW的高分辨图像。该策略不直接对多特征图上采样映射,而是通过逐层学习挖掘深度特征,具有很高的效率和表征能力。

为了增强模型对复杂背景下目标区域的表征能力,多层次耦合子模块经过次级联构成了深度网络的基本模型架构。然后针对稠密卷积神经网络结构的思想,采用1×1卷积层连接3×3卷积层结构,作为子块的基准结构,并且每个卷积层都采用ReLU作为激活函数;在基准结构的基础上,增加一个3×3卷积层,作为子块结构的改进结构;最后,将子块结构的基准结构和改进结构在特征图通道维度进行堆叠,作为子块结构的融合结构。

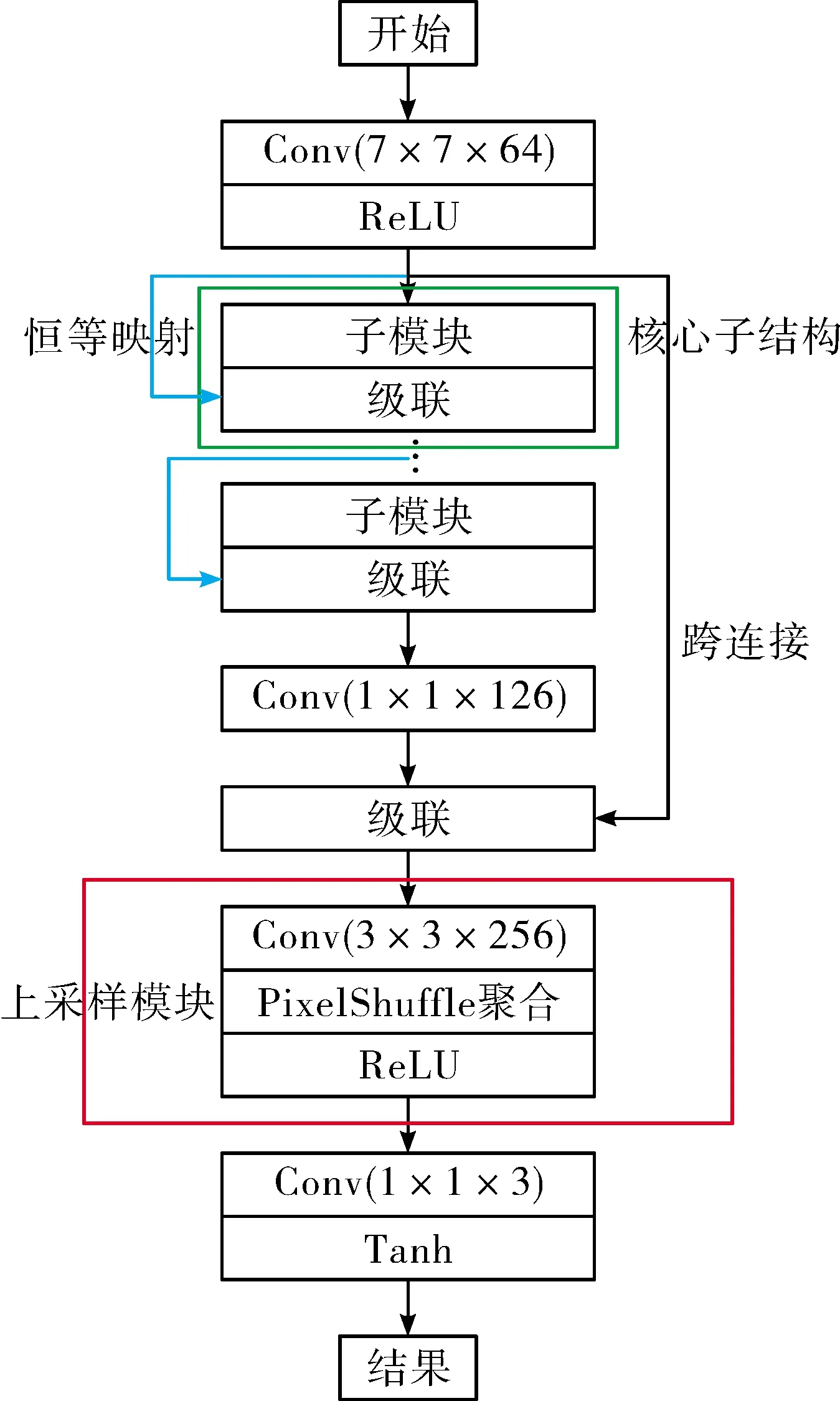

2.2 基于多级深度网络的电子变倍架构

低层次特征主要由局部特征组成,如边缘、轮廓和角点等,在区域描述上良好的旋转不变性和灰度不变性,以及较强的可解释性,有利于电子变倍任务[9]。深度特征则强调了模型结构的深度,而且更突出特征学习的重要性。通过逐层特征变换,挖掘数据丰富的内在信息。但深度增加会加大模型复杂度。因此提出的耦合策略,在不提升深度的情况下增强模型表征能力,其网络结构如图3所示。该网络将图2所示的子模块进行堆叠,通过恒等映射连接,确保了低层次特征能用于超分辨重建,从而使得网络完全融合了局部特征和全局特征。先使用一系列卷积模块和像素重整模块搭建深度残差网络,使用独立的卷积层和数据叠加层得到图像残差信号,然后中间数据经过像素重整模块,里面的上采样操作将输入图像的清晰度提高,该模型可以使不同尺寸图像的超分辨率增强,提高红外图像的清晰度和分辨率。

图3 深度网络结构

由于1×1卷积层可以降低特征维数,以更少的信息损失进行更快的计算。因此,网络结构先利用1×1卷积层降维,然后在另一个1×1卷积层下做还原,既保持了精度又减少了计算量。将低分辨率图像块输入一个 7×7的卷积层,并采用ReLU作为激活函数。7×7卷积层的输出特征输入多连接结构块,其中每个多连接结构块均包括一个子块结构和一个恒等映射;通过堆叠多连接结构块,然后将最后一个多连接结构块的输出特征图输入一个1×1卷积层,降低特征图的维数;采用一个跨连接层,将7×7卷积层输出的特征图和1×1卷积层降维后的特征图堆叠起来,共同作为放大模块的输入;最后采用低分辨率特征图按次序拼接成高分辨率特征图的方法,将低分辨率特征图放大到一定的倍数。

2.3 双参数损失函数

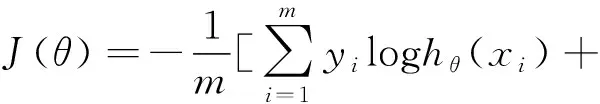

深度残差网络的损失函数可表示为:

(5)

式中:(xi,yi)代表低分辨图像与高分辨图像组成的训练样本;m表示训练样本的个数;hθ(x) 代表逻辑回归函数[16]。训练过程即是使损失函数最小的参数求解过程。然而,该函数对极端情况下的样本拟合能力较差。因此,采用了一种改进的双参数损失函数,该函数可以推广到目前许多流行的鲁棒损失函数。假定IHR和SHR之间的误差可以表示为e=IHR-SHR,文中采用的损失函数可以表示为:

(6)

式中:ρ(α)=max(1, 2-α);α、β是具有连续值属性的参数,可以通过不同的参数设置,模拟出任意的损失函数。相比于传统固定参数损失函数,采用双参数损失函数可以通过微调α和β获得更优的损失函数,具有很大的灵活性,可以适应更复杂的场景。

3 实验仿真及挂飞验证

为了验证文中提出的多级深度网络高清晰度电子变倍算法的有效性,将从静态实验室仿真与动态外场挂飞进行评价分析。

3.1 网络模型参数设置

第一卷积层:卷积核大小为3×3,输出特征图个数为64,卷积步长为1;非线性激活函数采用ReLU激活函数,其作用为引入非线性操作,将特征图中小于零的值变成零,而大于零的值维持不变,即f(x)=max(0,x) 。第二卷积层:卷积核大小为3×3,输出特征图个数为64,卷积步长为1;文中采用的多层次耦合层,包括低层次局部特征与高层次深度特征两路分支;在处理中间数据时,输入到每一个卷积模块时的数据流D1和该数据流经过一般结构层处理后的数据流D2进行合并,并且作为该卷积模块的输出,继续输入到下一卷积模块;深度支路最初的输入图像经过卷积层后的数据流Dint与经过全部卷积模块和批归一化处理后的数据流Dall进行叠加,输入到像素重整模块。像素重整模块,包括一个卷积层和一个像素重整层,其中卷积核大小为3×3,输出特征图个数为256,卷积步长为1,像素重整层使用比例系数C=0.01,对输入数据流进行上采样操作。训练时,批处理的大小设为64,动量参数设为0.9,权重衰减设为0.000 1;采用可变学习率的学习策略,初始学习率设为0.01,当误差停滞时,学习率衰减为之前的10%。α和β分别设置为1.12和0.05。

实验选择Tensorflow深度学习框架进行模型训练,其硬件平台采用Core i5 7600处理器:主频为3.94 GHz,内存为32 G,GPU GTX1080。本算法挂飞硬件平台采用RK3399开发板。

3.2 仿真结果与分析

由于红外图像很少有不同分辨率的基准数据库。为了便于定性定量的分析算法的有效性,采用武汉高德红外生产的制冷型锑化铟红外探测器ZCM01A,其分辨率为1 280×1 024,像元尺寸是12 μm;工作波段 3.7~4.8 μm,其对应的低分辨红外图像是由高斯模糊采样获取。由于实际的红外图像没有对应的高分辨的图像用做定量分析,只能从对比度、边缘区域的锐度、同质区域的平滑性等方面主观定性的对比分析。因此,采用低成本非制冷探测器采集的低分辨红外图像(320×240)进行超分辨重建,从对比度、边缘锐度、纹理特性等角度定量分析重建性能。

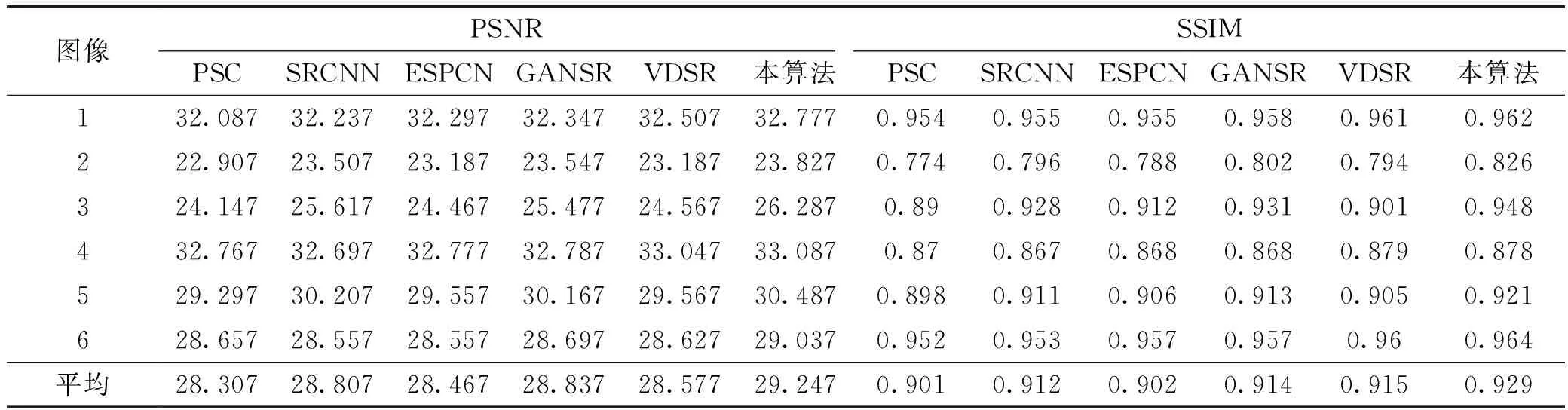

将文中方法与基于参数化稀疏表示的图像超分辨算法(PSC)[10],基于卷积神经网络的超分辨算法(SRCNN)[4],基于亚像素深度网络超分辨重建(ESPCN)[8]、基于生成对抗网络的超分辨重建(GANSR)[11]和基于递归残差超分辨(VDSR)[12]进行对比。峰值信噪比(PSNR)[13]和结构相似度(SSIM)[14]被用来定量评价超分辨结果的性能。表1列出了各种超分辨方法获得的PSNR值和SSIM值。

表1 不同算法的重建效果定量值

从表1的数据可以看出:基于深度学习重建性能明显优于基于参数化稀疏表示的图像超分辨算法,其中SRCNN的平均PSNR比PSC高0.5 dB, SSIM值高0.1。基于参数化稀疏表示的图像超分辨算法是目前传统机器学习中最优算法,其重建结果与深度学习算法仍有一点的差距。文中提出的方法与GANSR性能相当,大部分结果与SRCNN相差0.3 dB左右,一些结果甚至超过0.5 dB。在图像2上所有算法的重建结果都不理想,主要是由于图像2中图像存在大量的热浪,没有明显的纹理结构,深度学习的效果比较虚化,但从指标上看,文中算法的PSNR比GANSR的PSNR高0.28 dB, SSIM指标也要高0.132,充分说明提出的多层次深度耦合网络具有一定的优势,适合复杂红外背景下弱小区域超分辨重建。

图4是图像3与图像4不同算法的重建效果。从实验结果可以看出:所有算法的重建质量相比直接插值有一定的提升,对于强边缘区域可以得到清晰的纹理边缘结构。图4(a)是利用一种混合参数模式,不仅从训练数据中学习出非参数图像,还要估计出先验参数,该方法对边缘区域效果较好,但匀质区域容易出现伪影;SRCNN、ESPCN、GANSR、VDSR是深度学习超分辨领域比较有代表性的方法,从实验结果可以看出,此类方法的效果较好。图4(c)中,ESPCN引入了亚像素卷积层,将插值函数隐含地包含卷积层,直接在低分辨率图像上计算卷积得到高分辨率图像,该方法对部分匀质区域过于平滑,而缺少一些细节上的真实感。图4(d)中,GANSR是基于对抗网络的重建模式,理论上重建的高分辨率图像与真实图像无论是低层次的像素值上,还是高层次的抽象特征上都应当接近。该方法对自然图像的效果较好,但对于红外图像,由于大部分红外图像缺乏明显细节,对比度较低,代价函数容易过拟合,其结果容易重建出一些虚假的纹理。

文中提出的网络模型是对深度残差网络的改进,通过引入具有明显像素特性低层次特征与高层次深度特征耦合,使得模型并不需要太深的结构就能实现较好的效果。从图4(f)的效果可以看出,该方法获得的放大区域比较清晰,纹理结构明显。操作手只需要将波门拉到攻击区域附近,通过子图就能清晰的看到目标细节,方便锁定最佳攻击位置。

图4 不同算法的放大结果分析

3.3 挂飞视频对比分析

文中提出的算法已经移植到基于ARM平台的嵌入式系统[15]中,采用非制冷红外热像仪进行视频采集。操作手利用文中算法获取变倍后的高分辨图像锁定目标,能够清晰的看见弱小区域的边缘、纹理信息,增强了目标中心锁定的精度。对挂飞图像进行对比分析,其结果如图5所示,所有图像都是3倍放大后的结果。可以看出:文中提出的方法通过跳跃式连接耦合不同层次的特征,能够同时表征各种复杂的重构场景,生成具有丰富细节而清晰的高分辨红外图像。

图5 不同算法对挂飞视频定量分析

4 结论

为了提升红外导引头或光电跟踪系统电子变倍获取的放大图像的质量,增强边缘、纹理等细节信息,便于操作手锁定最佳攻击点,对深度残差网络进行有效改进,通过多层跨连接将低层次特征和高层次特征聚合形成新的特征,能够表征各种复杂的重构场景,并采用双参数损失函数来优化深度网络,提高模型的泛化能力。实验仿真与外场挂飞结果表明所提出的电子变倍方法能够生成具有丰富细节而清晰的高分辨红外图像,增强了目标锁定的精度。