基于Softplus+HKELM的彩色图像超分辨率算法*

王亚刚 王 萌

(西安邮电大学计算机学院 西安 710121)

1 引言

数字图像的空间分辨率是衡量图像质量的一种非常重要的指标。图像的空间分辨率高意味着有更高的像素密度,能够为图像内容的分析与处理提供更为丰富的像素信息。提高图像的空间分辨率,最直接的办法是提高图像采集设备传感器的密度,但是在目前的工艺水平下,传感器的密度已经接近极限。如何通过特定的技术手段在不改变成像系统硬件的前提下提高获取图像的质量,一直以来都是图像处理领域一个重要的研究内容。超分辨率[1](Super Resolution,SR)就是由低分辨率图像重建出高分辨率图像的一种软件技术。

近年来,随着深度学习技术的发展,基于学习[2]的超分辨算法是一种非常有前途的图像重建方法。深度学习强调以大数据为驱动进行端到端学习。为了进一步提高基于单幅彩色图像的超分辨率重建[3]速度,降低学习训练过程的复杂度,本文在极限学习机(Extreme Learning Machine,ELM)的基础上[4],提出了一种基于Softplus+HKELM的图像超分辨率重建算法。

2 ELM

ELM是一种单隐藏层前馈神经网络[5](Single Hidden Layer Feed-forward Neural network,SLFN),与传统的基于梯度的学习算法相比,ELM具有更快的学习速度与更高的精度[6]。ELM网络的泛化性能,使其可以在样本的学习过程中建立记忆,从而可以将未知的模型判为最接近的模型。

ELM网络结构由输入层,隐藏层和输出层组成。在图1中,展示了一种具有n个输入神经元,j个隐藏层神经元与m个输出神经元的ELM网络模型。

图1 ELM网络结构

对N个不同的学习样本:

其中隐藏层神经元的输出用下面的公式表达:

输出层神经元可以用下面的公式表达:

在上面的公式中g(x)表示ELM隐藏层的激活函数,β表示隐藏层与输出层之间的权值,w表示输入层与隐藏层之间的权值,b表示隐藏层神经元的偏置。

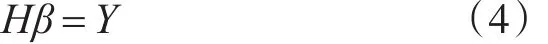

使用H表示隐藏层与输出层之间的连接权值矩阵,Y表示训练数据集的目标矩阵,所以式(2)可以缩写为如下:

如果隐藏层激活函数 g(wi,bi,xi)是无限可微的,那么ELM网络只需要设定隐藏层神经元节点个数,而无需动态调整输入的权值与隐藏层的偏置[7~8]。其中 Sigmoid 函数是隐藏层最常用的激活函数。Sigmoid是连续光滑严格单调的S型阈值函数,函数定义如下:

在训练ELM前,我们需要根据样本的特征向量与样本的种类,分别去确定输入层神经元个数和输出层神经元个数。最后还要根据特定环境决定隐藏层的激活函数与隐藏层神经元的数量。

在训练之前ELM能够随机的产生w和b,ELM的整个训练过程无需迭代,一次就能完成,所以和其他神经网络算法相比,极限学习机的速度非常快。

2.1 RELM

虽然ELM具有很快的学习速度和较好的泛化能力,但是仍然也有一些不足之处。根据统计学理论,我们知道实际的风险包括两个部分,经验风险和结构风险[9]。但是,ELM只考虑了经验风险,而没有考虑结构风险,因而可能会导致过度拟合的问题。此外,ELM的鲁棒性和可控性较差。

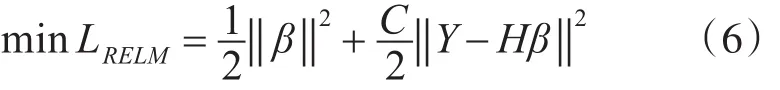

在文献[10]中,为了防止过拟合,Deng等提出了一种结合经验风险和结构风险的正则化极限学习机RELM。RELM通过添加输出权值的平方项约束,不仅有效地避免了过拟合的出现,而且提高了极限学习机的性能。RELM的数学描述如下,其中C表示正则化参数,C可以调节经验风险与结构风险各自的比例。

通过设置式(6)的梯度,可以得到如下公式:

如果H中行数大于列数,也就是训练样本的数量大于隐藏层神经元的个数,那么隐藏层与输出层之间的连接权值矩阵β就可以用如下公式表示:

相反,如果训练样本的数量少于隐藏层节点的个数,那么β就可以由下面的式(9)表示:

2.2 KELM

Huang等[11]在 ELM 中引入了核函数(kernel function)。与传统的神经网络一样,ELM核函数的选择也是一个核心问题。使用适当的核函数在很大程度上决定了最后训练的ELM的性能,因为核函数的选择对网络学习率和学习效果都有非常大的影响。

基于核函数的极限学习机KELM的输出层神经元可以看成一种非线性映射样本。当映射未知时,HHT可由核函数替代:

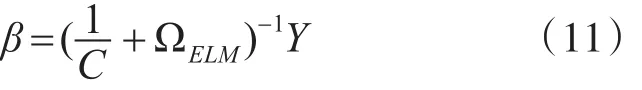

所以式(9)就可以表示为式(11):

其中ΩELM,j=h(xi)h(xj)=K(xi,xj),ΩELM代表核函数矩阵,H=[h(x1)t…h(xN)T]T代表隐藏层的输出矩阵,将输入数据xi映射到隐藏层特征空间,其与输出值yi和输出节点数没有关系。其中核函数矩阵为

式(12)只与输入数据xi和训练样本的数量N相关,所以KELM的输出函数的完整表示为如式(13):

3 Softplus+HKELM超分辨率算法

通常情况下,ELM的隐藏层激活函数为Sigmoid,这是一种在判别时采用双侧抑制的函数。不过在一些值函数单调时,这种双侧抑制会增加废运算。基于此,本文使用新型修正线性函数Softplus[12]作为极限学习机的激活函数。Softplus激活函数采用单侧抑制,并且兴奋边界宽广,是一种非线性并且连续可微的函数。Softplus激活函数是Relu函数[13]的改进版本,其继承了Relu函数运算速度快、泛化性能好的优点。在文献[14]中,Glorot X等通过实验证明了Softplus激活函数具有更好的泛化能力。并且,Softplus激活函数是一种比传统的Sigmoid激活函数更加接近生物学特征的激活函数,与传统的函数相比基于Softplus激活函数的ELM模型的整体性能更好,网络结构更加优化。其函数定义如下:

为了更加有效地提高训练效果,避免局部最小值的出现,本文选择使用结合较强学习能力的本地核函数与泛化能力好的全局核函数的混合(Hybrid)核函数极限学习HKELM。

在图像视觉中,因为人最敏感的是图像的亮度信息,对彩色图像,我们只处理其亮度,其它通道采用经典的二次三项插值算法[15](bicubic)进行放大。基于Softplus+HKELM进行图像超分辨率重建的主要步骤如图2所示。

图2 Softplus+HKELM超分辨率算法框图

在图2中,设高分辨率图像为HR。HR下采样且模糊处理后得到低分辨率图像LR,LR再通过图像插值算法进行放大得到ELM网络输入图像I0,HR与I0相减就是图像的高频信息:

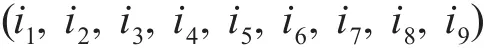

设I0(i,j)为插值后低分辨率输入图像中坐标为(i,j)的像素值,那么I0(i,j)与其周围的8个像素点可变成一个9维的特征向量,设其为

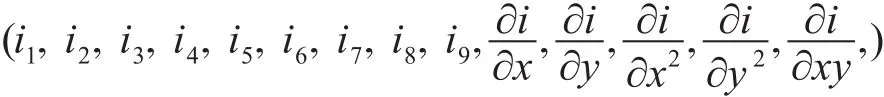

然后分别对I0(i,j)的横纵方向进行一阶与二阶求导,可得5个导数,与前面的9个像素点的值即可组成一个14维的特征向量:

对于训练输入图像I0的每个像素值I0(i,j),将得到的14维特征向量作为输入,HF中坐标(i,j)对应的像素值作为其标签,那么基于极限学习机的图像超分辨率重建算法的训练的过程可分为如下几个步骤。

步骤1:确定隐藏层神经元的个数,随机设置隐藏层的偏置b、输入层和隐藏层之间权值w;

步骤2:选择一种无限可微的函数Softplus作为ELM隐藏层的激活函数,然后计算隐藏层的输出矩阵H;

步骤3:计算隐藏层与输出层之间的权值β,β=HTH,HT是输出矩阵H的逆矩阵。

对于任意的低分辨率图像矩阵I0,在训练好的ELM模型输入端输入每个像素对应的14维特征向量,输出端就会输出相应图像的高频信息HF,将其与低分辨率图像矩阵I0相加,即可得到重建后的高分辨率图像HR:

4 实验分析

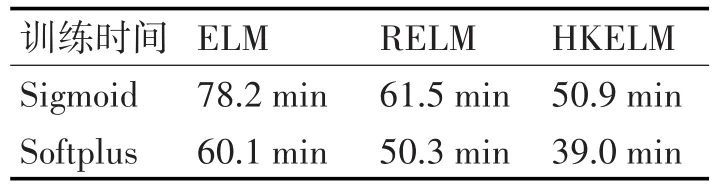

本文实验运行在fedora 26操作系统中,所用平台为基于docker的tensorflow机器学习架构。使用标准的USB-SIPI数据库图像对模型进行训练与测试。使用峰值信噪比(PSNR)与结构相似度(SSIM)评价图像重建质量。为了使实验更具说服力,本文实验分别统计了基于Sigmoid激活函数与基于Softplus激活函数的三种极限学习机模型ELM、RELM、HKELM的训练学习时间。从表1中可以明显看出,基于Softplus+HKELM的神经网络模型所用的训练时间要比传统的Sigmoid激活函数很多,是所有网络中训练时间最少的一个。

表1 训练时间

表2是基于Sigmoid激活函数的极限学习机模型对低分辨率图像超分辨率重建后测试的PSNR值与SSIM值。

表2 基于Sigmoid激活函数

表3是本文提出的基于Softplus激活函数的极限学习机超分辨重建的测试结果。

在表2和表3中K表示图像放大系数。对比表2和表3可以看出,对于测试图像baboon,客观上来说基于Softplus激活函数的极限学习机超分辨率重建效果要比基于Sigmoid激活函数的高,在同样的硬件条件与软件平台环境下,基于Softplus+HKELM超分辨率算法的测试的PSNR与SSIM的值最高,这也就表示图像的内容丰富,能够恢复图像本身更多的细节信息。

表3 基于Softplus激活函数

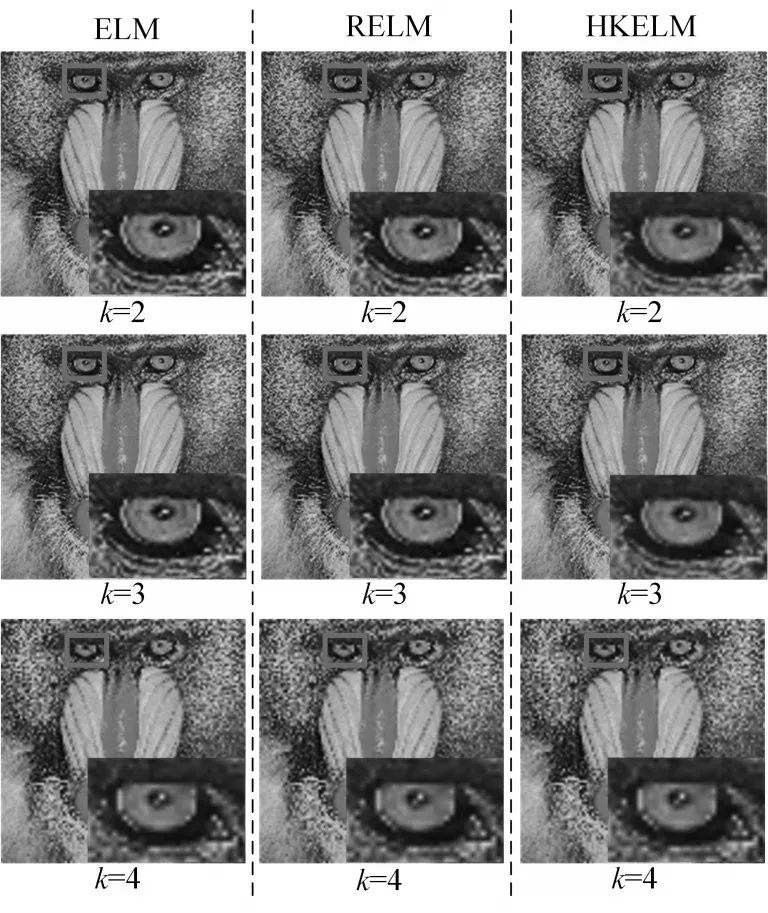

图3 Sigmoid激活函数

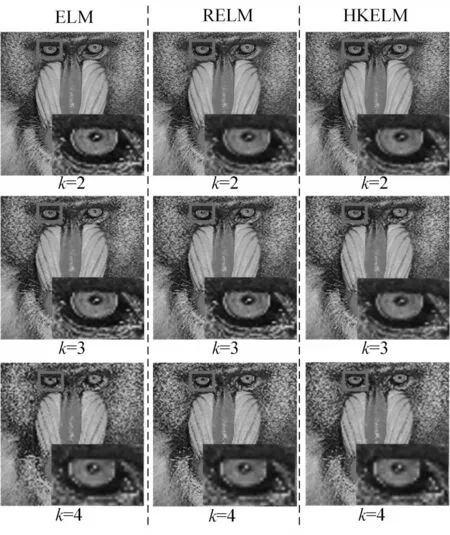

图4 Softplus激活函数

评价一幅重建图像质量的好坏有两种方式有主观评价与客观评价。为了更直观地说明基于Softplus+HKELM的超分辨率算法重建后图像的质量更好,在图3与图4中,分别展示了基于Sigmoid激活函数与基于Softplus激活函数超分辨率重建后图像的主观效果。

对比图3与图4,可以明显地看出,对于不同的K值,图4中相应的基于Softplus激活函数的极限学习机模型ELM、RELM与HKELM的主观视觉都要比传统基于Sigmoid函数的好很多,重建后能够展示更多的图像细节信息。其中本文提出的基于Softplus+HKELM重建的图像效果最好,图像的细节最为丰富。

5 结语

极限学习机最大的优势在于模型仅通过矩阵乘法和求逆运算即可进行参数求解。为了进一步提高彩色图像超分辨率重建的计算效率,本文提出了一种基于Softplus+HKELM的超分辨率重建算法。Softplus+HKELM算法结合了Softplus激活函数泛化能力好与HKELM学习能力强等各自的优势,在训练过程中能够学习到最好的网络参数。最后的实验表明不论是主观评价还是客观评价,重建的图像质量都要明显好于传统的Sigmoid激活函数与极限学习机网络。所以这充分说明基于Softplus+HKELM的彩色图像超分辨率重建算法不仅在训练过程中能够学到更好的映射关系,而且进一步降低了极限学习机训练的复杂度,提高了超分辨重建的速度。