融合FPN的Faster R-CNN复杂背景下棉田杂草高效识别方法

彭明霞,夏俊芳,彭 辉

融合FPN的Faster R-CNN复杂背景下棉田杂草高效识别方法

彭明霞1,夏俊芳2※,彭 辉1

(1. 华中农业大学信息学院,武汉 430070; 2. 华中农业大学工学院,武汉 430070)

为实现田间条件下快速、准确识别棉花与杂草,该文以自然光照下田间棉花与杂草为研究对象,采用垂直向下拍摄的方式获取棉花杂草视频,按1帧/s的速率从视频中提取图像,在人工去除冗余度过多的图片后,建立1 000幅图片的数据集。对比了Faster R-CNN和YOLOv32种典型卷积神经网络,将Faster R-CNN卷积神经网络的深度学习模型引入到棉花杂草图像识别中,并提出一种结构优化的方法,使之适用于复杂背景下的棉田杂草识别。该文选用残差卷积网络提取图像特征,Max-pooling 为下采样方法,RPN网络中引入特征金字塔网络生成目标候选框,对卷积神经网络结构进行优化。在使用700幅图片进行训练后,通过200 幅田间棉花杂草图像识别测试,结果表明:该方法的平均目标识别准确率达95.5%,识别单幅图像的平均耗时为1.51 s,采用GPU 硬件加速后识别单幅图像的平均耗时缩短为0.09 s。优化后的Faster R-CNN卷积神经网络相对于YOLOv3平均正确率MAP高0.3以上。特别是对于小目标对象,其平均正确率之差接近0.6。所提方法对复杂背景下棉花杂草有较好的检测效果,可为精确除草提供参考。

棉花;卷积神经网络;机器视觉;深度学习;图像识别;杂草识别;Faster R-CNN

0 引 言

棉花是中国重要的经济作物之一,其生长过程常会遭遇病、虫和杂草危害等生物逆境。杂草会与棉花竞争营养、水分、光照和生长发育空间,并且传播病虫害,常年造成的损失达到14%~16%,严重影响棉花的优质、高效生产[1]。及时有效地去除棉花幼苗期杂草是保证棉花高产稳产的一项重要措施,目前采用的除草方法有人工除草、机械除草和化学除草。化学除草由于其高效性,已成为国内外田间除草的主要方式,但会对生态环境造成危害。2013年农业部明确了通过技术手段和管理方式来治理农业面源污染[2],实现农业的可持续发展。在技术上,研究人员针对粗放喷洒所引起的浪费和残留问题提出了变量喷药的概念,并进行了相关的试验和研究[3]。变量喷药是基于精准农业发展起来的一种技术,根据杂草在田间的位置、种类和密度,对除草剂喷洒的时机和剂量进行变量调节,从而达到减少除草剂用量,提高杂草去除率的效果[4]。要实现变量喷药,需要解决的一个关键问题是如何实现作物和杂草的实时精确识别。

早期的杂草识别研究主要从图像中提取颜色、纹理和形态等特征,根据作物和杂草在图像中的不同特征对各类目标进行区分[5-8]。这些方法准确率较低,虽然基本实现了作物与杂草的识别,但难以实际应用。

随着机器学习技术的发展,一些具有数据学习能力的网络模型被引入到杂草识别研究中。如神经网络、遗传算法、决策树和支持向量机等。该类方法先对图像进行预处理,从背景中分离出目标作物和杂草,以向量的形式记录颜色、纹理、形态、光谱等特征,然后选择适当的分类器进行训练及检测[9-14]。特征的选取和图像的预处理效果决定了这类方法的识别效果,在杂草与作物密集分布、强光及阴影等情况下,准确率仍然不高。

相比上述方法,近几年兴起的深度学习方法对图像具有极强的数据表达能力。深度学习已在人体行为识别以及农作物果实识别和杂草识别等方面,获得了较好的效果。傅隆生等[15]基于卷积神经网络的田间多簇猕猴桃图像识别方法表明,卷积神经网络在田间果实识别方面具有良好的应用前景。基于卷积神经网络、哈希码以及多尺度分层特征识别玉米杂草等证明了CNN(convolutional neural networks)在田间杂草图像识别上的有效性[16-17];熊俊涛等[18]利用深度卷积网络对自然环境下绿色柑橘进行有效识别;王生生等[19]提出一种以小批量数据作为输入的轻量和积网络,结合均值聚类算法应用于无人机图像中的杂草识别,取得了良好的效果。以上研究的开展为CNN 应用于田间作物杂草识别提供了参考和可行性依据,同时也表明CNN 在图像识别中可以克服传统方法的不足。

棉花与其他作物的田间杂草种类不同,植株形态具有明显差异,实验室测试结果表明,现有方法应用于棉田杂草时效果并不理想。目前尚未有CNN网络用于棉花田间杂草识别的相关报导。本文以2~5叶期棉花和杂草为研究对象,提出基于Faster R-CNN模型的棉花杂草识别算法。该研究依赖于目标检测的深度学习框架,在采集大量棉花田间样本图像的基础上,通过建立深度卷积网络ResNet50对复杂背景下的棉田杂草进行特征提取,避免人为主观选取目标特征影响识别结果。然后在ImageNet预训练的多层卷积神经网络基础上进行参数微调,生成棉花和杂草的目标识别模型,最后利用训练后的模型对棉花杂草图像进行测试,对每张图像上的杂草和棉花目标标注类别、具体位置以及置信度,从而建立一个基于Faster R-CNN的棉田杂草图像识别系统,以实现自然光照环境下背景较为复杂的棉田杂草快速有效识别。

1 材料与方法

1.1 图像采集

该研究以棉花及其伴生杂草作为研究对象进行识别试验,并分析棉田杂草识别系统性能。图像采集工作于2015 年6 月在华中农业大学试验田中完成,采集设备为普通相机,主要参数为:CCD传感器,最大分辨率1 920×1 080 像素,帧率25帧/s,USB3.0 接口。相机距地面80 cm,采用垂直方式采集视频图像。当棉花幼苗处于2~5叶期间进行4次图像采集,所采集的样本图像为幼苗期棉花及此阶段常见的伴生杂草,包括马齿苋、马唐、马兰、牛筋草、反枝苋、香附子和荩草等。每次图像采集均在晴天、阴天不同光线状态下进行,代表田间除草作业时可能的环境条件。初始采集到的原始视频图像分辨率为1 920×1 080像素。本文建立的样本集均从真实棉田环境中采集,棉花及杂草生长位置复杂,采集的大部分图像中包含复杂背景、棉花和杂草的多个目标,这与实际应用情况相同,如图1所示。

a. 晴天a. Sunnyb. 阴天b. Cloudy

1.2 样本数据集与试验方法

按1帧/s的间隔从采集的视频中提取出5 000幅静态图像。为使训练集样本图像多样化,避免图像冗余,尽量减少过拟合,加强模型的稳定性,人工对静态图像进行筛选,建立一个1 000幅图片的样本集。

由于卷积残差网络ResNet50能够自动从不同尺寸图像中提取特征,所以样本图像可直接用于本文方法的训练与测试,不需要进行缩放等预处理操作。直接采用LabelImg按照PASCAL VOC2007的格式手工标注图片中的棉花和杂草目标,获得每幅样本图像的标签矩阵,在实际使用时根据不同框架支持的标注格式进行转换。

将全部图像样本分成训练集、验证集和测试集。其中训练集700张照片,测试集200张,验证集100张。这几个集合中的图片互不重叠,训练集用于训练模型参数,测试集用于训练完成后评估模型对样本的泛化误差,验证集用于训练过程中对模型的超参数进行调优。

试验完成后,采用深度学习在目标识别领域应用典型评测指标来衡量模型检测器性能。涉及到的指标有平均准确率AP、平均召回率AR、精度损失曲线(F值曲线)、检测时间等。

1.3 基于Faster R-CNN模型的棉花杂草网络

目标检测模型分为两类。一类是将物体识别和物体定位分2个步骤完成,这一类的典型代表是R-CNN, Fast R-CNN, FasterR-CNN家族。该类框架识别错误率低,漏识率也低,且可以满足实时检测场景。另一类典型代表是YOLO(you only look once),SSD(single shot multibox detector),YOLOv2,YOLOv3[20-23]等将物体分类和物体定位在一个步骤中完成。YOLO直接在输出层回归目标的位置和所属类别,可实现45帧/s的运算速度。尽管这些方法识别速度很快,但是准确率比Faster R-CNN要低。因此本文选取Faster R-CNN模型框架进行棉花杂草图像的识别。

目前Faster R-CNN[24]在目标检测领域被广泛应用于车辆识别和人体姿态行为监测等方面。本文对其重要结构参数和训练策略进行优化,获得适合棉花杂草图像识别的模型架构。试验目的是在图像中识别出棉花与杂草、标定其在图像上的位置并给出类别置信度的预测。

1.3.1 Faster R-CNN模型的棉花杂草网络结构

Faster R-CNN主要由候选区域的深度全卷积网路RPN(region proposal network)和快速区域卷积神经网络(Fast R-CNN)2个模块组成。基于Faster R-CNN的棉花杂草识别检测由以下4个部分组成:棉花杂草候选区域生成、棉花杂草特征提取、棉花杂草分类和边框回归。图2为本文Faster R-CNN算法原理图。

首先,对于任意大小的棉花杂草图像将其归一化大小为1 000×600像素。然后,通过CNN中的卷积层和池化层产生特征映射图(feature map)。本研究中,为了提高图像中杂草和棉花目标识别精度,没有选取VGG16网络作为基础特征网络提取图像特征。在目标检测、图像分割、视频分析和识别等其他领域,将Faster-RCNN中的VGG16替换成残差网络(ResNet)可以提高系统性能。PASCAL VOC2007数据集上,通过将VGG16替换成ResNet101,MAP从73.2%提高到76.4%,PASACAL VOC 2012上从70.4%提高到73.8%[25]。由于棉花杂草图像中目标类别和数量不是很多,故选取ResNet50网络提取图像特征。在所有Feature Map上通过候选区域生成网络RPN和FPN(feature pyramid networks)网络提取前景目标候选区域(region of interest,ROI)和区域得分,得分最高的区域作为最终的棉花和杂草候选区域。

图2 Faster R-CNN的算法原理图

任意一个目标候选区域经过ROIAlign层映射到Feature Map的相应位置上,并对该区域下采样成7×7大小的特征图,然后对每个输入的特征图通过全连接层提取成7×7×256维度的特征向量。最后将这个特征向量输入到2个同级的输出层:一个是分类层,判断目标是否是棉花或杂草;另一个是边界回归层,主要对ROI边框位置和大小进行微调。

在整个过程中,使用的Feature Map根据物体尺寸的不同而改变。物体尺寸较大时,采用高层的特征(C4, C5),而物体尺寸较小时则采用底层的特征(C1, C2)。

1.3.2 候选区域的深度全卷积网络RPN

1)RPN(region proposal network)

RPN是一个全卷积网络,经过端到端的训练,生成高质量的棉花杂草前景目标候选框,同时完成棉花杂草在每个位置的目标边界以及目标分数预测,该网络与棉花杂草检测网络共享图像的卷积特征。基于ResNet50的残差网络和Faster R-CNN模型共享C2到C5的卷积层。

2)FPN(feature pyramid network)

2017年Lin等[26]提出的特征金字塔网络算法大大提高了目标检测精度。FPN算法同时利用低层特征高分辨率和高层特征的高语义信息,通过融合这些不同层的特征达到预测的效果。为了提高棉花杂草图像中目标检测的精度,本文在RPN网络中采用FPN融合不同层的特征生成感兴趣的目标候选框。FPN把特征图设计成多尺度的金字塔结构,每一层金字塔应用单一尺度的锚(anchor),对应ResNet50每一层金字塔{P2, P3, P4, P5, P6}分别对应的anchor尺度为{32×32, 64×64, 128×128, 256×256, 512×512},使用3种比例{1:2, 1:1, 2:1},共用15种类型的Anchor对棉花杂草图像中的目标对象和背景进行预测,生成感兴趣的目标(棉花,杂草)候选框。RPN框架如图3所示。

图3 RPN框架

3)RoI Align模块

实际棉田杂草图像中存在大量目标偏小的杂草,为了提高棉花和杂草目标的识别精度,本文没有采用FasterR-CNN原文中使用的ROI Pooling。ROI Pooling根据输入的image,将ROI映射到feature map对应的位置;将映射后的区域划分为相同大小的sections,其数量和输出的维度相同。对每个section进行max pooling操作;在此过程中经过2次量化操作。该量化操作使得候选框和最开始回归出来的位置有一定的偏差,这个偏差会影响检测准确度。本文采用ROI Align取消量化操作,使用双线性内插的方法获得坐标为浮点数的像素点上的图像数值,解决ROI Pooling操作中2次量化造成的区域不匹配的问题[27]。

RPN的结果输入ROI Align层,映射成7×7的特征。然后所有输出经过2个全连接层(Fully-connected Layer),再经分类层和边界回归层得到最终结果。分类层给出候选区域中的物体是棉花和杂草的概率,边界回归层给出棉花和杂草候选区域的坐标。

2 基于Faster R-CNN棉花杂草图像识别

2.1 试验软件及硬件

本文利用Pytorch以及香港中文大学提供的mmdetection开源框架,在Ubuntu16.04系统下进行试验。试验所用机器的配置为:处理器为Intel(R) Core(TM) i7-7700K,主频4.20GHz,硬盘8T,内存32G,显卡NVIDIA TITAN Xp (12GB)。所用软件环境为:ubuntu16.04,Pytorch1.0.0,Python3.6。

2.2 网络模型的试验方法

2.2.1 模型训练

首先配置mmdetection的运行环境,并将筛选出来的棉花杂草图像数据按照PASCAL VOC2007标准进行标注和存储。在训练模型和优化参数之前,选择模型训练方式,并修改相应配置文件。

Faster R-CNN的训练方式主要有2种:交替训练和近似联合训练。交替训练方式训练2个网络,一个是RPN,一个是Fast-RCNN,总计2个阶段,每个阶段各训练1次RPN和Fast-RCNN。近似联合训练过程中仅训练1个权重网络,需要的显存略少,该训练方式比交替训练法节约25%~50%训练时间,而2 种训练方式精度相近[24],所以选取近似联合训练方式。

本文训练的棉花杂草图像数据集不是很大,所以选择随机梯度下降法对Faster R-CNN以端对端的联合方式进行训练,用均值为0、标准差为0.01的高斯分布随机初始化所有新加入层的权重,其余层用预训练好的ImageNet分类模型的参数初始化。设置学习率为0.005,动量为0.9,权值的衰减系数为0.000 1,epoch为1 500,迭代次数为550 000次,每迭代一个epoch保存一次模型,最终选取精度最高的模型。在此过程中,使用验证集中的图片对训练效果进行评估并进行参数调优。系统的超参数学习率采用热身策略[28-30],即一开始用比较小的学习率,慢慢增大学习率。这种方法可以获得很高的准确率,又可避免模型训练不收敛。训练时学习率从初始的0.001 99逐渐增大,采用线性增加策略,迭代500次后,增加到0.005。

2.2.2 非极大值抑制算法

非极大值抑制[31](non-maximum suppression,NMS)是一种去除非极大值的算法,可以去掉目标检测任务的重复检测框,找到最佳目标检测位置。Faster R-CNN训练过程中,利用NMS算法对生成的大量棉花和杂草候选框进行后处理,去除冗余候选框,得到最具代表性的结果,以加快目标检测的效率和提高检测精度。

RPN利用 Anchor Target Creator训练自身的同时,还提供RoIs(region of interests)给检测部分RoI Head作为训练样本。只有当棉花和杂草的候选框和真实目标的实际包围框的边框重叠度(intersection over union, IoU)最大或者大于0.7的候选框标记为正样本。如果一个候选框和实际包围框的IoU值小于0.3,该候选框标记为负样本(背景)。一幅棉花杂草图像RPN网络得到大约2万个锚,利用NMS算法选出概率最大的2 000个RoIs,由分别对应feature map不同大小的区域。利用Proposal Target Creator 挑选出128个RoIs, 然后使用ROI Align 将这些不同尺寸的区域全部池化到同一个尺度(7×7)上。

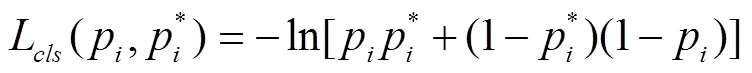

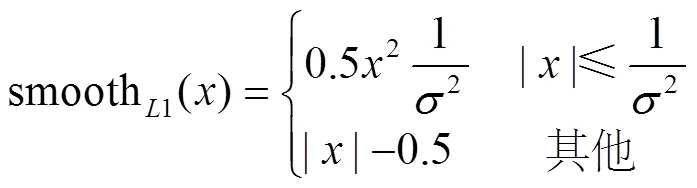

2.2.3 损失函数

本文检测对象类型有3类,分别为棉花、杂草和背景。Faster R-CNN的损失函数由分类损失和回归损失组成。对于分类部分直接利用交叉熵损失,对于边框位置回归损失采用Smooth_L1Loss。对于每一个区域候选框其损失函数为

式中是一个小批量数据中的候选框索引,p是候选框作为目标的预测概率,如果候选框为正样本,真实标签p=1,如果候选框为负样本,则p=0。为平衡权重归一化值,默认情况下,设置=10。t={t,t,t,t}表示预测边界框4个参数化坐标的向量,t是与正样本相关的真实边界框的向量。N为训练过程中mini-batch数量。N为候选框数量。L为回归损失函数。L是两个类别上的对数损失:

回归损失函数L为

其中smooth函数定义如下:

式中为边框预测的误差,参数用来控制平滑的区域,本文取值为3。

3 结果与分析

3.1 训练误差

采用上文描述的Faster R-CNN结构,使用700幅训练集样本数据进行训练,对上述训练集进行1 500次迭代。训练700幅图像,耗时30 h,其训练精度损失曲线如图4所示。

图4 训练损失曲线

结果表明,随着迭代次数不断增加,训练集产生的精度损失逐渐降低,当迭代到1 000次后,精度损失降至4%,说明模型训练效果良好。训练损失基本收敛到稳定值,表明Faster R-CNN达到预期训练效果。

3.2 模型的效果验证

为了验证模型的可靠性与稳定性,在训练完成后,对测试集的200幅田间棉花杂草图像进行识别。选用平均正确率MAP(mean average precision),平均召回率(average recall),平均准确率AP(average precision)作为试验结果有效性的评价指标,使用平均处理时间评价识别的速度。

识别结果如表1所示。识别对象分为棉花和杂草2种类别,当IoU阈值取典型值0.5时,2种类别的平均正确率为0.955。单幅图像的平均处理时间为1.51 s。

由表1可知,棉花的平均召回率与平均准确率指标均高于杂草,其原因主要有:一是棉花在图像中目标尺度通常大于杂草;二是棉田中杂草种类繁多,样本标注没有对各类杂草类别进行分别标注,杂草特征呈现多样性,棉花特征相对单一;三是自然光照下实际农田环境复杂,株间杂草容易因遮挡未被识别;四是田间背景环境和杂草相似时,难以识别。

表1 棉花杂草识别结果

在试验中发现,遮挡和背景相似度是影响杂草识别的主要原因。如图5a所示,圆圈中的杂草由于部分被棉花叶片遮挡导致未正确识别。如图5b所示,方框中的杂草由于目标很小且隐藏在与背景相似的环境下导致无法正确识别。而影响棉花识别的主要因素则是阳光直射。如图5c所示,圆圈中标识的棉花由于阳光直射时形成强烈反光,导致该区域未能正确识别。

图5 棉花及杂草识别效果图

3.3 ROI Pooling效果对比

为了提高小尺寸杂草的识别精度,本文没有采用FasterR-CNN原文中使用的ROI Pooling,而是使用了ROI Align(表1)。表2给出了使用ROI Pooling,IoU阈值取0.5时的识别结果。

表2 使用ROI Pooling棉花杂草识别结果

和表1中的数据进行比较后可以发现,使用ROI Pooling的方式对棉花这种大尺度的目标影响较小,但对于杂草这种尺度变化较大的目标识别率较低。

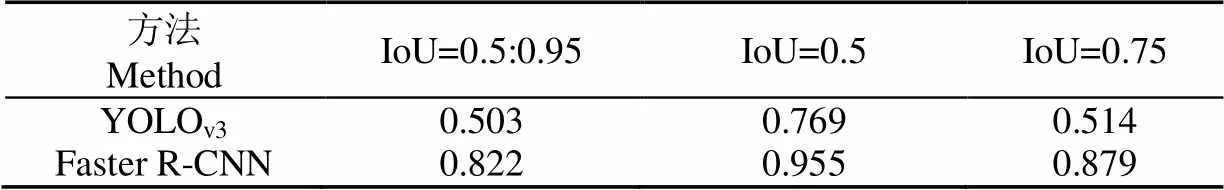

3.4 Faster R-CNN模型与YOLOv3模型效果对比

为了验证FasterR-CNN模型与YOLOv3模型的效果差异,本文选取相同样本数据集分别用YOLOv3和Faster R-CNN进行模型训练,YOLOv3同样使用ImageNet数据集初始化网络参数,最后使用评价指标AP,AR和值对比测试效果。

AP和AR两个指标评测的核心是实际真实对象和预测对象之间的相似性度量。在进行目标对象检测时,借助IoU定义真实对象与预测对象之间的匹配度,通过计算绘制PR(precision-recall) 精度召回曲线。表3给出了YOLOv3和Faster R-CNN相同样本数据集下的检测结果,图6a给出了棉花在2种模型下的精度召回曲线,图6b给出了杂草在2种模型下的精度召回曲线。

图6 棉花和杂草的精度召回曲线

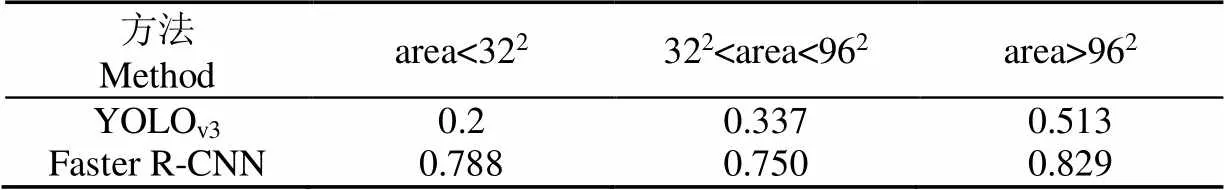

平均准确率AP衡量的是模型在所有目标类别上的性能,分析表3到表5的数据可以发现,Faster R-CNN相对于YOLOv3来说,当IoU取值为0.5:0.95,0.5和0.75时,平均准确率AP高出0.3以上。特别是对于小目标对象,其平均准确率之差接近0.6。平均召回率AR是在每幅图像中检测到固定目标的召回率,在目标类别和IoU域内上取平均值。Faster R-CNN性能优于YOLOv3模型。

表3 在参数 area= all, max Dets=100时AP值比较

表4 在参数 max Dets=100, IoU=0.50:0.95时AP值比较

表5 在参数 max Dets=100, IoU=0.50:0.95时AR值比较

在表3~表5中,area指被检测对象的图像面积,当此值为all时表示统计时不区分图像面积。max Dets为每个图像的最大检测阈值。

精度召回曲线图直观显示出学习器在样本总体上的查全率和查准率。在进行比较时,当一个学习器的P-R曲线完全被另一个学习器的曲线完全“包住”,就说明后者的性能优于前者。观察图6的精度召回曲线可以发现,Faster R-CNN的精度召回曲线可以完全包围YOLOv3的精度召回曲线。仔细观察发现当召回率为0.6时,此时,Faster R-CNN中的棉花和杂草的精度达到99%以上,而YOLOv3中杂草识别的精度下降到50%,棉花识别精度接近95%。随着召回率的增加,Faster R-CNN模型中准确率一直维持在一个很高的水平,而性能比较差YOLOv3模型需要损失较大精度才能换来召回率的提高。

准确率和召回率指标在某些情况下出现矛盾情况,所以需要综合考虑。为此,本文选用值进行衡量。值是和加权调和平均,计算公式为

迭代次数与F值的关系曲线如图7所示。

观察图7可知,Faster R-CNN方法的值曲线始终处于上方,说明FasterR-CNN试验方法比较理想。

综上所述,试验结果证明了Faster R-CNN模型对复杂环境下棉田杂草图像检测的有效性,该方法对于杂草和棉花的识别效果优于YOLOv3模型,尤其在识别尺度较小的杂草目标对象时Faster R-CNN模型性能远超YOLOv3模型。

3.5 Faster R-CNN模型与YOLOv3时间对比

选取相同的700幅样本图像分别用YOLOv3和FasterR-CNN进行模型训练,再用200幅测试图像进行识别测试,表6给出2种模型的运行时间比较,从表中数据可知,YOLOv3的训练时长要高于Faster R-CNN,但识别速度并没有明显差异。

表6 Faster R-CNN与YOLOv3运行时间比较

4 结 论

本研究将Faster R-CNN和YOLOv3引入到棉田杂草的识别中,比较了2种方法的优劣,并对Faster R-CNN的关键参数进行了优化,使之更适合复杂背景下的棉田杂草识别。

1)建立ResNet50网络模型从原始图像中提取棉花和杂草特征。该模型不依赖于图像预处理和数据转换,可通过学习自主提取棉花和杂草的特征表达,与人工设计提取的多种特征相比,能更准确地反映出棉花与杂草图像的有效识别信息。试验结果表明,该方法的平均目标识别准确率达95.5%,具有优秀的实际泛化性能,获得了稳定的高识别准确率。

2)本文提出的改进Faster R-CNN识别棉田杂草方法,与YOLOv3相比更适用于复杂背景下的棉田杂草识别,试验结果表明平均正确率MAP高出0.3以上。特别是对于小目标对象,其平均正确率之差接近0.6。

3)基于FasterR-CNN模型识别棉田杂草方法识别方法具有较强的实时性。试验结果表明,使用CPU识别一帧图像仅需1.51 s。采用GPU硬件代替CPU运算还可进一步提升本文方法的实时性,识别单幅图像的平均耗时仅为0.09 s。

本研究提出的FasterR-CNN模型识别棉田杂草方法能够获得较高的准确率和实时性,可为变量喷药等精准农业技术提供有益的参考。不足之处在于Faster R-CNN模型所需的训练时间较长,训练需要在GPU显存大于8G的条件下训练数据。但训练好后不影响实际测试的识别速度。在下一步的研究工作中还需要在识别杂草的基础上进一步识别确定杂草的种类。

[1] 张树珍. 棉田杂草的发生与防治措施[J]. 现代农业科技,2017(7):136-139.

[2] 杨林章,冯彦房,施卫明,等. 我国农业面源污染治理技术研究进展[J]. 中国生态农业学报,2013,21(1):96-101.

Yang Linzhang, Feng Yanfang, Shi Weiming, et al. Review of the advances and development trends in agricultural non-pointsource pollution control in China[J]. Chinese Journal of Eco-Agriculture, 2013, 21(1): 96-101. (in Chinese with English abstract)

[3] 牛丛,徐丽明,马帅,等. 变量喷药技术的应用现状与发展[J]. 农业装备与车辆工程,2018,56(12):1-4.

Niu Cong, Xu Liming, Ma Shuai, et al. Application and development of variable spray technology[J]. Agricultural Equipment & Vehicle Engineering, 2018, 56(12): 1-4. (in Chinese with English abstract)

[4] 尹东富,陈树人,毛罕平,等. 基于模糊控制的棉田变量对靶喷药除草系统设计[J]. 农业机械学报,2011,42(4):179-183.

Yin Dongfu, Chen Shuren, Mao Hanping, et al. Weed control system for variable target spraying based on fuzzycontrol[J]. Transactions of the Chinese Society for Agricultural Machinery, 2011, 42(4): 179-183. (in Chinese with English abstract)

[5] Bakhshipour A, Jafari A, Nassiri S M, et al. Weedsegmentation using texture features extracted from wavelet sub-images[J]. Biosystems Engineering, 2017, 157: 1-12.

[6] 张小龙,谢正春,张念生,等. 豌豆苗期田间杂草识别与变量喷洒控制系统[J]. 农业机械学报,2012,43(11):220-225,73.

Zhang Xiaolong, Xie Zhengchun, Zhang Niansheng, et al. Weed recognition from pea seedling images and variablespraying control system[J]. Transactions of the Chinese Society for Agricultural Machinery, 2012, 43(11): 220-225, 73. (in Chinese with English abstract)

[7] 李先锋,朱伟兴,纪滨,等. 基于图像处理和蚁群优化的形状特征选择与杂草识别[J]. 农业工程学报,2010,26(10):178-182.

Li Xianfeng, Zhu Weixing, Ji Bin, et al. Shape featureselection and weed recognition based on image processingand ant colony optimization[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2010, 26(10): 178-182. (in Chinese with English abstract)

[8] Zheng Y, Zhu Q, Huang M, et al. Maize and weedclassification using color indices with support vector datadescription in outdoor fields[J]. Computers and Electronics in Agriculture, 2017, 141: 215-222.

[9] 李颖,张立福,严薇,等. 地面成像光谱数据的田间杂草识别[J]. 遥感学报,2013,17(4):863-871.

Li Ying, Zhang Lifu, Yan Wei, et al. Weed identification using imaging spectrometer data[J]. Journal of Remote Sensing, 2013, 17(4): 863-871. (in Chinese with English abstract)

[10] 赵鹏,韦兴竹. 基于多特征融合的田间杂草分类识别[J].农业机械学报,2014,45(3):275-281.

Zhao Peng, Wei Xingzhu. Weed recognition in agricultural field using multiple feature fusions[J]. Transactions of the Chinese Society for Agricultural Machinery, 2014, 45(3): 275-281. (in Chinese with English abstract)

[11] 何东健,乔永亮,李攀,等. 基于SVM-DS多特征融合的杂草识别[J]. 农业机械学报,2013,44(2):182-187.

He Dongjian, Qiao Yongliang, Li Pan, et al. Weed recognition based on SVM-DS multi-feature fusion[J]. Transactions of the Chinese Society for Agricultural Machinery, 2013, 44(2): 182-187. (in Chinese with English abstract)

[12] 朱凤武,杨建姣,齐迹. 基于遗传算法的田间生物环境系统的研究[J]. 中国农机化学报,2016,37(12):157-160.

Zhu Fengwu, Yang Jianjiao, Qi Ji. Study of field biological environment system based on genetic algorithm[J]. Journal of Chinese Agricultural Mechanization, 2016, 37(12): 157-161. (in Chinese with English abstract)

[13] 权龙哲,肖云瀚,王建宇,等. 智能除草装备苗草模式识别方法研究[J]. 东北农业大学学报,2018,49(9): 79-87.

Quan Longzhe, Xiao Yunhan, Wang Jianyu, et al. Study on pattern recognition method of intelligent weeding equipment[J]. Journal of Northeast Agricultural University, 2018, 49(9): 79-87. (in Chinese with English abstract)

[14] 吴兰兰,徐恺,熊利荣. 基于视觉注意模型的苗期油菜田间杂草检测[J]. 华中农业大学学报,2018,37(2):96-102.

Wu Lanlan, Xu Kai, Xiong Lirong. Detecting weed in seedling rapeseed oil field based on visual-attention model[J]. Journal of Huazhong Agricultural University, 2018, 37(2): 96-102. (in Chinese with English abstract)

[15] 傅隆生,冯亚利,Elkamil Tola,等. 基于卷积神经网络的田间多簇猕猴桃图像识别方法[J]. 农业工程学报,2018,34(2):205-211.

Fu Longsheng, Feng Yali, Elkamil Tola, et al. Image recognition method of multi-cluster kiwifruit infield based on convolutional neural networks[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(2): 205-211. (in Chinese with English abstract)

[16] 王璨,武新慧,李志伟. 基于卷积神经网络提取多尺度分层特征识别玉米杂草[J]. 农业工程学报,2018,34(5):144-151.

Wang Can, Wu Xinhui, Li Zhiwei. Recognition of maize and weed based on multi-scale hierarchical features extracted byconvolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(5): 144-151. (in Chinese with English abstract)

[17] 姜红花,王鹏飞,张昭,等. 基于卷积网络和哈希码的玉米田间杂草快速识别方法[J]. 农业机械学报,2018,49(11):30-38.

Jiang Honghua, Wang Pengfei, Zhang Zhao, et al. Fast identification of field weeds based on deep convolutional network and binary hash code[J]. Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(11): 30-38. (in Chinese with English abstract)

[18] 熊俊涛,刘振汤,林越,等. 自然环境下绿色柑橘视觉检测技术研究[J]. 农业机械学报,2018,49(4):45-52.

Xiong Juntao, Liu Zhentang, Lin Yue, et al.Visual detection technology of green citrus under natural environment[J]. Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(4): 45-52. (in Chinese with English abstract)

[19] 王生生,王顺,张航,等. 基于轻量和积网络及无人机遥感图像的大豆田杂草识别[J]. 农业工程学报,2019,35(6):81-89.

Wang Shengsheng, Wang Shun, Zhang Hang, et al. Soybean field weed recognition based on light sum-productnetworks and UAV remote sensing images[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactionsof the CSAE), 2019, 35(6): 81-89. (in Chinese with English abstract)

[20] Liu Wei, Anguelov Dragomir, Erhan Dumitru, et al. SSD: single shot multibox detector[C]. Computer Vision ECCV 2016, Springer, Cham, 2016(C): 21-37.

[21] Redmon, Joseph. You only look once: unified, real-time object detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, NV, USA, 2016: 779-788.

[22] Redmon, Joseph. YOLO9000: Better, Faster, Stronger[J]. arXiv, 2016,1612.08242.

[23] Joseph Redmon, Ali Farhadi. YOLOv3: An incremental improvement[J]. arXiv, 2018,1804.02767.

[24] He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Deep residual learning for image recognition[C]. IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, NV, USA, 2016: 770-778.

[25] Ren S, He K, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(6): 1137-1149.

[26] Lin T, Dollar P, Girshick R, et al. Feature pyramid networks for object detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, Hawaii, USA, 2017: 936-944.

[27] He Kaiming, Gkioxari Georgia, Dollar Piotr, et al. Mask R-CNN[C]. IEEE International Conference on Computer Vision, Venice, Italy, 2017: 2980-2988.

[28] Yang You, Igor Gitman, Boris Ginsburg. Large batch training of convolutional networks[J]. arXiv, 2017, 1708.03888.

[29] Yang You, Zhao Zhang, Cho-Jui Hsieh, et al. ImageNet Training in Minutes[J]. arXiv, 2018,1709.05011.

[30] Chao Peng, Tete Xiao, Zeming Li, et al. MegDet: A large mini-batch object detector[C]. IEEE Conference on Computer Vision and Pattern Recognition, UTAH, USA, 2018: 6181-6189.

[31] Jan Hosang, Rodrigo Benenson, BerntSchiele. Learning non-maximum suppression[C]. IEEE Conference on Computer Visionand Pattern Recognition. HI, USA, 2017: 6469-6477.

Efficient recognition of cotton and weed in field based on Faster R-CNN by integrating FPN

Peng Mingxia1, Xia Junfang2※, Peng Hui1

(1.4300070; 2.4300070)

Cotton (Gossypium hirsutum) is one of the most important cash crops in China, The timely and effective removal of weeds in cotton seedling stage is an important measure to ensure high and stable yield of cotton. Nowadays, weed recognition based on machine vision is widely used. The fast and effective recognition of crop and weed in the field under natural illumination is one of the key technologies for the development of intelligent mechanization weeding pattern. In the one hand, cotton and weeds have similar color feature in the field. Feature presentation of the natural property of target is difficult to be obtained by the hand-engineered feature extractor. The spatial consistency of the obtained features is not good, and the real-time performance of recognition system is reduced for the complex feature extraction algorithm. On the other hand, the effect of image preprocessing has important influence on recognition results. In order to solve the main problems in the current research, we explored the way to improve the recognition accuracy, stability and real-time performance, and a recognition method of crop and weed based on Faster R-CNN.In this paper, cotton seedling at 2-5 leaves stages and weeding during the same stage were used as research objects under natural illumination. Weed identification from digital images taken under natural illumination at field level is still challenging in agricultural image processing applications, though a lot of research has been conducted related to this topic. To address this problem, images including cottons and weeds were taken vertically from top to bottom. A method based on Faster R-CNN convolutional neural network was proposed to identify weeds from cotton plants more accurately and quickly. The residual network was used to extract image features, with ReLU as the activation function and Max-pooling as the down-sampling method. In the region of proposal network, feature pyramid network was introduced to generate target candidate frame, and Softmax regression classifier was utilized to optimize the CNN network. The proposed methodology was implemented on 200 digital images taken under natural illumination. The experimental results demonstrated that, the average accuracy of weed identification reached 95.5%, and the average time for individual weed plant identification was 1.51 s, which was reduced to 0.09 s by using GPU. To test the efficiency of the proposed methodology, YOLOv3method was also carried out on the same training and test datasets. The weed identification results were assessed by mean average precision and average precision. The experimental results showed that better performance was achieved by using our proposed methodology, and better identification accuracy was reached as well. This indicated that the proposed method had a good effect on weed detection under natural illumination, and it will greatly promote the development of precise weed control.

cotton; convolutional neural network; machine vision; deep learning; image recognition; weed recognition; Faster R-CNN

彭明霞,夏俊芳,彭 辉. 融合FPN的Faster R-CNN复杂背景下棉田杂草高效识别方法[J]. 农业工程学报,2019,35(20):202-209.doi:10.11975/j.issn.1002-6819.2019.20.025 http://www.tcsae.org

Peng Mingxia, Xia Junfang, Peng Hui. Efficient recognition of cotton and weed in field based on Faster R-CNN by integrating FPN [J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(20): 202-209. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2019.20.025 http://www.tcsae.org

2019-04-17

2019-09-24

国家重点专项项目(2017YFD0301303);公益性行业(农业)科研专项项目(201503136)

彭明霞,博士生,主要从事农业信息技术集应用研究。Email:skymingxia@mail.hzau.edu.cn

夏俊芳,教授,博士生导师,主要从事农业精细农业装备和机械设计技术。Email:xjf@mai.hzau.edu.cn

10.11975/j.issn.1002-6819.2019.20.025

TP274; TP391.41

A

1002-6819(2019)-20-0202-08