基于改进时空步态图的步态识别

蒋敏兰,吴 颖,陈昊然

(浙江师范大学 物理与电子信息工程学院,浙江 金华 321001)

0 引言

步态识别是根据不同个体间的步态差异进行身份识别的技术,可实现远距离、隐蔽的身份识别,在智能视频监控领域应用广泛[1]。步态识别的性能主要取决于步态特征的提取和分类器的选择,所以在研究步态特征时,如何最大化提取行人步态运动中的动态特征和静态特征,是提高步态识别准确率的关键。

目前,已有的步态识别方法分为基于模型和基于图像两种[1]。基于模型的步态识别方法[2-9]主要根据人体结构对下肢步态运动进行建模。这类方法直接使用人体静态或关节点动态变化参数作为步态特征,在一定程度上能处理遮挡和噪声。该方法首先要准确定位人体关节点的位置,以关节点间的规律变化作为区分身份的重要特征。而仅依赖步态轮廓图的关节点定位容易受到图像噪声影响,且建模过程时间长、复杂,很难抽取出步态运动的本质。基于图像的步态识别方法[10-19],主要对人体步态图像的二值化轮廓、外形原始图像等进行特征提取从而进行身份识别。但基于图像的步态识别方法忽略了步态运动中身体各关节点规律变化的特征,当改变视角导致步态轮廓发生一定程度的形变时,能直接影响步态识别精度。显然基于图像的步态识别方法在简单条件下识别精度较高且计算简单,而在视角或携带物品发生改变等复杂环境下鲁棒性还不够。

基于图像的步态识别方法在一定条件下识别精度高、计算高效,在一定程度上优于基于模型的方法。但是在解决遮挡、跨视角等复杂环境下,基于模型的步态识别方法有着明显的优势。所以,针对基于图像步态识别复杂环境下准确率低,而基于模型步态识别平均准确率低、效率不高的问题,本文将基于模型和图像的步态识别方法结合起来,提出一种改进时空步态图及特征融合策略,结合机器学习算法进行步态识别研究。

1 关节点定位及动态特征

基于模型的步态识别方法是最早应用在步态识别上的方法之一,通过分析人体结构及步态运动中姿态的周期性变化,将人体各部分简单地分成躯干、四肢、头等几部分,如五连杆步态模型。近年来大量学者不断优化关节定位算法,提高在步态轮廓图上关节点定位精度。在此基础上若对整个步态轮廓图建模,提取全身主要关节点作为步态特征显然效率低下,且未区分最具表征性步态特征。而步态运动主要活动区域在下肢,因此,本文仅对下肢简单建模,抽取下肢主要关节点作为主要步态特征。通过优化基于模型的步态特征,以解决下肢动态特征维度不足的问题。

1.1 下肢关节定位

假设人体高度为H,根据人体解剖学原理,髋关节的纵坐标为从头顶往下0.47H的高度,记为y0。在0.47H处横向扫描得到人体轮廓宽度L,则髋关节的横坐标为L/2,记为x0,即髋关节坐标为(x0,y0)。

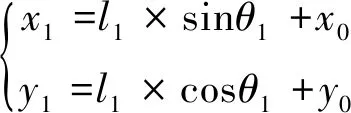

膝关节点:人行走过程中,大腿上半部分可以看作围绕髋关节点做前后钟摆运动[16]。因此,根据膝关节运动轨迹,圆心为髋关节坐标;半径为大腿上半部分长l1,其长度为0.245H。由以下公式计算膝关节横、纵坐标[16]:

(1)

(2)

其中,(x1,y1)、(x2,y2)分别为左右膝关节的横、纵坐标,θ1、θ2为髋关节、左右膝关节间直线段与竖直方向的夹角,l1为大腿上半部分长度。膝关节定位如图1(a)所示,以髋关节(x0,y0)为圆心,从左往右做向下半圆扫描,当第一次碰到像素点为大于100可标记为左脚膝关节外边缘,第二次碰到大于100可标记为左脚膝关节内边缘,取内外两坐标的平均值,即可得到左膝关节坐标。同理可得到右膝关节坐标。为了便于区分,将左膝关节坐标标记为(x1,y1),右膝关节坐标标记为(x2,y2)。

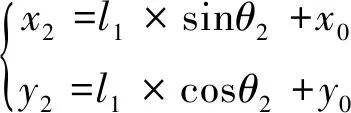

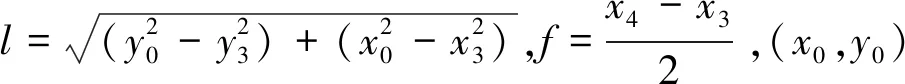

踝关节点:与膝关节定位原理相同,人体行走时,小腿以膝关节为轴心、小腿长(0.246H)为半径做圆周摆运动。以此确定踝关节坐标。同样踝关节也分为左右关节。采取以左膝关节(x1,y1)为圆心,从左往右做向下半圆扫描,当第一次碰到像素点为大于100可标记为左脚踝关节外边缘,第二次碰到大于100可标记为左脚内边缘,取内外两坐标的平均值,即可得到左踝关节坐标。同理可得到右踝关节坐标。为了便于区分,将左踝关节坐标标记为(x3,y3),右踝关节坐标标记为(x4,y4),可采用画圆弧的方法定位踝关节。

(3)

(4)

公式(3)为左踝关节的表达式,(x1,y1)为左膝关节的横、纵坐标,θ3为左膝关节、左踝关节间直线段与竖直方向的夹角,l2为小腿长度。同理公式(4)中,(x2,y2)为右膝关节的横、纵坐标,θ4为右膝关节、右踝关节间直线段与竖直方向的夹角,l2为小腿长度。踝关节定位如图1(b)所示。

1.2 动态特征

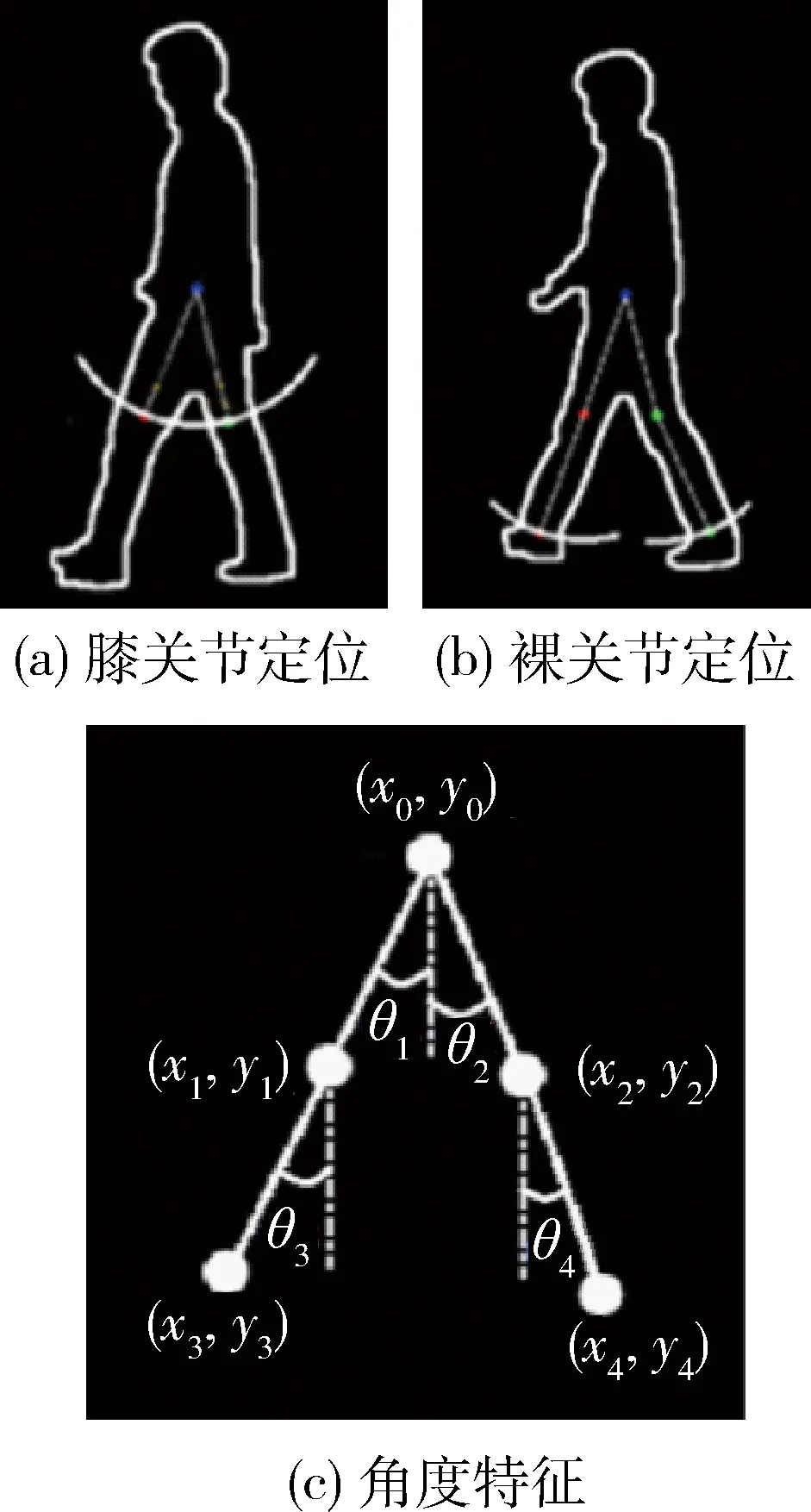

如图1(c)所示,获得关节点信息后,文献[13-15]中分别提取关节点间四个角度θ1,θ2,θ3,θ4作为步态运动中的动态特征。

(5)

图1 下肢关节定位示意图

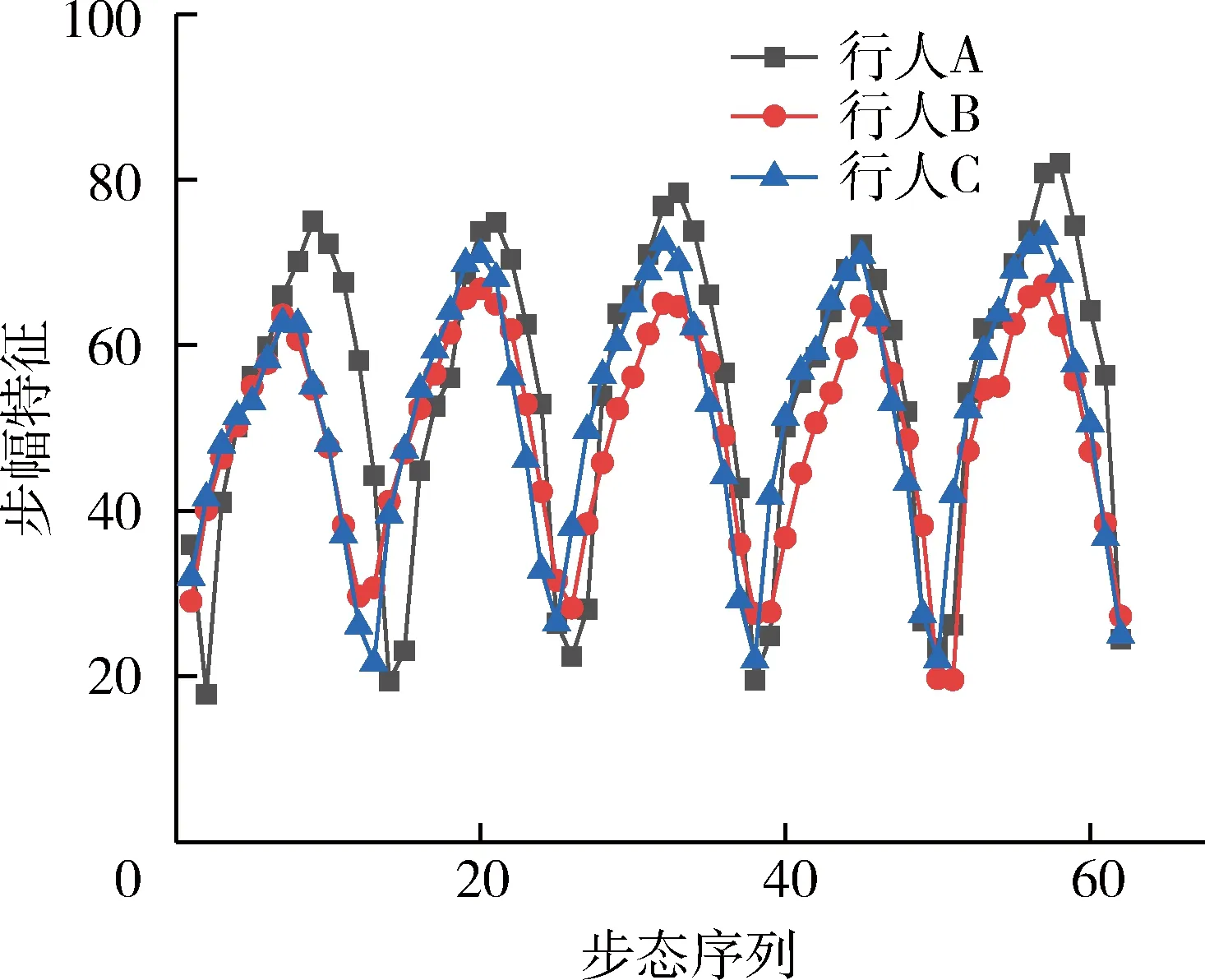

因每个人的身高差异且行走习惯等不同,导致人在步态运动中,不同的人步幅的差异相比于其他关节点间角度的变化更为明显,而髋关节与左右踝关节间的角度能直接反映出步幅状态。具体如图2所示,不同行人A,B,C在一段序列上的步幅特征有着明显的差异(为了效果更加明显取的步态序列更长),故本文在动态特征θ1,θ2,θ3,θ4的基础上加入髋关节与左右踝关节的角度θ5,以构成一个新的动态特征集:S= [θ1,θ2,θ3,θ4,θ5]。其中,

(6)

图2 不同行人的步幅特征

2 改进时空步态图

2.1 步态模板

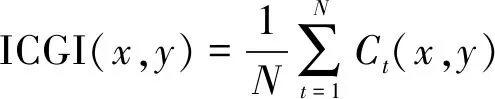

不同于人脸、指纹等其他生物识别特征,人的步态运动特征可以看成身体上各个部分规律运动的集合。所以不能以单张步态轮廓图作为识别的样本。因此,文献[8]首次提出可以用一个综合步态模板GEI来代表一段步态序列,GEI通过将周期内的步态轮廓图平均叠加所得,合成效果如图3(a)所示。GEI不仅能减少步态轮廓噪声带来的影响,还保留了原人体静态特征且计算高效,取得了不错的效果。CGI则借鉴GEI的思想,首次将时序信息以伪色彩的形式加入步态模板,合成效果如图3(b)所示,与GEI相比取得了更好的效果。通过对比效果图3(a)、图3(b),GEI与CGI均依赖于步态轮廓,对于视角、携带物引起的轮廓形变仍然识别精度不高,而基于模型的关节动态特征能有效克服遮挡、跨视角的影响。因此,有必要引入人体建模的思想,将时序特征和下肢关节点动态特征结合起来,在步态模板增加时序信息的同时,能突出下肢关节点间的规律变化。那么由此所合成的步态模板是否更具鲁棒性,本文从这点出发,对改进时空步态模板展开研究。

2.2 改进时空步态图

基于GEI和CGI两类步态模板的局限性,本文希望以伪色彩突出步态模板时序信息的基础上,引入下肢关节点动态特征。延续文献[11]中利用伪色彩描述时序的思想,提出一种改进时空步态图,将时序信息以彩色线条的形式加在关节点间,在加入时序信息的基础上,更加突出关节点在步态运动过程中的规律变化。具体做法为:将通过建模获得的下肢关节点定位信息,并把髋关节和左、右膝、踝关节的距离连线,通过伪色彩编码技术,将关节间连线编码画成不同颜色,以获得关节间包含时空信息的改进时空步态图。伪色彩映射公式如式(7)所示:

(7)

其中,Rkt,Gkt,Bkt分别为单帧步态图中的红、绿、蓝三个颜色分量,kt= (Wt-Wmin)/(Wmax-Wmin),Wi表示两条腿分开的程度,Wmax、Wmin表示一个周期内两条腿分开的最大距离和最小距离,I为像素的最大值255。编码后的第t帧图像Ct(x,y)可以表示为:

(8)

其中,L为髋关节与膝、踝关节间的连线,改进时空步态图ICGI(x,y)可定义为:

(9)

其中,ICGI(x,y)为改进后周期内时空步态图,N为一个周期内轮廓图片的数量,Ct(x,y)表示t时刻编码后的步态轮廓图。合成ICGI的整个过程如图3(a)所示。为了区别与步态能量图(GEI)、时空步态图(CGI)的不同,本文列出了GEI与CGI的合成过程,如图3(b)、3(c)所示。

图3 步态模板合成图

3 基于改进时空步态图的步态识别

3.1 特征融合

改进时空步态图在加入时序信息的基础上,引入了关节点动态特征,由此获得的步态模板显然包含更丰富的动态特征。而通过基于图像特征提取方法,仅是对改进后步态模板轮廓、边缘、伪色彩线条等特征进行提取,较原步态模板增加了一定的时序特征、动态特征,一定程度上提高了步态识别平均精度。但单纯依靠图像特征提取算法显然无法完全理解加入的动态特征,故有必要融合基于模型提取到的下肢动态特征,构建一个更加丰富且有效的特征集,来提高各种环境下步态识别的平均精度。

3.2 分类器

k近邻法(KNN)是一种简单高效的分类算法,其基本思想是:所给定一个测试样本在特征空间上K个最接近的样本中的大多数属于某一个类别,则该样本被划分为这一类别。基于改进时空步态图特征融合模型和KNN的步态识别分类的步骤如下:

(1)将实验数据集划分为两类:训练数据集、测试数据集。

(2)读取训练、测试数据集,分别提取两类数据集中的样本(图像尺寸为M×N×3,则转化成三个M×N矩阵分别提取特征降维处理),同时取出关节点间的动态特征集S,将RGB三通道处理后的子特征集V1、V2、V3与S级联形成一个综合特征集,以行的形式存入特征矩阵中。遍历处理所有训练集。

(3)设置K值(低于测试数据集某类样本数)。

(4)读取测试数据集合,重复步骤(2),遍历测试集合,并存入测试特征矩阵中。

(5)遍历训练特征矩阵和测试特征矩阵,计算出与测试特征矩阵中每一个样本相似的K个训练特征样本,其中K个样本中标签的多数类,即为该测试样本的类别。

(6)统计完测试集中每类样本的标签,与原标签进行对比,遍历每个测试样本统计正确率。

4 实验

本次实验数据集采用中科院自动化所公开的大型步态数据库CASIA-B。该数据库包含 124人(男93人,女31人),每人11个视角(0°,18°,36°,54°,72°,90°,108°,126°,144°,162°,180°),每个视角下有 3种行走状态(正常状态、大衣状态、背包状态)。

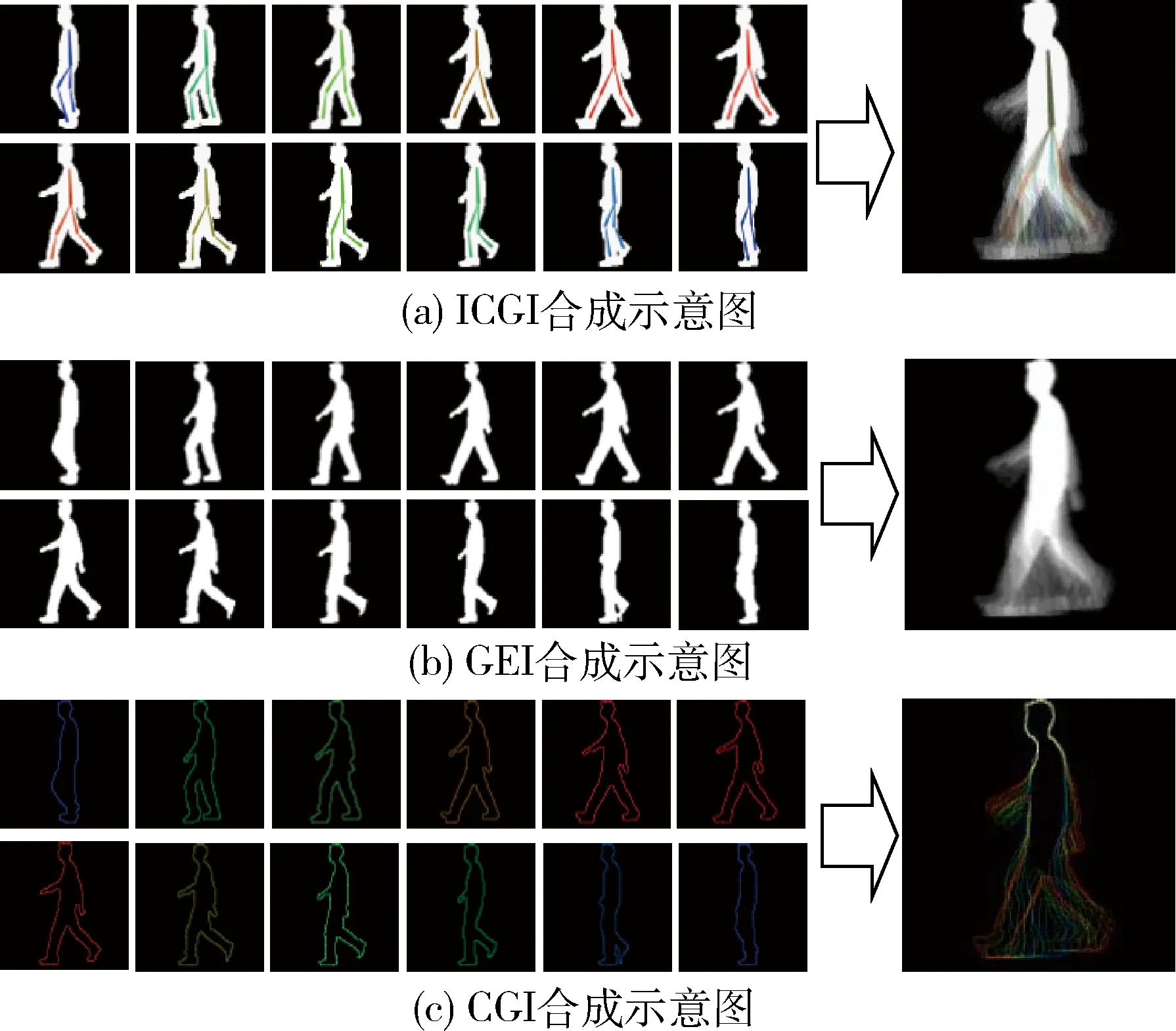

(1)基于改进时空步态图对比实验

为了验证所提改进步态模板的有效性,将步态模板直接结合KNN,对比改进步态模板前后的识别效果。在正常状态36°~144°视角不变情况下进行步态识别对比实验。实验结果如图4所示,表明改进时空步态图能有效提高步态识别精度。

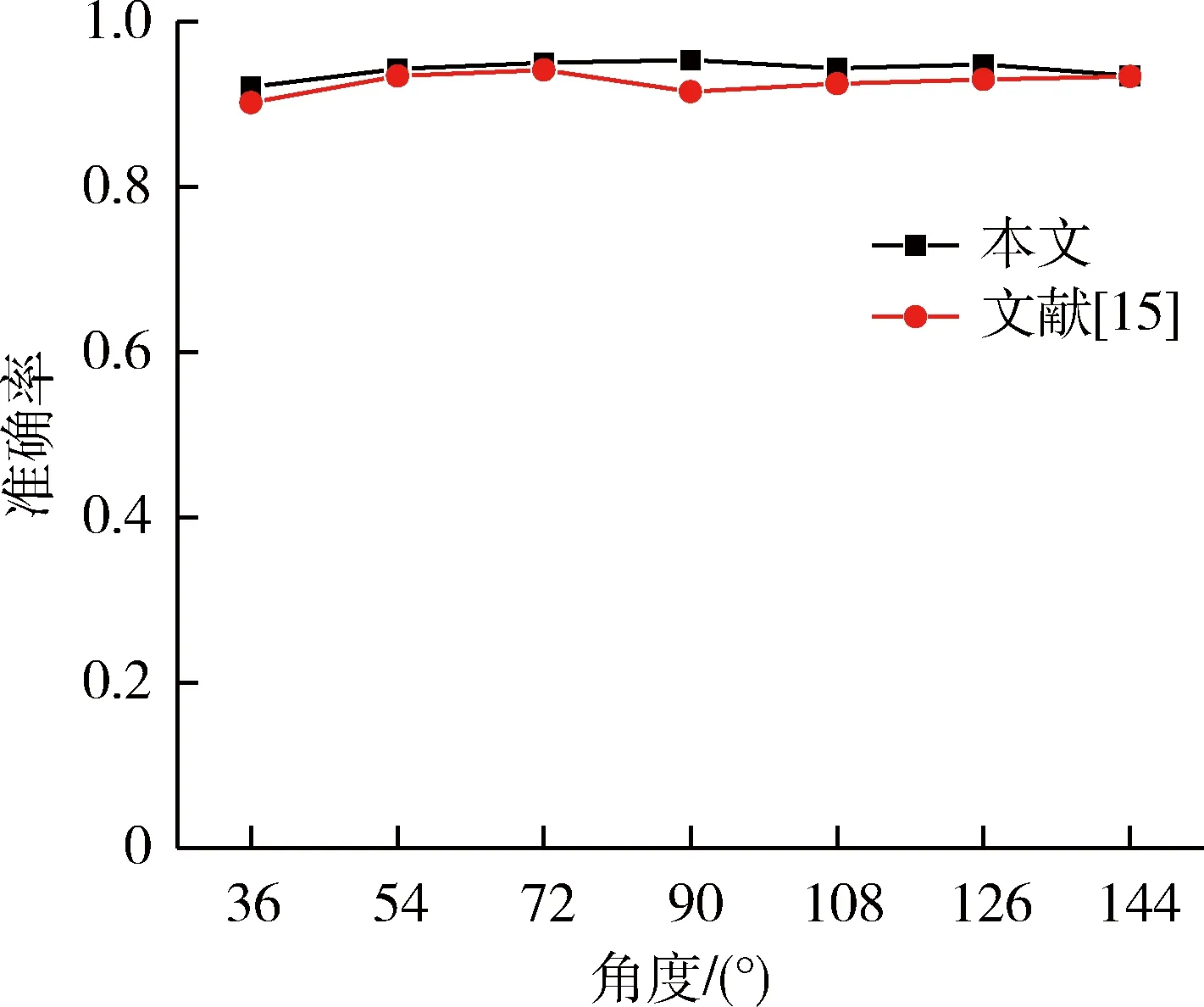

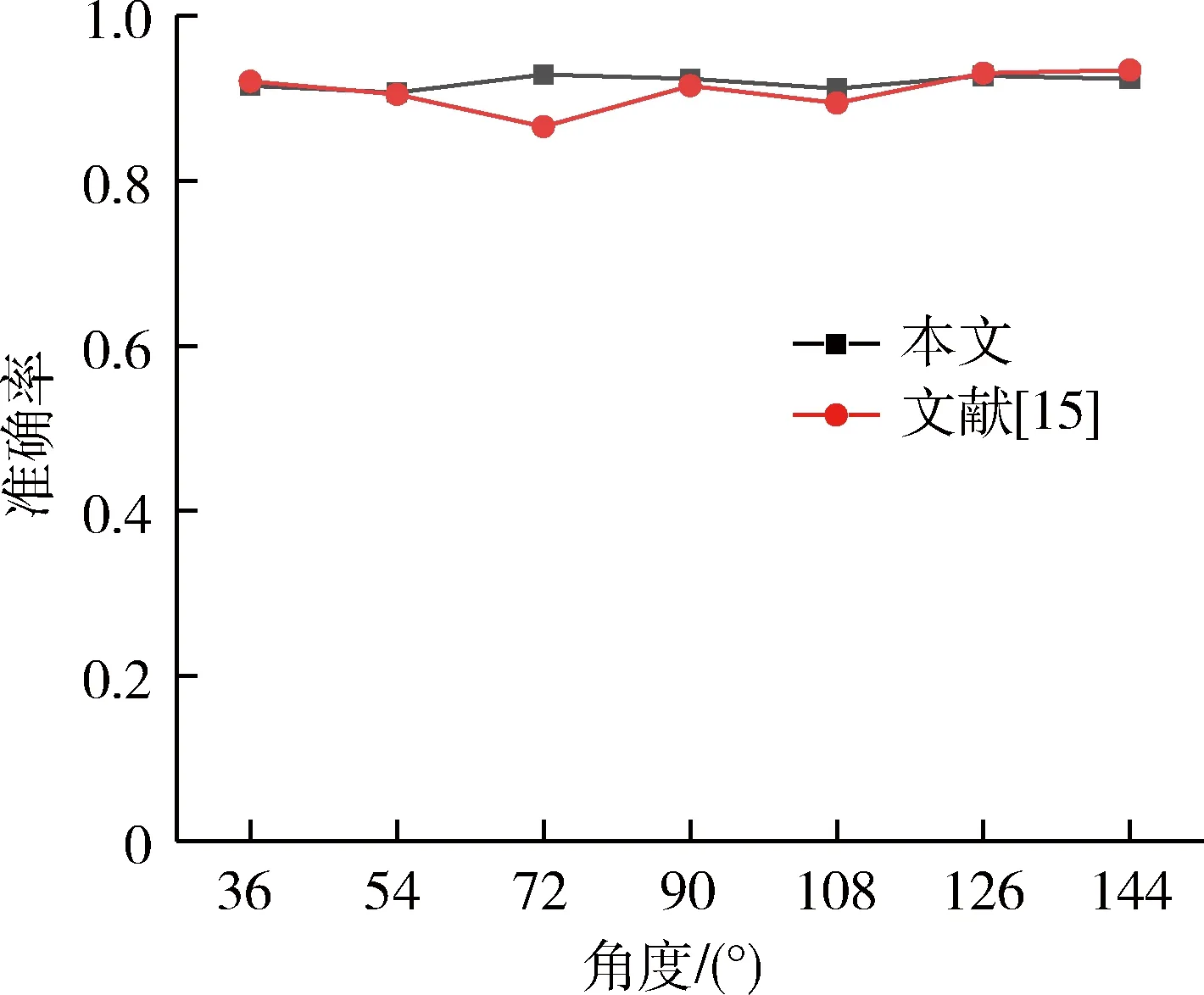

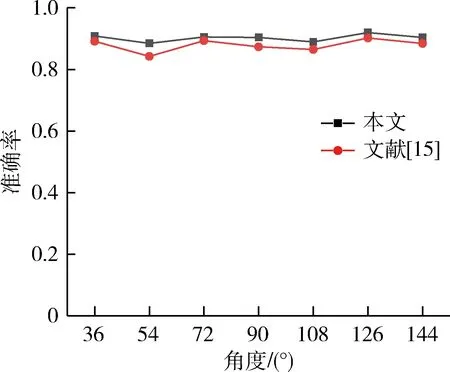

(2)特征融合后步态识别对比实验

为了验证融合特征后在复杂环境下步态识别的有效性,实验分别设置正常状态、大衣状态、背包状态下训练集36°~144°视角下步态序列(不包含测试视角),测试集为36°~144°视角下步态序列。同时加入了文献[15]实验数据进行对比。实验结果如图5~图7所示,表明所提方法能有效提高视角发生变化时的步态识别精度。

图4 改进步态模板对比实验

图5 特征融合后正常状态对比实验

图6 特征融合后背包状态对比实验

图7 特征融合后大衣状态对比实验

5 结论

本文针对基于图像步态识别中时空步态图(CGI)、步态能量图(GEI)的不足,结合步态过程中下肢关节点间规律运动的现象,提出一种改进时空步态图(Improved Chrono Gait Energy Image,ICGI)。将伪色彩映射到下肢关节间,在原有加入时序信息的基础上,引入关节点间动态特征,最大限度地保留步态模板内部动态信息。通过在CASIA-B数据集上的对比实验,表明基于ICGI的步态识别相比CGI、GEI精度更高。同时结合基于模型和基于图像步态识别的优势,提出一种特征融合策略。将关节间动态特征和基于ICGI步态图特征融合,结合KNN算法建立步态识别模型。实验表明,特征融合后的识别模型能有效提高跨视角步态识别精度。