基于改进RA-CNN的舰船光电目标识别方法

霍煜豪 徐志京

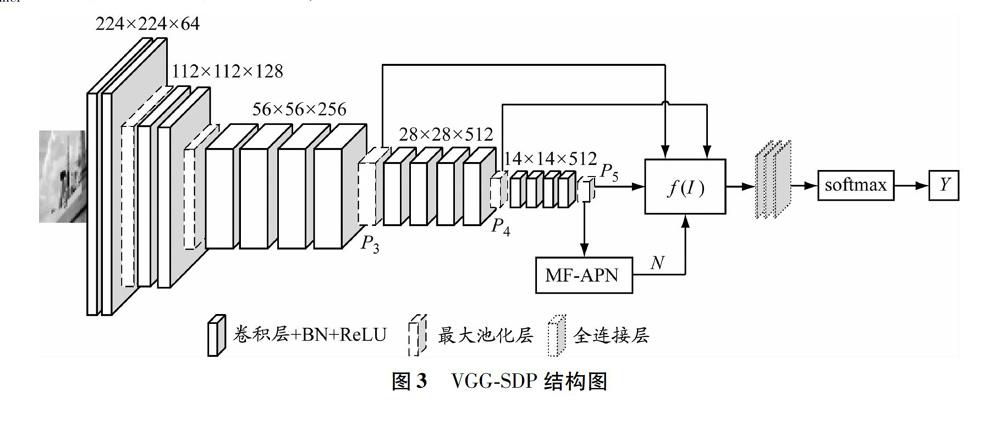

摘要:针对光电图像中舰船分类检测困难的问题,提出一种基于改进循环注意卷积神经网络(recurrent attention convolutional neural network,RA-CNN)的舰船目标识别方法。该方法中的VGG19采用多个卷积层提取图像特征,注意建议网络(attention proposal network,APN)通过全连接层的输出定位特征区域,然后采用尺度依赖池化(scale-dependent pooling,SDP)算法选择VGG19中合适的卷积层输出进行类别判定,最后引入多特征描述特征区域,交叉训练VGG19和APN来加速收敛和提高模型精度。利用自建舰船数据集对方法进行测试,识别准确率较VGG19和RA-CNN有较大提升,识别准确率最高可达86.7%。

关键词:舰船识别; 细粒度图像分类; 循环注意卷积神经网络(RA-CNN); 尺度依赖池化(SDP); 交叉训练

中图分类号: U674.7; TP391.413

文献标志码: A

Abstract: Aiming at the difficulty of classification and detection of ships in photoelectric images, a ship target identification method based on the improved recurrent attention convolutional neural network (RA-CNN) is proposed. The VGG19 in the method uses multiple convolutional layers to extract image features. The attention proposal network (APN) locates the feature region through the output of the fully connected layer, and then uses the scale-dependent pooling (SDP) algorithm to select the appropriate convolution in VGG19 for class determination. The multiple features are introduced to describe feature regions. The VGG19 and APN are cross-trained to accelerate the convergence and improve the accuracy. The method is tested using the self-built ship database of the model. The identification accuracy of the method is higher than that of VGG19 and RA-CNN, and the highest identification accuracy is 86.7%.

0 引 言

舰船光电图像是由不同成像系统观测得到的模拟或数字舰船图像。传统舰船光电图像多来源于卫星遥感观测系统,易受云层遮挡影响且观测角度均为俯视,鲁棒性和时效性都存在不足。现阶段随着无人机逐步发展,通过高性能机载光电设备获取舰船光电图像变得更加容易且更具时效性,清晰度也大幅提升,通过控制还可以获得舰船各种角度图像,在軍事侦察、预警等领域具有极为重要的应用价值。同时,由于船种繁多,同船种之间又派生出各种型号,相互之间差异细微,使得快速精准分辨舰船类别、及时预警出警成为一个研究难题。

鉴于以上所述舰船光电图像特点,将舰船分类归属于细粒度图像分类[1]范畴。国内外学者多通过深度学习技术解决舰船光电图像分类问题。目前主流的识别方法多采用卷积神经网络(convolutional neural network,CNN)提取图像特征[2]、定位目标位置并判别舰船种类,其主要可以分为强监督和弱监督两种分类方式[3]。

强监督分类方式不仅使用图像标签进行分类,还依赖目标标注框和部件标注点辅助网络学习特征。ZHANG等[4]提出了部件R-CNN(part region-CNN)算法,该算法基于部件R-CNN对部件模块分别进行识别最后综合判别目标类别。WEI等[5]提出了掩码CNN(mask-CNN)算法,通过全连接网络定位目标并将目标分割成两个mask联合判别。

弱监督分类方式仅依靠图像标签进行分类,精度比强监督分类方式有所下降,但无须额外信息。SIMON等[6]提出了Constellations算法,通过卷积操作得到特征图,根据特征图计算梯度确定位置和分类。LIN等[7]提出了双线性CNN(bilinear CNN)算法,

提出使用两个CNN网络分别完成定位和判别工作,相互优化提升整体识别效果。

2017年FU等[8]提出了循环注意CNN (recurrent attention CNN,RA-CNN)用以解决细粒度图像集的分类问题。该网络在CUB Birds、Stanford Dogs和Stanford Cars三个主流细粒度图像集上达到了最优水平,分别取得3.3%、3.7%和3.8%的准确率提升。然而,该网络不能很好利用图像全局信息,对特征区域形状选取单一,故本文提出一种改进的RA-CNN用来识别光电舰船目标。

1 RA-CNN模型简介

RA-CNN在结构设计上主要包含3个尺度的子网络,每个尺度子网络的网络结构相同,但网络参数不同且互相独立。每个尺度子网络都包含2种不同的网络,分别是分类网络——VGG19[9-10]和定位网络——注意建议网络(attention proposal network,APN)。分类网络提取输入图像的特征并进行分类;APN基于提取到的特征进行训练得到特征区域信息,再将特征区域裁剪出来并放大,作为第二个尺度子网络的输入,重复进行3次得到3个尺度子网络的输出结果,通过融合不同尺度子网络的结果判断细粒度图像的类别[11]。

該网络的优点在于通过多个尺度层结构让网络在学习过程中将学习重点逐步聚焦到特征区域。此外RA-CNN中有2个损失函数——分类损失函数和尺度间损失函数,通过交叉训练可使分类和定位网络相互促进学习,使损失更快地收敛。

细粒度图像之间相似度高、特征相近,对其进行标注需要专业知识与仔细评估,因此标注数据集需要大量时间和精力。RA-CNN在训练学习过程中为弱监督分类方式,只依赖图像标签进行类别判断而不需要数据集提供相应的bounding box信息来帮助网络定位特征区域[12]。同时RA-CNN中APN生成的特征区域形状固定,不利于网络对具有各种特殊几何外观的特征区域的学习。APN仅通过损失函数减少对VGG19的影响,忽略了定位后特征区域对VGG19的直接影响,因此本研究使用尺度依赖池化(scale-dependent pooling,SDP)算法[13]与多特征区域联合判别的办法改进系统模型。

2 系统模型

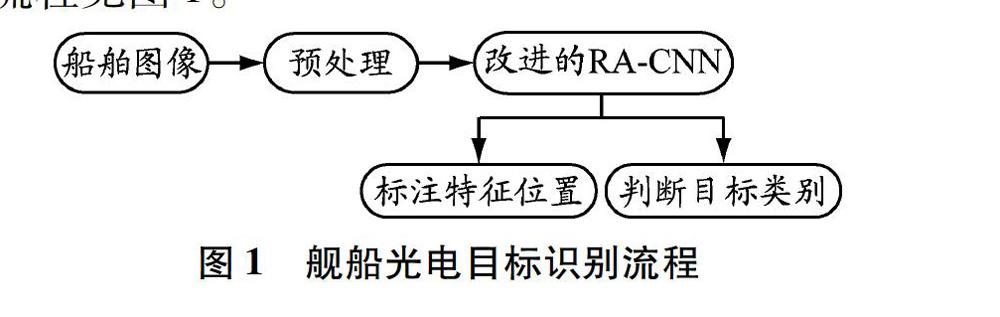

将预处理过的舰船光电图像送入训练好的神经网络进行检测,在输出图像中使用正方形框出舰船特征区域并在右上角显示其类别。舰船光电目标识别流程见图1。

4 结束语

本文基于细粒度检测网络RA-CNN提出了一种改进的用于智能区分不同舰船的方法。作为一种端到端的弱监督检测网络,无须训练集提供标注框即可进行训练。通过尺度依赖池化(SDP)算法让分类网络可以自适应地选择合适的池化输出,加强网络对于局部特征的学习能力。针对舰船特殊的几何外观特征提出MF算法,通过在图像中提取多个先验特征框综合描述特征区域,避免单一特征形状区域中包含与特征无关的背景部分,同时使用加权平均决策预测标签,加强矩形框影响力。采用BN、Dropout、改变学习率和预训练方式优化网络模型,加速网络训练收敛。结果表明,该方法可以高精度快速分类检测复杂背景下的舰船光电目标,为军事侦查和预警提供便利。

参考文献:

[1]ZHANG Xiaopeng, XIONG Hongkai, ZHOU Wengang, et al. Picking deep filter responses for fine-grained image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2016, IEEE: 1134-1142.DOI: 10.1109/CVPR.2016.128.

[2]IOFFE S, SZEGEDY C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]//32nd International Conference on Machine Learning, Lille 2015: 448-456.

[3]RADENOVIC' F, TOLIAS G, CHUM O. CNN image retrieval learns from BoW: unsupervised fine-tuning with hard examples[C]//European Conference on Computer Vision. ECCV 2016: 3-20.DOI: 10.1007/978-3-319-46448-0_1.

[4]ZHANG Ning, DONAHUE J, GIRSHICK R, et al. Part-based R-CNNs for fine-grained category detection[C]//European Conference on Computer Vision. ECCV 2014: 834-849.DOI: 10.1007/978-3-319-10590-1_54.

[5]WEI Xiu-Shen, XIE Chen-Wei, WU Jianxin, et al. Mask-CNN: localizing parts and selecting descriptors for fine-grained bird species categorization[J]. Pattern Recognition, 2018, 76: 704-714.DOI: 10.1016/j.patcog.2017.10.002.

[6]SIMON M, RODNER E. Neural activation constellations: unsupervised part model discovery with convolutional networks[C]//Proceedings of the IEEE International Conference on Computer Vision. ICCV 2015: 1143-1151.DOI: 10.1109/ICCV.2015.136.

[7]LIN Tsung-Yu, ROYCHOWDHURY A, MAJI S. Bilinear CNNs models for fine-grained visual recognition[C]//Proceedings of the IEEE International Conference on Computer Vision. ICCV 2015: 1449-1457.DOI: 10.1109/ICCV.2015.170.

[8]FU J, ZHENG H, MEI T. Look closer to see better: recurrent attention convolutional neural network for fine-grained image recognition[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). CVPR 2017: 3.DOI: 10.1109/CVPR.2017.476.

[9]RUSSAKOVSKY O, DENG Jia, SU Hao, et al. ImageNet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252. DOI: 10.1109/ACCESS.2017.2735019.

[10]BOTTOU L, CURTIS F E, NOCEDAL J. Optimization methods for large-scale machine learning[J]. SIAM Review, 2018, 60(2): 223-311. DOI: 10.1137/16M1080173.

[11]DU Chaoben, GAO Shesheng. Image segmentation-based multi-focus image fusion through multi-scale convolutional neural network[J]. IEEE Access, 2017, 5: 15750-15761. DOI: 10.1109/ACCESS.2017.2735019.

[12]GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. CVPR 2014: 580-587.

[13]YANG Fan, CHOI Wongun, LIN Yuanqing. Exploit all the layers: fast and accurate CNN object detector with scale dependent pooling and cascaded rejection classifiers[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. CVPR 2016: 2129-2137.DOI: 10.1109/CVPR.2016.234.

[14]KLAMBAUER G, UNTERTHINER T, MAYR A, et al. Self-normalizing neural networks[C]//Advances in Neural Information Processing Systems. NIPS 2017: 971-980.

[15]FAWCETT T. An introduction to ROC analysis[J]. Pattern Recognition Letters, 2006, 27: 861-874. DOI: 10.1016/j.patrec.2005.10.010.

(編辑 赵勉)