基于卷积神经网络的左心室超声图像特征点定位

周玉金 王晓东 张力戈 朱锴 姚宇

摘 要:针对传统级联卷积神经网络(CNN)在左心室超声图像中定位准确度较低的问题,提出一种融合更快速区域卷积神经网络(Faster-RCNN)模型提取区域的级联卷积神经网络,实现对超声图像中左心室心内膜和心外膜轮廓特征点的定位。首先,采用两级级联的方式改进传统级联卷积神经网络的网络结构,第一级网络利用一个改进的卷积网络粗略定位左心室心内膜和心外膜联合的特征点,第二级网络使用四个改进的卷积网络分别对心内膜特征点和心外膜特征点进行位置微调,之后定位输出左心室心内膜和心外膜联合的轮廓特征点位置;然后,将改进的级联卷积神经网络与目标区域提取融合,即利用Faster-RCNN模型提取包含左心室的目标区域并将目标区域送入改进的级联卷积神经网络;最后,由粗到细对左心室轮廓特征点进行定位。实验结果表明,与传统级联卷积神经网络相比,所提方法在左心室超声图像上的定位效果更好,更逼近真实值,在均方根误差的评价标准下,特征点定位准确度提升了32.6个百分点。

关键词:超声心动图;左心室;特征点定位;卷积神经网络;级联卷积神经网络

中图分类号: TP391.41

文献标志码:A

文章编号:1001-9081(2019)04-1201-07

Abstract: In order to solve the problem that the traditional cascaded Convolutional Neural Network (CNN) has low accuracy of feature point localization in left ventricular ultrasound image, an improved cascaded CNN with region extracted by Faster Region-based CNN (Faster-RCNN) model was proposed to locate the left ventricular endocardial and epicardial feature points in ultrasound images. Firstly, the traditional cascaded CNN was improved by a structure of two-stage cascaded. In the first stage, an improved convolutional network was used to roughly locate the endocardial and epicardial joint feature points. In the second stage, four improved convolutional networks were used to fine-tune the endocardial feature points and the epicardial feature points separately. After that, the positions of joint contour feature points were output. Secondly, the improved cascaded CNN was merged with target region extraction, which means that the target region containing the left ventricle was extracted by the Faster-RCNN model and then was sent into the improved cascaded CNN. Finally, the left ventricular contour feature points were located from coarse to fine. Experimental results show that compared with the traditional cascaded CNN, the proposed method is much more accurate in left ventricle feature point localization, and its prediction points are closer to the actual values. Under the root mean square error evaluation standard, the accuracy of feature point localization is improved by 32.6 percentage points.

Key words: echocardiography; left ventricle; feature points location; Convolutional Neural Network (CNN); cascaded convolutional neural network

0 引言

超聲心动图因其便携、成本低廉成为医学中心脏腔室测量可视化最常用的一种医疗成像方式。超声专家们往往关心超声图像上关键部位的生理参数信息,通常对左心室超声成像进行分析并对收缩末期和舒张末期阶段心室轮廓边界进行检测,用它来评价心功能的好坏进而预判诊断心脏疾病[1]。实现左心室轮廓的准确定位是对左心室功能评价的首要前提,对计算机辅助诊疗有着重要的价值。

采用特征点来实现对医学图像上一些生理结构关键部位的定位,一直以来是医学研究者研究的热点问题。如文献[2]采用角点检测的方法在骨龄图像上定位手部指骨特征点;文献[3]采用监督学习方法从不同角度在心脏图像上检测左心室特征点。目前,特征点定位方法大致可以分为两种:一种是基于统计建模的方法,根据先验特征点分布模型,通过不断迭代收敛来匹配定位特征点。如:文献[4]利用主动形态模型(Active Shape Model, ASM)[5]的点分布模型在超声图像中定位颈总动脉特征点进而对其分割,文献[6]采用主动表观模型(Active Appearance Model, AAM)[7]在胎儿超声心动图上建立多纹理点分布模型,根据左心室的特征点轮廓进行分割。第二种是基于级联回归[8]的方法,通过一系列回归器对一个指定的初始值逐步细化,通过回归器的级联来自动学习特征点向量。如:文献[9]直接利用形状回归检测左心室轮廓,文献[10]采用回归的方法分割右心室。这些方法虽然得到了广泛应用,但有其局限性:一是模型学习过多依赖于人工干预,初始值位置的设定往往决定着模型预测的好坏;二是需提取人工设计的特征,对于低水平图像信号中的突变情况,人为的特征并不能很好地表达图像特征。

进入了卷积神经网络(Convolutional Neural Network, CNN)[11]时代后,卷积网络利用其特有的局部感知和权值共享机制来自动提取更深层次特征,逐渐代替人工提取特征,越来越多的研究者将卷积神经网络应用于医学图像处理上,如:文献[12]利用卷积神经网络对医学图像进行分类;文献[13]在3D医学图像上采用卷积神经网络,实现了对股骨特征点的定位。本文进行了左心室超声图像轮廓特征点定位的研究工作,针对超声图像存在斑点噪声、伪影以及图像对比度较低等影响超声图像上左心室轮廓界限较难确定的一系列难题,汲取卷积神经网络应用在计算机视觉领域解决问题的经验,提出一种融合更快速区域卷积神经网络(Faster Region-based CNN, Faster-RCNN)[14]模型提取区域的级联卷积神经网络对经食管超声图像中左心室轮廓特征点定位的方法。该方法首先采用Faster-RCNN网络模型提取包含左心室的目标区域,然后将包含左心室的目标区域送入本文设计的两级级联卷积神经网络,经过第一级网络粗略预测特征点位置和在第二级网络进行位置微调的基础上,最终准确定位出左心室心内膜与心外膜联合的轮廓特征点,达到了较为理想的定位效果。

1 传统级联卷积神经网络特征点定位方法

Sun等[15]首次提出一种三级级联的卷积神经网络应用于人脸特征点的定位。该算法由三级级联网络组成:第一级网络粗略估计人脸特征点位置,第二级和第三级网络在以每个特征点为中心截取的小区域中对上一级网络估计的位置进一步地精确调整,由粗到细地实现人脸特征点的定位。预测的特征点位置表达式为:

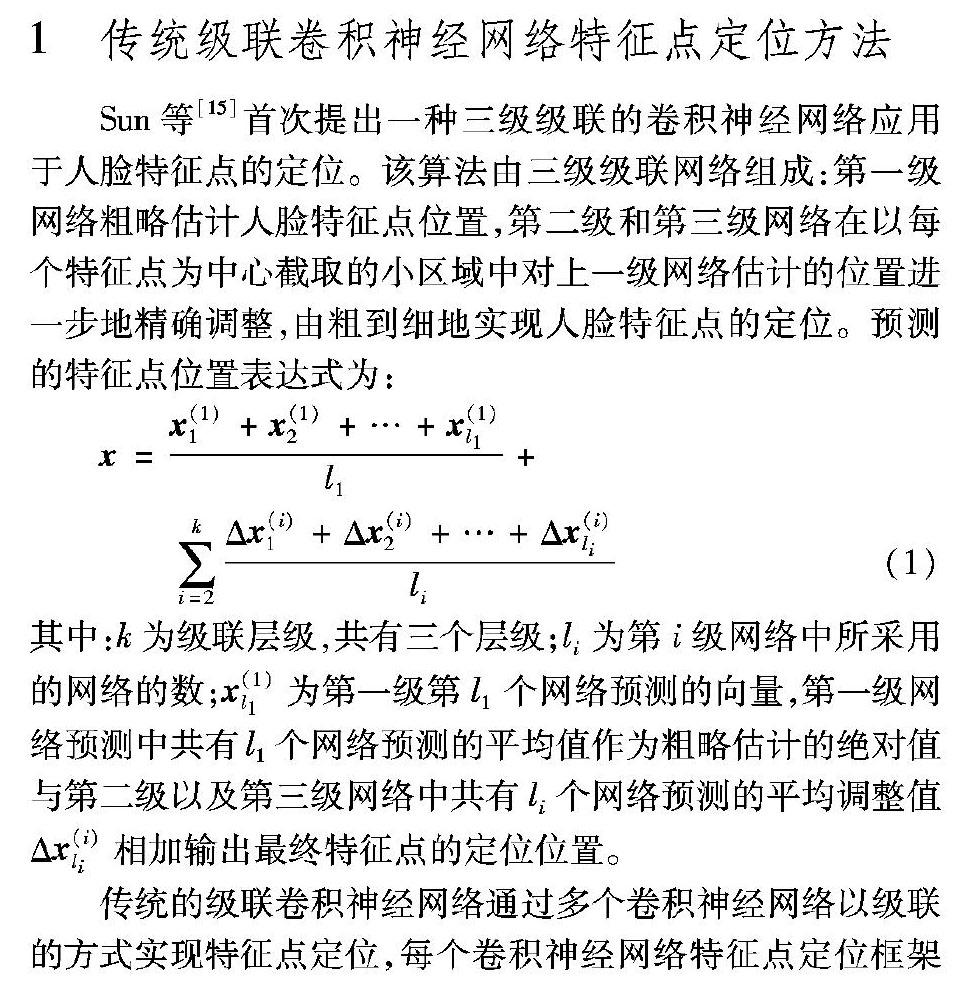

传统的级联卷积神经网络通过多个卷积神经网络以级联的方式实现特征点定位,每个卷积神经网络特征点定位框架如图1所示,g为激活函数的增益系数;b为偏置,通过tanh激活函数对池化后的特征图进行非线性输出。

2 改進级联卷积神经网络特征点定位方法

2.1 级联卷积神经网络结构的改进

传统级联卷积神经网络框架最初应用于人脸特征点定位并能准确定位出人脸的眉毛、眼睛、鼻子以及嘴等特征点。由于超声图像中左心室轮廓边界较为模糊,相对于人脸特征点,左心室轮廓特征点较难确定,直接采用传统级联卷积神经网络没有充分学习到左心室轮廓的特征,导致定位效果较差。因此,本文提出了改进的级联卷积神经网络,级联方式上与传统级联一致,采用两级级联方式:第一级网络粗略预测特征点位置,第二级网络分别选取包含左心室内膜特征点的小块区域和包含左心室外膜特征点的小块区域利用卷积神经网络对第一级网络预测的特征点位置进行细微调整,两级网络由粗到细地定位左心室轮廓特征点。

网络结构方面所采用的卷积神经网络结构与传统级联卷积神经网络采用的网络结构不同,其网络结构根据左心室超声图像轮廓特征点定位任务,依照深度卷积神经网络(AlexNet)[16]的网络结构而重新设计,并使用了修正线性单元(Rectified Linear Units, ReLU)作为激活函数。ReLU激活函数相对于tanh激活函数,梯度下降更快[17],其函数表达式如下:

本文提出的级联卷积神经网络中第一级网络所采用的卷积神经网络结构如图2(a)所示,输入为256×256的图像,包含了5层卷积层和3层全连接层。其前2个卷积层中卷积核设为7×7和5×5,其余3层卷积核尺寸都为3×3,卷积层后紧跟池化层,其核尺寸都设为3×3。全连接层将特征图映射为一维向量,最后1个全连接层输出左心室轮廓34个特征点(x, y)坐标组成的68维向量。第二级网络采用的卷积神经网络结构如图2(b)所示,相对于第一级网络结构,第二级网络输入区域相对较小,为96×96的目标图像区域,采用4个卷积层和2个全连接层。第1个卷积层采用7×7的卷积核,其余3层卷积层以及池化层的核尺寸都设为3×3。连接2层全连接层,最后1个全连接层输出34维向量。第二级网络共采用4个如图2(b)所示的卷积神经网络,针对包含心内膜特征点和包含心外膜特征点的小块区域,每个区域分别采用2个卷积神经网络取其输出向量的平均值作为每个区域特征点在第一级网络预测位置的微调,由粗到细地预测出左心室轮廓特征点位置,其预测特征点的预测向量与传统级联卷积神经网络预测特征点向量表达一致,如式(5)所示。

2.2 融合Faster-RCNN区域提取的改进

对于左心室超声图像轮廓特征点的定位,在超声图像中本研究所感兴趣的区域是包含左心室的区域。感兴趣区域包含着重要的信息,背景区域的信息较为次要,有时候不必要的背景区域难免会影响定位精度。因此,如何提取感兴趣区域成为特征点定位首先要解决的问题。

2.2.1 Faster-RCNN模型

Faster-RCNN模型因其较高的检测精度,在目标检测领域应用广泛,将其应用在包含左心室的目标区域检测效果比较理想。Faster-RCNN模型由Girshick等[18]在基于区域驱动的区域卷积神经网络(Region-based CNN, RCNN)、空间金字塔池化卷积网络(Spatial Pyramid Pooling convolutional neural network, SPP-net)[19] 和快速区域卷积神经网络(Fast region-based CNN, Fast RCNN)[20]的基础上提出,其整个模型是一个统一的目标检测网络,如图3所示,包含卷积层、区域生成网络、感兴趣池化和分类四部分。

1)卷积层利用一组基础的卷积层、ReLU激活函数和池化层提取图像的特征图,与第2)部分的区域生成网络和全连接层共享。

2)区域生成网络是一个全卷积网络(Full Convolutional Network, FCN)[21],用于生成候选区域,它以任意大小的图像作为输入,输出一组带有目标得分的目标候选区,可以同时在每个位置预测目标边界和目标分数并输入到该层两个子全连接层,其中分类层通过Softmax判断候选区域为前景目标区域或者背景区域,回归层修正候选区域获得更精确的候选区域。

3)感兴趣池化对输入的特征图和候选区域信息进行综合后提取候选特征图,映射至全连接层判定目标类别。

4)分类层利用候选特征图区别候选区域为前景目标区域还是背景区域,同时再次利用回归层来获得目标区域精确的边界框坐标位置。

2.2.2 融合Faster-RCNN的级联卷积神经网络

为了提高左心室超声图像上轮廓特征点定位精度,排除超声图像中影响定位精度的背景信息进一步提升定位准确度,本文在改进传统级联卷积神经网络的基础上,引入Faster-

RCNN模型,提出了融合Faster-RCNN模型提取区域的级联卷积神经网络。该方法首先利用Faster-RCNN模型提取包含左心室的目标区域,然后针对目标区域的图像块采用改进的两级级联卷积神经网络进行左心室轮廓特征点定位,第一级网络粗略预测左心室心内膜和心外膜联合的轮廓特征点位置,第二级网络分别针对心内膜特征点和心外膜特征点进行位置微调,两级网络由粗到细地实现左心室轮廓的特征点定位。

本文提出的融合Faster-RCNN模型提取区域的级联卷积神经网络应用于左心室超声图像轮廓特征点定位的整个流程如图4所示。第一步,采用Faster-RCNN模型通过一组基础的卷积神经网络提取特征,由区域生成网络生成候选区域,通过对候选区域的边界框精确的回归和分类,以此获取左心室目标区域,提取包含左心室的目标区域,最终输出左心室目标区域边界框的坐标向量(x0, y0,x1, y1),分别为边界框的左上角坐标(x0, y0)和右下角坐标(x1, y1)。第二步,根据Faster-RCNN输出的边界框坐标值,在相应的经食管超声图像中截取出目标区域图像块,将截取的左心室目标区域送入本文提出的两级级联卷积神经网络,第一级网络在截取的目标区域内进行左心室心内膜与心外膜轮廓特征点的粗略定位,第二级网络分别针对左心室心内膜和心外膜小块区域内的特征点进行位置微调,最终精确定位出左心室心内膜与心外膜联合的轮廓特征点。

3 实验与结果分析

3.1 实验数据

本文的实验数据来自四川大学华西医院麻醉科,由华西医院专家标注的不同心动周期内获取的经食管超声图像,共有训练集图像400张,测试集图像186张。每幅图像建立了左心室矩形边界框标注以及左心室心内膜与心外膜联合的轮廓特征点标注,标注的样例如图5所示。其中左心室的特征点标注同文献[22]一致,文献中Centripetal Catmull-Rom曲线能够在减少特征点数量的同时得到形状一致的特征点,选用了34个特征点,内层17个点表示心内膜,外层17个点表示心外膜, 心外膜和心内膜特征点联合勾勒出左心室轮廓。

针对本文实验较少的训练数据集进行数据增强以扩充训练数据集。先对训练集中原始图像进行水平翻转,其翻转表达式如式(7)所示,原始图像中像素(x0, y0)变换为(x, y),w为原始图像的宽度。经过水平翻转变换后,将训练数据集扩充至800张。

然后再对训练集中所有图像进行顺时针旋转β=10°,其旋转表达式如式(8)所示,将原始图像中像素(x0, y0)变换为(x, y)。旋转变换后训练数据集扩充至1600张进行训练。

本文提出的第一级级联卷积神经网络训练数据有两种:一是直接使用整张图像数据以及标注特征点的训练进行第一级心内膜与心外膜联合的34个特征点粗略定位。二是利用Faster-RCNN模型提取的左心室目标区域图像数据训练,此步骤首先要利用左心室边界框标注的训练集训练Faster-RCNN网络,获取边界框坐标后在整张图像上截取左心室目标区域,同时对标注点坐标进行相应的转换,针对含有左心室的目标区域图像在第一级网络中进行心内膜与心外膜联合的34个特征点粗略定位。

第二级级联卷积神经网络分别对心内膜和心外膜特征点进行微调定位。共4个卷积神经网络,分别用于心内膜图像区域和心外膜图像区域进行特征点微调。对于心内膜区域训练数据,以心内膜17个關键点的中心点作为中心,截取出原始图像宽度的4/10、5/10两种小区域图像数据,用2个卷积神经网络进行微调。心外膜17个关键点同理用2个卷积神经网络在截取出的原始图像宽度的4/10、5/10图像区域上进行微调,最终由粗到细定位出心内膜和心外膜联合的轮廓特征点。

3.2 实验结果分析

本文实验基于Caffe深度学习框架,利用Python 2.7编写完成,系统环境为Ubuntu14.04,显卡为Titan X。

传统级联卷积神经网络与本文改进的级联卷积神经网络在训练中网络参数变化如表1所示,传统级联卷积神经网络第一级网络输入的图像为256×256的超声图像,网络有4个卷积层、2个全连接层以及Euclidean Loss损失层,网络输出68维坐标向量,其第二级网络共有3个卷积层、2个全连接层和1个Euclidean Loss损失层,输入规格为96×96的包含心内膜或心外膜特征点的目标图像区域,最终输出心内膜或者心外膜34维的微调坐标向量。本文改进的级联卷积神经网络训练时,第一级网络输入为256×256的超声图像,经过5个卷积层,3个全连接层和Euclidean Loss损失层,最后输出68维左心室心内膜与心外膜联合的坐标向量。其第二级网络输入包含心内膜特征点的96×96规格的图像区域,经由4个卷积层、2个全连接层和Euclidean Loss损失层后,输出心内膜微调位置的34维向量,输入包含心外膜特征点的图像区域,输出心外膜特征点微调的34维向量。

本文改进的级联卷积神经网络训练过程中学习率设为1‰,采用随机梯度下降的优化方法,模型共训练迭代10万次,网络训练时损失和迭代轮次的关系如图6所示,横坐标为训练迭代的前400轮次,纵坐标为欧氏距离损失。从图6中可看到训练损失和验证损失在迭代过程中迅速下降,且最终损失接近于零。说明本文所改进的级联卷积神经网络在本研究数据集上的训练是有效的,并且能够快速收敛。

基于训练好的网络模型,进行左心室超声图像的轮廓特征点预测,传统级联卷积神经网络与本文方法的预测效果如图7所示,图7(a)中A、B、C和D是从测试数据集中挑选的4张经食管超声实例图像,其中A、D为左心室收缩期的超声切面实例图,B、C为左心室舒张期的超声切面实例图;图7(b)展示的是这4张经食管超声实例图的左心室轮廓手工标记特

征点;图7(c)~(f)是针对4张经食管超声实例图采用不同方法所预测特征点的效果展示。其中图7(c)展示的是传统级联卷积神经网络预测的效果;图7(d)展示的是本文所设计的单级卷积神经网络的粗略预测效果;图7(e)为本文改进的级联卷积神经网络在实例超声图像上的预测效果;图7(f)为本文提出的融合Faster-RCNN模型提取区域的级联卷积神经网络预测的效果。可看出图7(c)中传统级联神经网络在实例图A、B、C和D中预测的左心室轮廓特征点已经偏离左心室轮廓的真实标记点。图7(d)中本文所设计的单级卷积神经网络粗略的预测出了左心室轮廓的特征点,B、C实例图中预测的特征点较为贴合真实标记点, A、D实例图中左心室心尖部位的轮廓特征点位置预测不太准确。从子图7(e)中可看到本文改进的级联卷积神经网络明显修正了A、D实例图中本文所设计的单级卷积神经网络预测不准确的特征点,较为接近真实的轮廓标记点,但可看到A、B、C、D实例图中左心室轮廓心外膜上个别的预测点与真实标记点的位置仍有所偏离,图7(f)可看到本文提出的融合Faster-RCNN模型提取区域的级联卷积神经网络的预测点又进一步地修正了本文改进的级联卷积神经网络的预测位置,更逼近真实标记点的位置,表现效果最佳。

将本文方法与传统级联卷积神经网络进行定量分析,其累计误差分布如图8所示。可看出本文提出的融合Faster-RCNN模型提取区域的级联卷积神经网络效果最优,本文改进级联卷积神经网络在本文单级卷积神经网络的基础上表现有所提升,并且本文方法明显优于传统级联卷积神经网络。

本文采用式(5)的均方根误差评价标准对测试样本进一步定量评估,本文实验中定义评价标准下误差如果超过5%则认为是预测错误。定义预测样本准确度如式(9)所示:

其中:T为预测正确的样本数目;N为测试样本总数。

在评价标准下,对比结果如表2所示,在均方根误差测量下,本文方法比传统级联卷积神经网络获得的误差更小。无论是针对心内膜特征点、心外膜特征点还是心外膜与心内膜联合的轮廓特征点,本文方法的定位准确度都达到了80%以上。本文改进的级联卷积神经网络的定位准确度比本文单级卷积神经网络的定位准确度高。融合Faster-RCNN模型提取区域的级联卷积神经网络在本文改进的级联卷积神经网络的基础上定位准确度达到了85.0%,相对于传统级联卷积神经网络,定位准确度提升了32.6个百分点。

4 结语

本文提出了一种融合Faster-RCNN区域提取的级联卷积神经网络实现对左心室超声图像心内膜和心外膜轮廓特征点的定位方法。首先本文针对传统级联卷积神经网络直接照搬应用于经食管超声图像中左心室轮廓特征点定位不理想的情况,重新设计级联卷积神经网络结构,提升定位精度。其次针对背景区域影响定位精度的情况,进一步提出融合Faster-RCNN模型先提取包含左心室的目标区域,再进行目标区域内两级级联卷积神经网络的左心室轮廓特征点定位。实验结果表明,本文方法定位准确度更高,其预测的左心室轮廓特征点更逼近真实标记的特征点。在下一步的研究中,计划将级联卷积神经网络的特征点定位方法应用于3D超声心动图中实现左心室轮廓的跟踪,实时捕捉左心室的收缩舒张变化情况,进一步实现更智能化的计算机辅助诊疗。

参考文献(References)

[1] NOBLE J A, BOUKERROUI D. Ultrasound image segmentation: a survey[J]. IEEE Transactions on Medical Imaging, 2006, 25(8): 987-1010.

[2] 冉隆科. 一種基于角点检测方法的骨龄图像关键点定位[J]. 电子设计工程, 2011, 19(14): 175-177. (RAN L K. A corner detection method based on the image of the skeletal age point positioning [J]. Electronic Design Engineering, 2011, 19(14): 175-177.)

[3] MAHAPATRA D. Landmark detection in cardiac MRI using learned local image statistics[C]// STACOM 2012: Proceedings of the 2012 Statistical Atlases and Computational Models of the Heart — Imaging and Modelling Challenges, LNCS 7746. Berlin: Springer, 2012: 115-124.

[4] YANG X, JIN J, XU M, et al. Ultrasound common carotid artery segmentation based on active shape model[J]. Computational and Mathematical Methods in Medicine, 2013, 2013(2): 345968.

[5] COOTES T F, TAYLOR C J, COOPER D H, et al. Active shape models-their training and application[J]. Computer Vision & Image Understanding, 1995, 61(1): 38-59.

[18] GIRSHICK R, DONAHUE J, DARRELL T, et al. Region-based convolutional networks for accurate object detection and segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(1): 142-158.

[19] HE K, ZHANG X, REN S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[C]// ECCV 2014: Proceedings of the 2014 European Conference on Computer Vision. Berlin: Springer, 2014: 346-361.

[20] GIRSHICK R. Fast R-CNN[C]// Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2015: 1440-1448.

[21] LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2015: 3431-3440.

[22] 紀祥虎, 高思聪, 黄志标, 等. 基于Centripetal CatmullRom曲线的经食道超声心动图左心室分割方法[J]. 四川大学学报(工程科学版), 2016, 48(5): 84-90. (JI X H, GAO S C, HUANG Z B, et al. Left ventricle segmentation in transesophageal echocardiography based on Centripetal CatmullRom curve[J]. Journal of Sichuan University (Engineering Science Edition), 2016, 48(5): 84-90.)