基于轻量和积网络及无人机遥感图像的大豆田杂草识别

王生生,王 顺,张 航,温长吉

基于轻量和积网络及无人机遥感图像的大豆田杂草识别

王生生1,王 顺2,张 航2,温长吉3

(1. 吉林大学计算机科学与技术学院,长春 130012;2. 吉林大学软件学院,长春 130012; 3. 吉林农业大学信息技术学院,长春 130118)

为提高机器视觉在无人机等小型嵌入式设备中杂草识别的准确率,该文以大豆苗中常见禾本科杂草和阔叶型杂草为研究对象,针对传统和积网络在图像分类任务中模型参数多、训练时间长、含有较多冗余节点和子树的问题,该文改进传统和积网络的学习过程,提出一种以小批量数据作为输入的轻量和积网络。在结构学习中,当积节点作用域内的变量个数小于一定阈值时,合并积节点为多元叶节点,否则将积节点重组为和积混合结构,并对边缘节点进行裁剪,有效降低了模型的参数量和复杂度。在参数学习中,提出贝叶斯矩匹配更新网络参数,使得模型对小样本的学习效率更高。最后结合均值聚类算法应用于无人机图像中的杂草识别。试验结果表明,利用该方法对无人机图像中大豆苗、禾本科杂草、阔叶型杂草以及土壤的平均识别准确率达99.5%,高于传统和积网络和传统AlexNet。并且模型平均参数量仅为传统和积网络的33%,内存需求最大时减少了549 M,训练时间最多减少了688.79 s。该研究可为轻量和积网络模型在无人机喷洒农药中的杂草识别提供参考。

无人机;遥感;识别;和积网络;结构学习;参数学习;杂草

0 引 言

杂草是粮食生产的主要制约因素之一[1]。杂草管理的一个重要目标是区分禾本科杂草和阔叶型杂草,因为这2个杂草群落可通过不同除草剂适当控制[2]。作物田间杂草的识别方法主要有人工识别法、遥感识别法和机器视觉识别法3种[3]。

在杂草控制中,采用人工广泛喷洒除草剂的方法不仅会造成除草剂的浪费,还会造成环境污染。与此同时,也导致了农产品的安全和生态问题,如化学农药残留和杂草群落进化产生抗药性等[4]。在精细农业中,精准识别作物幼苗和杂草,合理使用农药尤为重要[5-6]。

无人机遥感技术以其低成本、高分辨率、高灵活性的特点使其成为精细农业中空中采集图像的新型工具[7]。如Castro AID等利用低空航拍高光谱图像通过植被指数、光谱角制图等方法绘制谷类和豆类中的十字花科杂草,由识别的结果定点喷施农药,节约了71.7%~95.4%的除草剂[8]。Ishida T等利用无人机遥感搭载液晶可调谐滤波器获得的高光谱图像,结合光照和阴影2种光谱反射率对植被、土壤、杂草等进行分类,对植被的分类准确率达94.5%[9]。Barrero O等将无人机获取的低分辨率多光谱图像和高分辨率RGB图像相融合以检测水稻萌发后50天的禾本科杂草,识别准确率最高为85%[10]。利用无人机装配先进传感器获取高光谱、高分辨率图像进行光谱分析,通过在某些特定波长作物与杂草反射率的不同来进行识别,弥补了传统遥感识别杂草距离远、实时性差的缺点,在农业领域应用中具有广阔前景[11]。

传统机器学习方法提取杂草的形状、颜色、纹理[12-14]等特定特征取得了一定效果,但对于形状、颜色和纹理差异不明显的作物与杂草识别准确率较低。而深度网络模型能够提取图像的高层特征,不受人工设计特征的影响。如Potena C等[15]提出了一种用于无人地面车辆除草装置的甜菜杂草分类感知系统,结合RGB和近红外图像使用2种不同的卷积神经网络架构,浅层网络进行植被检测,深层网络进一步将检测到的植被分为作物和杂草。他们首先进行像素分类,然后通过投票的方式对植被掩膜中检测到的斑点进行分类,植被识别的准确率约97%。Dos A等对通过对无人机获取的图像进行超像素分割,然后训练卷积神经网络AlexNet识别大豆苗和杂草,平均识别准确率在99%以上[16]。王璨等利用卷积神经网络从图像的高斯金字塔中提取多尺度分层特征,然后与多层感知机相连接,通过基于像素的分类实现玉米杂草的识别,平均识别准确率达98.92%[17]。卷积神经网络模型在识别领域效果显著,其主要问题在于卷积计算对硬件资源要求较高,模型占用内存大,难以移植到无人机等小型嵌入式设备,且模型结构较为复杂,对于小样本数据容易造成过拟合[18]。因此,针对无人机获取的大豆苗杂草小样本数据,采用了对硬件资源及样本数量要求较小的和积网络(sum-product networks)[19]。目前,和积网络已成功应用于图像分割,图像分类,动作识别,语音识别,目标检测[20-25]等多个领域。

在大豆种植园中,禾本科杂草和阔叶型杂草严重影响大豆产量,大面积种植时使用无人机获取图像根据不同杂草群落喷施农药是有效的防治手段。本文以无人机获取的大豆苗杂草小样本数据为研究对象,在图像处理阶段,基于和积网络的上述优点,提出了一种轻量和积网络杂草识别模型。模型首先使用均值聚类算法提取图像低层特征,然后将提取的特征下采样,再将采样特征以小批量数据作为输入,通过更新网络结构与更新网络参数提取高层特征并对杂草进行识别。在结构学习中采用一定方式对边缘节点进行裁剪,使模型结构轻量化,以期为轻量和积网络模型在无人机喷洒农药中的杂草识别提供参考。

1 材料与方法

1.1 图像获取

无人机获取的大豆幼苗期原始图像如图1所示,拍摄于2016年1月3日,平均飞行高度约4 m,采集高度变化不大,对应的垂直摄影地面采样距离小于1 cm。图像规格为4 000×3 000像素,JPG格式,采用默认工厂配置中的所有参数,没有使用额外的图像校正。

图1 2016年1月3日大豆幼苗期的原始图像

1.2 图像预处理

1.2.1 超像素分割

超像素分割是指将具有相似视觉特征的相邻像素分割成视觉特征一致的像素块。它利用像素之间特征的相似性进行分组,用少量的超像素代替大量的像素来表达图像特征,减少了大量的数据冗余,显著降低了后期图像处理的复杂度,是目标定位和图像分割中重要的预处理环节。对于无人机获取的原始图像使用简单线性迭代聚类算法(simple linear iterative clustering, SLIC)[26]构建图像数据集。

式中d表示第个像素中心与第个像素点的颜色距离;d表示第个聚类中心与第个像素点的空间距离;D表示所有像素点在CIELAB颜色空间中的距离与以间隔标准化到平面上的距离之和;表示颜色和空间距离的平衡因子,在该文献中默认为10。

试验环境为Win10操作系统,CPU Intel(R) Core i7-8 700 K @3.60 GHz,16 G运行内存。对无人机获取的原始图像使用了scikit-image库中的SLIC超像素分割算法。为将原始图像分割成大豆苗、杂草和土壤片段,在100至1 200范围内测试不同值,最终选择=300将其分割为大小约200×200像素的片段,该参数的选择取决于图像采集的高度和分辨率。在阴天拍摄的图像中含有较少的阴影,平衡因子的值可以使用较小的值,以使超像素边界对图像元素的边缘更加敏感。在晴天,阴影对图像的影响使得超像素对图像的光照过于敏感,易含有在同一超像素中属于不同类别的元素。因此可以选择较大的值,以使空间邻近信息相对于颜色和光照的相似性具有更大的权重[16]。

1.2.2 图像裁剪

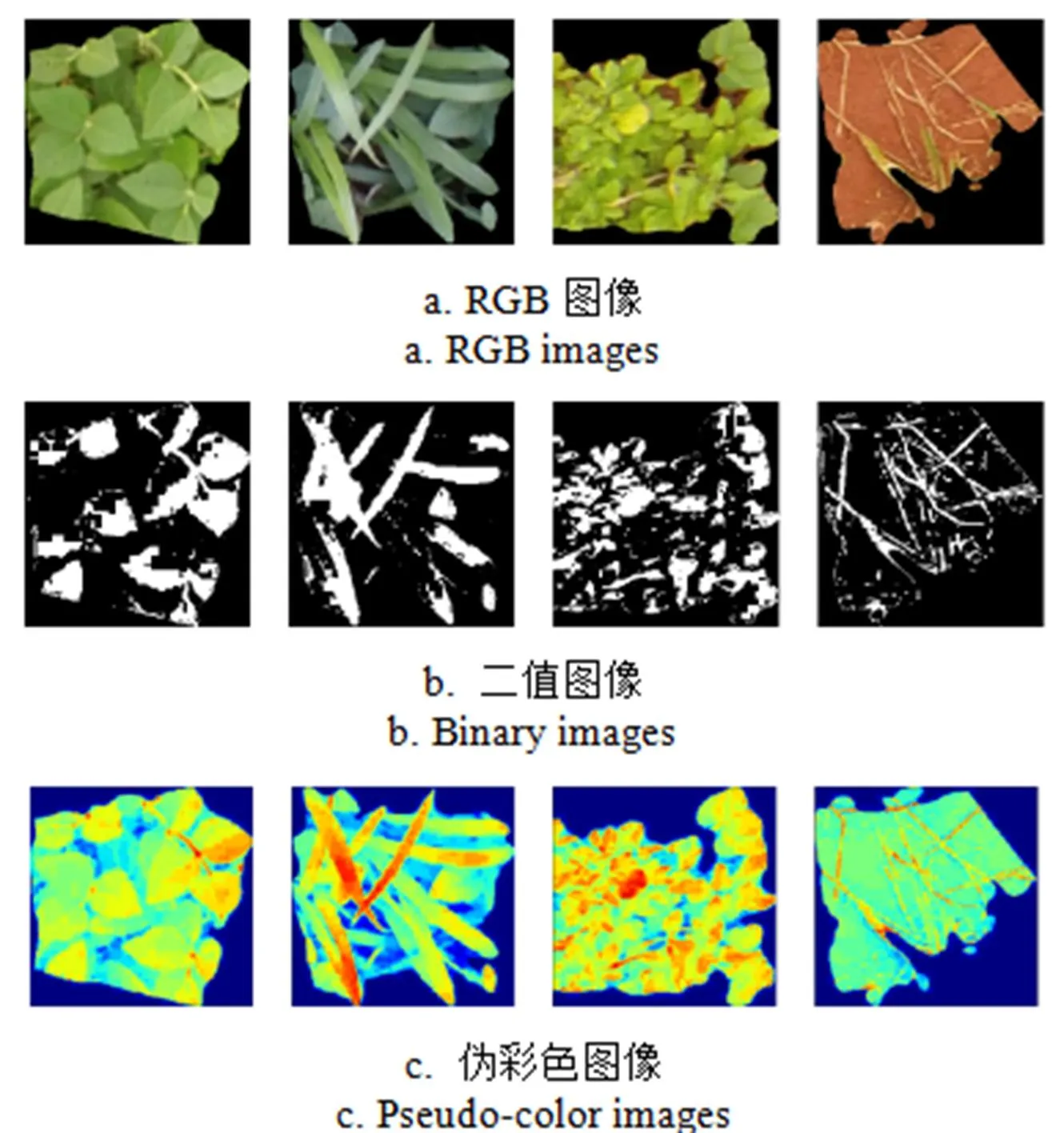

该数据集已将无人机获取的原始图像分割成15 336张小图像,分别为3 249张土壤、7 376张大豆苗、3 520张禾本科杂草和1 191张阔叶型杂草。由于在数据集中的图片大小不一,绝大部分图像的高度和宽度小于256像素。为便于处理,首先将图像放置在一个由黑色背景组成的图像左上角,大小为512×512像素,然后在左上角以256×256像素将其裁剪。处理后的杂草与土壤图像如图2所示,从左至右依次为大豆苗,禾本科杂草,阔叶型杂草和土壤。

图2 裁剪后的杂草与土壤图像

1.2.3 数据标准化

标准化之后的数据将被扩展到一个合理的范围,并转化为一个无量纲的纯数据。当图像中的像素包含多个维度且不稳定时,特征标准化公式可以确保每个维度都是零均值和单位方差。= {(1),(2),…,(i),…,(n)}表示给定的数据集,其中(i)表示数据集中第个样本。数据标准化公式[27]可表示为

1.2.4 数据降维

1.3 和积网络

和积网络是一种新型概率深度网络。它可以看成是一个含有根结点的广义有向无环图,内部节点由和节点与积节点递归组成,叶结点可以是离散或连续的概率分布[19],其主要有如下定义:

定义三(和积网络的计算):若表示在实数变量集上的和积网络,其参数为,S为以节点为根结点的子网络。对于每一个随机变量服从的分布,以=作为可观测变量的网络输入,S()表示节点处的输出值,S()表示节点下子节点输出值。此时,S()可由式(4)计算。

定义四(完整性):和积网络具有完整性当且仅当其和节点的所有子节点具有相同的作用域。

定义五(可分解性):和积网络具有可分解性当且仅当其积节点的所有子节点具有互斥的作用域。

注:X1,X2为布尔变量,,分别对应于上述变量相反的逻辑状态。

和积网络在表达能力、推理能力及易处理性上具有深厚的理论支持。它的积节点可表示提取的特征,和节点可以表示特征的混合[19]。和积网络可以解释为一种具有非负参数的特殊前馈神经网络,其中叶结点是输入神经元,而和节点和积节点是隐藏神经元。它也可以作为一种密度估计器,相对于传统概率图模型,在一些推理任务如边际推理,最大可能解释推理中可达到精确和快速的推理[30]。和积网络的学习分为参数学习和结构学习。其参数学习一般需要人工预定义网络结构,如使用极大似然估计[19],判别式学习[31],坍塌变分推理[32]等。因此近年来提出了几种自动化结构学习的方法,能够在构建网络的同时学习参数,无需超参数调节,显著降低了人工预定义的网络的成本。如传统和积网络LearnSPN算法以及基于该算法的变体[33-35],它们采用分治策略,分层聚类递归划分数据集实例与变量生成网络结构。Vergari A等则通过一种混合技术自顶向下学习含有多元叶结点的网络结构,进一步提高了和积网络的表达能力[36]。

传统和积网络的LearnSPN算法使用多次扫描的批处理学习方式,通过在线期望最大化算法递归划分数据矩阵的实例和变量,这样无需指定集群的数量,但复杂的网络结构是通过爆炸性地增加和节点后裔节点的个数实现的,含有较多冗余节点且训练时间较长。参数学习使用极大似然估计,叶结点全部为单变量分布,较为简单。但由于网络结构复杂,易将噪声数据的特征也学习到模型当中,导致模型泛化能力下降,容易过拟合。

1.4 轻量和积网络杂草识别模型

1.4.1 特征提取

图4 K均值聚类

1.4.2 轻量和积网络杂草识别流程

轻量和积网络杂草识别流程如图5所示,模型包括均值聚类和轻量和积网络两部分。经由上文所述方法,利用均值聚类提取输入图像的低层特征,然后以小批量学习的方式,将下采样后的数据经一次传递训练轻量和积网络,提取图像高层特征并进行杂草识别。轻量和积网络由内部节点学习输入特征的联合概率分布,由根结点输出特征所属类别的概率。不同种类分别训练,在进行杂草识别时,每一种类别对应于一个独立的网络结构。对于输入图像,每个网络结构输出该类别的概率值,概率最高的即为所属类别,依据识别结果可供无人机选择喷施特定农药。

图5 杂草识别流程

更新网络结构的方法是将作用域包含2个变量的子节点相关联。当子节点的个数小于一定数量时就创建一个多元的叶结点,反之则在变量上创建一个和积混合结构。此过程如图6所示。

注:x1 ,…, x5表示积节点的作用域。

图6a表示一个含有3个子节点的原始积节点,1,…,5表示该节点下的作用域。关联1与3的方法如图6b所示,积节点跟踪这5个变量的经验均值和经验协方差。当1和3的皮尔逊相关系数高于一定阈值时,该算法将具有1,32个子节点的作用域合并,并将它们转换为一个多元叶节点,以其统计的均值和协方差作为叶结点参数。另一种关联1和3的方法是创建一个混合模型,如图6c所示,它有2个组成部分。第一个部分为包含1和3积节点的原始子节点。第二个组成部分是一个新的积节点,它再次被初始化为在其作用域上的一个完全因式分解的分布,然后再将小批数据点传递给新混合模型以更新其参数。更新结构的方式可通过设置子节点个数的阈值来选择。

矩匹配是一种基于经验矩估计分布参数的常用方法。例如,在保证一致性的同时,矩匹配被用来估计混合模型、主题生成模型和隐藏马尔科夫模型的参数[38]。矩匹配也可以用于贝叶斯近似一个难以计算的后验分布。也就是说,通过计算这个分布的矩的子集,选择一个与这些矩匹配的易处理分布簇作为近似,如期望传播[39]。该文提出使用贝叶斯矩匹配更新网络中的参数。贝叶斯学习始于一个在权重上的先验概率(),然后对于给定观测数据集,根据贝叶斯式(7)学习计算后验概率(|)。

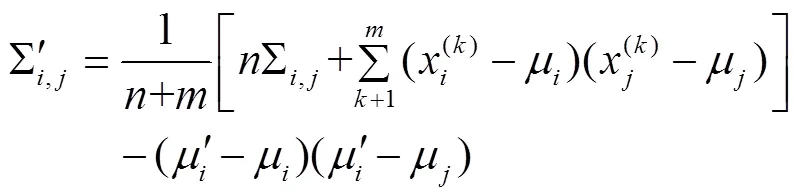

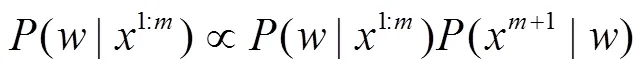

对于给定数据集= {(1),(2),…,(m),…,(n)}的小批量学习方式,可以将贝叶斯公式改写为公式(8),即将观测数据集均匀划分成若干个批次,表示Batch Size的大小。的取值可根据GPU或CPU硬件的内存需求调节。

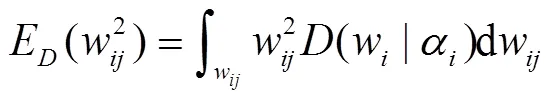

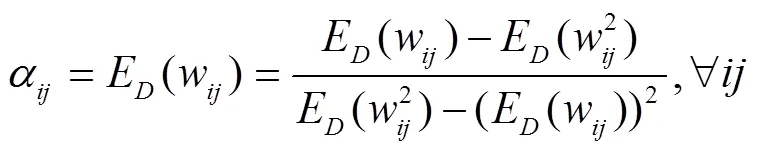

当用狄利克雷分布近似一个难以计算的分布时,首先计算的一阶矩和二阶矩,然后使用式(12)计算超参数以使其与分布有相同的矩。

进一步说,对于由狄利克雷分布的乘积得到的联合概率分布(),为了计算超参数α,可以通过计算每个边缘分布()的一阶矩和二阶矩,然后通过贝叶斯矩匹配与狄利克雷分布的乘积来近似,这样做的目的是为了减小直接显示计算的复杂性。

为了简化结构,当一个积节点最终只有一个子节点时,就将其从网络中删除,而使它的子节点与其父节点相连。如果一个和节点是另一个和节点的最后一个节点,那么就删除该和节点,并将其所有子节点提升一个层。这样有效地减少了冗余的边缘分支和子树,使模型结构更加轻量化。

2 结果与分析

2.1 杂草识别结果与分析

为验证模型的适用性,将试验数据分为平衡数据和非平衡数据2组,因为在实际应用中获取的样本数据往往是非平衡的。平衡数据是指模型在训练、测试、验证时每种类别均使用相同的样本数量。反之,当每种类别的样本数量分布不均匀时则是非平衡数据。在平衡数据中每个类别所选的图像数量为1 125张,共4 500张图片。其中3 000张用于训练,500张用于验证,1 000张用于测试。非平衡数据是在没有限制类别平衡的情况下形成的。为保持和文献[16]中试验的一致性且便于将数据集划分为训练集、验证集和测试集,使用了15 336张图片中的15 000张,组成较大数据集。丢弃其中的336张大豆类图像,因为大豆类的图像数量远比其他类别高,对试验几乎没有影响,其他类别的数据则全部使用。非平衡数据中的每个类别70%用于训练,10%用于验证,20%用于最终测试。小批量学习Batch Size的值一般设置为1 000以内,数值越小学习过程收敛越快,但产生的噪声越多。经多次试验,根据硬件设备的内存需求及试验结果,选择Batch Size为62。

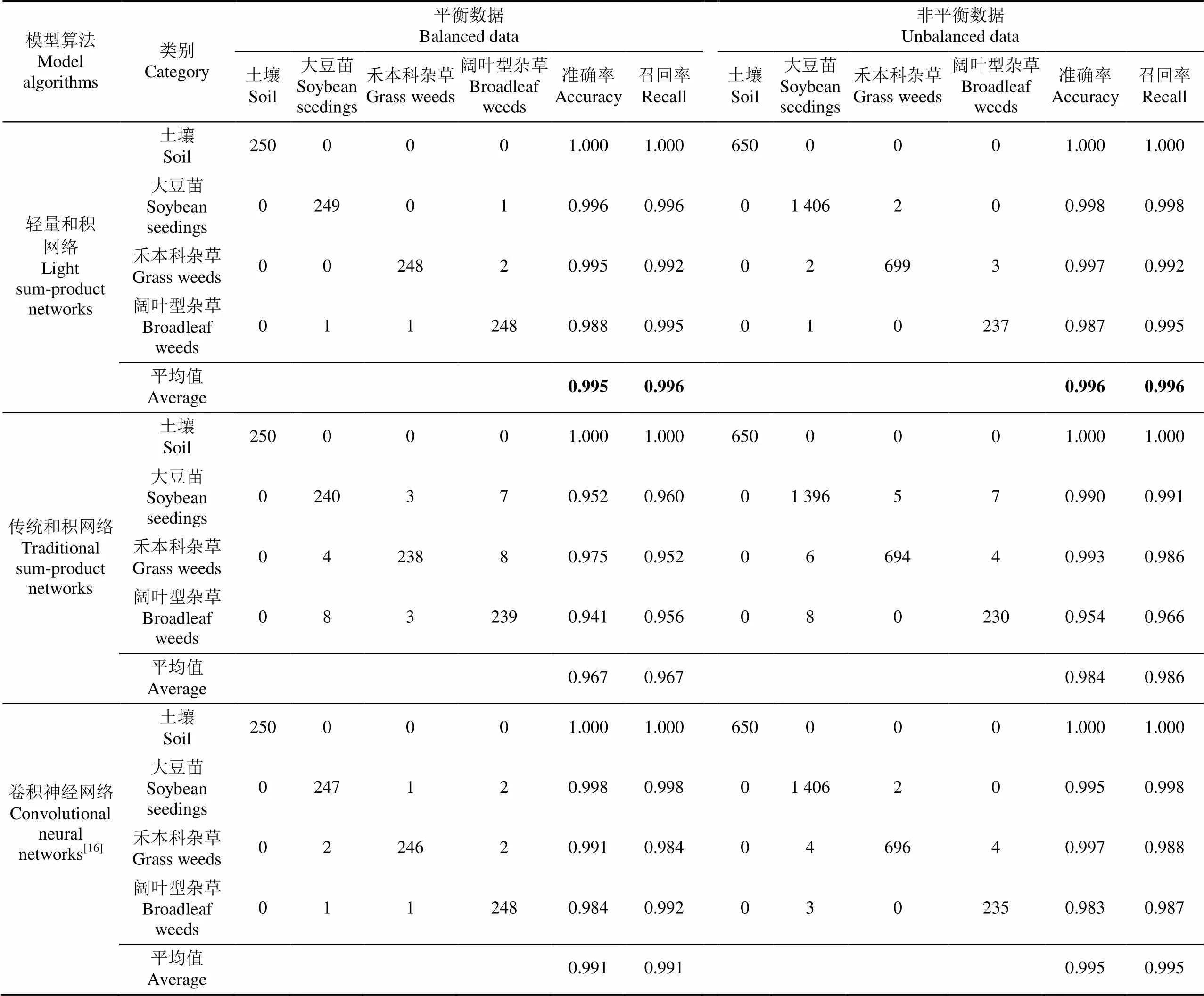

2次试验使用轻量和积网络与传统和积网络算法LearnSPN、卷积神经网AlexNet[16]对大豆苗、阔叶型杂草、禾本科杂草以及土壤的识别结果进行对比。不同模型算法下平衡数据与非平衡数据下的分类混淆矩阵如表1所示。

准确率计算公式为TP/(TP+FP),召回率计算公式为TP/(TP+FN),式中TP表示真正例,FP表示假正例,FN表示假反例。根据平衡数据与非平衡数据下的分类混淆矩阵,可得到平衡数据与非平衡数据下的准确率与召回率。由表1平衡数据中的结果可知使用均衡的数据集对模型的训练有所帮助,此时使用和积网络模型、卷积神经网络模型进行杂草识别的准确率均在96%以上。本文方法较传统和积网络方法LearnSPN的平均分类准确率提高了2.8个百分点,平均召回率提高了2.9个百分点;较卷积神经网络的平均分类准确率提高了0.4个百分点,平均召回率提升了0.5个百分点。可以看到未改进的传统和积网络其识别效果低于传统神经网络,主要是由于其冗余的节点分支对识别精度有一定影响。误分类的图片主要由于个别图像质量差、阴影、采集时不同类别重叠等问题导致。其中阔叶型杂草和大豆苗容易误分,某些图像由于以上原因及植物本身特点,即使人眼也很难完全正确分类。而土壤类别的识别准确率高于其他3种植物类别,主要由于它在颜色空间中的特征值与其他类别差异较大。

表1 不同模型算法下平衡数据与非平衡数据的分类混淆矩阵与分析结果

由表1使用15 000张非平衡数据的试验结果可知,在非平衡数据中轻量和积网络的平均分类准确率为99.6%,较平衡数据下的平均分类准确率提高了0.1个百分点,较传统和积网络提高了1.2个百分点。2组数据中的平均识别准确率均达到了99.5%。本文方法在4 500张数据时识别准确率已趋于饱和,说明模型对训练样本数的要求较少。在非平衡数据中传统和积网络的平均分类准确率为98.4%,相对于平衡数据提高了1.7个百分点。平均召回率为98.6%,提高了1.9个百分点。说明增加训练样本,对于和积网络的识别效果有所帮助。卷积神经网络在非平衡数据中的平均分类准确率和平均召回率为99.5%,较平衡数据均提高了0.4个百分点。可以看到训练数据较大时,所有方法的识别准确率均有上升,但对于非平衡数据,卷积神经网络更容易受到有更多数据的类的影响,相比于其他类别更为敏感,如在阔叶型杂草出现的现象,易误分为训练样本较多的类别,这种情况同样出现在和积网络中。

轻量和积网络的每个内部节点在其作用域上均定义了一个概率分布,其内部节点可看作特征提取器。为了将提取到的特征进行可视化,使用文献[30]中的方法自向下遍历网络,使每个叶结点根据自身的分布在实数集上生成一些观测值,相对于原始RGB图像,通过作用域函数对输入空间编码得到的大豆苗、禾本科杂草、阔叶型杂草及土壤的二值图像和伪彩色图像如图7所示。

注:从左至右依次是大豆苗、禾本科杂草、阔叶型杂草和土壤。

2.2 模型性能分析

卷积神经网AlexNet[16]中输入图片大小为256×256×3,第一层卷积有96个11×11×3的卷积核,第二层有256个5×5×48的卷积核,第三层有384个3×3×256的卷积核,第四层有384个3×3×192的卷积核,第五层有256个3×3×192个卷积核。前2层全连接层含有4 096个节点,总参数量为61 011 208。和积网络的参数量可通过节点计数器累加得到,采用多次训练后的均值。2次试验中轻量和积网络的训练时间、内存大小、参数量对比LearnSPN,卷积神经网络AlexNet0性能结果分析表如表 2所示。

由表2可知,轻量和积网络模型的平均参数量在平衡数据下较传统和积网络减少了482 637,约66.70%。在非平衡数据下参数量减少了1 916 572,约66.67%。即2组试验中轻量和积网络的平均参数量为传统和积网络参数量的33%。内存占用在最大时较传统和积网络减小了549 M,较卷积神经网络减小了1 072 M。和积网络的结构随着输入数据的不断增加,其深度逐步加深,网络结构不固定。而卷积神经网络的结构固定,其参数量与输入图片尺寸,卷积核大小、个数等有关,与输入数据量无关。对于15 000张的数据,轻量和积网络的参数量仍远小于卷积神经网络,说明轻量和积网络仍适用于较大数据。

此外,使用轻量和积网络作为杂草识别模型,在平衡数据下的平均训练时间较传统和积网络减少了282.15 s,在非平衡数据下减少了688.79 s。因为小批量的学习方式只需经数据的一次传递,因此对于较大数据集,其学习速率高于批量学习。因和积网络紧凑的网络结构,使其在内存占用和训练时间上均优于卷积神经网络。

表2 不同模型算法的性能结果分析

3 结论与讨论

本文以大豆苗中常见禾本科杂草和阔叶型杂草为研究对象,提出了一种基于轻量和积网络的杂草识别模型。模型首先使用均值聚类作为低层特征提取器,然后将提取的特征下采样,再将采样特征以小批量数据作为输入训练轻量和积网络。在结构学习中,当积节点作用域内的变量个数小于一定阈值时,合并积节点为多元叶节点,否则将积节点重组为和积混合结构,并采用一定方式对边缘冗余节点和子树进行裁剪,这样有效降低了模型的参数量和复杂度,且提出以贝叶斯矩匹配的方法更新网络参数,使得模型对小样本学习的效率更高。在杂草识别中,由网络内部节点学习输入特征的联合概率分布,由根结点输出特征所属类别的概率。对不同类别的杂草,依据识别结果可供无人机选择喷施特定农药。试验结果表明,针对大豆苗、禾本科杂草和阔叶型杂草以及土壤的小样本数据,该模型的平均识别准确率达到了99.5%,参数量仅为传统和积网络的33%,且远小于卷积神经网络,模型占用内存最大时减小了549 M,训练时间最多减小了688.79 s,更适用于无人机等小型嵌入式设备。此外,该模型在训练时间上也具有明显优势。

本文不足之处在于前期对于无人机图像获取的数据需要多步处理,数据集本身依赖于人工分类,部分图像有不同类别重叠,在提取特征时对此类图像的误分类会增大。但通过调整分类阈值,整体识别准确率可达到预期效果。后续可为深入研究轻量和积网络模型在复杂环境中的杂草识别提供参考。

[1] Zhu Jinwen, Wang Jian, Ditommaso A, et al. Weed research status, challenges, and opportunities in China[J]. Crop Protection, 2018: S0261219418300255.

[2] Herrera P, Dorado J, Ribeiro Á. A novel approach for weed type classification based on shape descriptors and a fuzzy decision-making method[J]. Sensors, 2014, 14(8): 15304-15324.

[3] 毛文华,王一鸣,张小超,等. 基于机器视觉的田间杂草识别技术研究进展[J]. 农业工程学报,2004,20(5):43-46. Mao Wenhua, Wang Yiming, Zhang Xiaochao, et al. Research advances of weed identification technology using machine vision[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2004, 20(5): 43-46. (in Chinese with English abstract)

[4] Ip R H L, Ang L M, Seng K P, et al. Big data and machine learning for crop protection[J]. Computers & Electronics in Agriculture, 2018, 151: 376-383.

[5] 赵川源,何东健,乔永亮. 基于多光谱图像和数据挖掘的多特征杂草识别方法[J]. 农业工程学报,2013,29(2):192-198. Zhao Chuanyuan, He Dongjian, Qiao Yongliang. Identification method of multi-feature weed based on multi-spectral images and data mining[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2013, 29(2): 192-198. (in Chinese with English abstract)

[6] 黄玉祥,杨青. 精细农业的环境效应[J]. 农业工程学报,2009,25(增刊2):250-254. Huang Yuxiang, Yang Qing. Impact of precision agriculture on environment[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2009, 25(Supp. 2): 250-254. (in Chinese with English abstract)

[7] Torressánchez J, Lópezgranados F, Castro A I D. Configuration and specifications of an unmanned aerial vehicle (UAV) for early site specific weed management[J]. Plos One, 2013, 8(3): e58210.

[8] Castro A I D, Jurado-Expósito M, López-Granados F. Airborne multi-spectral imagery for mapping cruciferous weeds in cereal and legume crops[J]. Precision Agriculture, 2012, 13(3): 302-321.

[9] Ishida T, Kurihara J, Viray F A, et al. A novel approach for vegetation classification using UAV-based hyperspectral imaging[J]. Computers & Electronics in Agriculture, 2018, 144: 80-85.

[10] Barrero O, Perdomo S A . RGB and multispectral UAV image fusion for gramineae weed detection in rice fields[J]. Precision Agriculture, 2018, 19(5): 809-822.

[11] Du M, Noguchi N. Monitoring of wheat growth status and mapping of wheat yield’s within-field spatial variations using color images acquired from UAV-camera system[J]. Remote Sensing, 2017, 9(3): 289.

[12] 李先锋,朱伟兴,纪滨,等. 基于图像处理和蚁群优化的形状特征选择与杂草识别[J]. 农业工程学报,2010,26(10):178-182. Li Xianfeng, Zhu Weixing, Ji Bin, et al. Shape feature selection and weed recognition based on image processing and ant colony optimization[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2010, 26(10): 178-182. (in Chinese with English abstract)

[13] 毛罕平,胡波,张艳诚,等. 杂草识别中颜色特征和阈值分割算法的优化[J]. 农业工程学报,2007,23(9):154-158. Mao Hanping, Hu Bo, Zhang Yancheng, et al. Optimization of color index and threshold segmentation in weed recognition[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2007, 23(9): 154-158(in Chinese with English abstract)

[14] 曹晶晶,王一鸣,毛文华,等. 基于纹理和位置特征的麦田杂草识别方法[J]. 农业机械学报,2007,38(4):107-110. Cao Jingjing, Wang Yiming, Mao Wenhua, et al. Weed detection method in wheat field based on texture and position features[J]. Transactions of the Chinese Society for Agricultural Machinery, 2007, 38(4): 107-110. (in Chinese with English abstract)

[15] Potena C, Nardi D, Pretto A. Fast and accurate crop and weed identification with summarized train sets for precision agriculture[C]//International Conference on Intelligent Autonomous Systems. Springer, Cham, 2011: 105-121.

[16] Dos A, Ferreira S, Matte D, et al. Weed detection in soybean crops using convnets[J]. Computers & Electronics in Agriculture, 2017, 143: 314-324.

[17] 王璨,武新慧,李志伟. 基于卷积神经网络提取多尺度分层特征识别玉米杂草[J]. 农业工程学报,2018,34(5):144-151. Wang Can, Wu Xinhui, Li Zhiwei. Recognition of maize and weed based on multi-scale hierarchical features extracted by convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(5): 144-151. (in Chinese with English abstract)

[18] Li Huiming, Fan Xitian, Li Jiao, et al. A high performance FPGA-based accelerator for large-scale convolutional neural networks[C]// International Conference on Field Programmable Logic & Applications. IEEE, 2016: 1-9.

[19] Poon H, Domingos P. Sum-product networks: A new deep architecture[J]. Research Gate, 2012, 21(5): 689-690.

[20] Rathke F, Desana M, Schnörr C. Locally adaptive probabilistic models for global segmentation of pathological OCT scans[C]// International Conference on Medical Image Computing and Computer-Assisted Intervention. Springer, Cham, 2017: 177-184.

[21] Sguerra B M, Cozman F G. Image classification using sum-product networks for autonomous flight of micro aerial vehicles[C]//2016 5th Brazilian Conference on Intelligent Systems (BRACIS). IEEE, 2016: 139-144.

[22] Amer M R, Todorovic S. Sum Product Networks for Activity Recognition[M]. IEEE Computer Society, 2016.

[23] Peharz R, Kapeller G, Mowlaee P, et al. Modeling speech with sum-product networks: application to bandwidth extension[C]// IEEE International Conference on Acoustics, Speech and Signal Processing. IEEE, 2014: 3699-3703.

[24] Butz C J, Santos A E D, Oliveira J S, et al. Efficient examination of soil bacteria using probabilistic graphical models[C]// International Conference on Industrial, Engineering and Other Applications of Applied Intelligent Systems. Springer, Cham, 2018: 315-326.

[25] Gens R, Domingos P. Learning the structure of sum-product networks[C]// International Conference on Machine Learning. ICML, 2013: 873-880.

[26] Achanta R, Shaji A, Smith K, et al. SLIC superpixels compared to state-of-the-art superpixel methods[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(11): 2274-2282.

[27] Coates A , Ng A Y . Learning feature representations with K-means[J]. Lecture Notes in Computer Science, 2012, 7700: 561-580.

[28] Coates A, Ng A, Lee H. An analysis of single-layer networks in unsupervised feature learning[C]//Proceedings of the fourteenth International Conference on Artificial Intelligence and Statistics. ICAISC, 2011: 215-223.

[29] Peharz R, Tschiatschek S, Pernkopf F, et al. On theoretical properties of sum-product networks[J]. Journal of Machine Learning Research, 2015,5: 744-752.

[30] Vergari A, Mauro N D, Esposito F. Visualizing and understanding sum-product networks[J]. Machine Learning, 2018,7: 1-23.

[31] Gens R, Domingos P. Discriminative learning of sum-product networks[C]//Advances in Neural Information Processing Systems. NIPS, 2012: 3239-3247.

[32] Zhao Han, Adel T, Gordon G, et al. Collapsed variational inference for sum-product networks[C]// International Conference on International Conference on Machine Learning. JMLR. org, 2016: 1310-1318.

[33] Rooshenas A , Lowd D . Learning sum-product networks with direct and indirect variable interactions[C]// International Conference on International Conference on Machine Learning. JMLR. org, 2014: 710-718.

[34] Adel T, Balduzzi D, Ghodsi A. Learning the structure of sum-product networks via an SVD-based algorithm[C]// Conference on Uncertainty in Artificial Intelligence. UAI, 2015: 32-41.

[35] Molina A, Vergari A, Di Mauro N, et al. Mixed sum-product networks: A deep architecture for hybrid domains[C]// Proceedings of the AAAI Conference on Artificial Intelligence. AAAI, 2018: 3828-3835.

[36] Vergari A, Mauro N D, Esposito F. Simplifying, regularizing and strengthening sum-product network structure learning[C]// Joint European Conference on Machine Learning and Knowledge Discovery in Databases. Springer, Cham, 2015: 343-358.

[37] Kodinariya T M, Makwana P R. Review on determining number of cluster in K-means clustering[J]. International Journal, 2013, 1(6): 90-95.

[38] Anandkumar A, Hsu D, Kakade S M. A method of moments for mixture models and hidden markov models [C]//Conference on Learning Theory. COLT, 2012: 33. 1-33. 34.

[39] Minka T, Lafferty J. Expectation-propagation for the generative aspect model[C]//Proceedings of the Eighteenth conference on Uncertainty in artificial intelligence. Morgan Kaufmann Publishers Inc. , 2002: 352-359.

Soybean field weed recognition based on light sum-product networks and UAV remote sensing images

Wang Shengsheng1, Wang Shun2, Zhang Hang2, Wen Changji3

(1.,,130012,; 2.,,130012,; 3.,,130118,)

In weed control, using unmanned aerial vehicle (UAV) to obtain images, spraying specific pesticides according to different weed communities is an effective means of prevention and control. Sum-product networks is suitable for small embedded devices such as UAV. But it has many parameters, long training time, and more redundant nodes and subtrees in the image classification task, so that the recognition accuracy is not high. In response to these problems, this paper improved the learning process of traditional sum-product networks and used a mini-batch learning method to construct a network model through one pass of data. Its lightweight structure required less hardware resources and was more suitable for small embedded devices such as drones. It had reference significance for the subsequent spraying of pesticides by drones. For the input image, the light sum-product networks weed recognition model first used-means clustering as the low-level feature extractor to obtain the feature dictionary, then downsampled the extracted features, and took the sampling features into mini-batches of data as input to train the light sum-product networks.Each category corresponds to an independent network structure, and the high-level features were extracted by internal nodes in the network structure. The probability values of the corresponding categories were output by the root nodes to identify weeds. The network structure was updated by comparing the correlation coefficients between variables. Bayesian moment matching was used to update the network parameters. To simplify the structure, when a product node had only one child, it was removed from the network, and its child nodes were connected to its parent node. Similarly, if a sum node was the last node of another sum node, then the child node was deleted and all its child nodes were promoted one layer up. This effectively reduced redundant edge branches and made the model structure lighter. Using this method, the average classification accuracy of soybean seedlings, grass weeds, broadleaf weeds and soils in UAV images was 99.5%, and the average sensitivity was 99.6%. And the model parameter quantity was only 33% of the traditional sum-product networks. The parameter quantity would increase with the input of the data flow. The amount of parameters was still much smaller than traditional convolutional neural networks AlexNet when using the larger data sets to construct the light sum-product networks. It showed that the model was suitable for larger data sets. The memory usage was reduced by 549 M compared to the traditional sum-product networks and was reduced by 1 072 M compared to the convolutional neural networks. The maximum average training time was reduced by 688.79 s compared to the traditional sum-product networks, which was much less than the convolutional neural networks. The experimental results showed that using the light sum-product network as the weed recognition model, the model parameters were less, the memory requirements were lower, and the training time was shorter without loss of precision. The shortcoming was that the data acquired by the UAV image in the previous stage needed to be processed in multiple steps. The data set itself relied on manual classification. Some images had different categories of overlap, and the misclassification of such images would increase when the features were extracted. However, by adjusting the classification threshold, the overall classification can achieve the desired results. The research can provide a reference for the use of light sum-product networks in weed recognition of UAV spraying pesticides.

unmanned aerial vehicle; remote sensing; recognition; sum-product networks; structure learning; parameter learning; weed

2018-11-14

2019-02-11

吉林省科技发展计划项目(20190302117GX,20180101334JC, 20180101041JC);吉林省教育厅科研规划重点课题(2016186)

王生生,教授,博士生导师,主要从事机器视觉、农业信息化方面的研究。Email:wss@jlu.edu.cn

10.11975/j.issn.1002-6819.2019.06.010

TP391.41

A

1002-6819(2019)-06-0081-09

王生生,王 顺,张 航,温长吉. 基于轻量和积网络及无人机遥感图像的大豆田杂草识别[J]. 农业工程学报,2019,35(6):81-89. doi:10.11975/j.issn.1002-6819.2019.06.010 http://www.tcsae.org

Wang Shengsheng, Wang Shun, Zhang Hang, Wen Changji. Soybean field weed recognition based on light sum-product networks and UAV remote sensing images[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(6): 81-89. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2019.06.010 http://www.tcsae.org