基于RSD的边缘数据中心构建方法研究

郭玉华 贾宝军 侯 乐 程筱彪 徐 雷

中国联通研究院 北京 100176

引言

在万物互联时代,数据中心需要处理海量设备收集上来的数据,处理完成以后还需要反馈到终端进行执行。数据中心在处理数据过程中需要消耗大量云端资源,对于实时性要求比较高的场景,比如智能驾驶、障碍物监测等,会影响数据处理效率,产生严重后果。边缘计算是万物互联的产物,能够在靠近数据源的区域,就近提供网络、计算、存储等资源,可以更好地满足业务的实时性要求,驱动了数据中心的发展。

未来数据中心的发展将会呈现出两极化发展趋势,云数据中心将会集中更多资源,成为超大规模数据中心;边缘数据中心作为用户和超大规模中心之间的缓存和数据聚合点,将会成为云数据中心的补充,与云数据中心协作,共同完成庞大数据的处理工作。边缘数据中心的发展已经进入白热化阶段。虽然目前仅有10%的企业采用传统集中式数据中心或云服务以外的边缘模式来创建和处理数据,但是根据Gartner预测,到2022年,这一比例将达到50%。此外,运营商也在积极投入到边缘数据中心的规划工作中。AT&T在2015年发起了CORD(Central Office Re-Architected as a Data Center)项目,进行传统机房改造,将CT设备替换成通用的IT设备,同时,中国联通也积极参与了其中的M-CORD项目,强化移动边缘计算能力。

RSD(Rack Scale Design)架构服务器,是一个能对计算、存储、网络资源进行解耦、资源池化及重构的逻辑架构,通过对CPU、内存、PCIe、存储等资源进行机柜级组合调度,并依托Redfish管理接口,可以让数据中心资源实现更有效的部署和利用。相较于通过RSD架构服务器构建云数据中心,通过RSD架构服务器构建边缘数据中心更具有挑战性。边缘数据中心更加靠近数据源,在定制化服务能力方面有更高的要求,需要能够根据预期的工作负载性能和容量要求,提供基础设施资源端到端的定制化服务。利用RSD架构服务器具有的资源池化和硬件解耦能力,能够满足边缘数据中心定制化服务能力要求;因此,边缘计算和RSD架构服务器的结合会变得很有意义。

1 RSD架构服务器和边缘计算技术简介

1.1 边缘计算

边缘计算是在靠近数据源附近的网络边缘侧执行数据处理能力的一种方法。边缘计算可以降低用户和超大规模中心之间的带宽需求、缓解链路负载压力,满足业务所需的数据处理低时延要求。边缘计算作为一种新兴技术,在标准和开源方面得到重大发展。

在标准方面,许多标准组织正在定义各种边缘计算标准。2016年4月,ETSI(欧洲电信标准协会)发布了与MEC相关的标准,提出7大业务场景,并对每个场景进行了详细描述[1]。2016年11月在首届边缘计算产业峰会上,以华为、英特尔、中国科学院沈阳自动化研究所为代表的公司和机构就专门成立了边缘计算产业联盟[2]。

在开源方面,许多开源社区也在成立各种边缘计算项目。2018年3月,Linux基金会宣布成立了Akraino项目,该项目的主要目标是集成多个边缘计算相关的开源项目,提供更高层次的API集合来统一管理基础设施,为客户提供端到端的边缘计算解决方案。2018年5月,OpenStack基金会宣布成立了StarlingX项目,该项目由Intel主导,主要提供边缘基础设施的管理服务。

1.2 RSD架构服务器

RSD架构服务器代表着下一代软件定义的基础设施,可以跨计算、网络和存储资源进行动态配置。该架构实现了硬件的全面解耦,并能通过硬件资源池化,根据业务需求实时定制硬件设备,进而为应用提供真正灵活、弹性的基础设施资源支持。

RSD核心管理组件包括Redfish API、OpenStack EPA和PODM三部分。

1)Redfish API:基于DMTF的开放Redfish API行业标准规范,旨在利用开放、通用的接口来提高多厂商设备的连通性和管理效能。它利用JSON格式和OData来指定一个RESTful接口,帮助用户将相关工具链整合到解决方案中。利用Redfish API, RSD能够有效整合管理多厂商设备。

2)OpenStack EPA:EPA可以在启动虚拟机之前完成负载与平台基础设施性能的精细匹配。EPA功能的加入,能够帮助RSD加强对底层基础设施的感知能力,并平衡工作负载与平台性能,以增强应用性能。

3)PODM:PODM(Pod Manager)是一个提供了图形化能力的软件接口,它可帮助用户更加直观地了解RSD中存在哪些池化的资源。通过PODM,用户能够对服务器资源进行可视化管理,并更为方便地进行优化和重构。

2 基于RSD的边缘数据中心构建方法

目前,由于大数据、大视频以及人工智能等创新业务的发展,对硬件资源池的使用提出了更高要求。边缘数据中心在构建过程中,需要以“提升IT基础设施的应用灵活性”为目标,积极探索新的技术和方案。

OpenStack作为业界公认开源云平台,为全球众多知名企业提供云技术支持,能够帮助他们支持自身新产品部署、内部系统升级和研发成本降低。2018年2月,OpenStack基金会发布白皮书《云边缘计算:超越数据中心》,强调了OpenStack作为边缘计算云端平台特别具有吸引力,已经建立的组件和体系结构有机会参与边缘计算市场竞争[3]。

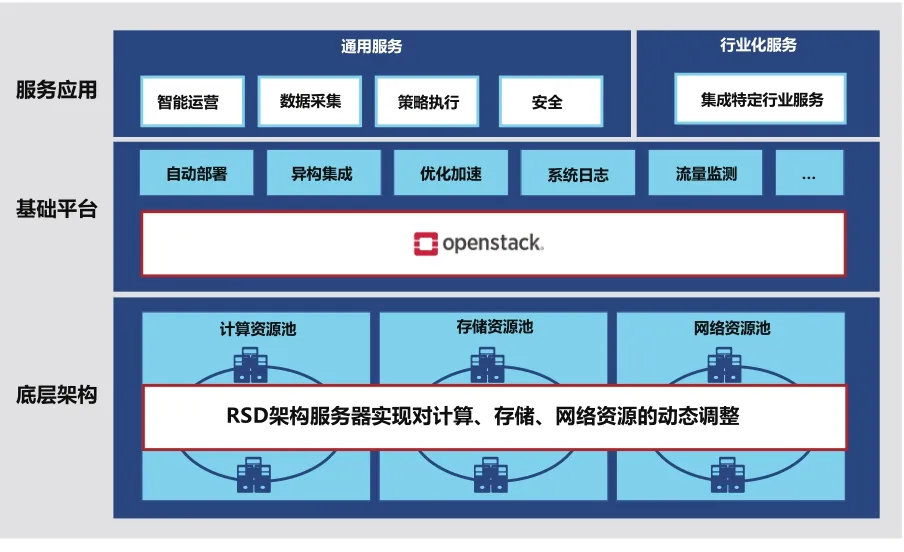

本文将RSD基础设施逻辑架构和OpenStack开源云计算平台进行结合,提出了一种“边缘数据中心物理资源RO构建方法”,实现了资源池化构想,使基础设施能够快速、灵活地响应上层业务应用的变化,提高了资源利用率。如图1所示。

RSD架构服务器可以进行物理资源重构,将传统服务器解耦合,打破服务器节点的概念,将计算、存储、网络等各类资源从紧耦合关系变成可以被软件调度的松耦合关系,最终将其进化为可根据业务负载匹配的硬件基础架构[4]。

图1 边缘数据中心架构图

OpenStack云平台可以按需进行资源管理。在计算资源池中,OpenStack云平台可以根据预订的参数值的大小过滤出匹配的资源,如CPU、内存、硬盘等。云平台还可以将存储资源、网络资源与计算资源进行组合成裸机服务,提供给上层应用使用。为了保证服务的完整性,云平台支持裸机自动化部署操作系统,能够通过API接口统一管理,还可以按需从资源池申请或回收资源,极大地降低了裸机管理的成本。目前行业现有方法主要以提供虚拟机为主。该方法存在内存容量限制。当系统需要运行大容量内容或较高计算资源支持的应用程序,就面临不能够提供充足资源支撑系统运行的风险;系统由专有硬件组成,专有硬件可能所属不同厂商,就面临统一运维管理的风险;当系统需要横向扩展,就面临性能和容量不能快速增长的风险[5-8]。与行业现有方法相比较,边缘数据中心物理资源RO构建方法,打破了内存容量的限制,面对系统运行峰值,可以提供足够资源支撑运行;构建池化资源池,实现软硬件的解耦;通过API接口统一管理,可以按需从资源池申请或回收资源。

边缘数据中心物理资源RO构建方法,主要适用于对硬件和可扩展性要求比较高、对硬件资源支撑依赖度高的场景。例如,大数据分析类平台,需要进行海量数据计算,对硬件和可扩展性要求比较高。数据库类应用,一般对硬件资源支撑依赖度比较高。在现有部署方式中,普遍采用专有硬件[9-10]。该类应用平时使用量不大,会在特定时间产生使用峰值。这就造成若投入硬件太多时,低计算量会有资源浪费现象,若投入硬件太少时,峰值情况会有无法满足性能需求现象。

3 测试及结果分析

本次POC测试,研究基于RSD和OpenStack的应用和功能实现,掌握RSD技术与OpenStack技术的结合重点,探索边缘数据中心构建解决方案。测试范围主要包括:RSD与OpenStack集成测试、RSD基本功能测试、OpenStack计算节点与存储节点横向扩展测试。

3.1 测试环境与组网

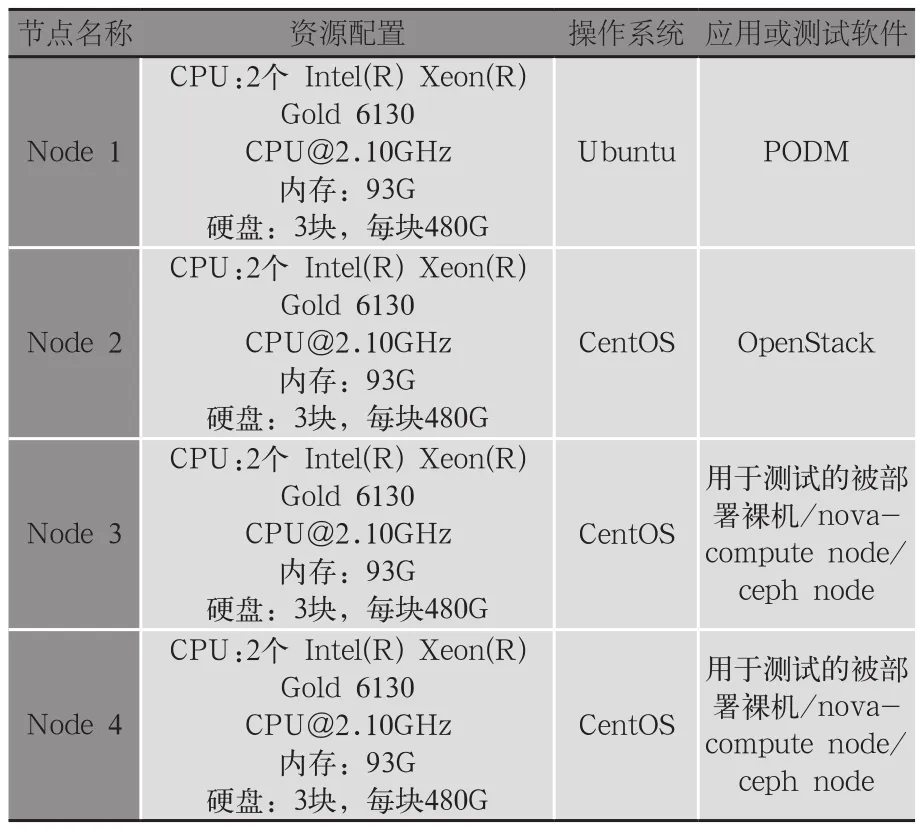

1)测试网络环境。如图2所示,测试环境中有1台机架服务器和2台交换机,机架服务器中有4个节点,分别命名为Node1、Node 2、Node 3和Node 4,每个节点均有两个网卡,网卡0和网卡1分别接到交换机LB9和LY8上。

图2 测试组网拓扑图

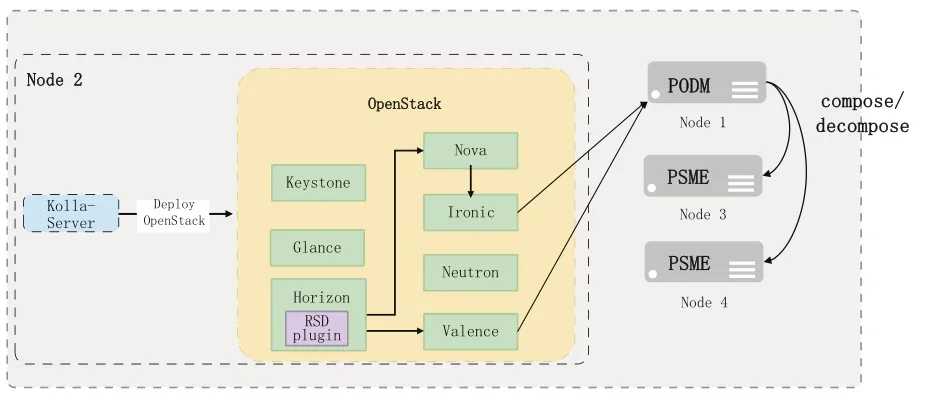

2)测试组网方案。本次测试中,4个节点的拓扑结构如图3所示。

图3 测试节点拓扑图

1)Node 1安装了PODM。PODM主要调用底层的PSME接口,获取资源池中的各种硬件资源,同时提供硬件重构的能力。

2)Node 3和Node 4安装了PSME。PSME能把Node 3和Node 4存储的硬件资源进行相关属性抽象,并提供API接口来供PODM调用。

3)Node 2安装了OpenStack,其控制面板Horizon安装了RSD插件,通过该插件,可以调用PODM对Node 3和Node 4的物理资源进行管理。

用户通过Node 2的RSD插件,调用Node 1的PODM,可以对Node 3和Node 4的物理资源进行Compose和Decompose。

3.2 测试资源

1)机柜环境。测试环境使用机房现有机柜,共占用机柜位8U,如表1所示。

表1 机柜设备功耗

2)IP网络配置。对4个节点进行IP网络配置,如表2所示。

表2 IP网络配置

Node 1两个网卡,网卡0配置IP地址为10.3.0.1,网卡1配置IP地址为10.1.98.9。

Node 2两个网卡,网卡0配置IP地址为10.3.0.42,网卡1分配两个IP地址,分别为10.1.99.10和10.1.99.100,在测试过程中,可以证明PODM能够实现多租户管理能力。

Node 3和Node 4用来存储物理资源,不需要配置IP地址。Node 3和Node 4上安装有PSME插件,能获取Node 3和Node 4底层硬件资源信息,把资源信息进行相关的属性抽象,并提供API接口来供Node 1调用。

图2为纯氧化钼XRD标准图谱及不同固液比制备样品XRD谱图。图2曲线1∶6、1∶10、1∶15衍射峰相同,且与三氧化钼曲线衍射峰相同,证明1∶6、1∶10、1∶15样品中金属钼的赋存状态为三氧化钼。钼精矿100 g,氧气分压1.20 MPa,温度200 ℃,搅拌转速500 r/min,保温保压时间为300 min,固液比在1∶6~1∶15,可以将钼精矿转化为三氧化钼。

3)RSD网络配置包括RSD管理网络和数据网络。

a)管理网路。

PODM Management Network

Non-VLAN

IP Subnet ID : 10.3.0.0/16

DHCP Server on PODM for Management Network

PODM default IP : 10.3.0.1/16

PSME IP: Dynamic IP from PODM DHCP Server

No DHCP Server (Customer need setup DHCP server for Data Network)

Support Multitenant Network

Partition Tenant Network VLAN by RSD VLAN or Compose API

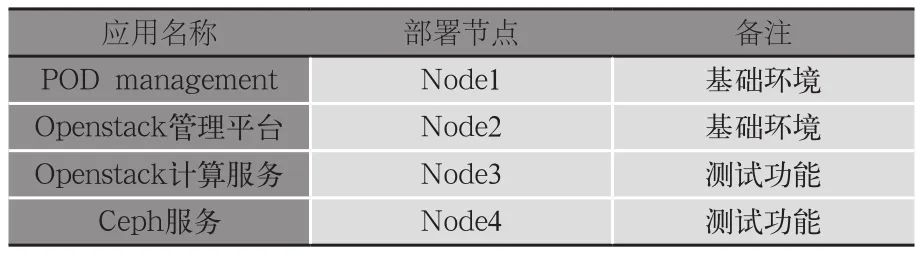

4)节点功能。Node 1作为部署PODM插件的节点,Node 2作为部署OpenStack云平台的节点,Node 3和Node 4作为被测试节点,如表3所示。

表3 服务器功能

5)应用及测试软件,如表4所示。

表4 应用及测试软件

3.3 测试结果及分析

本次测试,分为PODM管理测试、物理资源管理测试、裸机测试、裸机多品牌支持测试、监控测试、添加计算节点测试、添加Ceph存储节点测试、移除计算节点测试、移除存储节点测试、管理组件(容器)回滚测试、管理组件(容器)升级测试共11个大类21项测试用例。

根据预置条件设置环境参数按照测试步骤完成测试,查看每一个测试用例的实测结果与预期结果是否一致。

通过在测试环境下的功能测试以及云平台和数据中心中的节点重构,裸机服务、云平台节点缩容、扩容和云平台的服务升级等业务功能均达到预期目标,实测结果与预期结果完全一致,成功率为100%。

其中,成功率 = 与预期结果一致的测试用例数/测试用例总数×100%。

本次测试在现阶段已经验证了边缘数据中心物理资源RO构建方法在灵活动态硬件资源可扩展性方面的能力,利用边缘数据中心物理资源RO构建方法可以更加高效地实现硬件资源调度,使数据中心的灵活性得以大幅提升。具体体现为以下两点。

1)OpenStack云平台可以按照给定的CPU、内存、硬盘大小参数,从资源池中过滤出最匹配的计算资源,并和存储、网络资源组合提供给使用者,而且它提供API接口,允许用户对资源进行统一管理,还可以允许用户按需从资源池申请或回收资源,极大降低了管理成本;2)打破服务器节点的概念,将计算、存储、网络等各类资源从紧耦合关系变成可以被软件化的松耦合关系,实现了物理资源重构,最终将其进化为可根据业务负载匹配的硬件基础架构。

4 结语

边缘数据中心物理资源RO构建方法目前处于探索和验证阶段,在落地实施阶段,会面临与测试模型有差异的现象,如资源管理、与现有业务系统业务逻辑对接等问题。此外,要实现硬件资源池化,需要整个产业链在软、硬件上的全面协作和充分优化,该方法在落地实施之前,需要集合产业链的力量,打造开放的标准。

基于边缘数据中心物理资源RO构建方法构建的边缘数据中心将有望在数据中心转型中发挥重要作用,未来可以进一步推进硬件资源管理的自动化,减少人工干预,加速业务部署和创新。