一种运动背景下视觉注意辅助的目标检测方法

李鹏 王延江

摘 要:针对运动背景下序列图像中前景目标难以准确检测的问题,提出了一种视觉注意辅助ViBe算法的目标检测方法.首先利用提出的“记忆窗”随机抽样一致性算法估计出背景运动模型,再将补偿后的帧图像送入视觉显著性辅助ViBe算法进行目标检测,其中背景更新因子由图像的二维熵和显著性共同决定,同时,显著性特征也被用来对“鬼影”效应进行滤波抑制.实验结果表明,在缺乏运动前景目标的先验知识的情况下,本方法能够有效地解决通常方法对运动背景中的目标难以甚至无法检测的问题,并且具有较高的鲁棒性和检测效率.

关键词:视觉注意;匹配;目标检测;置信度

中图分类号:TP391.4 文献标志码:A

Abstract: It is difficult to detect the foreground targets accurately in the sequence images in the situation of moving background. According to the characteristics of the targets in moving backgrounds, a fast visual saliencyaided ViBe method was proposed. The “memory window” random sample consensus algorithm was first proposed to estimate the background motion model. Then, the compensated frames were delivered into the detection algorithm with adaptive background updating factor determined by the twodimensional entropy and saliency of the image. The saliency was also used to suppress the “ghost” effect. Experimental results show that, in the absence of prior knowledge of the moving foreground targets, the proposed method can effectively detect targets in the situation of moving background, and it also has good robustness and high efficiency.

Key words: visual attention;matching;target detection;confidence

運动目标检测是计算机视觉领域研究的热点之一.根据摄像头是否保持静止,可分为静态背景下的检测和运动背景下的检测[1].其中,运动背景下的目标检测由于整体场景发生移动、旋转或抖动,增加了检测的难度.

基于图像序列(或视频)的目标检测常用的方法[2]主要有帧差法、背景差法和光流法等.帧差法所提取的运动目标内部易产生空洞甚至因快速运动造成不连续现象,虽然目前的三帧差法、五帧差法等对此有一定改善,但效果仍欠佳.背景差分法的检测效果依赖于背景模型的准确性,其中高斯混合模型(Gaussian Mixture Model,GMM)是应用广泛的方法之一[3].GMM对于静态背景下的检测有良好的鲁棒性,但是其更新学习的方式运算代价较大.ViBe[4]算法是近年提出的一种像素级的快速有效且易于实现的背景建模算法,它利用首帧即可初始化背景模型,对静态背景下的运动目标能取得良好的检测效果.光流法是近年来运动目标检测的一个研究热点,其在运动边界处的计算误差较大,而且算法中亮度恒定的假设通常会被光照变化和噪声破坏,此时将难以得到准确的目标运动信息.Liu等[5]在彩色图像的基础上提出了SIFT流方法,利用了SIFT描述子的尺度、旋转和仿射不变性.虽然SIFT流相较传统光流法提高了运动检测效果,但计算代价过大,因此处理效率较低.

事实上,在运动背景下检测运动目标,往往需要对背景进行全局运动补偿[6],其核心是通过相邻帧背景中对应数据点间的匹配来估计全局背景运动参数,从而将检测行为“转化”到静态背景情形下.Kim等人[7]提出了一种基于多单应性矩阵的运动背景下的目标检测方法,能较好地检测到目标,但检测出的目标形状往往不完整或有较大空隙,且该方法处理效率较低.Yang等人[8]提出一种基于空时特征的背景建模方法,通过无记忆的更新策略对背景模型进行更新来提取运动目标.该方法也能较准确地定位运动成份,但却容易造成目标的割裂.随机抽样一致性(random sample consensus,RANSAC)算法[9]具有易于实现和鲁棒性高的优点,是当前最流行的一种全局参数估计算法.但其主要缺点是迭代次数随“局外点(outliers)”比例的增加而急剧增长,导致算法效率显著降低.文献[10-11]提出了快速RANSAC算法,利用预检验或者在局内点集中重抽样等办法,大大提高了算法的收敛速度.近年来,研究人员在目标检测中引入视觉注意机制来提高检测准确度,文献[12]采用视觉注意机制结合粒子窗的方法,通过建立多级分类器来检测运动目标,取得了较好效果.但是该模型需要训练Adaboost或SVM分类器,不具备实时性.文献[13]基于视觉注意检测行人,并规划了注意焦点路径,该方法虽能检测到目标的显著位置,但难以获得目标的整体形态轮廓.

根据运动背景下目标检测的特点,本文提出了一种视觉注意辅助的快速运动目标检测方法.首先提出了记忆窗随机抽样一致性(memory window random sample consensus,MWRANSAC)算法,将人类视觉系统(Human Visual System,HVS)的瞬时记忆特性应用到数据点的传播建模,对各匹配数据点对(pointpair)按照其置信度的大小进行重要性抽样,提高了算法的收敛速度.为了得到运动前景目标,将视觉注意机制引入至ViBe框架,利用视觉注意机制辅助生成动态背景更新因子,同时视觉注意也被用来对“鬼影(ghost)”进行有效的抑制.

1 MWRANSAC算法

HVS具有快速检测、搜索感兴趣目标的能力.视觉和心理学的研究表明,在缺乏运动目标的形状和运动规律等先验知识的情况下, HVS的瞬时记忆功能对运动目标的检测具有一定促进作用[14-16].受此启发,本文提出一种快速的MWRANSAC算法,对各数据点按照滑动窗内历史信息赋予其可变权重,根据权重大小进行重要性抽样,从而加速RANSAC算法的执行.

1.1 RANSAC 算法

1.2 基于滑动窗的数据点置信传播

1.2.1 数据点的映射

令图像序列的第t帧记作It,我们首先采用简单快速的FAST算法检测出角点[19],其中的角点定义为邻域内有足够多的像素点处于不同的灰度阶的像素点.由于序列中各帧的角点数并非固定,对It保留最显著的Nct个角点组成该帧的角点集: Pt=pitNcti=1,其中pit表示It的第i个角点.定义It的数据点集Dt为Pt与前一帧数据点集Dt-1在It的映射集的并集,即有:PtDt.两相邻帧间的匹配点映射采用金字塔LucasKanade(LK) 稀疏光流方法获得[20],相邻帧(不失一般性,分别记作 It-1和It)间的数据点映射示意图如图1所示.其中,黑实心圆点表示该帧中的角点数据点,空心圆点表示非角点数据点;各有向线段表示邻帧各点间的匹配映射.第i对匹配点对中两个点的坐标分别记作(xit,yit)和(xi′t,yi′t),点对间的位移向量记作vit.需要注意的是,由于各幀角点提取的独立性,It-1中的角点在It中的匹配点不一定再是角点;It-1中的非角点(首帧除外)在It中的对应点也可能首次或再次成为角点.相邻两帧间由于场景的全局运动使得部分数据点在帧边缘处进入或者离开场景,导致这些点无法找到正确的对应点而形成误匹配.实验表明,这些边缘点的光流矢量大小易于很小或者很大,因此本节算法中设定两个阈值Tbtm和Ttop以去除误匹配点.

1)鬼影效应.当首帧中存在前景运动目标时,由于目标像素也会作为背景加入到初始背景模型中,因此即使当运动目标移动走后,在其原处也会误检测到“目标”,形成所谓的鬼影.图2是我们用人工二值图像序列得到的鬼影示意图.序列中只包含一个大小5×5像素的方形运动目标(显示为白色).由于第1帧包含运动目标,从第2帧开始的后续帧中ViBe除顺利检测出运动目标外(图2的第2行),也在对应于首帧原目标位置处误检测到鬼影.

虽然随着序列检测过程的进行鬼影会逐渐变小乃至消除,但由于其一般具有几十到上百帧的持续时间(以上人工序列中鬼影持续到第24帧),将严重影响目标检测结果的准确性.

2)固定背景更新因子.在背景模型更新过程中,并不是在每一帧数据都进行更新,而是按一定的更新概率1/φ(通常取φ=16),算法计算量较小,但这也意味着背景样本集只有1/16的概率得到更新,当背景变化很快时,背景模型无法适应这一变化,导致检测性能下降.

2.2 视觉注意机制下的背景更新

为了克服ViBe的鬼影效应以及固定背景更新因子所带来的问题,我们引入视觉注意机制.

2.2.1 综合显著图的提取

HVS对于运动的或者与周围反差较大的物体反应较为敏感[23].根据这一视觉感知特性,本文提取空域静态显著特征和时域运动显著特征,并动态加权融合得到综合显著性图.

静态视觉注意数学模型大体上可分为认知模型、决策论模型、频域模型和图论模型等[24].相较之下,我们选择运算速度具有优势的频域模型作为本文静态显著性(图)的提取模型.其中,Hou 等人[25]提出了利用“图像签名(Image Signature ,IS )”算子对显著性进行描述,在离散余弦(Discrete CosineTransform,DCT ) 变换域中定义符号函数,通过对重构图像平滑滤波提取显著区域.徐超等人[12]的实验表明,IS频域模型具有快速的平均运行时间,同时所提取的显著图也具有较高的综合准确度.因此本文采用IS模型作为静态显著性的获取手段.

实验表明,采用上述再初始化方法在绝大多数情况下经过连续11帧左右即可较好地抑制鬼影.之所以很难在更短的时间内完全抑制鬼影,是由于视觉显著图往往并不具备精细的目标轮廓,因而在算法从第2帧开始执行的初始几帧,显著区域往往与鬼影区域有一定的重叠或“粘连”,这在一定程度上影响了再初始化的执行效果.因此,本文算法只在第2帧开始的后续11帧内进行鬼影抑制,而不必在视频序列的每一帧都执行,这样在保证较好的抑制效果的同时兼顾了较低的计算量.

2.3 方法总结

整体检测方法的基本过程如下:

1) 提取FAST角点,用提出的MWRANSAC 算法获取邻帧间的全局运动模型Mbest .

2) 用Mbest对帧图像进行运动补偿,以消除图像的全局运动.

3) 帧图像送入改进的ViBe检测框架.求取显著图,以显著图和二维熵协同产生动态的背景更新因子φ:在背景变化较快的情形下减小φ的值,变化较慢的情形下增加φ的值.用显著图对得到的前景二值图像进行滤波,并结合再初始化操作来抑制鬼影效应.方法的整体流程如图6所示.

3 实验结果与分析

为了验证本文方法的有效性,我们选择来自4个数据库的动态视频序列进行目标检测实验,并与ViBe、SIFT流、文献[7]、文献[8]、文献[13]检测方法以及本文MWRANSAC算法运动补偿后直接采用ViBe算法不采用动态更新因子的情形(以下简称为“静态模型”)进行比较.实验环境为CoreTMi7 CPU 处理器,16 GB内存,Windows 7操作系统的个人电脑,使用Matlab平台+(图像处理工具箱和视觉显著性工具箱).本文测试的总共9个视频序列名称及其参数如表1所示,这些序列包括了运动或动态背景下对刚性或非刚性目标的检测情形,它们分别取自于权威的change detection检测视频集[28],序列6~序列9(序列6去掉了下方的日期标签条),VIVID数据库[29](序列1),慕尼黑理工大学形变目标跟踪数据库[30](序列2~序列3)以及FBMS 数据库[31](序列4~序列5).这些序列中,序列6~序列9所有帧的目标块的Ground truth 数据库已经给出,序列4~序列5中原数据库给出部分帧的Ground truth,其余序列中目标的 Ground truth我们人工标注.序列1~序列3的Ground truth也由人工标注产生.

3.2 MWRANSAC算法实验结果与分析

图8是本文第1节MWRANSAC算法与未采用记忆机制的原始RANSAC算法[9]、文献[32]的基于子图像块匹配以及文献[7]的基于多单应性矩阵计算的运动补偿算法的抽样比较结果.我们选择文献[7]和[32]中提出的补偿算法作为比较是因为它们分别较好地代表了目前全局运动补偿方法中基于传统特征匹配的单单应性矩阵(singlehomography matrix)和基于分组的多单应性矩阵(multihomography matrix)两类方法.从图中直观地看到,与图8(g)的传统帧差法相比,各补偿算法(图8(c)~图8(f))在效果上都得到了改善.而这其中,文献[32]和本文的MWRANSAC算法取得了相近的最好的补偿效果.

式中:(i,j)表示像素位置坐标.由全部测试视频序列计算得到的平均灰度差均值和平均计算时间见表2.文献[7]的平均灰度差均值只有2.84,具有最好的补偿效果,本文MWRANSAC算法的平均灰度差均值为2.91,意味着两种算法补偿效果相近;但从计算时间上看,MWRANSAC则具有最高的计算效率,仅为0.016 s,明显低于文献[7]算法.综合来看,相比其他算法本文MWRANSAC算法在保证了较好的补偿效果的同时兼顾了良好的计算效率.

3.3 检测实验结果与分析

3.3.1 定性分析

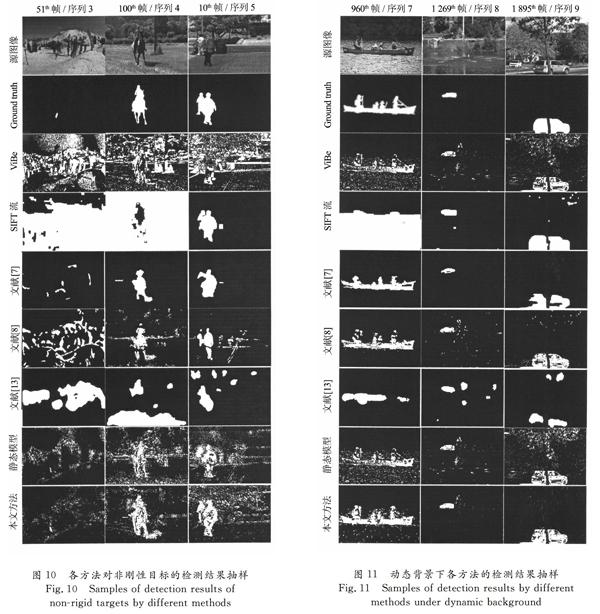

图9是各种方法针对刚性目标进行检测的抽样结果对比.其中,第1行为源图像,第2行为基准(Ground truth)检测结果,第3行到最后1行分别为各算法的对应检测结果.图的第1列是跟随拍摄形成的运动背景情形下的远距离单个运动目标检测;第2列是摄像头抖动造成的运动背景情形下的单目标检测;第3列是远距离多个目标的跟随检测情形. 由图9可知,在运动背景情形下,ViBe方法将许多琐碎背景区域检测为前景,因此已经不能正确地检测出前景目标.SIFT流方法在缺少前景目标先验信息的情况下,依靠矢量流的大小和方向信息也只可得到包含背景区域的大片块状前景,而无法得到确切的运动前景目标.文献[13]方法采用了视觉注意机制,但是在运动背景的情形下也无法得到较为准确的前景目标.文献[7]、文献[8]模型得到的结果直观上好于前述几种方法,但是依然可以看到明显的噪声团块.本文方法无论在平台移动的跟随拍摄或平台抖动造成的背景运动情形中,对于运动目标都可以得到较好的检测效果,这样,在后续的分割过程中辅以一定的形态学运算去噪后即容易得到前景目标.图9中也看到,未采用动态背景更新因子的静态模型得到的检测效果要次于动态更新因子情形,这是因为运动补偿的误差使得背景细节发生不可避免的波动,由此降低了经典ViBe算法的检测效果.

图10是各种方法针对非刚性目标进行检测的对比结果抽样.其中,第1列是平台跟随拍摄形成的运动背景情形下的远距离单运动目标检测;第2、3列分别是运动背景下较近距离的单目标和多目标检测情形.同样,在背景运动的情形下,ViBe算法无法正确检测出前景目标,只有当目标个体较大(较近距离)时,检测出的目标前景点较多;SIFT 流方法在背景全局运动大于前景局部运动情况下(第1列的滑雪者、第2列的骑手),发生严重的前景检测为背景、背景区域检测为前景的“倒置”情况,由此,在不知道目标先验信息的前提下也无法得到运动前景目标.文献[13]方法利用视觉注意机制得到的检测结果总体上好于前几种方法,但是也存在大量背景误检测为前景的情况.而文献[7]和文献[8]检测效果显然优于上述3种方法,但依然存在较为明显的噪声块,且检测到的目标并不完整.本文方法依然可以对于不同情形下的运动目標得到较好的检测结果,同样,静态模型由于前期采用了运动补偿,直观上取得的效果仅次于采用动态更新因子的本文方法.

我们还测试了本文方法在动态背景下的目标检测性能(图11).在本文中,动态背景特指摄像头虽然静止,但背景随时间发生频繁动态变化的情形(如背景是动态的波浪),它可以视作介于静止背景和运动背景之间的一种特例.从图11中看到,几种检测方法的检测效果总体上均要好于运动背景的情形,这是由于没有了背景的整体运动,检测问题变得相对简单,各方法只需要处理背景的琐碎扰动.直观上,在这几种方法中,本文方法有着最为准确的检测结果.这说明,本文方法不仅可以处理运动背景下的目标检测,也可以处理动态背景的情形.事实上,在动态背景的情形下已经不需要对整体运动参数进行估计,经过视觉注意辅助的ViBe算法就可实现目标的检测,而此时本文中静态模型也就褪变为传统的ViBe算法.

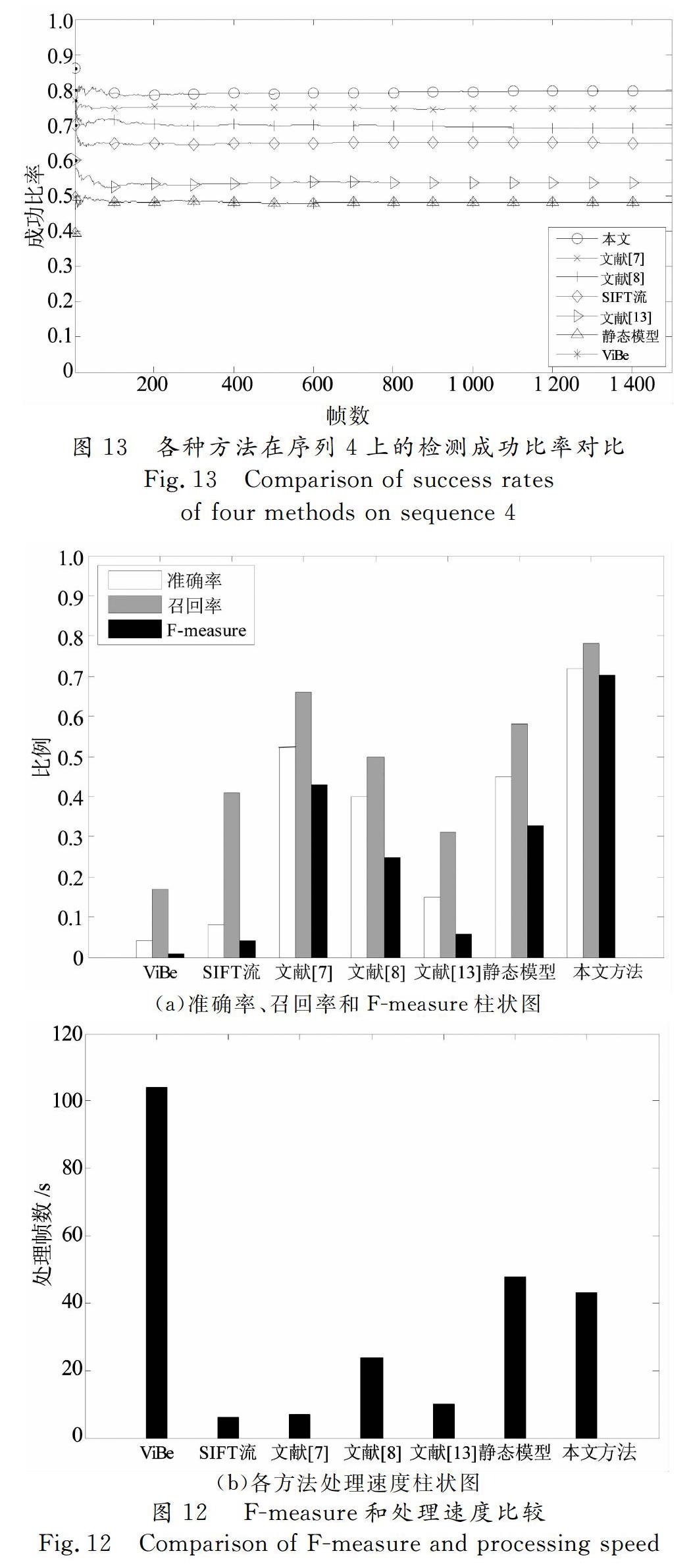

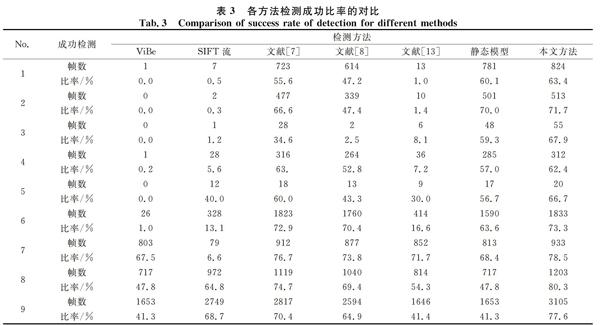

任取序列8,得到其检测成功比率演变规律如图13所示.由图13可知,随着序列目标检测的进行,各算法的成功比率逐渐趋于稳定,其中本文方法拥有最高值,ViBe和静态模型曲线发生了重叠.全部9个序列的检测成功比率具体值则由表3给出.

从表3中可以看到,ViBe、SIFT流和文献[13]方法在运动背景的情形下的成功比率非常低,甚至为0;在动态背景(序列7~9)的情况下这一情况得到改善,但整体仍然不佳.文献[7] 、文献[8]和静态模型在整体上的检测表现则要好得多,而本文方法在运动背景和动态背景情形下的表现平衡,具有最高的平均检测成功比率.

4 结 论

针对背景整体发生运动时难以准确检测前景运动目标的问题,提出了一种基于视觉注意机制改进的ViBe框架的目标检测方法.首先通过记忆窗随机抽样一致性算法得到整体背景运动模型,对帧图像进行运动补偿,再利用视觉注意辅助的自适应背景更新的ViBe算法进行目标检测,其中二维熵和显著性共同控制背景更新因子的自适应取值.显著性也被用来快速抑制“鬼影”,以克服其在运动目标检测中的干扰.实验表明,本文方法对运动背景或动态背景下的刚性、非刚性目标以及单目标和多目标都具有良好的检测能力.

然而,我们也发现本文方法在检测大运动目标(场景空间占比超过1/3)时效果欠佳,这是由于此时邻帧间匹配点对集中包含了较多的前景点,因而造成对背景运动的整体估计欠准确.在未来的工作中,我们考虑融合空间上下文显著性对背景区域进行预判,以进一步提升检测的鲁棒性.

参考文献

[1] 周许超,屠大维,陈勇,等.基于相位相关和差分相乘的动态背景下运动目标检测[J].仪器仪表学报,2010,31(5): 980-988.

ZHOU X C,TU D W,CHEN Y,et al.Moving object detection under dynamic background based on phasecorrelation and differential multiplication[J].Chinese Journal of Scientific Instrument ,2010 ,31(5):980-988.(In Chinese)

[2] 解晓萌.复杂背景下运动目标检测和识别关键技术研究[D].广州:华南理工大学计算机科学与工程学院,2012:1-30.

XIE X M.Research on key techniques of moving object detection and recognition in complex background[D].Guangzhou:School of Computer Science & Engineering,South China University of Technology,2012:1-30.(In Chinese)

[3] CELIK T.Bayesian change detection based on spatial sampling and Gaussian mixture model[J].Pattern Recognition Letters,2011,32(12): 1635-1642.

[4] BARNICH O,VAN DROOGENBROECK M.VIBE: A universal background subtraction algorithm for video sequences[J].IEEE Transactions on Image Processing,2011,20(6):1709-1724.

[5] LIU C,YUEN J,TORRALBA A,et al.SIFT flow:Dense correspondence across scenes and its applications[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2011,33(5):978-994.

[6] 齐美彬,汪巍,蒋建国,等.动态场景下的快速目标检测算法[J].电子测量与仪器学报,2011,25(9):756-761.

QI M B,WANG W,JIANG J G,et al.Rapid moving object detection under a dynamic scene[J].Journal of Electronic Measurement and Instrument,2011,25(9):756-761.(In Chinese)

[7] KIM S,YANG D W,PARK H W,et al.A disparitybased adaptive multihomography method for moving target detection based on global motion compensation[J].IEEE Transactions on Circuits and Systems for Video Technology,2016,26(8):1407-1420.

[8] YANG Y,ZHANG Q,WANG P,et al.Moving object detection for dynamic background scenes based on spatiotemporal model[J].Advances in Multimedia,2017(28):1-9.

[9] HARLEY R,ZISSERMAN A.Multiple view geometry in computer vision[M].2nd ed.Cambridge:Cambridge University Press,2003:116-123.

[10]陳付幸,王润生.基于预检验的快速随机抽样一致性算法[J].软件学报,2005,16 (8):1431-1437.

CHEN F X,WANG R S.Fast RANSAC with preview model parameters evaluation[J].Journal of Software,2005,16(8):1431-1437.(In Chinese)

[11]肖春宝,冯大政,冯祥卫.重抽样优化的快速随机抽样一致性算法[J].计算机辅助设计与图形学学报,2016,28(4):606-613.

XIAO C B,FENG D Z,FENG X W.Fast RANSAC algorithm with resample optimization [J].Journal of ComputerAided Design & Computer Graphics,2016,28(4):606-613.(In Chinese)

[12]徐超,高敏,杨锁昌,等.视觉注意机制下的粒子窗快速目标检测[J].光学精密工程,2015,23(11): 3227-3237.

XU C,GAO M,YANG S C,et al.Visual attention mechanismaided fast target detection by particle window[J].Optics and Precision Engineering,2015,23(11):3227-3237.(In Chinese)

[13]黎宁,龚元,许莙苓,等.视觉注意机制下结合语义特征的行人检测[J].中国图象图形学报,2016 ,21 (6) :723-733.

LI N,GONG Y,XU J L,et al.Semantic featurebased visual attention model for pedestrian detection[J].Journal of Image and Graphics,2016,21 (6):723-733.(In Chinese)

[14]李彬寅,许百华,崔翔宇,等.图像记忆对动态搜索的影响[J].心理学报,2010,42 (4):485-495.

LI B Y,XU B H,CUI X Y,et al.The role of iconic memory in visual search under dynamic condition[J].Acta Psychologica Sinica,2010,42 (4):485-495.(In Chinese)

[15]鲍旭辉,姬鸣,黄杰,等.视觉长时记忆激活度对促进视觉短时记忆的影响[J].心理学报,2014,46(8):1086-1093.

BAO X H,JI M,HUANG J,et al.The effects of activation levels of visual longterm memory on visual shortterm memory[J].Acta Psychologica Sinica,2014,46(8):1086-1093.(In Chinese)

[16]SPERLING G.The information available in brief visual presentations[J].Psychological Monographs: General and Applied,1960,74(11):1-29.

[17]FISCHLER M A,BOLLES R C.Random sample consensus:A paradigm for model fitting with applications to image analysis and automated cartography[J].Communications of the ACM,1981,24(6): 381-395.

[18]刘相滨,邹北骥.一种基于RANSAC的柱面圖像配准算法[J].湖南大学学报(自然科学版),2010,37(8):79-82.

LIU X B,ZOU B J.A RANSACbased cylindrical image registration algorithm[J].Journal of Hunan University(Natural Sciences),2010,37 (8):79-82.(In Chinese)

[19]ROSTEN E,DRUMMOND T.Machine learing for highspeed corer detection[C]//Proceedings of the 9th European Conference on Computer Vision.Berlin,Germany:Springer,2006:430-443.

[20]BOUGUET J.Pyramidal implementation of the LucasKanade feature tracker:Description of the algorithm[R].California,USA: Intel Microprocessor Research Labs,2000.

[21]张见双,张红民,罗永涛,等.一种改进的Harris角点检测的图像配准方法[J].激光与红外,2017 ,47 (2) :230-233.

ZHANG J S,ZHANG H M,LUO Y T,et al.Image registration method based on improved Harris corner detection algorithm[J].Laser and Infrared,2017,47 (2):230-233.(In Chinese)

[22]蔡军,邹鹏,沈弼龙,等.基于改进轮盘赌策略的反馈式模糊测试方法[J].四川大学学报(工程科学版),2016,48(2):132-138.

CAI J,ZOU P,SHEN B L,et al.Feedback fuzzing based on improved roulette wheel selection strategy[J].Journal of Sichuan University(Engineering Science Edition),2016,48(2):132-138.(In Chinese)

[23]付建中.普通心理学[M].北京:清华大学出版社,2012: 67-81.

FU J Z.Understanding psychology[M].Beijing:Tsinghua University Press,2012: 67-81.(In Chinese)

[24]黎万义,王鹏,乔红.引入视觉注意机制的目标跟踪方法综述[J].自动化学报,2014,40 (4):561-576.

LI W Y,WANG P,QIAO H.A survey of visual attention based methods for object tracking[J].Acta Automatic Sinica,2014,40(4):561-576.(In Chinese)

[25]HOU X,HAREL J,KOCH C,et al.Image signature:Highlighting sparse salient regions[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(1):194-201.

[26]周莺,柳伟,张基宏.基于内容感知的可分级视频码流排序方法[J].信号处理,2013,29(8):1012-1018.

ZHOU Y,LIU W,ZHANG J H.Contentaware based sorting approach of scalable video bit stream[J].Signal Processing,2013,29(8):1012-1018.(In Chinese)

[27]VAN DROOGENBROECK M,PAQUOT O.Background subtraction: Experiments and improvements for VIBE[C]//Proceedings of the 25th IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Washington DC,USA:IEEE Computer Society,2012:32-37.

[28]WANG Y,JODOIN P,PORIKLI F,et al.CDnet 2014: An expanded change detection benchmark dataset[C]//Proceedings of the 27th IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Washington DC,USA:IEEE Computer Society,2014:393-400.

[29]COLLINS R,ZHOU X,TEH S K.An open source tracking testbed and evaluation web site[C]//Proceedings of IEEE International Workshop on Performance Evaluation of Tracking and Surveillance.Washington DC,USA: IEEE Computer Society,2005:17-24.

[30]BELAGIANNIS V,SCHUBERT F,NAVAB N,et al.Segmentation based particle filtering for realtime 2D object tracking[C]//Proceedings of the 12th European Conference on Computer Vision.Berlin,Germany:Springer,2012: 842-855.

[31]ILG E,MAYER N,SAIKIA T,et al.FlowNet 2.0:Evolution of optical flow estimation with deep networks[C]//Proceedings of the 30th IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Washington DC,USA:IEEE Computer Society,2017:2461-2470.

[32]王棟,朱虹,康凯,等.基于背景补偿引导的动态场景下目标跟踪算法[J].仪器仪表学报,2014,30(6):1433-1440.

WANG D,ZHU H,KANG K,et al.arget tracking algorithm based on background compensation in dynamic scene[J].Chinese Journal of Scientific Instrument,2014,30(6):1433-1440.(In Chinese)

[33]SUHR J K,JUNG H G,LI G,et al.Background compensation for pantiltzoom cameras using 1D feature matching and outlier rejection[J].IEEE Transactions on Circuits and Systems for Video Technology,2011,21(3):371-377.

[34]LAZAREVICMCMANUS N,RENNO J,MAKRIS D,et al.An objectbased comparative methodology for motion detection based on the Fmsure[J].Computer Vision and Image Understanding,2008,111(1): 74-85.