多角度融合的RGB-D显著检测*

张志华,刘政怡

(安徽大学计算机科学与技术学院,安徽 合肥 230601)

1 引言

视觉注意机制是人类视觉系统的重要组成部分。通过视觉注意力,人眼能够过滤掉多余的信息,并从复杂的场景中快速找到区别于周围环境的显著目标。准确提取显著目标能够有效提高图像处理的效率和质量,因此,显著目标的检测已经广泛应用到图像分割[1]、图像识别[2]和目标重定位[3]等计算视觉领域。

虽然显著目标检测已被广泛研究了数年,但先前的大部分工作都着重于2D图像分析。近来,研究者开始整合多模态成像数据以提高图像处理的性能,而其中RGB-D图像的显著目标检测受到越来越多的关注。

(1)2D显著检测。现有的2D显著检测方法可以大致分为两类,即全局方法和局部方法[4]。基于全局的方法主要依据一个区域与整幅图像中全部区域的比较,比如Achanta等人[5]提出的频率调谐方法,将显著值定义为像素点颜色与图像平均颜色的差异。而基于局部的方法则只关注一个区域与周围相邻较小区域的对比关系,比如Liu等人[6]通过线性组合多尺度的对比和中心环绕直方图的分析定义了局部区域的对比。另一方面,基于紧密度的显著计算方法在各种显著检测模型中得到应用。其中,Gopalakrishnan等人[7]认为图像的低层次特征在背景上的分布相对于显著目标更为广泛。在此基础上,Cheng等人[8]将紧密度作为显著性的重要度量,利用特征相似和空间相近来衡量显著程度。同样地,基于图模型的传播方法在显著检测领域也取得了卓越的效果。Jiang等人[9]将边界上的超像素作为吸收节点,利用随机游走的方式计算显著值。Yang等人[10]利用背景先验将边界上的四条边定义为背景,并以流形排序计算与边界区域的相似性得到显著图。

(2)3D显著检测。早期的RGB-D显著检测方法将深度信息作为先验知识去引导2D显著图的权重分配[11]。这种方式没有考虑相对深度且只有当显著目标与背景在深度特征上的差异较大时才有效果。而后,由对比方法在2D显著检测方法的有效性得到启发,许多基于深度对比的方法被提了出来。Peng等人[12]提出了一种多级上下文对比模型,利用局部对比、全局对比以及背景对比检测显著目标。Cheng等人[13]分别利用颜色空间和深度空间的视觉线索进行对比,并将二维的中心偏移扩展到三维空间,提出空间偏移,将三种特征进行融合得到最终显著值。近来,以深度对比为基础,融合先验知识和优化的显著检测方法取得了卓越的效果。Ren等人[14]利用曲面方向先验和背景先验检测显著目标,并以PageRank算法和马尔科夫随机场MRF(Markov Rondom Field)算法优化显著图。Guo等人[15]在融合颜色对比和深度对比的基础上,利用迭代传播的方法得到最终的显著图。

本文依据RGB-D图像的特点,将深度图中的深度特征和RGB图中的颜色特征进行融合,使其相互补充,并以图模型为基础将颜色深度融合的特征贯穿整个显著检测过程。另外,将2D显著检测中全局和局部、前景和背景的互补关系应用到在显著计算和显著优化的过程中,进一步提高显著检测的准确率。

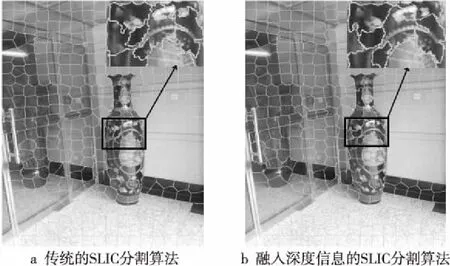

2 多角度融合

多角度融合是指颜色和深度融合、全局和局部融合、前景和背景融合。相对于2D显著检测,RGB-D显著检测多了一项非常重要的信息,即深度特征。现有的RGB-D显著检测方通常是将颜色和深度特征分开使用,将深度信息引入对比框架,计算前景与背景的深度对比差异,来得到深度显著图,然后结合颜色特征得到的显著图,形成最终显著图。这种方法虽然能取得一定的效果,但当前景的深度对比不明显时,深度显著图易产生误检,从而影响最终的检测结果,如图1所示。

Figure 1 Effect on detection results due to non-obvious depth constrast图1 因深度对比不明显而影响检测结果的情况

为了使深度特征得到充分利用,同时减小误检率,本文将颜色和深度特征融合,并以图模型的方式将颜色深度融合的特征应用到显著检测的每一步。另一方面,2D显著检测的方法提出了许多互补的显著关系。其中,局部和全局以及背景和前景的关系被广泛使用。基于局部的方法倾向于突出目标的边缘,而基于全局的方法却能得到更为一致的检测结果;背景角度的显著检测能够有效抑制背景区域,而前景角度却能够完整地突出显著目标。受互补关系在2D显著检测中取得的效果的启发,本文将这两对互补关系引入RGB-D的显著检测方法中,利用局部和全局方法在目标突出方面的互补提高初步显著值的精确度,以背景和前景方法在视觉关注方面的不同来得到高亮均匀的最终显著图。

3 具体算法

图2展示了具体算法的主要流程。首先,本文分别在像素级别和超像素级别进行颜色和深度的融合。以像素间的相似度作为聚类距离,对SLIC(Simple Linear Iterative Cluster)分割算法[16]进行拓展,以超像素间的相似度计算连接的权重,构造图模型。其次,在图模型的基础上分别计算全局紧密度和局部紧密度,并将全局与局部进行融合得到初步的显著图。最后是背景和前景的双向优化。以背景先验为基础,利用包含深度信息的边界连接权重[17]计算背景概率,并以背景概率对初步显著值加权得到背景优化显著图。利用阈值分割提取背景优化显著图中最为显著的部分作为前景查询节点,以流形排序[10]进行前景优化得到最终显著图。

Figure 2 An overview of the proposed method图2 具体算法流程图

3.1 颜色深度特征融合的图模型

Perazzi等人[18]认为将图像抽象成图模型能够有效提高显著检测的效率和性能,本文采用Harel等人[19]的方法构建无向图G(V,E)。下面分别从颜色深度特征融合和图模型的构造两个方面进行说明。

3.1.1 颜色深度特征融合

(1)像素级别颜色和深度融合。

像素级别颜色和深度的融合体现在引入深度信息,更为精确地表示像素之间的相似程度。

像素i与像素j之间的相似度定义为:

(1)

(2)

其中,li、ai以及bi分别对应像素点i在L、a和b通道上的数值。

(3)

其中,xi和yi表示平面坐标系中的坐标,di表示像素i的深度值。

(2)超像素级别颜色和深度融合。

超像素级别颜色和深度的融合体现在引入深度信息,更为精确地表示超像素之间的相似程度。超像素vi与超像素vj之间的相似度定义为:

(4)

其中,σ为控制参数,li,j和di,j分别表示超像素i和j间的颜色距离和深度距离,定义如下:

li,j=‖ci-cj‖

(5)

di,j=‖di-dj‖

(6)

其中,ci和cj分别表示超像素vi和vj内所有像素点在CIELab颜色空间的均值,而di和dj则表示对应超像素内所有像素点在深度空间的均值。

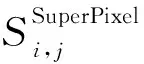

3.1.2 图模型的构造

Figure 3 Comparison of SLIC segmentation algorithm before and after depth Information Fusion图3 SLIC分割算法融入深度信息前后的分割对比

构造的图模型规定有着共同边界的超像素互为邻居,邻居间是连接的。另外,认为图像边缘上的每对区域都是连接的,以减少相似超像素间的测地线距离[9]。超像素之间的权重由颜色深度特征融合的关联矩阵Wcd=[wi,j]N×N表示。

(7)

其中,Nei表示与超像素vi相连接的邻居集合。

3.2 全局和局部融合的显著计算

为了更精确地描述超像素之间的相似性,本文利用颜色深度特征融合的关联矩阵Wcd,将相似性信息扩散到整个图模型中,即:

ΜT=(D-αWcd)-1SSuperPixel

(8)

显著目标通常被背景区域所包围,因此背景区域上的颜色和深度特征的分布一般会比显著区域上的更为广泛。所以,对于每个超像素来说,特征差异越大,紧密度就越小,越不可能成为显著性目标。首先从全局的角度出发,计算超像素vi与全部超像素的特征差异,即超像素vi的全局紧密度如下所示:

(9)

相对应地,从局部角度出发,计算超像素vi与相邻超像素的特征差异,即超像素vi的局部紧密度如下所示:

(10)

(11)

融合全局和局部两种不同的方式得到的紧密度,形成显著值:

Scom(i)=norm(sg(i)·sl(i))

(12)

3.3 背景和前景融合的显著优化

在显著计算的步骤中,本文以超像素间的紧密度作为初步的显著值。为了得到更完善的显著图,本文首先从背景角度优化抑制背景区域,然后通过前景角度的优化提高显著检测的完整度。

3.3.1 背景优化

自然图像中的显著区域与背景区域的空间分布是不同的。相对于背景区域,显著区域很少接触图像边缘,所以假设图像的边缘区域为背景是显著检测方法中常用的先验知识[22]。本文在Zhu等人[17]的方法基础上,将深度信息引入边界连接权重并计算背景概率,对初步显著图进行背景优化。首先,以超像素之间颜色深度特征融合的距离(li,j+di,j)为基础计算测地线距离。然后,定义边缘测地线权重与全图测地线权重的比值为边界连接权重。最后,利用边界连接权重计算背景概率对初步的显著值加权,完成背景角度的优化。

本文将超像素之间的测地线距离定义为两个超像素之间最短路径上的距离之和。超像素vi和vj之间的测地线距离dgeo(i,j)计算如下:

(13)

超像素vi的全图测地线权重G(i)和边缘测地线权重B(i)分别定义如下:

(14)

(15)

即,超像素vi的边界连接权重表示为:

(16)

超像素vi的背景概率表示如下:

(17)

其中,σBCon为控制参数。最后,利用背景概率对初步显著值进行加权得到背景优化显著值:

SB(i)=Scom(i)·pbg(i)

(18)

3.3.2 前景优化

在流形排序中,给定数据集X={xl,…,xl,xl+1,…,xn}∈Rn×n,将其中一些数据节点标记为询问节点,其余节点需要根据它们和询问节点间的相关性进行排序。令f:X→Rn表示排序函数,给每个节点xi分配一个排序值fi。f被视为一个向量f=[f1,…,fn]T,令y=[y1,y2,…,yn]T为指示向量,如果xi是询问节点则yi=1,否则yi=0。接着对数据集构建一个图G=(V,E),节点集合V代表数据集X,E由一个关联矩阵W=[wi,j]n×n加权,n表示图模型的顶点数量。给定G,对应的度矩阵即为D=diag{d11,…,dnn},dii=∑jwij。查询节点的最优排序通过最优化下面的公式解决:

(19)

μ控制平滑限制和拟合约束的平衡,也就是说,一个好的排序算法要使邻近的点之间相关性变化不大,且不能与初始的排序值有太大的差距。

通过求导置为零求解以上最小化问题,可以使用以下排序函数表示:

f*=(1-α)(I-αS)-1y

(20)

出于效率的考虑,本文采用非归一化的拉普拉斯矩阵形式来计算显著性,非归一化拉普拉斯形式的排序方程可表示为:

f*=(D-αW)-1y

(21)

(22)

所以,本文的前景优化显著图可以用以下公式表示:

(23)

4 实验

为验证本文方法,实验在RGBD1000[12]基准数据集上,同时与四种先进的RGB显著检测方法以及三种先进的RGB-D显著检测算法,在Precision、Recall、F-measure和运行时间这四个评价指标上作对比。本实验所有程序都是在Intel(R) Core(TM) i5-4970CPU 3.2 GHz、内存8 GB的PC上实现。本文实验所用软件为Matlab(R2013a),对比方法来自各作者提供的公开代码或检测结果。

4.1 数据集

RGBD-1000数据集是由Microsoft Kinect分别在室内室外所拍摄的自然图片组成,包含1 000张RGB图片和1 000张对应的手工标注显著模板。

4.2 评估标准

本文采用PR(Precision-Recall)曲线和F-measure值两个不同的指标来评估不同方法的性能,通过绘制PR曲线图和指标评价直方图直观展现对比差异。

PR曲线的Precision表示正确分配到提取区域中显著像素的比例,Recall表示定义为显著像素关于模板数量的比例。具体地,用0~255不同的固定阈值把显著图分割成256个二值图,并计算得到256个Precision-Recall对,以Recall为横轴,Precision为纵轴,绘制Precision随Recall变化的曲线。在显著性的评估过程中,Precision和Recall之间会互相影响。一般情况下,当检测的Precision提高时,Recall可能会有所下降,所以另外采用F-measure值来评价方法的性能。F-measure作为Precision和Recall的加权调和平均数,计算方法如下:

(24)

其中,β2为控制精确性和完整性的权值,其值设为0.3,强调准确率的重要性。

4.3 参数分析与设置

本文方法中需要设置k、m、σ、σbg、σBCon以及α六个参数。

(1)k:本文将人为设定的超像素个数k设置为300,另一方面,因为SLIC分割算法在分割的过程中会有误差,故将实际分割得到的超像素个数表示为N。

(2)m:SLIC分割算法在计算聚类距离时需要参数m平衡空间距离和颜色距离的相对重要性。当m大时,空间邻近性更重要,并且所得到的超像素更紧凑。当m小时,所得到的超像素更紧密地粘附到图像边界,但是具有较小的规则尺寸和形状。当使用CIELAB色彩空间时,m可以在[1,40],数值参考文献[15]设置为20。

(3)σ、σbg和σBCon:在本文方法中σ控制两个超像素之间的权重强度,σbg、σBCon控制指数函数下降率的参数,本文将其分别设置为σ=0.1,σbg=10,σBCon=1。

(4)α:流形排序算法是数据点通过图模型来将其显著值扩散给邻居节点的过程,扩散过程会一直重复,直到收敛到稳定状态为止。参数α是为了控制扩散过程中平滑限制和拟合约束的平衡。为了保证扩散能达到收敛,α的取值是[0,1),参考文献[10]将α设置为0.99。

4.4 实验结果

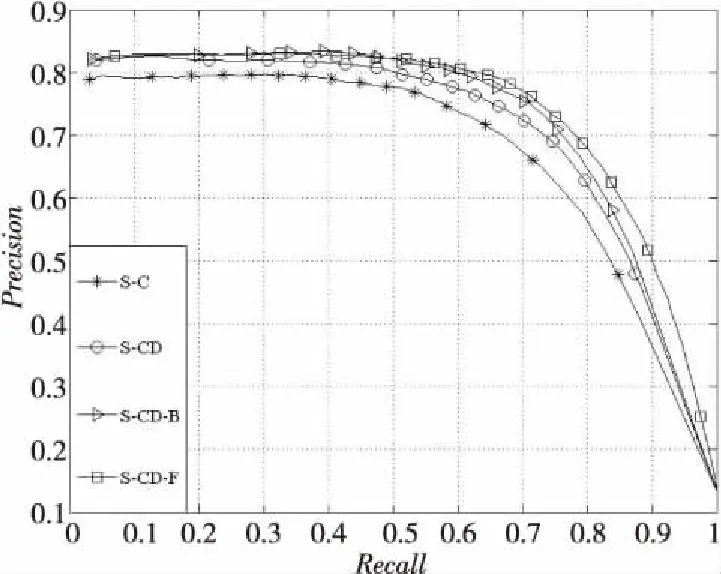

4.4.1 本文算法评估

本文算法评估对比如图4所示。本文在计算紧密度时使用了颜色深度融合的特征,为体现颜色深度融合相对于单独颜色的优势,本文首先评估单独颜色特征的紧密度计算和颜色深度特征融合的紧密度计算,在对比图中分别以S-C和S-CD表示。在PR曲线的对比中,相对于单独颜色特征的紧密度计算,颜色深度特征融合的紧密度计算有着明显提高。其次,本次实验对背景优化前后的结果做出了评估。其中,用S-CD-B表示背景优化后的结果。通过对比发现,利用背景概率为初步显著值加权能够有效优化检测结果。最后,用 S-CD-F表示前景优化后的结果,即最终结果。从PR曲线中可以看出,相对于背景优化的PR曲线,前景优化后的曲线在召回率增大的情况下,精确度下降的速率变小,即前景优化进一步完整地突出了显著目标。

Figure 4 Evaluation of the method in this paper图4 本文算法评估

4.4.2 其他显著检测方法对比

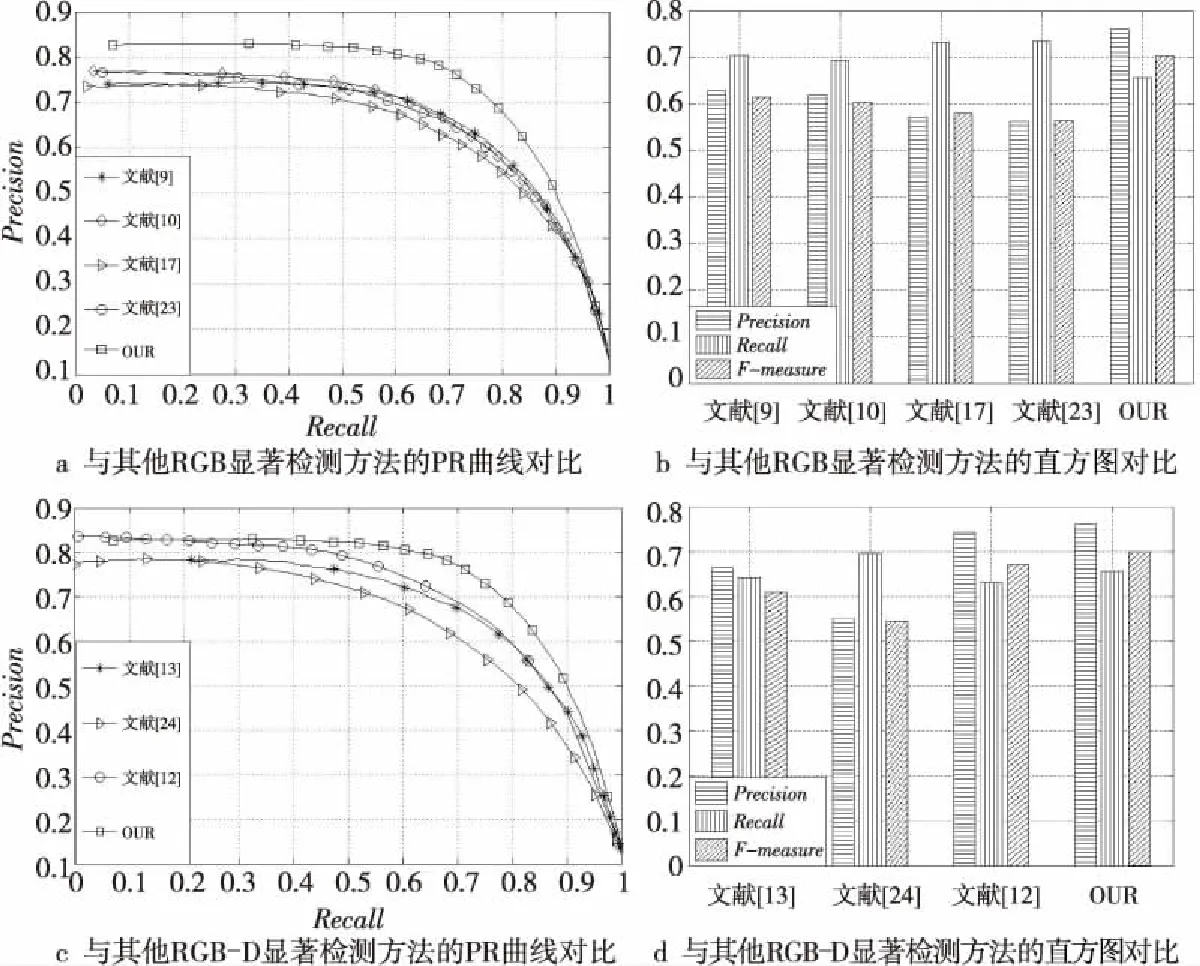

为进一步说明本文方法的性能,与多种先进的显著检测方法在RGBD1000数据集上作对比实验。首先与四种没有考虑深度信息的RGB显著检测方法进行对比,这四种方法分别来自文献[9,10,17,23]。如图5a和图5b所示,本文方法在PR曲线和评价指标直方图上均有明显优势。

Figure 5 Comparison with other methods图5 与其他算法对比

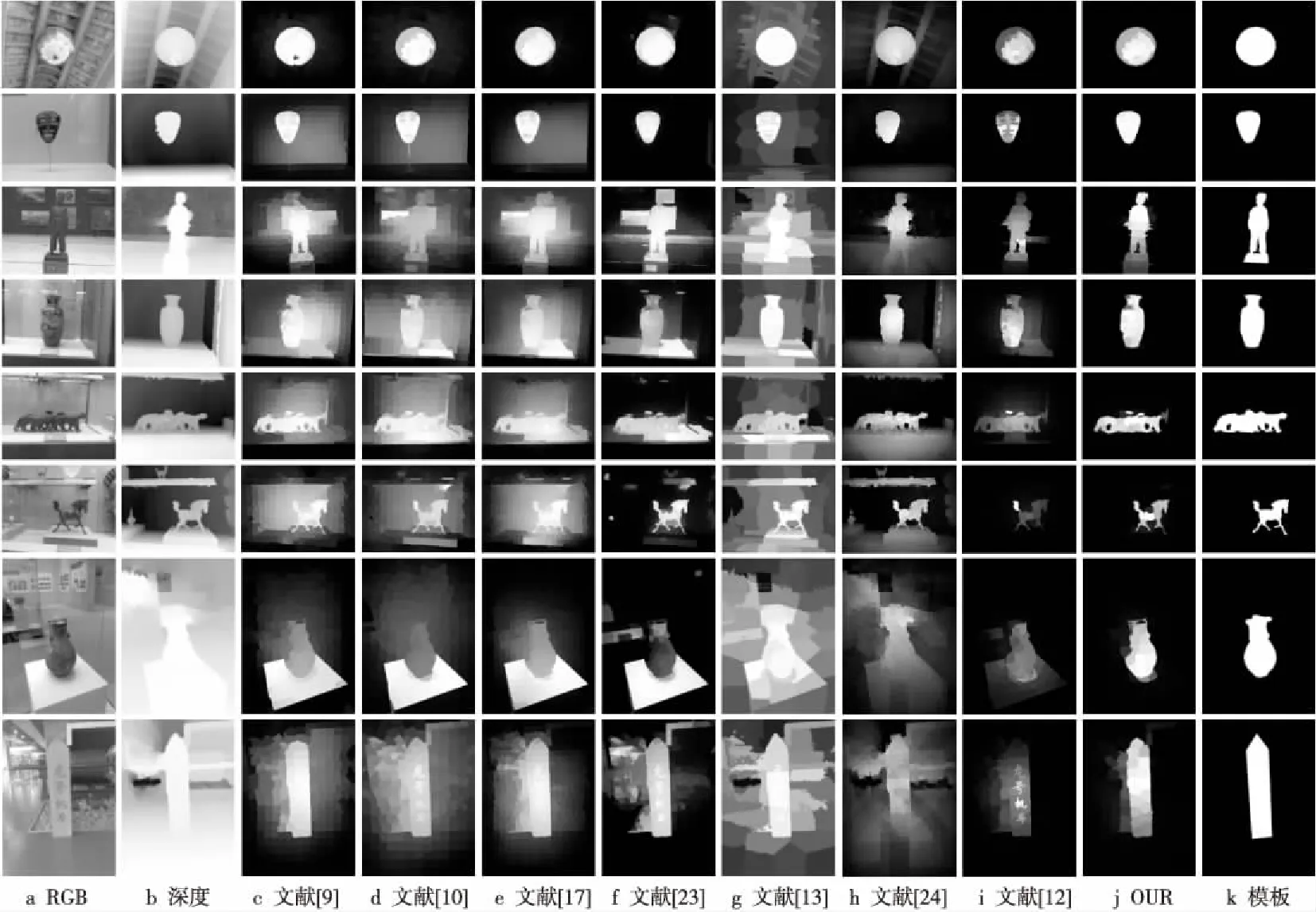

Figure 6 Quality comparison.图6 质量对比

本文方法所对比的三种RGB-D显著检测方法分别来自文献[12,13,24],对比结果如图5c和图5d所示。从PR曲线上看,本文方法明显优于文献[12,13,24]的方法。从评价指标直方图上看,本文方法有一定的优势,精确度达到了76%,F-measure值也达到了0.7,都处于较高水平。

4.5 质量比较

本文方法与其他方法的质量对比结果如图6所示。从RGB图和深度上看,第一行和第二行图片的颜色对比比较明显,所以,没有考虑深度信息时RGB显著检测方法也能取得较好的检测结果;而第三行、第四行以及第五行的RGB图片中颜色对比不明显,引入了深度信息的RGB-D显著检测方法相对于没有考虑深度信息RGB显著检测方法有着明显的优势,其中本文方法得到的显著图能够更加完整地突出显著目标;最后三行图片中的背景更加复杂,前景和背景中的颜色特征、深度特征都比较接近,对于现有的RGB-D显著检测方法也有一定的难度,但本文依靠多角度互补关系的融合依然能够取得较好的效果。

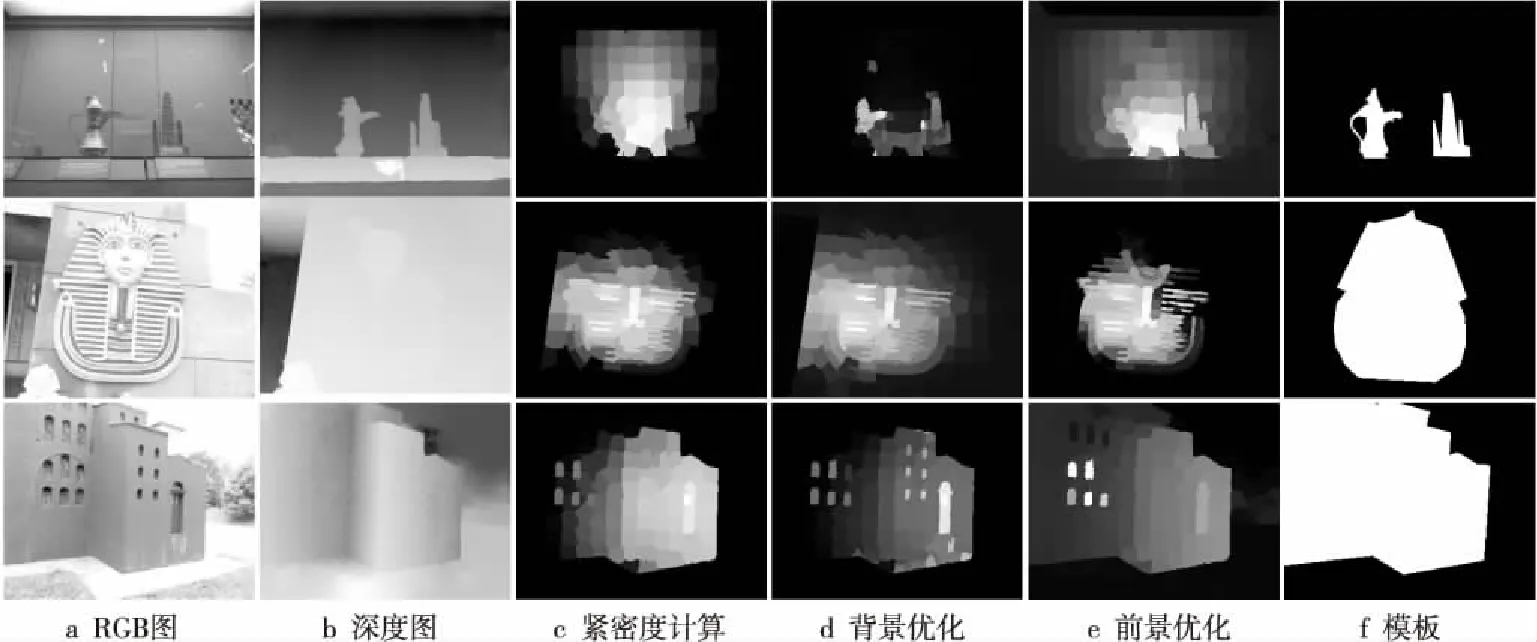

在实验中,同样发现本文算法的局限性。例如图7中的第一行和第二行,通过观察发现,当图像中的显著目标与背景在颜色、位置以及深度信息都较为接近时,紧密度计算得到的显著值与模板会有明显的差距,从而影响最终的检测结果。此外,观察图7中的第三行发现,当图像的边界有多处与显著目标具有相似的特征时,背景优化的效果往往会有所降低,导致最终的检测效果变差。

Figure 7 Failure examples of saliency detection results of the proposed method图7 本文算法显著检测失败例子

4.6 运行效率比较

本文方法与上述七种显著检测方法同样在RGBD-1000数据集做运行效率对比实验。由表1能够看出,相对于RGB显著检测方法,RGB-D显著检测方法在运行效率上偏低,但本文方法运行时间仅为2.126 s,运行效率较高。

5 结束语

本文融合颜色和深度特征构建图模型,并将图模型中颜色深度融合的特征应用到显著检测的每一步。然后融合全局紧密度和局部紧密度作为初步显著值。最后,依次从背景角度和前景角度进行优化,得到最终的显著图。以RGB-D图像为依据,结合多个角度的互补关系提高了RGB-D图像中显

著检测的准确率。

在未来的研究中可以进一步考虑RGB图像中的其他特征和深度特征的结合,引入更适合深度特征的先验知识,进一步提高检测正确率,或者利用自顶向下的检测模型,融入深度信息进行训练来获得更好的预测效果。

参考文献:

[1] Rother C,Kolmogorov V,Blake A.Grabcut:Interactive foreground extraction using iterated graph cuts[J]. ACM Transactions on Graphics (TOG), 2004,23(3):309-314.

[2] Ding Y,Xiao J,Yu J.Importance filtering for image retargeting[C]∥Proc of 2011 IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2011:89-96.

[3] Lin W Y,Wu P C,Chen B R.Image retargeting using depth enhanced saliency[C]∥Proc of 3D Systems and Applications (3DSA),2013:1-4.

[4] Cheng M M,Mitra N J,Huang X,et al.Global contrast based salient region detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(3):569-582.

[5] Achanta R,Shaji A,Smith K,et al.SLIC superpixels compared to state-of-the-art superpixel methods[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2012,34(11):2274-2282.

[6] Liu T,Yuan Z,Sun J,et al.Learning to detect a salient object[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2007,33(2):353-367.

[7] Gopalakrishnan V,Hu Y,Rajan D.Salient region detection by modeling distributions of color and orientation[J].IEEE Transactions on Multimedia,2009,11(5):892-905.

[8] Cheng M M,Warrell J,Lin W Y,et al.Efficient salient region detection with soft image abstraction[C]∥Proc of the IEEE International Conference on Computer Vision,2013:1529-1536.

[9] Jiang B,Zhang L,Lu H,et al.Saliency detection via absorbing Markov chain[C]∥Proc of the IEEE International Conference on Computer Vision,2013:1665-1672.

[10] Yang C,Zhang L,Lu H,et al.Saliency detection via graph-based manifold ranking[C]∥Proc of 2013 IEEE Conference on Computer Vision and Pattern Recognition(CVPR),2013:3166-3173.

[11] Zhang Y,Jiang G,Yu M,et al.Stereoscopic visual attention model for 3d video[C]∥Proc of International Conference on Multimedia Modeling,2010:314-324.

[12] Peng H,Li B,Xiong W,et al.Rgbd salient object detection:A benchmark and algorithms[C]∥Proc of European Conference on Computer Vision,2014:92-109.

[13] Cheng Y,Fu H,Wei X,et al.Depth enhanced saliency detection method[J].European Journal of Histochemistry Ejh,2014,55(1):301-308.

[14] Ren J, Gong X, Yu L,et al.Exploiting global priors for RGB-D saliency detection[C]∥Proc of 2015 IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW),2015:25-32.

[15] Guo J,Ren T,Bei J.Salient object detection for RGB-D image via saliency evolution[C]∥Proc of 2016 IEEE International Conference on Multimedia and Expo (ICME),2016:1-6.

[16] Hsu C Y, Ding J J. Efficient image segmentation algorithm using superpixels and boundary-focused region merging[C]∥Proc of 2013 9th International Conference on Information, Communications and Signal Processing(ICICS), 2013:1-5.

[17] Zhu W,Liang S,Wei Y,et al.Saliency optimization from robust background detection[C]∥Proc of 2014 IEEE Conference on Computer Vision and Pattern Recognition(CVPR),2014:2814-2821.

[18] Perazzi F, Krähenbühl P,Pritch Y,et al.Saliency filters:Contrast based filtering for salient region detection[C]∥Proc of 2012 IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2012:733-740.

[19] Harel J,Koch C,Perona P.Graph-based visual saliency[C]∥Proc of Advances in Neural Information Processing Systems,2006:545-552.

[20] Zhou L,Yang Z,Yuan Q,et al.Salient region detection via integrating diffusion-based compactness and local contrast[J].IEEE Transactions on Image Processing,2015,24(11):3308-3320.

[21] Xue H,Gu Y,Li Y,et al.RGB-D saliency detection via mutual guided manifold ranking[C]∥Proc of 2015 IEEE International Conference on Image Processing (ICIP),2015:666-670.

[22] M Wei Y, Wen F,Zhu W,et al.Geodesic saliency using background priors[C]∥Proc of European Conference on Computer Vision,2012:29-42.

[23] Qin Y,Lu H,Xu Y,et al.Saliency detection via cellular automata[C]∥Proc of 2015 IEEE Conference on Computer Vision and Pattern Recognition(CVPR), 2015:110-119.

[24] Ju R,Ge L,Geng W,et al.Depth saliency based on anisotropic center-surround difference[C]∥Proc of 2014 IEEE International Conference on Image Processing,2014:1115-1119.