数据中心机柜级冷却数值模拟及空调容灾分析*

黄志林,董凯军,苏 林,刘腾庆

(1. 中国科学院广州能源研究所,广州 510650;2. 中国科学院可再生能源重点实验室,广州 510650;3. 广东省新能源和可再生能源研究开发与应用重点实验室,广州 510650;4. 中国科学院大学,北京 100049)

0 引 言

随着云计算技术、通信业务和互联网数据业务的快速发展,建有大量服务器等设备的数据中心数量和规模急剧增长。服务器集成化、运行速度和效率的提升使得数据中心运行功率和散热负荷不断上升。据统计,数据中心单位面积功率密度从1987年的108 ~ 162 W/m2增长到如今的450 ~ 1 285 W/m2[1],单机柜功率更是增加到20 kW以上[2-3]。为保证数据中心全天候安全高效运行,对空调制冷系统及气流组织应有更高的要求。在气流组织方面,在采用风冷形式下,如何有效地在数据中心各设备之间进行冷量输送以及时将其热量带走是我们首先重视的问题。

目前数据中心常见的气流组织形式主要有冷通道封闭地板下送风和行级制冷送风形式,是目前数据中心气流组织模拟较多研究的气流组织形式[4-9]。随着机房单位面积功耗的增加,机柜级冷却和行间级制冷将会替代冷通道封闭地板送风形式成为主流[1]。这一方面是由于机柜级冷却采用模块化设计,能够锁定相应机柜的功率密度,提供更为合理的气流分配,从而让机房内的冷量更好地被利用,使设备冷却效果更佳;另一方面,相较于冷通道封闭地板下送风形式和行级空调制冷形式,在机柜级冷却形势下机柜摆放位置较为灵活,受房间格局的影响较小,灵活性强。

机柜级冷却也同样存在着自身的缺陷。首先,采用模块化设置情况下,每台空调与其对应的机架被单独设置与外界隔开,当模块A内设备低负荷运行而模块B内高负荷运行时,容易造成模块A内设备过度冷却而B内则冷却不足,从而造成冷量资源浪费;其次,为保证设备长时间稳定可靠的运行,即确保机房的可用性,机柜级冷却架构通常需要保证每个机柜2N制冷量,即针对机柜级冷却系统中每一个模块额外配置一台备份空调,而这将大大提高冷却系统的初始投资,是不太实际的做法。例如,相较于公共回风端采用N+1制冷共享模式的行级制冷架构,带有冗余的机柜级冷却系统的初始投资要高将近一倍。目前针对机柜级冷却系统,较为常见的是整个机房采用N+X(X<N)的冗余配置,比如中国科学技术大学超算中心的机房采用的是房间级备份式,即在机房内额外配置两台或多台房间级精密空调作为备份空调应对空调故障的情况,采用该方案能够短时间内保证IT设备安全运行,但由于房间级备份冷却形式下故障空调附近机柜的效率较低,冷却效果较差,长时间运行会导致机柜出现局部热点。

针对机柜级冷却形式存在的缺陷,本文结合行级空调制冷的特点提出一种行级备份式容灾方案,并通过计算流体力学(computer fluid dynamics,CFD)软件模拟在机房内气流组织、IT设备冷却效果等方面与房间级备份式容灾方案进行对比。

1 机柜级冷却行级备份式容灾方案

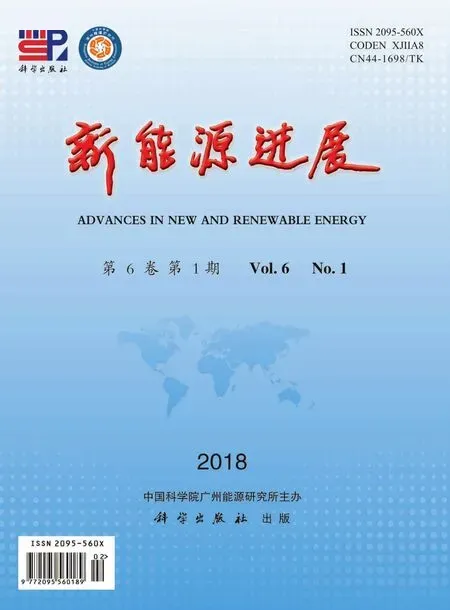

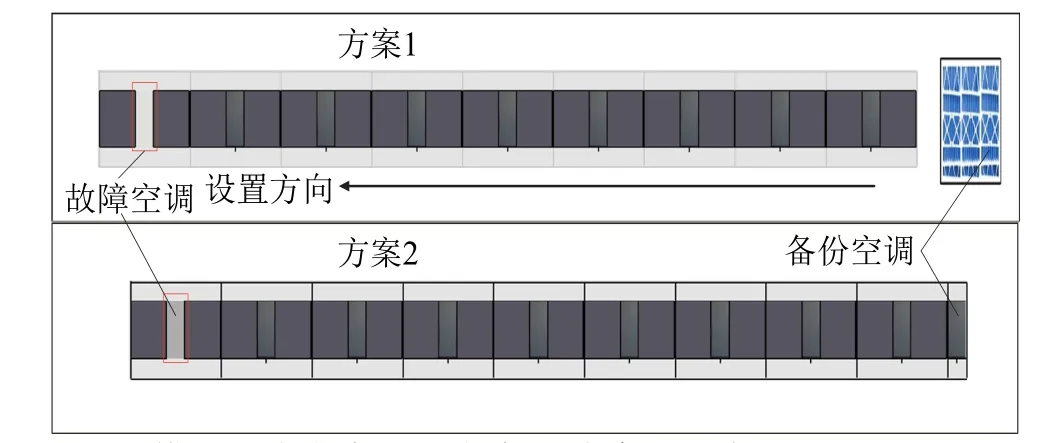

图1为数据中心机柜级冷却行级备份式容灾方案示意图。图1b中3个制冷模块并排安装在一起,在模块1旁边配有备份空调,不同模块之间、模块1与备份空调之间的送风空间和回风空间通过可自动调节的百叶窗进行连接。当各个模块均正常运行时,百叶窗处于完全关闭状态,备份空调不工作,保证机柜级冷却系统高效运行。当某个模块的空调出现故障无法提供足够的冷量给其相邻的机架时,送风区和回风区的百叶窗全部打开,同时备份空调开始工作,这种情况下三个机柜级冷却架构的模块就自动“退化”为行级制冷架构,从而保证了所有模块中的机柜信息设备能够安全稳定运行。采用上述的解决方案,一方面做到了N+1的冗余设置,在保证数据中心机房内 IT设备安全稳定运行的情况下,能够有效降低数据中心机柜级冷却架构下空调系统的初始投资,同时在出现空调故障或其他原因引起的冷量分配不均时,该解决方案能够实现冷量共享,减少冷气资源浪费,节约能源。

图1 行级备份式容灾方案示意图Fig. 1 Diagram of the row-level backup scheme

2 不同容灾方案的机柜级冷却系统模拟对比

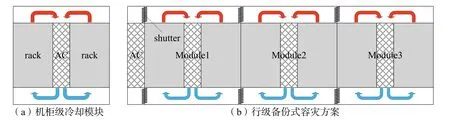

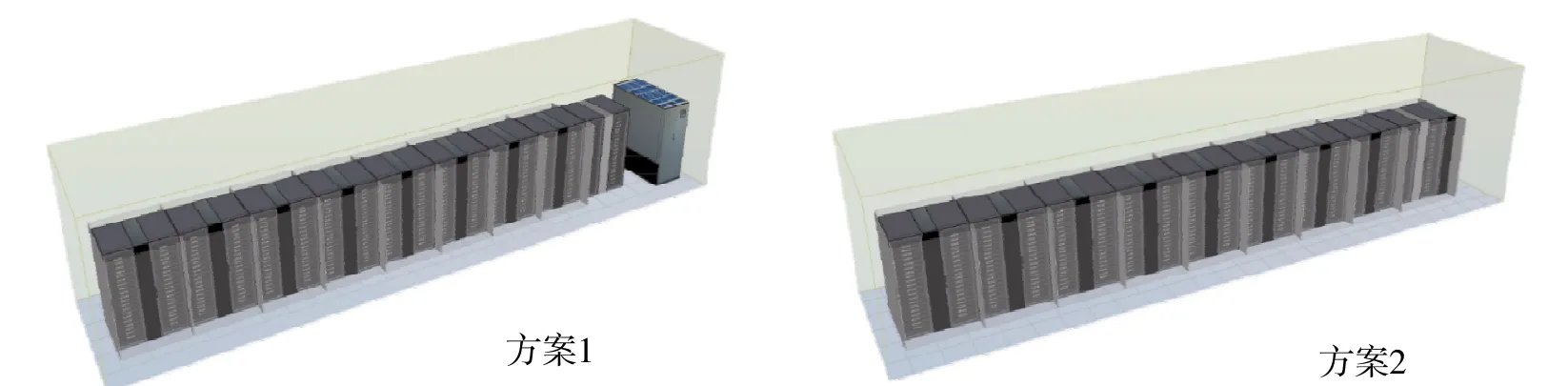

根据模拟实际需求本文建立了两个数据中心机房模型,其中模型1的房间尺寸为9.5 m × 3.3 m ×3.4 m,模型 2 的房间尺寸为 16.2 m × 3.3 m × 3.4 m。模型1机房内有4台机柜级冷却空调和8个机架。模型2中则有9台机柜级冷却空调和18个机架。根据对比内容,每个模型均有方案1和方案2两套子模型。方案1中备份空调为房间级精密空调,方案2中则是机柜级冷却空调。方案 1中机柜级空调和机架用隔板包围住,备份空调与其他设备隔开(正常工作下);方案2中备份空调紧靠机柜并用隔板包围住。根据《中国电信数据设备用网络机柜技术规范》确定机柜几何尺寸及其内部设备放置。模型 1中单机柜功率分别从4 kW设置到20 kW,递增间隔为2 kW,机柜级冷却空调功率设置为40 kW,送风温度18℃,故障空调位置设置在距离备份空调最远处,备份空调功率为40 kW,送风温度为18℃;模型2中单机柜功率设置为10 kW,机柜级冷却空调功率为20 kW,送风温度18℃,故障的位置则从距离备份空调最近到最远依次设置,备份空调功率为20 kW,送风温度18℃。其中空调送风量随单机柜功率增加而增加;除送风、回风位置有差别之外,房间级备份空调和机柜级备份空调的参数均相同。模型1和模型2的示意如图2 ~ 图5所示。

图2 CFD模型1建模示意图Fig. 2 The modeling diagram of model 1

图3 CFD模型2建模示意图Fig. 3 The modeling diagram of model 2

图4 模型1中方案1和方案2故障空调位置示意图Fig. 4 Fault AD position of scheme 1 and scheme 2 in model 1

图5 模型2中方案1和方案2故障空调位置Fig. 5 Fault AD position of scheme 1 and scheme 2 in model 2

为便于数值模拟,对上述物理模型作了如下假设:

①由于设备启用受到用户使用随机性的影响造成机架内服务器的热流密度随时间变化,模型将热流密度简化为恒定值;

②忽略房间壁面吸热;

③机架内服务器通常根据实际情况进行设计安装,但考虑到模型模拟的网格质量及计算速度,模型中对机架内服务器进行统一布置,对模型做出简化设置设备表面的平均热流密度,忽略服务器散热的不均匀性;

④对通信机房内气体的流动可视为恒定流[10-13];

⑤机房上部通常安装桥架布放电缆,但由于各个机房情况不同,为使模拟具有普遍性意义,对模型进行简化,忽略桥架及电缆对气流组织的影响[7-8]。

本文对机房内热环境进行包括温度场的数值模拟。机房具有门气密性良好、无外窗等特点,并且机房内空气气流流动属于大空间流动问题,因此选用针对高雷诺数的湍流计算标准模型k-ε模型。本文所用软件本身内置默认计算模型即为标准k-ε模型,边界条件设置如下:

①选用宽600 mm、深1 200 mm和高2 200 mm的42U标准机柜,单机柜内放置2U服务器,其余位置放置盲板以防止热空气回流;

②设定空调送风温度为18℃;

③气流组织形式为机柜级空调水平送风,每个模块的送风空间大小和回风空间大小相同,均为宽1 500 mm、深300 mm和高2 200 mm;

④房间级备份空调送风方式为下送风上回风。

为更精确地模拟机房内气流组织,在网格划分上限制最大网格尺寸为0.05 m。软件选用已标定的残差来控制求解方程的收敛精度,模拟时各计算残差曲线都收敛于1,代表各参数数值趋于稳定[6]。

3 模拟结果对比分析

3.1 单机柜同功率下两种冗余方案模拟结果对比

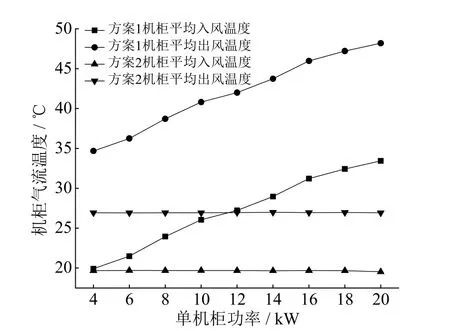

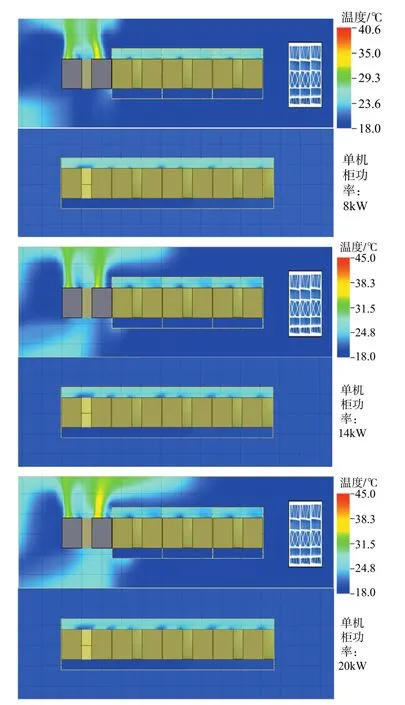

以单机柜功率为自变量,故障空调相邻机柜的平均入风温度和平均出风温度为应变量作图得到图6。从图中可以看出,随着单机柜功率的增加,方案1的机柜平均入风温度和平均出风温度都在升高,其中平均入风温度从单机柜功率4 kW时的20℃升至单机柜功率20 kW时的33.8℃,平均出风温度从4 kW时的34.8℃升至20 kW时的48.2℃,平均入风温度和平均出风温度与单机柜功率均成线性关系,且平均入风温度和平均出风温度相差近15℃,这是由于故障空调距离备份空调过远,送风余压和风量不足造成进入机柜内部的气流减少;方案2中机柜平均入风温度和平均出风温度随着单机柜功率的增加几乎无变化,其中平均入风温度一直保持在20℃附近,平均出风温度保持在27℃附近,入风和出风平均温差约为7℃。图7给出了单机柜功率8 kW、14 kW和20 kW下两种方案气流温度截面图(垂直高度1 m)。

图6 不同机柜功率两种方案下机柜气流温度对比Fig. 6 Airflow temperature comparison of cabinets under different power conditions in the two schemes

图7 两种方案气流温度截面图Fig. 7 Airflow temperature section diagram in the two schemes

两种方案中空调送风温度均设置为18℃,因此综上对比可知,采用房间级空调作为备份空调的方案1中,同样因为故障空调距离备份空调过远,送风余压和风量不足造成进入机柜内部的气流减少,导致机柜平均入风温度与空调送风温度差值、机柜平均入风温度和平均出风温度均比方案2中的差值更大,这说明当采用房间级空调作为备份空调应对空调故障时,机房内气流组织较差,空调送风和空调回风、机柜入风和机柜回风之间存在着冷热交换,从而降低了冷却效率。当单机柜功率增加至10 kW以上时,方案1中故障空调相邻的机柜入风温度已经超过标准上限,对IT设备的安全和性能造成影响。

图8 单机柜功率10 kW下机柜垂直方向服务器气流温度分布Fig. 8 Airflow distribution in the vertical direction of the cabinets

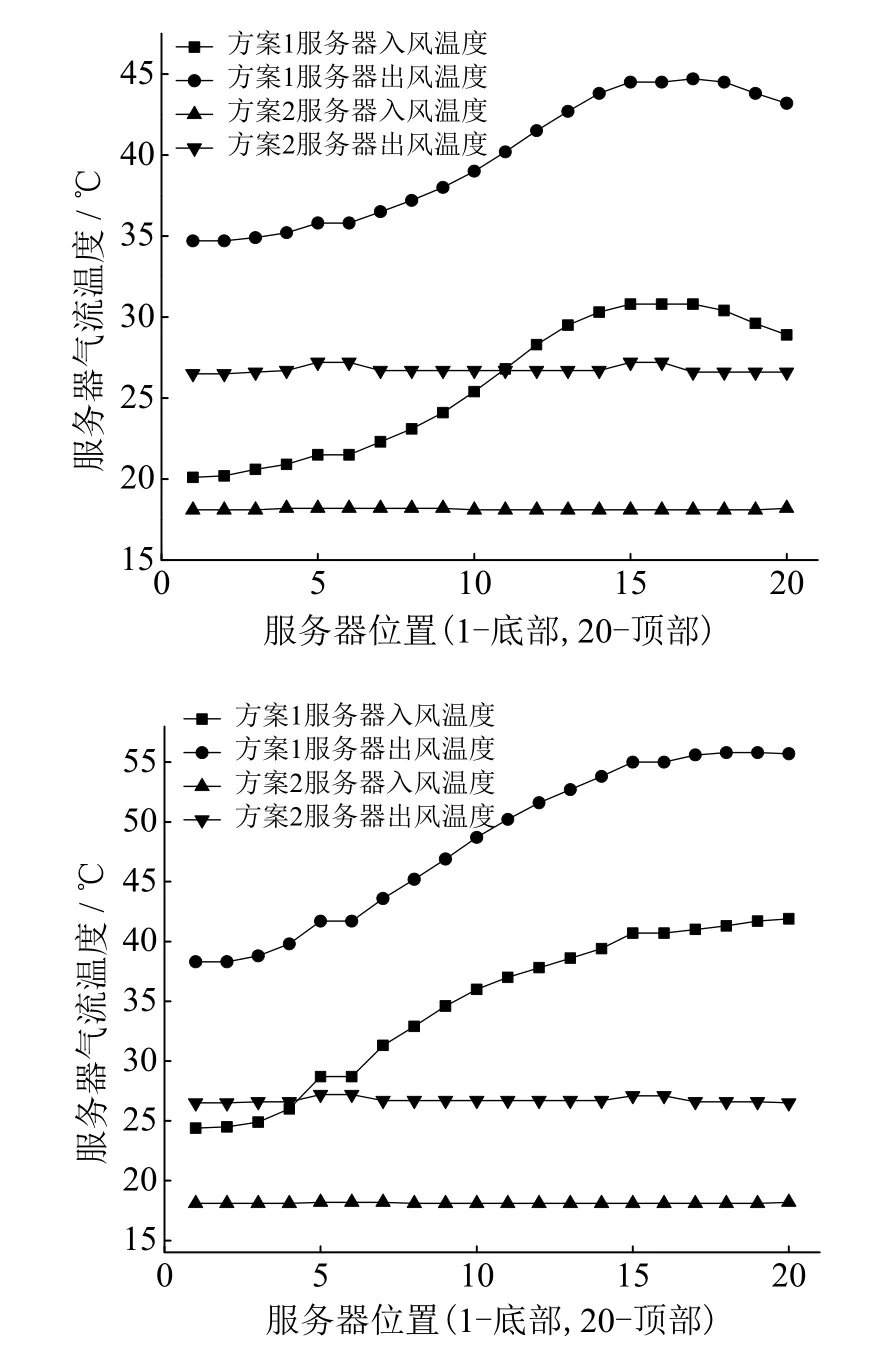

以故障空调相邻的两个机柜为研究对象,根据模拟结果作出机柜垂直方向服务器气流温度分布图,如图8所示。房间级气流组织冷却形式下,机柜上下进风温度和出风温度不同,并且入风温度和出风温度越高,气流越差,容易形成局部热点。方案1中采用房间级空调作为备份空调进行冷却,因而机柜内服务器的气流温度分布也呈现出了这样的特点。行级制冷则消除了垂直高度带来的影响,因而机柜上下服务器入风温度和出风温度几乎没有差别。方案2中当空调故障时,依然封闭所有的空调和机柜的冷热通道,仅仅打开冷热通道之间的隔板,将机柜级冷却“退化”为行级制冷,因而也具有行级制冷的特点。

3.2 故障空调不同位置下两种冗余方案模拟结果对比

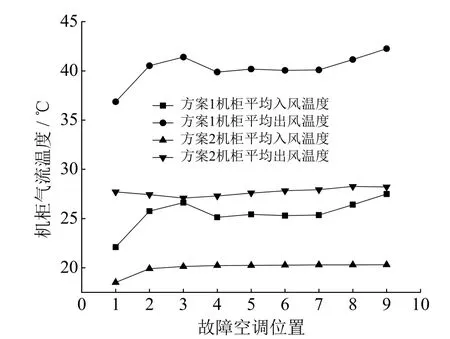

故障空调位置的不同造成了所需冷却机柜与备份空调间距离的不同,因此对有效冷却产生影响。根据所建模型的模拟结果,以故障空调位置为横坐标,机柜气流温度为纵坐标作图,如图9,其中,故障空调位置以距离备份空调所间隔模块数来确定,如距离最近的模块为1,最远则为9。并对截取垂直高度1 m处温度场图,如图10。

图9 不同故障空调位置下机柜气流温度Fig. 9 Airflow temperature of the cabinets under different fault AC conditions

根据图9和图10可以看出,方案1中故障空调相邻机柜的气流温度随着故障空调与备份空调距离的增加先上升,在故障空调位置为3时最大,而后下降且在4 ~ 7位置基本相同,最后又上升。方案2中故障空调相邻机柜的气流温度则几乎保持不变。方案1中,由于空调送风速度较大,如果空调与机柜距离较近且中间有阻碍物,则在被送入机柜内服务器前气流会受到较大的扰流影响,从而使得进入服务器内的气流分布不均匀,导致部分IT设备过度冷却而部分则产生热点,机柜出风温度较高;若距离较远则气流可逐步发展变得更为均匀,从而提升冷却效果,机柜出风温度也较低。方案2中,空调与机柜之间无障碍物,并且二者距离较近,加上封闭导流作用,因此各个机柜间气流分配比较均匀。

图10 不同故障空调位置下机柜气流温度Fig. 10 Airflow temperature of the cabinets under different fault AC positions

4 结 论

针对数据中心机柜级冷却系统存在的缺点,提出一种行级备份式容灾方案,方案中对每列机柜配置一台机柜级空调作为备份空调,在正常工作下备份空调关闭,系统中各模块独立运行;故障时备份空调开启,与同列的所有空调和机柜组成“行级制冷”系统。相对于现有的房间级备份式容灾方案,该容灾方案能够在空调故障时有效冷却设备,并降低系统建设初始投资。主要结论如下:

(1)数据中心机柜级冷却系统中,当单机柜功率较高时,采用房间级备份容灾方案在空调故障时其所负责冷却机架内IT设备的出风温度明显高于所限制的最大标准,表明设备冷却无法得到有效冷却,将有过热保护、宕机现象发生,不能有效应对空调故障情况,维持设备长时间安全有效运行,并且随着单机柜功率由2 kW增大至20 kW,机柜局部出风温度越高。

(2)房间级备份容灾方案中,备份空调与故障空调的距离不同时,IT设备的出风温度有显著差别,并且距离越大冷却效果越差。但行级备份式方案中,故障空调附近机柜的出风温度与其余机柜几乎相同。

(3)行级备份式容灾方案下,故障空调附近机柜的进出风温度均在限定标准内,能够保证机房内IT设备提供足够的冷量,从而确保热量能够及时快速地散发出去,保证数据中心安全高效运行,且备份空调与故障空调的距离变化对IT设备的冷却效果影响较小。

[1]陈杰. 数据机房冷通道封闭技术应用及模拟分析[J].暖通空调, 2015, 45(6): 37-40.

[2]杨国荣, 胡仰耆, 马伟骏. 数据中心空调设计初探[J].建筑电气, 2009, 28(12): 21-26. DOI: 10.3969/j.issn.1003-8493.2009.12.006.

[3]中国数据中心产业发展联盟. 2012年中国数据中心产业发展白皮书[R/OL]. 中国数据中心产业发展联盟, 2012.https://wenku.baidu.com/view/c484ced4240c844769eaee ec.html.

[4]CHO J, LIM T, KIM B S. Measurements and predictions of the air distribution systems in high compute density(Internet) data centers[J]. Energy and buildings, 2009,41(10): 1107-1115. DOI: 10.1016/j.enbuild.2009.05.017.

[5]CHO J, KIM B S. Evaluation of air management system's thermal performance for superior cooling efficiency in high-density data centers[J]. Energy and buildings, 2011, 43(9): 2145-2155. DOI: 10.1016/j.enbuild.2011.04.025.

[6]PATANKAR S V. Airflow and cooling in a data center[J].Journal of heat transfer, 2010, 132(7): 073001. DOI:10.1115/1.4000703.

[7]蒋雅靖, 刘成. 列间空调在高密度数据中心应用的数值模拟[J]. 建筑热能通风空调, 2012, 31(6): 92-95.DOI: 10.3969/j.issn.1003-0344.2012.06.027.

[8]刘芳, 王志刚. 某数据中心室内空调气流组织的模拟研究 [J].暖通与空调, 2016, 44(1): 11-17. DOI:10.3969/j.issn.1673-7237.2016.10.004.

[9]舒庆鑫. 变电站数据机房能耗及气流组织模拟研究[D]. 杭州: 浙江大学, 2014.

[10]胡坤, 李振北. ANSYS ICEM CFD工程实例详解[M].北京: 人民邮电出版社, 2014: 207-215.

[11]CHEN Q. Comparison of differentk-ε models for indoor air flow computations[J]. Numerical heat transfer, part b:fundamentals, 1995, 28(3): 353-369. DOI: 10.1080/10407799508928838.

[12]YAKHOT V, ORSZAG S A, THANGAM S, et al.Development of turbulence models for shear flows by a double expansion technique[J]. Physics of fluids a: fluid dynamics, 1992, 4(7): 1510-1520. DOI: 10.1063/1.858424.

[13]KIM S W, CHEN C P. A multiple-time-scale turbulence model based on variable partitioning of the turbulent kinetic energy spectrum[J]. Numerical heat transfer, part b:fundamentals, 1990, 16(2): 193-211. DOI: 10407798908944935.