基于自适应弹性网络稀疏编码的目标识别

杜玉龙, 李建增, 张 岩, 范 聪

(军械工程学院, 石家庄 050003)

基于自适应弹性网络稀疏编码的目标识别

杜玉龙, 李建增, 张 岩, 范 聪

(军械工程学院, 石家庄 050003)

传统稀疏编码模型特征选择能力较弱,稀疏系数向量中负系数的存在导致维数偏高、信息冗余,不利于目标识别。针对这个问题,提出了一种基于自适应弹性网络的稀疏编码模型。该模型首先利用融合尺度空间的AGAST检测子提取特征点,经过FREAK算子描述,采用能够自适应选择强相关性特征的自适应弹性网络回归模型求解稀疏系数向量,最后通过分类器实现对目标的分类识别。实验结果表明,特征检测算法对于图像中尺度、视角、光照和旋转等变换具有更强的鲁棒性,在自适应弹性网络的约束下,模型具有较好的识别性能。

目标识别; AGAST; 尺度空间; 自适应弹性网络; 稀疏编码

0 引言

近些年来特征检测算法发展迅速,Harris角点[1]检测以泰勒展开式构建像素点邻域内的连续曲面,计算所有像素点的微商的平方和,采用其中的最大值和最小值作为判断特征角点的显著性依据;FAST[2](Features from Accelerated Segment Test)检测算法基于加速分割测试实现检测,当某个像素点的邻域范围内存在足够多的点的灰度值与该点处于不同的灰度区

在局部特征编码方面,基于局部特征的特征袋[5](Bag-of-Features,BoF)模型是一种应用较广泛的编码算法,该模型利用图像中特征的统计信息,应用k均值聚类获取视觉单词构建特征字典,但是由于该模型在运算中将局部特征和视觉单词一一对应,忽略了与其他视觉单词之间的相关性,所以表达能力有限;针对这个不足,稀疏编码[6](Sparse coding,SC) 模型被提出,该模型通过求解L1范数的优化问题获得稀疏系数,并融入了特征与多个视觉单词的相关性,但对于强相关性的特征,该模型通常只随机地选择一个特征,却不在意具体是哪一个特征,且稀疏系数向量中存在的负系数也不利于图像表达。

本文首先改进特征点检测算法,将AGAST[7](Adaptive and Generic Corner Detection Based on the Accelerated Segment Test)算子与尺度空间结合检测特征点,利用经FREAK[8](Fast Retina Keypoint)算子描述得到的特征点描述子构造特征词汇库,形成特征词典,而后采用自适应弹性网络回归模型求解出稀疏系数向量,确定特征描述子集与特征词典中视觉单词之间的联系,在将图像内所有稀疏系数向量成功构建为图像的全局向量之后,利用经典分类器支持向量机[9](Support Vector Machine,SVM)对训练图像进行学习,即可实现对测试图像的分类识别。

1 特征检测与描述

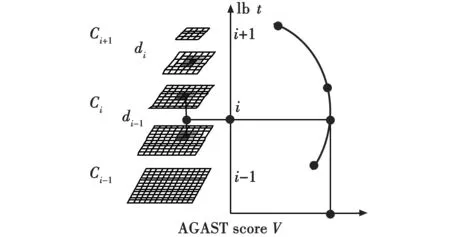

提取能够表征图像内容的特征点集,是实现本文算法的基础,而能否快速而准确地检测特征点关系到目标识别算法的质量和实时性。本文在了解检测算法研究发展的基础上,提出了一种基于尺度空间的AGAST特征检测算法。AGAST检测算法是近些年被提出的一种算子,其本质是对FAST检测算法的改进,区别于FAST,该算法采用由逆向归纳法构建的二叉决策树来完成搜索,在进行特征点检测时,不需要训练即可自适应环境提供高效决策树,因此速度更快,但该算法对于存在尺度变换的图像鲁棒性较差。针对这个问题,本文将其与尺度空间(见图1)理论结合,改善算法的尺度不变性。

图1 尺度空间的建立Fig.1 Establishment of the scale space

研究[10]表明,在将图像与高斯函数进行卷积计算的过程中,随着高斯卷积核的尺度增加,图像内的极值点位置会发生变化并陆续消失。在实际的特征检测中,由于无法保证目标的显著性更高,图像卷积在降低噪声影响的同时,也损失了图像中的一部分高频信息,在这个过程中有可能会损失掉目标的独特性信息,对目标识别任务不利,因此本文尺度空间的建立区别于SIFT算法中的高斯金字塔,只需对图像做降采样处理,无需高斯平滑以及图像卷积,简化了计算量,提高算法运行速度,有利于满足图像处理的实时性,同时保留了图像中的高频信息。具体过程如图1所示,尺度空间的建立是在原图像的基础上经过一系列降采样后排列组合得到,由交叉排列的n个外层Ci与n个内层di构成,其中,C0层为原图像,由原图像经1.5倍降采样得到d0层,Ci层可由Ci-1层经过半采样得到,di层由di-1层半采样得到,在其中利用AGAST算子检测特征点,经过多次拟合与插值之后即可得到特征点的真实尺度与精确位置。

在采用改进算法检测得到特征点后,需经过描述子描述才能用于目标的分类识别,本文采用符合仿生学原理的FREAK描述子对特征点进行描述,该算法通过采用与人眼视网膜细胞相同分布规律的采样模型实现对特征点的描述,由于其采用圆形对称结构,且感受域半径和采样密度随着离中心特征点距离变化而变化,以及高斯平滑的应用,该描述子对于旋转、尺度、光照和噪声等仿射变换都具备一定程度的鲁棒性。而且作为一种二进制描述子,该算法采用汉明距离代替传统算法中的欧氏距离,降低了算法的计算量,进一步提高算法运行速度,完全满足实时性要求。

2 基于自适应弹性网络的稀疏编码模型

本文采用稀疏编码模型对特征进行编码,图像统计学研究表明,图像中的局部特征是一个稀疏信号,符合稀疏分布,因此采用该模型实现编码在理论上具备可行性与合理性,同时相对于其他编码模型,该模型能够捕获每一幅图像中更显著的特征,因此对图像的重构误差更小。

2.1 传统稀疏编码模型

设训练样本集中特征描述子的集合为U=[u1,u2,…,uM],ui∈RD,i=1,2,…,M,是D维局部特征描述子,V=[v1,v2,…,vN],vj∈RD,j=1,2,…,N,是一个与特征描述子对应的过完备基向量的集合,也称为词典。模型中稀疏系数向量为φ=[φ1,φ2,…,φM],φi通过对词典中基向量进行线性组合实现对图像的重构,其值可能为负数。传统稀疏编码模型为

(1)

由此模型实现编码可分为训练过程和编码过程,首先,将训练图像集中的特征描述子集合U用于训练过完备基向量集合V和系数向量集合φ;而后,在编码过程中,利用V描述每一幅图像,通过最优化φ即可实现对每一幅图像的稀疏编码。

该模型获得稀疏系数向量是通过在词典中不断迭代与优化计算实现的,计算量较大,耗时严重。在进行特征选择时,该模型虽然考虑了特征描述子与多个视觉单词之间的相关性,但是对于具有强相关性的一组特征,只是随机选择一个代表特征。通常情况下,最后计算得到的稀疏系数有正有负,研究[11]表明,由于这些负系数的存在,视觉单词之间存在通过相互“抵消”实现对图像重构的可能,导致图像稀疏表示中产生冗余信息,独特性随之下降,维数增大却无法改善甚至降低算法的性能,增大计算量,而且在目标分类识别中这些负系数的存在缺乏合理的解释,因此模型的编码性能不够优秀,不利于目标识别任务的实现。

2.2 基于自适应弹性网络的稀疏编码模型

针对传统稀疏编码模型的不足,本文结合自适应弹性网络[12](Adaptive Elastic Net,AENet)回归模型理论提出一种改进稀疏编码模型,AENet的一个突出优点就是能够自适应地选择所有特征中强相关性的特征群,可以将相关性高度统一的特征点一并选择出来,且相对于传统弹性网络,AENet模型能够剔除运算过程中产生的冗余信息,消除负系数,精简运算的同时提高模型的鲁棒性。

根据模型参数定义可知,稀疏向量集合中φi值的大小反映了第i个描述子在图像重构过程中的贡献度,因此可以简单地采用|φi|作为描述子的重要性评估指标,根据这个标准设计如下自适应权重矩阵

W=diag(ω1,ω2,…,ωN)

(2)

Wφ||

1+λ2||

(3)

式中:||

由式(3)可以看出,本文编码模型是加权L1范数和L2范数的凸组合,这种约束保证了系数向量φ的稀疏性,且相比于传统弹性网络,本文通过引入权重ωi自适应调整模型系数实现群体激励效应,可以提取所有高度相关的特征,避免了负系数的产生和由于与不重要特征之间的相关性而产生的冗余信息,改善模型的特征选择性能。

式(3)可以通过固定其中一个参数的方式,将模型简化为凸优化问题,通过交替优化的方式进行求解,模型可拆分为以下几点。

1) 字典学习。

当φ固定时,模型表达式可简化为

(4)

可以通过字典学习算法[13]求解,将训练样本集中特征描述子组成过完备基,利用模型计算即可得到对应的特征词典。

2) 特征编码。

当V固定时,模型表达式可简化为

(5)

可通过坐标下降算法[14]求解引入自适应权重系数矩阵W的自适应弹性网络,而后利用交叉检验获取最优模型的稀疏系数向量,以便快速获得最优解。

3 实验结果及分析

本文对提出的算法进行了验证,计算机配置为Intel酷睿i7处理器,主频2.5 GHz,操作系统为Windows7 32位,仿真实验平台采用VS2013+OPENCV编程环境与Matlab配合。

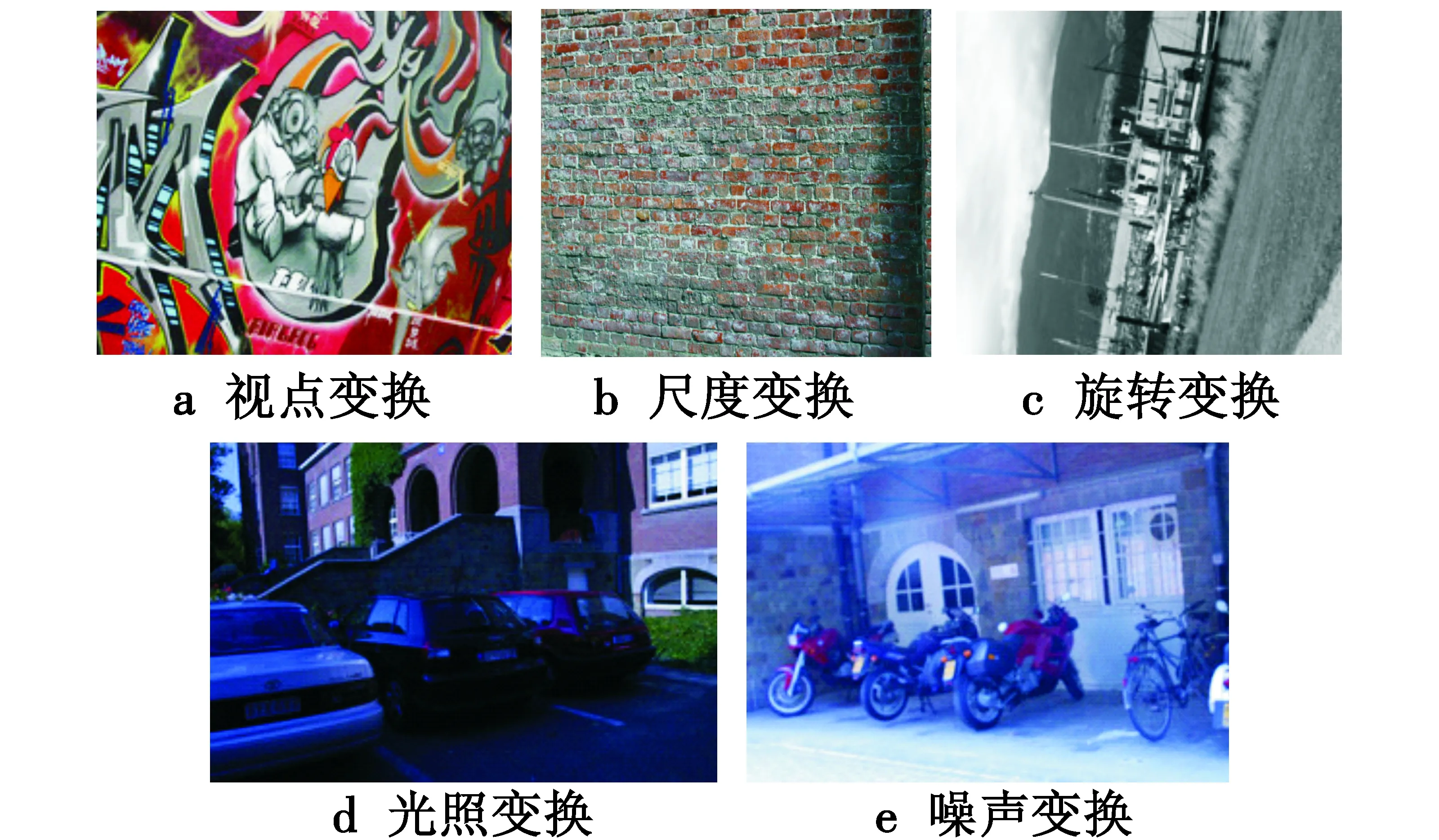

3.1 特征检测性能测试

本文使用图2所示的国际标准测试图像分别测试本文算法在光照变换、噪声变换、视点变换、尺度变换、旋转变换等方面的鲁棒性能。

图2 测试所用图片集Fig.2 Datasets used for evaluation

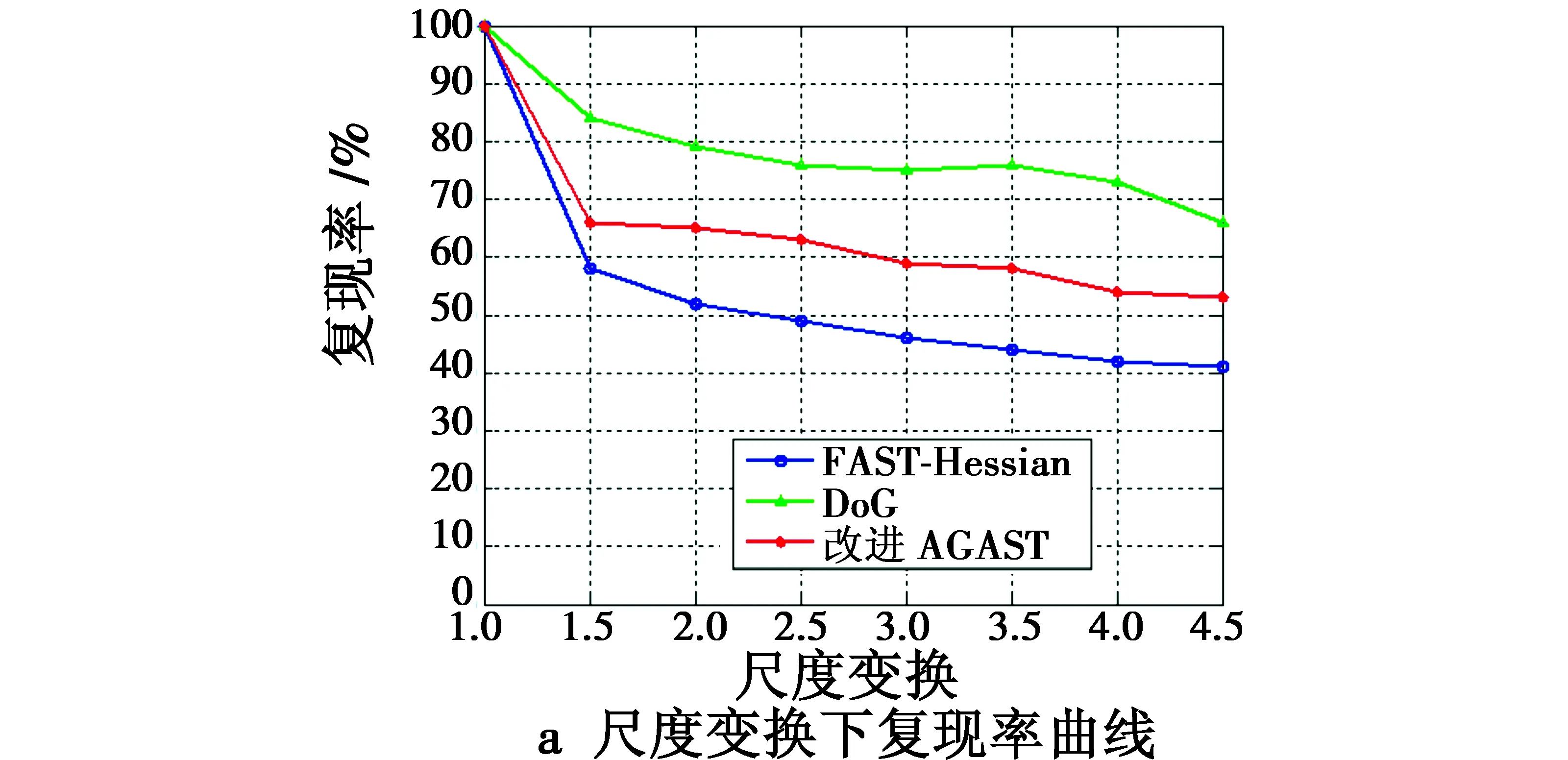

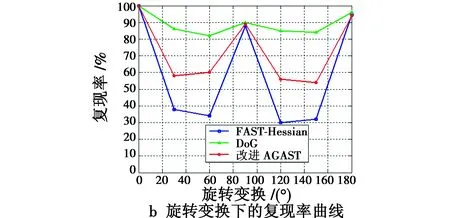

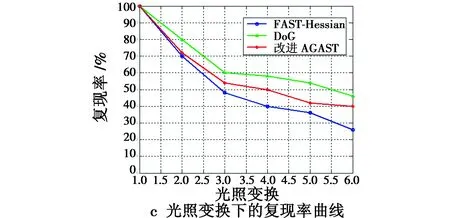

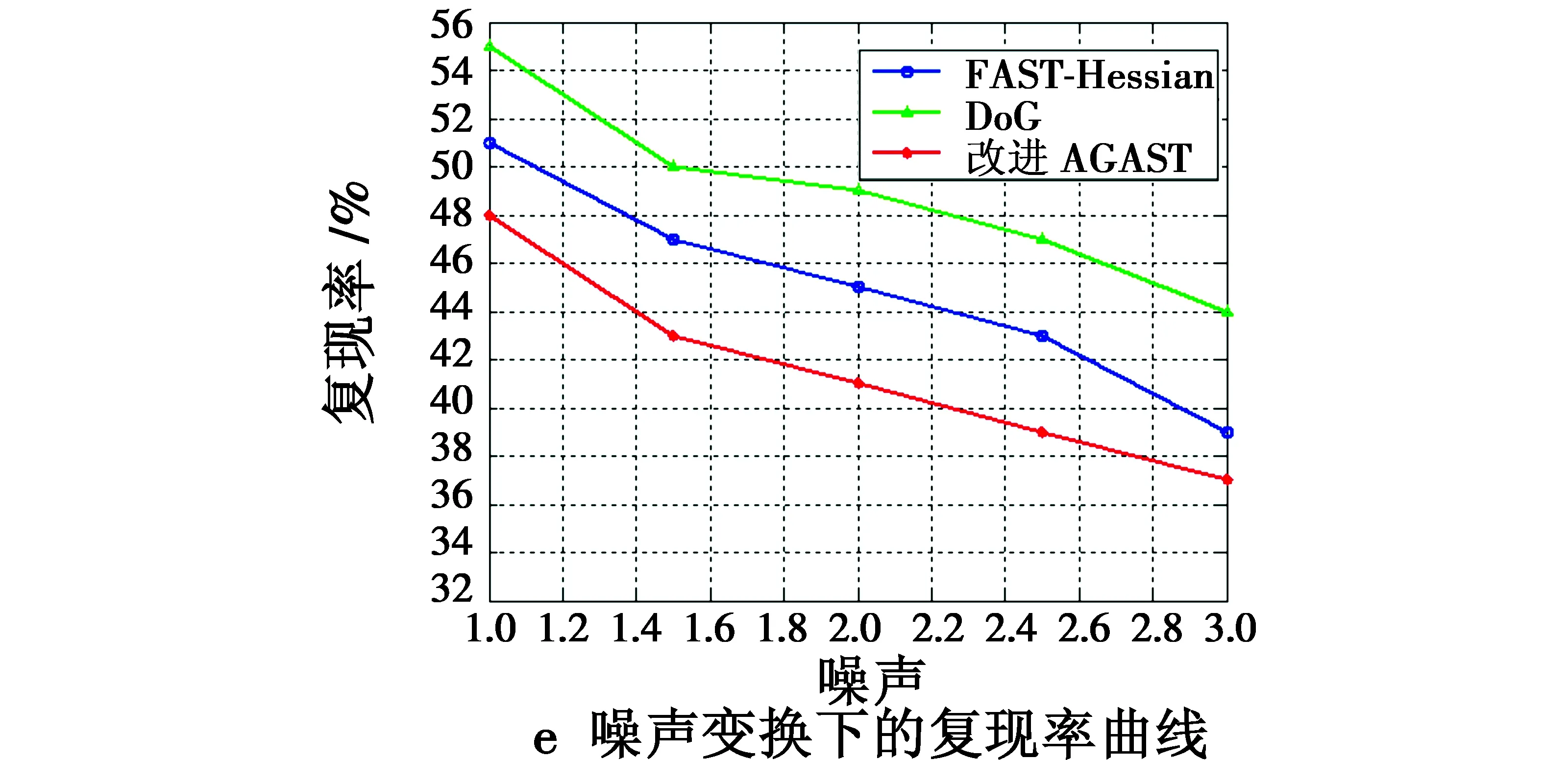

性能测试以不同程度变化下的特征点重复率作为衡量检测子效果好坏的指标,同时与经典的SIFT(DoG)与SURF(FAST-Hessian)检测子进行对比,得到实验结果如图3所示。

图3 不同变换条件下的复现率比较Fig.3 Repeatability under different transform conditions

综合考虑算法性能表现与处理速度,结合AGAST与尺度空间,本文提出一种改进的特征检测算法。由上述实验结果可以看出,本文特征检测算法性能表现良好,在尺度、旋转、光照和视点变换下的特征点重复率虽然低于SIFT检测子,但明显高于SURF检测子,这是由于本文在尺度空间的建立过程中进行了简化,只是在降采样的基础上进行建立,去除了图像卷积与高斯平滑的步骤,所以性能低于SIFT检测子,但与尺度空间的结合使得本文算法性能优于SURF检测子。由于没有进行高斯平滑滤波,本文算法对于噪声的鲁棒性低于使用模板滤波与图像卷积的SURF算法,同时尺度空间的简化使得算法的运行速度显著提高,表1中给出了3种检测算法的耗时比较。

表1 算法耗时比较

根据表1中数据,本文算法具有明显的速度优势,本文算法的运行速度为SURF算法的13倍,这是由于本文算法去除了图像卷积与高斯滤波,构建一种新的尺度空间,并引入AGAST加速检测特征点。在描述特征点时, FREAK描述子满足实时性要求,且该描述子符合仿生学原理,所得到的结果具有更好的鲁棒性。

根据上述实验结果,对比3种算法的性能可以看出,对于实际生活中存在更种仿射变换和噪声影响的图像,本文算法在保证算法的精度即特征点的重复检测率的同时,其运行速度也有较大提升,完全满足实时处理的要求,因此相对于其他2种算法,更适合于实际应用。

3.2 基于自适应弹性网络的稀疏编码

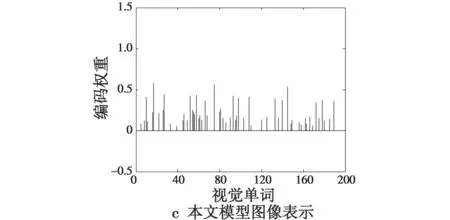

针对同一幅图像,分别采用传统稀疏编码模型与本文所提出的基于自适应弹性网络的稀疏编码模型对图像进行稀疏表示,实验结果如图4所示。

图4 3种模型下图像的稀疏表示比较Fig.4 Sparse representation of image by different models

分析上述实验结果,由图4a可知,在本文实验图像中共检测到16个特征点,根据图4b与图4c中结果可以看出,在传统稀疏编码模型与本文模型求解得出的图像稀疏表示中特征点与多个视觉单词之间具有相关性,且稀疏系数向量的峰值所在的视觉单词与BoF模型是相互对应的,不同之处只是在于峰值的大小。但在由传统稀疏编码模型计算得到的图像表示中存在负系数,导致冗余信息的产生,降低重构中图像稀疏表示的独特性,不利于实现精确目标识别。

根据实验结果可以看出,相对于传统编码模型,本文模型存在较大优势:一方面,稀疏系数向量中与特征点相关性最强的视觉单词是相同的,在实验结果中的表现为特征点对应视觉单词的稀疏系数权值均为峰值,说明对图像进行描述时该视觉单词的贡献最大,本文模型保证了这些视觉单词在图像稀疏表示中的重要性;另一方面,本文模型同时考虑了特征点与其他视觉单词之间存在的相关性,将相关性较强的其他视觉单词一起选出来对图像进行表示,具体体现为实验结果中其他非零元素的存在,这些元素的存在能够有效降低模型的重构误差;最后,由于引入自适应弹性网络,消除了稀疏系数向量中负系数的存在,避免了“抵消”现象,在降低稀疏系数向量维数的同时,保证了图像稀疏表示的独特性,降低了算法计算量,有利于目标识别任务。

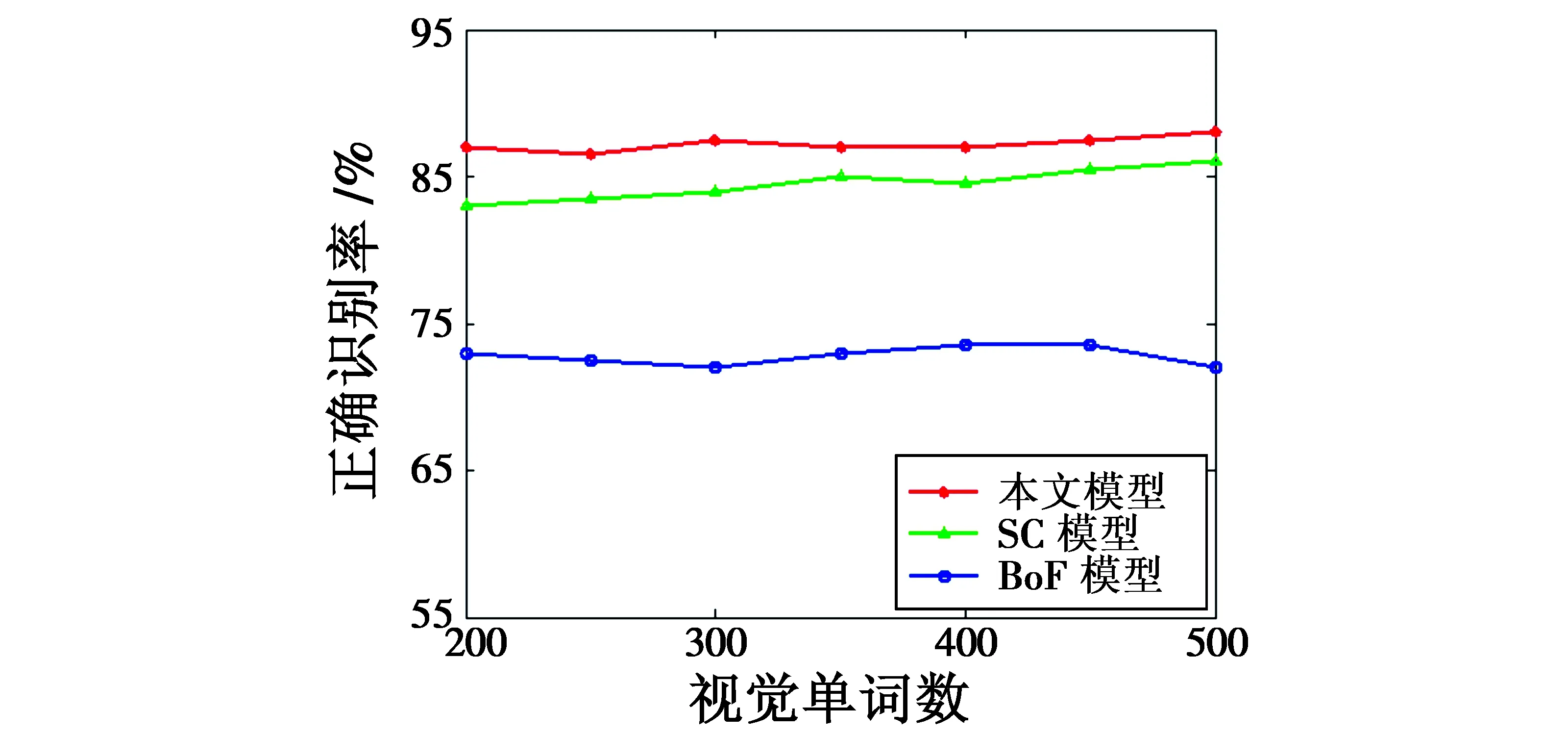

根据图5中3种模型随视觉单词数目变化的正确识别率变化曲线,实验中的分类器统一选用支持向量机,视觉单词数在200~500之间变化,可以看出,在这一区间变化时模型正确识别率曲线已经基本趋于平稳。

图5 SVM下3种模型正确识别率比较Fig.5 The accuracy comparison of different models under SVM

通过比较发现,本文模型获取图像稀疏表示的目标识别正确率明显高于其他2种模型,这是由于在BoF模型中采用k均值聚类算法构建特征词典,特征点与视觉单词之间一一对应,忽略了与其他视觉单词的相关性。在传统稀疏编码模型中虽然考虑了这种相关性,但稀疏系数向量中负系数的存在降低了其独特性,冗余信息较多,表达能力有限。而本文模型采用自适应弹性网络,通过引入自适应权重矩阵,通过判断特征的重要性而自适应地调整对应的稀疏系数,能够将相关性较高的特征一起选择出来用于对图像的稀疏表示,并消除负系数的影响,剔除运算过程中产生的冗余信息,改善模型特征选择能力,有效提高了算法的鲁棒性。

4 结束语

针对传统稀疏编码模型的不足,提出了一种基于自适应弹性网络稀疏编码的目标识别算法,通过仿真以及实验充分说明了算法的可行性与优越性,本文做了如下工作。

1)对比分析了几种特征检测算子的特点,本文采用AGAST算子进行特征点检测,考虑到该算子自身对于尺度变换的鲁棒性较弱,将尺度空间与算子结合改善算法性能,利用FREAK描述子对特征点进行描述,通过实验与SURF和SIFT算法进行对比,实验结果证明,本文算法在尺度变换、旋转变换、光照变换、视点变换和运行速度方面都具备很大优势。

2)对符合图像统计学原理的稀疏编码模型进行了深入研究,传统稀疏编码模型在重构时得到的稀疏系数向量中存在负系数,导致向量维数偏高,存在冗余信息,针对这个问题,本文结合自适应弹性网络,提出了一种基于自适应弹性网络的稀疏编码模型,并利用坐标下降算法进行求解,实验结果表明,本文模型识别性能得到有效的改善。

算法的改进方向:根据实验结果,特征检测算法的性能还存在继续优化的空间,提高其对于各种变换的鲁棒性,尤其是噪声影响。另外,编码模型的求解算法需要进一步改进,在保证精度的同时,提高算法计算速度。

[1] HARRIS C,STEPHENS M.A combined corner and edge detector[C]//Alvey Vision Conference,1988:147-151.

[2] LOWE D G.Distinctive image features from scale-invariant keypoints [J].International Journal of Computer Vision,2004,60(2):91-110.

[3] BAY H,ESS A,TUVTELLARS T,et al.SURF:speeded up robust features [J].Computer Vision and Image Understanding,2008,110(3):346-359.

[4] ROSTEN E,DRUMMOND T.Machine learning for high-speed corner detection[C]//Proceedings of the European Conference on Computer Vision,2006:430-443.

[5] LI F F,PERONA P.A Bayesian hierarchical model for learning natural scene categories[C]//IEEE Computer Society Conference on Computer Vision and Pattern Recognition,2005:524-531.

[6] YANG J,YU K,GONG Y H,et al.Linear spatial pyramid matching using sparse coding for image classification[C]//IEEE Conference on Computer Vision and Pattern Recognition,2009:1794-1801.

[7] MARI E,HAGER G,BURSCHKA G,et al.Adaptive and generic corner detection based on the accelerated segment test[C]//Proceedings of the 11th European Conference on Computer Vision,2010:183-196.

[8] ALAHI A,ORTIZ R,VANDERRGHEYNST P.FREAK:fast retina keypoint[C]//Proceedings of Computer Version and Model Recognition,IEEE Computer Society Press,2011:510-517.

[9] 唐峰.基于稀疏编码与机器学习的图像内容识别算法研究[D].上海:上海交通大学,2011.

[10] BABAUD J,WITKIN A P,BAUDIN M,et al.Uniqueness of the Gaussian kernel for scale-space filtering[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1986,8(1):26-33.

[11] ELHAMIFAR E,VIDAL R.Sparse subspace clustering[J].In CVPR,2009,35(11):2790-2797.

[12] ZOU H,ZHANG H H.On the adaptive elastic net with a diverging number of parameters[J].Annals of Statistics,2009,37(4):1733-1751.

[13] KREUTZ-DELGADO K,MURRAY J F,RAO B D,et al.Dictionary learning algorithms for sparse representation[J].Neural Compution,2003,15(2):349-396.

[14] CHANG K W,HSIEH C J,LIN C J.Coordinate descent method for large-scaleL2-loss linear support vector machines[J].Journal of Machines Learning Research, 2008,49(7):1369-1398.

ObjectRecognitionBasedonAdaptiveElasticNetSparseCoding

DU Yu-long, LI Jian-zeng, ZHANG Yan, FAN Cong

(Ordnance Engineering College,Shijiazhuang 050003,China)

The traditional sparse coding model has poor feature selection performance,and the negative coefficient in the sparse-coefficient vectors may cause high dimensions and information redundancy,which is harmful for the object recognition.To solve the problem,a sparse coding model based on the adaptive elastic net is proposed.The model firstly extracts the feature points by AGAST (Adaptive and Generic Corner Detection Based on the Accelerated Segment Test) detector in scale space,and describes them by FREAK algorithm.Then the sparse-coefficient vectors are calculated out by applying an adaptive elastic net regression model that can select strong correlation features.Finally,target recognition is realized by classifier.The result shows that feature detection algorithm is more robust to the changes of scale,viewpoint,brightness,and rotation,and the recognition performance of the model has great improvement under the restriction of adaptive elastic net model.

object recognition; AGAST; scale space; adaptive elastic net; sparse coding

杜玉龙,李建增,张岩,等.基于自适应弹性网络稀疏编码的目标识别[J].电光与控制,2017,24(7):28-32,45.DU Y L,LI J Z,ZHANG Y,et al.Object recognition based on adaptive elastic net sparse coding[J].Electronics Optics & Control,2017,24(7):28-32,45.

TP391.4

A

10.3969/j.issn.1671-637X.2017.07.006

2016-05-03

2017-03-17

国家自然科学基金(51307183)

杜玉龙(1992 —),男,辽宁北票人,硕士生,研究方向为无人机信息传输与处理技术。域,则将该点定义为特征点,算法检测速度较快,但当图像中存在光照变换时,稳定性不足,适应能力差;SIFT[3](Scale Invariant Feature Transform)检测算法是现阶段应用较为成熟的一种算法,该算法在高斯尺度空间中进行极值点检测并将其作为特征点,对于各种变换都具备鲁棒性,但耗时较严重;针对这一点,SURF[4](Speeded Up Robust Features)检测算法被提出,该算法采用Hessian矩阵对高斯尺度空间进行近似处理,有效减少了计算量,但算法对于各种变换的鲁棒性相对下降。