基于ORB特征点匹配的多目标跟踪算法

李鹏+王延江

摘 要:视频中的多目标跟踪是计算机视觉领域的一个重要问题.针对多目标跟踪过程中由于目标缩放、旋转、扭曲以及遮挡等问题的存在导致目标易丢失的问题,提出了一种基于ORB特征点的多目标跟踪算法.首先利用"运动边缘生长"算法得到目标块,再利用目标块的 ORB特征与特征模板的匹配来实现目标的关联.通过匹配过程,目标模板能够得到实时更新,即去除由噪声带来的过时的特征信息并添加进新的特征信息,保证特征模板的实时有效性,进而提高跟踪过程中匹配的可靠性.实验结果表明,本算法能够实时有效地处理目标由于形变以及局部遮挡而导致跟踪性能下降甚至跟踪目标丢失的问题,具有较好的鲁棒性.

关键词:显著性;特征点;匹配;目标跟踪

中图分类号:TP 391.4 文献标志码:A

Multi-target Tracking Algorithm Based on ORB FeaturePoints Matching

LI Peng1,2,WANG Yanjiang1

(1.College of Information and Control Engineering,China University of Petroleum,Qingdao 266580,China;

2.College of Computer and Communication Engineering,China University of Petroleum,Qingdao 266580,China)

Abstract:Video multi-target tracking is an important problem in the field of computer vision. In order to solve the problem where the target is easy to lose due to target scaling,rotation,distortion and occlusion,this paper proposed a multi-target tracking algorithm based on ORB feature point . First,the "moving edge growth" algorithm was used to obtain target blocks. Next,targets were associated by matching the ORB features of target blocks with feature templates. The matching process enables target templates to be updated in the real time by eliminating the old feature information from the noise and adding new feature information. In this way,effectiveness of feature template is guaranteed in the real time,resulting in greater reliability of matching during the tracking process. Experimental results demonstrate the ability of the proposed algorithm to robustly track targets even if the targets are deformed or partially occluded.

Key words:saliency; feature point; matching; target tracking

视觉跟踪是计算机视觉技术的一个关键应用,在智能监控、移动机器人、导航制导及无人驾驶等领域具有广阔的应用和发展前景.近年来研究人员在视觉跟踪领域开展了大量工作,提出了很多相关的理论和方法.这些理论和方法大致可分为3类:基于滤波理论[1-2],基于目标模式搜索匹配理论[3-4]和基于分类理论[5-6].基于滤波理论的跟踪方法的典型代表是无迹卡尔曼滤波(UKF)和粒子滤波(PF)等[7],但它们难以适应一些实时性要求较高的跟踪场合;目标模式搜索匹配理论一个代表是Camshift跟踪[8],算法计算量小、实时性好,但背景较为混杂、目标遮挡以及目标运动较快的时候跟踪效果不佳,因此往往需要和其他目标特征或跟踪方法配合使用;Yang 等[9]提出一种利用背景减除法得到目标,然后利用模板匹配进行目标跟踪的方法,但是该方法在目标间遮挡的情况下不能有效分割各目标.基于分类理论的目标跟踪需要采用机器学习的方法对目标样本进行训练学习,跟踪效果往往取决于分类器的设计和样本的多少.为了解决运动目标由于旋转、缩放、光照变化等情况给跟踪算法带来的问题,部分学者将sift特征[10]用在目标跟踪中[11-13],在跟踪稳定性上有所提高,但耗时较大,不利于目标跟踪的实时性.Rublee等人[14]提出了一种称为ORB的具有旋转和尺度不变性的特征检测算法,在得到较高质量特征点的同时,速度上比sift提升了兩个数量级,适合于应用在对实时性要求较高的场合.

人类利用视觉注意机制能够从场景中迅速选择少数几个显著度高的目标或区域进行优先处理从而提高信息的处理效率.另外,视觉系统对生物运动信息具有特殊的敏感性,因此,将目标的运动显著性引入到目标检测或跟踪框架中,对于提高检测及跟踪的性能具有重要意义.Zhang 等[15]将运动显著图和粒子滤波结合实现了对多目标的稳定跟踪,但是对于目标范围的界定不太准确.endprint

本文在利用边缘帧差结合LK光流法来获得目标运动边缘显著性的基础上,对运动目标进行分割,并对得到的目标块提取ORB特征,利用该特征与目标信息库中目标模板的匹配实现运动目标关联.

1 运动目标检测

目标检测是目标跟踪的前提.人眼视觉系统对于物体的边缘具有强敏感性,往往通过边缘信息获取目标物体的具体形状、解读目标物体等[16-18],本文提出一种通过“运动边缘生长”提取运动目标的方法,其中的边缘运动显著性通过光流计算得到.

1.1 边缘显著性

本文提出一种三帧边缘差分的方法来进行运动边缘检测,其优点是计算简单并且能提取到最重要的运动边缘,为后面的光流法大大减少了计算量.Canny算子[19]能够提取到较为理想的连续边缘,因此,我们首先利用Canny 算子分别得到相邻的t-1,t和t+1时刻的三帧图像It-1,It和It+1的二值边缘图,分别记作Et-1,Et和Et+1,则三帧边缘差分图DEt表示为:

DEt=Et-Et-1∩Et+1-Et(1)

其中,∩表示相交运算.

我们对边缘检测后的二值图像DEt用3×3的正方形结构元素进行形态学闭运算处理,既有助于边缘的融合和连通区域的形成,又能去除一些较小的噪点.本文通过Lucas-Kanade(LK)光流计算方法得到边缘点运动信息[20].LK是一种基于两帧差分的稀疏光流估计算法,可以只处理一定数量的离散点,计算开销较小,易满足对实时性的要求.

光流矢量v具有强度和方向两个属性.一般来说幅度越大的运动越能吸引人眼的注意,因此我們将(i,j)位置处的某边缘点的运动强度SMi,j用光流矢量大小|v|表征,得到所有边缘点的运动显著性后,令非运动边缘点的显著度置为零,则得到与源图像相同大小的显著度矩阵作为运动显著图;同时,每个运动边缘点的方向属性用一个3维向量Θi,j:Θi,j=(i,j,θ)表示并存储,其中θ表示光流的方向弧度值.

提取边缘运动显著性的基本过程如图1所示.首先利用三帧边缘差分法得到二值运动边缘图,然后对运动边缘点利用LK算法提取光流矢量,再根据光流矢量大小得到对应的边缘显著图.

1.2 目标分割

经过三帧边缘差分法得到的第t帧It的二元运动边缘图DEt存在边缘明显不连续的现象,难以根据运动边缘图实现目标的分割.本文提出一种“边缘生长”的有效的策略,可实现不连续运动边缘的完善.具体步骤如下:

步骤 1:令It的运动边缘点坐标集和边缘点坐标集分别表示为ZtDE和ZtE(两个集合中的元素对应的像素值都为1);初始化ZtDE中的元素索引k=1.将边缘差分图DEt“遮罩”于边缘图Et之上.

步骤 2:选择集合ZtDE中第k个运动边缘点DEt,ik,jk,建立初始队列Ψt,ik,jk={φ1},其中φ1=(ik,jk)表示队列中第一个元素的坐标,此时φ1=(ik,jk);设置队列长度变量Total初始值为1;设置Ψt,ik,jk中全部元素对应点的显著度均值MSMt,ik,jk和方向均值MΘt,ik,jk的初始值分别为点DEt,ik,jk的显著度值和方向.

步骤 3: 在DEt上,建立以φ1为中心的3×3邻域,考察φ1的8个相邻连通点,如果存在点p:pZtDE&&p∈ZtE&&DEt,p=0,则考察点p的显著度和方向,如果满足:

SMt,p-MSMt,ik,jk 其中Tsm,Tθ是阈值,本文中分别取Tsm=02,Tθ=π/36,则认为边缘点p与DEt,ik,jk是运动相似点,将p存入队列Ψt,ik,jk后端;更新DEt,p:DEt,p=1;更新Total:Total=Total+1. 步骤4: 计算队列Ψt,ik,jk中所有坐标元素对应点的显著度均值MSMt,ik,jk和方向均值MΘt,ik,jk.删除队列Ψt,ik,jk中第一个元素,后面其余元素依次前移一位;更新Total:Total=Total-1.如果Total≠0,从Ψt,ik,jk取出第一个元素φ1,返回到步骤3;否则执行k=k+1,返回步骤2. 步骤 5:重复步骤2~4直到生长结束. 边缘生长结束后,通过去除噪点、形态学膨胀和填充得到最终的运动目标边缘,再对其做最小外接矩形框得到目标块,从而标定目标区域范围. 2 多目标跟踪 整体框架如图2所示.首先对检测过程得到的当前帧运动目标块提取ORB局部不变性特征描述子,通过与目标库中各目标特征模板的匹配,实现目标关联,得到目标运动轨迹.同时,利用模板匹配过程更新目标库中的目标模板、各特征点位置坐标等. 2.1 ORB 特征 ORB 建立在 FAST[21]特征点检测和BRIEF[22]特征描述子基础上. 考察图像某像素点p为中心的半径r(一般为9像素)的圆圈上的像素值,如果圆圈上至少有N(一般为12)个连续的像素qi,i=1,…,M,的灰度值都满足Ip-Iqi>εd或者都满足Iqi-Ip>εd,其中Ip和Iqi分别表示像素p和qi的灰度值,i是圆圈上满足条件的第一个像素的标号且M≥N,则认为该像素点是一个关键点.对所有的关键点使用 Harris 角点测量算法排序并选取靠前的所需数量的点作为特征点.为了赋予尺度特征,ORB建立了图像金字塔.另外,为了给每个特征点赋予方向信息,ORB计算角点和质心之间的偏移角度表示角点的方向信息. 对图像进行高斯滤波后,以特征点p为中心,取31×31像素的邻域窗口P.在P中随机选取一对5×5的子窗口作为测试点P(x)和P(y),x和y分别是这两个测试点的坐标.通过比较两个测试点的灰度值,得到一个二进制位.以上过程重复n次,就得到长度为n的二进制串作为初步描述子,记作f'n(p).BRIEF描述子不具有旋转不变性,所以ORB又给它加上了旋转不变性而得到最终的描述子fn(p).

2.2 基于自适应模板更新的目标跟踪

本小节的跟踪算法分为目标匹配与模版更新两个过程.

2.2.1 目标匹配

本文的算法是用目标的特征点来表征目标,因此目标间的匹配就是各自特征点的匹配.

1) 目标信息库.对应于每个目标的信息包括:目标序号、历史帧中目标块左上角坐标以及中心坐标、目标块的特征模板、所有特征点的位置矩阵以及留存级矩阵.本文中,目标的特征模板表示为一个m×n维的矩阵,m表示特征点数目,矩阵每一行对应于一个特征点的n维ORB描述子(本文中n=256).

2)特征点匹配.特征点间的匹配是利用其描述子间的欧氏距离进行匹配度量.本文提出一种“近邻双向匹配”策略来改善算法执行效率,其思想基于:相邻帧的同一匹配特征点在几何空间上不会有太大的位移.以当前帧目标O中第i个特征点pi为例(其匹配点记作pmatch),具体过程为:

设置一个描述子匹配阈值Tr;在当前帧建立以pi为中心的w×w大小的搜索窗Wcur,在前一帧同样位置也建立相同大小的搜索窗Wpre.搜索窗尺寸w如果太大,会降低搜索效率;太小,当目标运动较快时相关匹配点对易造成丢失,在实验中取w=10时可以取得较恰当的折中效果.

a)后向搜索.将pi与在Wpre内的属于目标信息库的特征点进行归一化匹配度量,匹配度最高的前两个特征点作为候选特征点(图3(a)),分别记作p1和p2,相应匹配度记作ξ1和ξ2.若ξ1和ξ2都低于阈值Tr,则拒绝匹配;若只有ξ1高于阈值Tr,则直接选择p1為匹配特征点,即pmatch=p1;若ξ1和ξ2都高于阈值Tr且ξ2与ξ1的比值小于0.4,则pmatch=p1;若ξ1和ξ2都高于Tr但ξ2与ξ1二者的比值不小于0.4,则执行步骤b).

b)前向搜索.p1,p2分别到当前帧的Wcur窗内搜索匹配特征点,各自取前两个最小距离点作为候选点,分别记作p11,p12和p21,p22,相应匹配距离记作ξ11,ξ12和ξ21,ξ22.如果p11,p12中一个是pi(图3(b)),则pmatch=p1;相反,若p21,p22中一个是pi,则pmatch=p2;如果p11,p12和p21,p22中各有一个是pi(图3(c)),则遵循下面原则选取匹配点:

pmatch=p2,ifp12=pi&&p21=pi&&d2 式中:d1和d2分别是pi到p1和p2的空间距离,如果p11,p12和p21,p22四者中没有一个是pi,则pmatch=pm,m=argmink∈1,2ξk+ξk1+ξk2. 3)目标匹配.对当前考察目标O在前一帧得到的所有匹配点进行统计,求出其分别所属目标模板的目标标号以及匹配点个数并组成集合Z:Z=Nφ1,…,Nφi,…,NφI,φi∈{1,…,L}.其中Nφi表示所有匹配点中属于第φi个目标的个数,I是Z中的元素个数,L是目标信息库中的目标总个数,是个变量.从Z中找出最大值记作Nφj,并设N为当前目标块中特征点的总个数,则最大匹配率为:PO=Nφj/N.预设一目标匹配率阈值Tp,当PO>Tp时,认为当前目标与目标库第φj个目标匹配,从而建立起关联;否则,将当前目标与前一帧标号为φ1,…,φi,…,φI的目标分别进行目标再匹配后重新判断.实际中发现,由于邻帧同一目标的相对位移很小,往往并不需要进行再匹配. 2.2.2 模板更新 为了保持目标信息库在目标跟踪过程中的有效性,必须对其进行实时更新.本文借鉴文献[13]中的模版更新过程为目标库中每个目标的每个特征点设置一个特征保留等级,比如目标O的第j个特征点的保留等级记作RO,j,它表示该特征点属于该目标的置信度,最大值记作Rmax. 1) 添加新目标模板:若当前帧某个目标与目标库所有目标模板均不匹配,则认为此目标是新目标,将新的目标序号、目标块坐标以及目标模板等信息添加到目标库.因为是新目标,所以将所有特征点的保留等级最大化为Rmax. 2) 匹配目标模板的更新:若当前目标O与目标库中第 i个目标匹配,则第i个目标模板中相匹配的特征点替换为当前目标中相匹配的特征点,更新特征点位置矩阵,同时将所对应特征点的保留等级均置为Rmax;对于目标模板中未匹配的特征点,其保留等级减 1;对于当前目标O中未匹配的特征点,将其加入目标模板中,更新特征点位置矩阵,同时,所对应的保留等级均置为Rmax.某特征点保留等级降为 0时,说明此特征长期没有得到匹配,则删除此特征点的所有信息. 3) 未匹配目标模板的更新:当前帧所有目标匹配结束后,若目标库中仍有目标模板未得到匹配,则存在三种情况:目标暂时停止、被完全遮挡或离开场景.那么,考察上一次该目标匹配时刻以及之前l-1帧的中心坐标,分别计算时间窗内l帧的目标块中心坐标与场景四个边界的距离的最小值,依时间顺序分别记作dist1,…,distl,如果l个距离递减且distl≤Te,Te是预设的阈值,则认为目标离开场景,模板所有特征点保留等级维持不变;如果distl>Te且在最后一次匹配的目标位置处,当前帧对应图像块依然能与该目标模版匹配,则认为目标暂时停止,特征点保留等级维持不变.此时,跟踪中的跟踪目标框中心位于目标模板中保存的目标块中心;否则,判定目标被完全遮挡.上述时间窗大小l和距离阈值Te,本文根据所采用视频序列的帧率由实验分别确定为l=8和Te=15像素.本算法对于刚性目标的跟踪 Rmax 取值为3,非刚性目标跟踪 Rmax取值为 5[13]. 本算法没有进行模板的删除,这是考虑到在实际应用中,离开场景的目标有可能再次返回. 2.3 目标间的局部遮挡 在多目标跟踪中,会出现两个或多个目标间遮挡的情况.本文提出一种分别根据匹配特征点比例和位置关系进行遮挡判断和目标分离的处理方法.

2.3.1 遮挡判断

当不同运动目标发生部分遮挡时,将得到单一的外接目标矩形框构成的一个目标块,这时判定目标间发生了遮挡.如图4所示.

发生遮挡的多个目标块会形成一个单一的“簇目标块”.对遮挡的判断基于如下考虑:当遮挡刚刚发生时,目标模板在簇目标块中都能找到绝大多数特征点.以两目标为例(图4),设簇目标块在后向匹配中得到的目标序号及其匹配点个数集合为B:B={N1,N2,Nother_1,…,Nother_k},其中N1,N2表示所有匹配点中分别属于第1,2个目标的个数,Nother_i,i∈{1,…,k}表示分别属于k个其它目标的匹配点个数.对于B中每个元素Nj,j=1,2,other_1,…,other_k,令NTj表示相应模板j中全部的特征点数,如果至少有2个j值满足Tm≤Nj/NTj≤1成立,其中Tm是比例阈值(由实验确定取值0.8),则认为当前帧的簇目标块发生了目标1和目标2两个目标间的部分遮挡.

2.3.2 遮挡处理

遮挡发生后,不对目标库中发生彼此遮挡的各目标特征模板及目标块(框)尺寸进行更新,即,各目标块的大小保持发生遮挡前一个匹配时刻的各自大小不变.但是在跟踪中我们仍然需要估计各目标块的中心位置.

令xTi,j和yTi,j分别表示簇目标中与第i个目标模板匹配的第j个特征点在模板上的x坐标和y坐标,xcuri,j,ycuri,j则分别表示对应匹配特征点在簇目标中的x坐标和y坐标.则第i个目标在簇目标中的中心坐标(xcuri,c,ycuri,c)为:

xcuri,c=xTi,c+1Ni∑Nij=1(xcuri,j-xTi,j)ycuri,c=yTi,c+1Ni∑Nij=1(ycuri,j-yTi,j)(4)

式中:xTi,c和yTi,c分别表示第i个目标模板中的中心坐标的x和y分量;Ni是簇目标中匹配第i个目标模板的特征点总数.

3 实验结果与分析

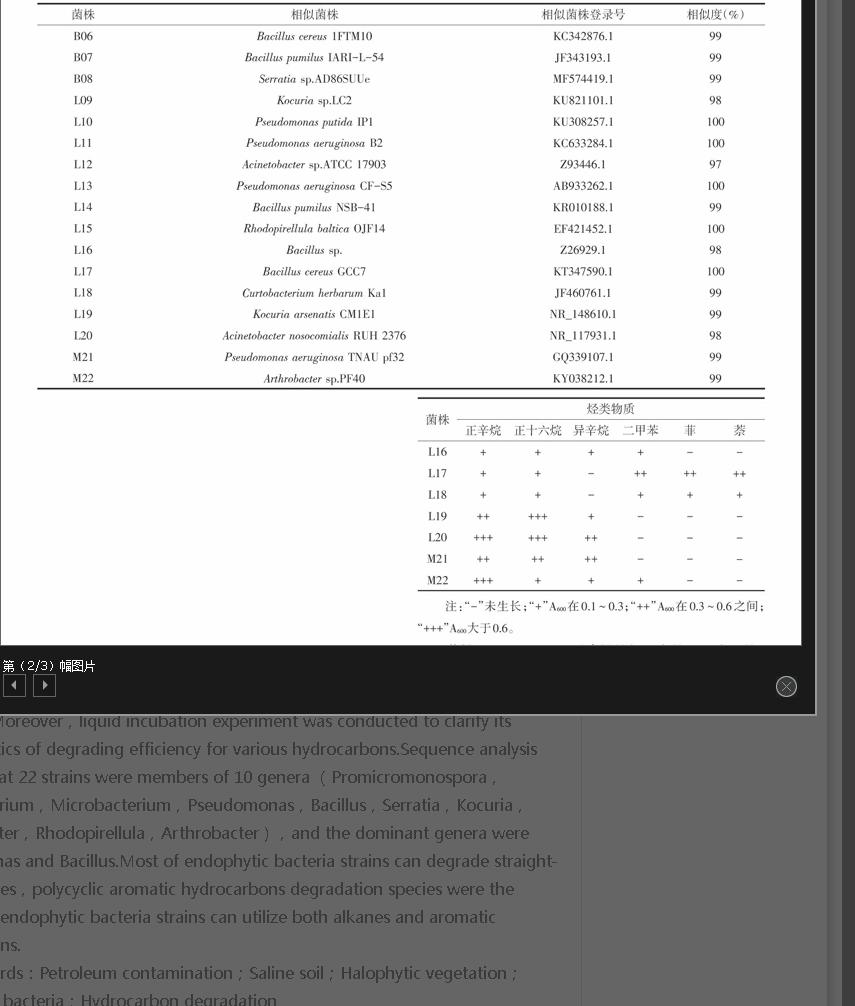

为了验证本文算法的有效性,我们选择不同的视频序列进行目标检测、跟踪实验,并与颜色特征模板匹配算法[9]、基于视觉注意的粒子滤波算法[15]进行比较.实验环境为CoreTM-i7 CPU 处理器,8GB内存,Windows 7操作系统的个人电脑,使用Matlab软件编程.本文测试的总共10个视频序列名称及其参数如表1所示,这些序列包括了室内、室外不同场景,以及刚性、非刚性目标,它们分别取自于ATON project of UCSD圣迭戈加利福尼亚大学数据库(sequence1),德国卡尔斯鲁厄大学(sequence7和sequence9),伦敦玛丽女王大学(sequence 3,sequence 8 and sequence10)韩国汉阳大学计算机视觉实验室(No.4~ No.6 sequence 4~ sequence 6)以及MATLAB图像工具箱(sequence 2),以上数据库在本文中依次简记为Dataset1~Dataset5.测试序列中,No.3,No.8 and No.10 sequences 中所有目标块的groundtruth 已经给出;No.4~ No.6 sequences 中只给出一个目标的ground truth,其余目标的ground truth我们人工標注;其余序列中目标的ground truth我们人工标注.

3.1 检测结果与分析

本小节对本文第1节所提出的目标检测算法进行对比验证.图5是本文算法、帧差法和背景减除法在对序列1运动目标检测过程中的抽样结果(221th帧)对比.图中第一行从左到右分别是原始帧图像和各目标的ground truth;第二行和第三行分别是帧差法和背景减除法得到的前景区域和滤除噪声后得到的运动目标块,其中背景建模为:

Bi,j,t=αIi,j,t+(1-α)Bi,j,t-1(5)

式中:α取0.15.可以看到,帧差法在目标内部容易产生“空洞”,而背景减除法得到的前景目标有“拖尾”效应,这都将会导致在目标分割时产生分歧,降低分割的准确度.图中第4行是本文算法得到的前景目标块,可以看到本文算法能取得更好的分割结果.

我们利用“受试者工作特征(Receiver Operating Characteristic,ROC)曲线”下的面积AUC(Area Under the Curve)指标来定量分析这3种检测算法的性能[23].将原始二值检测图中前景噪声团块面积作为ROC图绘制中的可变辨别门限,大于门限的前景团块有资格作为目标被分割,门限变化范围从1像素~100像素;对每个目标可求得ROC曲线下面积AUC值.为了减少比对的计算量且不失一般性,我们在所有10个视频序列所有帧中无重复地随机抽取500个样本帧对上述帧差法、背景减除法和本文检测算法求取AUC的均值(精确到小数点后3位),结果分别是0.804,0.826和0861,本文检测算法具有更好的性能.

3.2 跟踪结果与分析

3.2.1 关键阈值Tr和Tp的设置

Tr表征的是两个特征点描述子的匹配度,用于特征点匹配环节的后向搜索过程中,该值经由简单的实验统计法选取.令两个等长的描述子f1,f2的匹配度表示为:

Lmatch=1-1μNorm_2(f1-f2)(6)

其中Norm_2(.)表示2-范数,常数μ=16(描述 子长度为256位,完全不匹配时的2-范数值为16)用来归一化.从本文引用的数据库中另选取5个视频序列(Crowds,walking(Dateset4),rheinhafen(Dateset2),highway1(Dataset1)和vipmen(Dataset5))用作参数估计,其中涵盖了室内和室外场景、刚性和非刚性目标.每一序列中我们随机选择两个连续出现15帧以上的运动目标作为样本目标,截取并统计每个样本目标15帧中的特征点匹配情况.这样共选择10个样本目标即10个子序列,统计帧数共150帧.记录并统计Tr值的变化对特征点正确匹配率(定义为:正确匹配的点对数/全部匹配点对数;对于当前帧的特征点pi,若经本文的匹配算法得到匹配点为p1,即有pi=>p1;基于p1反向执行算法,如果能求得p1的匹配点为pi,即有p1=>pi,则将pi,p1初步判为一正确匹配点对.进一步,将得到的初步正确匹配点对集利用随机抽样一致算法性算法(RANSAC)[24]剔除误匹配点得到的点对集作为本文的正确匹配集),统计结果如图6(a),当Tr值很低的时候,特征点匹配率较低,这是由于候选特征点p1和p2的各自匹配度ξ1和ξ2即使不高很易满足该门限,在执行完“后向搜索”后执行下一步“前向搜索”的概率降低,而后者有助于进一步的确认匹配点.随着匹配阈值Tr的增长,特征点匹配率也增大,在Tr增到大约0.5以后特征点匹配率达到较为稳定的状态.但是,当Tr较大的时候ξ1和ξ2容易同时低于阈值Tr,“前向搜索”过程被激活的概率也大为增加,使得特征点匹配过程的整体执行时间增加.因此,综合考量算法的匹配率和实效性,文中取Tr的值为0.5.endprint

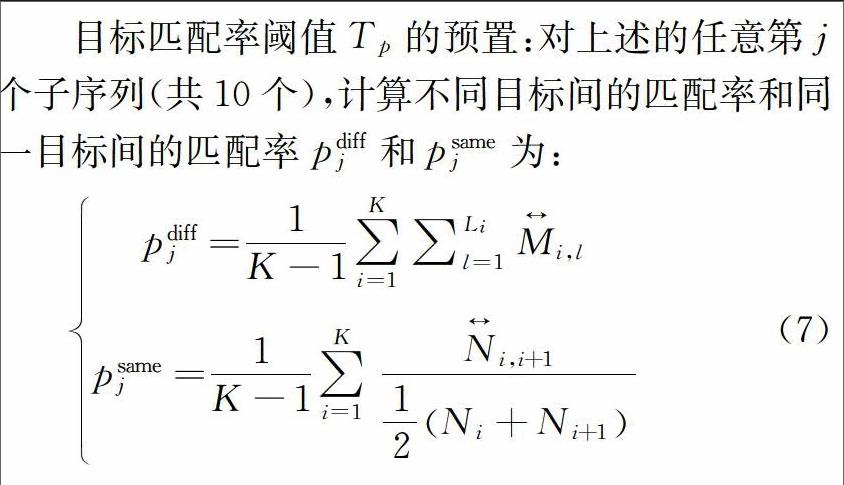

目标匹配率阈值Tp的预置:对上述的任意第j个子序列(共10个),计算不同目标间的匹配率和同一目标间的匹配率pdiffj和psamej为:

pdiffj=1K-1∑Ki=1∑Lil=1Mi,lpsamej=1K-1∑Ki=1Ni,i+112Ni+Ni+1(7)

其中K=15是子序列帧数,Mi,l表示第i帧第l个其它目标的ground truth目标块与样本目标ground truth目标块的匹配点对数;Li是第i帧中其它目标的总个数;Ni,i+1表示第相邻两帧的样本目标ground truth目标块的匹配点对数;Ni是第i帧中样本目标ground truth目标块的的特征点数.统计全部10个子序列(图6(b))可知,相同目标间具有很高的匹配率,不同目标间的匹配率则很低.据此,本文实验中我们将目标匹配率阈值设置为Tp=0.8.

3.2.2 定性分析

出于比较的目的,将本文提出的跟踪算法与Yang等[9],张焱等[15]和蔺海峰等[13]的算法在不同的图像序列上进行性能对比.为了描述的方便,后文中将后3种方法分别记作YG,ZG和LN算法.

图7是对序列2室外环境下公路场景中汽车(刚性目标)的跟踪结果.

图8是对序列3室内场景中行人(非刚性目标)的跟踪结果.

图9是对序列4这种介于室外和室内环境的走廊场景中行人的跟踪结果.以上3个图中,不同颜色的线框分别代表不同的目标,点划线、粗实线、实线、虚线和点线矩形框分别表示目标的ground truth(真实)分割以及本文算法、LN算法、ZG算法和YG 算法得到的目标块.第1行是ground truth结果;第2行是LN算法与ZG算法的跟踪结果;第3行是本文算法与YG 算法的跟踪结果.从这3个图中可以直观地看出,我们的方法有更好的跟踪性能.

图10从左到右分别给出了在本文算法下序列2(1st帧到55th帧)、序列3(1st帧到450th帧)和序列4(1st帧到 311th帧)的目标跟踪轨迹,其中轨迹线的颜色分别与图7~图9中跟踪框的颜色相一致.而对于出现的其它颜色的跟踪线,例如图10右图上方的浅灰色线,则表示在序列3这期间出现的其他目标的跟踪轨迹.

为了测试本文方法在运动目标间部分遮挡情况下对目标的跟踪能力,我们对视频序列5中的多人进行跟踪实验,并考察4种方法的抗遮挡性能.图11第1行是39th帧和55th帧的源图像,可以看到,二者都发生了目标间的遮挡(39th帧中,图像左部的一对行人发生了彼此遮挡;55th帧中,图像中部的两对行人均发生了部分遮挡).第2行是LN算法与ZG算法的结果,可以看到,ZG算法能够继续目标跟踪单个目标,但准确性不佳;LN算法将彼此遮挡的多个目标作为一个目标进行跟踪,无法辨别具体的单个目标(39th帧中的灰色细实线大框;55th帧中的细实线灰色大框),直到遮挡状态解除.第3行是本文方法与YG方法的对比,当遮挡发生时,YG方法也如同LN一样将合并后的目标当作一个整体来跟踪(39th帧中的灰色虚线大框;55th帧中的两个虚线灰色大框),但是本文方法的准确性要高于ZG方法.另外,也能直观地看到,本文算法相较于其它算法有着最好的跟踪效果.

我们进一步测试了本文算法在目标光照变化条件下的跟踪性能,如图12所示.第1行是目标的真实分割,第2行是LN,ZG算法的跟踪结果;第3行是本文算法和YG算法的跟踪结果.

可以看到ZG算法对光照改变时的目标跟踪效果不佳.如图12所示,当车辆目标的光照发生了变化(如第2行第2列图),ZG算法不能够准确地跟踪目标,这是由于该算法中所采用的粒子滤波算法的粒子特征固定而无法随目标光照的变化而改变;而LN算法(第2行细实线框)和YG算法(第3行虚线框)由于都采用了背景更新模型在光照变化时也能较好地跟踪目标,但是正如前面讨论的那样,当目标间发生部分遮挡时,LN和YG将多个目标作为一个整体进行处理而无法区分个体目标(如第3行,第2列灰色虚线框).而本文算法由于所采用的ORB描述子本身具备一定的光照变化鲁棒性,因此得以较好地对目标实现跟踪.

3.2.3 定量分析

为了定量分析跟踪效果,我们考察跟踪准确性和成功率两个指标.采用目标块重叠率作为跟踪准确性的评判标准[25],计算如下

Rt=rt∩rGTtrt∪rGTt(8)

式 (8) 中,rGTt 为第t帧真实目标块(Ground truth),rt为跟踪算法得到的目标块,∩和∪分别表示两个区域的交和并,|.|表示区域中的像素个数.对于一帧中包含多目标的情况,分别计算各个目标的重叠率然后取均值作为本帧的整体重叠率.在试验中,对于一帧中包含多目标的情况,我们分别计算各个目标的重叠率然后取均值作为本帧的重叠率.另外,使用累积平均重叠率作为当前帧的跟踪准确性度量:

R-t=1t∑tk=1Rk(9)

任取序列3,得到其跟踪准确性演变规律如图13.从图中可以看到,随着对序列中目标跟踪的进行,所有算法的准确性值逐渐趋于稳定,其中我们的算法有最高的跟踪准确性.全部10个序列的跟踪准确性具体值在表2第3列给出.进一步地,本文规定:如果某一帧的跟蹤准确性高于50%,则认为该帧跟踪成功.表2列出了3种算法分别在10个序列上的跟踪成功率具体结果,可以看到本文的算法在整体上具有最高的跟踪成功率.

4 结 论

本文提出了一种基于ORB特征点匹配的目标跟踪算法.首先通过帧间边缘差分和LK光流法提取边缘运动显著性,再进行运动边缘生长得到运动目标的边缘,从而分割出目标块;然后提取目标块的ORB特征,利用目标与模板特征点之间的匹配实现目标的跟踪过程.在跟踪过程中,目标信息库不断得到更新,从而能确保模板的持久有效性.实验证明,该算法对多运动目标在形变、旋转、光照变化以及目标间发生部分遮挡的情形下都具有较好的实时跟踪鲁棒性.然而,我们也注意到我们的算法不能够有效处理目标被狭长背景障碍物“劈裂”的情况.在这种情况下,在本文的目标检测阶段该目标就会被检测为两个不同的运动目标,我们计划融合其它的目标特征来解决这个问题,从而进一步提升目标检测的鲁棒性;本文尚没有考虑去除运动目标阴影,这将在后续工作中加以完善.最后,如何将算法应用到活动场景下的目标跟踪也是我们着重考虑的方向.endprint

参考文献

[1] RAO G M,SATYANARAYANA C.Visual object target track-ing using particle filter: a survey[J].International Journal of Image,Graphics and Signal Processing,2013,5(6): 57-71.

[2] TOLOEI A,NIAZI S.Stateestimation for target tracking problems with nonlinear Kalman filter algorithms[J].International Journal of Computer Applications,2014,98(17): 30-36.

[3] CHOI Y J,KIM Y G.A target model construction algorithm for robust real-time mean-shift tracking[J].Sensors,2014,14(11): 20736-20752.

[4] KORMAN S,REICHMAN D,TSUR G,et al.Fast-match: Fast affine template matching[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2013: 2331-2338.

[5] LI L,HAN Z,YE Q,et al.Visual object tracking via one-class SVM[C]//Asian Conference on Computer Vision.Springer Berlin Heidelberg,2010:216-225.

[6] KALAL Z,MIKOLAJCZYK K,MATAS J.Face-tld: Tracking-learning-detection applied to faces[C]//Image Processing (ICIP),2010,17th IEEE International Conference on.IEEE,2010,119(5): 3789-3792.

[7] DOUC R,CAPPE O.Comparison of resampling schemes for particle filtering[C]//Image and Signal Processing and Analysis,2005,Proceedings of the 4th International Symposium on.IEEE,2005: 64-69.

[8] 宋晓琳,王文涛,张伟伟.基于LBP纹理和改进Camshift算子的车辆检测与跟踪[J].湖南大学学报:自然科学版,2013,40(8): 52-57.

SONG Xiaolin,WANG Wentao,ZHANG weiwei.Vehicle detection and tracking based on the local binary pattern texture improved camshaft operator[J].Journal of Hunan University: Natural Sciences,2013,40(8): 52-57.(In Chinese)

[9] YANG T,PAN Q,LI J,et al.Real-time multiple objects tracking with occlusion handling in dynamic scenes[C]//Computer Vision and Pattern Recognition,2005,IEEE Computer Society Conference on.IEEE,2005:970-975.

[10]LOWE D G.Distinctive image features from scale-invariant key points[J].International Journal of Computer Vision,2004,60(2): 91-110.

[11]ZHOU H,YUAN Y,SHI C.Object tracking using SIFT features and mean shift[J].Computer Vision and Image Understanding,2009,113(3): 345-352.

[12]TUYTELAARS T,MIKOLAJCZYK K.Local invariant feature detectors: a survey[J].Foundations and Trends in Computer Graphics and Vision,2008,3(3): 177-280.

[13]藺海峰,马宇峰,宋涛.基于 SIFT 特征目标跟踪算法研究[J].自动化学报,2010,36(8): 1204-1208.

LIN Haifeng,MA Yufeng,SONG Tao.Research on object tracking algorithm based on SIFT[J].Acta Automatica Sinica,2010,36(8): 1204-1208.(In Chinese)

[14]RUBLEE E,RABAUD V,KONOLIGE K,et al.ORB: An efficient alternative to SIFT or SURF[C]//Computer Vision (ICCV),2011,IEEE International Conference on.IEEE,2011,58(11): 2564-2571.endprint

[15]张焱,张志龙,沈振康,等.基于动态显著性特征的粒子滤波多目标跟踪算法[J].电子学报,2008,36(12): 2306-2311.

ZHANG Yan,ZHANG Zhilong,SHEN Zhenkang,et al.The images tracking algorithm using particle filter based on dynamic salient features of targets[J].Acta Electronica Sinica,2008,36(12): 2306-2311.(In Chinese)

[16]JOULAN K,HAUTIERE N,BREMOND R.A unified CSF-based framework for edge detection and edge visibility[C]//Computer Vision and Pattern Recognition Workshops (CVPRW),2011,IEEE Computer Society Conference on.IEEE,2011: 21-26.

[17]CHEN J,PAPPAS T N,MOJSILOVIC A,et al.Adaptive perceptual color-texture image segmentation[J].IEEE Transactions on Image Processing,2005,14(10): 1524-1536.

[18]汪凯斌,俞卞章,王琦,等.无须反复初始化的活动围道纹理分割方法[J].西安电子科技大学学报,2008,35(3):542-545.

WANG Kaibin,YU Bianzhang,WANG Qi,et al.Texture image segmentation using the without re-initialization geodesic active contour model[J].Journal of Xidian University,2008,35(3):542-545.(In Chinese)

[19]ERSEN L I,SHULONG Z,BAOSHAN Z,et al.An adaptive edge-detection method based on the canny operator[C]// Environmental Science and Information Application Technology,2009,International Conference on.IEEE,2009: 465-469.

[20]BAKER S,MATTHEWS I.Lucas-kanade 20 years on: A unifying framework[J].International Journal of Computer Vision,2004,56(3): 221-255.

[21]ROSTEN E,DRUMMOND T.Machine learning for high-speed corner detection[C]//European Conference on Computer Vision.Springer Berlin Heidelberg,2006: 430-443.

[22]CALONDER M,LEPETIT V,STRECHA C,et al.Brief: Binary robust independent elementary features[C]//European Conference on Computer Vision.Springer Berlin Heidelberg,2010: 778-792.

[23]WEBB G I,TING K M.On the application of ROC analysis to predict classification performance under varying class distributions [J].Machine Learning,2005,58(1): 25-32.

[24]劉相滨,邹北骥.一种基于RANSAC的柱面图像配准算法[J].湖南大学学报:自然科学版,2010,37(8):79-82.

LIU Xiangbin,ZOU Beiji.A RANSAC-Based cylindrical image registration algorithm[J].Journal of Hunan University: Natural Sciences,2010,37(8):79-82.(In Chinese)

[25]黎万义,王鹏,乔红.引入视觉注意机制的目标跟踪方法综述[J].自动化学报,2014,40(4):561-576.

LI Wanyi,WANG Peng,QIAO Hong.A survey of visual attention based methods for object tracking[J].Acta Automatica Sinica,2014,40(4): 561-576.(In Chinese)endprint