注意对视听语义整合加工的影响 *

吕 勇 顾吉有

(教育部人文社会科学重点研究基地天津师范大学心理与行为研究院,天津 300074)

注意对视听语义整合加工的影响 *

吕 勇 顾吉有

(教育部人文社会科学重点研究基地天津师范大学心理与行为研究院,天津 300074)

采用2×3的被试内实验设计,将注意条件和目标刺激类型作为实验变量,考察了指向不同感觉通道的注意对视听语义整合加工的不同影响。结果发现,只有在同时注意视觉和听觉刺激时,被试对语义一致的视听刺激反应最快,即产生冗余信号效应。而在选择性注意一个感觉通道时,语义一致的视听刺激并不具有加工优势。进一步分析发现,在同时注意视觉和听觉时语义一致视听刺激的加工优势源自于其视觉和听觉成分产生了整合。也就是说,只有在同时注意视觉和听觉时,语义一致视听刺激才会产生整合,语义不一致视听刺激不会产生整合。而在选择性注意一个感觉通道时,不论语义是否一致,视听刺激均不会产生整合。

注意,多感觉整合,语义联结,竞争模型。

1 引言

人们的脑每天都会接受大量来自不同感觉通道的信息。持续追踪并整合这些来自不同通道的信息是人类知觉系统的一项重要功能(Su,2014)。有研究显示,个体对多通道信息的整合加工(即多感觉整合,multisensory integration)能够减少反应时并提高正确反应率(孙远路等, 2011;Koelewijn, Bronkhorst, & Theeuwes, 2010),并且降低知觉阈限(Frassinetti, Bolognini, & Làdavas, 2002;Lovelace, Stein, & Wallace, 2003)。已有文献中将这种对双通道目标的加工优势称为“冗余信号效应(the redundant signal effect)”(Miller, 1982)。

在对多通道信息的整合加工中,注意的作用一直存在争论(Koelewijn et al., 2010;Talsma,Senkowski, Soto-Faraco, & Woldorff, 2010)。目前,主流观点认为注意对视听整合加工起一定的作用。比如,Talsma和Woldorff(2005)采用简单图形和短音分别作为视觉和听觉材料,考察了被试在注意和非注意条件下探测偶然出现的目标刺激的表现,同时记录被试的脑电。结果发现,被试对双通道刺激的反应明显快于对任意一个单通道刺激的反应。并且,只有在注意条件下,才会出现代表视听整合加工的ERP效应。

但是,Talsma和Woldorff的研究仅关注注意与非注意条件,并没有将注意条件做进一步的区分。众所周知,注意除可以指向不同的空间位置、客体特征之外,还可以指向不同感觉通道(Talsma, 2015)。那么,当注意指向不同感觉通道时,视听整合是否会存在差异?有研究者(Mittag, Alho, Takegata, Makkonen, & Kujala, 2013)针对上述问题进行了考察。他们采用芬兰语中半合成的辅音-元音音节作为视觉刺激,其读音作为听觉刺激,考察被试在注意不同通道时多感觉整合的差异。结果发现,被试在注意视觉和同时注意视觉和听觉时,都会产生明显的多感觉整合效应,而在只注意听觉时,没有多感觉整合效应产生。这项研究表明,尽管注意能够影响视听整合,但并不是在注意任意通道时均会产生,因此注意对多感觉整合的影响由于注意指向的感觉通道不同而具有一定的条件性。

同时,人们生活环境中的刺激除共享时间和空间特征,还共享语义特征(Laurienti, Kraft, Maldjian,Burdette, & Wallace, 2004),这就构成了刺激之间的语义联结。有研究者认为,大脑在处理信息时,倾向于将内容上匹配的刺激当作源自于相同资源处理,或者说,当两种刺激在内容上相一致(如,语义一致)时,大脑更倾向于认为它们来源于同一资源,这样更有益于人们的知觉系统将其整合成统一的知觉(Su, 2014)。一些以视听语义知觉为考察对象的研究结果与这种视听语义一致信息的加工优势基本一致(van Wassenhove, Grant,& Poeppel, 2007; Ten Oever, Sack, Wheat, Bien, & van Atteveldt, 2013)。由此可见,语义一致的视听刺激更易产生整合。那么,在不同的注意条件下,这种语义一致的视听刺激是否仍然具有加工优势呢?本研究采用简单图形作为视觉刺激,采用人声读出的单字词作为听觉刺激,使听觉刺激和视觉刺激之间形成一定的语义联结。同时,通过线索将被试的注意指向不同感觉通道,考察当个体注意不同通道时的视听语义整合加工是否存在不同。

2 方法

2.1 被试

被试为26名在校大学生(男生16人,女生10人),平均年龄为20岁。所有被试视力或矫正视力正常,听力正常,均为右利手,身体健康,没有脑部损伤史。被试完成实验后获得少量报酬。

2.2 实验仪器和材料

实验刺激采用E-prime 1.1软件编制实验程序。视觉刺激通过17寸液晶显示器呈现,听觉刺激通过入耳式耳机呈现,响度约为64 db。被试眼睛正对电脑显示器中央位置,距离约50 cm。实验中线索包括三种:“请注意看”、“请注意听”、“请注意看和听”。这三种线索均用30号白色宋体字呈现于屏幕中央(黑色背景)。单通道视觉目标刺激为白色圆形、白色正方形和白色三角形,视角为3.4°。单通道听觉目标刺激采用Sound Forge 9.0软件制作和处理,为同一女声读出的“圆”、“方”和400 Hz的短音。双通道目标刺激为视觉和听觉刺激同时呈现。

2.3 实验程序与实验设计

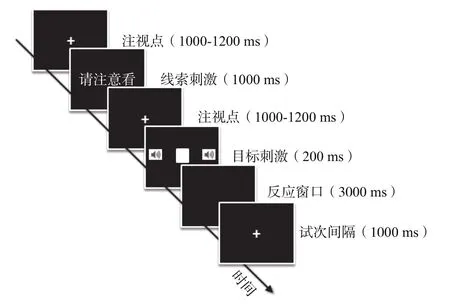

在每个试次中,首先在黑色屏幕上呈现白色十字注视点,持续时间为1000 ms至1200 ms之间随机。注视点消失后在屏幕中央呈现线索。线索呈现1 s,随后白色十字注视点出现在屏幕中央,在1000 ms至1200 ms之间的随机呈现。注视点消失后呈现目标刺激。视觉和听觉刺激均呈现200 ms,随后被试进行按键反应,按键后自动进入下一个试次。如果超过3 s不做反应,该试次记为错误,也自动进入下一试次。随后呈现1 s的空屏作为试次间隔。实验中人声读出的“圆”、“方”分别与圆形和正方形形成具有语义联结的刺激对,同时,分别将白色三角形与“圆”、“方”匹配,将短音与圆形和正方形匹配,以形成语义不一致的刺激对。被试的任务是根据线索的要求进行按键反应:当看到圆形、听到“圆”、或看到的圆形和听到的“圆”同时呈现时,按F键;当看到正方形、听到“方”、或者看到正方形和听到“方”同时呈现时,按J键。在整个实验过程中,要求被试双眼注视屏幕正中央,既快又准确地做出反应。实验流程见图1。

图 1 实验流程示意图

根据线索的要求,实验包含以下10种试次类型:注意视觉-单通道视觉目标;注意视觉-语义一致双通道目标中的视觉成分;注意视觉-语义不一致双通道目标中的视觉成分;注意听觉-单通道听觉目标;注意听觉-语义一致双通道目标中的听觉成分;注意听觉-语义不一致双通道目标中的听觉成分;注意视听-单通道视觉目标;注意视听-单通道听觉目标;注意视听-语义一致的双通道目标;注意视听-语义不一致的双通道目标。其中,当线索为“请注意看”、“请注意听”时,该试次为注意单通道条件,即选择性注意条件;当线索为“请注意看和听”时,该试次为注意双通道条件,即分配性注意条件。

实验采用2(注意条件:分配性注意、选择性注意)×3(目标刺激类型:单通道视觉目标、单通道听觉目标、双通道目标)的被试内设计。实验中,每个试次持续约5 s。实验共有330个试次,整个实验约持续28分钟。在正式实验之前有36个试次作为练习部分。在正式实验中每60个试次可进行短暂休息,被试按空格键可以继续进行实验。

3 结果

对数据进行初步处理:删除了反应错误的以及反应时小于200 ms和大于1000 ms的数据,还删除了反应时超出平均反应时3个标准差的数据。初步处理后删除的数据约占总数据的5.64%。所有被试的数据均有效。

表1呈现了被试在两种注意条件下对四种不同类型目标的反应正确率和反应时。在正确率方面,首先对视听语义一致目标与单通道目标进行重复测量方差分析。结果发现,无任何显著效应,ps>0.05。对于视听语义不一致目标与单通道目标的重复测量方差分析发现,目标通道主效应显著,F(2, 50)=23.05,p<0.001,η2=0.48。事后比较发现,被试对视听语义不一致目标的反应正确率最低,而对其他两种目标的反应正确率无显著差异。

表 1 不同注意条件下的正确率和反应时

在反应时方面,将视听语义一致目标与单通道目标进行重复测量方差分析,结果发现,目标通道主效应显著,F(2, 50)=29.94,p<0.001,η2=0.55;注意条件与目标通道交互作用显著(见图2),F(2, 50)=31.62,p<0.001,η2=0.56。进一步分析发现,在分配性注意条件下,被试对语义一致的双通道目标的反应时显著短于对单通道视觉目标和单通道听觉目标的反应时,单通道视觉目标的反应时显著短于单通道听觉目标的反应时,ps<0.001。即,被试对语义一致的双通道目标反应最快,产生冗余信号效应,而对单通道听觉目标刺激的反应最慢。在选择性注意条件下,被试对单通道视觉目标的反应时显著小于对语义一致的双通道目标的反应时,p<0.05,和单通道听觉目标的反应时,p<0.05;双通道目标与单通道听觉目标的反应时之间无显著差异,p>0.05。

将语义不一致的双通道目标反应时与单通道目标反应时进行重复测量方差分析。结果发现,注意条件主效应显著,F(1, 25)=30.04,p<0.001,η2=0.55,被试在分配性注意条件(475±12)下的反应时显著长于在选择性注意条件(452±12)下的反应时。目标通道主效应显著,F(2, 50)=14.82,p<0.001,η2=0.37。事后比较发现,被试对单通道视觉目标的反应时(449±12)显著短于对语义不一致的双通道目标(464±13),p<0.01,和单通道听觉目标反应时(478±13),p<0.001,语义不一致的双通道目标反应时显著短于对单通道听觉目标反应时,p<0.05。注意条件与目标通道交互作用不显著,p>0.05。上述结果表明,被试对语义不一致的双通道目标的反应不具有加工优势。

图 2 不同注意条件下对三种类型目标的反应时

有研究者针对冗余信号效应做出了解释。Raab(1962)提出的竞争模型(the race model)认为,在个体加工多通道刺激时,这些不同通道的刺激被分别加工,对多通道刺激的加工优势(即冗余信号效应)来自于统计便利:不同通道刺激之间相互竞争,最先完成加工的通道优先触发被试的反应。这就类似于掷骰子,掷两个骰子得到一个6点的几率要大于掷一个骰子得到一个6点的几率(刘强, 2010)。而共同激活模型(the coactivation model)认为不同通道的信息均被激活,它们在某些特定时间点上融合为统一的知觉信息,共同作用于随后的加工,因此产生了冗余信号效应(Miller, 1982, 1986)。针对这两种模型,Miller(1982)提出了竞争模型不等式。不等式的左边代表在任意给定时间t内个体对同时呈现的双通道刺激反应的概率值,右边代表竞争模型预测值。这一不等式的含义是:在任意给定时间点上,如果个体对多通道刺激的反应概率显著大于竞争模型预测值,那么对多通道刺激的反应偏离竞争模型,这就表明组成多通道刺激的两个单通道刺激之间产生了神经上的融合,因此导致了冗余信号效应。

由于只有在分配性注意条件下表现出冗余信号效应,因此本研究只对分配性注意条件下的数据进行竞争模型分析(见图3)。首先计算反应时的累积分布函数:单通道视觉P(RT<t|V),单通道听觉P(RT<t|A),语义一致的多通道P(RT<t|AV语义一致)。根据已有研究(Raab,1962)计算出竞争模型预测值[P(RTv<t)+P(RTa<t)]-[P(RTv<t)×P(RTa<t)]。为考察在反应时数据上表现出的冗余信号效应是否源自语义一致双通道目标的多感觉整合,将实验值和竞争模型预测值进行比较,即在每10%的时间点上将语义一致的多通道P(RT<t|AV语义一致)与竞争模型预测值进行配对t检验。结果发现,在340 ms至410 ms之间,语义一致的多通道P(RT<t|AV语义一致)显著大于竞争模型预测值(340 ms,t(25)=2.69,p=0.01;350 ms,t(25)=3.00,p=0.01;360 ms,t(25)=3.68,p=0.001;370 ms,t(25)=3.18,p=0.004;380 ms,t(25)=2.78,p=0.01;390 ms,t(25)=2.42,p=0.02;400 ms,t(25)=2.18,p=0.04;410 ms,t(25)=2.19,p=0.04),此结果符合共激活模型。这表明,本实验中出现的冗余信号效应来自于语义一致双通道目标的视觉和听觉成分的整合。

图 3 分配性注意条件反应时的竞争模型分析图

4 讨论

通过线索刺激将注意指向不同感觉通道,以简单图形作为视觉刺激,以人声读出的单字词作为听觉刺激,使视觉和听觉刺激之间形成一定的语义联结,考察了被试在注意不同通道时,语义一致和不一致视听刺激的整合加工是否存在差异。结果发现,在反应时方面,分配性注意条件下,被试对语义一致的双通道刺激的反应最快,即,在语义一致的视听刺激上产生了冗余信号效应。通过竞争模型分析发现,这种冗余信号效应源自于语义一致的双通道刺激中视觉和听觉成分产生的整合。而在选择性注意条件下,被试对视觉目标的反应时最短,语义一致的双通道目标并不具有加工优势。另一方面,对于语义不一致的双通道刺激,在分配性注意条件下的反应时长于在选择性注意条件下的反应时;同时,被试对单通道视觉目标的反应时最短,其次是语义不一致的双通道目标,单通道听觉目标的反应时最长。也就是说,对于语义不一致的双通道刺激,即使其视觉和听觉成分同时呈现,仍没有表现出冗余信号效应,表明双通道刺激的视觉和听觉成分之间的语义不一致可能会阻碍二者的整合加工。

已有研究发现,当个体选择性注意于一个感觉通道时,被忽略通道所在皮层的活性会被抑制(Haxby et al., 1994; Kawashima, O’Sullivan, &Roland, 1995; Laurienti et al., 2002; Johnson &Zatorre, 2005, 2006),从而导致在被忽视的皮层中,能够用于产生多感觉整合的刺激信息减少,因此与同时注意两个通道相比,选择性注意于一个通道难以产生视听整合。同时,有研究者认为,大脑在处理信息时,倾向于将内容上匹配的刺激当作源自于相同资源处理,这样更有益于脑将其整合成统一的知觉(Su, 2014)。一些以视听语义知觉作为考察对象的研究结果与这种视听语义一致信息的加工优势基本一致。比如,有研究发现,与视听不匹配的刺激对相比,当被试听到的声音与看到的面孔在性别上一致(Vatakis &Spence, 2007),或者当被试听到的词语与看到的嘴唇运动相一致时,双通道刺激均被优先整合(van Wassenhove et al., 2007; Ten Oever et al., 2013)。由此可见,视听刺激之间的匹配(如语义一致)对于双通道信息的整合加工有一定的促进作用。这就很好地解释了本研究中只有在同时注意两个通道(分配性注意)时,语义一致的双通道刺激才会产生整合。

在正确率方面,实验结果发现被试对视听语义不一致的双通道目标的反应正确率最低,这表明,被试对语义不一致的双通道目标反应最为困难。预测编码模型(predictive coding model)认为,脑会产生对环境的贝叶斯估计(Friston,2010),因而可能存在对环境估计的随机模型。这些模型基于当下个体加工的感觉信息进行不断更新。这些随机模型能用来调整对当前感觉输入的预测。如果在预测和实际感觉输入之间存在强烈的不匹配,可能会导致内部模型更大的更新。从这个角度看,当输入的视听刺激之间存在不一致甚至冲突的语义联结时,大脑的预测与实际输入之间的较大差别可能导致内部模型的较大更新,因此造成对此类信息的加工更为困难(Talsma,2015),表现为对视听语义不一致信息的反应正确率降低。

综上所述,本研究采用具有语义联结的视听刺激作为实验材料,考察了注意对视听语义整合加工的影响。在发现只有分配性注意条件下才能产生冗余信号效应的同时,针对此效应的实质进行了竞争模型分析,发现这种效应的确来源于语义一致的视听刺激之间的整合。而语义不一致的视听刺激尽管同时呈现,但是并没有产生整合。这表明,与视听刺激之间的语义不一致相比,视听刺激之间的语义一致能够促进其整合加工。但是,注意对视听语义整合加工的影响是否具有稳定性?或者说是否存在其他对二者关系的调节因素?这些调节因素又是怎样对二者关系产生影响?这些问题均有待于未来研究给出答案。

5 结论

本实验条件得出如下结论:(1)在同时注意视觉和听觉通道(分配性注意)时,对语义一致的双通道目标加工最快,即产生冗余信号效应,并且这种效应源自于语义一致的双通道目标中视觉和听觉成分的整合;选择性注意于一个感觉通道时没有产生视听刺激的整合;(2)无论选择性注意还是分配性注意条件,语义不一致的双通道目标中的视觉和听觉成分均没有产生整合。

刘强.(2010). 多感觉整合脑机制研究 (博士学位论文). 西南大学.

孙远路, 胡中华, 张瑞玲, 寻茫茫, 刘强, 张庆林.(2011). 多感觉整合测量范式中存在的影响因素探讨. 心理学报, 43(11), 1239–1246.

Frassinetti, F., Bolognini, N., & Làdavas, E.(2002). Enhancement of visual perception by crossmodal visuo-auditory interaction. Experimental Brain Research, 147, 332–343.

Friston, K.(2010). The free-energy principle: A unified brain theory?.Nature Reviews Neuroscience, 11(2), 127–138.

Haxby, J. V., Horwitz, B., Ungerleider, L. G., Maisog, J. M., Pietrini, P., &Grady, C. L.(1994). The functional organization of human extrastriate cortex: A PET-rCBF study of selective attention to faces and locations.Journal of Neuroscience, 14(11), 6336–6353.

Johnson, J. A., & Zatorre, R. J.(2005). Attention to simultaneous unrelated auditory and visual events: Behavioral and neural correlates. Cerebral Cortex, 15(10), 1609–1620.

Johnson, J. A., & Zatorre, R. J.(2006). Neural substrates for dividing and focusing attention between simultaneous auditory and visual events.NeuroImage, 31(4), 1673–1681.

Kawashima, R., O’Sullivan, B. T., & Roland, P. E.(1995). Positronemission tomography studies of cross-modality inhibition in selective attentional tasks: Closing the “mind’s eye”. Proceedings of the National Academy of Sciences of the United States of America, 92(13),5969–5972.

Koelewijn, T., Bronkhorst, A., & Theeuwes, J.(2010). Attention and the multiple stages of multisensory integration: A review of audiovisual studies. Acta Psychologica, 134(3), 372–384.

Laurienti, P. J., Burdette, J. H., Wallace, M. T., Yen, Y. F., Field, A. S., &Stein, B. E.(2002). Deactivation of sensory-specific cortex by crossmodal stimuli. Journal of Cognitive Neuroscience, 14(3), 420–429.

Laurienti, P. J., Kraft, R. A., Maldjian, J. A., Burdette, J. H., & Wallace, M.T.(2004). Semantic congruence is a critical factor in multisensory behavioral performance. Experimental Brain Research, 158(4),405–414.

Lovelace, C. T., Stein, B. E., & Wallace, M. T.(2003). An irrelevant light enhances auditory detection in humans: A psychophysical analysis of multisensory integration in stimulus detection. Cognitive Brain Research, 17(2), 447–453.

Miller, J.(1982). Divided attention: Evidence for coactivation with redundant signals. Cognitive Psychology, 14(2), 247–279.

Miller, J.(1986). Timecourse of coactivation in bimodal divided attention.Perception & Psychophysics, 40(5), 331–343.

Mittag, M., Alho, K., Takegata, R., Makkonen, T., & Kujala, T.(2013).Audiovisual attention boosts letter-speech sound integration.Psychophysiology, 50(10), 1034–1044.

Raab, D. H.(1962). Statistical facilitation of simple reaction times.Transactions of the New York Academy of Sciences, 24, 574–590.

Su, Y. H.(2014). Content congruency and its interplay with temporal synchrony modulate integration between rhythmic audiovisual streams.Frontiers in Integrative Neuroscience, 8, 92.

Talsma, D.(2015). Predictive coding and multisensory integration: An attentional account of the multisensory mind. Frontiers in Integrative Neuroscience, 9, 19.

Talsma, D., Senkowski, D., Soto-Faraco, S., & Woldorff, M. G.(2010). The multifaceted interplay between attention and multisensory integration.Trends in Cognitive Sciences, 14(9), 400–410.

Talsma, D., & Woldorff, M. G.(2005). Selective attention and multisensory integration: Multiple phases of effects on the evoked brain activity.Journal of Cognitive Neuroscience, 17(7), 1098–1114.

Ten Oever, S., Sack, A. T., Wheat, K. L., Bien, N., & van Atteveldt,N.(2013). Audio-visual onset differences are used to determine syllable identity for ambiguous audio-visual stimulus pairs. Frontiers in Psychology, 4, 331.

van Wassenhove, V., Grant, K. W., & Poeppel, D.(2007). Temporal window of integration in auditory-visual speech perception. Neuropsychologia,45, 598–607.

Vatakis, A., & Spence, C.(2007). Crossmodal binding: Evaluating the “unity assumption” using audiovisual speech stimuli. Perception &Psychophysics, 69(5), 744–756.

The Effect of Attention on Audiovisual Speech Integration

LYU Yong, GU Jiyou

(Academy of Psychology and Behavior, Tianjin Normal University, Key Research Base of Humanities and Social Sciences of the Ministry of Education, Tianjin 300074)

The present research used the square and the triangle as visual stimuli and spoken words as auditory stimuli to investigate the effect of attention on multisensory speech integration. The visual and auditory stimuli were semantically congruent or incongruent.The results from a discrimination task showed that: 1) In the condition of divided attention, participants required less time to react to audiovisual semantic-congruent targets than other types of targets; that is the redundant signal effect; 2) According to the race model,the redundant signal effect in the condition of divided attention originated from the multisensory integration. To conclude, the multisensory integration occurred when the attention was divided between visual and auditory modality only in the semanticcongruent audiovisual stimuli.

attention, multisensory integration, semantic congruence, race model.

B842.1

2016–3–29

天津市高等学校“心理健康与行为调控创新团队(39)”。

吕 勇,E-mail: ly6312@163.com。