一种结合视觉显著性的GrabCut图像分割方法

高智勇,刘垚玲

(中南民族大学 生物医学工程学院,武汉 430074)

一种结合视觉显著性的GrabCut图像分割方法

高智勇,刘垚玲

(中南民族大学 生物医学工程学院,武汉 430074)

结合显著区域检测技术和GrabCut算法,提出了一种新的图像分割方法.首先,计算融合中心知识和目标紧致度的多尺度区域对比度,通过Harris特征信息和贝叶斯模型进一步提高显著性,得到更加精确的前景检测模型;然后,对显著图进行分割获得目标的粗略位置,将位置信息用于GrabCut算法初始化,并在GrabCut初始化建模中引入显著值权重;最后,结合形态学运算改进分割的目标.实验结果表明:该方法能够实现自动分割,并且取得了接近甚至优于一些GrabCut方法的结果.

显著性;GrabCut算法;图像分割

近年来,国内外学者对改进GrabCut[1]算法的性能开展了大量的研究.Pourjam等[2]通过ASM[3]训练模型得到目标的初始轮廓位置,但分割结果依赖于训练模型的有效性.文献[4]用EM算法[5]求解高斯混合模型,但EM算法中初始参数的选择影响分割结果.文献[6]结合Gabor滤波算法和显著图初始化GrabCut,由于目标位置和Gabor滤波器分类数目紧密相关,对于背景复杂图像难以达到精确的分割效果.程明明等[7]提出了一种新的显著性目标分割方法,将固定阈值化后的显著图替代GrabCut的交互过程,并通过迭代运行GrabCut分割算法逐步改善显著目标分割结果.该方法对所有图像采用统一固定阈值,降低了自适应性能,同时会导致某些图像中目标分割不准确.文献[8]结合显著图和图像特征信息计算星凸中心点,并用Graph cuts来分割目标,但星凸中心点的数目和位置的准确性对分割结果影响很大,所以星凸中心点的位置和数目选取成了研究的难点.针对文献[7,8]中的不足与优势,本文提出了一种结合显著性模型和显著权值改进的GrabCut算法,以期得到更加精确的分割结果.

1 结合显著性和GrabCut的图像分割算法

本文提出的算法流程如图1所示.首先,利用多尺度的超像素方法计算区域对比度,接着计算图像的Harris特征点[9]下的最小凸包,在最小凸包条件下基于贝叶斯方法得到显著图,然后,结合阈值分割和形态学方法得到GrabCut的外围掩膜,最后,利用外围掩模和显著信息改进GrabCut算法来分割目标.

图1 算法流程图Fig. 1 Algorithm flow chart

1.1 显著性计算

现有的大多数显著性计算方法主要基于以下3个准则:和邻域像素对比度越大的超像素显著值越大,临近图像中心位置的超像素更有可能成为显著目标,靠近图像边界处的大量像素点属于背景的可能性更大.本文基于以上度量机制计算显著图.为了对图像中的显著目标进行更精确的检测,对文献[7]中的算法做了如下改进:采用多尺度的超像素方法计算区域对比度,结合贝叶斯模型和图像特征信息进一步优化区域对比度,具体的计算步骤如下.

首先,计算区域对比度.通过设置M个SLIC[10]算法中控制分割区域数目的参数K可以得到不同尺寸的区域,假定图像I被分割成n个区域.对于图像中的区域,其局部区域对比度计算见公式(1):

(1)

(2)

其中,x和y是区域的中心点坐标位置,x0和y0定义为输入图像的中心点位置坐标,δx,δy的值为输入图像宽度和高度的1/3.

其次,计算整体一致度.观察发现靠近图像边界处的大量像素点属于背景的可能性更大,加入目标整体性权值检测出的目标更具完整性,整体一致度定义见公式(3):

(3)

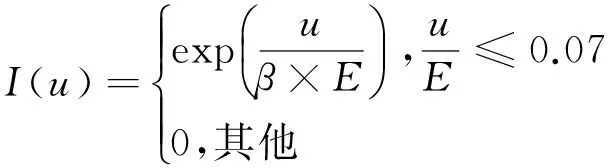

其中,u为区域ri的边界像素点数目,E是图像边界像素点总数目,β为调节权重因子,取值为0.1.综合上述,基于整体一致性约束的得显著图计算如公式(4):

(4)

再次,结合贝叶斯模型改进显著值.通过Harris检测算法定位到目标的大致几何位置,根据文献[11]的计算模型得到显著值计算公式(5):

(5)

p(B)=1-p(O),

(6)

其中,p(B)和p(O)分别为Harris特征点检测得到的最小凸包在公式(4)下的显著值.

最后,计算多尺度融合显著图.得到各个图像区域的显著值之后,需要将显著值重新分配到每个像素点,得到完全分辨率的显著图.M个尺度下的融合权重为不同尺度下各像素点与当前超像素单元的颜色距离值.公式(7)为多尺度融合后的最终显著图:

(7)

其中,x为图像I中的像素,Z为权值w的归一化参数,hi为尺度i下图像显著值,wi为尺度i下的权值,S为最终计算所得的显著图.

1.2 结合显著性的GrabCut图像分割

GrabCut通过迭代GMM和Graph cuts来改进每一次的分割结果.利用阈值分割和形态学方法对上文1.1节计算的显著图处理,得到前景区域和背景区域的标记信息.将标记信息替代GrabCut算法的交互输入,同时,结合1.1节得到的显著图信息,改进GrabCut的能量函数形式,得到更加精确的分割结果.

1.2.1 前景和背景种子区域标记

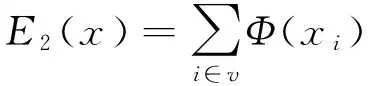

上文中得到的显著图如图2(e)所示,图中每个像素的灰度值代表了该像素引起观察者注意的能力,值越大表明该像素越有可能是感兴趣区域.假定f(x,y)为显著图,g(x,y)为二值图,根据分割阈值T得到二值标记图的计算如公式(8):

(8)

Otsu[12]通过计算最大类间方差来自动确定阈值,具有简单、处理快速的优点,本文使用该方法计算T.为了去除显著物体周围不确定的像素,结合形态学运算改善阈值分割结果.从图2(d)可知,经阈值分割所得的显著物体是标准分割的近似,不能精确地获取分割目标,需要结合GrabCut算法进一步分割得到更加精确的目标.将显著图阈值分割后的图分别腐蚀和膨胀得到一个如图2(e)的三元标记图,基于三元标记图初始化GrabCut算法.

1.2.2 改进能量函数的GrabCut图像分割算法

GrabCut算法将图像的背景区域标记为T_B,未知区域标记为T_U,其中T_U是需要进一步分割的区域.根据T_U和T_B分别创建前景和背景的GMM模型,并在迭代过程中不断更新GMM模型及其参数,利用最后一次迭代的GMM模型构建能量函数E,此基础上分割目标.对于图像I,定义向量x={x1,x2,…,xi,xn},其中xi为每个像素的颜色值,基于吉布斯能量得到计算公式(9):

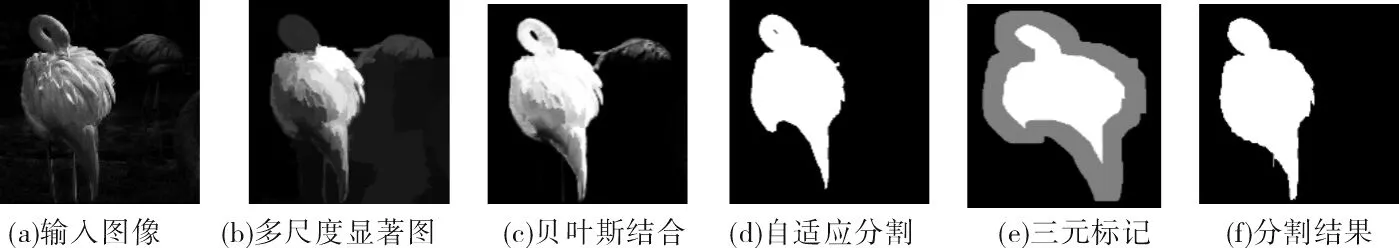

(9)

其中,φ(xi)是区域项能量,由像素点的颜色分布模型计算得到,v是图像I的像素点映射到图中的顶点集合;φ(xi,xj)为边界约束项能量,通过计算颜色空间的欧氏距离得到,N是图像I中邻域像素对在图中的边集.根据上文1.2.1节的三元标记计算前景和背景的高斯混合模型,并建立图模型,通过公式(9)得到相应的吉布斯能量,当吉布斯能量达到最小时,根据输入图像和网络图的映射关系,可以将图像分割问题转化为二元划分问题,用最大流/最小割算法计算最优分割结果.

GrabCut对于前景和背景颜色具有重叠情况的分割效果较差,为了解决这个问题,本文将显著图计算中的先验信息融合到能量函数中,提高分割的精度.改进的能量函数计算如公式(10):

(10)

其中,Φ(xi)为归一化后的显著值,由公式(6)计算所得,φ(xi)为区域项能量方程,φ(xi,xj)为边界约束项能量,同公式(9).

改进后的能量函数能够指导算法迭代,使得分割的目标区域更加精确.为了解决分割目标完整性的问题,在每一次迭代之后,将当前分割出的目标进行膨胀和腐蚀处理得到新的三元图进行下一次迭代.图2是结合视觉显著性分割的步骤效果图,其中,图2(b)是基于多尺度区域计算的结果,图2(c)是融合贝叶斯模型改进的显著图,图2(d)和图2(e)是1.2.1节中的效果图.

图2 结合视觉显著性的图像分割Fig.2 Image segmentation combined with saliency

2 实验结果与分析

实验在Lenovo E430 Core 2.5 GHz,4 GB RAM的计算机上完成,实验环境为Matlab- R2012b和VS2012.实验中的自然图像数据库来自于MSRA-1000[13],该数据集中图像包含种类多样变化的目标,且给出了真实的人工标注值,便于主观和客观评价算法的性能.

2.1 算法性能分析

2.1.1 多尺度与单尺度分割

采用多尺度的显著图可获取更加丰富的目标信息,避免单尺度下显著区域部分缺失导致无法分割出完整目标.在数据集上选取了一些图片进行单尺度和多尺度实验,部分效果如图3所示.图3(b)RC显著图和图3(c)RC分割图是文献[7]中的显著图及其分割效果图,用于对比.从图3可以看出融合多尺度的显著图分割(MSRC分割图)效果要优于单一尺度下的(RC分割效果图).考虑到计算速度和显著图质量,尺度数目M取值为5.

2.1.2 固定阈值与自适应阈值分割

不同的物体在不同图像中的灰度、形状等有着显著差异,固定阈值分割显著图进,对某些图像或者物体效果不好.如图4所示.同时,显著图分割结果作为GrabCut的输入时,初始的三元区域标记影响高斯建模参数的计算,对分割结果影响很大.采用形态学方法进行处理后,能够得到较好的标记结果.自适应阈值分割能够获得更加精确的结果,而固定阈值分割可能将部分背景区域误选入三元标记图的前景区域,使得分割结果中部分背景区域被分为目标.图4第二行图中的旗帜在固定阈值分割下,分割出的前景部分缺失比较严重.GrabCut图像分割算法中,三元标记图计算过程中膨胀和腐蚀结构元素半径取值为15个像素宽.图5是图4分割过程中多次迭代的三元标记的中间效果图,其中图5(b)的二值图由公式(8)所得.

图3 多尺度和单尺度显著值图像分割效果图Fig.3 Results of multi-scale and single scale segementation in saliency map

图4 固定阈值和自适应阈值分割效果图Fig.4 Results of fixed threshold and adaptive threshold segmentation

图 5 多次迭代三元标记效果图(三元图中灰色部分为未知区域,黑色为固定背景,白色为固定前景)Fig.5 Results of multi iterations trimap(gray as unknown region,black as fixed backgruond,white as foreground)

2.1.3 改进能量函数的分割

当场景中的背景和目标颜色相似时,GrabCut分割效果较差.结合显著图,对区域能量和边界能量函数进行优化,可以更好地分离区域和边界,提高分割效果.从图6(b)可以看出,当场景中背景和目标颜色相似时,融合显著值改进的能量函数能够分割出更加精确的目标,图6中分割出的青蛙和人工标注图接近.从其他几组图也可以看出,融合显著值的能量函数可以提高GrabCut算法中高斯模型参数的精确度,得到更加符合输入图像的前景和背景描述模型,进一步完善分割效果.在图6 (f)图中,改进的能量函数并未分割出符合人眼视觉的目标,是由于显著图计算导致GrabCut能量函数的区域项能量和目标描述度不一致产生的.

通过对比多尺度与单尺度,自适应阈值和固定阈值以及融合显著值改进能量函数的实验效果分析,在改进的显著图基础上采用自适应阈值初始化的GrabCut改进算法能够取得相对较优的性能.

图6 改进能量函数分割效果图(第一行为输入图像,第二行原始能量函数分割效果图,第三行为改进能量函数分割效果图)Fig.6 Results of improved energy function(first row as input,second row original energy function,third row improved function)

2.2 与其他算法比较

将本文方法(简称为MBSGC)分别与文献[7]RCC算法、文献[8]SRAPC算法进行量化比较和分析.图7为实验数据库中选取的具有代表性的分割效果图.

图 7 3种方法的图像分割结果(从上到下为输入图像,文献[8]SRAPC分割,文献[7]RCC分割,改进MBSGC分割,金标准图) Fig.7 Results of three methods(SRAPC segmentation, RCC segmentation, improved MBSGC segmentation, ground truth)

从图7可以看出本文MBSGC方法在三种方法中效果最好,文[7]中RCC方法虽然能快速实现GrabCut自动分割,但是由于采用固定阈值分割显著图,当目标颜色差异较大且由多个部分组成或存在多目标时,会导致检测结果不完整.如图7(b) 和图7(c)所示.此外,当目标与背景颜色相似时,检测结果与实际结果差异较大.文[8]中SRAPC方法采用星形先验知识进行分割,能够取得较好的分割效果.但在背景较为复杂时,聚类点难以准确确定,导致检测效果较差,如图7(e)所示.本文结合多尺度超像素和贝叶斯模型计算显著图能够得到更精确的目标位置信息,同时,自适应阈值形和态学运算得到的三元图标记比文[7]中RCC固定阈值化的标记结果更准确,但是对于比较复杂的目标,本文方法也会失效.如图7(f)所示,3种方法都能分割出较为准确的目标,但是与金标准图中的显著目标完全不一致,这主要与显著目标的任务和主观选择有关,需要进一步进行关于注意焦点的研究.

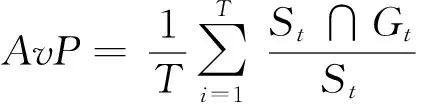

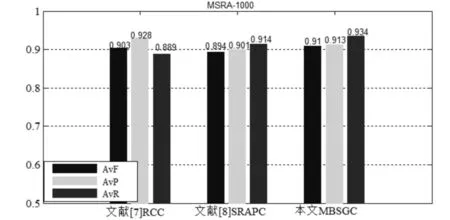

为了客观地评价算法的性能,本文采用三个评价指标来衡量分割效果.评价指标为:AvP、AvR、AvF,计算结果为百分比,公式如下:

(11)

(12)

(13)

其中,T是数据集中总的图像数目,St和Gt分别为数据集中t对应的分割图和金标准图,Pt和Rt分别为t的precison和recall值,参数β用来调节precison和recall的权值,本文取值为0.3.图8是3种方法在MSRA-1000数据集上的性能指标对比图.

图 8 3种法在MSRA-1000数据集上的AvF,AvP,AvR值Fig. 8 AvF,AvP,AvR values in MSRA-1000 Data set of three methods

对于三种量化标准指数,AvF为综合评价系数值,值越大,算法的分割效果越好.从图8可以看出,尽管本文MBSGC方法的AvP值略低于文[7]RCC,但其他指标值均为最优.本文算法的AvP准确率虽然略低于文[7]RCC,但从图7结果来看,在分割目标的完整性上有一定的优势.而文[8]SRAPC方法则需要保证标记的星形中心点络在目标内部才能得到准确的分割结果.

本文方法相比RCC方法更具适用性,SRAPC需要获取相应的星形中心标记点,复杂背景下难以保证准确性.本文算法在保证计算效率的同时,也能获得较为精确的分割结果,同时也实现了自动分割目标.

3 结语

本文对结合显著性的GrabCut图像分割算法展开了研究,针对现有的显著目标分割中的自适应性阈值和先验中心难以确定等问题,提出了一种结合多尺度超像素和贝叶斯模型的显著图改进 GrabCut的自动标记和能量函数的方法.该方法不仅能够实现自动分割图像中的目标,还同时保证了计算效率,且对于前景和背景颜色相似时图像分割效果也较好,但对于背景比较复杂的图像,分割效果不理想.在以后的研究工作中,将考虑结合自顶向下的显著模型计算和目标的形状信息,实现多目标的分割.

[1] Rother C, Kolmogorov V, Blake A. Grabcut: interactive foreground extraction using iterated graph cuts[J]. ACM Transactions on Graphics, 2004, 23(3): 309-314.

[2] Pourjam E, Ide I, Deguchi D, et al. Segmentation of human instances using grab-cut and active shape model feedback[C]//MVA. IAPR International Conference on Machine Vision Applications. Kyoto:MVA,2013:77-80.

[3] Cootes T F, Edwards G J, Taylor C J. Active appearance models[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2001, 23(6): 681-685.

[4] LI X, LI Y, QI Y. Automatic grabcut color image segmentation based on EM algorithm[C]//CMCEE. The 4th International Conference on Computer, Mechatronics, Control and Electronic Engineering. Hangzhou:CMCEE,2015:6-11.

[5] Moon T K. The expectation-maximization algorithm[J]. IEEE Signal Processing Magazine, 1996, 13(6): 47-60.

[6] Na I S, Oh K H, Kim S H. Unconstrained object segmentation using grabcut based on automatic generation of initial boundary[J]. International Journal of Contents, 2013, 9(1): 6-10.

[7] Cheng M M, Mitra N J, Huang X, et al. Global contrast based salient region detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 569-582.

[8] Liao X, Xu H, Zhou Y, et al. Automatic image segmentation using salient key point extraction and star shape prior[J]. Signal Processing, 2014, 105: 122-136.

[9] Harris C. A combined corner and edge detector[J]. Proc Alvey Vision Conf, 1988, 1988(3):147-151.

[10] Achanta R, Shaji A, Smith K, et al. SLIC superpixels compared to state-of-the-art superpixel methods[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(11): 2274-2282.

[11] Xie Y, Lu H. Visual saliency detection based on Bayesian model[C]// IEEE. The 18th IEEE International Conference on Image Processing. Brussels, Belgium:IEEE, 2011: 645-648.

[12] Wang Y Q, Zhuang L L, Shi C X. Construction research on multi-threshold segmentation based on improved otsu threshold method[J]. Advanced Materials Research, 2014, 1046:425-428.

[13] Achanta R, Hemami S, Estrada F, et al. Frequency-tuned salient region detection[C]// IEEE.International Conference on Computer Vision and Pattern Recognition. Miami:IEEE, 2009:1597-1604.

A Method of Image Segmentation Combined Visual Saliency and GrabCut

GaoZhiyong,LiuYaoling

(College of Biomedical Engineering, South-Central University for Nationalities, Wuhan 430074, China)

This paper presented a new segmentation method based on GrabCut combined with saliency detection. Firstly, saliency map is calculated by multi-scale regional contrast fused with center knowledge and target compactness. Meanwhile, Harris key point detection and Bayesian method can be used to improve the accuracy of the saliency map. Secondly, coarse segmentation is implemented to locate the position of object which is passed into GrabCut as the initial trimap. And the energy function which calculated by the gaussian mixture models of foreground and background is improved with saliency map. Finally, morphological operation is used to get the final result. Experiment results show that this method can achieve automatic segmentation and performance close to or even better than some existing methods.

saliency; GrabCut; image segmentation

2016-12-23

高智勇(1972-),男,教授,博士,研究方向:图像处理与识别,E-mail:zhiyonggao@mail.scuec.edu.cn

湖北省自然科学基金资助项目(2014CFB922);中央高校基本科研业务费资助项目(CZW15121)

TP391.41

A

1672-4321(2017)02-0079-06