复杂光照环境下的车辆检测方法

裴明涛, 沈家峻, 杨敏, 贾云得

(北京理工大学 计算机学院, 智能信息技术北京市重点实验室,北京 100081)

复杂光照环境下的车辆检测方法

裴明涛, 沈家峻, 杨敏, 贾云得

(北京理工大学 计算机学院, 智能信息技术北京市重点实验室,北京 100081)

提出一种用于复杂光照环境下的车辆检测方法,该方法在传统的假设验证框架下充分利用了先验知识和复杂光照背景下的车辆特征. 在假设生成阶段,利用车辆边缘信息与车辆前部形状特征进行拟合来生成假设;在假设验证阶段,使用HOG特征作为描述子,结合SVM分类器完成假设车辆目标的验证识别. 实验结果表明在复杂的光照环境中,本文方法能够有效检测出传统方法无法检测的目标,是对正常光照环境下车辆检测方法的有效补充.

车辆检测;假设验证框架;复杂光照

车辆检测是计算机视觉领域的重要研究内容. 目前有很多成熟的算法被提出,许多算法利用阴影[1]、颜色[2]、对称性[3]等特征进行车辆检测,但在复杂的光照环境下有较高的漏检率. 在利用车辆边缘信息的方法中,Sun等[4]提出一种多尺度3级分辨率的假设产生方法,对3级不同分辨率的图像分别提取垂直和水平边缘,再生成垂直与水平边缘直方图,根据边缘直方图的波峰分布确定车辆假设的区域. 然而这种方法在车辆一侧光照较强的环境中由于光照的干扰导致另一侧的边缘信息丢失严重,无法形成完整的垂直与水平边缘组合,从而使车辆目标在假设生成阶段被排除掉. 另外一种效果较好的车辆检测方法主要是利用车辆的纹理特征[5],但是这种方法对于车辆表面的信息的完整性具有较高的依赖,在实际路面图像采集过程中由于光照环境的变化很难保证图像中车辆的表面信息始终完整. 在一些复杂的光照环境中,由于光线在车辆表面的反射会使得车辆表面模糊一片,很难提取纹理特征,因此产生大量的漏检.

复杂光照环境一般包括车辆两侧的光照不均,车辆的顺光与逆光以及光照强度短时间内剧烈变化等情况. 目前关于复杂光照环境中的车辆目标检测研究较少. 本文主要研究复杂光照环境中车辆检测问题,分析复杂光照环境中车辆特征信息,包括车辆与路面之间的边界信息和车辆前部形状特征信息等,并基于假设验证框架[6],建立了一种基于边缘提取的车辆检测方法.

基于假设验证的车辆检测流程如图1所示. 该框架分为两个步骤:①假设生成,在图像中生成一些可能是车辆的假设区域;②假设验证,通过测试验证确认假设生成的区域中是否真的存在车辆.

图1 基于假设验证框架的车辆检测流程

Fig.1 Flowchart of hypothesis-verification structure

1 车辆假设的生成

在车辆假设的生成过程中,先进行图像预处理,提高图像质量;然后利用LoG(Laplace of Gaussian)边缘检测算法对图像进行边缘检测并二值化边缘图;再根据车辆的前部形状特征进行拟合,并根据拟合度确定候选区域.

1.1 图像的预处理

车辆检测的数据多从道路监控拍摄的视频中获取,但从源视频中取得的视频图像数据并不能直接用于目标检测,在进行车辆目标假设区域的生成操作之前需要进行预处理.

摄像机系统在成像过程中必然会受到光照、天气、传感器以及系统非线性、目标快速移动等复杂因素的影响而产生噪声干扰,降低图像的质量并影响车辆的检测,因此在车辆检测之前需要对图像进行平滑去噪. 本文对原始彩色图像进行的预处理分为灰度化处理和平滑处理两步. 彩色图像先采用加权平均法对RGB3个分量进行计算得到较为合理的灰度图像,然后对灰度图像进行高斯滤波去除噪声的干扰,得到较为平滑的图像.

经过图像的预处理,原始视频数据转化为灰度图像数据,并减少或过滤了图像的噪声干扰,增强图像的有用信息,为目标的检测创造了良好条件.

1.2 LoG边缘检测

在光照环境较为复杂的情况下,车辆表面的信息丢失较为严重,但是车辆与路面的边界区分依然明显,因此本文在假设区域生成的过程中充分利用这一特点,为得到完整的边缘图像,用LoG边缘检测算子对图像进行边缘检测.

LoG算子即高斯-拉普拉斯算子,基本思想是首先对原始图像进行最佳平滑处理, 最大程度地抑制噪声, 再对平滑后的图像求取边缘.

高斯-拉普拉斯算子使用的低通滤波器是二维高斯滤波器,其基本函数为

(1)

图像通过低通滤波即平滑处理可以实现对噪声最大程度的抑制. 平滑后的图像通过拉普拉斯算子2计算二阶导数进行增强.

对图像的高斯平滑滤波和拉普拉斯微分运算两步可以合并成一个卷积算子

(2)

实验中原始的灰度图像经过LoG算子边缘检测之后成功地保留了车辆的轮廓,效果如图2(b)所示. 图2(a)为原始图像.

1.3 拟合策略

道路监控画面主要拍摄的是车辆前部,本文车辆检测的标记位置为车辆前部,车辆前部具有明显的形状特征,整体成矩形,存在上下左右4个边缘,并满足一定的高宽比. 对于LoG边缘检测所得到的图像进行拟合,对目标与矩形以及长宽比的拟合程度进行比较确定候选区域.

首先将边缘图像二值化,如图2(c)所示.

分析二值图像可知,相对于路面以及路边的干扰物,汽车目标作为人造刚体,其边缘呈现出较为明显的形状特征. 因此可根据目标对于车辆前部形状的拟合程度进行判定.

拟合之前先确定一个合适的扫描窗口,统计区域的大小、长宽比以及厚度的选择对结果有影响,本文在实验之前通过统计分析选择长宽比和大小符合大部分车辆前部的结果生成扫描窗口,以此窗口为单位对整个二值图像进行扫描.

对于扫描窗口向外和向内各扩展一段距离形成一个中空的区域,作为有效统计区域,如图3所示,黑色区域为有效统计区域. 对于在扫描窗口的统计区域内的像素进行统计.

设有效统计区域为D,对于扫描窗口n定义拟合度为

(3)

式中i(x,y)为(x,y)处的像素值,在二值图像中为1或0. 对于每一个扫描窗口计算拟合度,将限定扫描区域内拟合度高于一定阈值Gth的目标作为假设候选.

1.4 聚类融合

由于车辆的类型不同,车辆距离监控镜头的位置也不同,导致目标区域的大小变化多样. 为了不产生漏检,实际实验中会采用多尺度扫描的策略,因此会产生满足条件的假设框集中分布的情况,需要对于集中分布的假设框进行聚类从而得到较为准确的假设区域.

本文采用具有噪声的基于密度的聚类方法DBSCAN[7](density-based spatial clustering of applications with noise)进行聚类运算, DBSCAN是一种空间聚类算法. 该算法基于密度处理,将具有足够密度的区域划分为簇,能够在具有噪声的空间数据库中发现任意形状的簇,将簇定义为密度相连的点的最大集合. DBSCAN算法的优点是聚类速度快且能够有效处理噪声点和发现任意形状的空间聚类. 另外该算法不需要输入划分的聚类个数,适用于本文所需的不确定假设数量的情况.

2 假设验证算法

获得车辆假设后,需要对假设的真伪进行验证. 本文采用了基于表观的方法,选择方向梯度直方图HOG(histograms of oriented gradients)特征作为特征描述子,支持向量机SVM(support vector machine)作为分类器. 将上一步得到的车辆假设框归一化到一定的尺寸,再提取假设区域的HOG特征表示为一组特征值. 最后将特征值送到训练好的SVM分类器进行分类,分为车辆和非车辆类别以确定假设框的真伪.

2.1 车辆特征描述

本文的研究重点在于复杂的光照环境下的车辆检测,因此要求选择的特征描述子能够有效地克服目标亮度和尺度的变化. HOG特征最早由由Dalal等[8]提出用于行人检测,并取得了较好的效果,后来被推广用于各种目标检测的描述中. HOG特征更加关注目标局部区域内梯度方向直方图分布,而通常目标的变化只会出现在较大的尺度范围内. 因此保证了HOG特征对尺寸和光照变化的不敏感性[9].

HOG特征提取的提取可分为梯度计算和梯度统计两步进行. 梯度值计算时用一维的离散微分模板[-1,0,1]和[-1,0,1]-1同时在水平和垂直方向上对图像进行处理. 对于每一个像素,用式(4)(5)分别计算每一个点水平和垂直的梯度分量,再用式(6)(7)计算每一个像素点的梯度值和梯度方向,

(4)

(5)

(6)

(7)

在梯度统计的过程中,对于每个像素点上的梯度值和方向进行加权统计. 本文在方向直方图的构建时采用了0°~180°的方向范围并分为9个等级,每20°是一个等级. 不同形状的物体梯度分布不同,可以用梯度方向直方图区分物体的形状.

每一幅图像可分成等大小的细胞单元(cell),在细胞单元内计算图像边缘梯度直方图. 为了避免光照和对比度的变化对梯度分布的影响,必须局部归一化梯度,将几个细胞单元组成一个块(block). 将块内细胞单元的梯度直方图连接起来作为块的特征,在图像上滑动块得到的特征值连接起来就构成了图像的梯度直方图特征.

2.2 SVM分类器

采用SVM作为车辆分类器[10],SVM是一种有效的用于线性和非线性二分类问题的分类器. 对于给定的一组点,SVM分类器找到一个超平面来使得两边每个类别正确的数量最多,并且每一类到该超平面的距离最大. 分类间的超平面可以表示为

(8)

式中:参数x∈RN为被分类对象的特征描述向量;y∈(-1,+1)为样本标记;k(x,xi)为内核函数. 通过采用不同的内核,SVM可训练为不同种类的分类器,本文采用式(9)的径向基核函数来构造分类器对HOG特征向量进行分类

(9)

在使用分类器之前需收集一定数量的正样本和负样本训练分类器,通过调节参数σ来获得更高准确率的SVM. 本文的待分类目标是每一个假设框的HOG特征向量,对于假设生成过程产生的每一个结果提取HOG特征向量,通过SVM分类为车辆目标和非车辆目标. 至此完成整个图像的车辆检测,在整个过程中从假设生成的边缘检测到假设验证的特征描述子再到分类器的选择均需要考虑复杂光照环境这一研究重点.

3 实验结果与分析

3.1 分类器的训练

在训练车辆分类器时,本文在实际路口拍摄的图像中收集训练数据,通过随机滑动窗口的方法收集负样本,手工标定的方法收集正样本. 在训练分类器时,本文使用了正样本300个,负样本600个. 在测试分类器时,挑选独立于训练样本的正负样本各100个,调节核函数的参数获得查准率较高且错分率较低的分类器作为实验使用的分类器.

3.2 实验数据

本文的实验首先建立了一个复杂光照环境的数据集,所有数据均来自实际路口拍摄的图像,其中包含了300幅比较具有代表性的复杂光照环境下的道路监控图像,这些图像均独立于分类器训练时所采用的数据. 图像中受光照的影响,车辆的各方面特征均有较为严重的丢失,正常光照下的车辆检测方法在这样的图像中漏检率和误检率较高.

图4为部分实验数据,这些图像均受到了复杂光照的影响,或为强顺逆光导致车身表面过度曝光,细节信息全无,或为单侧光照过强导致左右两边特征不对称. 这些都是复杂光照对于车辆表观特征产生的严重影响,传统车辆检测方法在这样的数据中表现较差,因此本文实验在这样的数据集上进行以验证方法的有效性.

3.3 定性分析

为测试本文方法的检测效果,进行了与其他方法的比较实验. 实验选择了同样利用边缘特征进行候选目标提取的文献[4]中的方法进行比较,该方法通过边缘图像的灰度影射图来确定候选目标. 本文的方法重点在于假设生成的过程,因此又选择了直接采用滑动窗口扫描提取特征分类的方法进行对比. 实验对于车辆检测的标注为车前部,检测到完整的车前部即为有效目标.

图5为部分实验结果,在复杂的光线环境中,尽管车辆表面的信息丢失严重,车辆与路面的边界依旧明显,因此本文方法能够很好地检测出目标. 其中复杂光照对白色车辆的影响尤为明显,车辆的表面纹理以及车牌均由于过度曝光而模糊一片. 但路面大多为深色,车辆与路面的边界边缘清晰可见,本文的方法恰恰利用了这一优势,对于白色车辆有更好的检测效果.

对比实验中Sun的方法在光照比较极端的情况下只能检测出车辆的一侧边缘,在车辆阴影较大时会将阴影误认为候选目标. 当画面中同时出现多辆车时检测到的边缘之间会互相影响从而降低检测效果. 而直接通过滑动窗口密集采样的方法能够检测出大多数正确目标,但同时误检率也很高且速度较慢.

3.4 定量分析

为进一步定量分析本文提出的方法的有效性和鲁棒性,定义实验数据集中车辆检测的准确率(查准率)为

(10)

式中:Ntp为正确检测为车辆的个数;Nfp为将非车辆区域检测为车辆的个数,即误检个数. 同时定义实验数据集中车辆检测的召回率(查全率)为

(11)

式中:Nfn为将车辆区域检测为非车辆区域的个数,即漏检个数;Ntp+Nfn为图像序列中车辆的总个数.

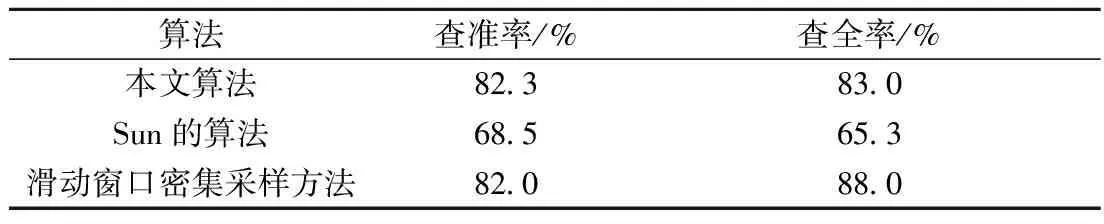

对比实验将3种方法分别在复杂光照环境的数据集中测试,对比结果如表1所示.

表1 各算法评价指标

在复杂光照的数据集上本文的方法取得了较高的准确率和召回率,相比文献[4]的边缘灰度统计方法效果有较大的提升. 直接通过滑动窗口对整个图像进行扫描提取特征并分类的方法比本文有更高的召回率,但耗时较长(每张图像需1 200 ms),无法满足实际视频中实时监测车辆的要求. 本文的方法每张图像的耗时小于40 ms,可完全满足车辆检测系统的实时性要求.

图6为阈值由低升高时召回率和准确率的变化曲线,由图6可知,当拟合度设定的阈值Gth变化时,查准率和查全率会随之变化. 阈值较低时绝大部分车辆目标会被检测出,同时误检数量也较高. 因此查准率较低,查全率较高. 当阈值设定较高时则相反,误检的数量会降低,但是漏检的数量也会增多. 在实际使用过程中可根据需求设定合适大小的拟合度阈值.

由定量的结果可知,在正常光照下的车辆检测方法几乎无法检测出目标的情况下,本文的方法依旧保持了较高的检测率,对于复杂光照环境这一特殊情况切实有效.

4 结 论

提出了一种复杂光照环境下的车辆检测方法,实验结果表明,对于正常光照环境下车辆检测方法无法检测的车辆,本文方法能够有效地检测出目标. 由于本文方法所使用的边缘特征充分考虑到了复杂光照环境中车辆所能保留的信息,同时结合车辆头部的形状特征进行拟合来进行假设区域的生成,因此可以面对复杂的光照环境而保持较好的检测效果,可以作为正常光照环境下车辆检测方法的有效补充.

[1] Mori H, Charkai N M. Shadow and rhythm as sign patterns of obstacle detection[C]∥Proceedings of IEEE International Symposium on Industrial Electronics. [S.l.]: IEEE, 1993:271-277.

[2] Buluswar S D, Draper B A. Color machine vision for autonomous vehicles[J]. Engineering Applications of Artificial Intelligence, 1998,11(2):245-256.

[3] Zielke T, Brauckmann T M, VonSeelen W. Intensity and edge-based symmetry detection with an application to car-following[J]. CVGIP: Image Understanding, 1993,58(2):177-190.

[4] Sun Z, Miller R, Bebis G, et al. A real-time precrash vehicle detection system[C]∥Proceedings of Sixth IEEE Workshop on Applications of Computer Vision. [S.l.]: IEEE, 2002:171-176.

[5] Haralick R M, Shanmugam K, Dinstein I H. Texture features for image classification[J]. IEEE Transactions on System, Man, and Cybernetics, 1973(6):610-621.

[6] Sun Z, Bebis G, Miller R. Monocular precrash vehicle detection: features and classifiers[J]. IEEE Transactions on Image Processing, 2006,15(7):2019-2034.

[7] Ester M, Kriegel H P, Sander J, et al. A density-based algorithm for discovering clusters in large spatial databases with noise[C]∥Proceedings of the Second International Conference on Knowledge Discovery and Data Mining (KDD-96). Portland, Oregon, USA: [s.n.], 1996.

[8] Dalal N, Triggs B. Histograms of oriented gradients for human detection[C]∥Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition. [S.l.]: IEEE, 2005.

[9] Khammari A, Nashashibi F, Abramson Y, et al. Vehicle detection combining gradient analysis and AdaBoost classification[C]∥Proceedings of the 8th Intemafional IEEE Conference on Intelligent Transportation Systems. Vienna, Austria:[s.n.], 2005:1084-1089.

[10] Sun Z, Bebis G, Miller R. On-road vehicle detection using gabor filters and support vector machines[C]∥Proceedings of 2002 14th International Conference on Digital Signal Processing. [S.l.]: IEEE, 2002:1019-1022.

(责任编辑:李兵)

Vehicle Detection Method in Complex Illumination Environment

PEI Ming-tao, SHEN Jia-jun, YANG Min, JIA Yun-de

(Beijing Laboratory of Intelligent Information Technology, School of Computer Science,Beijing Institute of Technology, Beijing 100081, China)

An on-road vehicle detection method under complex illumination environments was introduced. The approach uses the features of a vehicle under complex illumination environment and prior knowledge of the vehicle’s front shape based on the hypothesis-verification framework. During the stage of hypothesis generation, edges were extracted from the front image of a vehicle and then fit approximately with the front shape of the vehicle. In the hypothesis verification phase, HOG features were used as a descriptor, in combination with the SVM classifier to complete the verification of hypothesis. The experimental results show that the proposed method works well in complex illumination environment, and it has good performance in detecting vehicle targets under complex illumination environment.

vehicle detection; hypothesis-verification framework; complex illumination

2014-12-09

国家自然科学基金资助项目(61472038);北京市教育委员会共建专项资助项目

裴明涛(1977—),男,博士,副教授,E-mail:peimt@bit.edu.cn.

TP 39

A

1001-0645(2016)04-0393-06

10.15918/j.tbit1001-0645.2016.04.011