NSCT域内结合边缘特征和自适应PCNN的红外与可见光图像融合

闫 利,向天烛,2

(1.武汉大学测绘学院,湖北武汉430079;2.武汉大学测绘遥感信息工程国家重点实验室,湖北武汉430079)

NSCT域内结合边缘特征和自适应PCNN的红外与可见光图像融合

闫 利1,向天烛1,2

(1.武汉大学测绘学院,湖北武汉430079;2.武汉大学测绘遥感信息工程国家重点实验室,湖北武汉430079)

针对传统的基于多尺度变换的红外与可见光图像融合,对比度不高,边缘等细节信息保留不充分等问题,结合NSCT变换的多分辨率、多方向特性和PCNN全局耦合、脉冲同步激发等优点,提出一种基于NSCT变换结合边缘特征和自适应PCNN红外与可见光图像融合算法.对于低频子带,采用一种基于边缘的融合方法;对于高频方向子带,采用方向信息自适应调节PCNN的链接强度,使用改进的空间频率特征作为PCNN的外部激励,根据脉冲点火幅度融合子带系数.实验结果验证了该算法的有效性.

图像融合;非下采样Contourlet变换;脉冲耦合神经网络;边缘特征;空间频率;红外图像

1 引言

红外图像是根据地物的热辐射特性成像,目标信息突出,能够捕获到隐藏在低光照条件下或者伪装的目标,但它对亮度变化不敏感,缺乏场景细节信息;而可见光图像是根据物体的反射特性成像,分辨率较高,而且包含丰富的场景细节信息[1].因此,将红外与可见光图像进行融合,有利于综合红外图像较好的目标识别特性和可见光图像较高的空间分辨率和丰富的背景细节信息,从而提高在复杂环境中正确检测识别目标的概率以及目标定位的能力.

目前,由于离散小波变换(Discrete Wavelet Transform,DWT)等多尺度分析工具优秀的多分辨率特性和时频局部特性,基于多尺度几何分析的图像融合算法成为当前的研究热点.但是传统的小波变换各向同性,只具有有限个方向,且存在采样操作,缺乏平移不变性,不能很好地表示图像中的边缘方向等信息,在源图像之间存在配准误差的情况下,将对融合结果带来不利影响.为此,很多学者提出了多种新的多尺度几何分析工具,如Bandelet变换、Curvelet变换、Contourlet变换、非下采样Contourlet变换等.其中,非下采样Contourlet变换[2](Nonsubsampled Contourlet Transform,NSCT)是对Contourlet变换的改进,不仅具有小波变换的多分辨率和时频局部特性,还具有各向异性和多方向特性,并且具有平移不变特性,克服了小波、Contourlet等存在的伪吉布斯效应,是一种真正的图像多尺度、多方向的表示,非常有利于图像融合.NSCT应用到图像融合,可以有效地提取图像特征,为融合图像提供更丰富的信息,从而提升融合的效果.

目前常用的融合规则没有充分考虑图像的边缘等特征,导致融合图像细节信息保留不够,为此学者们提出了许多顾及图像边缘信息的融合方法.Nikolov S G等[3]首次提出将小波多尺度边缘用于图像融合,利用图像的多尺度边缘信息来融合图像,以更好地保留原图像边缘等特征;晁锐等[4]提出一种基于边缘的小波融合方法,采用方向滤波算子进行边缘检测,选择最有可能是边缘的点加以保留;连静等[5]在此基础上改进了高频系数融合规则,采用局部模极大和局部强度比规则来融合高频系数;Zou J等[6]在图像多尺度边缘检测的基础上,利用边缘相关性最大的规则进行融合,最大程度上保留了原图像边缘信息;童涛等[7]对图像进行小波分解,对每层低频子带进行 Canny边缘提取,用于指导高频子带系数的融合;Liu K等[8]将图像分割与边缘检测相结合,在基于区域特征分割的基础上,对待融合图像进行Sobel边缘检测,保留图像边缘点;鉴于小波变换的一些局限性,李美丽等[9]将NSCT变换和脉冲耦合神经网络(Pulse Coupled Neural Network,PCNN)结合起来,提出了在NSCT域低频子带基于边缘,高频子带基于PCNN的融合方法,PCNN规则顾及了图像的全局特征,以及每个像素的特性,能够有效地提取和保留图像的细节信息.但是文献[9]仅采用单个像素的灰度值作为PCNN的输入,忽略了人眼对边缘、方向等信息敏感的特性,同时PCNN参数多,设置复杂,该方法缺乏自适应性,需要大量的迭代,在一定程度上影响了融合效果.

为此,充分利用图像的边缘特征,及PCNN全局耦合和脉冲同步激发的优良特性,提出一种NSCT域内结合边缘特征和自适应PCNN的红外与可见光图像融合方法.首先对原图像进行NSCT分解;对于低频子带,采用基于边缘的方法进行融合;对于高频方向子带,分别计算各子带系数的空间频率,作为PCNN的外部激励,采用各子带图像的方向信息来自适应的调节链接强度,在一定程度上实现了PCNN模型的自适应,然后采用基于PCNN点火幅度的融合规则,相比传统的基于PCNN脉冲点火次数的融合规则,该规则大大减少了模型的迭代次数,而且可以更好地反映同步脉冲激发的幅度,以提升融合图像的整体效果.最后,通过 NSCT逆变换对融合系数进行重构得到融合图像.该方法充分结合了NSCT变换多尺度、多方向、各向异性的特点和PCNN全局耦合和脉冲同步激发特性,以及图像的边缘特征,既保证了图像融合的视觉效果,又较好地保留了源图像的边缘、纹理等细节信息.

2 PCNN模型

PCNN是Eckhorn提出的一种模拟猫、猴等动物的大脑视觉皮层细胞对视觉信号的处理机制而产生的一类新型神经网络模型[10].由于经典PCNN模型存在大量非线性调制机制和多个漏电积分器,参数设定复杂,不便于实际应用.因此,本文使用一种简化的PCNN模型,其数学方程描述如下所示:其中:Sij是外部输入激励;下标(i,j)表示像素的坐标或者神经元坐标;Fij是神经元的反馈输入;Lij是神经元的链接输入;Uij是内部活动项;θij为动态阈值;Yij表示PCNN的脉冲输出;n表示迭代次数.Wijkl为神经元之间的连接权系数矩阵,k,l表示神经元与周围链接的范围;αL,αθ为链接输入和变阈值函数的时间常数;VL,Vθ为链接输入和变阈值函数的幅度系数;β为链接强度系数.如果Uij(n)≥θij(n),则神经元产生一个脉冲,称为一次点火.

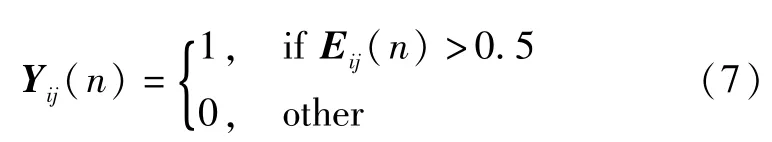

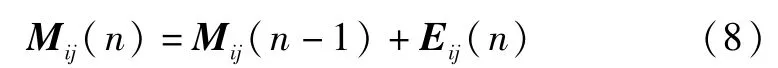

基于PCNN的图像融合一般都是根据n次迭代之后神经元的点火次数来选择融合系数.迭代次数一般是根据实验或者经验来确定,在文献[11]中,作者将迭代次数设置为200次,这样将会非常耗时,但是如果n太小,PCNN的同步脉冲特性不能充分体现.同时,由于模型采用的是硬限幅函数,每次点火输出为1或者0,不能反映出点火的幅度差异.为此,廖勇[12]等提出将脉冲点火幅度用于图像融合,大大减少了迭代次数.在PCNN的输出阶段,采用一个软限幅函数——Sigmoid函数来计算每个迭代过程中子带系数的点火输出幅度,根据输出的点火幅度之和来选择子带融合系数. Sigmoid函数曲线类似于“S”形,是一个典型的神经元非线性转换函数,可以更好地刻画同步脉冲激发时在点火幅度上的差异.PCNN的输出定义如下:

其中,Eij(n)是位于(i,j)处的系数输出的脉冲点火幅度,取值范围为[0,1].设 Mij(n)表示第n次迭代时(i,j)处系数输出的脉冲点火幅度总和,则其公式为:

然后根据脉冲点火幅度之和Mij(N)来选择融合系数,N表示总的迭代次数.具体融合规则如下:

3 本文融合规则

图像经NSCT分解后得到低频子带和高频子带.其中低频子带代表图像的近似分量,反映了图像的轮廓;高频部分代表图像的细节分量,包括边缘、纹理等细节信息,是人眼识别和机器视觉最敏感的部分.因此,原图像经分解后融合规则的选择对于融合质量至关重要.

3.1低频子带融合规则

由于多尺度分解的不完全性,低频部分仍保留有部分细节信息,这种现象在分解层次较少的情况下尤为突出.目前对于低频子带常采用加权平均法,没有考虑图像的边缘等特征,将会损失一部分可见光图像的光谱细节信息,降低融合图像的对比度.因此,本文对低频子带系数采用基于边缘的选择方案,尽可能多的保留原图像中最有可能是边缘的点,更充分地融合图像中的边缘细节信息.对原红外图像和可见光图像的低频子带系数定义一个边缘测度指标E,计算公式为:

其中a表示红外或者可见光图像的低频子带系数,(i,j)表示子带系数坐标

E在一定程度上反映了低频子带在水平、垂直和对角线方向的边缘信息.为了较好的保留源图像的细节,对红外和可见光图像的低频子带系数分别计算EI和EV,并选择两者较大的低频系数作为融合图像的低频子带系数,这样就能在融合图像中最大程度的保留原图像的边缘等细节信息,使得融合图像细节更为丰富.

低频融合系数选取方法如下:

其中,aF(i,j)表示低频子带(i,j)处的融合系数.

为了保证融合后图像数据的一致性,对低频子带融合后的系数进行一致性验证,即在低频子带融合系数中,若某一系数来自于红外图像I的低频子带,而它的邻域中大多数系数却来自于可见光图像V的低频子带,那么该点的系数改成可见光图像V低频子带对应的系数,反之不变.

3.2高频子带融合规则

高频系数融合一般是采用取绝对值最大或者基于区域能量、方差、梯度等特征的规则进行选择,这些规则只考虑了单个像素或者窗口内像素,对图像细节信息提取不够.为了更好地融合原图像的特征信息,对高频系数采用基于PCNN的融合方法.在许多基于PCNN的图像融合中,一般将单个像素的灰度值直接作为输入项Fij,然而人眼视觉系统对单个像素并不敏感,而对图像的边缘、方向和纹理等信息比较敏感.图像的空间频率特征能够很好地表示图像边缘细节信息,因此选择局部空间频率[13]特征作为PCNN的外部输入.

空间频率一般只对水平和垂直方向进行梯度能量计算,这里对其进行了改进,增加了两个对角方向的梯度计算,更好更全面地提取图像信息.对于一幅M×N的高频方向子图像C,C(i,j)表示图像(i,j)上的灰度值或子带系数值,那么改进的空间频率(Modified Spatial Frequency,MSF)数学表达式如下:

其中,RF,CF,MDF和SDF分别表示为行频率、列频率、主对角频率和副对角频率,其公式如下:

3.3链接强度β的确定

链接强度β反映了子带系数间的变化,在融合过程中起着关键作用.在传统的基于PCNN的图像融合中,链接强度系数β一般都是根据实验或经验来确定,且所有神经元都是取相同的值.根据文献[14],每个神经元的链接强度不可能都相同,而与图像在该处的特征信息有一定的关联,当神经元输入较大时,其链接强度也应该相应的增大.因此,可以根据图像的局部特征来设置β值.大量学者对此进行了研究,提出了不同的链接强度自适应方法,比如采用标准差,平均梯度、空间频率、EOL(Energy of Laplacian)等[15]来确定链接强度,都取得很好地效果.

图像的方向信息[16](Orientation Information,OI)是一种有效的用于表示图像边缘、纹理特征的算子,非常适合用来自适应调整PCNN的链接强度.因此文中采用邻域内的方向信息作为神经元链接强度系数.对于一幅给定的图像I,I(i,j)表示图像(i,j)处的像素值,在以(i,j)为中心的窗口内计算该像素点的方向信息,计算公式为:

其中

式中AL和AR分别表示窗口中的左右区域,如图1所示.窗口大小为(2wx+1)×(2wy+1),图中lθ表示经过(i,j)点的线,这条线将窗口分为左右两个区域.文中使用一个5×5的滑动窗口逐像素的计算每个点的方向信息.如果图像中存在尖锐的边缘,那么方向信息值就会大,而纹理区域方向信息值一般相对较小.如果一幅图像中某个窗口内是平滑的,没有明显的边缘以及丰富的纹理,那么方向信息值就很小.由此可见,方向信息可以作为链接强度系数β.

一般β的取值位于[0,1]之间,用于调节中心神经元的点火周期和邻域神经元的影响程度,其的数学表达为:

其中,η>0是一个常数,用于调节β的取值,一般取0.01.如果OI(i,j)越大,那么它相应神经元的β(i,j)值也就越大,从而神经元越早被捕获发生点火;反之亦然.

4 实验结果与分析

选取两组红外与可见光图像作为实验图像进行融合实验,并将该算法与目前常用的小波(DWT)融合方法、NSCT融合方法以及传统的NSCT和PCNN相结合[17](NSCT-PCNN)的融合方法进行对比.前两种方法融合规则为低频系数取平均,高频系数取绝对值最大值,第三种方法β=0.2,子带系数作为 PCNN的输入项.其中DWT采用3层“db2”小波;NSCT变换采用“9 -7”滤波器和“pkva”滤波器,方向级数从“细”到“粗”依次为[0,2,3,4].文中方法PCNN的其他参数为:迭代次数为10次,远小于其他方法中常用的200次,αL= 0.06931,αθ=0.2,VL=1,Vθ=20,链接权重W= [0.707,1,0.707;1,0,1;0.707,1,0.707].

第一组选取“UN Camp”拍摄的红外和可见光图像进行融合实验,实验结果如图2所示.其中图2(a)和2 (b)分别为红外和可见光原图像.从图中可以看出红外图像能较好地识别目标,行人清楚可见,但人所在场景比较模糊,背景细节信息较少,而且图像分辨率低;可见光图像中,由于光线较暗以及树叶遮挡,很难辨识出行人,但是道路、灌木等场景清晰,背景信息丰富.图2(c)~(f)分别为红外与可见光图像采用 DWT方法、NSCT方法,NSCT-PCNN方法和文中方法的融合结果.由图2 (c)~(f)可知,四种方法都成功地融合了红外图像和可见光图像的信息,既突出了目标信息又包含有背景信息,达到了较好地融合效果.但是仔细观察可以发现,DWT方法由于缺乏平移不变性,产生了伪吉布斯现象,存在一些虚影模糊,融合效果差;而基于NSCT的融合结果更平滑,目标信息突出,对比度高,其中本文方法对比度最高.观察图2(c)~(f)左下角和右下角部分,可以发现,图2(f)的灌木细节信息更丰富,像素灰度和边缘轮廓更接近可见光图像,可见文中方法能更好的保留可见光图像的背景信息,边缘细节更突出,便于人眼观察,整体视觉效果更好.

第二组实验图像为“OCTEC”拍摄的红外与可见光图像,实验结果如图3所示.其中图3(a)和3(b)分别为红外和可见光原图像,图3(c)~(f)分别为采用DWT方法、NSCT方法,NSCT-PCNN方法和文中方法的融合结果.由3(a)和(b)可以看出可见光图像房屋、树木等信息丰富,但是由于烟雾的遮挡,看不见烟雾中奔跑的人和火源,而红外图像中可以看到跑动的人和火源等目标.图3(c)~(f)可以看出,几种融合方法都很好地保留了可见光图像中的背景信息和红外图像中的目标信息.但是前三种方法整体对比度低,房屋、树木等轮廓边缘模糊,图3(f)更多地保留了可见光图像中的树木、房屋等的边缘细节信息,背景更清晰,而且还可以发现,对于天空中的云,图3(f)融合了更多的红外图像特征信息.

红外与可见光图像融合主要是为了利用两者信息互补性,弥补单一源图像信息的不足,同时提高红外影像的分辨率,尽可能多的保留红外的目标特性和可见光图像的光谱特性,因此在客观评价指标上,本文主要采用了信息熵(Information Entropy,IE)、交叉熵(Cross Entropy,CE)、联合熵(Union Entropy,UE)、标准差(Standard Difference,SD)和偏差指数(Difference Coefficient,DC)等[18]指标进行评价,其结果如表1、表2所示.

由表1、表2可以看出,文中算法信息熵最大,表明该算法融合结果所包含的信息量最丰富;联合熵最大,交叉熵最小,表明该算法融合的信息最多,对原图像信息保留程度更好,与原图像灰度分布间的信息差异最小;标准差最大,则融合图像灰度分布离散程度最大,对比度更高,目视效果更好;偏差指数最小,反映了融合图像与原图像间在光谱信息上相对差异最小,说明融合图像对原始图像的光谱信息保留越好.客观评价与主观评价基本一致.

表1 不同融合算法性能比较(第一组实验)

表2 不同融合算法性能比较(第二组实验)

由以上分析可得,本文提出的方法融合图像对比度高,目标信息突出,边缘纹理等细节信息更丰富,从主客观评价看,具有更好的融合性能.

5 结论

针对红外与可见光图像融合,提出一种结合边缘特征和PCNN的NSCT域内红外与可见光图像融合方法,充分利用了NSCT灵活的多分辨率、多方向特性和PCNN全局耦合和脉冲同步激发的特性.对低频子带,采用基于边缘的融合方法,充分利用图像的边缘特征,尽可能保留图像中的边缘细节信息;对于高频子带,提出一种基于特征激励的自适应PCNN融合方法,采用方向信息设置链接强度,使用一种改进的空间频率特征激励PCNN,最后根据脉冲点火幅度来选择高频方向子带系数,更加符合人眼视觉系统,而且迭代次数大大减少,取得了很好效果.通过两组红外与可见光图像融合实验表明,该方法较好地保留了可见光图像中丰富的场景信息,又很好地融入了红外图像的目标信息,融合对比度高,光谱细节信息丰富.

[1]Xiang T,Yan L,Gao R.A fusion algorithm for infrared and visible images based on adaptive dual-channel unit-linking PCNN in NSCT domain[J].Infrared Physics&Technology,2015,69:53-61.

[2]Da Cunha A L,Zhou Jian-ping,Do M N.The nonsubsampled contourlet transform:theory,design,and applications[J].IEEE Transactions on Image Processing,2006,15 (10):3089-3101.

[3]Nikolov S G,Bull D R,Canagarajah C N,et al.Fusion of 2-D images using their multi-scale edges[A].Proceedings of 15th International Conference on Pattern Recognition [C].Barcelona:IEEE,2000.41-44.

[4]晁锐,张科,李言俊.一种基于小波变换的图像融合算法[J].电子学报,2004,32(5):750-753. Chao Rui,Zhang Ke,Li Yan-jun.An image fusion algorithm using wavelet transforms[J].Acta Electronica Sinica,2004,32(5):750-753.(in Chinese)

[5]连静,王珂,李光鑫.基于边缘的小波图像融合算法[J].通信学报,2007,28(4):18-23. Lian Jing,Wang Ke,Li Guang-xin.Edge-based image fusion algorithm with wavelet transform[J].Journal on Communications,2007,28(4):18-23.(in Chinese)

[6]Zou J,Zhao W.An image fusion algorithm based on compact image coding from multi-scale edges[A].The 9th International Conference on Signal Processing[C].Beijing,China:IEEE,2008.1079-1082.

[7]童涛,杨桄,孟强强,等.基于边缘特征的多传感器图像融合算法[J].红外与激光工程,2014,43(1):311-317. Tong Tao,Yang Guang,Meng Qiangqiang,et al.Multi-sensor image fusion algorithm based on edge feature[J].Infrared and Laser Engineering,2014,43(1):311-317.(in Chinese)

[8]Liu K,Guo L,Li H,et al.Fusion of infrared and visible light images based on region segmentation[J].Chinese Journal of Aeronautics,2009,22(1):75-80.

[9]李美丽,李言俊,王红梅,等.基于NSCT和PCNN的红外与可见光图像融合方法[J].光电工程,2010,37(6):90 -95. Li Mei-li,Li Yan-jun,Wang Hong-mei,et al.Fusion algorithm of infrared and visible images based on NSCT and PCNN[J].Opto-Electronic Engineering,2010,37(6):90 -95.(in Chinese)

[10]Monica Subashini M,Sahoo S K.Pulse coupled neural networks and its applications[J].Expert Systems with Applications,2014,41(8):3965-3974.

[11]Ikuta C,Zhang S,Uwate Y,et al.A novel fusion algorithm for visible and infrared image using non-subsampled contourlet transform and pulse-coupled neural network[A]. The 9th International Conference on Computer Vision Theory and Applications[C].Lisbon,Portugal:ACM,2014.160-164.

[12]廖勇,黄文龙,尚琳,等.Shearlet与改进PCNN相结合的图像融合[J].计算机工程与应用,2014,50(2):142-146. Liao Yong,Huang Wen-long,Shang Lin,et al.Image fusion based on Shearlet and improved PCNN[J].Computer Engineering and Applications,2014,50(2):142-146.(in Chinese)

[13]Das S,Kundu M K.NSCT-based multimodal medical image fusion using pulse-coupled neural network and modified spatial frequency[J].Medical&Biological Engineering&Computing,2012,50(10):1105-1114.

[14]Chai Y,Li H F,Guo M Y.Multifocus image fusion scheme based on features of multiscale products and PCNN in lifting stationary wavelet domain[J].Optics Communications,2011,284(5):1146-1158.

[15]李奕,吴小俊.粒子群进化学习自适应双通道脉冲耦合神经网络图像融合方法研究[J].电子学报,2014,42 (2):217-222. Li Yi,Wu Xiao-jun.A novel image fusion method using self-adaptive dual-channel pulse coupled neural networks based on PSO evolutionary learning[J].Acta Electronica Sinica,2014,42(2):217-222.(in Chinese)

[16]Y C,Li H F,Qu J F.Image fusion scheme using a novel dual-channel PCNN in lifting stationary wavelet domain [J].Optics Communications,2010,283(19):3591-3602.

[17]刘盛鹏,方勇.基于Contourlet变换和IPCNN的融合算法及其在可见光与红外线图像融合中的应用[J].红外与毫米波学报,2007,26(03):217-221. Liu Sheng-peng,Fang Yong.Infrared image fusion algorithm based on contourlet transform and improved pulse coupled neural network[J].Journal of Infrared and Millimeter Waves,2007,26(03):217-221.(in Chinese)

[18]Xu H,Jiang T.Multi-source remote sensing image fusion algorithm based on combined wavelet transform and HIS transform[J].Journal of Convergence Information Technology,2012,7(18):392-400.

闫 利 男,1966年8月出生于山西山阴,1999年在武汉大学获得大地测量与测量工程博士,现为武汉大学教授、博士生导师,主要从事摄影测量与遥感、地面三维激光扫描的研究.

E-mail:lyan@sgg.whu.edu.cn

向天烛 男,1988年12月出生于湖北宜昌,现为武汉大学摄影测量与遥感专业博士生,主要从事摄影测量、遥感图像处理的研究.

Email:skylabs@whu.edu.cn

Fusion of Infrared and Visible Images Based on Edge Feature and Adaptive PCNN in NSCT Domain

YAN Li1,XIANG Tian-zhu1,2

(1.School of Geodesy and Geomatics,Wuhan University,Wuhan,Hubei 430079,China;2.State key Laboratory of Information Engineering in Surveying,Mapping and Remote Sensing,Wuhan University,Wuhan,Hubei 430079,China)

To improve the contrast and preserve more image details in the fusion of infrared and visible images,a fusion method for infrared and visible images based on nonsubsampled contourlet transform(NSCT)combined with image edge feature and adaptive pulse coupled neural network(PCNN)is proposed.For the low frequency subband,the fusion is based on edges of images.For the high frequency subbands,the orientation information of each pixel in images is utilized as the linking strength,and a modified spatial frequency is adopted as the input to motivate the adaptive PCNN,and the fire amplitude is employed to determine the coefficients selection.Experimental results indicate the effectiveness of the proposed algorithm.

image fusion;nonsubsampled contourlet transform;pulse coupled neural network;edge feature;spatial frequency;infrared image

TP391.41

A

0372-2112(2016)04-0761-06

电子学报URL:http://www.ejournal.org.cn 10.3969/j.issn.0372-2112.2016.04.002

2014-09-25;

2015-04-30;责任编辑:李勇锋

国家自然科学基金(No.41271456)