应用颜色聚类图像块的多舰船显著性检测

郭少军,娄树理,刘 峰

(海军航空工程学院 控制科学与工程系,山东 烟台 264001)

应用颜色聚类图像块的多舰船显著性检测

郭少军*,娄树理,刘峰

(海军航空工程学院 控制科学与工程系,山东 烟台 264001)

由于多舰船目标显著性检测过程容易将边界像素作为背景处理, 本文提出了应用颜色聚类图像块的多舰船显著性检测方法。该方法首先检测邻域 像素是否具有颜色相似性,并将临近的具有相似颜色的像素聚集在一起作为一个图像块。接着,对获得的图像块进行扩展,使图像块包含很多其他图像块的像素以提高图像块内像素间的对比强度;对边缘像素进行背景索引标记,计算图像块中像素的显著性强度,采用阈值分割方法获得目标显著性区域。最后,基于颜色聚类的图像块存在部分重叠的特点,利用权值对存在叠加的显著性图像进行融合,从而获得多舰船目标整幅图像的显著性检测结果。对获得的多舰船目标图像进行了实验测试,并对本文算法结果和当前比较先进的其它显著性检测算法进行了效果对比。结果显示:提出的利用颜色聚类图像块的舰船显著性检测方法的查全率达到78%以上,准确率达到92%以上,综合评价指标Fβ≥0.7;无论考虑单个指标还是整体指标,本文算法均优于其他对比算法。

多目标检测;显著性检测;舰船;图像块;颜色聚类

1 引 言

显著性检测用于识别场景中最重要最具信息价值的部分,已广泛应用于图像分割[1],目标识别[2],图像压缩[3],基于内容的图像检索[4]等。通常用方框将显著性区域标记出来[5-6],同时将背景与前景进行二值化[7-10]。Liu[8]等提出结合图像特征训练条件随机场来估计显著性二值化模型;Wang[10]等人在统一能量最小化框架下分析多重索引,并利用图模型[11]进行显著性计算;Lu[9]等提出了分层图模型,并利用模型计算图节点之间的权值;Achanta[12]等通过计算每个像素与其周边像素的对比强度获得显著性值;Cheng[13]等改进了Achanta等人的工作,计算每个像素与整幅图像其它像素的对比强度来评估显著性;Goferman[1]等基于人眼视觉注意机制,提出通过场景感知和K散度[14]计算提取目标的显著性区域;Xie[15]等人结合中低等级的索引,利用贝叶斯框架构建一种自下而上的显著性检测模型;Sun[16]等人改进了Xie等人的模型,引入了边界软分割的概念;文献[17]中利用高维高斯滤波器来计算显著性强度;Itti[18]等提出了基于视觉注意机制的显著性模型;Hou[19]等提出稀疏显著性区域提取算法; Koch[20]等人结合神经系统工作原理和视觉注意机制提出了显著性计算模型;Chen MM[21]通过检测场景中的图像显著性和相似性进行场景分析,并提出了基于直方图的全局对比度分析方法;Achanta[22]提出了基于频率调谐的显著性区域检测算法,该算法根据显著性区域在频域中的不同进行显著性检测;在文献[23]中,Hou等人提出了基于光谱残留法进行显著性区域检测;Guo[24]等人通过计算傅里叶变换相位谱来进行显著性检测;Castelhano[25]等人提出了一种基于自然统计数据的自上而下的显著性检测方法。在文献[26]中,Chen MM提出了一种基于全局对比度的显著性区域检测方法;文献[27]中,Zhang等人提出了一种基于布尔方法的显著性检测算法。Chuan Yang[28]等人基于超像素理论[29]和图论生成了全分辨率的显著性映射图像,该算法能够检测到图像中较大的目标但是容易将小目标吞没,在多舰船目标检测中无法应用;文献[30]提出构建多个测量区域来计算显著性区域;文献[31]提出了一种自动显著性检测方法,其结合了自底而上和目标形状优先的显著性方法的优点。为了满足海面多舰船目标的显著性检测,本文首先检测图像中相似的色彩图像块,然后扩展图像块区域并利用图模型计算区域显著性映射,最后将图像块显著性映射加权融合获得最终多目标显著性区域。另外,还进行了实验,实验结果见第5节。

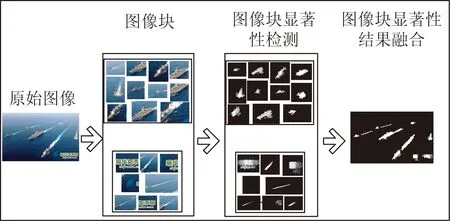

2 图像块的提取

在一幅数字图像中,边缘轮廓通常具有较强的梯度值或者较强的颜色变化。对于多舰船图像,背景通常为蓝色,舰船的边缘颜色和背景明显不同。当舰船在海上编队航行时,舰船之间是存在间隙的。所以具有强梯度值的像素可以认为是舰船的边界或者轮廓区域,而在强梯度像素之间的像素应该是舰体或者舰桥等部位。本节将通过计算区域内的颜色相似性来获得小图像块,并通过重构小图像块的显著性图像获得大图像的目标显著性映射图像。流程图如图1所示。

图1 算法流程图

输入一幅数字图像,对每一个颜色通道都以0~255作为递增阈值进行分割,获得各个小图像块,当阈值递增到某个值时,小图像块的面积不再变化,则认为这个图像块中的所有像素具有颜色相似性,将这个图像块作为一个显著性计算候选区域,图2(彩图见期刊电子版)是对图像块的说明。如果图像块面积不再变化或变化极小时,图像块内的灰度值的总和将不会发生大的变化。

(a)图像块(a)Image block

(b)图像块边缘(蓝色)(b)Image block boundary

设灰度值和的变化率为GT,每个图像块中像素为E={e1,e2,…,eN},则像素灰度和可表示为等式(1):

(1)

其中Gray(*)是像素的灰度值,灰度值和的变化可表示为ΔGT。

ΔGT=GT+1-2×GT+GT-1.

(2)

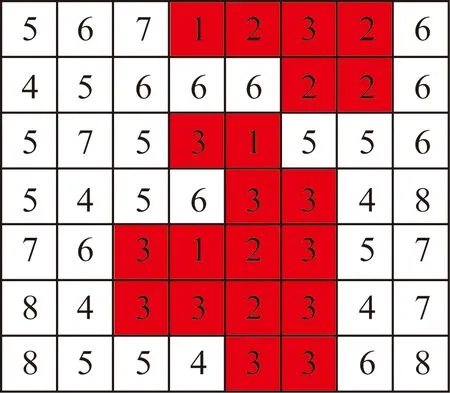

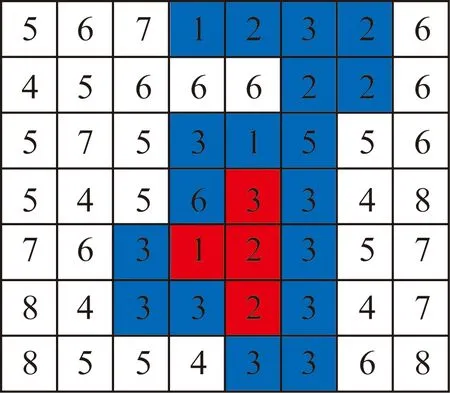

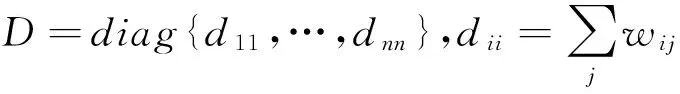

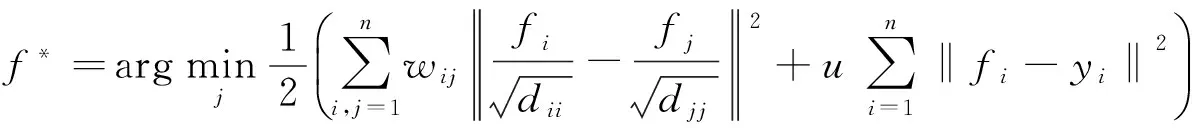

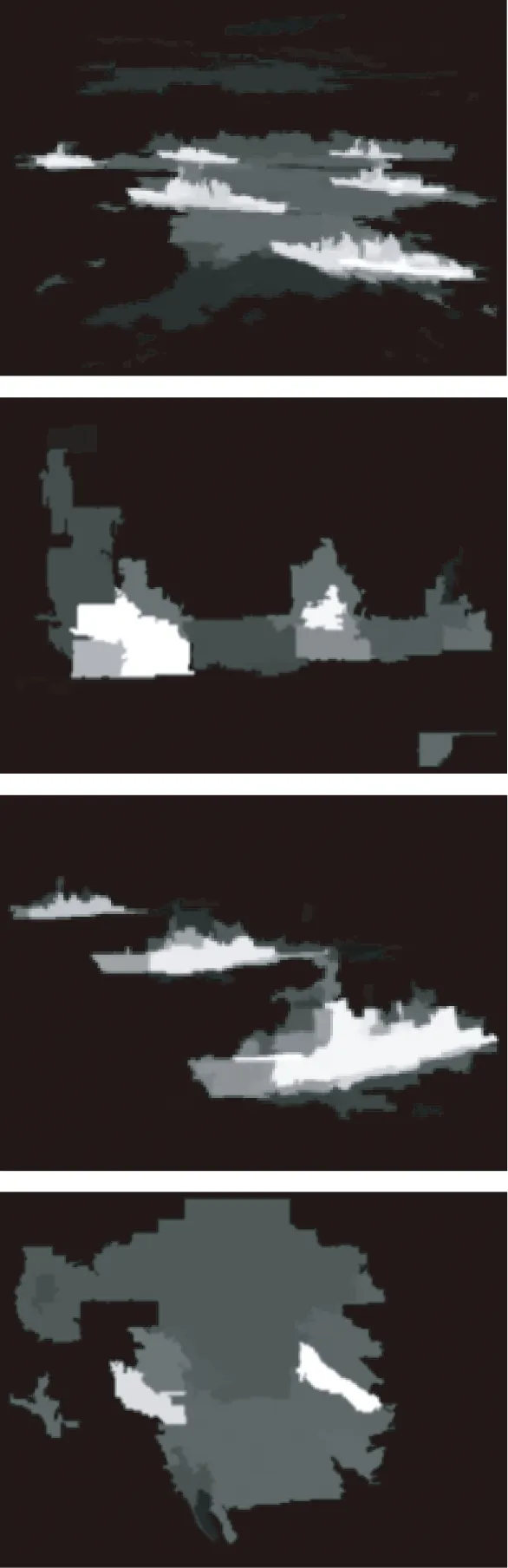

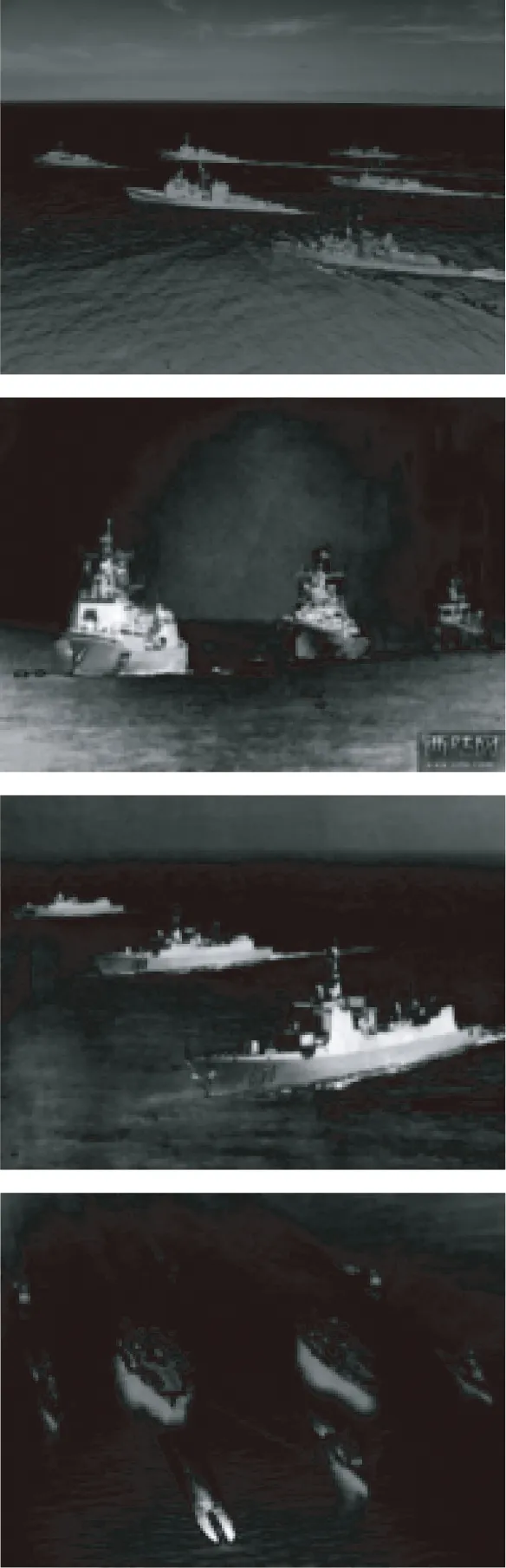

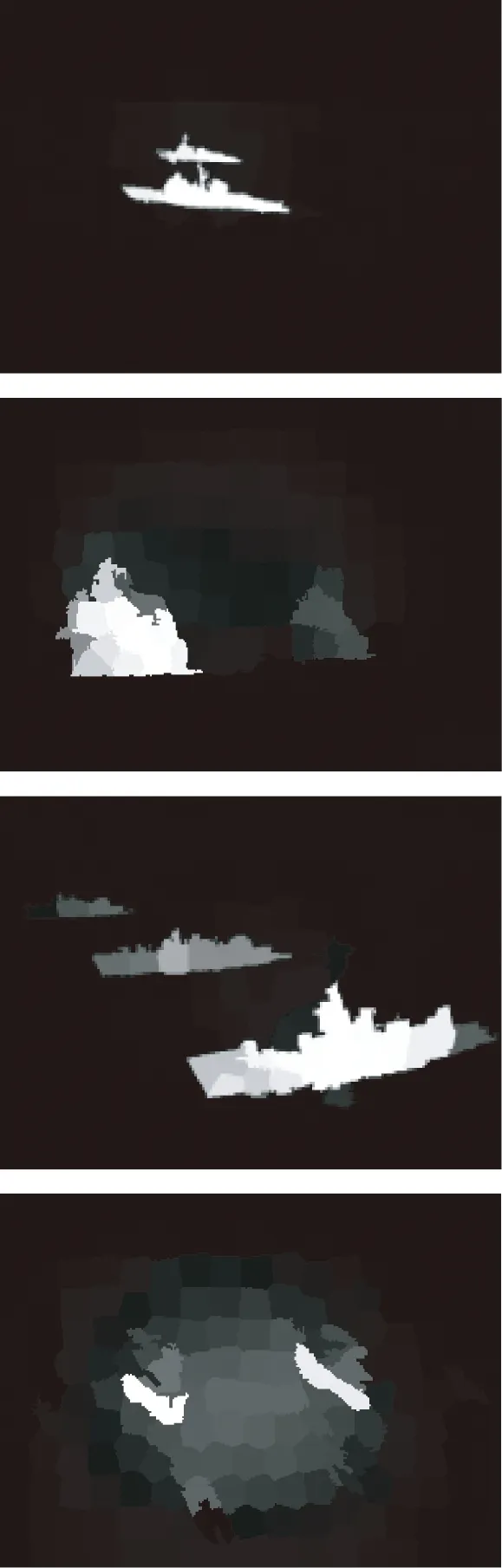

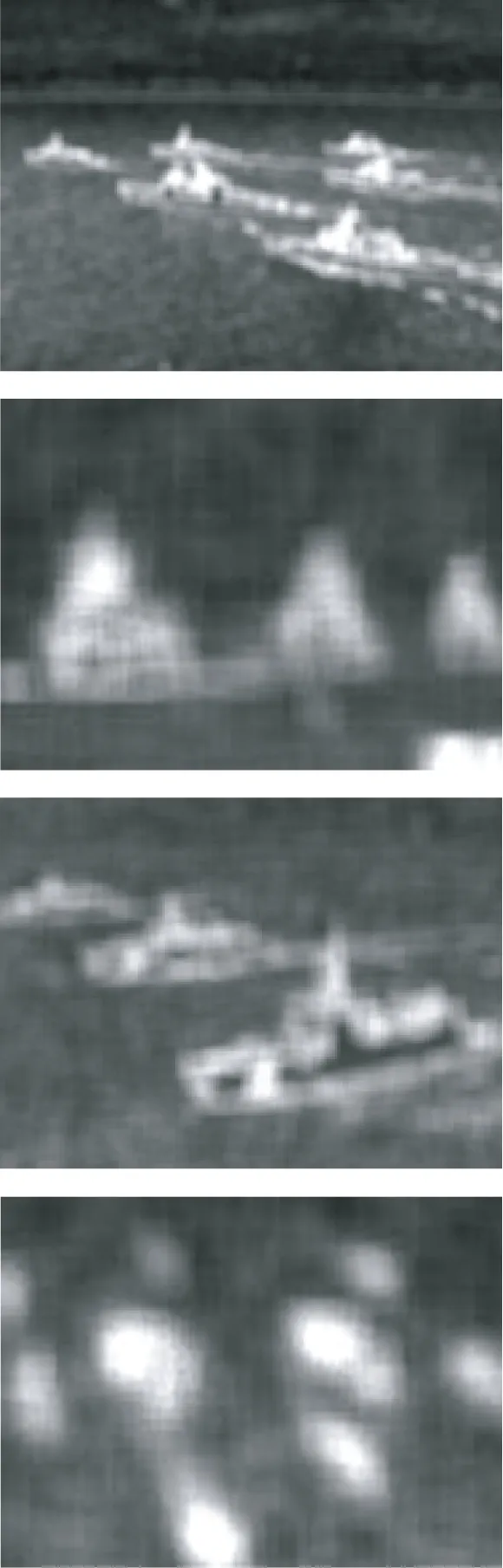

在一系列阈值T{t|T1,T2,…,Tk}中,图像块应该满足ΔGT 3.1图像块显著性等级与索引优化 (3) 将数据集元素按照显著性进行等级排序的过程实质上是一个优化过程,优化问题可表示为等式(4): (4) 其中μ用来平衡平滑约束。等式(4)可以变形为等式 (5)。 f*=(I-αS)-1y, (5) 其中:I是识别矩阵,α=1/(1+μ),S是标准化拉普拉斯矩阵,S=D-1/2WD-1/2,代入等式(5)得到等式(6)。 f*=(D-αW)-1y. (6) 本文在实验中利用等式(6)进行图像块像素显著性等级计算,令A=(D-αW)-1,f*=Ay。f*(i)是第i个像素或数据点相对所有索引点的相关强度值的和。由于索引点的标记可能出错,因此需要计算索引点的可信度。首先将矩阵A的对角线元素都置为0以消除索引点自身相关性造成的影响,进一步,将索引点中与其他索引点相关值低的数据点从索引点集中去除。通过这一步骤可以完成对索引点集的优化,因为标记点中大部分是正确的,如果索引点集中出现与其它索引点综合相关值低的情况,则这个索引点可能是目标数据点,将其标记为背景索引则是错误的。 3.2图像块显著性检测 首先对每一个图像块进行一定范围的扩展,使其扩展后能够包含一部分其他图像块的内容,将扩展图像块中靠近边界的一定范围内的像素作为背景索引点。大部分像素或数据点之间是没有直接联系的,因此W中大部分元素值为0,按照等式(7)计算数据点之间的边的权值。 (7) 其中:ci,cj是第i,j个像素点在CIELAB颜色空间中的坐标,权值按照像素点之间的颜色空间距离进行计算[32-34]。σ是权重控制因子。本文将每个图像块中4个边界附近的像素标记为4组背景索引点集,因为每组索引点集间存在的特征不同,所以针对每一组边界背景索引点集图像块都会获得相对应的显著性映射图像。将对应4组索引点集的显著性映射图像分别记为ST(顶部),SB(底部),SL(左侧),SR(右侧),计算4个显著性映射矩阵的点积作为图像块的最终显著性映射Sbq,如等式(8)所示。 Sbq(i)=ST(i)×SB(i)×SL(i)×SR(i), (8) 其中:Sbq(i)表示第i个像素基于背景索引的综合显著性值,ST(i),SB(i),SL(i),SR(i)表示第i个像素和对应的索引组的显著性强度,取值在0~1之间。基于背景索引的显著性映射为Sbq,则基于前景的显著性映射为Sfq=1-Sbq。 在舰船显著性检测时,统计分析Sfq的值域发现,显著性映射图像中的大部分像素属于背景像素,本文根据文献[35]进行图像背景拟合,拟合阈值公式如等式(9)所示。 T=Cu+σ(C=1,2,2.5), (9) 其中:C的取值越大,获得的图像显著性精确度越高,但是查全率会相应降低。u的值在数值上略小于图像显著性的均值,为了计算简便,本文按式(10)计算阈值。 T=C·mean(Sfq)(C=1,2,2.5). (10) 当图像中的目标在整幅图像占较大比例,为大目标时,由于目标颜色的多样性,每个小图像块包含的区域边界可能是不同颜色的另一块目标区域,颜色距离与空间距离都不如与背景像素的差距大,因此获得的显著性区域面积会相应变大。适当增大阈值能够提高检测精度。 图3给出了本文算法的大目标显著性检测结果图。从结果来看,当阈值过小时,显著性结果会包含大量背景像素,随着阈值增大,背景像素被过滤,阈值过大则会造成目标像素丢失。 在本文实验中,对所有舰船目标均取C=2。图像块显著性检测示例结果如图4所示。 图3 不同阈值下大舰船目标显著性检测结果 图4 目标真实位置与显著性检测结果 在每个图像块获得显著性映射结果中往往只包含目标舰船的一部分。如图4所示,而多目标显著性检测的目标是检测更多更完整的目标显著性区域。 图 5 扩展的图像块 图5中方框是对图像中颜色相似区域扩展后的标记,图像块之间存在共同区域,如果认为在共同区域,每个图像块的显著性值具有相同的贡献,则共同区域中每个图像块的权重为Wx,y=1/nx,y,nx,y是共同区域中图像块的个数,则图像中某像素点(x,y)的显著性值可通过等式(11)来求取。 (11) 其中:n是对最终显著性值有贡献的图像块个数,wi是第i个图像块的贡献权重。Si是第i个图像块的显著性值。实验结果表明,通过本文对图像块显著性区域的融合能够获得较好的多目标显著性区域,并且包含很少的背景区域。本文算法概述为算法1. 算法1多舰船目标显著性检测 输入:图像和相应参数 (1)计算图像块的超像素,以超像素为数据点构造图G。计算图的相关对角矩阵D和边的权重矩阵W; (2)计算(D-αW)-1并将对角元素设置为0; (3)将图像块的4个边缘像素分为4个背景索引组,计算图像块对应4组索引的显著性映射; (4)计算图像块4个显著性映射矩阵的点积,获得每个图像块的显著性映射矩阵Sbq; (5)计算图像块的前景显著性矩阵Sfq=1-Sbq; (6)利用权值矩阵W融合图像块的前景显著性映射矩阵获得Sfinal; 输出:多舰船目标显著性映射图像。 5.1显著性结果对比 实验在互联网上获得的一系列多舰船目标图像中进行,并将本文算法结果和当前比较先进的其它显著性检测算法进行了效果对比。对比的方法主要有GBMR[28], ITTI[18], GB[11], IR[19], AIM[20], RC, HC, LC[21], FT[22], SR[23], PQFT[24], SUN[25], GC[26], CA[1], BMS[27],图6,图7和图8是处理图像集中具有代表性的部分结果对比。 (a)原始图像(a)Original images (b)真实目标(b)Real targets (c)ITTI(c)ITTI (d)AIM(d)AIM (e)RC(e)RC (f)HC(f)HC (a)原始图像(a)Original images (b)LC(b)LC (c)FT(c)FT (d)SR(d)SR (e)PQFT(e)PQFT (f)GBMR(f)GBMR (a)原始图像(a)Original images (b)SUN(b)SUN (c)GC(c)GC (d)CA(d)CA (e)BMS(e)BMS (f)Ours(f)Ours 由于ITTI[18]利用像素邻域内的对比度进行显著性计算,漏检了较多目标显著性像素;AIM[20]是基于视觉注意机制进行计算的,对所有造成视觉差异的像素都进行保留,故包含了很多背景像素; RC[21]首先采用Grabcut进行目标区域获取,然后进行显著性检测,当目标间存在较大间隙时,具有较好的表现,然而对于较小目标Grabcut存在严重漏检;FT[22]在频域上对图像像素进行分类,具有高频率的像素区域将被保留,目标边界位置保留较好,但平滑目标区域存在大量漏检;PQFT[24]是基于FT的一种改进算法,存在和FT同样的弱点,即对频域变换较为敏感,显著性结果存在大量零散碎片,目标间的区分度也不明显;GBMR[28]将整幅图像作为一个检测区域,只利用了图像中4个边界的像素作为背景索引,对多目标图像中颜色多样性利用不足,容易将边界目标作为背景处理,从而造成严重漏检;SUN[25]以空间场景作为引导,利用人眼运动机制对图像中显著性像素进行检测,对噪声异常敏感;GC[26]利用图像全局区域内的像素做显著性对比计算,能够很好地检测图像中的显著区域,但是对于大片背景区域,显著性计算值同样较大,易将大片背景作为目标显著性区域;CA[1]算法利用上下文感知进行显著性检测,而海面舰船场景中,天空与海面的高亮部分内容感知与目标区域十分相似,从检测结果来看,显著性检测结果并不理想;BMS[27]首先利用随机阈值对图像进行二值化,获得二值化图像序列并对序列图像进行显著性检测,再将显著性结果加权叠加获得图像显著性结果。算法降低了目标与周边目标差异的重要性,导致弱小目标在二值化过程中被滤除从而漏检,如图8中BMS处理结果所示,边缘目标几乎没有检测到。 从对比实验结果来看,本文算法考虑到了图像不同区域颜色的多样性,并有效结合了图的结构进行像素相关性计算,能够很好地检测到图像中的多目标显著性区域,尽管在多目标显著性检测结果中带有少量的背景像素,但相比其他算法来说这些像素的数量少之又少。在所有对比方法中,本文算法获得了最好的结果。 本文还采用检测准确率(Precision),召回率(Recall)和综合评测方法(F-score)来评价算法的优劣,设参数σ2=0.1,α=0.99。检测准确率定义为检测到的显著性区域中属于目标的像素占所有显著性区域像素数的比例,如等式(12)所示: (12) 其中:Precision是检测准确率,NStarget是显著性区域中属于目标的像素数,Nsalience为显著性区域中所有像素数的总和。召回率函数如等式(13)所示: (13) Ntarget是真实目标位置所包含的像素总数量。 在实际实验中,检测结果的准确率与召回率是一对矛盾体,准确率高召回率就低,而理想结果应该是两者都高,本文提出用F-score来进行综合评价,表达式如等式(14)所示。 (14) 本文更强调检测的准确率,参考文献[34],设β=0.3。 图9(a)(彩图见期刊电子版)给出了各种对比方法的准确率与召回率对应值曲线,图9(b)(彩图见期刊电子版)展示了各种方法正确检测与错误检测的对应曲线图。从曲线结果来看,本文算法具有最优秀的表现。图10(a)(彩图见期刊电子版)给出了几种对比方法在实验图像集的准确率Precision,召回率Recall与F-score的柱状图。从对比结果来看,本文算法准确率高达92%以上,回调率在78%以上,F-score评价值大于0.7,综合对比,本文算法的效果最优。同时,图10(b)(彩图见期刊电子版)给出的各种对比方法的平均误差值柱状图也显示,本文算法的误差值最低,低于0.05。文中其他几种方法的3种参数的数值对比结果如表1所示,其中RC,SR,AIM,PQFT,SUN等几种方法在正确率上较本文算法稍高,但这几种算法的查全率最高为66.7%,较本文算法的78.2%低了11.5%,综合能力不如本文算法。 表1 对比方法参数评价值 (a)Precision-recall曲线 (a)Precision-recall curves (b)False-positive 曲线 (a) Precision, recall and F-score柱状图 (b)显著性检测结果平均误差柱状图 5.2运行时间 影响本文算法运行时间的因素有两个,一是图像中目标的数量,数量越多耗时越多,二是可能提取的背景图像块,比如对于光照和舰船航行造成的海杂波形成的图像块同样需要时间进行处理。本文实验使用CPU Intel(R) Core(TM) i5-3317U CPU @1.70GHz的计算机和MATLAB2014a进行计算。几种对比方法耗时如表1所示。 从耗时表来看,运算速度最快的是HC[21]算法,HC的不足之处是其多舰船目标显著性检测结果包含的背景像素过多。尽管本文算法对每幅图像的平均处理时间为10.91 s,但是本文算法具有最好的显著性检测结果及参数曲线和最低的平均误差。从准确性优先来考虑,利用本文算法对多舰船目标进行显著性检测具有更加实际意义。本文算法主要利用Matlab代码进行计算,优化成C++代码并利用多线程运算能够获得更快的运算速度。这也是下一步需要进行的工作。 表2 显著性检测方法耗时,代码类型及来源 5.3算法适应性 由于处于海天线上的舰船由于受到天空与海面背景的双重影响,而且海面环境又复杂多变,这些都为舰船目标的显著性检测增加了难度,并且天气和光照的不同都会对算法结果有影响,本节对不同天气条件下海天线附近舰船进行了显著性检测实验,实验参数和其它图像实验一致,实验结果如图11所示。 图11本文算法对海天线附近舰船显著性检测结果 Fig.11Saliency results of ships near sea-sky line by proposed method 从图11中发现,利用本文算法在不同天气条件下对海天线附近舰船进行显著性检测时,目标显著性区域的检测效果较好,然而对于海天线上目标过小且存在多目标重叠的情况,存在一定程度的漏检,而且无法将多目标区分开,但显著性检测区域覆盖率较全,目标区域检测精度较高(如图11第4行第一列图像处理结果)。实验结果表明本文算法具有较强的适应性,这主要源于算法核心思想是计算图像块内目标区域与4组边界像素之间的相关性,即使图像存在一定程度的模糊或不清晰,只要目标与背景存在颜色和亮度差异,本文算法就能够有效区分背景与目标像素,完成显著性区域检测。 本文提出了一种针对多舰船目标的显著性区域检测算法,首先利用颜色相似性将图像中的相邻区域聚类为多个图像块,然后对各图像块进行区域扩展,将边缘像素进行背景索引标记,并计算图像块中像素的显著性强度,采用阈值分割方法获得目标显著性区域。最后,利用图像块之间存在相互重叠的特点,采用加权融合多个显著性图像块的方法进行显著性结果融合,获得多舰船目标显著性图像结果。 本文算法准确率达到92.6%以上,查全率达到78%以上,F-score评价得分为0.7,平均误差低于0.05,几种指数均满足多舰船目标显著性检测的各方面要求。然而本文耗时相对较多,每幅图像的平均处理时间约为10 s,这是下一步需要改进的地方,设想利用C++重新编码并引入并行多线程处理方法对算法进行优化,以提高算法运行效率。 [1]GOFERMAN S, ZELNIK-MANOR L, TAL A. Context-aware saliency detection[J].IEEETransactionsonSoftwareEngineering, 2012,34(10):1915-1926. [2]RAMIK D M, SABOURIN C, MORENO R,etal.. A machine learning based intelligent vision system for autonomous object detection and recognition[J].AppliedIntelligence, 2014, 40(2):358-375. [3]ITTI L. Automatic foveation for video compression using a neurobiological model of visual attention[J].IEEETransactionsonImageProcessingAPublicationoftheIEEESignalProcessingSociety, 2004,13(10):1304-1318. [4]CHEN T, CHENG M M, TAN P,etal.. Sketch2Photo: internet image montage[J].ACMTransactionsonGraphics, 2010, 28(5):89-97. [5]RUAN X C O C. Image saliency map determination device, method, program, and recording medium: EP2797051[P]. 2014. [6]WEI Y, FENG J, TAO L,etal.. Salient object detection by composition: US, US8989437[P]. 2015. [7]GOPALAKRISHNAN V HU YQ, RAJAN D. Random walks on graphs for salient object detection in images[J].IEEETransactionsonImageProcessing, 2011,19(12):3232-3242. [8]LIU T, YUAN Z J, SUN J,etal.. Learning to detect a salient object[J].PatternAnalysis&MachineIntelligence, 2010,33(2):353-367. [9]LU Y, ZHANG W,LU H,etal.. Salient object detection using concavity context[C].IEEEInternationalConferenceonComputerVision.Milpitas,CA,2011:233-240. [10]WANG L, XUE R, ZHENG N N,etal.. Automatic salient object extraction with contextual cue[C].IEEEInternationalConferenceonComputerVision(ICCV),Barcelona,Spain, 2011:105-112. [11]HAREL J, KOCH C, PERONA P: Graph-based visual saliency[J].AdvancesinNeuralInformationProcessingSystems, 2006,19:545-552. [12]ACHANTA R, ESTRADA F, WILS P,etal.. Salient region detection and segmentation[J].LectureNotesinComputerScience, 2008:66-75. [13]CHENG M M, ZHANG G X, MITRA N J,etal.. Global contrast based salient region detection[C].IEEEInternationalConferenceonComputerVision.Milpitas,CA, 2011:409-416. [14]ECONOMOU P, TZAVELAS G. Kullback-Leibler divergence measure based tests concerning the biasness in a sample[J].StatisticalMethodology, 2014, 21(11):88-108. [15]XIE Y L, LU H C, YANG M H. Bayesian saliency via low and mid level cues[J].IEEETransactionsonImageProcessing, 2012,22(5):1689-1698. [16]FRANCOIS A R J,SCHULTZ J. Image processing based on depth information and color data of a scene:US, US8823745[P]. 2014. [17]WU B, XU L. Integrating bottom-up and top-down visual stimulus for saliency detection in news video[J].MultimediaTools&Applications, 2014, 73(3):1053-1075. [18]ITTI L, KOCH C, NIEBUR E. A model of saliency-based visual attention for rapid scene analysis[J].IEEETransactionsonPatternAnalysis&MachineIntelligence, 1998,20(11):1254-1259. [19]HOU X D, HAREL J, KOCH C. Image signature: highlighting sparse salient regions[J].IEEETransactionsonPatternAnalysis&MachineIntelligence, 2012,34(1):194-201. [20]ITTI L, KOCH C. Computational modelling of visual attention.NatureReviewsNeuroscience[J],2001, 2:194-203. [21]CHENGM M.Saliencyandsimilaritydetectionforimagesceneanalysis[D]. [Ph.D. dissertation], Tianjin:Nan Kai University, 2012: 33-56. [22]ACHANTA R, HEMAMI S, ESTRADA F,etal.. Frequency tuned salient region detection[C].IEEEInternationalConferenceonComputerVisionandPatternRecognition,Miami,Florida,USA,2009:1597-1604. [23]HOU X, ZHANG L. Saliency detection: a spectral residual approach[C].IEEEConferenceonComputerVisionandPatternRecognition.Portland,Oregon,USA, 2013:1-8. [24]GUO C, MA Q, ZHANG L. Spatio-temporal Saliency detection using phase spectrum of quaternion fourier transform [C].IEEEComputerSocietyConferenceonComputerVisionandPatternRecognition,Anchorage,Alaska,USA,2008: 1-8. [25]CASTELHANO M S, HEAVEN C. Scene context influences without scene gist: Eye movements guided by spatial associations in visual search [J].PsychonomicBulletin&Review, 2011, 18(5):890-896. [26]CHENG M M, ZHANG G X, MITRA N J,etal.. Global contrast based salient region detection [J].IEEETransactionsonPatternAnalysisandMachineIntelligence, 2015, 37(3):409-416. [27]ZHANG J, SCLAROFF S. Exploiting surroundedness for saliency detection: a boolean map approach [J].IEEETransactionsonPatternAnalysis&MachineIntelligence, 2015:1-1. [28]YANG C, ZHANG L H, LU H C,etal.. Saliency detection via graph-based manifold ranking [C].IEEEConferenceonComputerVisionandPatternRecognition.,Portland,Oregon,USA, 2013:3166-3173. [29]ZHANG X, CAHILL N D. SLIC superpixels for efficient graph-based dimensionality reduction of hyper spectral imagery [C].SPIEDefense+Security,InternationalSocietyforOpticsandPhotonics,Baltimore, USA. 2015:1-4. [30]BAHETI P K, BARMAN K K, KRISHNAMOORTHI R,etal.. Identifying a maximally stable extremal region by skipping comparison of pixels in the region, WO 2014014687 A1[P]. 2014:23-35. [31]XU M, ZHANG H. Saliency detection with color contrast based on boundary information and neighbors[J].VisualComputer, 2014, 31(3):355-364. [32]LI B, LI R H, KING I,etal.. A topic-biased user reputation model in rating systems [J].Knowledge&InformationSystems, 2015, 44(3):581-607. [33]ANDREW Y NG, MICHAEL I. Jordan and YAIR Weiss. on spectral clustering: analysis and an algorithm [P]. 2002,2:849C856.[34]ZHANG W J, XIONG Q Y. Image salient region detection algorithm based on contrast and spatial location[J].JoumalofUniversity:EngineeringandTechnologyEdition, 2015, 45(5):1709-1716. [35]陈维真, 张春华, 周晓东. 基于局部直方图高斯拟合的星图背景性质研究[J]. 红外技术, 2008, 30(4):230-233. CHEN W ZH,ZHANG CH H, ZHOU X D. Study of star-sky image background characteristics based on local-histogram gaussian fitting method[J].InfraredTechnology, 2008, 30(4):230-233.(in Chinese) 郭少军(1985-),男,湖南洞口人,助理工程师,博士研究生,2008年、2011年于海军航空工程学院分别获得学士、硕士学位,主要从事目标检测与识别,计算机视觉等方面的研究。E-mial: guoba2000@163.com 娄树理(1976-),男,山东蒙阴人,博士,副教授,2004年、2011于海军航空工程学院分别获得硕士、博士学位,主要从事多源目标成像技术,目标检测与识别等研究。E-mail:shulilou@sina.com. (版权所有未经许可不得转载) Multi-ship saliency detection via patch fusion by color clustering GUO Shao-jun*, Lou Shu-li, LIU Feng (DepartmentofControlEngineering,NavyAeronauticalEngineeringUniversity,Yantai264001,China) *Correspondingauthor,E-mail:guoba2000@163.com Because the boundary pixels are easy to be classified as a background in the multi ship target detecting processing, this paper proposes a multi-ship saliency detection method based on patch fusion by color clustering. Firstly, this method detects the color similarity of the pixels in the neighbourhood, and the adjacent pixels with the similar color are gathered as an image patches. Then, the image patches are expanded to make them include some pixels of other patches, so as to enhance the contrast value of the pixels of patches. Then, edge pixels are marked in the background index to calculate the saliency ability of the pixels in image patches and the threshold segmentation method is used to obtain the saliency region of the target. As the image patches have the features of partial overlap, the weight values are used to fuse the saliency images with the partial overlaps, so that the saliency detection results on a whole image for the multi-ship targets are obtained. The experimental tests are carried out for the multi-ship target images, and the results from the proposed algorithm in this paper and the current advanced detection algorithms are compared. The results show that the proposed method based on patch fusion by color clustering has the recall rate more than 78%, the accurate above 92%, and its comprehensive evaluation indexFβis more than 0.7. Both for comparisons of the single index or the entire indexes in this experiments, the algorithm is superior to other methods. multi-target detection; saliency detection; ships; image patch; color clustering 2016-04-27; 2016-05-31. 国家自然科学基金资助项目(No.61303192) 1004-924X(2016)07-1807-11 TP391 Adoi:10.3788/OPE.20162407.18073 图像块的显著性检测

4 多舰船目标的显著性检测

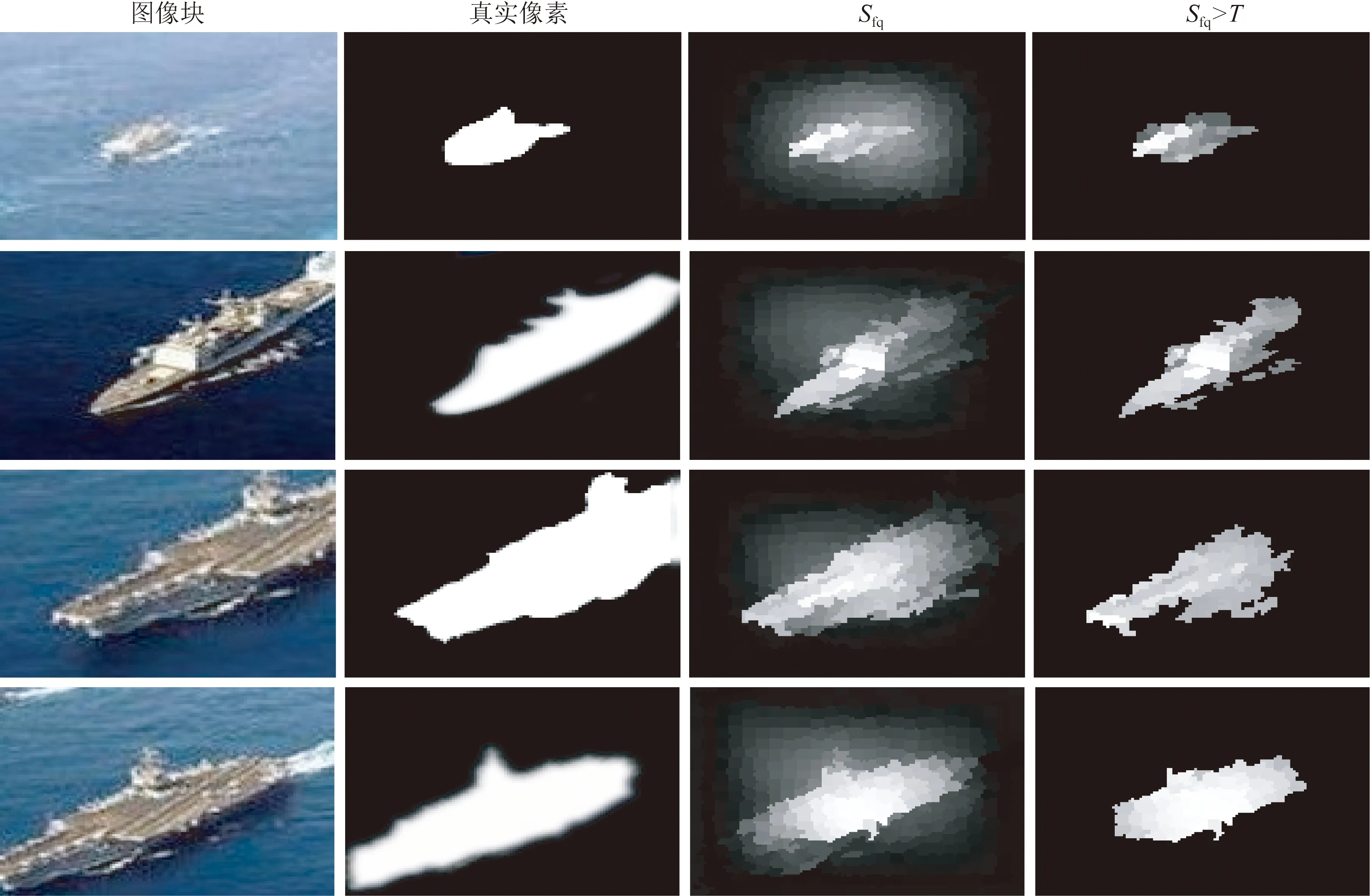

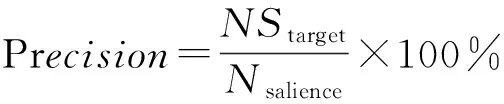

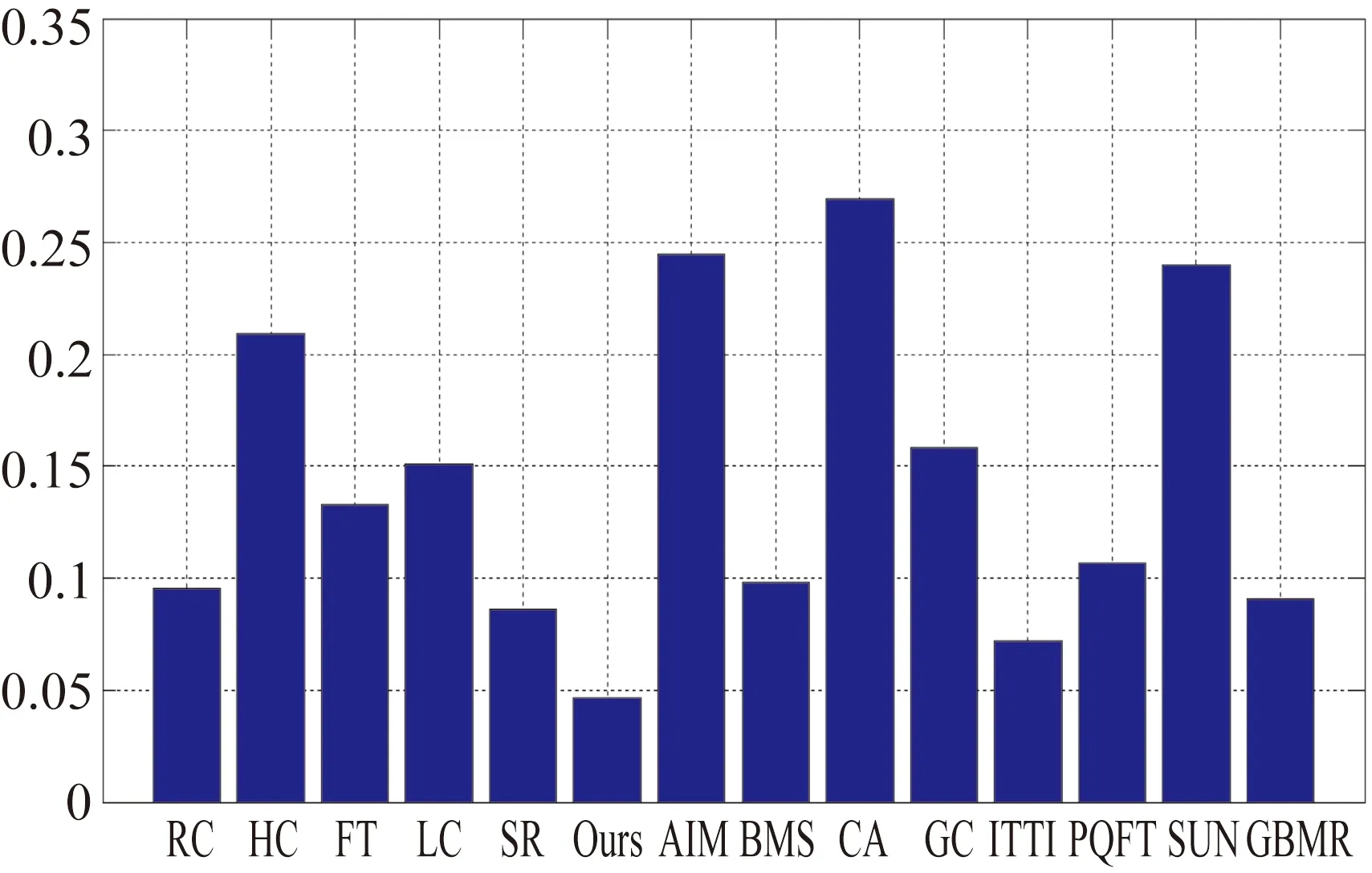

5 实验与分析

6 结 论