分布式集装箱数据中心的绿色层次化管理

侯小凤 宋朋涛 唐伟超 李 超 梁晓峣

(上海交通大学计算机科学与工程系 上海 200240)

分布式集装箱数据中心的绿色层次化管理

侯小凤宋朋涛唐伟超李超梁晓峣

(上海交通大学计算机科学与工程系上海200240)

(xfhelen@sjtu.edu.cn)

摘要近几年,模块化数据中心(集装箱数据中心)因其高能效可拓展的特点而成为极具前景的IT基础设施解决方案.预定制的集装箱数据中心不仅可以被部署在传统仓库级数据中心设施中以支持容量扩展,还能够被部署在城市郊外以支持物联网数据的本地处理.把传统集中建设和管理的数据中心与地理上分布的模块化数据中心结合起来,能够更加方便地利用本地绿色能源发电以及减少数据传输成本.针对目前涌现的地理上分布的集装箱式数据中心模块提出了一种新型分层化管理模式,该技术将分布式集装箱数据中心逻辑上划分成多个性质和功能不同的层级.一个中央调配系统被用来监控每个层级的集装箱数据中心并施加动态休眠机制以进一步提升数据中心的整体效能.小规模测试实验结果显示分层化管理机制能够提升12%~32%的数据中心整体能效,并且保持较高的服务性能.

关键词云计算;集装箱数据中心;绿色计算;分层管理;性能评估

随着物联网技术的飞速发展和各式智能终端的增加,传统中央式“云”数据中心已无法适应目前信息处理的需要.此处的关键原因在于,越来越多的信息处理任务将围绕来自于不同位置的分布式物理设备,如传感器网络、监控摄像头、移动基站、智能仪表等.随之而产生的分布式数据流如果全部汇集到中央“云”数据中心进行处理,将不可避免地面临阻塞, 造成两大问题:1)传统数据中心受能耗和温室气体排放的限制,难以自由扩展其计算资源以应对不断汇集的数据处理需要.据统计早在2007年全球数据中心二氧化碳排放量已超过1亿吨[1],碳足迹(carbon footprint)动态检测已经成为许多数据中心的必要手段[2].2)海量数据传输不但造成高昂的网络费用,还极大地增加了决策延迟和时间成本[3],即便是利用低速网络上传一部分数据,2014年1月份亚马逊公司数据传输价格也高达每兆60美元.因此,面对“互连网+”引发的分布式大数据的处理浪潮,探索一种与目前数据中心互补的、能够有效降低数据传输开销并借助新能源来驱动的绿色信息处理模式变得尤为关键.

面对人们不断增长的计算需求和传统数据中心资源日益紧缺的问题,集装箱式数据中心(containe-rized datacenter)有望成为重要的IT基础设施解决方案.集装箱易于扩展,可以快速部署在使用者指定的适当位置,部署通常只耗费几周时间.相比之下,建造传统的数据中心因为机房建设涉及的基建、供电、制冷、电信等复杂因素而往往需要几个月甚至几年.此外,集装箱数据中心因为优化了内部散热通道因而具有较高能效优势.

基于集装箱数据中心以上特点,本文探索一种混合了传统集中建设的大型数据中心与基于集装箱部署的地理分布式微数据中心模块的泛在化数据处理系统.这种混合式数据中心的好处是双重的:一方面,分布式的集装箱数据中心可以解决中央数据中心因数据流大规模涌入造成的网络带宽瓶颈问题,实现数据密集型应用的就近处理,避免数据传输开销,提升决策速度.另一方面,虽然大规模的新能源发电与并网存在技术挑战和成本问题,许多因地制宜的小型可再生能源发电设备却得到了广泛应用;而分布式集装箱数据中心因其体积较小可以采用本地的新能源装置或者储能电池为其供电;因此分布式微型数据中心也有助于整个信息行业对环保可再生能源的有效利用.

但是即便如此,对于分布式集装箱数据中心而言,缺乏合理的结构规划与运营管理同样会造成严重的资源浪费.最直接的结果是导致如传统数据中心中类似的服务器平均利用率低下的问题.为此,本文研究如何优化分布式集装箱数据中心集群以达到进一步节能的目的.

我们借鉴集装箱数据中心集群面临的网络延迟状况将集装箱数据中心集群在逻辑上划分成分层结构,层数越高的数据中心其访问开销也更大.我们进而结合用户应用的访问热度来为不同层级的数据中心分配任务.每一层保留特定的数据和处理的任务,距离用户层次越“远”的集装箱数据中心其处理的任务优先级越低或者仅仅保存一部分冷数据.最“远”点则汇合至传统数据中心,可以用作长期保存数据使用.最后,我们针对不同层级的数据中心采取动态集中休眠策略.高层次的数据中心不必要保持24×7的在线时间,这样做可以极大地节省混合式数据中心生态系统的整体效能,并不会造成明显的性能影响.

1集装箱数据中心现状

集装箱数据中心一般指的是将服务器和供配电基础设施置入一台可移动的大型集装箱或固定空间中的数据中心,也常被称为模块化数据中心(modular datacenter)或便携式数据中心(portable datacenter).这种预制的小规模数据中心相对传统数据中心概括起来具有两大优势:

1) 集装箱数据中心易于扩展.集装箱可以部署在采用者指定的适当位置,且它们通常可以非常迅速地在几周时间内部署完毕;相比之下,建造传统的数据中心通常得需要几个月甚至几年.通过添加集装箱数据中心、预制单位或建筑面积我们能够方便地扩展计算容量.

2) 集装箱数据中心节能经济.模块化数据中心可提供恰如所需的供电、冷却和计算能力.对传统开放式数据中心及建筑大楼来说,不同的设备(例如服务器、配电系统以及供暖、通风和空调设备等)在设计时都要考虑到最差情况,所以在设计余量中存在着严重的成本浪费.

世界上第1款集装箱式数据中心是Sun公司2007年推出的BlackBox,包含250台服务器和超过2 PB的磁盘存储,计算能力强大.相对于建设一个同样规模的传统数据中心,Blackbox只需110的时间和1%的建设成本[4].目前一些主流的模块化数据中心设施生产商包括Sun,HP,IBM,SGI等公司.这些集装箱数据中心都具有比较高的能源效益(PUE 1.2~1.3)和可观的计算容量[5-6].

最初集装箱数据中心的主要设计优化是通过特有的冷热通道隔绝来提升整体能效.如果按照冷却装置的部署特点可以大致分为3类[7]:1)以HP公司POD集装箱数据中心为代表的顶上冷却架构,该结构中制冷装置被装在服务器机柜上,由上向下提供冷气;2)SIG公司的ICE Cube,其采用的是行间冷却架构,制冷装置被安装在机柜靠内的一侧,这样两排机柜之间形成了一条冷气流通道,而它们的另一侧则是热气流通道,最后冷热气流交换实现了整个系统架构的制冷;3)Sun公司所采用的行间循环冷却架构,此时制冷装置被安装在同行机柜之间的前后侧,这样在每个机柜周围都形成了循环的冷热气流交替.

后期集装箱数据中心设计开始向更加灵活且可扩展的方向发展.比如爱默生公司的SmartCabinet[8]实现了机柜级别的细粒度模块化解决方案.一个标准机柜内包括所有IT设备所需的恒定运行条件,占地仅0.7~2 m2,可在1 d内部署完,能够提供22U服务器空间(约5 kVA)的容量. Dell公司的Humidor[9]系统则独辟蹊径地提出了2个集装箱的纵向堆叠架构:底层集装箱具有24个全尺寸的机架来提供IT设备;顶层的双集装箱提供电力的转换、测量、分配、以及非易失性电源和致冷散热系统.这种设计尤其方便IT架构师和设施维护师互不干扰地同时作业.此外,Datapod公司的模块化数据中心解决方案则更注重可重构性[10].运营商可以根据有机地借助预定义的多种计算设备与基础设施的模块来搭建成多种容量的集装箱化数据中心.

以往关于模块化数据中心部署的研究主要集中于各模块间的网络互联与优化.Bcube[11]是一个具有代表性的针对数据密集型应用的数据中心网络优化设计,其特点是能够借助商用迷你交换机来实现高效经济的模块间通信.与之类似的技术还有MDCent[12],一种数据中心模块之间的互连结构.以及EBSN[13],借助尽可能少的网络资源来实现适用于模块化数据中心的高可靠网络架构.另一方面,meGautz[14]则创新地规定了不同模块的网络流量,动态平衡负载数量,并对集装箱内部和外部的网络进行隔离,从而有效避免了它们之间的带宽冲突,使得各自拥有比较高的网络吞吐量.在其它方面,微软的研究人员则具体借助Markov过程对集装箱承载的服务器可靠性进行了分析[15],率先提出了针对模块化数据中心的一般性设计方法.佛罗里达大学的研究人员则调研了数据中心集装箱的散热效率问题[7].目前,针对模块化数据中心的能效优化的研究非常有限,尤其是在和传统数据中心之间的相互配合与调度之上.

2混合式数据中心系统

传统数据中心一般是将电信机房与供电设备和制冷装置统一建立大型计算中心.它们承载着大规模的计算资源,是云计算的重要基础设施,占据着服务器市场的主要份额.然而,集装箱数据中心所具有的得天独厚的优势正不断促进中央式大数据中心与分布式微数据中心的协同部署和应用.

2.1传统设计的局限性

传统数据中心的一个显著局限性是缺乏充足的电力供给,尤其是可持续获得绿色能源.为了提供稳定的信息服务,数据中心需保持(24×7 h)地运行,因而消耗大量的电能.据估计,全球互联网数据中心的用电功率可达300亿瓦特[2],相当于30个核电站的供电功率.伴随庞大能耗而来的不仅是巨大的电费开支,还有能源危机与环境问题.为此,许多IT公司都开始发展新能源发电系统用于建设绿色数据中心[16-18],包括惠普、微软、Google、Facebook、苹果等;在国内,阿里巴巴也将在河北建设绿色数据中心(建筑外表覆盖太阳能电板、购买风能),同时采用自然风冷和水冷系统[19]

然而,一味地为传统数据中心增设新能源设备并不能解决数据中心的可持续发展问题.受周边资源的天然限制,任何一个大型数据中心厂址都无法从本地获取大规模可持续的新能源供给.在现有情况下,传统数据中心依赖于从远处电厂调度电能.事实上,在2010年Google公司为了绿色环保地驱动其俄克拉何马州的数据中心而买下了爱荷华州风力发电厂20年的发电量[20].这一过程不仅受电网架设的限制,还带来极大的能源传输损耗.

此外,传统中央式数据中心如果不改变自身的IT架构,将难以应对负载应用激增带来的冲击.近些年各种物联网应用快速发展,生产了大量的数据.这些数据需要通过网络直接传到数据中心进行处理,其结果是来自四面八方的数据不论大小、不分时刻地涌入数据中心,给数据中心网络和计算单元带来了严重的负担.高峰期间的数据传输会造成网络带宽资源紧缺.负载种类的复杂性会增加任务相互间的干扰[21],进一步降低能效和性能.

2.2混合式设计的挑战

传统数据中心的局限性势必会促进低成本可扩展的集装箱数据中心的发展.利用集装箱易于部署的特点,可以为传统大型数据中心配备分布式的微型数据中心,从而构建一种混合式的数据中心系统.如图1所示,在给定传统大型数据中心之外,这些集装箱式数据中心规模有大有小,且能源供给方式也不尽相同.有的是多个集装箱集群构成的中型数据中心,利用配套的智能微电网驱动自身运转;有的是小型独立集装箱数据中心,采用因地制宜的绿色能源供电(风能、太阳能、生物能源).

Fig. 1 Hybrid green datacenter ecosystem.图1 混合式绿色数据中心生态环境

这种基于地理上分布的微型数据中心的泛在化数据处理系统在大数据时代具有重要意义.这是由于分布式的微型数据中心可以充分使用当地已存的绿色能源来驱动自身的运转,解决数据中心用电难、不环保的问题;与此同时,大规模的用户应用请求不必同时涌向某个单一数据中心,而是被分配到合适的本地集装箱数据中心上进行处理.这样不仅能缓解单一数据中心数据拥堵问题,还能缓解计算负荷过大和用电密度过高的压力.

值得注意的是,虽然混合式设计能够带来以上的好处,任意分派的用户请求并不能很好地解决能源浪费以及网络代价过高的问题.因为没有合理的结构规划,混合式数据处理系统中仍然存在能源利用率不高、服务器能效低下的问题.导致的结果最终只不过是能源浪费和网络拥堵从中央式数据中心转移到了分布式的集装箱数据中心.因此,建设混合式数据中心系统面对两大挑战:1) 如何提高对能源的利用效率;2) 如何调度负载从而保证性能.

3分层化设计

为实现对混合式数据中心的调度和管理,本节探索一种分层化的集装箱数据中心组织架构.

3.1逻辑分层架构

数据中心应用服务存在多元性和多样化.有的用户请求需要较短的计算时间且对响应速度要求比较高,而有的用户请求处理时间冗长但对响应速度却没有太严格的要求.根据数据中心部署地理位置的网络性能情况,我们可将数据中心群首先划分为不同的层,距离用户层次越“近”的数据中心处理的任务的优先级高,层次越“远”,处理任务的优先级更低,最“远”点则汇合在传统数据中心,基本不处理任务请求,用作保存大量存档数据.

在图1展示的混合式数据中心系统中,B,C,D等地区网络设施比较齐全,数据流通过网络能够很快上传到该位置上的集装箱数据中心,因此我们认为把它们离用户很“近”,由它们共同组成的数据中心层也被定义为边缘层,用于处理用户交互比较活跃的请求,它们可以配置一些能效比较高、性能比较好的服务器;而A,G,J等地区网络资源不是很便利,并且该地区用户活跃度也不是很高,因此可以作为边缘层的上一层,处理一些对响应时间不敏感的应用,这些数据中心配置一些中端服务器就可以基本满足服务性能要求;F是导航数据中心,基本不用于用户交互,主要负责层与层之间的通信和状态查询,以及保存大数据时代日益增长的冷数据,因此它可以配置低端经济的服务器.

上述系统的分层结构特点可以用图2来表示:最下面一层是边缘层,是距离用户应用最“近”的数据中心层,该层主要用于处理那些紧急、活跃的任务.这部分任务数据往往是通过高速网络上传到这一层,因此可以满足对性能要求严格的应用的需要;根节点代表导航数据中心,在距离用户最“远”的层次上,所有的数据或处理过的数据都将通过廉价的慢速网络最终被送到导航数据中心中保存以便日后分析研究;实线连接表示下一层的数据中心可以通过网络直接将任务请求转发给上一层计算中心处理,也就是说对于非导航层的其它层之间,当下一层计算资源紧张,则可以将任务转发到上层数据中心进行计算;同层的数据中心之间传输代价非常高或者缺乏连接.当下层数据中心转发任务请求过程中,如果上层数据中心资源不够或者处于休眠状态,则考虑将任务转发给同层数据中心进行计算.

Fig. 2 An example of layered structure.图2 层次化结构举例

在未来大数据爆发的时代,数据被访问的频率以及模式将成为影响底层硬件工作状态的重要因素.在分层组织的结构下,不同数据层之间用于传输的通信性能不同,并且数据根据它们需要被处理的紧急程度可以被分成“热”数据和“冷”数据[22].“热”数据即用户交互频繁的应用请求使用到的数据,这部分数据量比较紧急并且数量相对比较少,使用较快速的网络传送到较“近”的数据中心层进行处理;“冷”数据指那些对响应时间要求不高的请求所使用的数据以及那些暂时不需要处理但是可以被存储起来以便日后分析的数据,这部分数据未来将日益增加,可以利用慢速网络在网络空闲(比如说凌晨)时上传到“远”层进行处理或存档.

3.2系统优势分析

分层结构具有显著的潜在性能优势.1)分布式的数据中心可以将大规模的应用数据分散开来传输和处理,不仅可以减少网络拥堵,而且能够缓解数据中心集中式处理负担过大的问题,可以提升计算性能.2)由于紧急任务不再耗费大量网络资源和时间代价传到中央数据中心处理,而是直接被分派到更高效距离更“近”的数据中心上处理,这种分类分层的处理方式可以减少任务的等待时间,进一步提升数据中心的处理性能.3)利用慢速网络代替快速网络传递大部分非紧急数据,还节约了网络基础设施的建设和运营成本;而非紧急数据放在空闲时传输对任务本身来说影响较小.

如果对分层结构采取更进一步的分析和优化,可以获取很高的能效优势,理由如下:分层结构根据不同应用的性质将它们部署在不同的层次上进行处理,因此边缘层必须保持24×7 h在线以保证与用户交互频繁的应用的正常运行;但是越往里层,处理的用户任务对时间相应要求越低,因此服务器也不必时时在线,可以根据负载性质情况动态选择关闭一部分计算单元;导航数据中心基本不处理用户任务,只是负责通信和数据存储,因此只需要保持负责通信管理的计算单元在线,将其他计算单元周期性的关闭即可.换言之,如果我们针对集装箱数据中心采用集中动态休眠的策略,就可以极大地提升分层结构的能源利用效率.

4动态调度

4.1集中休眠

在本文的分层结构中,边缘层(近层)须保持实时在线,但是高层级(远层)的集装箱数据中心可以根据负载状况动态调整服务器的在线状态.

分层组织的混合式数据中心可以采用一种动态集中休眠的策略来进一步解决能源利用率的问题,获取更大的能效优势.具体调度过程如图3所示.

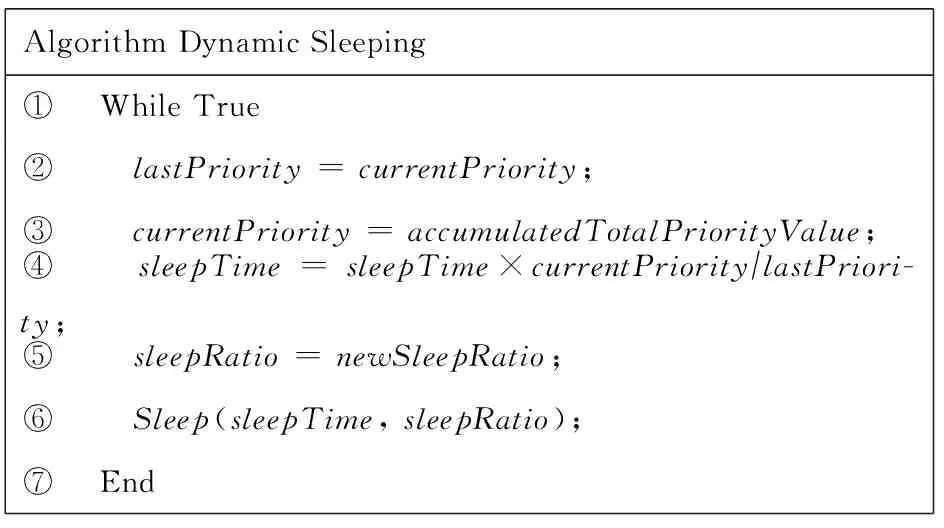

该算法思路是把任务按照它们的性质分配不同的优先级,每个优先级对应一个优先级权值,优先级越高其权值也越高.优先级权值的总和临界值一般交由数据中心管理人员决定,而处理中心的休眠时间和休眠率由优先级权值总和确定,也就是说管理人员可以根据需要自由控制分层数据中心中服务器的动态休眠比率和时间.如果对应任务队列优先级权值总和比较低,则该层次集装箱数据中心会比较频繁地进入休眠状态,反之如负载优先级增长,系统则动态减少休眠时间和休眠比率.在此管理模式下,集装箱数据中心群会形成一种服务器在线时间逐层下降的局面.由于数据中心系统不再维持长时间的空闲运作,其整体能源消耗会极大降低.

AlgorithmDynamicSleeping① WhileTrue② lastPriority=currentPriority;③ currentPriority=accumulatedTotalPriorityValue;④ sleepTime=sleepTime×currentPriority∕lastPriori-ty;⑤ sleepRatio=newSleepRatio;⑥ Sleep(sleepTime,sleepRatio);⑦ End

Fig. 4 Program flow diagram of request.图4 请求处理程序流程图

Fig. 3Unified dynamic sleeping strategy.

图3集中动态休眠策略

4.2请求处理

混合式数据中心的分层结构中,用户请求被首先分配到边缘层.随后,根据用户请求的紧急程度和数据的冷热程度,低优先级的任务会逐渐被推送到较远端的数据中心层处理和存储.如果某一层不能满足用户数据处理所需要的计算资源,则该任务也会被转发到上层处理,如果上层不能处理,才考虑转发给同层的数据中心进行处理.

在整个请求处理过程中,每个数据中心容器配置一个控制器,其主要任务是管理该容器中服务器的动态休眠以及处理新任务请求和完成任务转发.控制器是独立于数据处理中心运行的,采用低功耗的高可靠性嵌入式系统模块配备后备能源来运行.图4描述请求处理过程.每个数据中心收到的请求可能来自2个方面:1)数据中心的下级站点(对于边缘层的集装箱来说,其下级站点就是不同的智能终端);2)除下级站点的其他站点.将这2类请求区分的原因是,控制器对于这2类请求的处理优先级是不同的.下级站点的任务请求要优先于其他站点的处理请求,当某个数据中心满载或者休眠时,控制器会将其标记为Bypass状态.

在实验中,我们模拟了3层系统结构,每层处理2种处理来源不同的任务,因此形成了2×3种不同的优先级.我们首先将下级站点的任务优先级划分为较高的前3个等级,其次将其他站点的任务请求划分为后3个等级.因而下级站点的所有任务优先级均高于其他站点.从这6个等级中依次派生出6个任务队列储存于控制器之上,为防止优先级较低的任务被饿死,控制器被设计为按一定概率选择任务,任务依据其优先级被选中的概率也不同.

4.3转发处理

数据中心的转发请求发生在自身无法满足本地用户的请求,而且其上级站点同样无法处理请求时.无法处理请求可能是数据中心已休眠或者当前站点正忙.对于转发的处理类似于传统的选择算法,我们首先以当前数据中心为中心划分出一块临近区域,该区域的大小确定依据整个架构的密度来决定,在此区域内控制器搜集各个站点的信息,各个站点的状态由对于数据中心的控制器提供,而该数据中心到临近数据中心的权值由相邻数据中心的繁忙程度确定.相邻数据中心当前负载越高,则到达该数据中心的权值越大.结合数据中心的状态和权值可以确定一个最终权值,若站点离线或繁忙则权值被标记为无穷大.如果某个数据中心无法直达而需要通过其他数据中心进行中转,则到达该数据中心的权值会依据中转次数相应增加.通过以上过程,控制器可以降低整体开销,但如何到达代价最小的数据中心还需要具体的算法保证.

5性能与能耗分析

为了验证分层管理与组织以及引入动态休眠策略给混合式数据中心带来的潜在能效和性能优势,本节将设计实现对它们进行讨论.

5.1实验环境和设计

5.1.1负载选择

我们选择了5种常见的数据中心负载来代表对QoS要求不同的应用服务. 5种应用对应于不同的任务优先级,如表1所示:

Table 1 Workloads

具体描述如下:

1) PerlBench被用来模拟物联网环境下多用户并发访问的场景,该Workload是一个用Perl语言实现的包含垃圾邮件处理、HTML解析器、IO测试等互联网常用应用场景,该应用运行时间较长.

2) Astar应用是一个A*寻路算法的实际应用,多用于游戏中的智能路径寻找.该应用被用来模拟智能导航等应用场景.该算法的复杂性导致了较长的运行时间.

3) TextProcess应用包括大量的IO和CPU操作密集型的任务,例如文件压缩解压缩、文本过滤等,用以模拟物联网环境下大数据的预处理等场景.

4) AudioRecognization为语音识别应用,采用Pocketsphinx的运行库,执行一段语音识别任务,用以模拟物联网环境下采集的音频信息进行后期处理的场景.

5) FaceDetection为图像识别负载, 采用神经网络算法识别图像中的人脸,用以模拟对摄像头采集的图像进行实时处理的场景.

5.1.2设备参数

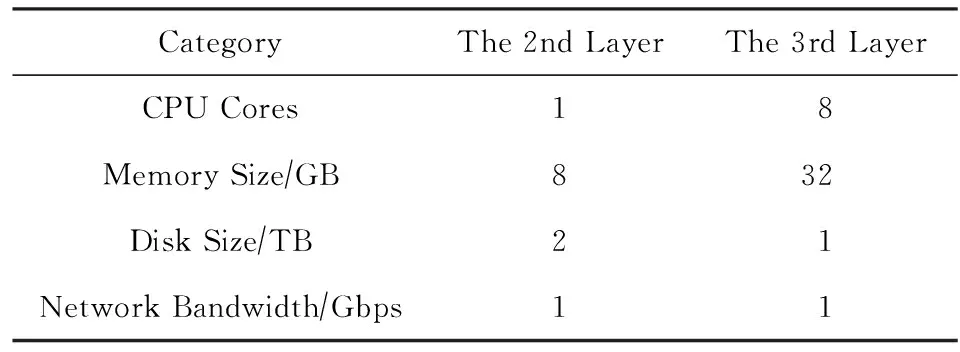

我们利用服务器模拟集装式数据中心,搭建了分层的混合数据中心的一个缩小版的原型.在实验设计中,混合式集装箱数据中心被按分成了不同处理性能的3层,负载将会根据其优先等级部署在不同层的数据中心中,并且所有请求会通过Apache服务器发送给后台PHP进行处理.表2显示了不同逻辑层硬件配置.我们利用3台8核Intel®Xeon®CPU模拟与用户距离最“近”的层次上的数据中心,2台Intel®CoreTMi5 CPU模拟第2层和导航数据中心.客户端的任务则由5个多线程程序来模拟,我们采用单台机器的多个线程进行随机请求发送,根据不同的负载设定不同的请求速率.由于客户端只负责发出请求,它们的能耗并不在实验统计范围之内.

Table 2 Hardware settings

对于每个数据中心都存在一个线程用以填充其任务队列.控制器作为数据中心的控制单元而独立于数据中心的运行,为了满足不同控制器之间、控制器与导航数据中心之间的通信要求,我们将所有计算的运行都在一个局域网内进行,因此通信线路采用1 Gbps的双绞线进行连接.客户端与控制器以及处理中心间的信息交换使用HTTP协议,客户端通过CURL命令将单个请求发送至控制器,控制器根据处理中心状态选择将请求加入队列或者路由至处理中心处理,客户端和处理中心间的数据交换通过基于SSH协议的SCP进行拷贝.控制器与处理中心一一对应,而控制器对于相应的处理中心有完全控制权.为了保证安全,控制器与处理中心间的通信全部采用非对称加密,控制器通过SSH协议公钥访问处理中心.控制器与导航中心通信时采用SOCKET进行信息交换.

5.1.3管理策略

为了验证本文提出的设计优势,我们对比了分层管理的数据中心和未优化的混合式数据中心的性能和能源使用情况.我们采取专业精密功率和电能表对服务器的能耗和功耗进行实时检测,并监测任务等待队列堆积的请求数量来分析其性能.

最终实验包含3种策略:

1) Origin策略.该情况作为实验对比的基准,没有将数据中心进行分层管理,因此也没有引入动态休眠策略.该种情形下,所有客户端依照不同的任务产生速率随机发送请求至控制器,控制器将任务加入等待队列,数据中心不断从等待队列中获取任务并执行.在此种调度策略下,单一数据中心仅服务于固定区域,无法处理的请求会在任务队列内堆积或者造成处理中心低能效运行.

2) Layered策略.相比传统设计,该情况将混合式数据中心进行了分层管理.优先级等级较高的请求被发送到最“近”的层面的数据中心处理,优先级较低的发送到第2层计进行处理,导航中心基本不参与数据处理.下层数据中心不能处理的请求优先发送到上层站点进行处理,若上层站点不能处理则转发至导航数据中心处理;若导航数据中心仍然繁忙,则才转发至同层的数据中心请求帮助.

3) Layered+Sleep.在分层设计的基础上对集装箱数据中心群采用动态休眠政策,具体是最外层数据中心保持24×7实时在线处理用户请求,第2层数据中心和最远点的导航数据中心采用不同的动态休眠政策.此时,转发过程中,如果被求助的对象处于休眠状态,也不能帮助处理,只能继续转发至其它数据中心或者加入等待队列.

5.2实验结果

5.2.1性能分析

图5是实验中测得的任务等待队列中任务数量随时间的变化,其数值越大,说明任务堆积越严重,数据中心性能越低下,越难满足计算需求.

Fig. 5 Monitored performance results.图5 性能监测结果

图5(a)(b)分别是Origin和Layered两种策略下任务等待队列的长度随时间的变化.传统的任务调度模式缺乏对随机到达任务的管制和分配,因而数据中心存在任务分配不均以及一定的任务堆积现象.相比图5(a)、图5(b)中等待队列里的任务能够很快被处理完.这一方面说明分层的组织结构能够很好的提升混合式数据中心的性能,即任务等待时间;另一方面也说明分层情况下计算资源有空闲的余地,即便是被关闭一部分计算资源仍有可能满足计算需求,存在进一步用性能换能效的潜力.

图5(c)和图5(d)展示的是Layered+Sleep策略下的结果.由于计算队列中任务数量变化较大,性能检测显示抖动较大.我们考虑了2种情形:轻度睡眠和深度睡眠.在轻度睡眠情况下,中间层数据中心的休眠频率平均在20%;而在深度睡眠情况下,中间层数据中心的休眠频率平均在50%.可以看到,轻度睡眠的服务器对于一些高优先级负载的队列等待长度影响是较小的,而对于低优先级的任务(MailProcess)影响则比较明显.若进一步增加休眠频率,一些低优先机的任务可能面临不断增加的队列长度,这会影响到队列中每个任务的平均等待时间.虽然低优先级的任务对于响应时间并不敏感,但是如果我们在分层数比较小的情况下施加较为激进的休眠的话会造成比较严重的数据堵塞.

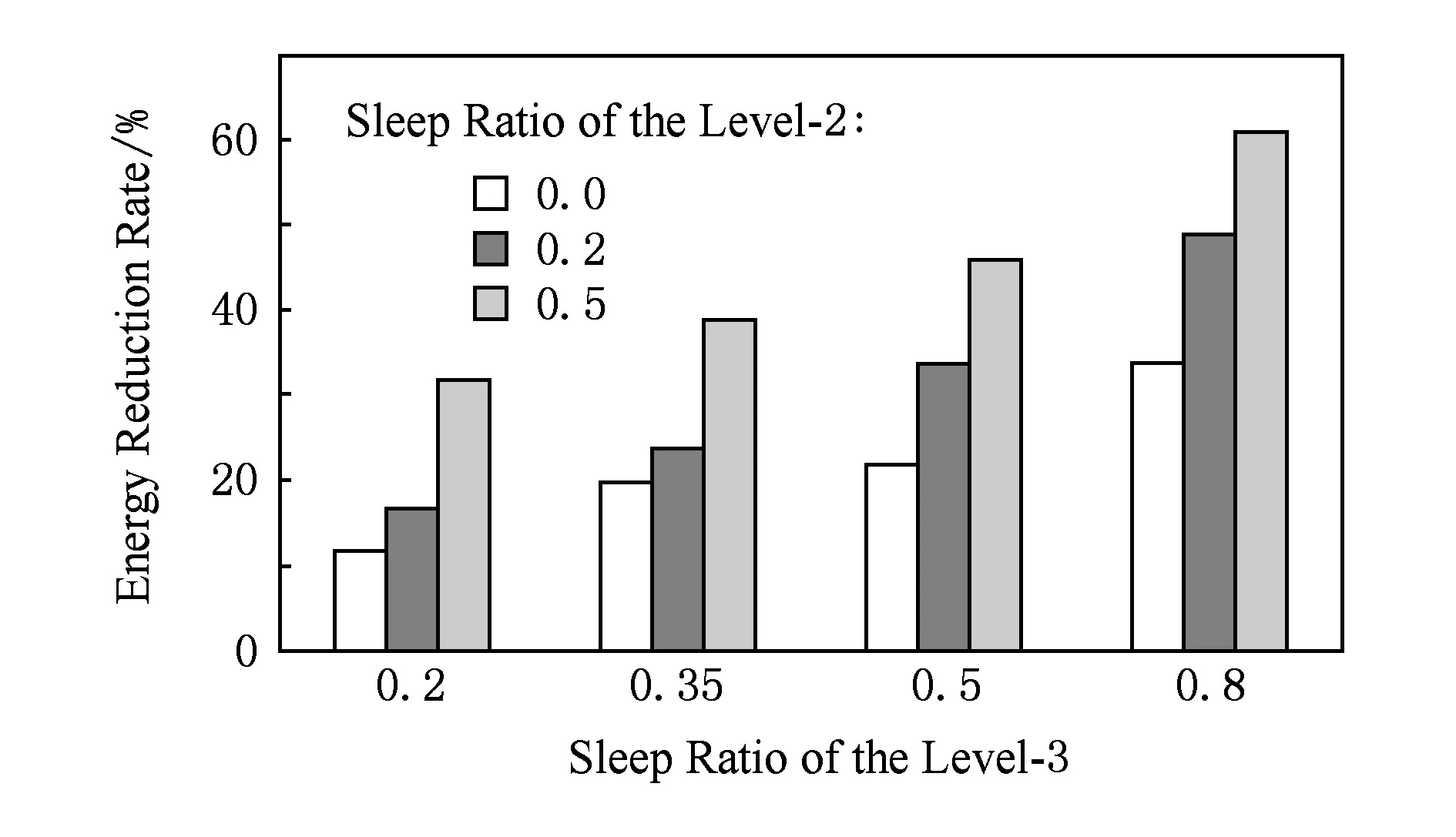

5.2.2能效分析

分层结构使得不同层次计算需求不同,利用这种计算需求上的差异引入动态休眠存在很大的能效优势.在图6中我们对比不同休眠状态下可以带来的数据中心整体节能效果.我们直接测得Origin情况下所有服务器(混合式数据中心系统)消耗的功率大约是最大功率的80%,图6中纵坐标表示Layered情况下4×3种不同动态休眠策略下相比Origin节约的能源百分比,横坐标表示代表中央数据中心的服务器的休眠比率.可以看出,随着动态休眠时间的增长,数据中心可以节约更多的能源;但是这样的能效优势却也是受到数据中心性能牵制的,即当关闭的计算资源过多或造成数据中心计算资源不够,从而导致其服务质量严重下降.在实验中,对各层级集装箱数据中心采取适度的负载整合以及集体休眠策略可以带来12%以上的节能. 综上,针对分布式集装箱数据中心集群的分层组织结构可以实现对计算资源合理的管理和规划,并且在这种分层结构中使用合理的集体休眠策略可以在性能影响较低的情况下进一步提高能效.

Fig. 6 Experimental results of energy consumption.图6 能耗测量结果

6结语与展望

模块化预定制的硬件设计模式使得地理分布的微型数据中心能够快速方便地部署.这些集装箱数据中心与传统集中建设的大型数据中心在未来共同组成了一种混合式的数据中心生态环境.对此类混合式系统进行合理的调度和管制,可以进一步提升数据中心能源利用的效率.本文着眼于集装箱数据中心集群在部署时可能面临的网络状况和本地待处理数据特性的差异,将混合式数据中心在逻辑上划分成不同的分层结构来进行任务调度和资源分配.基于这种分层的逻辑结构,引入了一种动态集体休眠的管理方法来进一步提升能源利用效率.小规模实验结果显示所提出的设计机制能够提升12%~32%的整体能效,并确保任务性能可控.

本文提出的分层化设计与管理技术作为集装箱数据中心绿色节能的初步探索,还存在一些考虑不周的地方.例如,本文并没有具体分析应该分多少层、每层数据中心的合理容量规划等.另外值得注意的是数据中心集装箱本身也存在一些劣势:为放置在边远地区的集装箱数据中心和预制单位提供水电和网络资源的难度大费用高;孤立的集装箱数据中心或预制单位比普通大楼更容易被入侵或捣毁;耐用性方面,目前的集装箱数据中心还不适合长期用于恶劣环境中.如何设计和利用更加可靠经济的集装箱数据中心依然是个开放性问题.

参考文献

[1]Ren C, Wang D, Urgaonkar B, et al. Carbon-aware energy capacity planning for datacenters[C]Proc of the 20th Int Symp on Modeling, Analysis & Simulation of Computer and Telecommunication Systems. Piscataway, NJ: IEEE, 2012: 391-400

[2]DatacenterDynamics. Green grid signs metrics collaboration pact with ODCA[EBOL]. (2011-11-08) [2016-03-01]. http:www.datacenterdynamics.comnewsgreen-grid-signs-metrics-collaboration-pact-with-odca55525.fullarticle

[3]Li C, Hu Y, Liu L, et al. Towards sustainable in-situ server systems in the big data era[C]Proc of the 42nd Annual Int Symp on Computer Architecture. New York: ACM, 2015: 14-26

[4]Christesen S. Data center containers[EBOL]. (2009-06-15) [2016-05-08]. http:www.datacentermap.comblogdatacenter-contai ner-55.html

[5]TechTarget. Investigating data center containers of different vendors[EBOL]. (2010-03-17) [2016-05-08]. http:www.searchdatacenter. com.cnshowcontent_32690.htm (in Chinese)(TechTarget. 各大厂商集装箱式数据中心挨个看[EBOL]. (2010-03-17) [2016-05-08]. http:www.searchdatacenter.com.cnshowcontent_32690.htm)

[6]Sohu IT. Sun Blackbox a revolution in datacenter[EBOL]. (2007-10-22) [2016-05-08]. http:it.sohu.com20071022n252785910.shtml (in Chinese)(搜狐IT. Sun Blackbox引发数据中心革命[EBOL]. (2007-10-22) [2016-05-08]. http:it.sohu.com20071022n252785910.shtml)

[7]Qouneh A, Li C, Li T. A quantitative analysis of cooling power in container-based data centers[C]Proc of the 2011 IEEE Int Symp on Workload Characterization. Piscataway, NJ: IEEE, 2011: 61-71

[8]GrayBar. Emerson SmartCabinet: Intelligent, integrated infrastructure in an enclosure[EBOL]. (2015-12-03) [2016-05-08]. http:www. graybar.comblogiotemerson-smartcabinet

[9]Vance A. Dell sees double with data center in a container[EBOL]. (2008-12-08) [2016-05-08]. http:bits.blogs.nytimes.com20081208dell-sees-double-with-data-center-in-a-container

[10]Watson G. Server room solutions inside modular and containerized data centers[EBOL]. (2015-09-11) [2016-05-08]. http:blog. datapod.com.aublogserver-room-solutions-inside-modular-and-containerized-data-centers

[11]Guo C, Lu G, Li D, et al. BCube: A high performance, server-centric network architecture for modular data centers[C]Proc of the ACM SIGCOMM Conf on Data Communication. New York: ACM, 2009: 63-74.

[12]Lu Feifei, Zhu Guiming, Tao Zhirong, et al. MDCent: A modular data center interconnection with high scalability and high performance[J]. Journal of Computer Research and Development, 2015, 52(5): 1127-1136 (in Chinese) (陆菲菲,朱桂明,陶志荣, 等. MDCent: 一种高可扩展、高吞吐量的模块间互联结构[J]. 计算机研究与发展, 2015, 52(5): 1127-1136)

[13]Han Dong, Xiao Wenjun, Li Meisheng. EBSN: A new model with full-structure for modular data center[J]. Journal of South China University of Technology: Natural Science Edition, 2015, 43(1): 94-99 (in Chinese)(韩冬,肖文俊,李梅生. EBSN:一种新型全结构模块化数据中心模型[J]. 华南理工大学学报: 自然科学版, 2015, 43(1): 94-99)

[14]Huang F, Zhang Y, Li D, et al. meGautz: A high capacity, fault-tolerant and traffic isolated modular datacenter network[JOL]. IEEE Trans on Services Computing, 2016 [2016-05-08]. http:ieeexplore.ieee.orgxplarticleDetails.jsp?arnumber=7440897

[15]Vishwanath K, Greenberg A, Reed D. Modular data centers: How to design them[C]Proc of the Workshop on Large-Scale System and Application Performance. New York: ACM, 2009: 3-10

[16]Li C, Wang R, Qian D, et al, Managing server clusters on renewable energy mix[J]. ACM Trans on Autonomous and Adaptive Systems, 2016, 11(1): No 1

[17]Deng Wei, Liu Fangming, Jin Hai, et al. Leveraging renewable energy in cloud computing datacenters: State of the art and future research[J]. Chinese Journal of Computers, 2013, 36(3): 582-598 (in Chinese)(邓维, 刘方明, 金海, 等. 云计算数据中心的新能源应用: 研究现状与趋势[J]. 计算机学报, 2013, 36(3): 582-598)

[18]Ye Ran, Li Chao, Liang Xiaoyao. Energy storage system in green data centers: Architecture and management[J]. Journal of Computer Research and Development, 2016, 53(2): 326-340 (in Chinese)(叶冉, 李超, 梁晓峣. 面向绿色数据中心的储能系统:体系结构和管理方法[J]. 计算机研究与发展, 2016, 53(2): 326-340)

[19]Zhao Gang. Ali Cloud built green data center in Zhangbei[EBOL]. (2015-06-08) [2016-05-08]. http:it.gmw.cn2015-0608content_15915778.htm (in Chinese)

(赵刚. 阿里云在张北建绿色能源数据中心[EBOL]. (2015-06-08) [2016-05-08]. http:it.gmw.cn2015-0608content_15915778.htm)

[20]Bosker B. Google buys 20 years’ worth of wind energy to power data centers[EBOL]. (2010-07-21) [2016-05-08]. http:www.huffingtonpost.com20100721google-wind-farm-purchase_n_653146.html

[21]Lo D, Cheng L, Govindaraju R, et al. Heracles: Improving resource efficiency at scale[C]Proc of the 42nd Annual Int Symp on Computer Architecture. New York: ACM, 2015: 450-462

[22]Kambatla K, Kollias G, Kumar V, et al. Trends in big data analytics[J]. Journal of Parallel and Distributed Computing, 2014, 74(7): 2561-2573

Hou Xiaofeng, born in 1993. PhD candidate. Her main research interests include computer architecture and highly available data center system.

Song Pengtao, born in 1991. Master candidate. His main research interests include computer architecture, IoT system, and cloud computing.

Tang Weichao, born in 1989. Received his Master degree in 2016 from Shanghai Jiao Tong University. His main research interests include computer architecture and green data center design.

Li Chao, born in 1986, Tenure-track assistant professor and PhD supervisor at Shanghai Jiao Tong University. Member of China Computer Federation. His main research interests include computer architecture and green computing.

Liang Xiaoyao, born in 1978. Professor and PhD supervisor. Member of China Computer Federation. His main research interests include computer architecture, GPGPU, and HPC systems.

收稿日期:2016-03-06;修回日期:2016-05-12

基金项目:国家自然科学基金项目(61502302)

通信作者:李超(lichao@cs.sjtu.edu.cn)

中图法分类号TP391

Green Hierarchical Management for Distributed Datacenter Containers

Hou Xiaofeng, Song Pengtao, Tang Weichao, Li Chao, and Liang Xiaoyao

(DepartmentofComputerScienceandEngineering,ShanghaiJiaoTongUniversity,Shanghai200240)

AbstractIn recent years, modular datacenters (datacenter containers) have become promising IT infrastructure solutions due to their impressive efficiency and scalability. Pre-fabricated containers can be deployed not only in existing warehouse-scale datacenter facilities for capacity expansion, but also in urban�remote areas to support onsite Internet of Things (IoT) data processing. Combing conventional centralized datacenter servers with distributed containers can offer cloud providers new opportunities of exploiting local renewable energy resources and reducing unnecessary data movement overhead. This paper investigates a hierarchical management strategy for emerging geographically distributed datacenter containers. We logically group distributed datacenter containers into multiple classes that have different data accessing patterns. During runtime a central navigation system is used to monitor the utilization of each container class and perform dynamic sleeping scheduling to further improve the overall energy efficiency. Experimental results on our scaled-down test-bed show that the proposed mechanism can save 12%~32% energy cost while ensuring high performance.

Key wordscloud computing; datacenter container; green computing; hierarchical management; performance evaluation

This work was supported by the National Natural Science Foundation of China (61502302).