融合距离图像和彩色图像的圆位姿测量方法

陈 欣 高 隽 张旭东 张 骏

(合肥工业大学计算机与信息学院 安徽 合肥 230009)

融合距离图像和彩色图像的圆位姿测量方法

陈欣高隽张旭东张骏

(合肥工业大学计算机与信息学院安徽 合肥 230009)

摘要针对基于单目视觉的单个圆位姿测量解的二义性问题,提出一种融合距离图像和彩色图像消除二义性的方法。该方法首先用RGB相机获取的高分辨率彩色图像计算圆位姿,获得圆位姿的一组歧义解。然后将彩色图像和飞行时间TOF(time-of-Flight)相机获取的距离图像融合,形成一个高分辨率的距离图像。最后,根据距离图像恢复圆在RGB相机下的三维信息,剔除圆位姿中的虚假解,从而得到圆的真实位姿。实验结果表明,该方法能够有效地解决基于单目视觉的单个圆位姿测量的二义性问题,且能够准确获得较高精度的圆位姿。

关键词圆位姿测量二义性距离图像彩色图像融合

0引言

随着计算机技术的飞速发展,基于计算机视觉的位姿测量在航天、军事、智能交通、医疗、多媒体等领域有着广泛的应用[1,2]。在航天领域,多数在轨服务航天器为非合作目标,即没有预先安装合作标志器(如发光标志器、角反射镜等装置)。因此,对于非合作目标位姿测量,只能利用目标航天器本身的特征(如对接环和发动机喷嘴)来实现目标的识别和定位[3]。航天器的对接环和发动机喷嘴具有圆形结构,使利用圆特征求解非合作目标的位姿成为可能。

相对于其他点线特征,圆代表的是个对称矩阵,在数学上比较容易计算,对于抗遮挡和图像定位精度来说,圆也有很大的优势。然而,在没有任何约束条件下,基于单个圆的单目视觉位姿估计的解具有二义性[4,5],难以应用于实际中。因此,如何剔除位姿估计中的虚假解引起众多学者研究。

Velasquez等[6]给定目标一个初始化位姿,利用扩展卡尔曼滤波器EKF(ExtendedKalmanfilter)估计下一时刻的位姿信息,将接近预测值的解作为圆目标真实位姿信息。但是若目标的初始位姿不确定,该方法就不能获得圆目标的位姿信息。Xu等[7]利用双目相机分别计算获得圆目标在两个相机下的位姿解,将两相机获得的位姿解转换到世界坐标系下,对于同一圆,在世界坐标系下,根据左右两相机获取的法向量的正确解间的夹角小于某一阈值,从而获得圆的正确位姿信息。但是实际中,若是阈值选择得不合适的话,该方法就不再适用。Du等[8]将目标航天器上的对接环和矩形底座边缘作为识别对象,采用矩形底座边缘的消隐点求解正确圆的法向量,从而剔除虚假解。但是当矩形底座的其中一条边被遮挡时,该方法将不再适用。苗锡奎等[9]根据圆平面外一参考点到圆心距离的欧氏不变性,剔除虚假解。但是该方法需要已知在目标本体坐标系下参考点到圆心的距离信息,且必须保证参考点在图像平面上成像。魏振忠等[10]根据圆所在平面上的一对相交直线角度在欧式空间中保持不变,对圆目标正确定位。若圆所在的平面找不到角度约束的辅助信息,该方法就不再适用。

上述解决二义性的圆位姿测量方法皆存在着不同的约束条件。鉴于此,本文采用一种新型的、小型化的基于飞行时间原理的三维立体成像设备飞行时间TOF相机[11]。它无需扫描便可同时获取目标的幅度图像、距离图像和灰度图像。我们利用距离图像恢复空间圆在TOF相机下的三维信息,从而对圆进行准确定位。然而,TOF相机获取图像分辨率较低[12],因此直接利用空间圆在TOF相机下的投影图像计算空间圆位姿的精度不高。针对该问题,本文利用RGB相机和TOF相机组成的2D/3D系统求解圆位姿。首先利用RGB相机获取的高分辨率彩色图像计算圆位姿;然后将彩色图像和TOF相机获取的距离图像融合,形成一个高分辨率的距离图像;最后根据距离图像恢复圆在RGB相机下的三维信息,唯一确定圆的位置和姿态角参数。实验验证了本文提出的圆位姿测量算法有效地解决了解的二义性问题,且能够获得较高的圆位姿测量精度。

1位姿测量系统结构

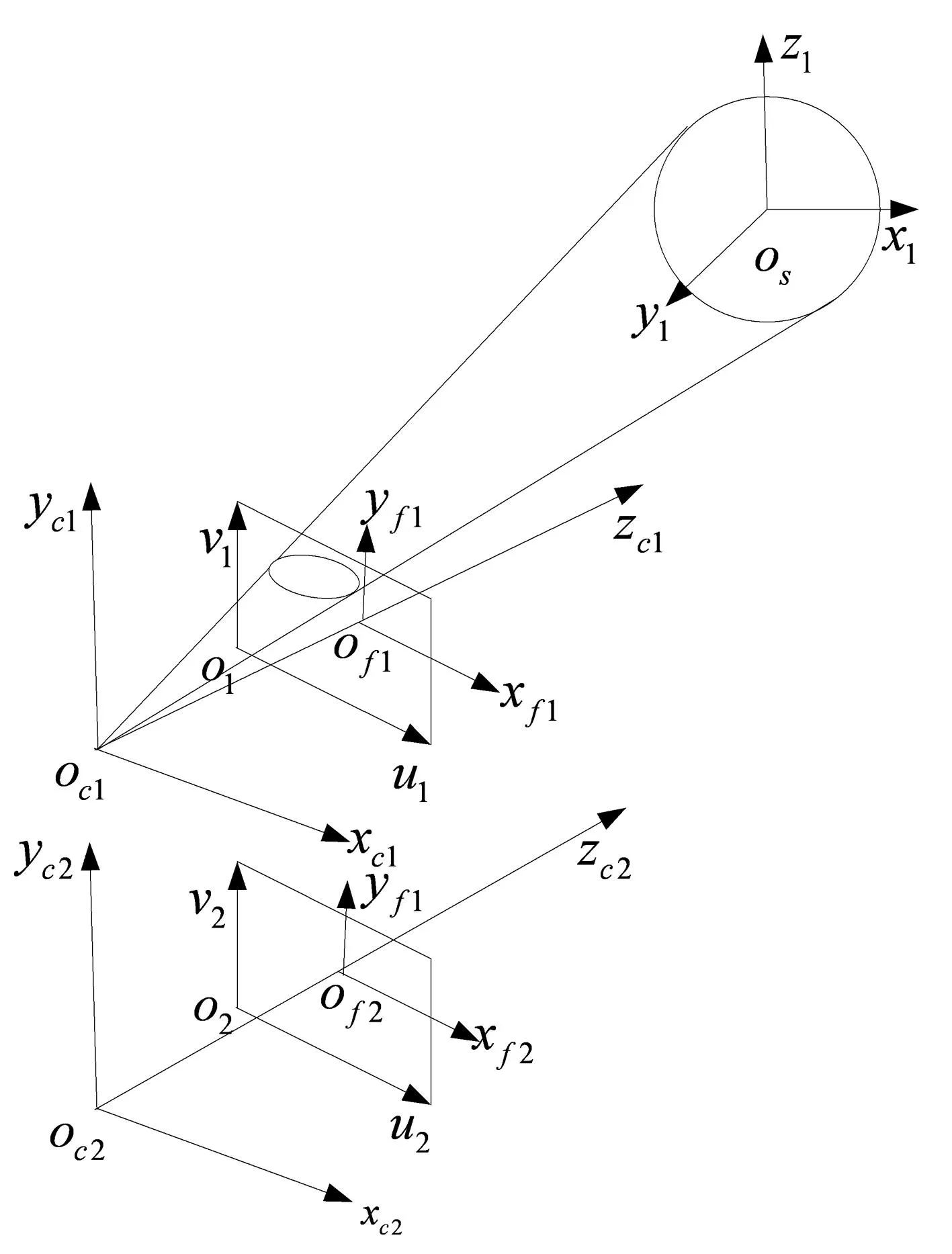

为了便于分析,本文建立如图1所示的目标本体坐标系os-x1y1z1,RGB相机和TOF相机坐标系oc1-xc1yc1zc1、oc2-xc2yc2zc2。

图1 目标本体坐标系、相机坐标系、像平面坐标系的定义

RGB相机和TOF相机像平面坐标系分别定义如下:

(1) 目标本体坐标系os-x1y1z1

以目标上圆特征的圆心为坐标原点os,以圆面法向量为z1轴方向,利用右手法则依次建立x1轴和y1轴,从而建立目标物体的本体坐标系os-x1y1z1。

(2) 像平面坐标系

① 对于RGB像平面像素坐标系o1-u1v1,以像平面的左上角第一个像素点为原点o1,u1轴和v1轴方向分别对应于像平面的行方向和列方向;同理,建立TOF像平面像素坐标系o2-u2v2;② 对于RGB像平面物理坐标系of1-xf1yf1,以RGB相机的光轴与像平面的交点为原点of1,xf1、yf1分别与u1轴和v1轴平行;同理,建立TOF像平面物理坐标系of2-xf2yf2。这里,单位为毫米。

(3) 相机坐标系

对于RGB相机坐标系oc1-xc1yc1zc1,以相机透镜中心作为原点oc1,主光轴方向为zc1轴,xc1轴、yc1轴分别与像平面坐标系u1、v1平行。同理,建立TOF相机坐标系oc2-xc2yc2zc2。

为了解决单个圆姿态识别中的二义性问题,本文采用如图2所示算法框架。首先对RGB相机和TOF相机获得图像进行预处理,主要包括对TOF相机获取的距离图像进行滤波降噪;对RGB相机获取的彩色图像进行边缘检测,对于边缘检测后的图像进行椭圆检测,从而获得圆在像平面上的投影椭圆。然后对彩色图像上获得的椭圆采用基于圆的单目视觉位姿估计算法[6],获得圆的位姿解。针对圆位姿计算获得的解具有二义性,将RGB相机获取的彩色图像和TOF获取的距离图像融合形成高分辨率的距离图像DH,根据距离图像DH恢复圆在RGB相机坐标系下的三维点云,求出圆的正确位姿解。

图2 圆位姿测量算法框架

2圆位姿估计

2.1预处理

2.2基于单目视觉的圆位姿估计法

一般情况下,根据相机小孔成像模型,三维空间圆在相机二维像平面上的投影为椭圆,像平面上的投影椭圆和相机透镜光心形成一个椭圆锥。圆三维位置和方向的求解就是在空间中寻找一个平面,且此平面与椭圆锥相交形成一个圆。

对于2.1节中椭圆检测获得椭圆几何参数,利用圆姿态重建的闭式解法[5]在椭圆锥空间中找到两个平面,且这两个平面分别与椭圆锥相交的圆在像平面上的投影为同一个椭圆,如图3所示。其中,RGB相机坐标系oc1-xc1yc1zc1下的圆心坐标和圆所在平面法向量的一组歧义解如式(1)所示:

(1)

图3 圆位姿歧义解示意图

2.3基于距离图像和彩色图像融合消除位姿二义性

2.3.1距离图像和彩色图像的融合

利用立体配准算法[18]将低分辨率距离图像映射到高分辨率彩色图像空间中,获得一个初始高分辨率距离图像DS。再利用Ferstl等[19]提出的距离图像和彩色图像的融合方法对距离图像上采样,将上采样问题转化成二阶广义总变分(TGV)的全局能量函数优化问题。其中二阶广义总变分(TGV)的全局能量目标函数如式(2)所示:

(2)

2.3.2三维点云获取

由于TOF相机获得的距离数据为TOF相机光心到目标物体的径向距离,所以融合获得的高分辨率距离图像上每个像素点的距离数据为RGB相机光心到目标物体的径向距离。利用RGB相机的小孔成像模型,结合式(3)-式(5)计算圆上各点在RGB相机坐标系oc1-xc1yc1zc1下的三维坐标X(xi,yi,zi),即RGB相机下的三维点云。对于RGB相机获取的3维点云存在着部分离散点和孤立点,采用KNN邻域滤波[22]对获取的点云进行平滑处理(本文实验K=10)。

(3)

(4)

(5)

2.3.3二义性消除

由空间几何可知,若空间圆心坐标为O0(O0x,O0y,O0z),圆上任一点坐标为Xo(xo i,yo i,zoi),那么圆所在的平面方程可用式(6)表示:

nT[(Xo-O0]=0

(6)

式中,n为圆所在平面的法向量。

对于计算获得的圆的三维点云数据,由于相机自身存在的系统误差和非系统误差,圆上各点并不能准确满足式(6),因此建立如式(7)的目标函数:

f(n,O0,Xo)=nT(Xo-O0)

(7)

将RGB相机坐标系下圆心坐标、圆所在平面法向量的一组歧义解以及空间圆各点三维坐标分别代入式(7),按式(8)获得正确的圆心坐标Ot和法向量nt:

(8)

其中,圆心坐标为位置信息,从平面法向量求出绕x轴和y轴的旋转角度。

3实验结果与分析

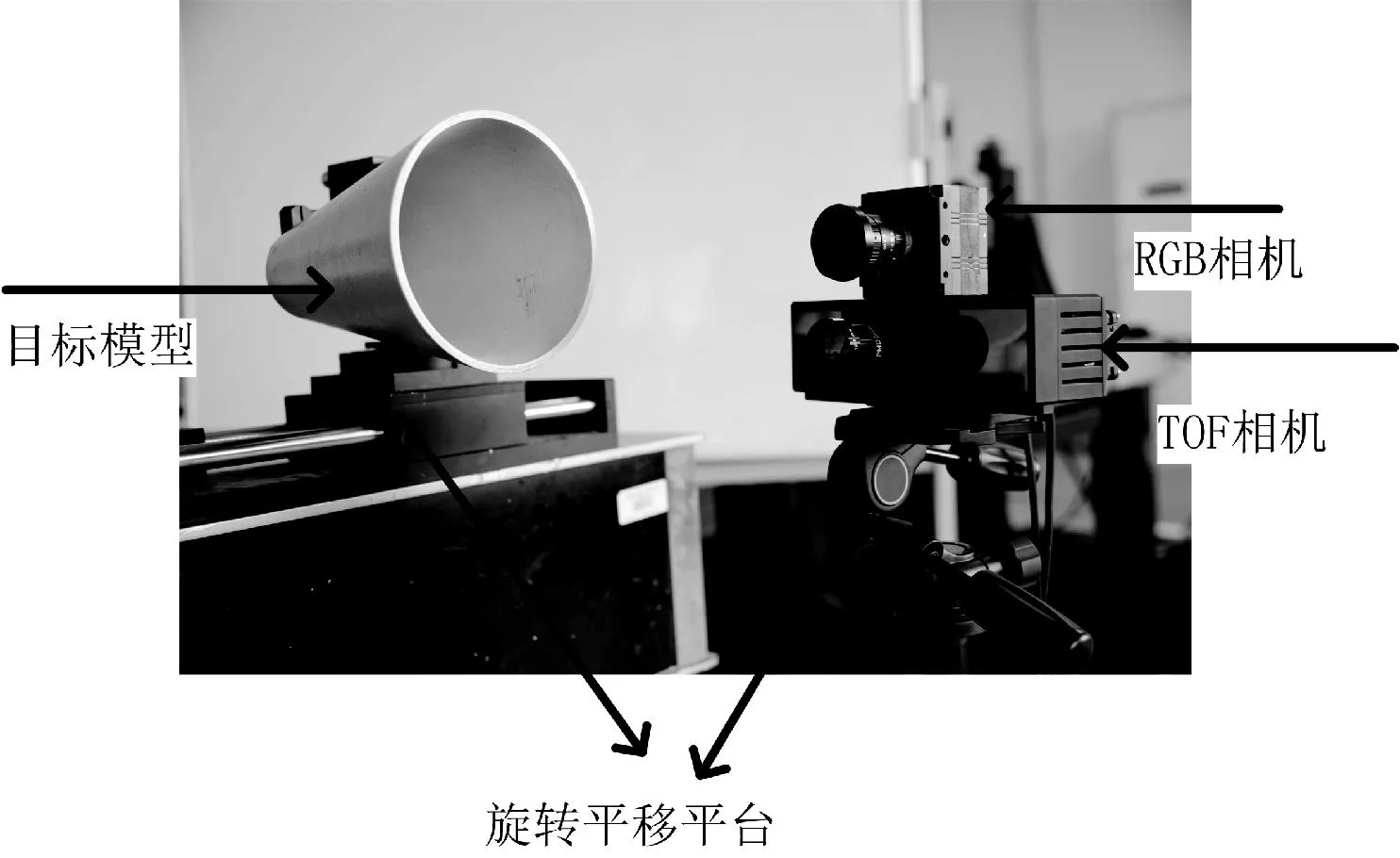

为了验证算法的可行性和准确性,本文自行搭建位姿测量平台。如图4所示,包括自制的目标模型(塑料)、TOF相机和RGB相机组成的2D/3D相机系统、旋转平移平台。

图4 位姿测量平台

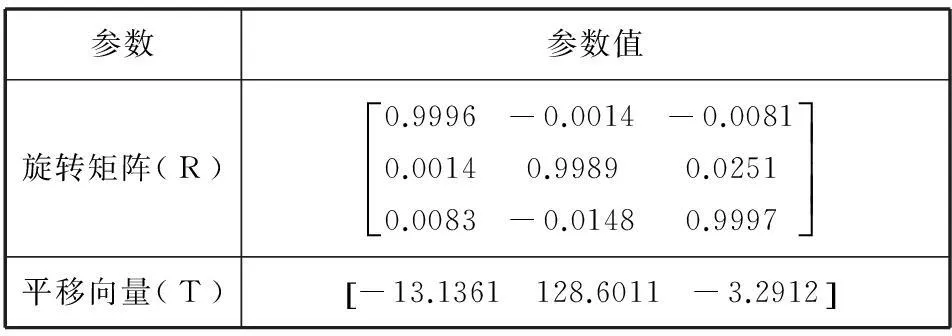

其中,TOF相机为PMD®Camcube2.0,分辨率为204×204;RGB相机为大恒公司的DH-SV1421FC,分辨率为1392×1040,两相机坐标系间的旋转矩阵R、平移矩阵T参数如表1所示。本实验中采用的圆特征为目标模型中圆环的外圆,外圆直径为150mm。

表1 两个相机坐标系之间的坐标转换关系

首先固定2D/3D相机系统,控制旋转平台使其回到初始零位,校准目标模型,使模型中的圆平面与实验中的旋转平台的x轴、y轴平行,与z轴垂直。利用2D/3D相机系统采集目标图像,对采集的图像利用本文算法计算圆的位姿。如图5给出了不同步骤获得的结果。(a)是RGB相机输出的彩色图像,(b)是TOF相机输出的距离图像。对RGB相机获取的图像进行预处理,获得圆的投影椭圆,(c)是彩色图像中检测到的椭圆,将检测到的椭圆利用单目视觉圆位姿测量方法获得圆位姿的一组歧义解;对TOF相机获取的距离图像进行滤波降噪,得到如(d)所示的距离图像;利用距离图像和彩色图像的融合方法获取如图5(e)所示的高分辨率的距离图像;然后将高分辨率的距离图像计算获得三维点云,结果如(f)所示,最后消除位姿歧义解中的虚假解。

图5 图像处理结果图

为了验证算法的可行性与准确性,本实验分别设计了如下的相对位置测量实验和旋转角度测量实验。

(1) 相对位置测量实验

以z向距离500mm处为测量基准点,分别在z向距离500、750、1000、1250、1500、1750、2000mm这个7个距离点采集数据。在每个距离点上,依次在x轴、y轴方向上平移目标,每次平移50mm,总共平移200mm。

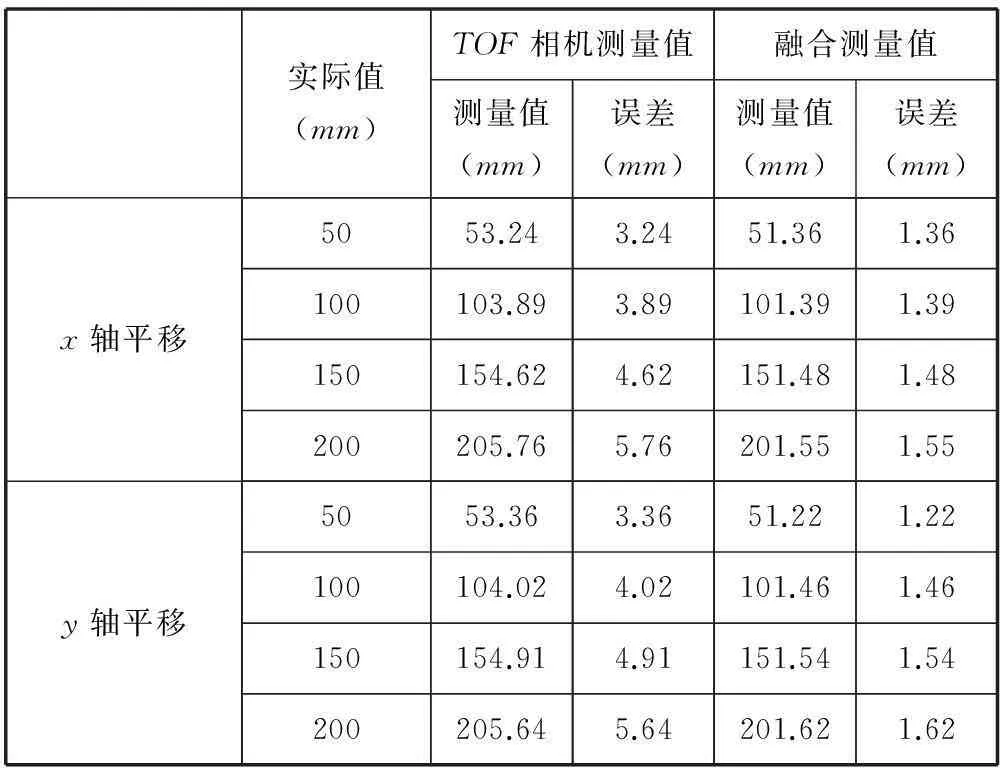

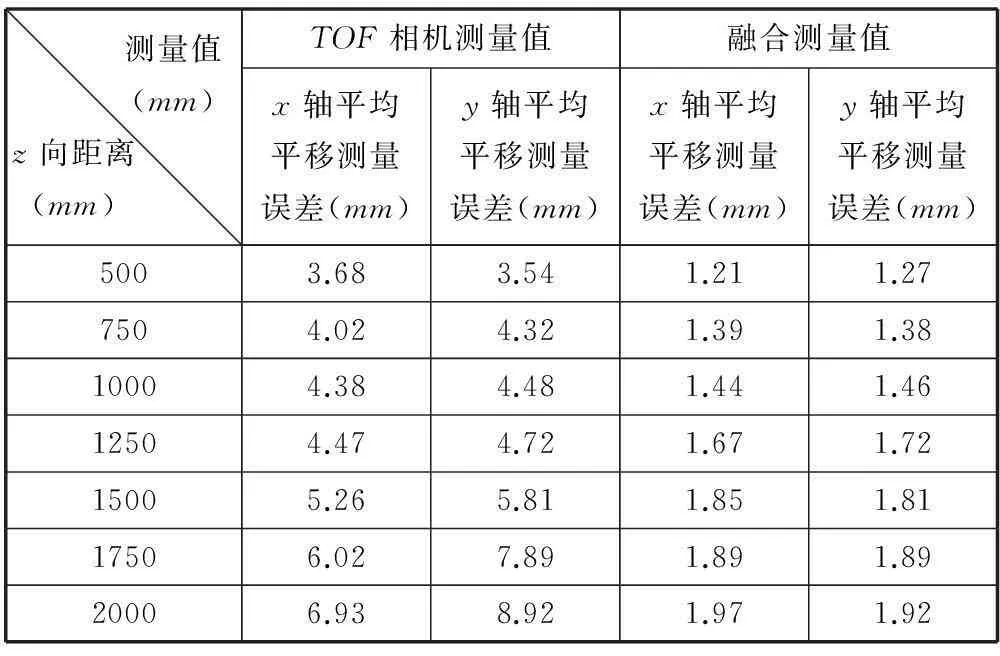

分别利用TOF相机系统以及TOF相机和RGB相机组成的2D/3D相机系统采集图像,求解位移变化量,得到z轴、x轴、y轴依次单轴平移结果如表2、表3、表5所示。其中,表3表示在z向距离1000mm时,x轴、y轴方向上的依次单轴平移测量结果。表5表示在不同距离点上,x轴、y轴上的平均平移误差。实验结果表明,融合距离图像和彩色图像能够准确地获取圆位姿。随着单轴平移量的增加,各次平移的误差也在增加。

(2) 旋转角度测量实验

无论空间圆绕其轴旋转多大角度,其在像平面成像都不会改变。因此本实验中,对于每个距离点上,只依次转动旋转平台x轴、y轴,每次转动10度,共转动50度。

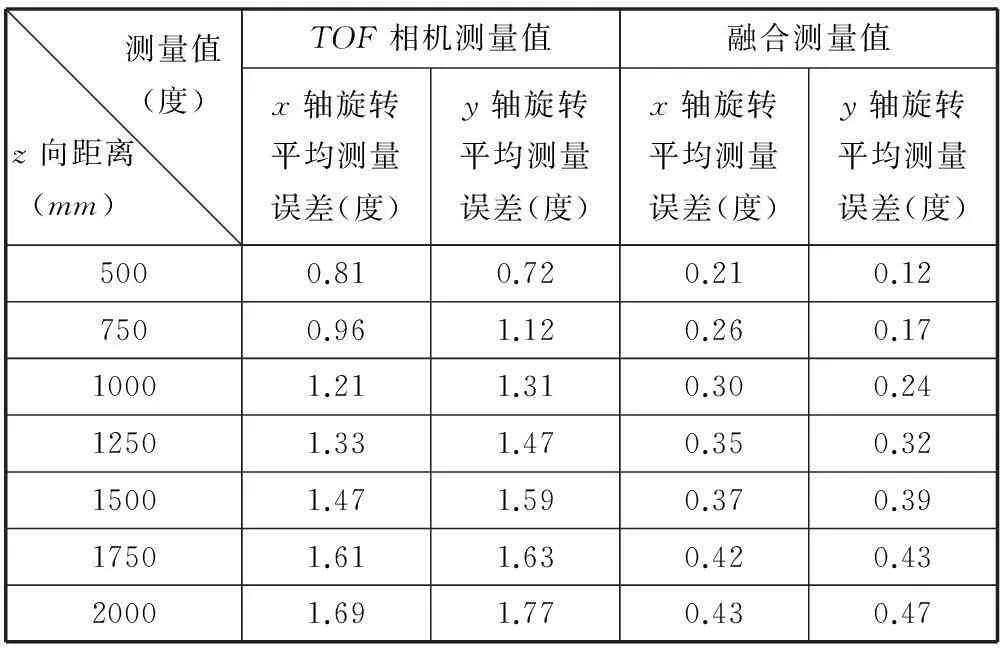

利用TOF相机系统以及2D/3D相机系统分别采集各个姿态角下的目标图像,利用本文的圆定位方法,确定各情况下旋转角度变量,获得x轴、y轴依次单轴旋转时的测量结果如表4、表6所示。其中,表4表示在z向距离1000mm时,x轴、y轴依次单轴旋转时的旋转角度误差。表6表示在不同距离点上,x轴、y轴依次单轴旋转时旋转角度平均误差。随着单轴旋转角度的增加,各轴的旋转角度误差也在增加。

表2 z轴方向上的平移测量结果

表3 z=1000 mm,x轴、y轴平移测量结果

表4 z=1000 mm,x轴、y轴旋转测量结果

表5 x轴、y轴平均平移测量误差

表6 x轴、y轴旋转平均测量误差

上述实验结果表明,与仅采用TOF相机系统输出的低分辨率图像求解圆位姿相比,利用2D/3D相机系统采集图像,对获取的距离图像和彩色图像进行融合求解圆位姿的测量误差明显减小,能够有效地获取高精度的圆位姿。表3、表4表明随着单轴平移量和旋转角度的增加,各次平移和旋转的误差也在增加,单轴平移误差小于1.7mm,单轴旋转角度低于0.5度。实验验证了本文位姿测量方法的正确性和实验方案设计的合理性。表2、表5、表6表明,随着z轴平移量的增加,x轴、y轴的平均平移测量误差、z轴的平移误差增大,且x轴、y轴旋转平均角度误差也增大。其中,平移平均测量误差小于3.9mm,旋转平均测量误差小于0.5度。这主要是由于随着距离的增加,非合作目标上圆特征的成像椭圆大小逐渐减小,椭圆的拟合误差增加,从而大大影响圆位姿的精度。

4结语

本文提出一种融合距离图像和彩色图像的圆位姿测量方法。该方法针对RGB相机求解圆位姿存在二义性,搭建RGB相机和TOF相机组成2D/3D相机系统,将RGB相机获取的彩色图像和TOF相机获取的距离图像融合,形成一个高分辨率的距离图像,由距离图像恢复三维点云,剔除虚假解,唯一确定圆的位姿。实验结果表明,该算法能够有效准确地获取较高精度的圆位姿,满足实际位姿测量系统精度需求。

参考文献

[1]OumerNW,PaninG.3Dpointtrackingandposeestimationofaspaceobjectusingstereoimages[C]//The21stInternationalConferenceonPatternRecognition(ICPR),Tsukuba,Japan,2012:796-800.

[2]RegoliL,RavandoorK,SchmidtM,etal.On-linerobustposeestimationforRendezvousandDockinginspaceusingphotonicmixerdevices[J].Actastronautica,2014,96(3):159-165.

[3]PetitA,MarchandE,KananiK.Vision-basedspaceautonomousrendezvous:Acasestudy[C]//2011IEEE/RSJInternationalConferenceonIntelligentRobotsandSystems(IROS),California,USA,2011:619-624.

[4]ShiuYC,AhmadS.3Dlocationofcircularandsphericalfeaturesbymonocularmodel-basedvision[C]//ProceedingsoftheIEEEInternationalConferenceonSystems,ManandCybernetics,Massachusetts,USA,1989:576-581.

[5]Safaee-RadR,TchoukanovI,SmithKC,etal.Three-dimensionallocationestimationofcircularfeaturesformachinevision[J].IEEETransactionsonRoboticsandAutomation,1992,8(5):624-640.

[6]VelasquezAF,MaraniG,EvansT,etal.Virtualsimulatorfortestingavisionbasedposeestimationsystemforautonomouscaptureofsatelliteswithinterfacerings[C]//2013 21stMediterraneanConferenceonControl&Automation(MED),Crete,Greece,2013:1597-1602.

[7]XuWenfu,XueQiang,LiuHoude,etal.Aposemeasurementmethodofanon-cooperativeGEOspacecraftbasedonstereovision[C]//2012 12thInternationalConferenceonControlAutomationRobotics&Vision(ICARCV),Guangzhou,China,2012:966-971.

[8]DuXiangdong,LiangBin,XuWenfu,etal.PoseMeasurementofaGEOSatelliteBasedonNaturalFeatures[C]//2012InternationalConferenceonVirtualRealityandVisualization(ICVRV),Qinhuangdao,China,2012:33-40.

[9] 苗锡奎,朱枫,丁庆海,等.基于星箭对接环部件的飞行器单目视觉位姿测量方法[J].光学学报,2013,33(4):123-141.

[10] 魏振忠,赵征,张广军.空间圆姿态识别二义性的角度约束消除[J].光学精密工程,2010,18(3):685-691.

[11]FoixS,AlenyaG,TorrasC.Lock-intime-of-flight(ToF)cameras:asurvey[J].SensorsJournal,IEEE,2011,11(9):1917-1926.

[12]ZhangXudong,ShenYuliang,HuLiangmei.Super-resolutionreconstructionAlgorithmforPMDrangeimagebasedonregularization[C]//2011InternationalConferenceonIntelligentHuman-MachineSystemsandCybernetics(IHMSC),Hangzhou,China,2011:15-18.

[13]KahlmannT,RemondinoF,IngensandH.Calibrationforincreasedaccuracyoftherangeimagingcameraswissrangertm[J].ImageEngineeringandVisionMetrology(IEVM),2006,36(3):136-141.

[14]FrankM,PIaueM,HamprechtFA.Denoisingofcontinuous-wavetime-of-lightdepthimagesusingconfidencemeasures[J].OpticalEngineering,2009,48(7):1-24.

[15]GaoJun,JiaBaozhu,ZhangXudong,etal.PMDcameracalibrationbasedonadaptivebilateralfilter[C]//2011InternationalSymposiumonPhotonicsandOptoelectronics(SOPO),Wuhan,China,2011:1-4.

[16]PrasadDK,LeungMKH,ChoSY.Edgecurvatureandconvexitybasedellipsedetectionmethod[J].PatternRecognition,2012,45(9):3204-3221.

[17]ZhangZhengyou.Aflexiblenewtechniqueforcameracalibration[J].PatternAnalysisandMachineIntelligence,2000,22(11):1330-1334.

[18]LindnerM,KolbA,HartmannK.Data-fusionofPMD-baseddistance-informationandhigh-resolutionRGB-images[C]//2007InternationalSymposiumonSignals,CircuitsandSystems,Beijing,China,2007,1:1-4.

[19]FerstlD,ReinbacherC,RanftlR,etal.Imageguideddepthupsamplingusinganisotropictotalgeneralizedvariation[C]//2013IEEEInternationalConferenceonComputerVision(ICCV),Sydney,Australia,2013:993-1000.

[20]ChambolleA,PockT.Afirst-orderprimal-dualalgorithmforconvexproblemswithapplicationstoimaging[J].JournalofMathematicalImagingandVision,2011,40(1):120-145.

[21]PockT,ChambolleA.Diagonalpreconditioningforfirstorderprimal-dualalgorithmsinconvexoptimization[C]//2011IEEEInternationalConferenceonComputerVision(ICCV),Barcelona,Spain,2011:1762-1769.

[22]DavisLS,RosenfeldA.Noisecleaningbyiteratedlocalaveraging[J].IEEETransactionsonSystemsManandCybernetics,1978,8(9):705-710.

CIRCLE POSE MEASUREMENT BASED ON FUSION OF DISTANCE IMAGEANDCOLOURIMAGE

Chen XinGao JunZhang XudongZhang Jun

(School of Computer and Information,Hefei University of Technology,Hefei 230009,Anhui,China)

AbstractIn order to solve the equivocation problem in monocular vision-based single circle pose measurement, we presented an approach to eliminate equivocation by fusing distance image and colour image. First, the method calculates the circle pose using the high-resolution colour image acquired by RGB camera and thus obtains a set of equivocal solutions of circle pose. Then, it fuses the colour image and distance image captured by TOF camera to form a high-resolution distance image. Finally, according to distance image it restores the 3D information of circle in RGB camera, culls the false solutions in circle pose, so as to get real pose of circle. Experimental results indicated that this method can effectively solve the equivocation problem of single circle pose measurement based on monocular vision, and can accurately attain circle pose with higher precision.

KeywordsCirclePose measurementEquivocationDistance imageColour imageFusion

收稿日期:2015-02-09。国家自然科学基金项目(61273237,6127 1121);安徽省自然科学基金项目(11040606M149)。陈欣,硕士生,主研领域:机器视觉,空间导航研究。高隽,教授。张旭东,教授。张骏,讲师。

中图分类号TP274

文献标识码A

DOI:10.3969/j.issn.1000-386x.2016.06.046