基于人脸3D模型的驾驶人头部姿态检测*

张 波,王文军,成 波

(清华大学,汽车安全与节能国家重点实验室,北京 100084)

2016009

基于人脸3D模型的驾驶人头部姿态检测*

张 波,王文军,成 波

(清华大学,汽车安全与节能国家重点实验室,北京 100084)

为对驾驶过程中的驾驶人注意力分散行为实施监控和预警,提出了一种基于人脸3D模型的驾驶人头部姿态检测方法。该方法使用ASM算法与ASEF算法定位驾驶人的正面人脸;在此基础上,基于通用人脸3D模型与正面人脸计算当前驾驶人的人脸3D模型;以正面人脸3D模型为姿态度量的基准,运用PnP算法实时解算驾驶人的头部姿态,并进行姿态有效性判别;同时提出了一种特征点更新的方法,以提高姿态解算的鲁棒性。实验结果表明,该方法能够在驾驶室环境中有效检测出驾驶人的头部姿态。

驾驶人;头部姿态;机器视觉;人脸3D模型

前言

头部姿态检测广泛应用于人脸识别、人机交互、驾驶人注意力分散检测和驾驶行为分析等领域。统计数据表明,25%~30%的道路交通事故是由驾驶人注意力分散造成的[1]。美国国家公路交通安全管理局的研究报告显示,近80%的车辆碰撞事故均涉及到事故发生前3s内的驾驶人注意力分散行为[2]。研究驾驶人的头部姿态,进而对驾驶人的注意力进行分析,对于降低交通事故的发生率,研究驾驶人的驾驶行为,分析驾驶人的精神状态等具有重要意义。

基于机器视觉的驾驶人头部姿态检测,通过对驾驶人脸部图像的分析实现对驾驶人头部姿态的判别。目前,基于机器视觉的头部姿态检测主要包括纹理模板匹配法[3]、检测器阵列法[4-5]、几何计算法[6]、柔性模板法[7]、跟踪法[8]和其它方法[9]。纹理模板匹配法将人脸图像与已知姿态标签的图像模板进行纹理对比而完成头部姿态的检测,该方法受脸部图像定位误差的影响较大,同时只能获得离散的头部姿态。检测器阵列法利用多姿态人脸分类器检测同一人脸图像,根据检测结果判定头部姿态,该方法同样只能得到离散的头部姿态。几何计算方法在脸部区域内定位特征点,通过特征点相对位置的变化解算头部姿态。该方法对特征点的定位精度极为敏感。柔性模板法采用可变性模板ASM[10]和AAM(active appearance model)[11]等方法根据形状变化解算头部姿态。跟踪法在初始姿态已知的情况下,通过对相邻图像帧之间的特征点进行跟踪的方法[12-13]实时计算头部姿态,该方法的检测精度相对较高。

正常驾驶时,驾驶人不断地变换头部姿态以完成视觉搜索的驾驶任务。同时,驾驶室内的光照条件复杂多变,驾驶人抓耳、接电话、喝水等动作常造成脸部区域的部分遮挡,因此,在脸部定位特征点以及通过对比脸部图像的姿态检测方法难以在驾驶室环境内完成检测任务。

本文中驾驶人的人脸3D建模,采用脸部区域特征点跟踪的方法完成驾驶人头部姿态的实时检测。该方法无需在脸部区域内定位特征点,因此受脸部遮挡、表情变化和随机光照的影响相对较小。

1 检测方法

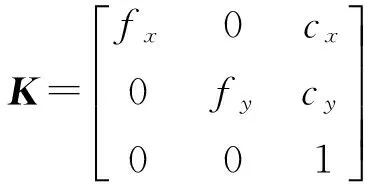

驾驶人头部姿态是相对于正面人脸而言的三维空间位置变化,故本文算法首先进行正面人脸检测。同时,驾驶人头部姿态的检测需要进行摄像机标定,为简化检测过程,对摄像机模型进行了一定程度的简化。

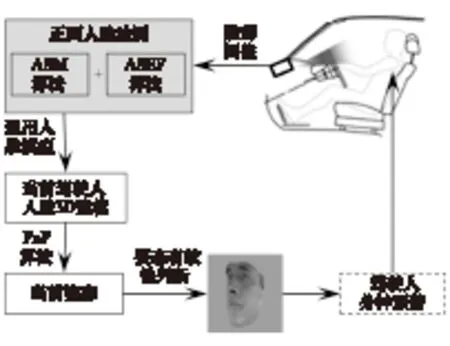

驾驶人头部姿态检测方案如图1所示。

图1 驾驶人头部姿态检测方案

检测系统通过CCD摄像头采集驾驶人的脸部图像,首先使用ASM算法与ASEF算法[14]进行正面人脸检测;根据正面人脸检测结果,改变通用人脸模型的二维形状(深度信息保持不变),并进行纹理贴图,完成当前驾驶人的人脸3D建模;在当前驾驶人的人脸3D模型的基础上,通过PnP算法解算摄像机坐标系(二维图像)与世界坐标系(三维物体)之间的空间位置关系(头部姿态),同时实时判别当前姿态的有效性;最终将驾驶人当前姿态输入至驾驶人分神预警系统进行判别,并将判别结果反馈给驾驶人或发送至远程监控中心。

2 正面人脸检测

2.1 ASM算法

采用ASM算法与ASEF算法相结合的方法确定驾驶人的正面人脸。

ASM算法由局部纹理模型与全局形状模型组成。在检测过程中,两模型交替作用,完成对目标形状的配准。局部纹理模型采用逐点搜索的方法在图像中确定人脸形状向量XF中每个特征点的坐标。

XF=(x1,y1,x2,y2,…,xN,yN)

(1)

式中(xi,yi)表示在图像中确定的第i个特征点的坐标。全局形状模型基于主成分分析(PCA)理论,建立人脸形状变化空间,用以描述不同人脸构型之间的形状差异。最终确定输出的人脸形状Y为

(2)

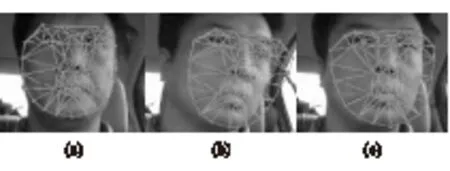

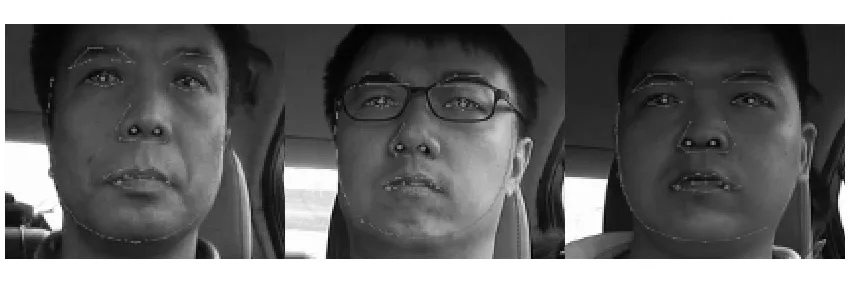

采用68点ASM算法描述人脸拓扑形状,如图2所示。

图2 ASM算法检测结果

由图2可知,在驾驶人头部姿态变化不太大的情况下,ASM算法能够较为准确地实现脸部特征点的定位,如图2(a)所示;受随机光照、姿态变化等因素的影响,ASM算法的输出结果易产生较大的偏差,如图2(b)和图2(c)所示。

在实际的驾驶过程中,驾驶人不断地变换头部姿态,以完成视觉搜索的驾驶任务,且驾驶室内的光照条件也不断变化。因此,仅用ASM算法无法定位出驾驶人的正面人脸。

2.2 ASEF算法

基于相关滤波器的ASEF算法,用原图像与滤波器进行相关运算生成输出图像,通过在输出图像中定位局部极值的方法实现目标的检测与定位,如式(3)所示。

(3)

式中:F-1表示傅里叶反变换运算;B为人脸图像的傅里叶变换;A为以目标位置为中心的二维高斯函数图像a的傅里叶变换。

a(x,y)=e-((x-xd)2+(y-yd)2)/σ2

(4)

式中:(xd,yd)为目标位置坐标;参数σ决定了高斯函数的尖锐程度,直接影响滤波器的检测灵敏度与抗噪声性能。

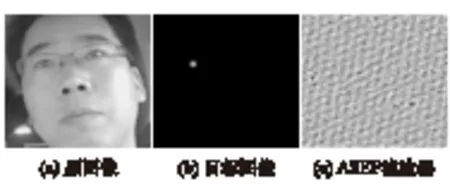

图3为左眼ASEF滤波器的计算过程。图3(a)为人脸图像,图3(b)为以左眼为中心的目标图像,图3(c)为式(3)计算得到的ASEF滤波器。

图3 左眼ASEF滤波器的构建

ASEF算法通过对每张人脸图像得到的滤波器h进行累加求取均值的方法,得到最终的检测滤波器。文献[15]中将PCA运用到ASEF滤波器的计算过程中,使计算得到的PSEF(principal directions of synthetic exact filters)对于不同人脸适应性更强。

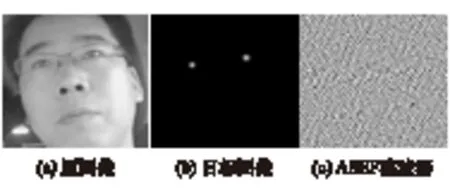

本文中将单眼ASEF滤波器拓展至双眼,利用双眼几何结构约束检测结果,提高ASEF算法的鲁棒性,其计算过程如图4所示。

图4 双眼ASEF滤波器的构建

基于CAS-PEAL人脸库[16]训练得到不同σ参数下的双眼ASEF滤波器,如图5所示。

图5 不同σ参数下的双眼滤波器

在双眼ASEF滤波器的基础上,将其推广至双鼻孔和双嘴角,检测结果如图6所示。

图6 ASEF算法检测结果

由图6可知,接近正面姿态时,ASEF算法可以有效地实现驾驶人脸部特征点的定位,如图6(a)所示,同时,ASEF算法的检测结果同样受到驾驶人姿态的影响,如图6(b)和图6(c)所示。

2.3 ASM与ASEF相结合的正面人脸检测

由前面分析可知,ASM算法与ASEF算法的检测结果均受到驾驶人姿态的影响。单独使用时,均不能将其输出结果作为正面人脸的判定标准。故本文中同时使用ASM算法与ASEF算法进行驾驶人脸部特征点的定位,结合两者的输出结果,作为正面人脸的判定标准,如式(5)所示。在式(5)中,第1项为ASM算法的对称性检验,第2项为ASEF算法的对称性检验,第3项为ASM算法与ASEF算法对应特征点差异性检验,第4项为ASM算法与ASEF算法纵轴重心位置差异性检验。

E=EASM+EASEF+EASM-ASEF+EOASM-OASEF

(5)

其中:

(6)

式中:F为人脸大小;N1为ASM算法左右两侧点对数目;N2为ASEF算法左右两侧点对数目;N3为ASM算法与ASEF算法相比较的特征点数目;Xil,Xir与Xjl,Xjr分别为ASM与ASEF算法中左右两侧点对的横向坐标向量;XkASM与XkASEF分别为ASM与ASEF两种算法中相对应的特征点的横向坐标向量;OyASM与OyASEF分别为ASM算法与ASEF算法输出结果在纵轴方向的质心。

首先检验ASM算法的对称性EASM。通过计算左右两侧特征点的对称轴,将左侧特征点镜像至右侧,计算镜像后特征点对之间的误差,即可检验ASM算法输出结果的对称性。

其次,检验ASEF算法的对称性EASEF,方法同EASM。

随后检验ASM算法与ASEF算法对应特征点的误差EASM-ASEF。根据ASM输出拓扑结构计算眼睛、鼻孔、嘴角6个特征点的坐标,并将之与ASEF算法的输出结果进行比较,计算差异性。

最后检测ASM算法与ASEF算法输出结果在纵轴方向的质心偏差。

若该偏差小于预设阈值,则判定当前人脸为正面人脸,按照此规则检测出来的正面人脸见图7。

图7 正面人脸检测结果

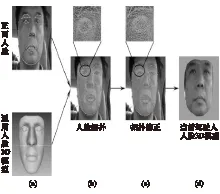

3 驾驶人的人脸3D建模

基于通用人脸3D模型[8]与正面人脸2D模型构建当前驾驶人的人脸3D模型。该通用人脸3D模型由3 449个顶点和6 644个面组成。从通用人脸3D模型中选取31个特征点(人脸轮廓点、眉毛点、眼睛点、鼻子点、嘴部边缘点)与正面人脸检测确定的ASM算法拓扑结构中的相应特征点建立对应关系,计算当前驾驶人的人脸3D模型,如图8所示。

图8 当前驾驶人人脸3D模型的建立

(7)

式中s为尺度因子。因为人脸的2D与3D模型均为正面人脸,故式(7)中的旋转矩阵R为单位矩阵,因此,只需计算摄像头成像面主点坐标cx和cy,以及平移向量T=(TxTyTz)T,即可完成摄像机成像建模。

当前驾驶人的人脸3D模型计算过程如下。

初始条件:正面通用人脸3D模型,并手动选取脸部轮廓、眉毛、眼睛、鼻子、嘴巴等31个特征点的三维坐标K0。

步骤1:进行正面人脸检测,并根据检测结果,确定与K0相对应的二维特征点的坐标K1。

步骤2:根据K0与K1的对应关系,采用式(7)计算平移向量T和摄像头焦距f的最小二乘解,摄像头成像面主点坐标cx和cy取为2D图像相应坐标轴分辨率的一半,并根据计算结果将通用人脸3D模型拓扑结构调整至2D图像中,如图8(b)所示。

步骤3:根据正面人脸检测确定的ASM算法拓扑结构,将人脸3D模型进行仿射变换[17],修正人脸3D模型的2D形状(深度坐标Z保持不变),如图8(c)所示。

步骤4:对生成的人脸3D模型进行纹理贴图,得到最终的当前驾驶人的人脸3D模型,见图8(d)。

4 驾驶人头部姿态检测

4.1 头部姿态实时检测

采用PnP算法[18]实时求解驾驶人的头部姿态。PnP算法基于二维图像点集与三维物体点集之间的对应关系,计算摄像机坐标系(二维图像)与世界坐标系(三维物体)之间的空间位置关系。驾驶人的头部姿态是相对于正面姿态而言的,故可将正面人脸3D模型作为姿态度量的基准,计算当前二维图像(摄像机坐标系)与正面人脸3D模型(世界坐标系)之间的空间位置关系,该空间位置关系即为驾驶人的头部姿态。

驾驶人头部姿态的计算,需要在2D和3D图像中定位若干特征点,为避免驾驶人眼睛睁闭和眼镜局部反光等原因造成特征点跟踪失败,在特征点选取时,避开了眼睛部位的特征点,如图9所示。

图9 头部姿态实时计算

第T帧时,设当前驾驶人的头部姿态为RT与TT,在人脸2D图像中的人脸区域内确定的特征点P2T为

P2T=(x1,y1,x2,y2,…,xNT,yNT)

(8)

在当前姿态人脸3D模型中,P3T为与P2T相对应的特征点。根据RT与TT,可解算出P3T在正面姿态人脸3D模型中的对应点PT。

根据F-B Error算法[19]对P2T进行跟踪,得到第T+1帧人脸2D图像中的特征点P2T+1(NT+1≤NT)

P2T+1=(x1,y1,x2,y2,…,xNT+1,yNT+1)

(9)

根据跟踪关系,其在PT中的对应点为PT+1,根据P2T+1(2D对应点)与PT+1(3D对应点)可运用PnP算法解算出第T+1帧驾驶人的头部姿态(旋转矩阵RT+1与平移向量TT+1)。

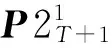

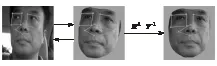

采用F-B Error算法实现2D图像间的特征点跟踪,如图10所示。

图10 F-B Error跟踪算法

4.2 特征点更新

PnP算法基于一定数量的2D-3D对应点解算驾驶人的头部姿态,受随机光照、脸部自遮挡、脸部非刚体运动的影响,2D-3D对应点在跟踪的过程中将逐步丢失,影响到驾驶人头部姿态的实时检测。本文中采用每帧图像均更新特征点[13]的方法,以保证足够数量的对应点,提高PnP算法的鲁棒性。

在第T+1帧人脸2D图像的人脸区域内,随机选取MN+1个特征点P2T+1[13],该MN+1个特征点中有强特征点与弱特征点,为提高跟踪过程的鲁棒性和姿态解算的可靠性,需选取强特征点进行第T+2帧的姿态解算。该强特征点有别于上文F-B Error算法中提到的强特征点(仅在2D图像中),该特征点用于2D图像与人脸3D模型间的姿态解算。根据特征点在相邻帧间的鲁棒性,进行强特征点的选取[8],如图11所示。

图11 特征点更新

由P2T+1可按式(10)计算出其在第T+1帧当前姿态人脸3D图像中的特征点P3T+1(本文中3D模型深度坐标Z始终保持不变,仅随着头部姿态作相应的旋转与平移),P3T+1的X与Y坐标为

(10)

根据T+1帧头部姿态RT+1与TT+1可由式(11)解算P3T+1在正面姿态人脸3D图像中的对应点PT+1。

(11)

4.3 姿态有效性判定

基于2D-3D对应点解算驾驶人的头部姿态,采用每帧图像均更新特征点的方法提高姿态解算的鲁棒性,即在当前帧人脸区域内更新特征点,建立2D-3D特征点之间的对应关系,并运用F-B Error算法对2D特征点进行跟踪,利用跟踪结果解算下一帧图像驾驶人的头部姿态。

受脸部表情、快速运动和自遮挡等因素的影响,特征点跟踪的结果有可能产生漂移,由此产生错误的2D-3D对应点,致使解算出的头部姿态产生偏差,因此有必要对解算出的头部姿态进行有效性判定。

在人脸区域内定义如图12所示的感兴趣特征点(左、右眼矩形框角点,鼻子部位菱形框角点),利用感兴趣特征点之间的偏差,作为头部姿态的有效性度量。

图12 姿态判定感兴趣特征点

驾驶人头部姿态(旋转矩阵R与平移向量T)的计算均基于正面人脸3D模型,故每一帧图像的头部姿态均可按照R-1与T-1恢复到作为基准的正面人脸3D模型。若2D-3D对应点错误,则当前姿态人脸3D模型无法恢复到正面人脸3D模型。

根据以上条件,首先根据驾驶人的人脸3D建模的结果,确定正面人脸3D模型中的感兴趣特征点的坐标,以此作为基准特征点Xb。将每一帧检测到的驾驶人头部姿态按照R-1与T-1恢复到正面人脸3D模型,判定当前特征点与基准特征点之间的偏差,即

(12)

式中:N为特征点的个数,N取值为12。

若偏差d>dthreshold,则说明当前姿态的跟踪结果已经存在较大误差,则重新进行正面人脸检测,重新实时获取驾驶人的姿态。

5 实验验证

5.1 样本采集

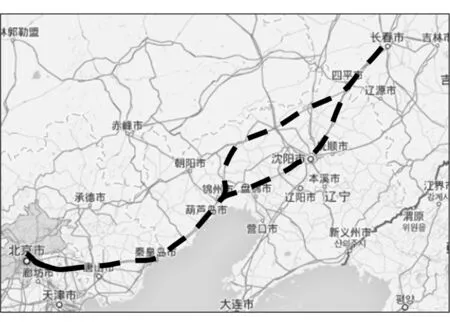

为完成人脸3D模型的构建,以及验证该模型对于驾驶人头部姿态检测的鲁棒性,在长春至北京高速路段(图13中虚线所示),以及京沈高速北京近郊路段(多次往返,图13中实线所示)进行了实车驾驶实验。

图13 实车实验路线

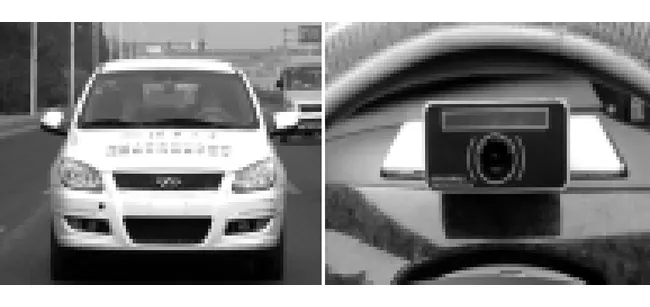

共有13名驾驶人(12名男性,1名女性,年龄28~55岁,平均驾龄10.5年)参与实验,图14为实验车辆与采集摄像头。

图14 实验车辆与摄像头

5.2 ASEF算法参数确定

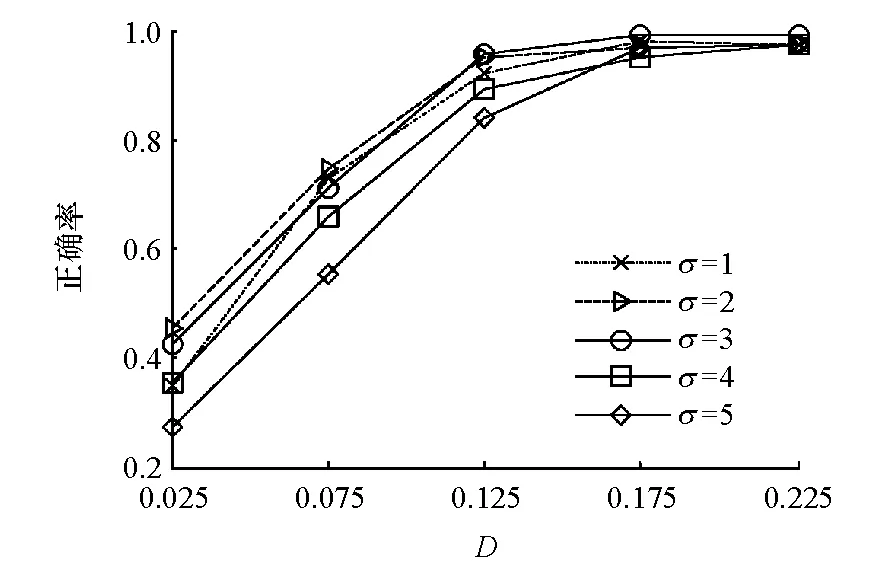

由第2.2节可知,ASEF算法中的参数σ直接影响到滤波器的检测灵敏度与抗噪声性能。为选择最优的σ参数,选用FERET人脸库[21]进行测试。在每张人脸图像中,手动标记出左右眼中心,左右鼻孔点和左右嘴角点作为基准位置,用不同σ参数下的双眼、双鼻孔、双嘴角ASEF滤波器进行检测,以双眼ASEF滤波器为例,测试规则为

(13)

式中:Rl,Rr分别为手动标记的左、右眼中心位置;Tl,Tr分别为双眼滤波器定位出的左、右眼中心位置;D为评价准则,令D∈{0.025,0.075,0.125,0.175,0.225}代表不同的精度要求,测试结果如图15所示。

图15 不同σ参数下的双眼ASEF滤波器测试结果

由图15可知,双眼ASEF滤波器最优σ参数值为3,经过测试,双鼻孔、双嘴角ASEF滤波器的最优σ参数值分别为4与3。

5.3 算法检测精度测试

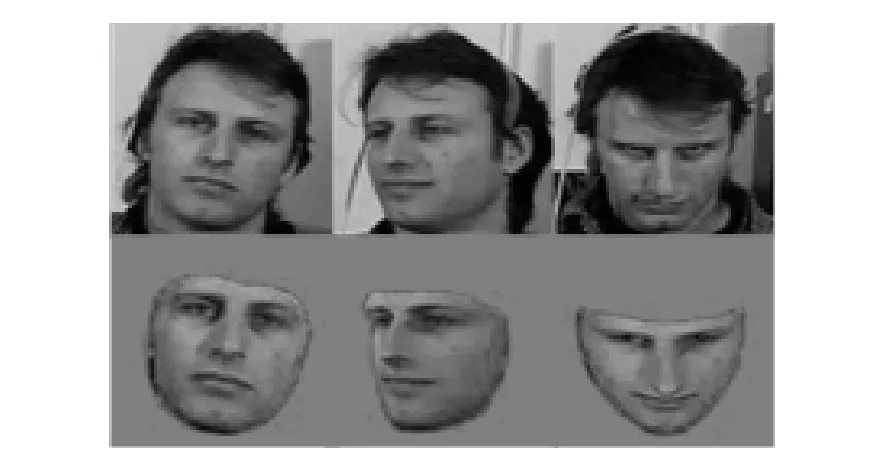

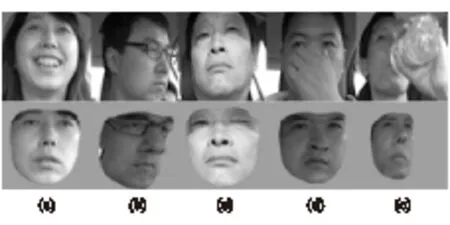

选用BU头部姿态数据库[22]对本文算法进行精度测试。BU头部姿态数据库由5名被试人员,45段视频组成,每段视频共200帧图像。该数据库使用Flock of Birds传感器获取被试人员的头部姿态[8]。BU数据库中,一名被试人员的人脸3D建模效果如图16所示。

图16 BU姿态库一名被试人员的人脸3D建模效果

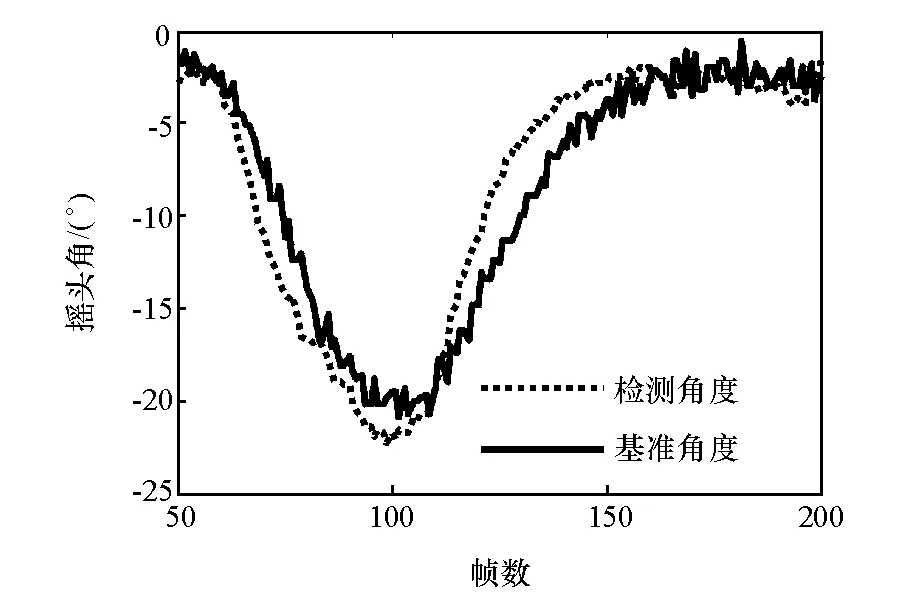

一名被试人员头部姿态(摇头角度)解算结果如图17所示。本文算法需要首先定位被试人员的正面人脸,故初始50帧图像无姿态数据。

图17 一名被试人员头部姿态(摇头角)检测结果

经过测试,得到本文算法对各帧图像的检测误差数据,对其进行统计分析,检测误差的均值为5.12°,误差分布的标准差为4.28°。

5.4 算法鲁棒性测试

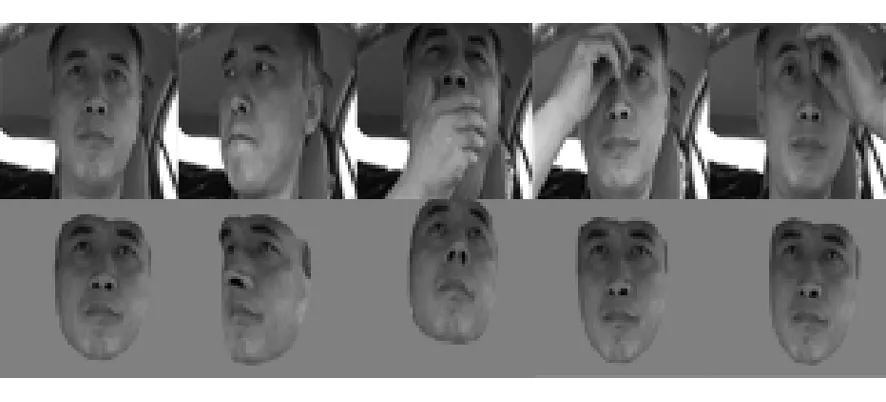

采用实车视频测试驾驶人的人脸3D建模的鲁棒性。测试视频包括光照强烈、光照均匀等多种光照条件,驾驶人正常驾驶、打哈欠、脸部部分遮挡等驾驶工况。

实验过程中,一名在复杂光照条件下行驶的驾驶人的人脸3D模型如图18所示。

图18 某驾驶人的人脸3D模型

人脸3D模型利用驾驶人脸部区域内的特征点解算驾驶人的头部姿态,故该模型对于驾驶人脸部区域中的部分遮挡能够表现出较强的鲁棒性,如图19所示。

图19 同一驾驶人脸部部分遮挡的人脸3D建模效果

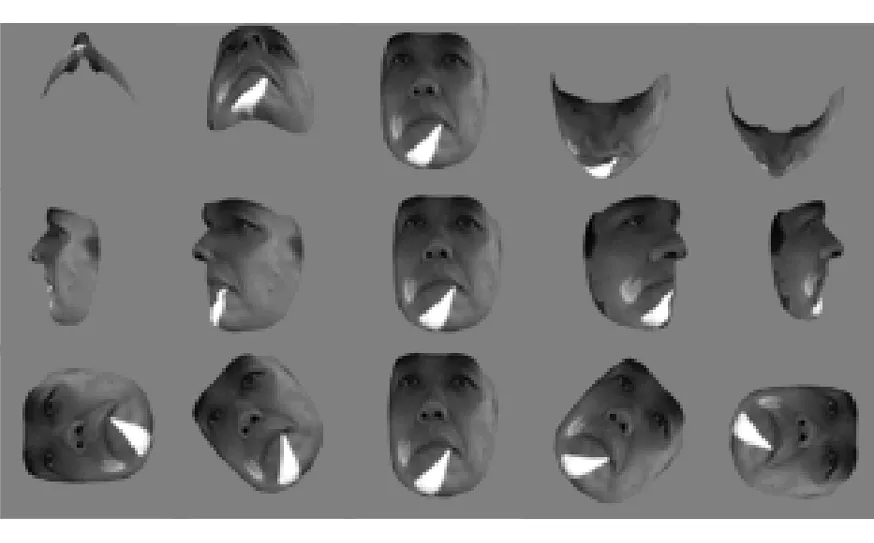

本文人脸3D模型中的纹理图像为模型建立时检测到的正面人脸,实时监测过程为特征点的跟踪处理过程,纹理图像仅在模型更新时重新获取,故本文人脸3D模型不能表达驾驶人的表情变化,如图20(a)所示。由图20可知,本文人脸3D建模算法,对于驾驶人脸部表情、光照变化、脸部部分遮挡等均具有一定的鲁棒性。

图20 不同驾驶人的人脸3D建模效果

该算法的平均运行时间为95ms,计算机处理器为英特尔i7-4600,主频2.89GHz,内存8G。

6 结论

基于人脸3D模型的驾驶人头部姿态检测算法,提出了运用ASM与ASEF算法相结合的驾驶人正面人脸检测方法,并运用通用人脸3D模型与正面人脸2D模型建立当前驾驶人的人脸3D模型;提出了特征点更新机制提高PnP姿态解算的鲁棒性,以及实时判别姿态解算的有效性。本文中的姿态解算均以正面人脸作为度量的基准,当正面人脸检测错误时,实时计算出来的驾驶人头部姿态也将产生错误;采用F-B Error算法对驾驶人脸部图像中的特征点进行跟踪,当驾驶人头部运动较大时,光流跟踪失败,同时姿态解算错误。后续工作将着眼于解决由这两个原因而造成的检测失败问题。

[1] WANG J S, KNIPLING R R, GOODMAN M J. The Role of Driver Inattention in Cashes: New Statistics from the 1995 Crahworthiness Data System [C]. 40thAnnual Proceedings of the Association for the Advancement of Automative Medicine, Vancouver, British Columbia,1996:1-16.

[2] 孙海燕.基于双目视觉的驾驶人注意力分散监测方法研究[D].长春:吉林大学,2012.

[3] SHERRAH J, GONG S, ONG E J. Face Distributions in Similarity Space Under Varying Head Pose[J]. Image and Vision Computing,2001,19:807-819.

[4] ZHANG Z Q, HU Y X, LIU M, et al. Head Pose Estimation in Seminar Room Using Multi View Face Detectors[J]. Multimodal Technologies for Perception of Humans, Lecture Notes in Computer Science,2007,4122:299-304.

[5] HUANG J, SHAO X H, WECHSLER H. Face Pose Discrimination Using Support Vector Machines (SVM)[C]. 14th International Conference on Pattern Recognition, Brisbane,Australia,1998,1:154-156.

[6] HORPRASERT T, YACOOB Y, DAVIS L S. Computing 3D Head Orientation from a Monocular Image Sequence[C]. 25th AIPR Workshop: Emerging Applications of Computer Vision, Washingon, DC, USA, SPIE,1997,2962:242-247.

[7] LANITIS A, TAYLOR C J, COOTES T F. Automatic Interpretation and Coding of Face Images Using Flexible Models[J]. Transactions on Pattern Analysis and Machine Intelligence,1997,19(7):743-756.

[8] CHOI J, DUMORTIER Y, CHOI S, et al. Real-time 3-D Face Tracking and Modeling from a Webcam[C]. IEEE Workshop on Application of Compuer Vision, Breckenridge, USA,2012:33-40.

[9] ERIK M C, TRIVEDI M M. Head Pose Estimation in Computer Vision: A Survey[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2009,31(4):607-626.

[10] COOTES T F, TWINING C J, TAYLOR C J. Diffeomorphic Statistical Shape Models[J]. Image and Vision Computing,2008,26(3):326-332.

[11] COOTES T F, EDWARDS G J, TAYLOR C J. Active Appearance Models[C]. 5th European Conference on Computer Vision. Freiburg, Germany,1998,2:484-498.

[12] LOWE D G. Distinctive Image Features from Scale-Invariant Keypoints[J]. International Journal of Computer Vision,2004,60(2):91-110.

[13] GUNNAR F. Two-Frame Motion Estimation Based on Polynomial Expansion[J]. Image Analysis, Lecture Notes in Computer Science,2003,2749:363-370.

[14] BOLME D S, DRAPER B A, BEVERIDGE J R. Average of Synthetic Exact Filters[C]. IEEE Conference on Computer Vision and Pattern Recognition, Miami,USA,2009:2105-2112.

[15] VITOMIR S, JERNEJA Z G, NIKOLA P. Principal Directions of Synthetic Exact Filters for Robust Real-Time Eye Localization[J]. Biometrics and ID Management, Lecture Notes in Computer Science,2011,6583:180-192.

[16] GAO Wen, CAO Bo, SHAN Shiguang, et al. The CAS-PEAL Large-Scale Chinese Face Database and Baseline Evaluations[J]. IEEE Transactions on System Man and Cybernetics (Part A),2008,38(1):149-161.

[17] 于仕琪,刘瑞祯.学习opencv(中文版)[M].北京:清华大学出版社,2009:443-445.

[18] VINCENT L, FRANCESE M N, Pascal F. EPnP: An Accurate O(n) Solution to the PnP Problem[J]. Int J Comput Vis,2009,81(2):155-166.

[19] KALAL Z, MIKOLAJCZYK K, MATAS J. Forward-backward Error Automatic Detection of Tracking Failures[C]. International Conference on Pattern Recognition, Istanbul, Turkey,2010:2756-2759.

[3] CLEMO K, DAVIES R. The Practicalities of Pedestrian Protection[C]. ESV Conference, Paper 98-S10-P-16,1998.

[4] ZHENG Guojun, MEN Yongxin, HU Ping. A Study on Energy Absorption Panel of Bumper Based on Impact of Pedestrian’s Lower Leg[C]. CECNet International Conference on, April 16-18,2011, Xian Ning, China.

[5] SHULER S, MOOIJMAN F, NANDA A, et al. Improved Energy Absorber and Vehicle Design Strategies for Pedestrian Protection[C]. SAE Paper 2005-01-1872.

[6] LIU Weihai, CHENG Xiusheng. Improvement of Bumper Structure for Pedestrian Lower Leg Protection Based on Euro-NCAP[C].2011 International Conference on Mechatronic Science, Electric Engineering and Computer, August 19-22,2011,Jilin, China.

[7] HAN Y, LEE Y. Optimization of Bumper Structure for Pedestrian Lower Leg Impact[C]. SAE Paper 2002-01-0023.

[8] MOHAPATRA S. Rapid Design Solutions for Automotive Bumper Energy Absorbers Using Morphing Technique[C]. Altair CAE Users Conference 2005, August 11-13, Bangalore, India,2005.

[9] European New Car Assessment Program Assessment. Pedestrian Testing Protocol Version 5.3[S].2011.6.

[10] 黄俊.面向行人下肢碰撞保护的汽车前端结构快速优化设计研究[D].北京:清华大学,2013.

[11] 黄俊,夏勇,周青.基于汽车前端刚度分析的降低小腿加速度快速设计方法[J].汽车工程,2012,34(8):679-685.

[12] 徐中明,徐小飞,万鑫明,等.铝合金保险杠防撞梁结构优化设计[J].机械工程学报,2013,49(8):136-142.

[13] 王元博,夏勇,景谊明,等.考虑行人腿部保护和低速碰撞特性的保险杠系统概念设计[J].汽车工程,2009,31(12):1111-1115.

Detection of Driver’s Head Posture Based on 3D Face Model

Zhang Bo, Wang Wenjun & Cheng Bo

TsinghuaUniversity,StateKeyLaboratoryofAutomotiveSafetyandEnergy,Beijing100084

For monitoring and forewarning the distraction behavior of driver during driving, a detection method of driver’s head posture based on 3D face model is proposed. The method utilizes active shape model algorithm and average synthetic exact filter algorithm to locate the front-view face of driver. On this basis, the 3D face model of the specific driver is calculated based on the general 3D face model and front-view face. With the frontal 3D face model as the base of posture measure, PnP algorithm is adopted to calculate the driver’s head posture in real time, with the posture effectiveness discriminated. Meanwhile a scheme for updating characteristic points is also put forward to improve the robustness of posture calculation. The results of experiments show that the method proposed can effectively detect the head posture of driver in cabin environment.

driver; head posture; machine vision; 3D face model

*国家863计划项目(2012AA111901)资助。

原稿收到日期为2014年6月20日,修改稿收到日期为2014年8月26日。